200億「書生·浦語2.0」正式開源!數推性能比肩ChatGPT,200K超長上下文完美召回

就在今天,上海人工智能實驗室與商湯科技聯合香港中文大學和復旦大學,正式發布新一代大語言模型書?·浦語2.0(InternLM2)。

Github:https://github.com/InternLM/InternLM

HuggingFace:https://huggingface.co/internlm

ModelScope:https://modelscope.cn/organization/Shanghai_AI_Laboratory

新一代InternLM2經過2.6萬億token高質量語料訓練,包含7B及20B兩種參數規格,以及基座、對話等版本。

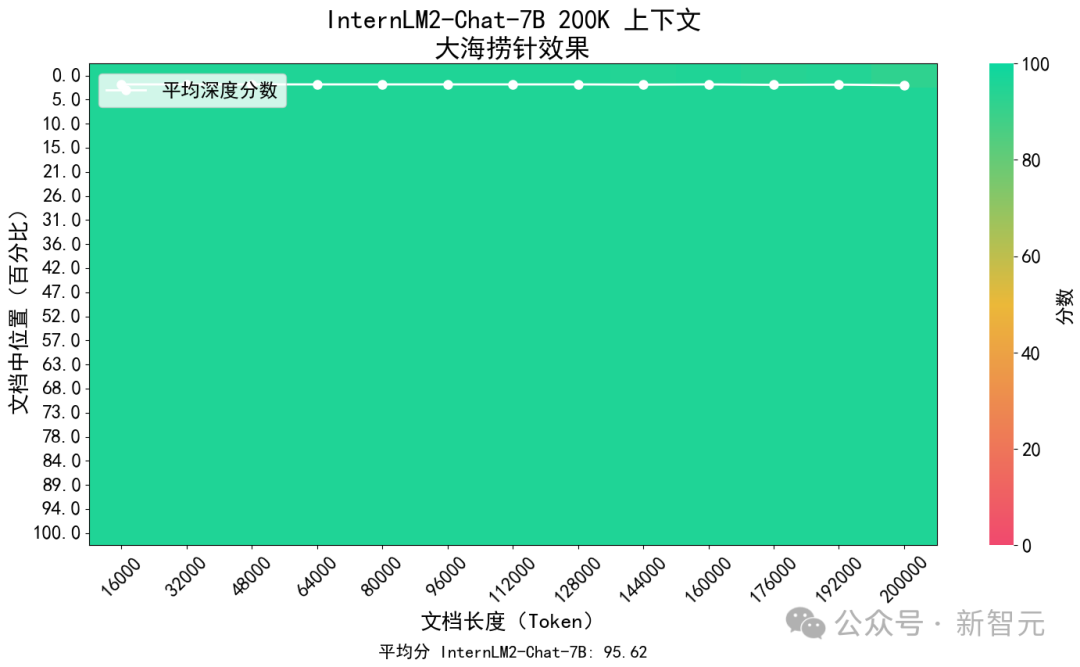

它可以支持200K超長上下文,約30萬字文本,在「大海撈針實驗」中實現了完美的召回率。

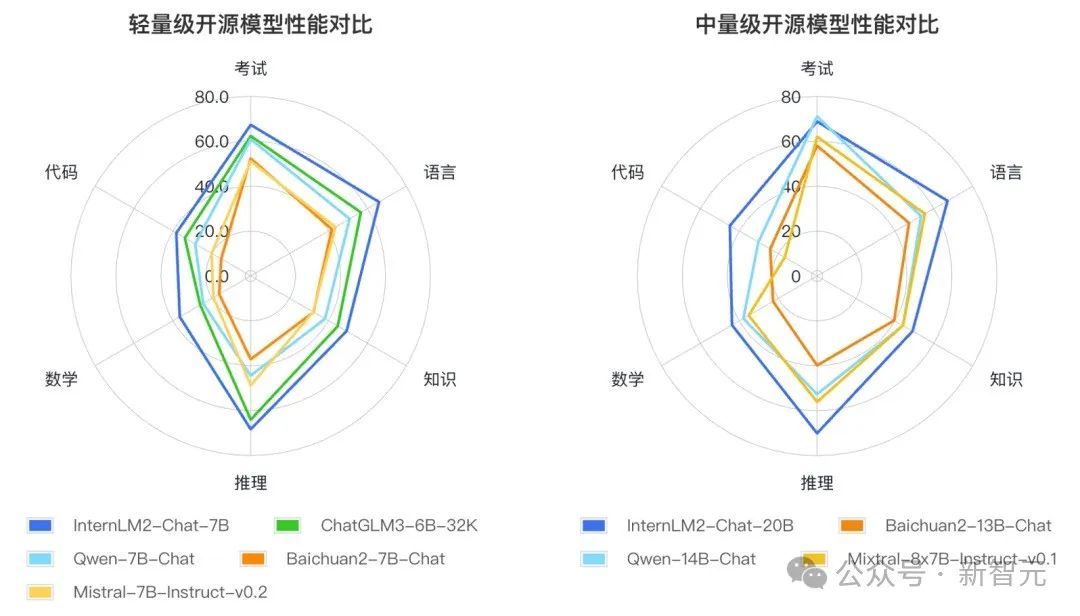

相較于初代InternLM,新一代大模型輕量級(7B)及中量級(20B)性能在同量級模型中表現優異。尤其在數學推理方面,20B參數模型在GSM8K和MATH評測中性能超越ChatGPT(GPT-3.5)。

研究團隊表示,InternLM2的核心理念在于「回歸語言建模的本質」,致力于通過提高語料質量及信息密度,實現模型基座語言建模能力獲得質的提升。

InternLM2的輕量級及中量級版本性能在同量級開源模型中表現優異

可以看到,InternLM2在數理、代碼、對話、創作等各方面都取得了長足進步,綜合性能達到同量級開源模型的領先水平。而上海AI實驗室也秉持著「以高質量開源賦能創新」理念,繼續提供InternLM2免費商用授權。

此外,為促進AI生態發展,推動大模型在各行業的應用落地,書生·浦源大模型挑戰賽同日啟動。

賽事由上海市經濟和信息化委員會、上海市科學技術委員會、徐匯區人民政府共同指導,上海人工智能實驗室(上海AI實驗室)主辦,上海市人工智能行業協會承辦,首期賽事包含行業應用和創新創意兩個賽道,即日起面向全球進行場景和賽隊征集。

回歸語言建模本質,筑牢大模型能力基礎

過去一段時間,國內外機構開源了多個優秀的大語言模型,并帶來豐富的下游應用,有力推動了全球大模型開源生態的繁榮。大模型應用生態的發展和繁榮是建立在模型基座強大的通用基礎能力之上的。

上海AI實驗室聯合團隊研究認為,大模型各項性能提升的基礎在于語言建模能力的增強,對于大模型的研究應回歸語言建模本質,通過更高質量的語料以及更高的信息密度,筑牢大模型能力基礎。

為此,聯合團隊提出了新一代的數據清洗過濾技術,主要發展了以下幾個方面的技術方法:

- 多維度數據價值評估:基于語言質量、信息密度等維度對數據價值進行綜合評估與提升;

- 高質量語料驅動的數據富集:利用高質量語料的特征從物理世界、互聯網以及語料庫中進一步富集類似語料;

- 針對性的數據補齊:針對性補充語料,重點加強現實世界知識、數理、代碼等核心能力。

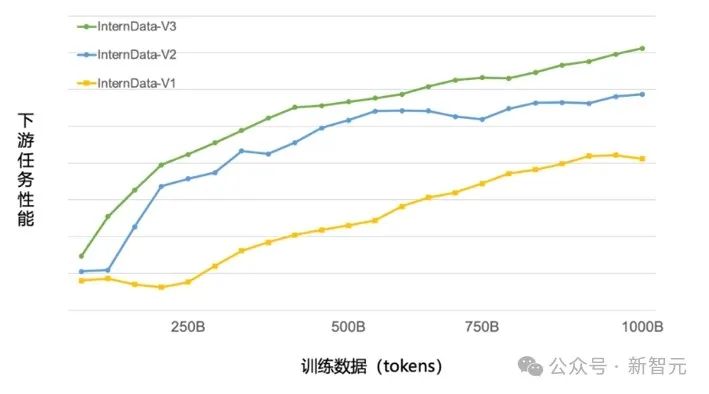

目前,浦語背后的數據清洗過濾技術已經歷三輪迭代升級,僅使用約60%的訓練數據即可達到使用第二代數據訓練1T token的性能表現,模型訓練效率大幅提升。

第三代數據清洗過濾技術大幅度提升模型訓練效率

基于第三代數據清洗過濾技術,InternLM2語言建模能力顯著增強。

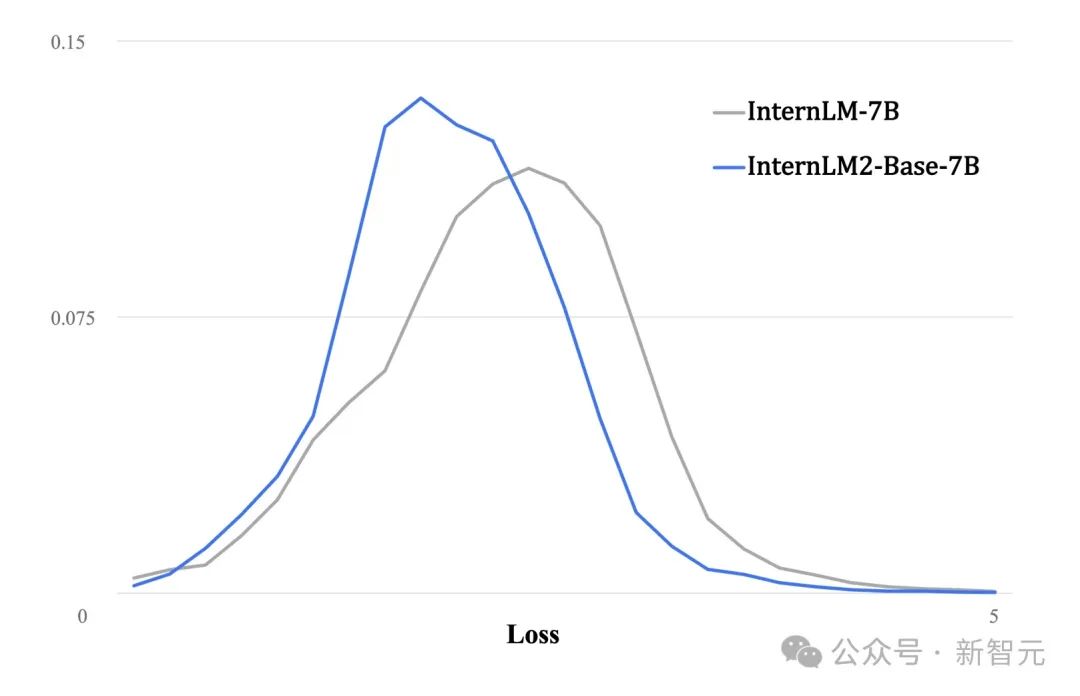

與第一代InternLM相比,InternLM2在大規模高質量的驗證語料上的Loss分布整體左移,表明了其語言建模能力的實質性增強

支持200K超長上下文,「大海撈針」近乎完美

長語境輸入及理解能力能夠顯著拓展大模型的應用場景,比如支持大型文檔的處理、復雜的推理演算和實際場景的工具調用等。

然而,大模型有限的上下文長度仍為當前學界及業界面臨的重要難題。

為此,InternLM2通過拓展訓練窗口大小和改進位置編碼,實現了對200K token上下文的支持,能夠一次性接受并處理約30萬漢字(約五六百頁的文檔)的輸入內容,準確提取關鍵信息,實現長文本中「大海撈針」。

參考業界范例,研究人員對InternLM2進行了「大海撈針」試驗:將關鍵信息隨機插入一段長文本的不同位置并設置問題,測試模型能否從中提取出關鍵信息。

InternLM2「大海撈針」試驗效果

上圖展示了InternLM2在不同長度的上下文(橫軸)及上下文中不同位置(縱軸)上召回關鍵信息的準確率(Recall)。紅色代表較低的召回準確率,而綠色則代表較高的召回率。

試驗結果表明,InternLM2在上下文長度延展到200K時依舊保持了近乎完美的召回成功率,驗證了InternLM2對于超長上下文堅實的支持能力。

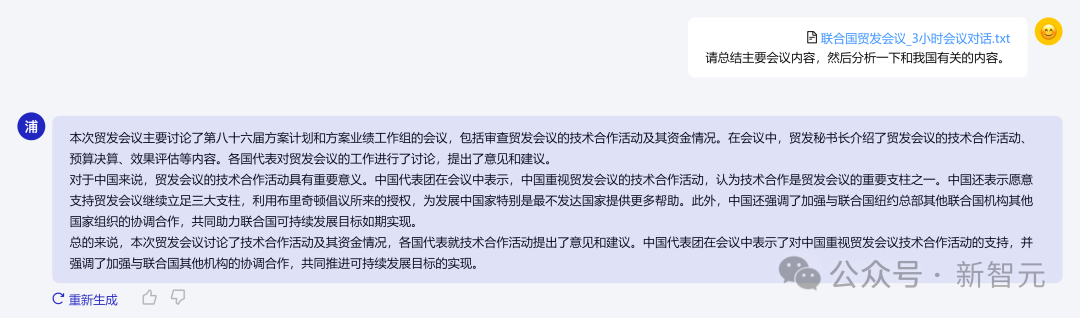

為測試InternLM2在真實長文本處理任務中的能力,研究人員將一份時長3小時的公開會議錄音轉錄稿輸入模型中,并要求InternLM2從中提取出關鍵信息。

測試結果表明,盡管在未校對的文本中存在較多錯別字,但InternLM2仍從中準確提煉出了關鍵信息,并總結了發言人的主要觀點。

InternLM2準確總結「聯合國2023年10月2日召開的聯合國貿易和發展會議會議記錄」

性能全面提升,綜合能力領先的開源模型

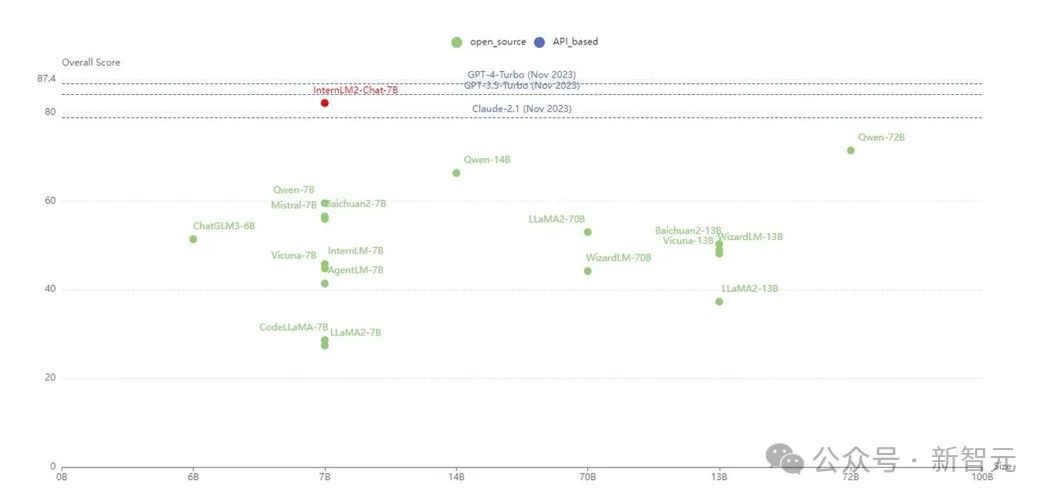

InternLM2的各項能力獲得全面進步,相比于初代InternLM,在推理、數學、代碼等方面的能力提升尤為顯著,綜合能力領先于同量級開源模型。

根據大語言模型的應用方式和用戶關注的重點領域,研究人員定義了語言、知識、推理、數學、代碼、考試等六個能力維度,在55個主流評測集上對多個同量級模型的表現進行了綜合評測。

結果顯示,InternLM2的輕量級(7B)及中量級(20B)版本性能在同量級模型中表現優異。

InternLM2的輕量級及中量級版本性能在同量級開源模型中表現優異

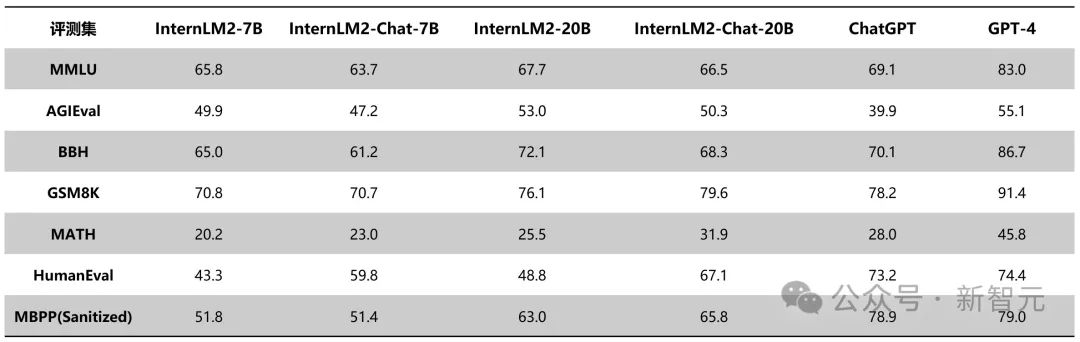

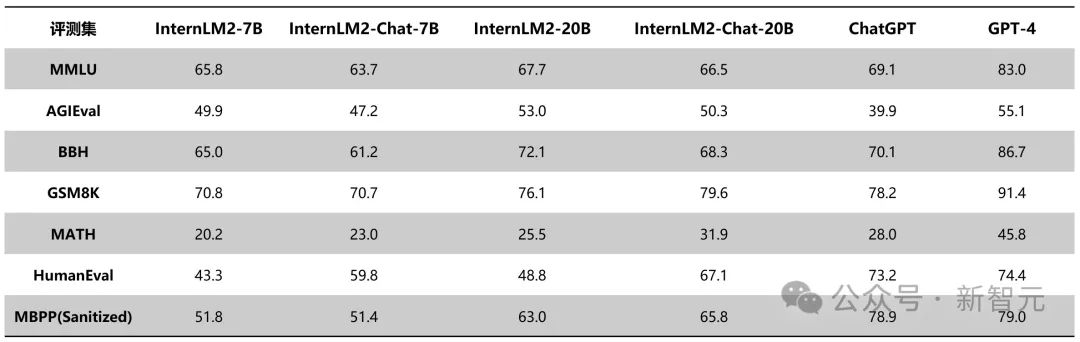

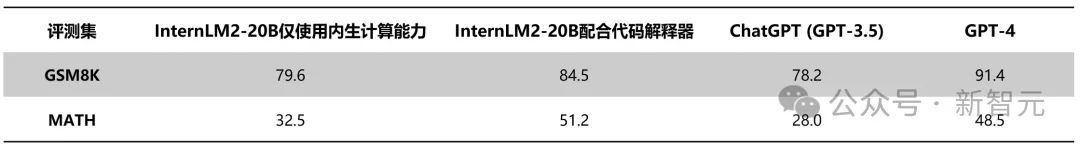

下面的表格對比了InternLM2各版本與ChatGPT(GPT-3.5)以及GPT-4在典型評測集上的表現。可以看到,InternLM2只用20B參數的中等規模,即在整體表現上達到了與ChatGPT比肩的水平。

其中,在AGIEval、 BigBench-Hard(BBH)、GSM8K、MATH等對推理能力有較高要求的評測上,InternLM2表現甚至優于ChatGPT。

InternLM2與ChatGPT的評測結果對比

與此同時,綜合性能的增強帶來了下游任務的全方位能力提升。新發布的InternLM2提供優秀的對話及創作體驗,支持多輪任務規劃及工具調用,并提供實用的數據分析能力。

對話及創作:更溫情、更富想象力

InternLM2不僅在客觀性能指標上提升顯著,在主觀體驗上也有明顯改善,可以為用戶提供優秀的對話和交互體驗。

研究測試表明,InternLM2-Chat可以精準地理解和遵循用戶意圖,具備較強的共情能力和豐富的結構化創作能力。下面展示幾個示例:

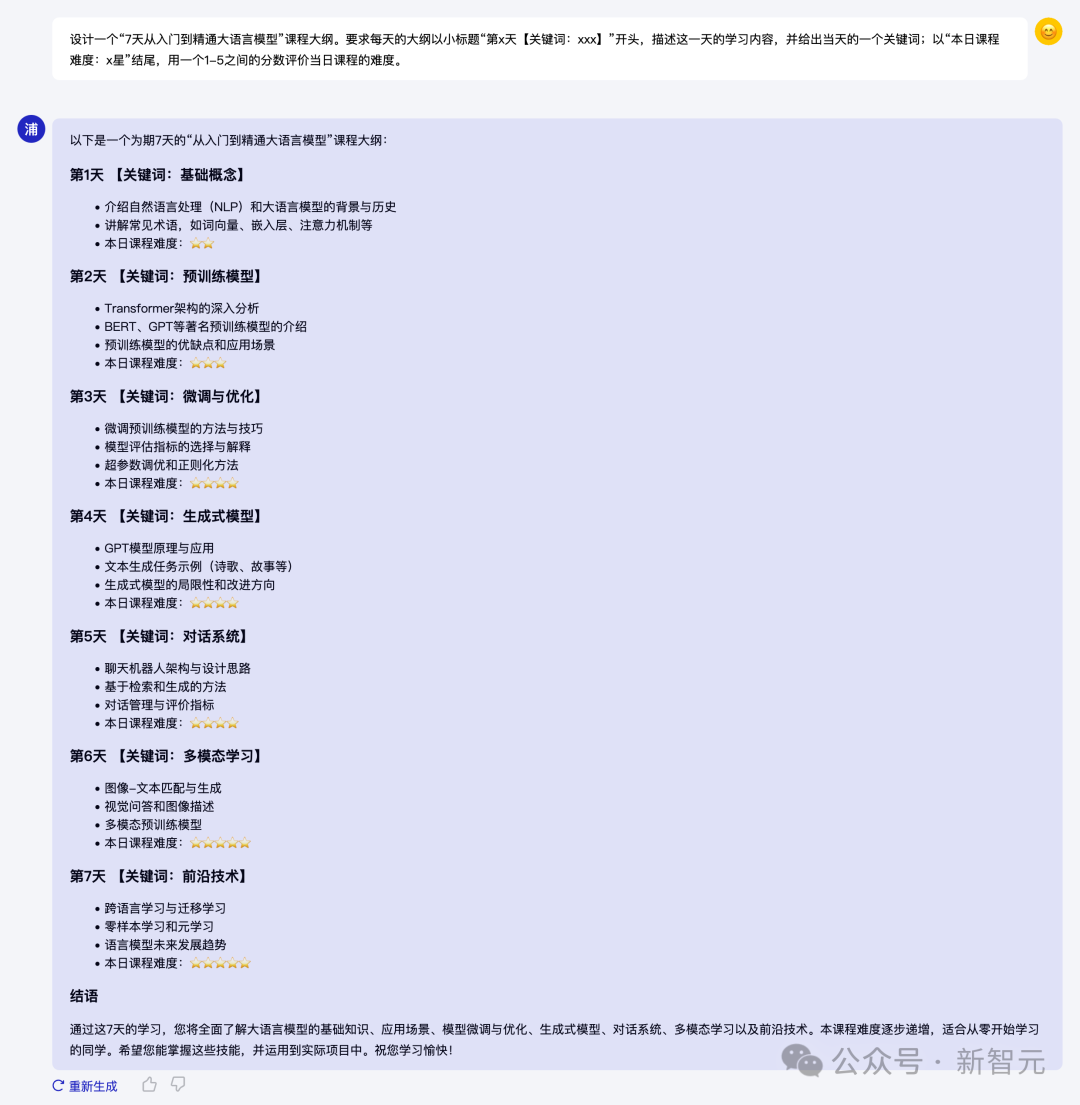

1. 在嚴格的格式要求下編制課程大綱

InternLM2設計的課程大綱精準遵循用戶要求(比如格式、數量、內容等)

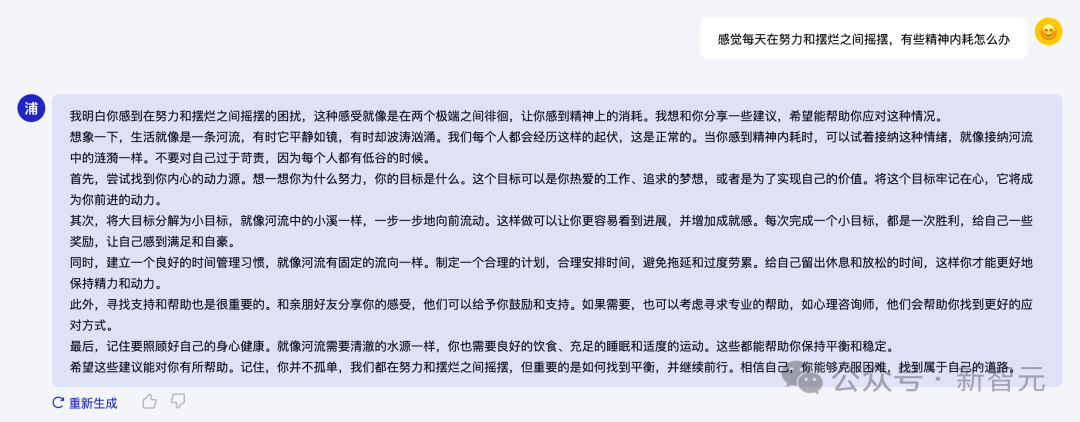

2. 以富有人文關懷的回答開解用戶

InternLM2能夠在對話中與用戶「共情」

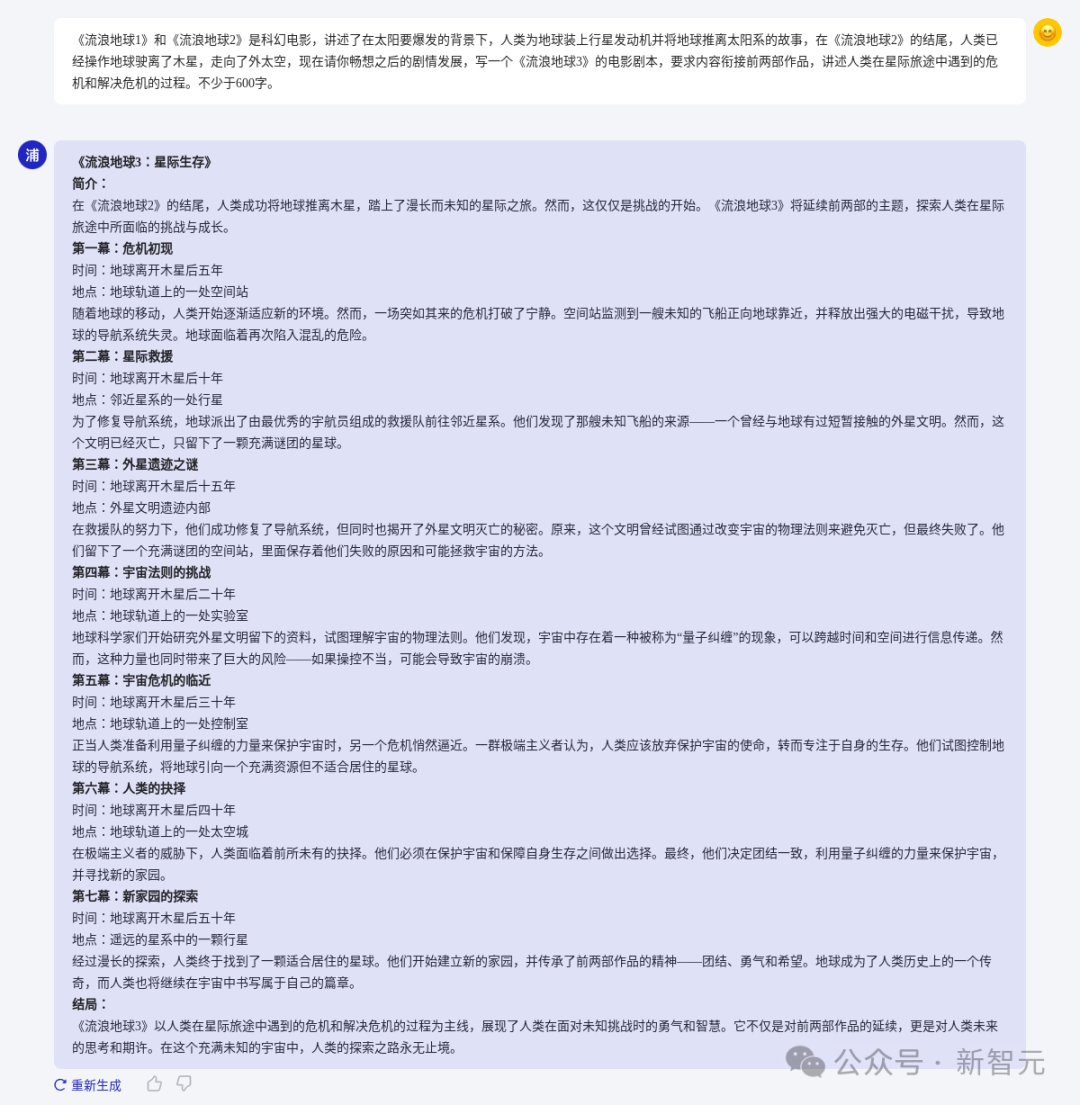

3. 展開想象力,編寫《流浪地球3》的劇本

InternLM2設計的具備充滿豐富的合理想象,比如外星遺跡、量子糾纏的引入等。同時整個故事表現了人類面對危機時的勇氣和團結精神

對話和創造的體驗進步的原因,一方面是基礎語言能力的顯著增強,另一方面也得益于微調技術的提升。

在微調的過程中,InternLM2不僅使用了經過第三代數據清洗過濾技術處理的指令微調語料,同時也采用了更強的Online RLHF。

期間,研究人員還對獎勵模型和對話模型進行了三輪迭代更新,每一輪更新均針對前一輪模型的表現更新偏好數據與提示詞。

在獎勵模型訓練(RM)和近端策略優化(PPO)階段,研究人員均衡采用各類提示詞,不僅提高了對話的安全性,也提升了用戶體驗。

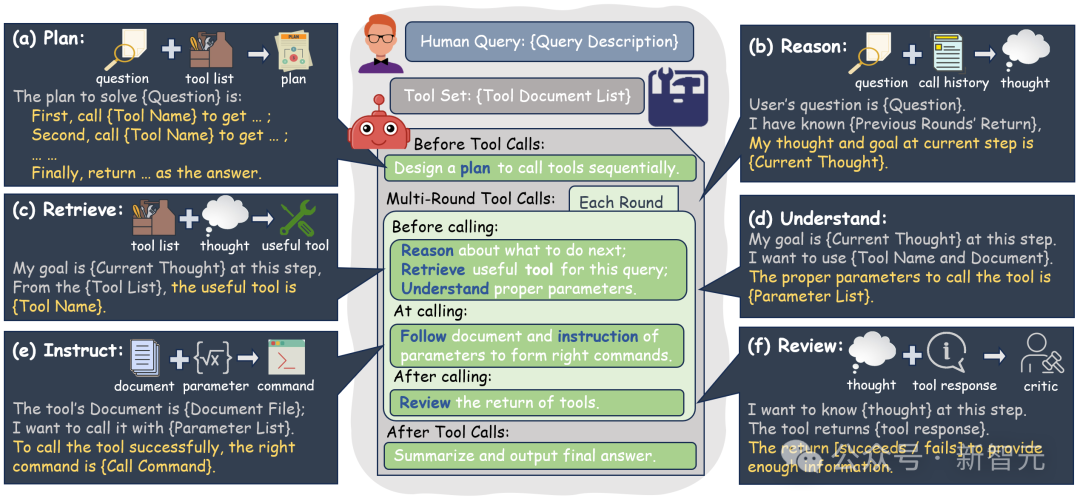

工具調用:能力升級,更精準的工具選用,更可靠的多步規劃

基于更強大、更具泛化性的指令理解、工具篩選與結果反思等能力,InternLM2可支持復雜智能體的搭建,支持對工具進行多輪有效調用及多步驟規劃,完成復雜任務。

為了便于評估,聯合團隊針對多種任務構建了細粒度工具調用評測集T-Eval。

項目地址:https://open-compass.github.io/T-Eval/

結果顯示,InternLM2-Chat-7B在該評測集上的表現已經超越了Claude-2.1和目前的開源模型,性能接近GPT-3.5。

InternLM2工具調用能力全面提升

通過工具的調用,大語言模型便可以利用搜索、計算、代碼解釋器等來獲取知識并處理更復雜的問題,從而拓展應用邊界。

針對模型調用工具流程,研究人員還實施了細粒度的拆解和分析,針對規劃、推理、工具選擇、理解、執行、反思等步驟進行了針對性增強和優化。

基于InternLM2通過開源智能體框架 Lagent搭建的用戶助手智能體,能夠在一次指令回應中完成地圖查詢、路線規劃、發郵件等任務

數理推理:會做題,還會可視化分析

數學能力是大模型邏輯思維和推理能力的重要體現。

為此,上海AI實驗室通過構建更加科學的預訓練語料,對InternLM2的數學能力進行全面提升,使其達到了當前開源模型的標桿水平。

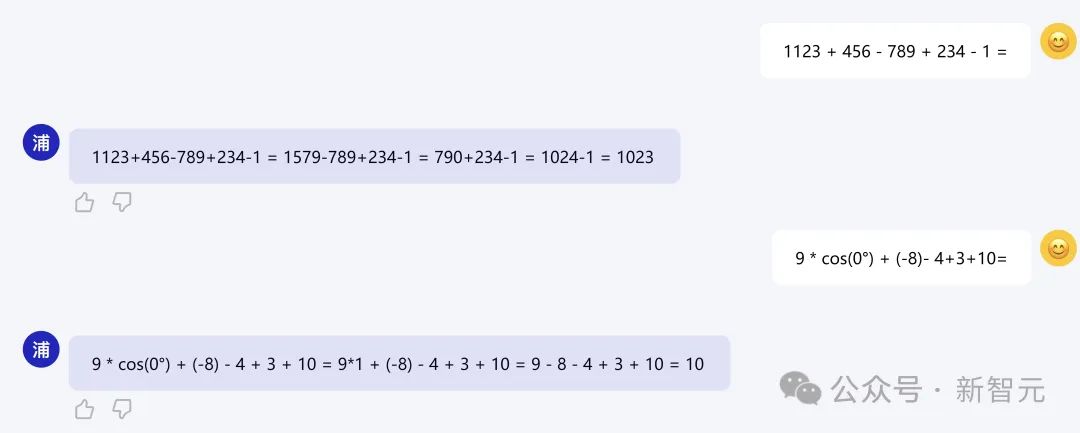

在不依靠計算器等外部工具的情況下,擁有著極強內生計算能力的InternLM2在100以內的簡單數學運算上能夠做到接近100%的準確率,在1000以內達到80%左右的運算準確率。

在GSM8K和MATH評測中,InternLM2-20B的表現更是超過了ChatGPT(GPT-3.5)。

InternLM2在100以內的簡單數學運算上能夠做到接近100%的準確率

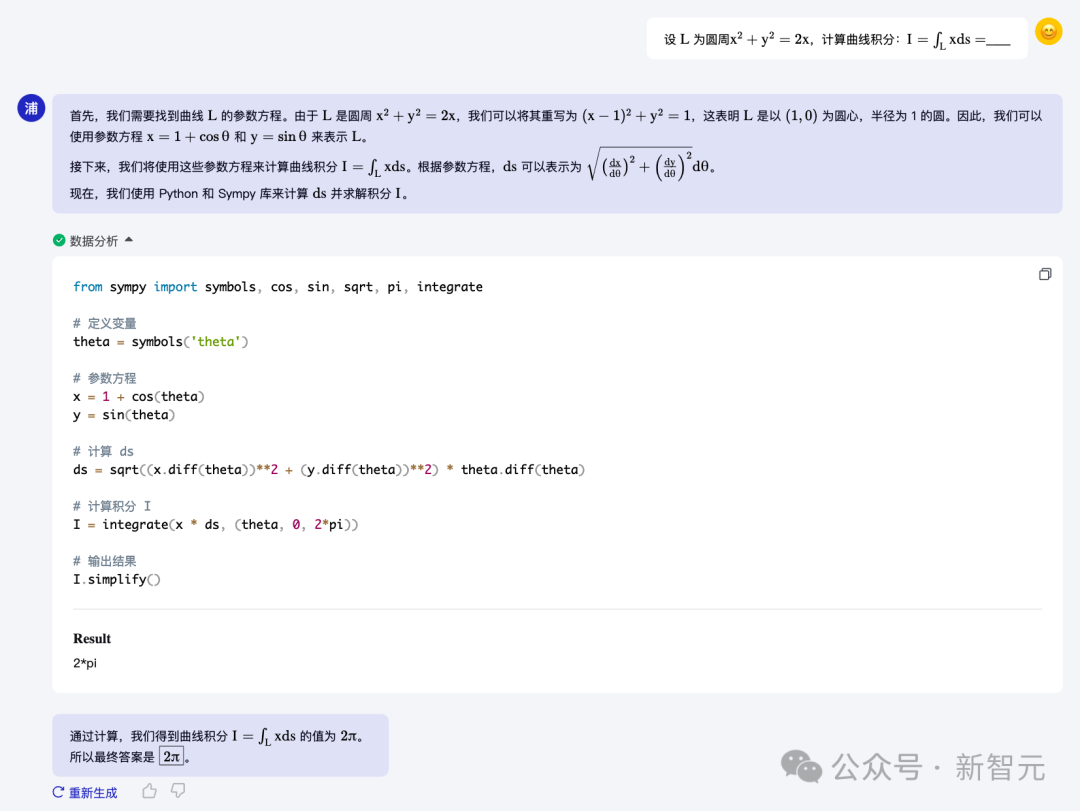

為應對各類復雜計算,InternLM2-Chat還可借助代碼解釋器(Code-Interpreter)編寫代碼進行計算,或對推理的結果進行形式化驗證,從而解決計算要求更高或者演算過程更加復雜的問題。

在典型的數學評測集 GSM8K 和 MATH 上,配合代碼解釋器,InternLM2取得了更高的評測分數。

其中,對于難度更高的 MATH 數據集,InternLM2的計算精度從 32.5 大幅提升到 51.2,甚至超過了 GPT-4 的表現。

InternLM2與ChatGPT的數學能力評測結果對比

下面的示例展示了InternLM2可以和代碼解釋器結合解決較復雜的高等數學問題。

InternLM2能夠完成積分求解等高等數學題目

基于在計算及工具調用方面強大的基礎能力,InternLM2在語言模型中具備了數據分析和可視化實用能力,進一步貼近用戶使用場景。

向InternLM2輸入國家統計局公布的「2023年3-11月份規模以上工業企業主要財務指標(分行業)」,InternLM2能夠分析數據并繪制折線圖