當LLM學會左右互搏,基礎模型或將迎來集體進化

金庸武俠小說中有一門武學絕技:左右互搏;乃是周伯通在桃花島的地洞里苦練十余年所創武功,初期想法在于左手與右手打架,以自娛自樂。而這種想法不僅能用來練武功,也能用來訓練機器學習模型,比如前些年風靡一時的生成對抗網絡(GAN)。

進入現今的大模型 (LLM) 時代,又有研究者發現了左右互搏的精妙用法!近日,加利福尼亞大學洛杉磯分校的顧全全團隊提出了一種新方法 SPIN(Self-Play Fine-Tuning),可不使用額外微調數據,僅靠自我博弈就能大幅提升 LLM 的能力。顧全全教授表示:「授之以魚不如授之以漁:通過自我博弈微調 (SPIN) 可以讓所有大模型達到從弱到強的提升!」

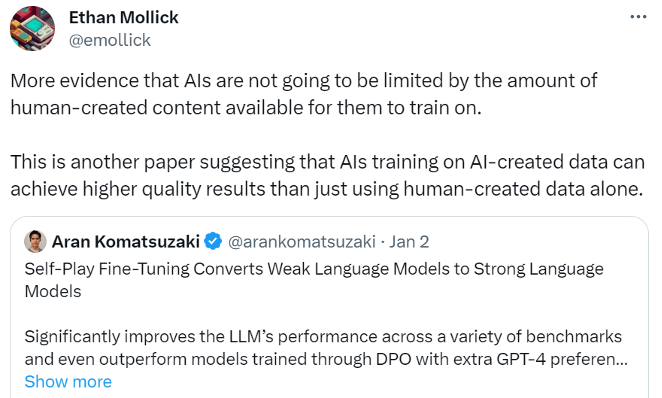

這項研究也在社交網絡引起了不少討論,比如賓夕法尼亞大學沃頓商學院的 Ethan Mollick 教授就表示:「更多證據表明,AI 不會受限于可供其訓練的人類創造內容的數量。這篇論文再次表明使用 AI 創造的數據訓練 AI 可以比僅使用人類創造的數據獲得更高質量的結果。」

此外,還有許多研究人員對這一方法感到興奮,并對 2024 年在相關方向的進展表現出極大期待。顧全全教授向機器之心表示:「如果你希望訓練一個超越 GPT-4 的大模型,這是一項絕對值得嘗試的技術。」

論文地址:https://arxiv.org/pdf/2401.01335.pdf

大型語言模型(LLM)開啟了通用人工智能(AGI)的大突破時代,它能以非凡的能力解決需要復雜推理和專業知識的廣泛任務。LLM 擅長的領域包括數學推理 / 問題求解、代碼生成 / 編程、文本生成、摘要和創意寫作等等。

LLM 的一大關鍵進步是訓練之后的對齊過程,這能讓模型的行為更符合需求,但這個過程卻往往依賴于成本高昂的人類標注數據。經典的對齊方法包括基于人類演示的監督式微調(SFT)和基于人類偏好反饋的強化學習(RLHF)。

而這些對齊方法全都需要大量人類標注數據。因此,為了精簡對齊過程,研究人員希望開發出能有效利用人類數據的微調方法。

這也是這項研究的目標:開發出新的微調方法,使得微調后的模型可以繼續變強,而且這個微調過程無需使用微調數據集之外的人類標注數據。

實際上,機器學習社區一直都很關注如何在不使用額外訓練數據的情況下將弱模型提升成強模型,這方面的研究甚至可以追溯至 boosting 算法。也有研究表明,自訓練算法可以在混合模型中將弱學習器轉換成強學習器,而無需額外的標注數據。但是,要在沒有外部引導的前提下自動提升 LLM 的能力既復雜又少有研究。這就引出了以下問題:

我們能讓 LLM 在沒有額外人類標注數據的前提下實現自我提升嗎?

方法

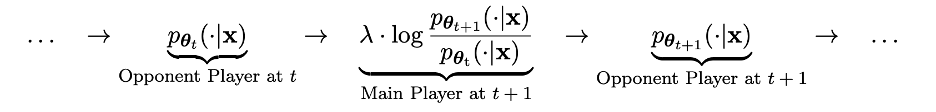

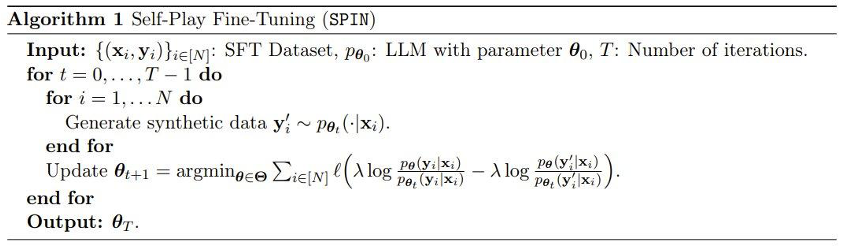

從技術細節上講,我們可以將來自之前迭代的 LLM 記為 pθt,其對于人類標注的 SFT 數據集中的 prompt x,可以生成響應 y'。接下來的目標是找到一個新的 LLM pθ{t+1},使其有能力區分 pθt 生成的響應 y' 和人類給出的響應 y。

這個過程可被看作是一個兩個玩家的博弈過程:主玩家就是新 LLM pθ{t+1},其目標是區分對手玩家 pθt 的響應以及人類生成的響應;對手玩家就是舊 LLM pθt,其任務是生成與人類標注的 SFT 數據集盡可能相近的響應。

新 LLM pθ{t+1} 是通過微調舊 LLM pθt 得到的,訓練過程是讓新的 LLM pθ{t+1} 有很好的能力區分 pθt 生成的響應 y' 和人類給出的響應 y。而這個訓練不僅讓新的 LLM pθ{t+1} 作為一個主玩家達到很好的區分能力,而且讓新的 LLM pθ{t+1} 作為一個對手玩家在下一輪迭代中,給出更對齊 SFT 數據集的響應。在下一輪迭代中,新獲得的 LLM pθ{t+1} 會變成響應生成的對手玩家。

這個自我博弈的過程的目標是讓 LLM 最終收斂到 pθ?=p_data,使得可能存在的最強大的 LLM 生成的響應不再與其之前版本和人類生成的響應不同。

有趣的是,這個新方法與 Rafailov et al. 近期提出的直接偏好優化(DPO)方法表現出了相似性,但新方法的明顯區別是采用了自我博弈機制。也因此,這個新方法就有了一大顯著優勢:無需額外的人類偏好數據。

此外,我們也能明顯看出這種新方法與生成對抗網絡(GAN)的相似性,只不過新方法中的判別器(主玩家)和生成器(對手)是同一個 LLM 在相鄰兩次迭代后的實例。

該團隊還對這個新方法進行了理論證明,結果表明:當且僅當 LLM 的分布等于目標數據分布時,即 p_θ_t=p_data 時,該方法可以收斂。

實驗

在實驗中,該團隊使用了一個基于 Mistral-7B 微調后的 LLM 實例 zephyr-7b-sft-full。

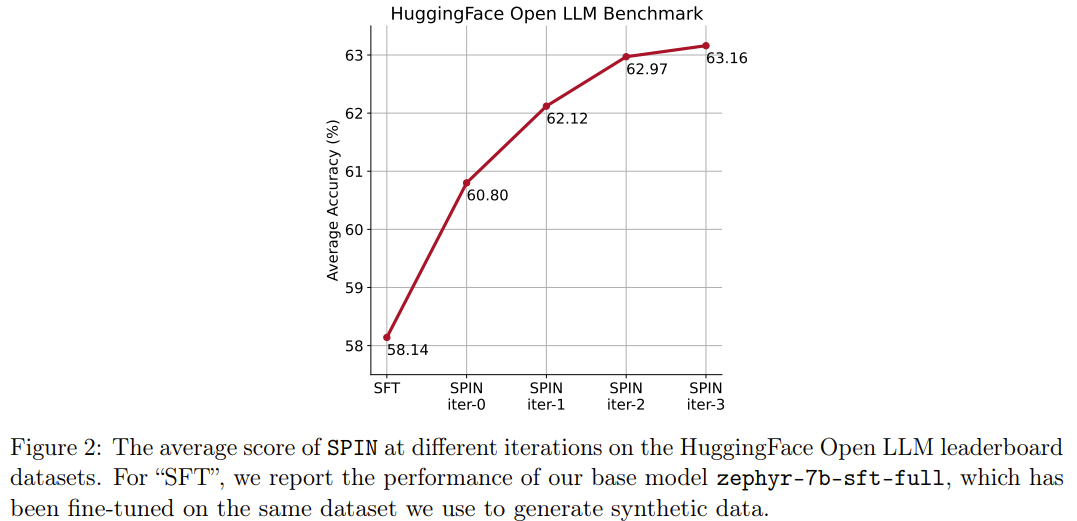

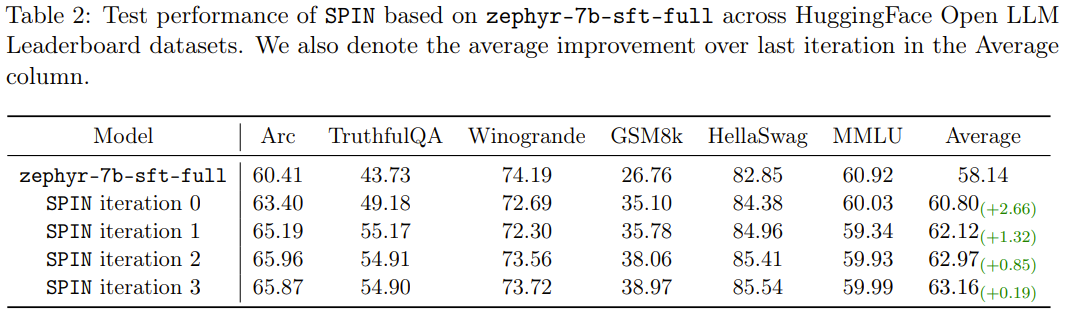

結果表明,新方法能在連續迭代中持續提升 zephyr-7b-sft-full,而作為對比,當在 SFT 數據集 Ultrachat200k 上使用 SFT 方法持續訓練時,評估分數則會達到性能瓶頸,甚至出現下降情況。

更有趣的是,新方法使用的數據集只是 Ultrachat200k 數據集的一個 50k 大小的子集!

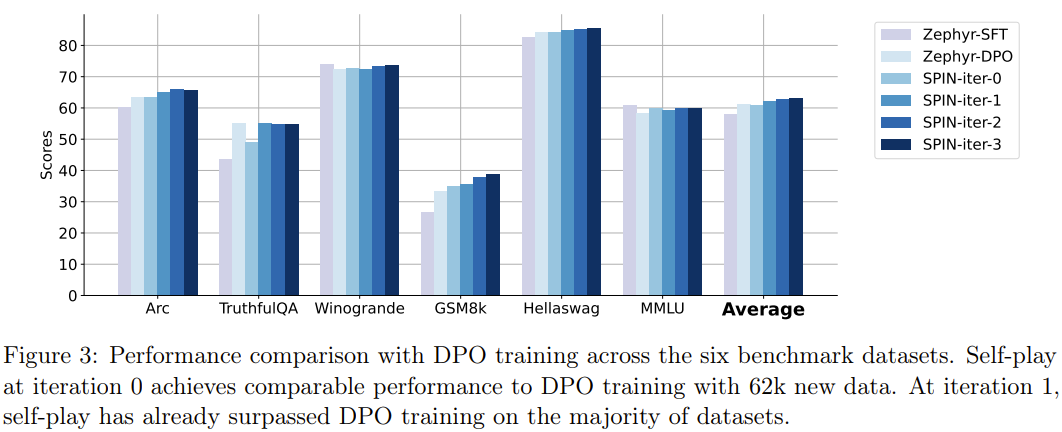

新方法 SPIN 還有另一項成就:可有效地將 HuggingFace Open LLM 排行榜中基礎模型 zephyr-7b-sft-full 的平均分數從 58.14 提升至 63.16,其中在 GSM8k 和 TruthfulQA 上能有超過 10% 的驚人提升,在 MT-Bench 上也可從 5.94 提升至 6.78。

值得注意的是,在 Open LLM 排行榜上,使用 SPIN 微調的模型甚至能與再使用額外 62k 偏好數據集訓練的模型媲美。

結論

通過充分利用人類標注數據,SPIN 讓大模型靠自我博弈從弱變強。與基于人類偏好反饋的強化學習(RLHF)相比,SPIN 使 LLM 能夠在沒有額外人類反饋或者更強的 LLM 反饋的情況下自我改進。在包含 HuggingFace Open LLM 排行榜的多個基準數據集實驗上,SPIN 顯著且穩定地提高了 LLM 的性能,甚至超過了使用額外 AI 反饋訓練的模型。

我們期待 SPIN 可以助力大模型的進化和提升,并最終實現超越人類水平的人工智能。