ChatGPT變笨新解釋:世界被AI改變,與訓練時不同了

對于ChatGPT變笨原因,學術界又有了一種新解釋。

加州大學圣克魯茲分校一項研究指出:

在訓練數據截止之前的任務上,大模型表現明顯更好。

論文重點研究了“任務污染”問題,也就是大模型在訓練時期就見識過很多任務示例,給人一種AI擁有零樣本或少樣本能力的錯誤印象。

也有學者從另一個角度指出,大模型訓練后參數凍結,人們不斷提出新的任務也就是輸入分布不斷變化。如果模型不能不斷適應這種變化,就表現成能力慢慢退化。

人們以為只提了個問題AI就能回答,其實是在訓練時見過大多數常見任務。

隨時間推移,人們開始提出更多新問題,AI表現就不行了。

比如對于代碼問題,編程語言還在持續發展變化,遲早有一天效率會低到不可接受。

這是所有不具備持續學習能力模型的命運。

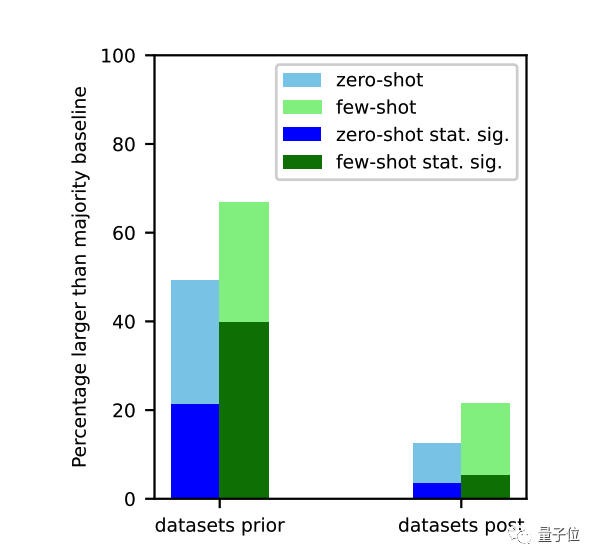

任務污染有多嚴重?

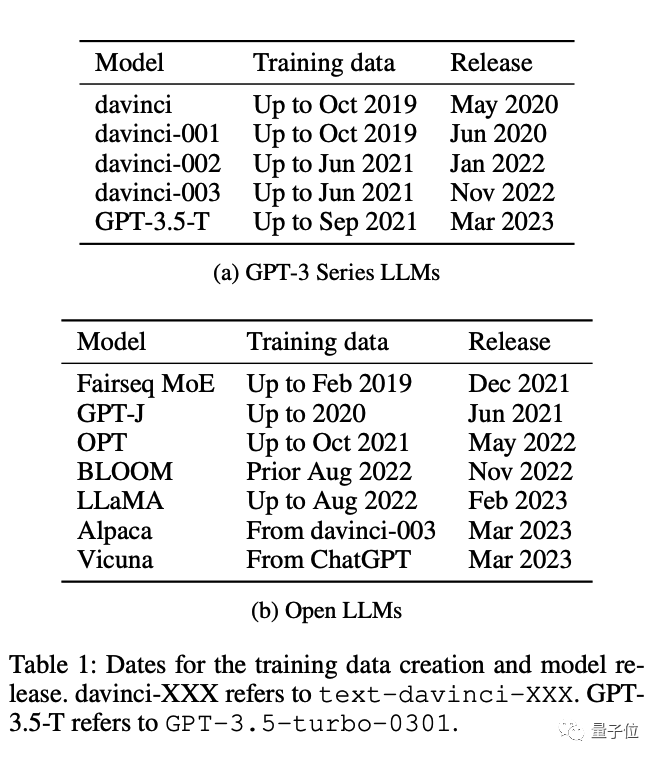

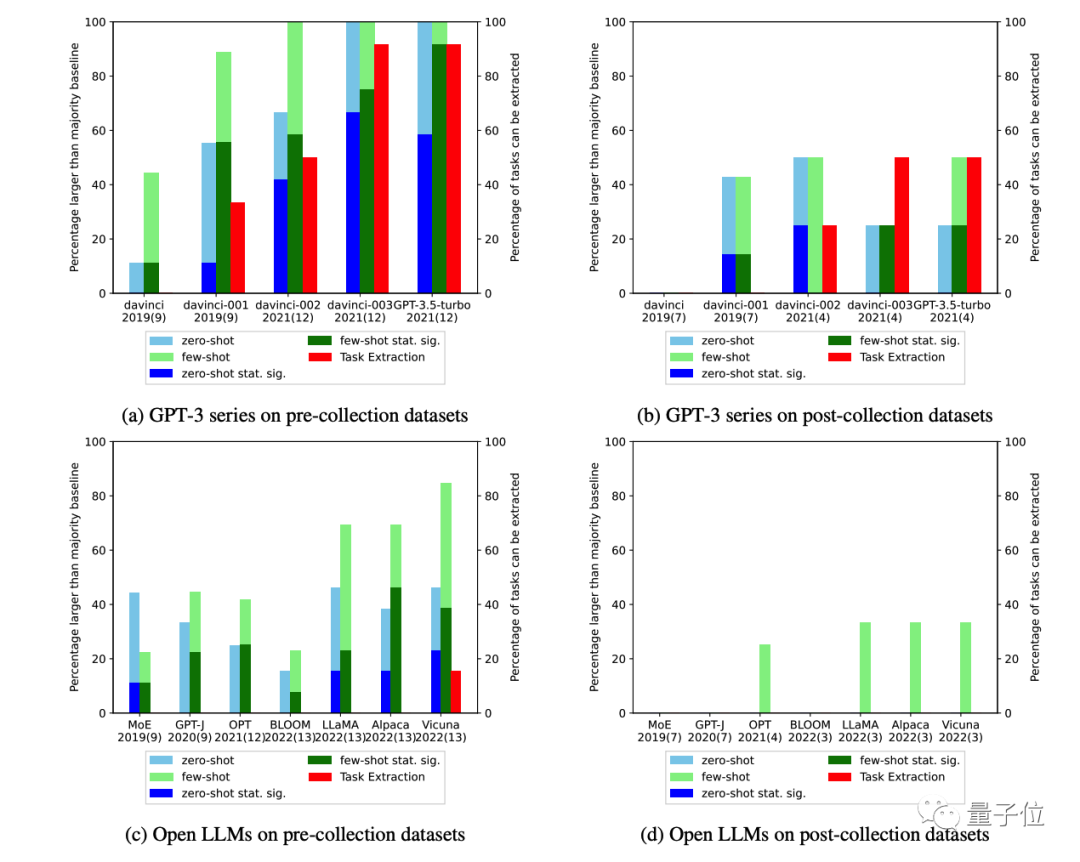

研究團隊一共評估了12種模型,從ChatGPT之前的GPT-3系列、OPT、Bloom,到最新的GPT-3.5-turbo、羊駝家族Llama、Alpaca和Vicuna等。

它們都存在類似問題,也就是在訓練截止之前的任務上表現明顯更好。

評估任務污染非常困難,閉源模型根本不會公布訓練數據,大多數開源模型也只是生命了來源,而不發布數據本身。

如果研究者重新爬取互聯網數據,也有可能與模型訓練時相比發生了變化。

對此,團隊采用4種方法來測量任務污染程度:

- 檢查訓練數據:直接搜索有沒有相應的任務示例

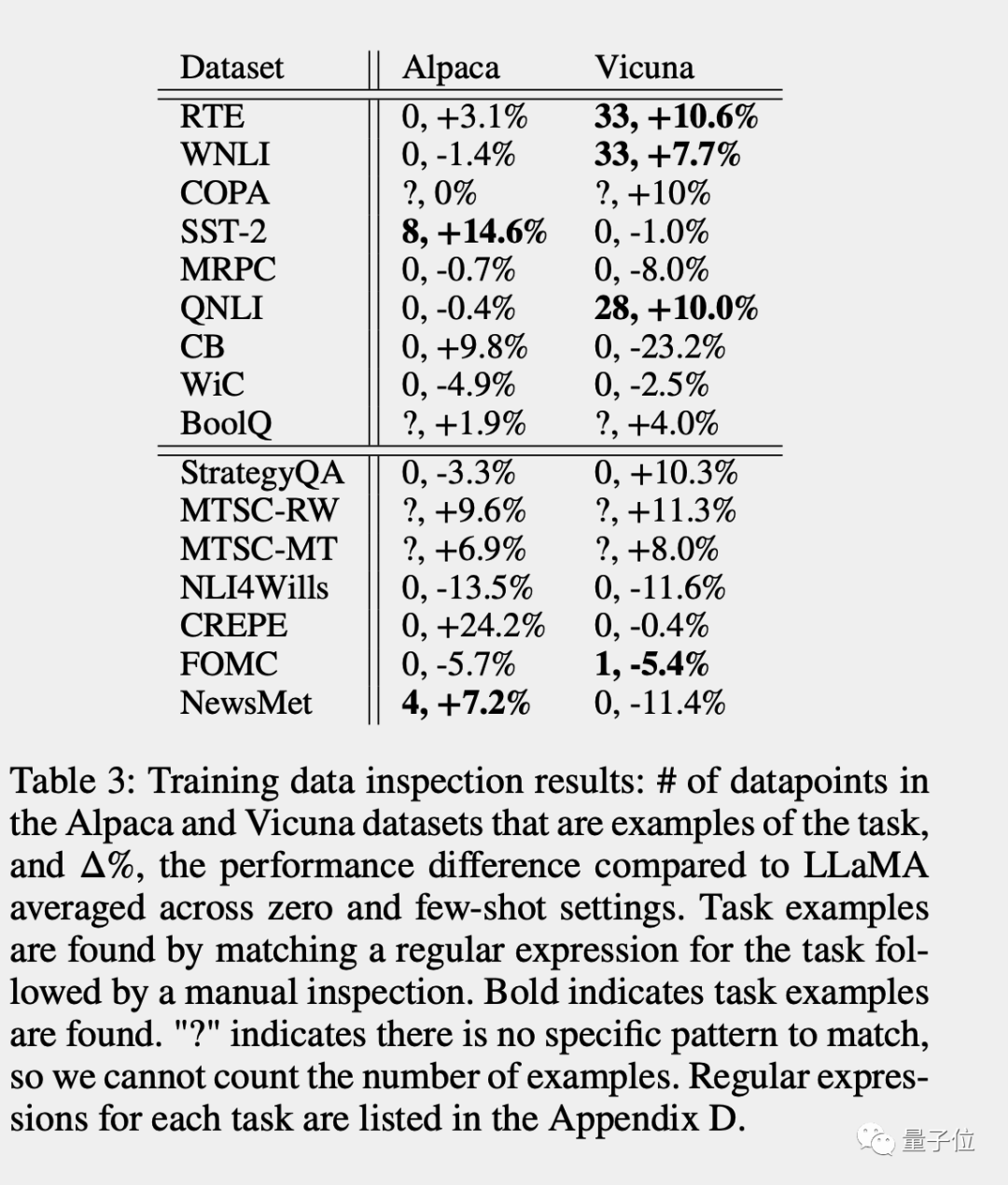

在開源模型Alpaca和Vicuna上,存在訓練數據污染的任務表現就比原版Llama更好的趨勢明顯。

- 提取任務示例:通過調整提示詞,讓模型自己把訓練數據中的任務示例背出來

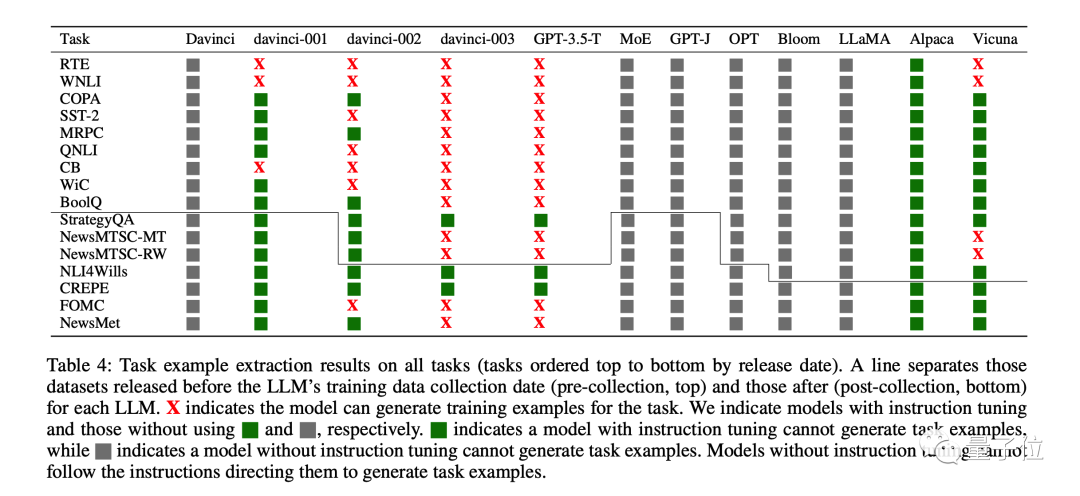

從GPT-3 davinci-001版本到GPT-3.5-Turbo,這個問題越來越嚴重了。

圖中X代表模型復述出了訓練數據數據中的原始任務示例,綠色代表經過指令微調的模型沒有復述訓練數據。

灰色代表未經過指令微調的模型無法根據提示詞指示復述訓練數據,但不代表問題不存在。

- 成員推斷(只適用于生成任務):檢查模型生成的答案是否與原始數據完全相同

- 按時間順序分析:對于已知訓練數據收集時間的模型,測量已知發布時間數據集上的表現并使用按時間順序的證據檢查數據污染證據

前三種方法精度較高,但召回率較低。如果在任務的訓練數據中找到數據,則可以肯定它已經看到了示例。

但由于數據格式的變化、關鍵字的變化以及數據集的大小,使用前三種方法沒有找到證據并不意味著數據污染不存在。

第四種方法召回率高但精度低,容易受干擾因素影響。

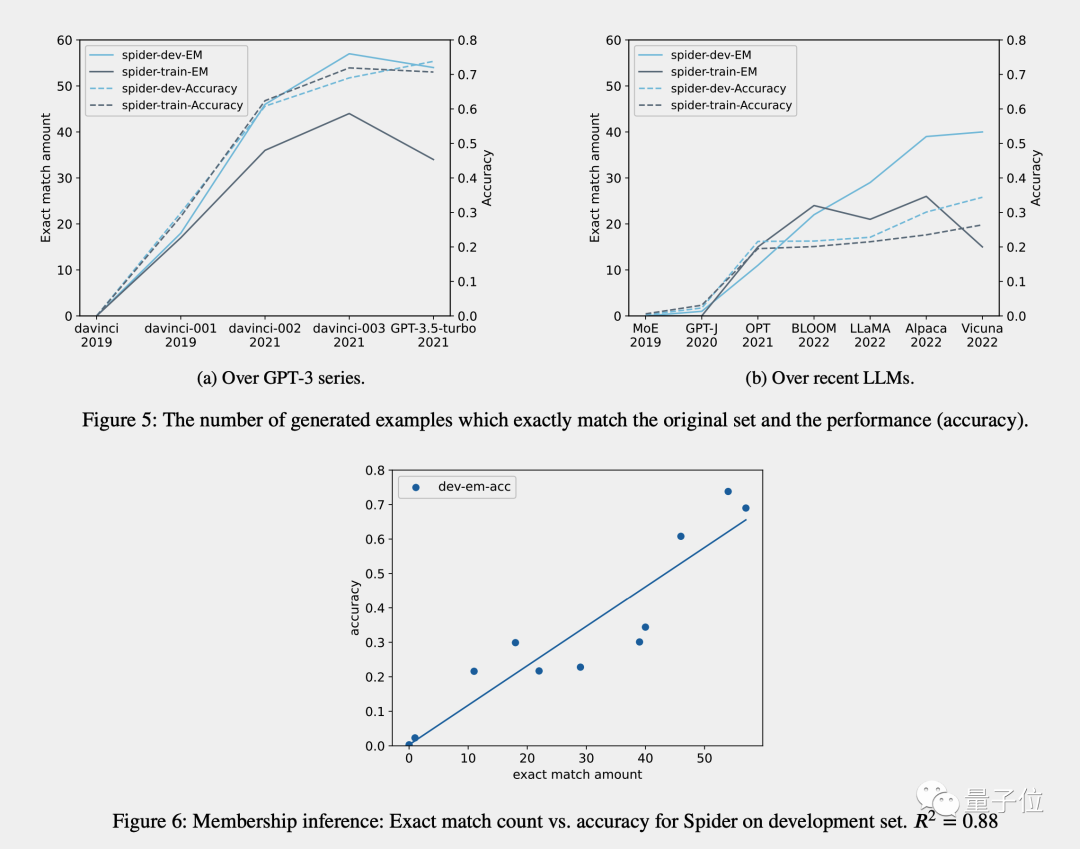

特別是對于GPT-3系列,目前人們假設其能力提高來自于指令微調,但研究團隊認為事實并非如此。

雖然在2021年之前的數據集上,davinci-002比davinci-001的性能有所提高,但在2021年之后的數據集上性能卻相應下降,

通這表明GPT-3系列的指令微調只適用于某些早期數據集。

最后團隊的結論為:

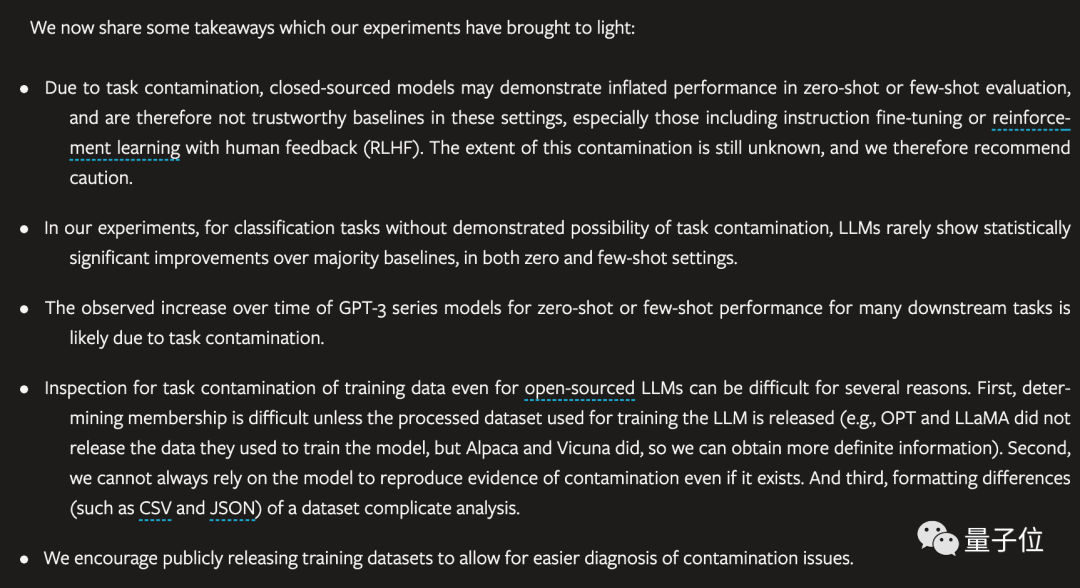

- 由于任務污染,閉源模型可能會在零樣本或少樣本評估中表現的比實際好,特別是經過RLHF微調的模型。污染的程度仍不清楚,因此我們建議謹慎行事。

- 在實驗中,對于沒有任務污染可能性的分類任務,大模型很少在零樣本和少樣本設置中表現出相對于大多數基線具有統計學意義的顯著改進。

- 隨著時間推移,觀察到GPT-3系列模型在許多下游任務的的零樣本或少樣本性能有所增加,這可能是由于任務污染造成的。

- 即使對于開源模型,檢查訓練數據的任務污染也很困難。

- 鼓勵公開發布訓練數據,以便檢查任務污染問題。

有人總結到:

- 用現有數據訓練AI

- 人們過多使用AI,以至于改變了現實世界

- AI無法適應改變后的世界,變得低效

這是一個循環。

論文:https://arxiv.org/abs/2312.16337。

參考鏈接:

[1]https://twitter.com/ChombaBupe/status/1741531065032798360。