2024年最大的坑?基于深度學習的端到端自動駕駛最新綜述

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

寫在前面

最新的端到端自動駕駛綜述剛剛出爐,話說論文一作卡內基梅隆大學的Apoorv Singh今年產出了七篇綜述,都和自動駕駛相關,推薦給大家。就一個字:牛!

個人主頁:https://www.apoorvsingh.com/research-papers

- End-to-end Autonomous Driving using Deep Learning: A Systematic Review

- A Review on Objective-Driven Artificial Intelligence

- Training Strategies for Vision Transformers for Object Detection

- Trajectory-Prediction with Vision: A Survey

- Transformer-Based Sensor Fusion for Autonomous Driving: A Survey

- Surround-View Vision-based 3D Detection for Autonomous Driving: A Survey

- Vision-RADAR fusion for Robotics BEV Detections: A Survey

摘要

端到端自動駕駛是一種完全可微分的機器學習系統,它將原始傳感器輸入數據和其他元數據作為先驗信息,并直接輸出自車的控制信號或規劃軌跡。本文試圖系統地回顧最近所有基于機器學習的技術來實現這一端到端任務,包括但不限于目標檢測、語義場景理解、目標跟蹤、軌跡預測、軌跡規劃、車輛控制、社會行為和通信。本文重點研究了最近的完全可微端到端強化學習和基于深度學習的技術。我們的論文還通過對重要方法進行分組并展示其研究趨勢,建立了它們的分類法。最后,本次調查突出了懸而未決的挑戰,并指出了未來可能的方向,以啟發對該主題的進一步研究。

總結來說,本文的主要貢獻如下:

- 我們為理解端到端自動駕駛方法提供全面的背景知識。首先總結了有史以來第一種應用于自動駕駛任務的技術。此外總結了模塊化自動駕駛問題解決方案的競爭替代方法。還涵蓋了用于端到端自動駕駛任務的評估和基準。

- 接下來,我們將端到端方法分為模仿學習、強化學習、帶輔助任務的端到端自主駕駛和師生范式四個部分,對其進行了廣泛的介紹。此外,在深入討論細節之前,我們用數學建模為讀者介紹了一段理論知識。

- 我們討論了所涵蓋的所有方法和方法的關鍵挑戰,以啟發讀者未來的研究思路。此外,我們還討論了一些開放式研究問題,我們預計這些問題將是端到端自動駕駛研究的下一步。

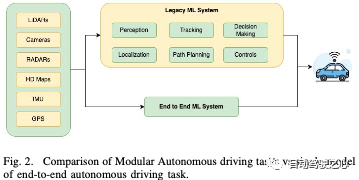

自動駕駛的模塊化方法

傳統的模塊化自動駕駛軟件是一個復雜的系統,包括各種子模塊,每個子模塊負責駕駛過程的特定方面。這些子模塊協同工作,使車輛能夠在無需人工干預的情況下導航、感知環境并做出決策。自動駕駛軟件的一些關鍵子模塊包括:

- 地圖繪制和高精地圖繪制:是指創建和維護道路和周圍環境的詳細、高精地圖。與人類駕駛員使用的傳統導航地圖不同,自動駕駛地圖要詳細得多,并包含對自動駕駛系統的特定需求至關重要的信息。它們包括有關車道邊界、道路曲率、交通標志、交通信號、車道變更規則和道路坡度的信息。高精地圖以厘米級的精度創建,以確保自動駕駛汽車能夠在下游定位堆棧中的環境中準確定位。

- 感知:是指自動駕駛汽車理解和解釋周圍環境的能力。它包括傳感器融合、車輛和行人檢測、像素級分割以及紅綠燈/其他路標檢測等任務。主要是基于多個相機、激光雷達和雷達的傳感器的組合。

- 定位:指的是自動駕駛汽車在其環境中準確確定其位置和方向(位姿)的能力。常見使用的關鍵組件是全球定位系統(GPS)、慣性測量單元(IMU)和通過地圖匹配的感知傳感器,其中包括將傳感器數據與高清地圖進行比較,以完善車輛的位置估計。

- 目標跟蹤:指的是自動駕駛汽車監測物體在其環境中過去運動的能力。這對于在下游任務中進行預測至關重要,過去的狀態對下游任務至關重要。跟蹤對于被遮擋的道路目標至關重要,因為即使在感知中看不到目標,我們仍然可以保持對該目標的期望。跟蹤涉及感知輸出的數據關聯和運動學預測。

- 行為規劃(軌跡預測):指的是自動駕駛車輛預測各種道路使用者(如行人、騎自行車的人、其他汽車甚至動物)未來行動和移動的能力。

- 路徑規劃:它指的是自動駕駛車輛在避開障礙物、遵守交通規則并考慮環境動態的同時,為自動駕駛車輛從當前位置導航到所需目的地確定安全和最佳路徑的能力。基于當前車輛位置、期望目的地以及地圖和傳感器信息,路徑規劃算法生成初步路徑,該初步路徑將車輛連接到目標,同時避開障礙物。成本函數考慮了距離、舒適性、安全性、能源效率和碰撞風險因素。該算法搜索一條將此成本最小化的路徑。模塊化管道中最常見的規劃方法包括使用復雜的基于規則的設計,這在解決駕駛時發生的許多情況時往往無效。

- 決策:指的是自動駕駛車輛在各種交通場景中選擇適當行動和行為的能力,同時優先考慮安全、效率和遵守交通規則。它與路徑規劃密切合作,涉及風險評估、情景分析、行為預測、交通規則和條例、倫理道德考慮等。

- 控制:它指的是將高層決策和計劃軌跡轉化為車輛執行器為物理操縱車輛而采取的具體行動的機制和算法。這些控制裝置可確保車輛沿預定路徑行駛、加速、減速和處理各種駕駛場景,同時保持穩定性、安全性和舒適性。控制彌合了決策和車輛物理行為之間的差距。它包括執行器、車輛動力學、速度控制、穩定性和操控性、平穩過渡、人體舒適性等子部件。

- 仿真和測試:在實際道路上部署之前,評估自動駕駛系統的性能、安全性和功能至關重要。

這些系統及其依賴如圖2所示。

BENCHMARKING/ EVALUATIONS

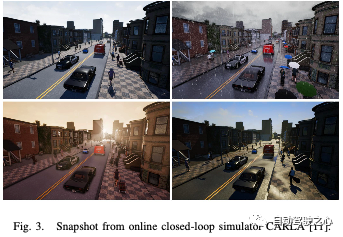

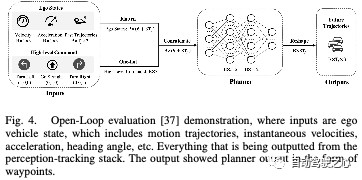

在開發軟件之前,首先要開發測試需求,讓我們在深入研究主要方法之前,先看看端到端系統的評估需求。評估可分為兩種類型:閉環評估和開環評估。前者是在在線仿真器中定義的;然而,前者是在人類駕駛數據集上離線計算的。端到端系統可以在CARLA等在線模擬器上輕松評估;許多模塊化感知技術依賴于更昂貴的離線數據集。

閉環評測如圖3所示。

開環評測如圖4所示。

方法

A.模仿學習

在模仿學習中,智能體通過模仿人類專家或預先存在的模型所展示的行為來學習執行任務。agent不是明確地設計獎勵函數或定義最優策略,而是通過觀察和模仿專家采取的行動來學習。與強化學習相比,模仿學習有幾個優勢,包括利用人類專業知識解決復雜任務的能力,以及提供更安全、更可解釋的行為的潛力,在強化學習中,主體通過試錯進行學習。然而,模仿學習也有局限性,例如對專家演示中的錯誤很敏感,并且不總是能夠探索超出專家演示范圍的新策略。在訓練期間,agent的目標是學習從輸入觀察到專家演示的行動的映射。這通常使用監督學習技術來完成,在監督學習技術中,對agent的模型進行訓練,以最大限度地減少其預測動作與專家數據集中的動作之間的差異。類似地,在評估過程中,根據新的、看不見的數據來評估經過訓練的agent的性能,以確定其模仿專家行為的能力。這種評估可以包括將代理人的行為與專家的行為進行比較,或者評估代理人是否成功完成了任務。模仿學習可以進一步分為Behavior Clone和Inverse Reinforcement Learning。

然而,IRL和模仿學習也有其自身的一系列挑戰和局限性:

- 家行為的模糊性:IRL假設觀察到的專家行為在某些潛在的獎勵函數方面是最優的或接近最優的。然而,現實世界中的專家行為可能是嘈雜的、次優的,或者受到獎勵函數未捕捉到的因素的影響,導致推斷的獎勵函數中的模糊性。

- 解決方案的非唯一性:多個獎勵函數可以解釋同一組觀察到的專家行為。這種非唯一性會使確定哪種獎勵函數是“正確的”獎勵函數具有挑戰性,導致所學習的獎勵函數和后續策略的不確定性。

- 有限的專家演示:IRL在很大程度上依賴于專家演示的質量和數量。如果數據集較小、有偏差或沒有覆蓋廣泛的場景,則學習的獎勵函數可能無法準確地表示真實的底層獎勵結構。

- 維度詛咒:隨著狀態空間變得越來越大、越來越復雜,由于維度詛咒,從有限的專家數據中準確恢復獎勵函數的能力變得越來越困難。高維狀態空間需要大量的數據來捕捉獎勵函數的復雜性。

- 計算復雜性:許多IRL算法涉及計算成本高昂的優化問題,尤其是在處理大的狀態空間或復雜的獎勵函數時。

- 缺乏探索:IRL專注于從專家演示中學習,并沒有本質上提供探索專家演示之外的新策略的機制。這可能會限制代理人發現更有效或更具創造性的解決方案的能力。

- 轉移到新環境:習得的獎勵函數通常是特定于推斷它們的環境的。由于動力學、狀態空間和其他因素的差異,將學習到的獎勵函數轉移到一個新的、看不見的環境可能具有挑戰性。

B.強化學習

在強化學習中,智能體學習如何在環境中做出決策和行動,以最大化累積獎勵信號。在自主智能體的背景下,RL為這些智能體提供了一種通過試錯學習來學習如何在沒有明確編程的情況下執行任務和做出決策的方法。自主主體是RL框架中的學習者。它與環境相互作用,并采取行動實現某些目標。環境是代理與之交互的外部系統。它根據代理人的行為通過獎勵向代理人提供反饋。在每個時間步長,環境都處于特定狀態,這表示環境當前條件的快照。代理根據操作的當前狀態選擇操作。行為會影響環境,使其轉變為一種新的狀態,并獎勵代理人。環境在每個動作之后向代理提供數字獎勵信號,指示動作的直接收益或成本。代理的策略是一種將狀態映射到操作的策略。代理的目標是學習一種最優策略,使隨著時間的推移累積獎勵最大化。值函數估計代理在遵循特定策略的同時,從給定狀態可以實現的預期累積回報。它有助于代理人在知情的情況下決定采取哪些行動。代理使用RL算法通過試錯來學習最優策略或值函數。學習過程包括探索環境、獲得獎勵和調整政策以提高績效。代理人面臨著探索新動作以發現潛在的更好策略(探索)和利用已知動作以最大限度地獲得即時回報(利用)之間的權衡。然而,自主智能體的RL也面臨著挑戰,如高效探索、長期獎勵和在現實世界環境中的安全學習。強化學習方法可進一步細分為以下幾個子領域:

- Value Based RL;

- Policy Based RL;

- Actor-Critic RL

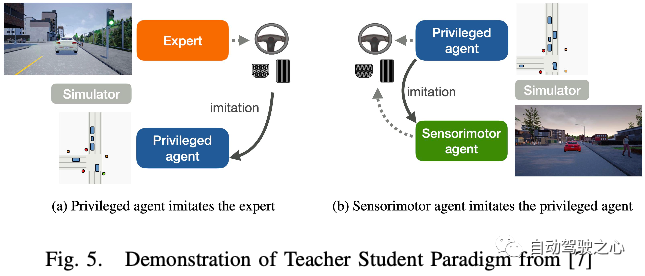

C.Teacher Student范式

端到端自主駕駛的最先進方法遵循師生范式。教師模型,如CARLA,使用特權信息(周圍代理和地圖元素的基本狀態)來學習駕駛策略。學生模型只能訪問原始傳感器數據,并對教師模型收集的數據進行行為克隆。

D.帶輔助任務的端到端自動駕駛

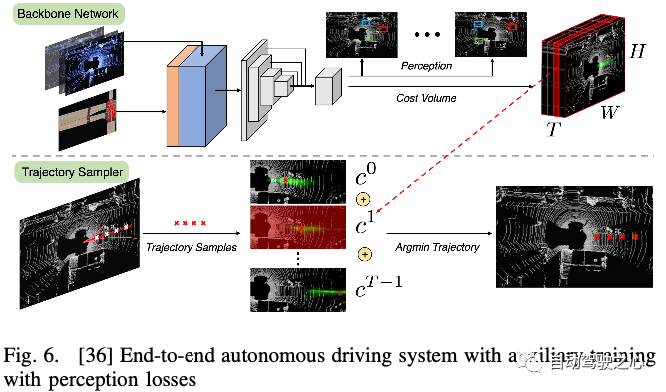

通常,人們普遍認為,用于軌跡規劃的學習控制輸出/路點可能過于復雜,無法從傳感器數據的數十億個參數中進行映射。這導致研究人員開發輔助任務來監督端到端的學習任務,正如我們之前在中看到的那樣,感知和規劃模塊分兩個階段進行訓練。Uber ATG在論文中介紹了另一種更離散的方法,他們使用以激光雷達數據和地圖為輸入的主干來學習端到端可解釋的運動規劃器。首先,他們輸出其他參與者的邊界框,用于未來的時間步(感知)和使用T過濾器進行規劃的成本量。接下來,對于來自采樣器的每個軌跡建議,從成本體積的不同濾波器中索引其成本,并將其相加。成本最低的軌跡將是我們的最終規劃,如圖6所示。他們使用多任務訓練,從檢測、運動預測和人類驅動的自車軌跡進行監督。請注意,沒有對成本量進行監督。因此,他們采用最大邊際損失來推動網絡學習區分好軌跡和壞軌跡。

開放的挑戰和未來趨勢

考慮到所討論方法中的挑戰,并從機器學習的多學科領域獲得靈感,我們發現了未來研究人員的潛在研究方向:

- 端到端協作任務:已經有關于協作感知的研究,其中從附近的自動駕駛汽車聯合進行感知,以處理遮擋并擴大檢測范圍。端到端自動駕駛任務也有類似的概念。隨著越來越多的自動駕駛汽車公司在城市中部署車隊,這種端到端的協作任務可能成為該領域SOTA方法的下一個范例。

- 使用擴散模型基于文本需求生成場景:自動駕駛汽車經過訓練,在通用場景中運行良好;一個尚未解決的主要挑戰是長尾問題,我們無法在模擬器中對其進行廣泛建模。最近,使用穩定擴散方法的圖像生成模型取得了很好的結果;很高興看到未來的研究人員利用這項技術來構建更真實的模擬場景。自動駕駛的端到端任務可以在端到端的任務中進行訓練,其中擴散模型自動生成自動駕駛汽車故障案例的相似場景。然后,我們可以在那些精心挑選的模擬場景上進行訓練,直到我們的模型在真實世界的指標上如預期那樣進行預測。

- 基礎模型:最近,計算機視覺和大語言中的基礎模型在多樣化的大規模數據集上進行訓練后,顯示出了最先進的性能,并且可以適應廣泛的任務(駕駛場景)。研究人員可以利用這些模型將端到端任務的能力從模擬器推廣到現實生活中的數據。

結論

總之,本文對快速發展的端到端自動駕駛領域進行了全面的探索。從傳統的模塊化方法到端到端學習的范式轉變概念的歷程已經闡明,展示了從handcrafted的功能和復雜的管道到允許車輛直接從原始傳感器輸入中學習的數據驅動解決方案的轉變。討論涵蓋了這種方法的優勢和挑戰,強調了它在簡化系統設計、捕捉復雜交互和適應不同駕駛場景方面的潛力。隨著這一領域的不斷成熟,該論文討論了安全保證、監管框架的重要性,以及學術界、工業界和政策制定者之間合作的必要性。發現了一些懸而未決的挑戰,如極端場景下的安全性、遷移學習、可解釋性、人際互動和高效探索,邀請研究人員和從業者共同為塑造自動駕駛的未來做出貢獻。

從本質上講,這篇綜述文章展示了端到端的自動駕駛不僅僅是一次技術飛躍;這是一種范式轉變,體現了機器學習、機器人和運輸工程的融合。未來的道路充滿了令人興奮的機遇和復雜的挑戰,需要跨學科的努力來實現安全、高效和可靠的自動駕駛汽車的愿景,使其能夠無縫地在我們的現代道路上行駛。

原文鏈接:https://mp.weixin.qq.com/s/i1axGn7_szdHqxDqRO9NCw