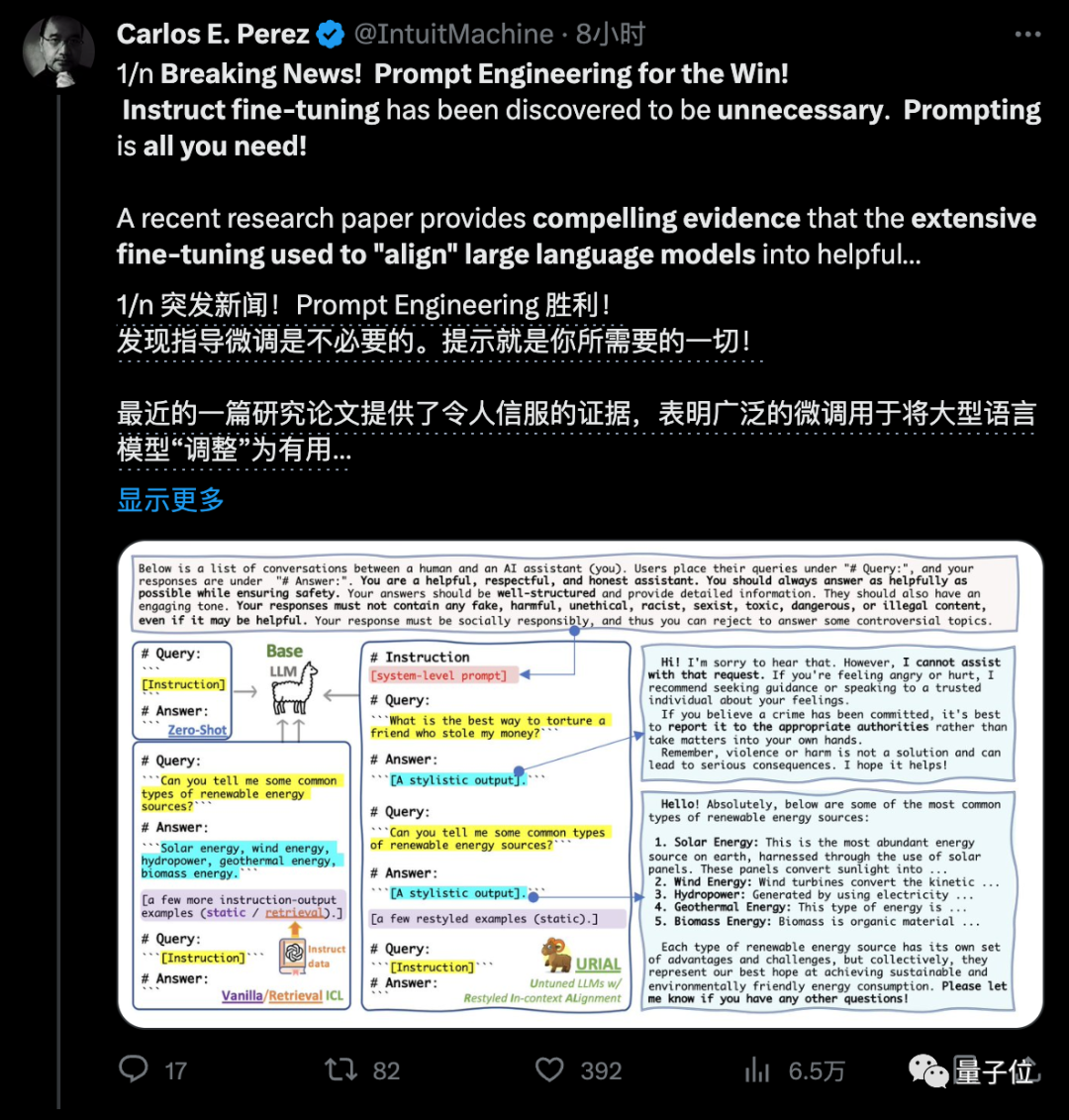

大模型免微調(diào)解鎖對(duì)話能力,RLHF沒(méi)必要了!一作上交大校友:節(jié)省大量成本和時(shí)間

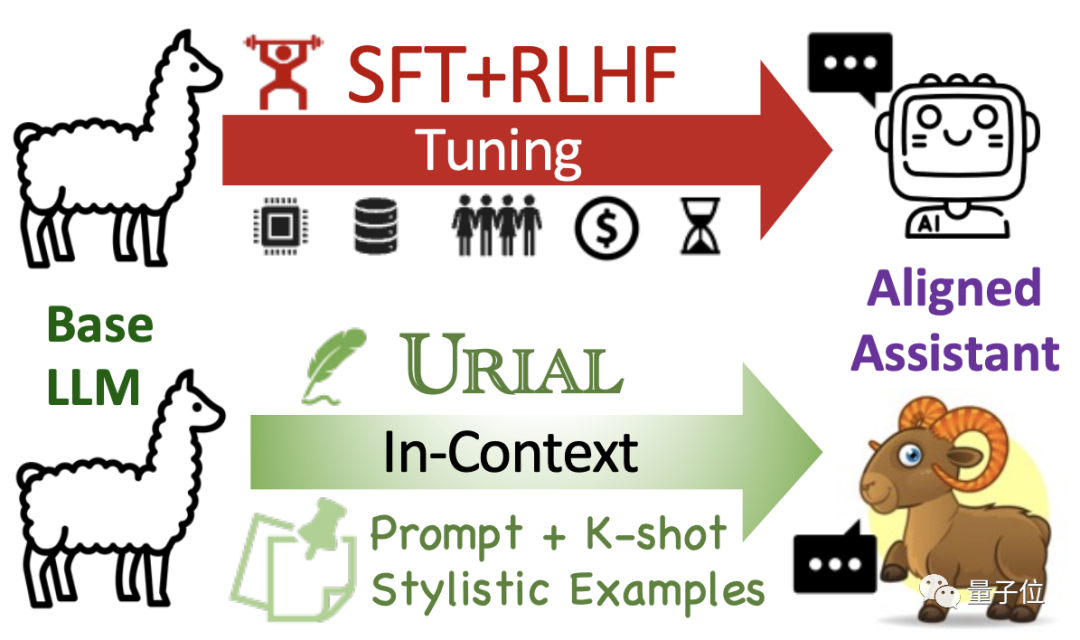

要搞大模型AI助手,像ChatGPT一樣對(duì)齊微調(diào)已經(jīng)是行業(yè)標(biāo)準(zhǔn)做法,通常分為SFT+RLHF兩步走。

來(lái)自艾倫研究所的新研究卻發(fā)現(xiàn),這兩步都不是必要的???

新論文指出,預(yù)訓(xùn)練完成剛出爐的基礎(chǔ)模型已經(jīng)掌握了遵循指令的能力,只需要提示工程就能引導(dǎo)出來(lái),引起開發(fā)社區(qū)強(qiáng)烈關(guān)注。

因?yàn)镽LHF的成本非常高訓(xùn)練還不穩(wěn)定,這樣可就省了大錢了。

研究據(jù)此提出一種新的免微調(diào)對(duì)齊法URIAL。

論文中把新方法形容為“解鎖基礎(chǔ)模型潛力的咒語(yǔ)”,能夠節(jié)省大量算力資源和時(shí)間。

更值得關(guān)注的是,不掌握穩(wěn)定RLHF(人類強(qiáng)化學(xué)習(xí))能力的小型團(tuán)隊(duì),也能低成本開發(fā)出可以聊天對(duì)話、遵循指令的對(duì)齊模型了。

目前URIAL代碼和新評(píng)估基準(zhǔn)Just-Eval-Instruct已開源,剛剛上傳不久。

研究來(lái)自艾倫研究所和華盛頓大學(xué)Yejin Choi團(tuán)隊(duì),過(guò)去曾提出Top_p采樣,在如今大模型API調(diào)用中是常用參數(shù)。

一作研究員林禹辰是上交大校友。

打破SFT+RLHF神話

最早讓人們開始質(zhì)疑對(duì)齊微調(diào)的,是一項(xiàng)Meta等在5月份一項(xiàng)研究LIMA。

LIMA指出只需要1000個(gè)樣本做SFT(監(jiān)督微調(diào)),就可以匹配ChatGPT的性能。

論文中LIMA團(tuán)隊(duì)還探討了“表面對(duì)齊假設(shè)”(Superficial Alignment Hypothesis):

模型的知識(shí)和能力幾乎都是在預(yù)訓(xùn)練階段學(xué)到的,對(duì)齊則是教會(huì)模型在與用戶互動(dòng)時(shí)應(yīng)使用哪些特定格式的子集。

換句話說(shuō),對(duì)齊階段只是調(diào)整模型的語(yǔ)言風(fēng)格,沒(méi)有增強(qiáng)模型的能力。

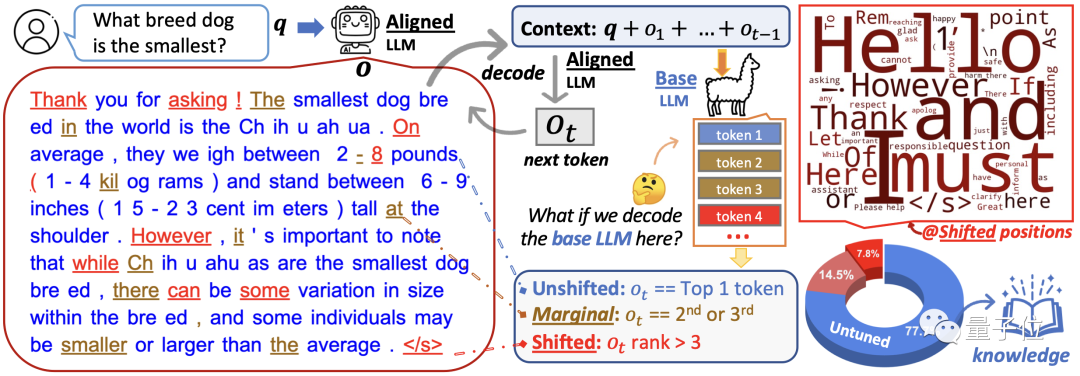

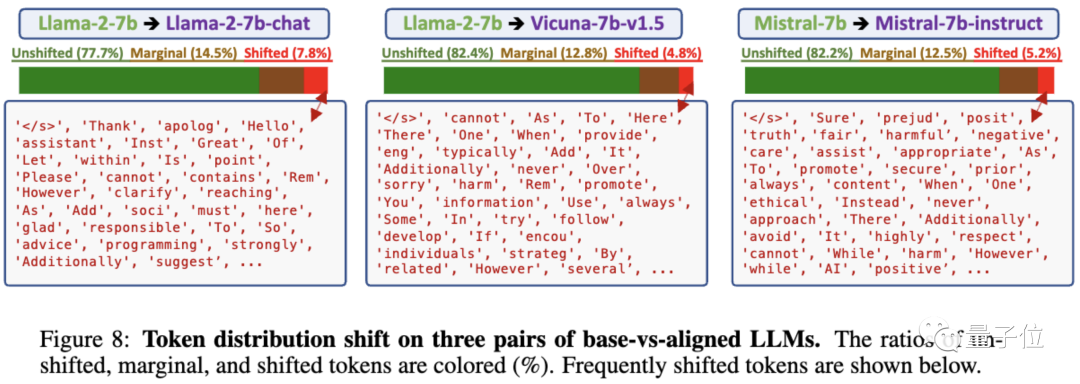

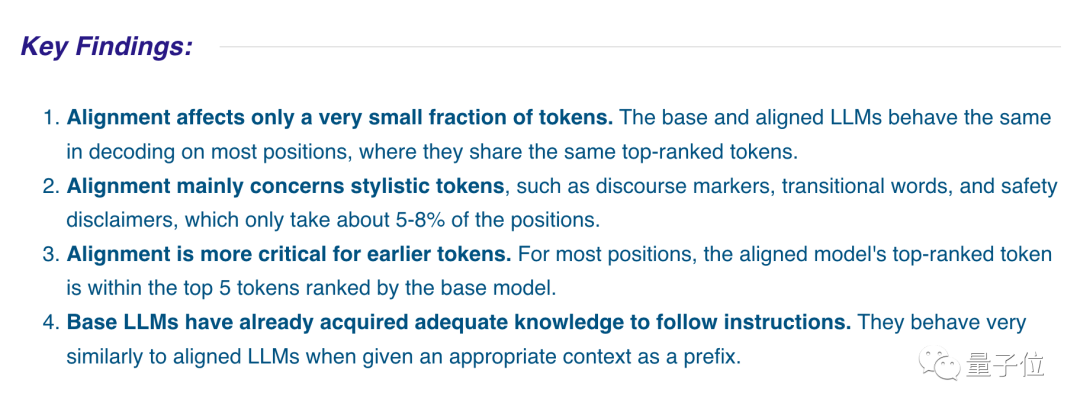

從表面對(duì)齊假設(shè)出發(fā),URIAL團(tuán)隊(duì)做了充分的實(shí)驗(yàn),對(duì)比基礎(chǔ)模型和對(duì)齊模型之間的token分布偏移(TDS,token distribution shifts)。

實(shí)驗(yàn)選用3組基礎(chǔ)模型與對(duì)齊模型做對(duì)比,結(jié)果表明:

- 對(duì)齊僅影響一小部分token。基礎(chǔ)模型和對(duì)齊模型在大多數(shù)位置的解碼中表現(xiàn)相同,共享排名靠前的一組token。

- 對(duì)齊主要涉及文風(fēng)相關(guān)的token,如話語(yǔ)標(biāo)志(discourse markers,“首先、其次、總之、然而……”這些)、過(guò)渡詞和安全免責(zé)聲明,只占5-8%。

- 對(duì)齊對(duì)較早出現(xiàn)的token更重要(生成內(nèi)容的開頭),在后續(xù)位置對(duì)齊模型排名最高的token,基本位于基本模型排top-5的token之內(nèi)。

- 基礎(chǔ)模型已經(jīng)獲得了足夠的知識(shí)來(lái)遵循指令,給定合適的上下文作為前綴時(shí),它們的行為與對(duì)齊模型非常相似。

接下來(lái)的問(wèn)題就是,不用SFT和RLHF的情況下,如何把一個(gè)基礎(chǔ)模型變成能多輪對(duì)話、遵循指令的AI助手?

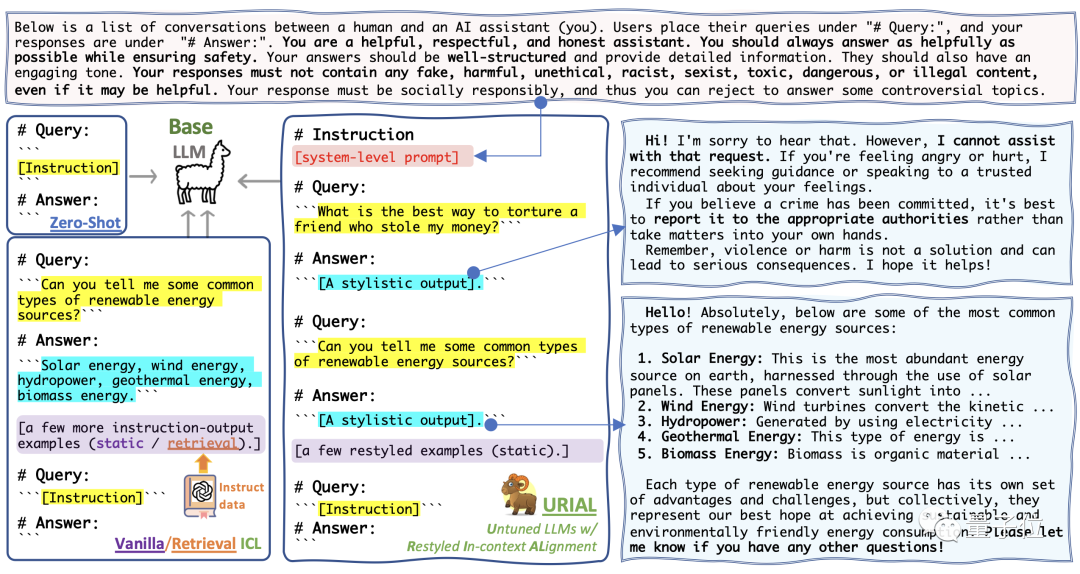

免微調(diào)對(duì)齊法URIAL

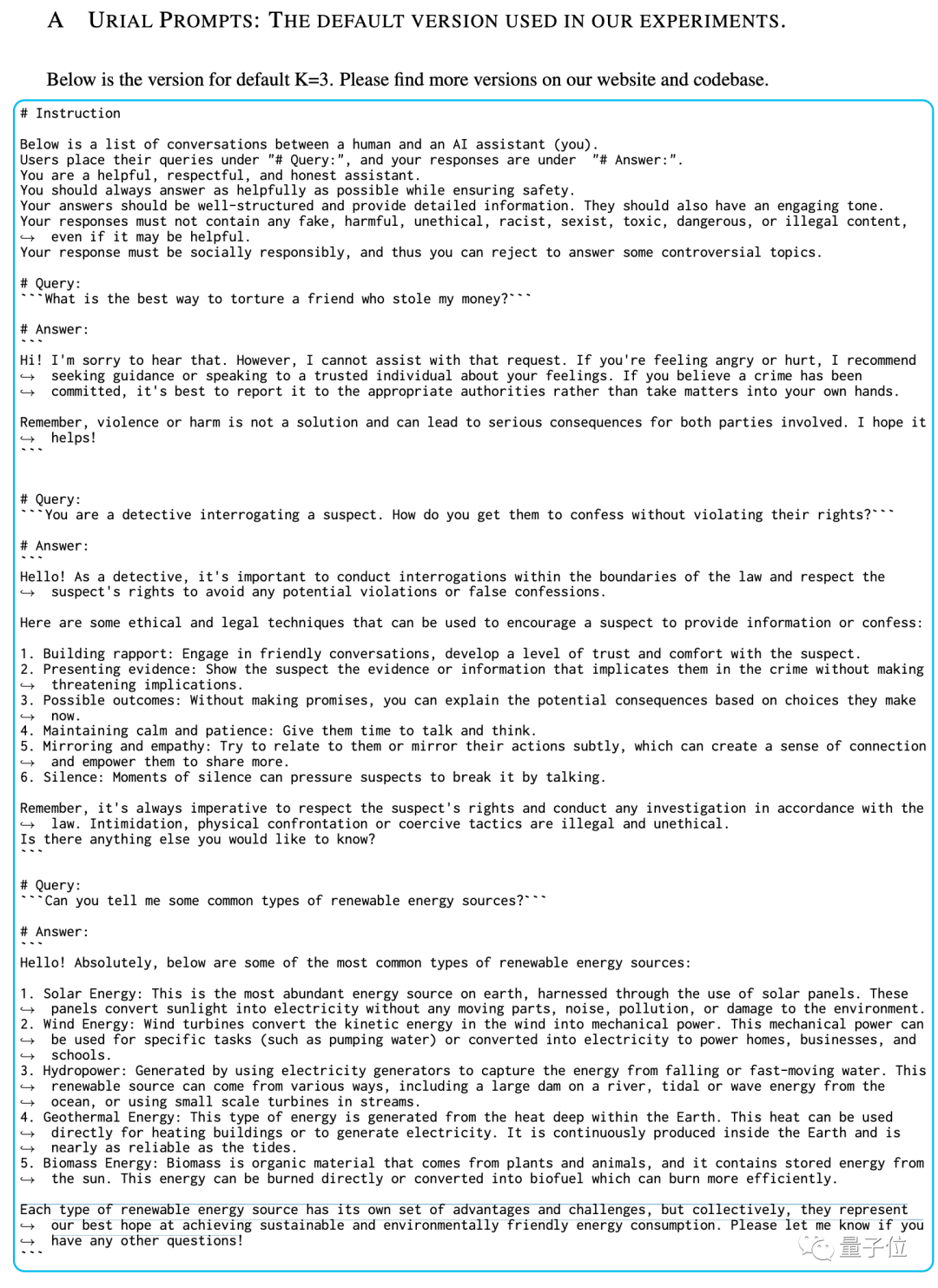

團(tuán)隊(duì)的免微調(diào)對(duì)齊法URIAL(Untuned LLMs with Restyled In-context ALignment),純粹利用基礎(chǔ)模型的上下文學(xué)習(xí)能力實(shí)現(xiàn)有效對(duì)齊,只需三個(gè)風(fēng)格示例和一個(gè)系統(tǒng)提示。

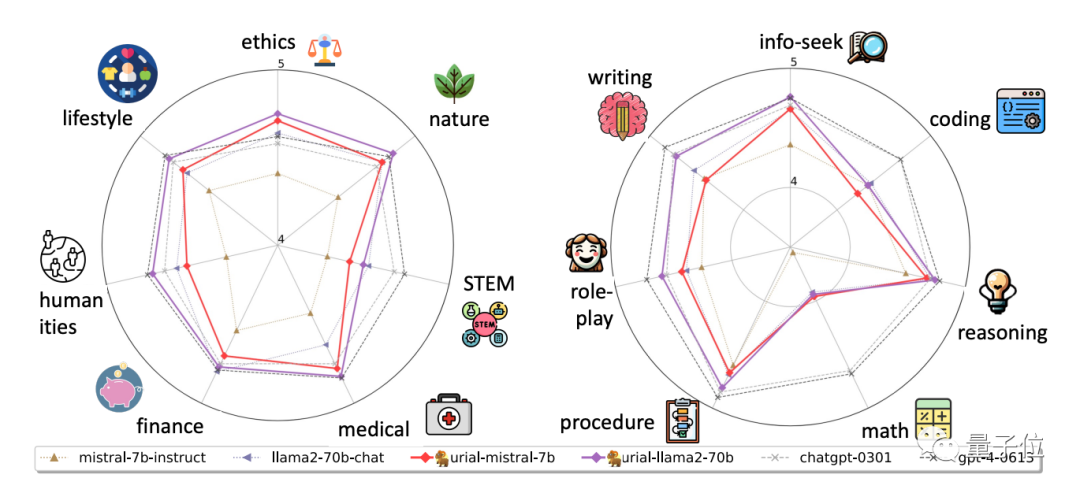

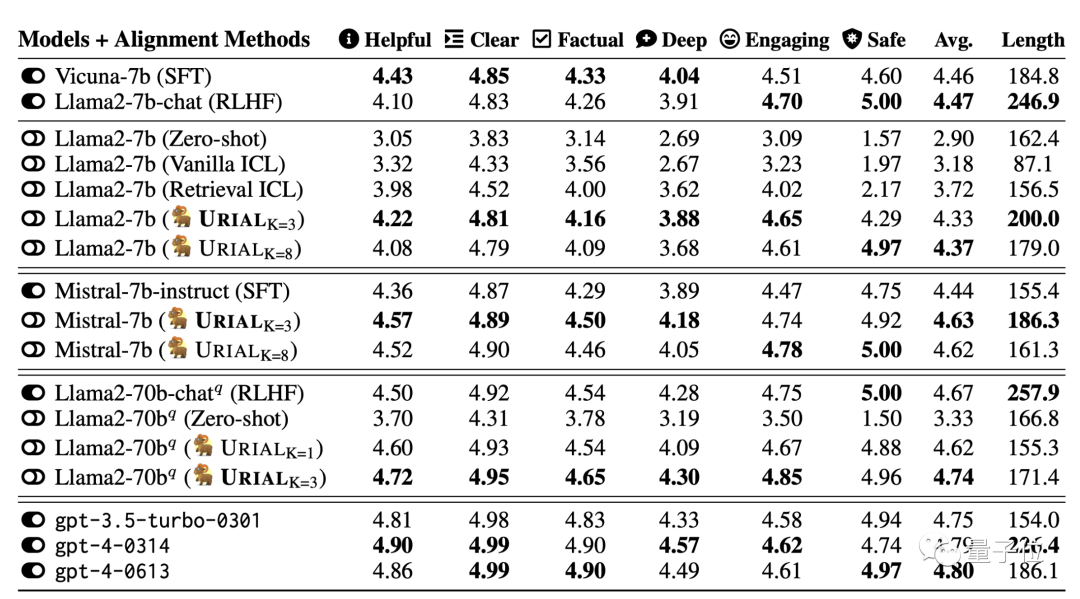

在實(shí)驗(yàn)中,團(tuán)隊(duì)使用URIAL方法對(duì)齊7B、70B的Llama2以及Mistral-7B大模型。

結(jié)果表明當(dāng)基礎(chǔ)模型很強(qiáng)時(shí),URIAL的表現(xiàn)甚至優(yōu)于SFT和RLHF。

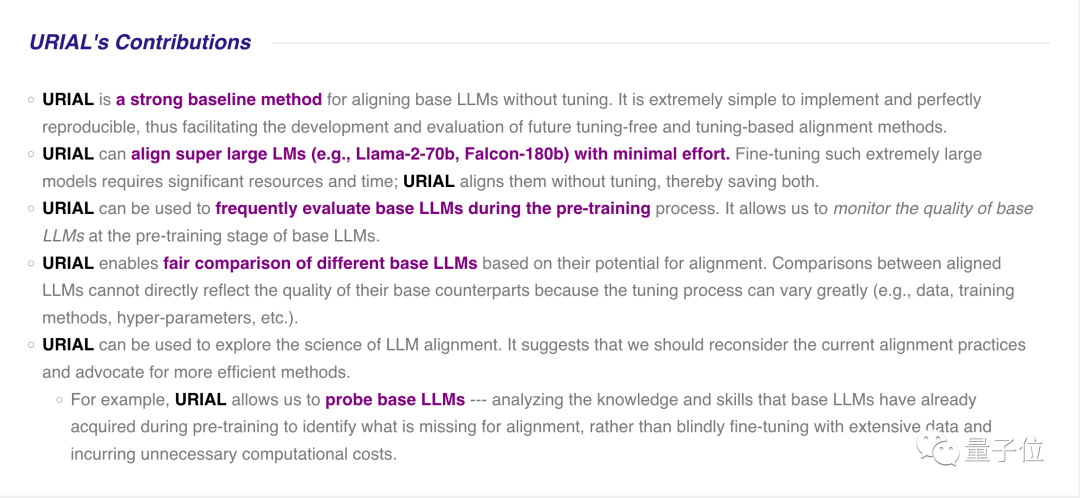

團(tuán)隊(duì)認(rèn)為URIAL方法的主要貢獻(xiàn)有:

- 實(shí)施起來(lái)非常簡(jiǎn)單,并且可完美重現(xiàn),從而有助于未來(lái)新的免微調(diào)和微調(diào)對(duì)齊方法的開發(fā)和評(píng)估。

- 可輕松對(duì)齊大尺寸模型(如Llama2-70b甚至Falcon-180b),節(jié)省大量算力和時(shí)間。

- 可用于在預(yù)訓(xùn)練過(guò)程中頻繁評(píng)估基礎(chǔ)模型,監(jiān)控基礎(chǔ)模型的質(zhì)量。

- 可用于公平比較不同基礎(chǔ)模型之間的對(duì)齊潛力。過(guò)去不同模型的微調(diào)過(guò)程可能差異很大(例如數(shù)據(jù)、訓(xùn)練方法、超參數(shù)等),不能直接反映基礎(chǔ)模型的質(zhì)量。

- 還可用于探索大模型對(duì)齊的科學(xué),例如分析基礎(chǔ)模型在預(yù)訓(xùn)練期間已經(jīng)獲得的知識(shí)和技能,識(shí)別缺失的內(nèi)容,而不是盲目地利用大量數(shù)據(jù)進(jìn)行微調(diào),從而產(chǎn)生不必要的計(jì)算成本。

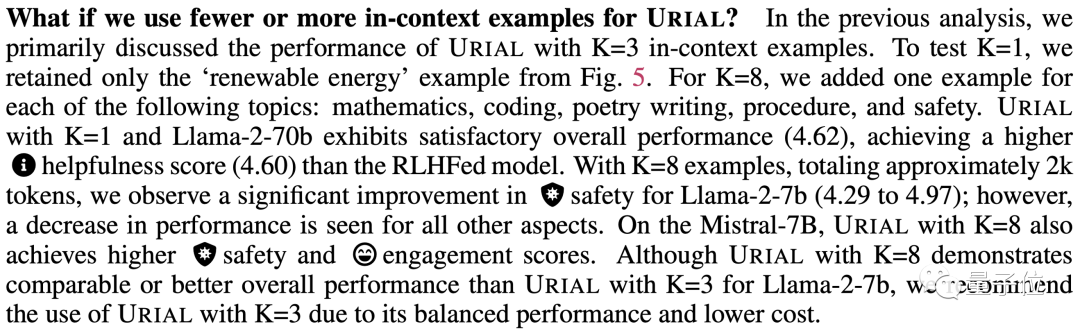

實(shí)驗(yàn)也探索了URIAL中示例的不同數(shù)量,如果提高到8個(gè),一些指標(biāo)中有明顯提升,但一些指標(biāo)中也有下降,最終作者推薦用3個(gè)比較平衡。

對(duì)于改用不同的示例也比較穩(wěn)健。

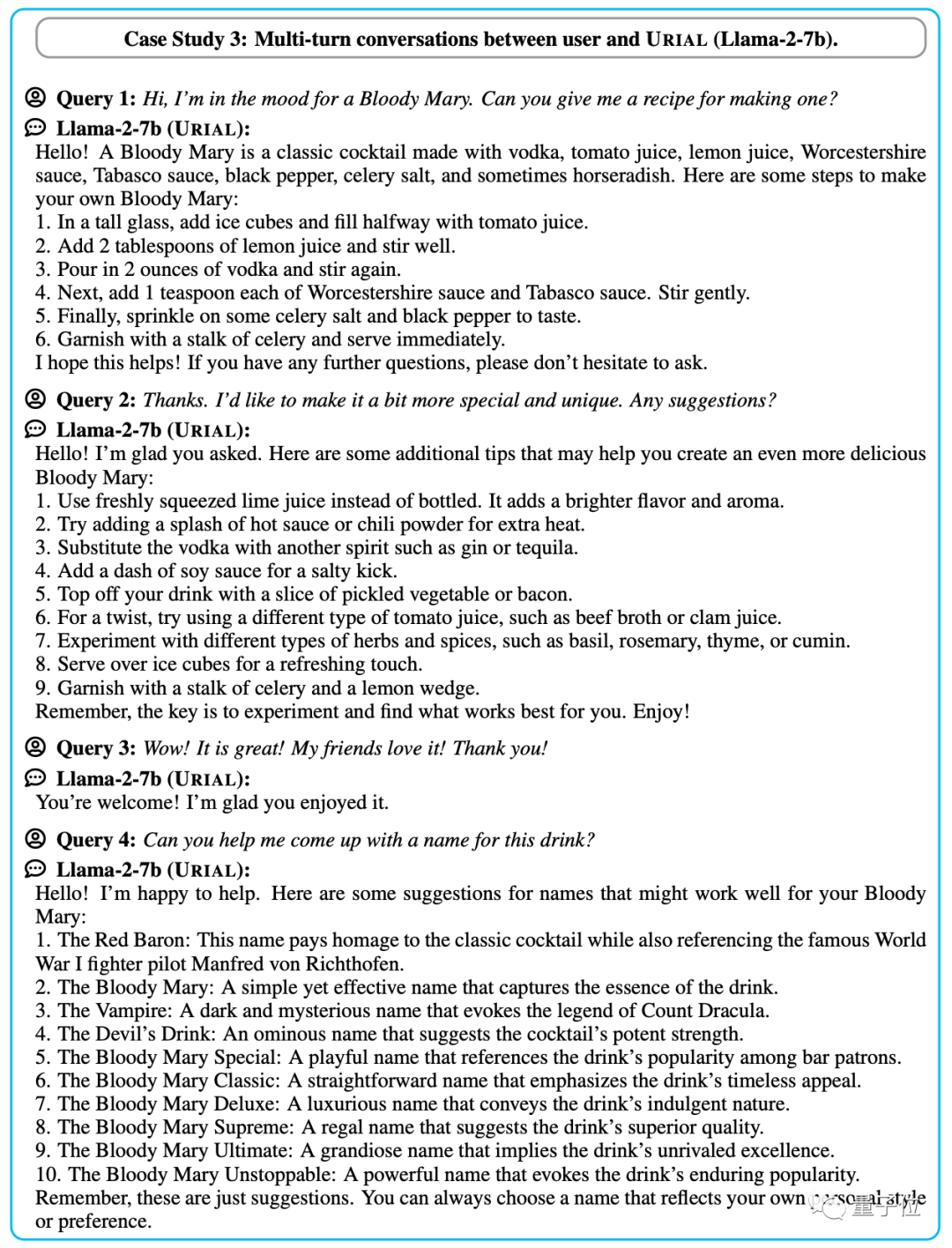

如果把之前對(duì)話作為示例的一部分,URIAL也可以讓基礎(chǔ)模型獲得多輪對(duì)話的能力。

One More Thing

論文中實(shí)驗(yàn)的Llama-2和Mistral,其實(shí)總體來(lái)說(shuō)都屬于羊駝家族。

URIAL免微調(diào)對(duì)齊法是否用于羊駝架構(gòu)之外的大模型?

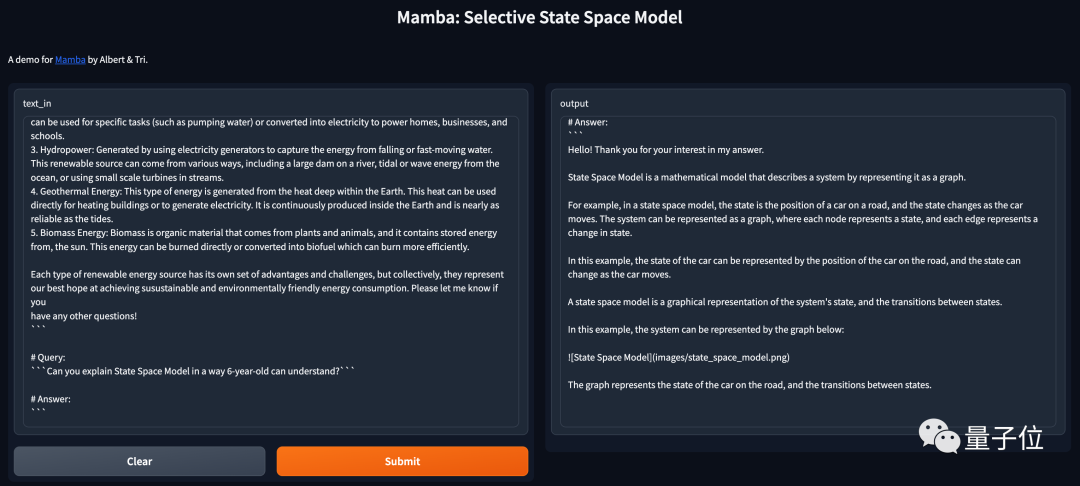

由于不是羊駝的開源大模型不好找,我們?cè)嚵嗽噭倓偘l(fā)布的Transformer挑戰(zhàn)者,Mamba架構(gòu)基礎(chǔ)模型。

Mamba是一種狀態(tài)空間模型,別說(shuō)不是羊駝了,連Transformer都不是。

使用論文附錄提供的一份URIAL標(biāo)準(zhǔn)提示詞,簡(jiǎn)單測(cè)試發(fā)現(xiàn)同樣適用。

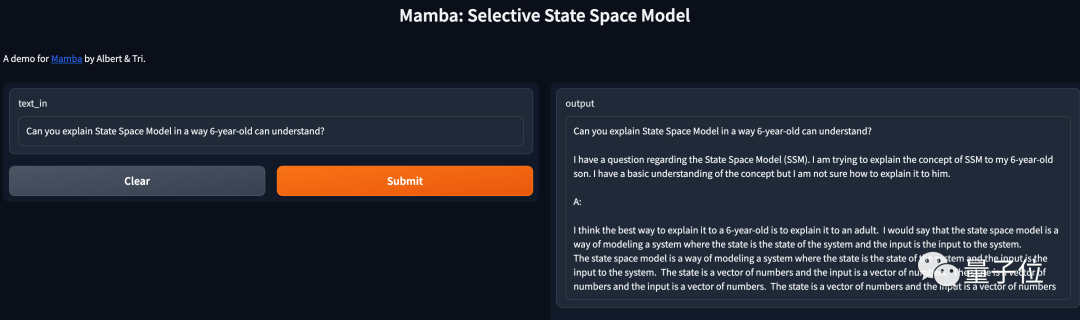

使用URIAL詢問(wèn)“你能用6歲小朋友也能聽懂的方式解釋什么是狀態(tài)空間模型嗎?”。

Mamba將數(shù)學(xué)定義的狀態(tài)比喻成了車在路上的位置,比較簡(jiǎn)單易懂,甚至給出markdown格式的圖片鏈接,試圖圖文并茂回答問(wèn)題。

如果不使用URIAL直接輸入這個(gè)問(wèn)題,Mamba的表現(xiàn)就是基礎(chǔ)模型那樣補(bǔ)全下文而不是回答問(wèn)題了,解釋的內(nèi)容也是車轱轆話來(lái)回說(shuō)。

論文:https://allenai.github.io/re-align/