Casetext如何使用人工智能為法律行業(yè)賦能

人類和人工智能——發(fā)揮各自的優(yōu)勢

Casetext 目前在我們業(yè)務(wù)的許多領(lǐng)域都采用了人工智能技術(shù),我們將繼續(xù)部署研究實驗室的最新進展。在Casetext,我們在系統(tǒng)設(shè)計方面的指導(dǎo)原則是讓人類和機器分別完成最適合的任務(wù)。通過在實踐中應(yīng)用這一原則,我們的后端數(shù)據(jù)管道將人工智能驅(qū)動的過濾與人工專家審查相結(jié)合,我們的前端面向用戶的服務(wù),如 CARA AI,會顯示最相關(guān)的信息,然后我們的用戶可以消化這些信息并用于制定論點。

CARA AI 是我們面向用戶的旗艦 AI 產(chǎn)品。關(guān)于其內(nèi)部工作原理的討論值得單獨討論,但我們 Casetext 也在將 AI 整合到我們運營的更多領(lǐng)域,我們將討論我們在過去一年中使用 AI 的一些新領(lǐng)域。

類似問題

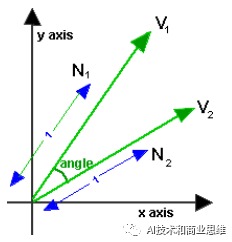

對于我們的類似問題功能,我們使用一種技術(shù)將一段法律文本轉(zhuǎn)換為高維向量——代表該段落的數(shù)字列表,可以將其視為坐標系內(nèi)具有一定長度和方向的直線。在二維中,向量如下所示:

我們用來表示一段文本的向量的維數(shù)比二維多得多,但是,在這個高維空間中,我們用于操作二維向量的某些數(shù)學(xué)技術(shù)仍然成立。通過這些技術(shù),相似的通道得到相似的向量表示,導(dǎo)致兩個相似通道的向量之間的角度很小,而兩個非常不同的通道向量之間的角度很大。對于給定的文本段落,將其稱為段落 A,我們的系統(tǒng)從整個法律中返回其他段落,其向量與段落 A 的向量的角度最小。

引用者

Citator 是 Casetext 對不再是良法的案件發(fā)出危險信號的系統(tǒng)。Casetext 可以以比我們的競爭對手低得多的價格提供準確的引用者,因為我們使用 AI 來過濾掉我們的律師審稿人不需要閱讀的新案件部分。在上訴法院或更高級別出現(xiàn)的每一個新案件都可能推翻先前的案件。我們不是讓律師閱讀每個案件的全部內(nèi)容,而是讓我們的人工智能閱讀每個案件的全部內(nèi)容,然后只將案件中有機會推翻另一個案件的部分傳遞給我們的律師。我們?nèi)鱿铝艘粡埛浅拸V的網(wǎng),并向我們的審稿人展示我們的人工智能模型認為哪怕是很小的機會包含壓倒性語言的任何段落。這意味著我們掃過許多沒有推翻的段落,這樣我們就可以抓住所有推翻另一個案例的段落。

我們的律師會審查模型選擇的每個段落,確定它是否確實推翻了另一個案件,然后記錄哪個案件被推翻了。這種人工智能驅(qū)動的方法不僅節(jié)省了大量人力,而且還提高了準確性。必須閱讀整個案例以尋找壓倒性語言的人工審稿人往往會掩蓋或遺漏關(guān)鍵信息。然而,我們的人工智能算法永遠不會感到疲倦或無聊,它們會閱讀每一段文本。我們已經(jīng)看到過這樣的例子,我們發(fā)現(xiàn)了競爭對手遺漏的推翻案例,例如,推翻性的語言被埋藏在腳注中,而他們的人工審稿人必須跳過。

我們的人工智能在數(shù)千個推翻案件的例子中進行了訓(xùn)練,在這些例子中,我們的律師手工突出顯示了案件中代表推翻裁決的特定語言。使用這個數(shù)據(jù)集,我們訓(xùn)練了一個人工智能模型來區(qū)分推翻段落和非推翻段落。我們讓人類審查模型告訴我們的任何段落,哪怕只有一點點機會包含壓倒性的語言。隨著我們逐漸訓(xùn)練出更準確的模型,我們已經(jīng)能夠在不犧牲引用者的全面性的情況下逐步減少審稿人需要閱讀的段落數(shù)量。

這些是我們在過去一年中添加的人工智能應(yīng)用。在下一節(jié)中,我將介紹最新的人工智能研究的狀況,以及未來一年的機會。

人工智能驅(qū)動的法律信息學(xué)的現(xiàn)狀

對于人工智能在法律行業(yè)來說,我們正處于一個非常激動人心的時刻。直到最近,人工智能在自然語言處理(NLP)方面的進步遠遠落后于計算機視覺方面的進步。

計算機視覺從2012年左右開始爆炸式增長的一個主要原因是,計算機視覺最有效的算法類型,即深度卷積神經(jīng)網(wǎng)絡(luò),適合遷移學(xué)習(xí)。遷移學(xué)習(xí)是一種技術(shù),在這種技術(shù)中,首先對 AI 模型進行預(yù)訓(xùn)練,以在大型數(shù)據(jù)集上針對特定任務(wù)進行預(yù)訓(xùn)練,然后在小型數(shù)據(jù)集上針對不同任務(wù)進行微調(diào)。

神經(jīng)網(wǎng)絡(luò)對數(shù)據(jù)的需求量很大——當您向它們提供更多訓(xùn)練數(shù)據(jù)時,其他類型模型的性能會趨于平穩(wěn),即使有大量訓(xùn)練數(shù)據(jù),足夠大小的神經(jīng)網(wǎng)絡(luò)也會繼續(xù)改進。然而,訓(xùn)練數(shù)據(jù)通常需要人工標記——例如,如果你想訓(xùn)練一個 AI 模型來識別圖像中的對象,你需要讓人類查看每個圖像,并用它所包含的對象的名稱標記每個圖像。人工貼標既昂貴又耗時。因此,在大多數(shù)業(yè)務(wù)情況下,可用的手動標記數(shù)據(jù)點相對較少。如果神經(jīng)網(wǎng)絡(luò)必須在每個任務(wù)的小型數(shù)據(jù)集上從頭開始訓(xùn)練,那么它們就不會像現(xiàn)在這樣有用。然而,事實證明,神經(jīng)網(wǎng)絡(luò)在一項計算機視覺任務(wù)上所做的大部分學(xué)習(xí)也對其他視覺任務(wù)有用。

卷積神經(jīng)網(wǎng)絡(luò)可以理解為逐漸變得更加復(fù)雜的模式識別器,它們相互堆疊。以下是計算機視覺神經(jīng)網(wǎng)絡(luò)中漸進層識別的模式類型的可視化。該模型是在包含超過 100 萬張帶有標簽的圖像的公共數(shù)據(jù)集上訓(xùn)練的。如您所見,第一層圖案是簡單的線條和漸變。下一層是由前一層的線條和漸變組合而成的紋理和基本形狀,第三層是由第二層的簡單形狀組合而成的更復(fù)雜的形狀。

許多形狀和紋理,當然還有線條和漸變,幾乎在任何視覺識別任務(wù)中都很有用。因此,一旦在大型數(shù)據(jù)集上訓(xùn)練到能夠識別這些類型的模式,計算機視覺模型的下層就可以重新用于許多不同的視覺任務(wù)。使用這種被稱為遷移學(xué)習(xí)的技術(shù),擁有少于 100 萬張標記圖像的人能夠在自己的計算機視覺任務(wù)中獲得出色的結(jié)果。

直到最近,遷移學(xué)習(xí)在自然語言處理中還不如在計算機視覺中有效。由于大多數(shù)與法律相關(guān)的人工智能任務(wù)都涉及自然語言處理,這一直是人工智能在法律中的應(yīng)用的一個限制。

通過對預(yù)先訓(xùn)練的詞向量(在大型文本語料庫上訓(xùn)練的單詞的表示)進行遷移學(xué)習(xí),取得了一些收益。詞向量于 2003 年首次提出,并于 2013 年通過一種稱為 word2vec 的重要技術(shù)進行了改進。Word2vec 看起來相當令人印象深刻——例如,從“國王”的向量中減去“男人”的向量,然后加上“女人”的向量,得到一個非常接近“女王”向量的向量。這些結(jié)果表明,詞向量技術(shù)正在捕捉單詞中的許多含義。

詞向量推動了該領(lǐng)域的發(fā)展,但未能實現(xiàn)計算機視覺中遷移學(xué)習(xí)所看到的那種結(jié)果。用預(yù)先訓(xùn)練的詞向量替換單詞僅代表神經(jīng)網(wǎng)絡(luò)第一層的遷移學(xué)習(xí)。第一層之外的所有層仍然必須從頭開始訓(xùn)練,這限制了NLP中遷移學(xué)習(xí)的能力。

這一切都在 2018 年發(fā)生了變化,引入了可用于多層遷移學(xué)習(xí)的自然語言處理 AI 模型架構(gòu)。基于過去幾年的進步,許多組件進入了這些模型架構(gòu)。

2017 年,谷歌的一個研究小組發(fā)表了一篇題為《注意力就是你所需要的一切》的論文,該論文闡述了神經(jīng)轉(zhuǎn)換器的架構(gòu)——一種有效的方法,在決定輸出序列的每個部分時,通過“注意”輸入序列的關(guān)鍵部分來獲取輸入序列并輸出不同的文本序列。這種類型的架構(gòu)最初被證明在機器翻譯中非常有用,但很快擴展到其他領(lǐng)域,因為它是迄今為止已知的創(chuàng)建整個句子長度文本序列的矢量化表示的最佳方式(而不僅僅是單詞,就像單詞嵌入一樣)。

2018年初,艾倫研究所(Allen Institute)和華盛頓大學(xué)(University of Washington)的一個研究小組推出了ELMo,這是一種用于創(chuàng)建多層上下文相關(guān)詞嵌入的技術(shù)。ELMo通過兩種方式改進了預(yù)先存在的單詞嵌入技術(shù):1.它根據(jù)單詞的上下文為每個單詞的序列創(chuàng)建嵌入,而不是為每個單詞創(chuàng)建一組嵌入,而不管上下文如何。這使得“Will went to the store”中“Will”的嵌入與“Will you go to the concert?”中“Will”的嵌入不同。2. ELMo 單詞嵌入是從經(jīng)過訓(xùn)練的模型的許多層創(chuàng)建的,這些模型可以預(yù)測給定文本序列的下一個單詞,而不僅僅是從第一層創(chuàng)建,從而實現(xiàn)單詞的更穩(wěn)健的表示。

同樣在 2018 年初,Jeremy Howard 和 Sebastian Ruder 推出了 ULMFiT,它引入了在 NLP 的整個模型上使用遷移學(xué)習(xí)的想法。這涉及在不需要人工標記的任務(wù)上預(yù)訓(xùn)練整個模型(在本例中,預(yù)測單詞序列中的下一個單詞),然后在目標任務(wù)上微調(diào)模型。

在2018年末,所有這些想法與一些新想法一起被組合成由領(lǐng)先的NLP小組創(chuàng)建的各種模型類型。谷歌在 2018 年底發(fā)布了 BERT,OpenAI 在 2019 年初發(fā)布了 GPT-2。兩者都利用轉(zhuǎn)換器、上下文深度詞嵌入和對任務(wù)進行預(yù)訓(xùn)練,而無需人工標記,然后對特定任務(wù)進行微調(diào)。兩者都取得了令人印象深刻的成果,在廣泛的 NLP 基準測試中取得了新的記錄。

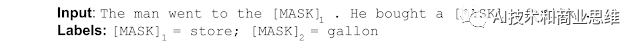

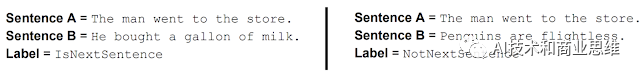

谷歌通過使用這兩個任務(wù),而不是預(yù)測序列中下一個單詞的常規(guī)任務(wù),在沒有人工標記的情況下對預(yù)訓(xùn)練進行了新的改變:

1. 在一個刪除了兩個單詞的句子中,BERT 被訓(xùn)練來預(yù)測這兩個單詞是什么。

2. 給定兩個句子,BERT 被訓(xùn)練以確定這些句子中的一個句子是否在一段文本中緊隨其后,或者它們是否只是兩個不相關(guān)的句子。

在 Casetext,我們使用了類似于 BERT 和 GPT-2 的技術(shù)來大幅改進我們的引用者過濾算法。結(jié)合這些新技術(shù),我們可以將律師審稿人需要閱讀的段落百分比從所有新案件中的 10% 減少到僅 3%。我們的競爭對手有律師閱讀 100% 的案件。生產(chǎn)我們的 citator 所需的工時大幅減少,使我們能夠以比競爭對手低得多的價格提供 citator,而不會犧牲準確性。