北大全新「機(jī)械手」算法:輔助花式抓杯子,GTX 1650實(shí)現(xiàn)150fps推斷

手是人類與世界交互的重要部分,手的缺失(如上肢殘障)會(huì)大大影響人類的正常生活。

北京大學(xué)董豪團(tuán)隊(duì)通過將擴(kuò)散模型和強(qiáng)化學(xué)習(xí)結(jié)合,使機(jī)械手能根據(jù)人手腕部的移動(dòng)軌跡,自適應(yīng)的抓取物體的不同部位,滿足人類多樣化的抓取需求,目前該工作已被NeurIPS 2023接收。

論文地址:https://arxiv.org/abs/2309.06038

項(xiàng)目主頁:https://sites.google.com/view/graspgf

有了這個(gè)機(jī)械手,只要?jiǎng)觿?dòng)手腕,機(jī)械手就能按照人類想要的方式抓起物體,比如抓取杯身和杯壁。

由于人類行為的復(fù)雜與多變性和真實(shí)世界物體的多樣性,僅僅根據(jù)人手腕部的移動(dòng)軌跡來不斷預(yù)測(cè)人類想法是一件非常困難的事情。

新方法真正實(shí)現(xiàn)了靈巧的抓取,能在真實(shí)世界中對(duì)于不同的物體,不同的抓取姿態(tài),不同的抓取軌跡進(jìn)行泛化。

機(jī)械手如何明白人類的想法?

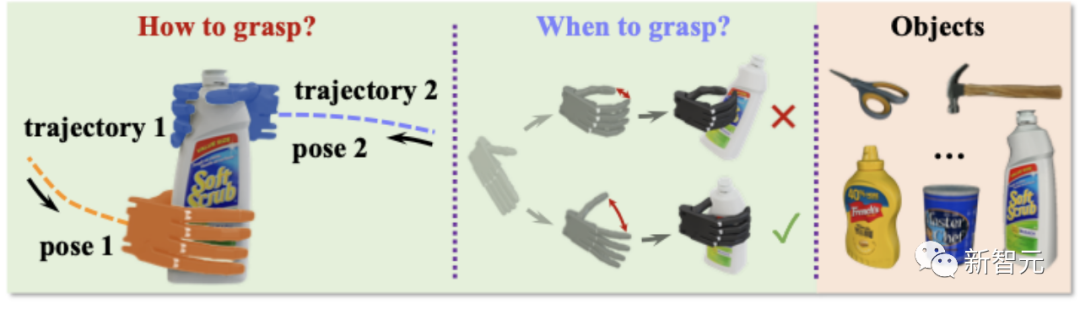

北大董豪團(tuán)隊(duì)提出將人類的想法分解成兩個(gè)部分:

1. 如何抓: 考慮到人類和物體當(dāng)前的相對(duì)姿勢(shì),機(jī)械手應(yīng)該如何抓取物體?

2. 何時(shí)抓: 機(jī)械手應(yīng)該根據(jù)用戶歷史運(yùn)動(dòng)軌在何時(shí)、以什么速度執(zhí)行抓取動(dòng)作?

如何抓?

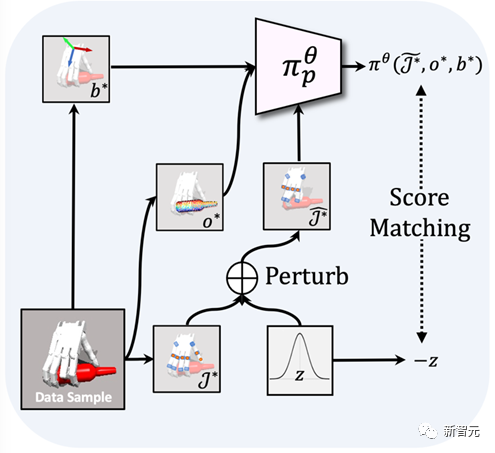

首先,如上圖所示,新方法將學(xué)習(xí)人類想要「如何抓取物體」,定義為從一個(gè)包含各種抓取姿態(tài)的數(shù)據(jù)集中,學(xué)習(xí)抓取梯度場(chǎng)Grasping Gradient Field(GraspGF)。

基于當(dāng)前人手腕部和物體的相對(duì)關(guān)系,GraspGF會(huì)輸出一個(gè)梯度,這個(gè)梯度代表最快提高「抓取可能性」的方向。這個(gè)梯度可以轉(zhuǎn)化為對(duì)每個(gè)手指關(guān)節(jié)的原始控制,使手指能夠通過不斷迭代達(dá)到適當(dāng)?shù)淖ト∽藨B(tài)。

這樣的梯度場(chǎng)可以隨著人手腕部和物體的關(guān)系的變化,而不斷的輸出新的梯度指示當(dāng)前人類的抓取意圖,即意向抓取的物體區(qū)域及抓取姿態(tài)。

GraspGF隨著手腕的旋轉(zhuǎn),不斷調(diào)整抓取姿態(tài)

何時(shí)抓?

GraspGF的動(dòng)作會(huì)導(dǎo)致提前合攏

然而,只知道「如何抓」并不夠完備,如果不知道要「何時(shí)抓」(如上圖所示),雖然最終的抓取姿態(tài)是合理的,但是在達(dá)到抓取姿態(tài)的過程中會(huì)和物體發(fā)生碰撞。

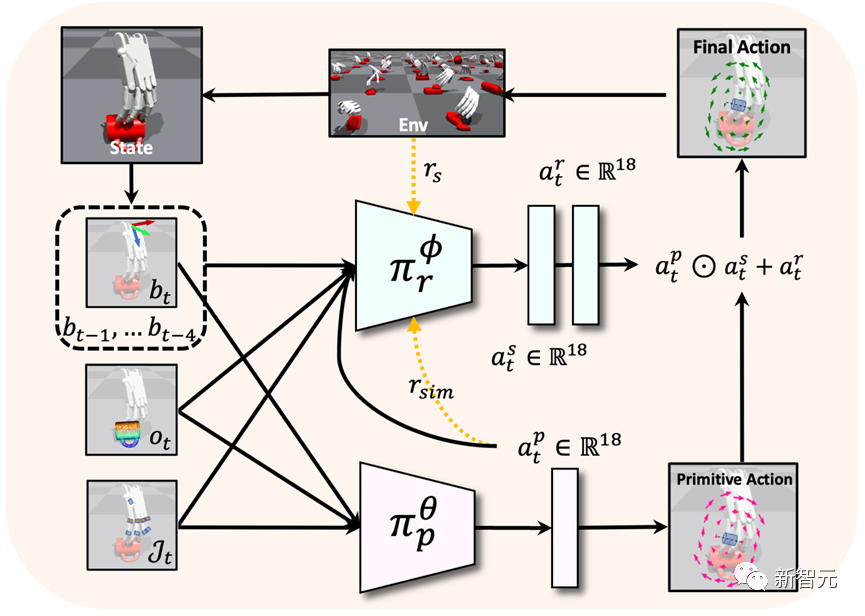

如上所示,為了解決「何時(shí)抓取」的問題,新方法還訓(xùn)練了一個(gè)基于強(qiáng)化學(xué)習(xí)的殘差策略,它首先會(huì)輸出一個(gè)「縮放動(dòng)作」,根據(jù)手腕軌跡的歷史,決定手指關(guān)節(jié)應(yīng)該以多快的速度沿著原始動(dòng)作的方向移動(dòng)。

此外,因?yàn)樵疾呗允腔谧罱K抓取姿態(tài)數(shù)據(jù)集離線訓(xùn)練得到的,原始策略并不了解環(huán)境的物理約束 ,殘差策略還會(huì)輸出一個(gè)「殘差動(dòng)作」來進(jìn)一步校正原始動(dòng)作。

通過結(jié)合殘差策略,模型能夠通過殘差策略學(xué)習(xí)到的「何時(shí)抓」更好地實(shí)現(xiàn)原始策略學(xué)習(xí)到的「如何抓」。

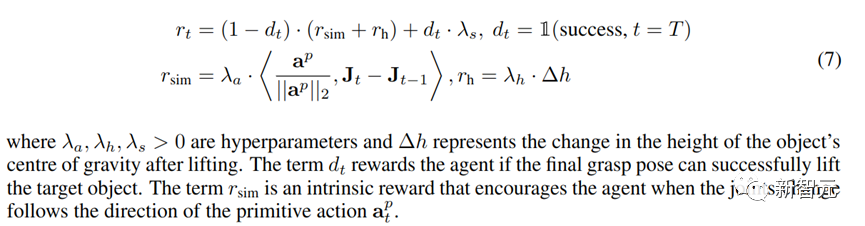

簡(jiǎn)單的獎(jiǎng)勵(lì)函數(shù)

該方法在獎(jiǎng)勵(lì)函數(shù)的設(shè)置上不需要過多的human design,因?yàn)樵紕?dòng)作已經(jīng)提供了一個(gè)比較好的「如何抓」的引導(dǎo),在訓(xùn)練強(qiáng)化學(xué)習(xí)模型時(shí),除了給定成功抓取和抓取后的高度變化獎(jiǎng)勵(lì),僅僅只需要一個(gè)獎(jiǎng)勵(lì)函數(shù)去鼓勵(lì)機(jī)械手跟隨原始動(dòng)作即可。

該方法的優(yōu)勢(shì)

- 該方法僅需要成功抓取的抓取姿態(tài)數(shù)據(jù)集用于訓(xùn)練,與需要專家演示的方法相比,不需要大量的人工標(biāo)注或者工程工作。

- GraspGF借助了擴(kuò)散模型強(qiáng)大的條件生成建模能力,這使它能夠根據(jù)新穎的用戶意圖輸出有效的原始動(dòng)作。

- 殘差學(xué)習(xí)的設(shè)計(jì)改善了強(qiáng)化學(xué)習(xí)探索效率低下的問題,提升了強(qiáng)化學(xué)習(xí)模型在未見過物體和軌跡上的泛化能力。

結(jié)果

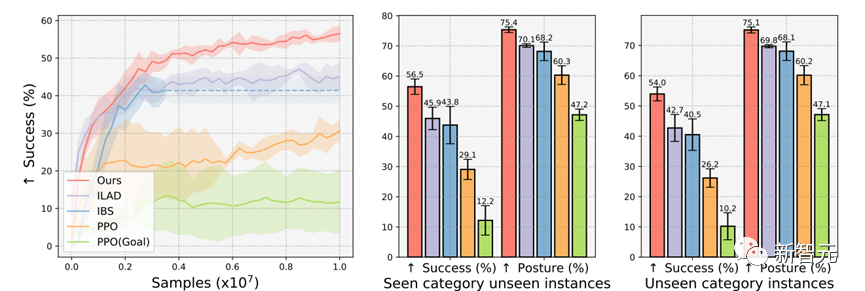

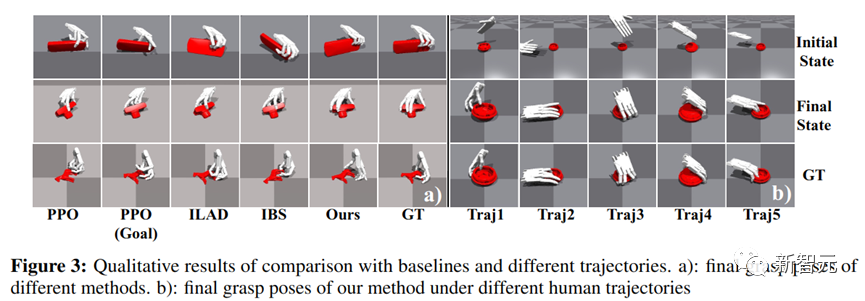

最終在4900多個(gè)物體,200條不同的人類移動(dòng)軌跡上,新方法都優(yōu)于基準(zhǔn)。

該方法的最終的抓取姿態(tài)相比于基線更符合人類的抓取意圖。

此外,該方法在抓取過程中對(duì)物體造成的擾動(dòng)要小于其他基準(zhǔn)。

經(jīng)過測(cè)試,該模型在GTX1650的顯卡上,能達(dá)到150fps的推斷速度,能做到與人類的實(shí)時(shí)交互,也許未來能真正用于輔助手部缺失的人更好地進(jìn)行日常生活。

本次研究的通訊作者董豪是北京大學(xué)的助理教授、博導(dǎo)、博雅青年學(xué)者、智源學(xué)者,其創(chuàng)立并領(lǐng)導(dǎo)北大超平面實(shí)驗(yàn)室(Hyperplane Lab)。

董老師在NeurIPS、ICLR、CVPR、ICCV、ECCV、ICRA、IROS等國(guó)際頂尖會(huì)議/期刊上發(fā)表論文40余篇,Google Scholar引用4700余次,多次擔(dān)任國(guó)際頂尖會(huì)議如NeurIPS、CVPR、AAAI、ICRA的領(lǐng)域主席和副編委。

其領(lǐng)導(dǎo)了多個(gè)開源項(xiàng)目,例如TensorLayer和OpenMLsys,出版書籍獲得15萬次下載,開源軟件獲得上萬Github Star,獲ACM Multimedia 最佳開源軟件獎(jiǎng)、OpenI杰出項(xiàng)目獎(jiǎng)。

論文一作吳天昊,現(xiàn)為北京大學(xué)博士生,導(dǎo)師為董豪老師,研究方向?yàn)殪`巧手操縱算法。