單點(diǎn)端到端文本檢測(cè)識(shí)別框架速度提升19倍!華科、華南理工等聯(lián)合發(fā)布SPTS v2

近年來(lái),場(chǎng)景文本閱讀(Text Spotting)有了顯著進(jìn)步,能同時(shí)定位和識(shí)別文本,廣泛應(yīng)用于智慧辦公、金融、交通等領(lǐng)域。

然而,與目標(biāo)檢測(cè)相比,文字除了定位還需要精確識(shí)別內(nèi)容;同時(shí),由于字體和排版的不同,文本實(shí)例可能以任意形狀呈現(xiàn),這就需要使用包含更多坐標(biāo)的邊界框來(lái)標(biāo)注,例如SCUT-CTW1500最多使用了28個(gè)坐標(biāo)進(jìn)行標(biāo)注,標(biāo)注成本十分高昂。

圖片

圖片

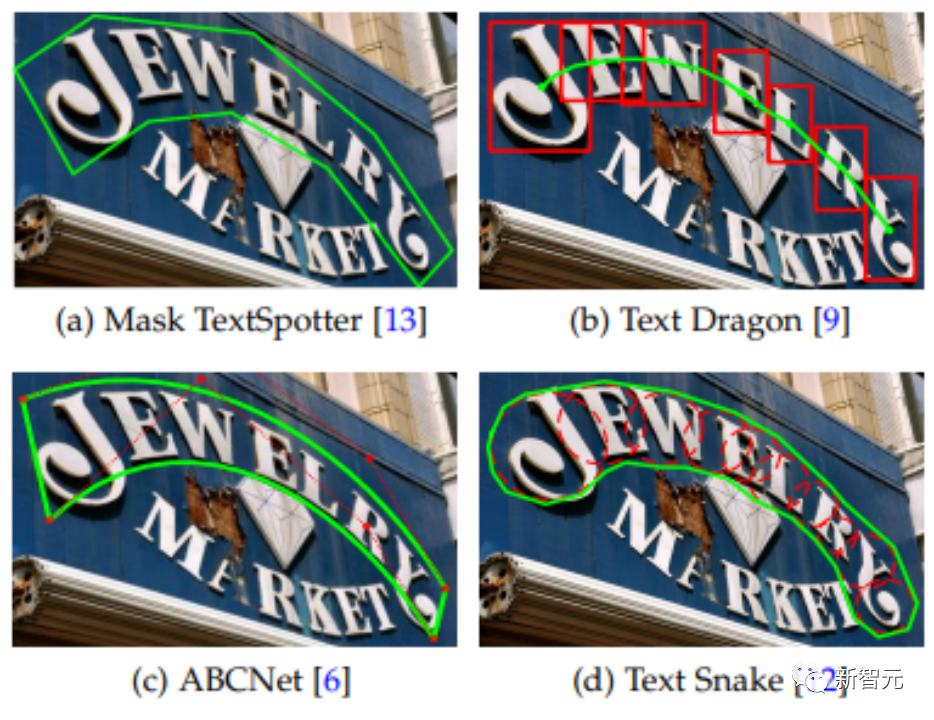

近幾年,以多邊形及貝塞爾曲線表征為基準(zhǔn)的任意形狀文字表征成為了主流研究方向。然而多邊形的標(biāo)注成本十分昂貴。 在此背景下,SPTS系列論文首次證明了不需要任何標(biāo)注框,僅用單點(diǎn)標(biāo)注即可取得最好的識(shí)別結(jié)果,極大地降低了標(biāo)注成本,同時(shí)單點(diǎn)顯著地降低了表示文本的序列長(zhǎng)度。然而,由于文本內(nèi)容(transcript)通常很長(zhǎng)(如默認(rèn)最少25),將所有文本放在一個(gè)自回歸序列中串行解碼依然會(huì)導(dǎo)致推理時(shí)間非常長(zhǎng)。

圖片

圖片

論文鏈接:https://arxiv.org/abs/2301.01635

代碼地址:https://github.com/Yuliang-Liu/SPTSv2

今年9月,華中科技大學(xué)白翔團(tuán)隊(duì)劉禹良研究員聯(lián)合華南理工大學(xué)、浙江大學(xué)、香港中文大學(xué)、字節(jié)跳動(dòng)等機(jī)構(gòu)的研究人員于TPAMI在線發(fā)表了SPTS v2的相關(guān)工作,針對(duì)端到端場(chǎng)景文本檢測(cè)識(shí)別任務(wù),提出基于單點(diǎn)標(biāo)注的SPTS v2方法。

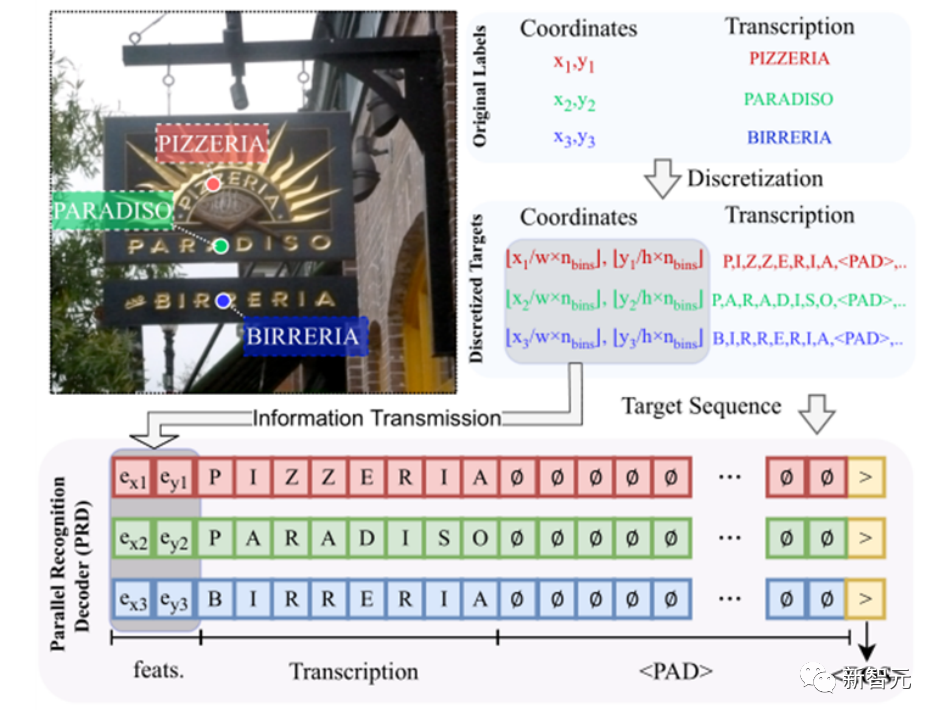

該方法采用了單點(diǎn)來(lái)指示文本位置,采用語(yǔ)言序列統(tǒng)一表征圖片、坐標(biāo)及文本等不同模態(tài),使得檢測(cè)及識(shí)別任務(wù)的融合更加緊密,也免除了先驗(yàn)知識(shí)的介入和復(fù)雜的后處理操作。針對(duì)其自回歸推理速度較慢的問題,通過將檢測(cè)識(shí)別解耦為自回歸的單點(diǎn)序列預(yù)測(cè)及基于每個(gè)單點(diǎn)的并行文本識(shí)別進(jìn)行推理加速。

此外,該方法同樣采用了單點(diǎn)來(lái)指示文本位置,極大地降低了標(biāo)注成本,并且使用序列預(yù)測(cè)的方式完成端到端場(chǎng)景文本檢測(cè)識(shí)別任務(wù),使得兩個(gè)任務(wù)的融合更加緊密,也免除了先驗(yàn)知識(shí)的介入和復(fù)雜的后處理操作。

實(shí)驗(yàn)證明該方法在多個(gè)場(chǎng)景文本端到端檢測(cè)識(shí)別數(shù)據(jù)集上優(yōu)于現(xiàn)有方法,同時(shí)相對(duì)于SPTS v1達(dá)到了19倍的推理加速。

大白話SPTSv2

1. 怎么用點(diǎn)實(shí)現(xiàn)Text Spotting?

以前的Text Spotting方法通常依賴于先檢測(cè)后采樣再識(shí)別的端到端模式,強(qiáng)依賴于核心對(duì)齊模塊,如Mask TextSpotter[2]的Hard ROIMasking、TextDragon[3]的ROISlide及ABCNet[4]的BezierAlign等。

圖片

圖片

SPTSv2通過序列來(lái)統(tǒng)一表征文本實(shí)例位置和內(nèi)容,將Text Spotting簡(jiǎn)化為離散空間的連續(xù)描述。這種檢測(cè)識(shí)別同時(shí)預(yù)測(cè)的方式解耦了識(shí)別對(duì)檢測(cè)結(jié)果的強(qiáng)依賴,鑒于此,該方法進(jìn)一步將邊界框簡(jiǎn)化為位于一個(gè)點(diǎn)標(biāo)注。

2. 為什么SPTSv2能顯著降低推理時(shí)間?

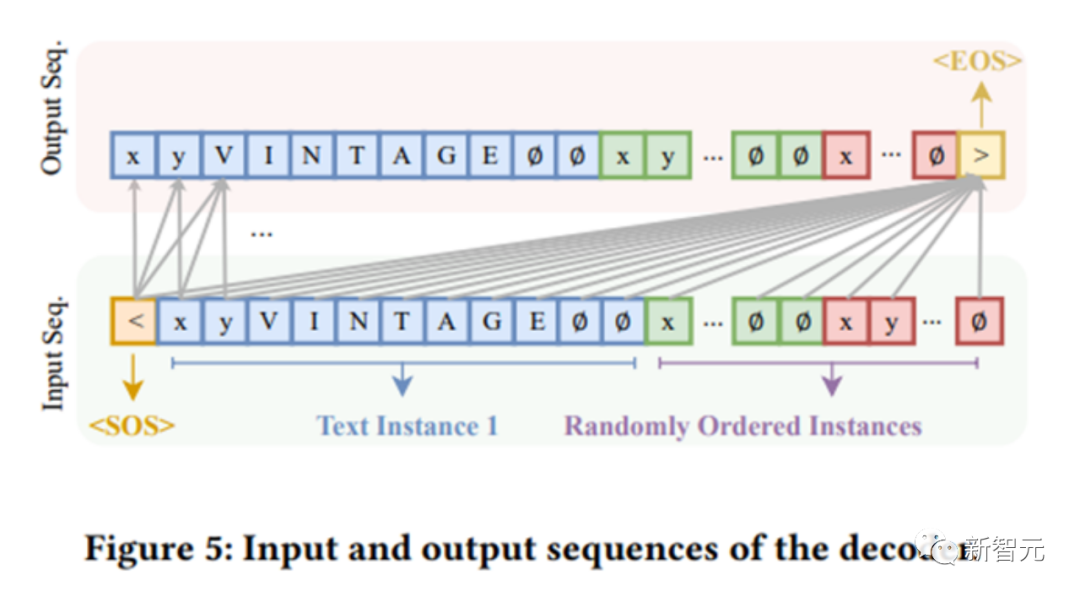

自回歸方法的推理時(shí)間,在很大程度由串行循環(huán)次數(shù)決定。假設(shè)一張圖片最多包含N個(gè)文本實(shí)例,每個(gè)實(shí)例最多包含K個(gè)字符,每個(gè)實(shí)例的位置表征個(gè)數(shù)為T(單點(diǎn)為2,包括橫縱坐標(biāo),14點(diǎn)的多邊形就是28)。

對(duì)于原始的自回歸來(lái)說(shuō),將所有坐標(biāo)和文本都放在一個(gè)序列里面實(shí)現(xiàn),那么預(yù)測(cè)這張圖片需要(T + K) * N + 1個(gè)串行循環(huán)次數(shù);最后的+1代表終止符號(hào)。

圖片

圖片

舉個(gè)例子,假設(shè)設(shè)置最長(zhǎng)有100個(gè)文本實(shí)例,最大長(zhǎng)度取最小默認(rèn)值25。

那么,對(duì)于單點(diǎn)來(lái)說(shuō),串行循環(huán)次數(shù)是2701次。對(duì)于多邊形來(lái)說(shuō)就是5301次。

而SPTS v2提出了實(shí)例分配解碼器(IAD)和并行識(shí)別解碼器(PRD),串行自回歸只需要單點(diǎn)坐標(biāo)參與,識(shí)別解碼是由每個(gè)單點(diǎn)并行自回歸得到的,總共只需T * N + K + 1個(gè)串循環(huán)次數(shù),減少了K * (N - 1)。

那么在上述例子中,SPTSv2只需要226次,循環(huán)數(shù)量減少了91.6%(226/2701),對(duì)于文本行來(lái)說(shuō),K通常取100,此時(shí)循環(huán)數(shù)量甚至減少了97.0%!

同時(shí),在實(shí)際上可能串行循環(huán)次數(shù)還能進(jìn)一步減少,因?yàn)樵赟PTSv2的識(shí)別預(yù)測(cè)上,如果所有實(shí)例都遇到序列結(jié)束符,SPTS v2也可以提前結(jié)束。

圖片

圖片

因此,通過這種并行預(yù)測(cè),推理速度可以顯著提高。

3. 點(diǎn)的表征有什么性質(zhì)及優(yōu)點(diǎn)?

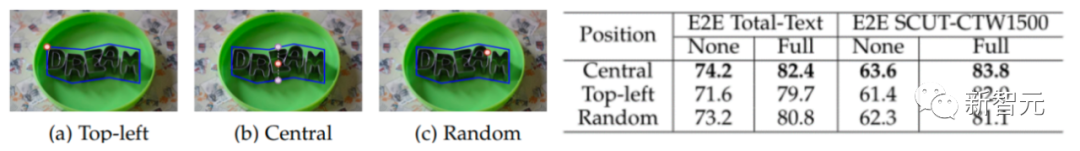

① 點(diǎn)的標(biāo)注可以很隨意。

實(shí)驗(yàn)表明,點(diǎn)即使是隨機(jī)的一個(gè)點(diǎn),效果依然是和全部選取中心點(diǎn)相差不大的,甚至比全部取左上角點(diǎn)還要高。這意味著標(biāo)注人員僅需對(duì)著文本隨意點(diǎn)一個(gè)點(diǎn)即可標(biāo)注文本。

圖片

圖片

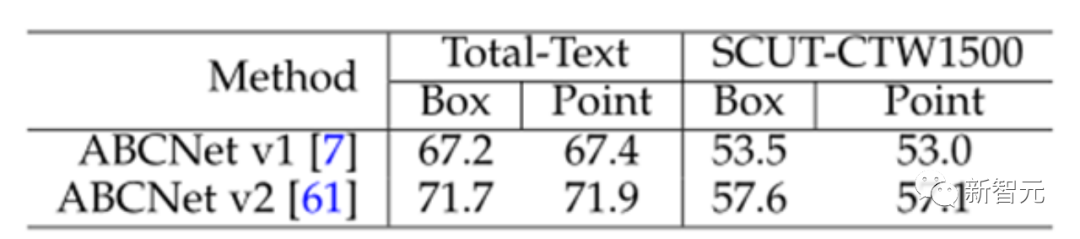

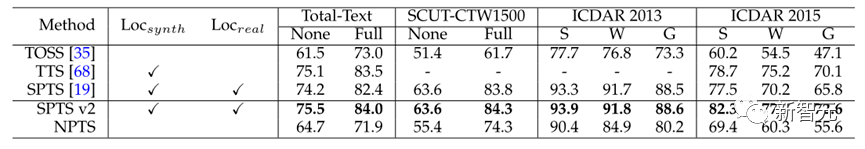

② 點(diǎn)的性能很高。

文中點(diǎn)的性能取得了最好的Text Spotting結(jié)果。同時(shí)為了消除是否是因?yàn)辄c(diǎn)和框不同評(píng)估標(biāo)準(zhǔn)的影響,實(shí)驗(yàn)驗(yàn)證了點(diǎn)的評(píng)估和框的評(píng)估性能差異不大。

圖片

圖片

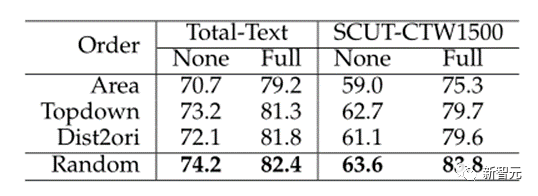

③ 隨機(jī)文本排序最好。

由于自回歸的有序性,第一階段預(yù)測(cè)哪個(gè)文本點(diǎn)的順序可能會(huì)對(duì)結(jié)果產(chǎn)生影響。實(shí)驗(yàn)表明隨機(jī)點(diǎn)排序達(dá)到了最佳性能,因?yàn)樗赡軙?huì)在以后捕獲那些丟失的對(duì)象。由于在不同迭代中為同一圖像構(gòu)建的不同序列,這使模型更加魯棒。這一結(jié)論也與Pix2seq[5]一致。

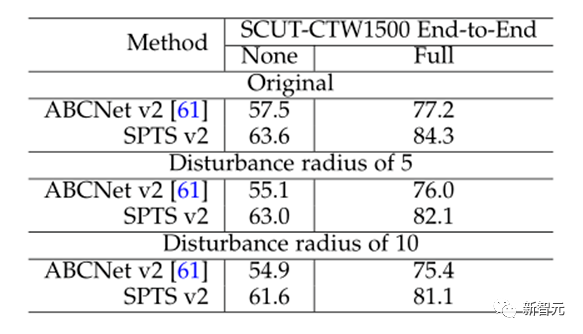

④對(duì)噪聲更加魯棒。

在SCUT-CTW1500上對(duì)框或者點(diǎn)的坐標(biāo)加上隨機(jī)擾動(dòng),實(shí)驗(yàn)結(jié)果表明SPTSV2相比于基于框的方法能夠更好地應(yīng)對(duì)標(biāo)注噪聲。

⑤甚至很長(zhǎng)的文本行也可以僅用一個(gè)點(diǎn)標(biāo)注。

如SCUT-CTW1500就是文本行數(shù)據(jù),SPTSv2效果不僅是最好的,還大幅好于基于框的方法。

4. 既然檢測(cè)識(shí)別解耦,是不是該方法不需要點(diǎn)也能識(shí)別結(jié)果?

回答是肯定的。文中進(jìn)一步嘗試了No-Point Text Spotting(NPTS),在僅僅使用文本轉(zhuǎn)錄訓(xùn)練的情況下,NPTS取得了較好的性能。但是,相比起有單點(diǎn)標(biāo)注的結(jié)果,性能差距十分明顯,平均10%以上的差距,這證明點(diǎn)的標(biāo)注對(duì)最終性能還是至關(guān)重要的。

圖片

圖片

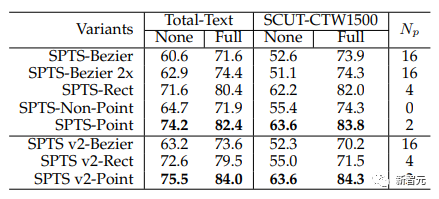

此外,值得一提的是,文中還有一個(gè)有趣的發(fā)現(xiàn)。僅僅只是在SPTS的框架內(nèi)驗(yàn)證,如果不預(yù)測(cè)點(diǎn),而是預(yù)測(cè)水平矩形框和多邊形,效果不如點(diǎn)。針對(duì)這一現(xiàn)象,文中做了一些分析:

圖片

圖片

① SPTS-Rect和SPTS-Bezier的結(jié)果是根據(jù)與SPTS-Point相同的訓(xùn)練時(shí)長(zhǎng)獲得的,三者除了點(diǎn)的數(shù)量以外其他嚴(yán)格一致。實(shí)驗(yàn)顯示,訓(xùn)練了2倍周期的SPTS-Bezier與1倍周期的比沒有顯著超越。此外,采用較長(zhǎng)的時(shí)間甚至?xí)?dǎo)致其在SCUT-CTW1500的None指標(biāo)上的表現(xiàn)降低,這表明訓(xùn)練時(shí)長(zhǎng)可能不是主要問題。② 過去Text Spotting方法經(jīng)常可以觀察到,有時(shí)即使檢測(cè)結(jié)果不準(zhǔn)確,識(shí)別結(jié)果仍然可以準(zhǔn)確。這是因?yàn)槲谋咀R(shí)別的對(duì)齊是基于特征空間的,其中裁剪的特征對(duì)于文本內(nèi)容有足夠的接受字段,這表明方法對(duì)于框的位置標(biāo)注要求并不是非常敏感。由于SPTSv2的方法中圖像是利用Transformer進(jìn)行全局編碼的,近似的位置可能足以讓模型捕獲附近的所需特征。當(dāng)然這一結(jié)論僅僅只是在SPTSv2的框架內(nèi)做了驗(yàn)證。

圖片

圖片

總結(jié)

本文的方法能夠在任意形狀的文本上獲得更好的準(zhǔn)確性的原因可能是:所提出的方法丟棄了基于先驗(yàn)知識(shí)設(shè)計(jì)的特定任務(wù)模塊(例如RoI模塊)。因此,識(shí)別精度與檢測(cè)結(jié)果解耦,即使檢測(cè)標(biāo)注點(diǎn)在文本區(qū)域內(nèi)隨機(jī),本文的方法也能獲得魯棒的識(shí)別結(jié)果。實(shí)驗(yàn)證明SPTS v2在多個(gè)場(chǎng)景文本端到端檢測(cè)識(shí)別數(shù)據(jù)集中均有出色的表現(xiàn),且推理速度可達(dá)到SPTS的19倍。SPTS v2將多模態(tài)數(shù)據(jù)統(tǒng)一表征的訓(xùn)練方法使其特別適合多模態(tài)、多任務(wù)場(chǎng)景,且整個(gè)方法僅需一個(gè)交叉熵?fù)p失函數(shù),框架十分簡(jiǎn)潔。另一方面,它能大大減少所需的自回歸序列長(zhǎng)度(如減少91%)。事實(shí)上,這也引發(fā)了思考,大模型ChatGPT本質(zhì)上也是一個(gè)自回歸Transformer。假如,當(dāng)其能夠在第一階段串行輸出關(guān)鍵點(diǎn),建模不同點(diǎn)之間的關(guān)系,那么第二階段是否也可以根據(jù)不同關(guān)鍵點(diǎn)并行輸出所有文本內(nèi)容,這種「分點(diǎn)作答」的方式,或許也可以大幅度提升大模型輸出的速度。

參考資料:

[1] Yuliang Liu, et al. “SPTS v2: Single-Point Scene Text Spotting.” IEEE Transactions on Pattern Analysis and Machine Intelligence. 2023.

[2] Minghui Liao, et al. "Mask textspotter v3: Segmentation proposal network for robust scene text spotting." Computer Vision–ECCV 2020: 16th European Conference, Glasgow, UK, August 23–28, 2020, Proceedings, Part XI 16. Springer International Publishing, 2020.

[3] Feng Wei, et al. "Textdragon: An end-to-end framework for arbitrary shaped text spotting." Proceedings of the IEEE/CVF international conference on computer vision. 2019.

[4] Yuliang Liu, et al. "Abcnet v2: Adaptive bezier-curve network for real-time end-to-end text spotting." IEEE Transactions on Pattern Analysis and Machine Intelligence 44.11 (2021): 8048-8064.

[5] Chen Ting, et al. "Pix2seq: A language modeling framework for object detection." arXiv preprint arXiv:2109.10852 (2021).