NeO 360:用于室外場(chǎng)景稀疏視圖合成的神經(jīng)場(chǎng)

本文經(jīng)自動(dòng)駕駛之心公眾號(hào)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

論文:ICCV 2023 https://arxiv.org/pdf/2308.12967.pdf

作者單位:Georgia Institute of Technology;Toyota Research Institute

近期的隱式神經(jīng)表示在新視角合成方面取得了很好的結(jié)果。然而,現(xiàn)有的方法需要從大量視角進(jìn)行昂貴的場(chǎng)景優(yōu)化,然而現(xiàn)實(shí)世界中感興趣的對(duì)象或背景僅從很少的視角觀察到,因此限制了這些方法在真實(shí)世界的無(wú)限城市環(huán)境中的應(yīng)用,為了克服這一挑戰(zhàn),本文引入了一種名為NeO 360的新方法,用于稀疏視角合成室外場(chǎng)景的神經(jīng)場(chǎng)表示。NeO 360是一種通用方法,可以從單個(gè)或少量定姿的RGB圖像重建360°場(chǎng)景。該方法的精髓在于捕捉復(fù)雜現(xiàn)實(shí)世界室外3D場(chǎng)景的分布,并使用混合的圖像條件三平面表示,可以從任何世界點(diǎn)進(jìn)行查詢。本文的表示結(jié)合了基于體素和鳥(niǎo)瞰圖(BEV)表示的優(yōu)點(diǎn),比每種方法都更有效和表達(dá)豐富。NeO 360的表示使本文能夠從大量的無(wú)界3D場(chǎng)景中進(jìn)行學(xué)習(xí),同時(shí)在推理過(guò)程中對(duì)新視角和新場(chǎng)景具有普適性,甚至可以從單個(gè)圖像中進(jìn)行推理。本文在提出的具有挑戰(zhàn)性的360°無(wú)界數(shù)據(jù)集NeRDS 360上演示了本文的方法,并展示了NeO 360在新視角合成方面優(yōu)于現(xiàn)有的通用方法,同時(shí)還提供了編輯和合成能力。項(xiàng)?主頁(yè):zubair-irshad.github.io/projects/neo360.html

主要貢獻(xiàn)有哪些?

本文的?法擴(kuò)展了 NeRF++ 使其具有可推廣性。?法的核?是以三平?形式表示的局部特征。這種表示被構(gòu)建為三個(gè)垂直的交叉平?,其中每個(gè)平?從?個(gè)?度對(duì) 3D 環(huán)境進(jìn)?建模,通過(guò)合并它們可以實(shí)現(xiàn) 3D 場(chǎng)景的全?描述。NeO 360 的圖像條件三平?表示有效地對(duì)來(lái)?圖像級(jí)特征的信息進(jìn)?編碼,同時(shí)為任何世界點(diǎn)提供緊湊的可查詢表示。本文將這些特征與剩余局部圖像級(jí)特征相結(jié)合,從?量圖像中優(yōu)化多個(gè)?界 3D 場(chǎng)景。NeO 360 的 3D 場(chǎng)景表示可以為完整的 3D 場(chǎng)景構(gòu)建強(qiáng)?的先驗(yàn),從?只需?個(gè)擺好姿勢(shì)的 RGB 圖像即可實(shí)現(xiàn)對(duì)戶外場(chǎng)景進(jìn)??效的 360°新穎的視圖合成。全新?型 360°?界數(shù)據(jù)集包含 3 個(gè)不同地圖上的 70 多個(gè)場(chǎng)景。本文在 few-shot 新穎視圖合成和基于先驗(yàn)的采樣任務(wù)中證明了本文的?法在這個(gè)具有挑戰(zhàn)性的多視圖?界數(shù)據(jù)集上的有效性。除了學(xué)習(xí)完整場(chǎng)景的強(qiáng)? 3D表示之外,本文的?法還允許使? 3D ground truth邊界框?qū)饩€進(jìn)?推理時(shí)間修剪,從?能夠從?個(gè)輸?視圖進(jìn)?組合場(chǎng)景合成。總之,本文做出以下貢獻(xiàn):

- 適?于室外場(chǎng)景的通? NeRF 架構(gòu)基于三平?表示來(lái)擴(kuò)展 NeRF 公式,以實(shí)現(xiàn) 360 度的有效few-shot新穎視圖合成360°?界的環(huán)境。

- ?規(guī)模合成360°數(shù)據(jù)集,稱為 NeRDS 360,?于 3D 城市場(chǎng)景理解包含多個(gè)對(duì)象,通過(guò)密集的相機(jī)視點(diǎn)注釋捕獲?保真室外場(chǎng)景。

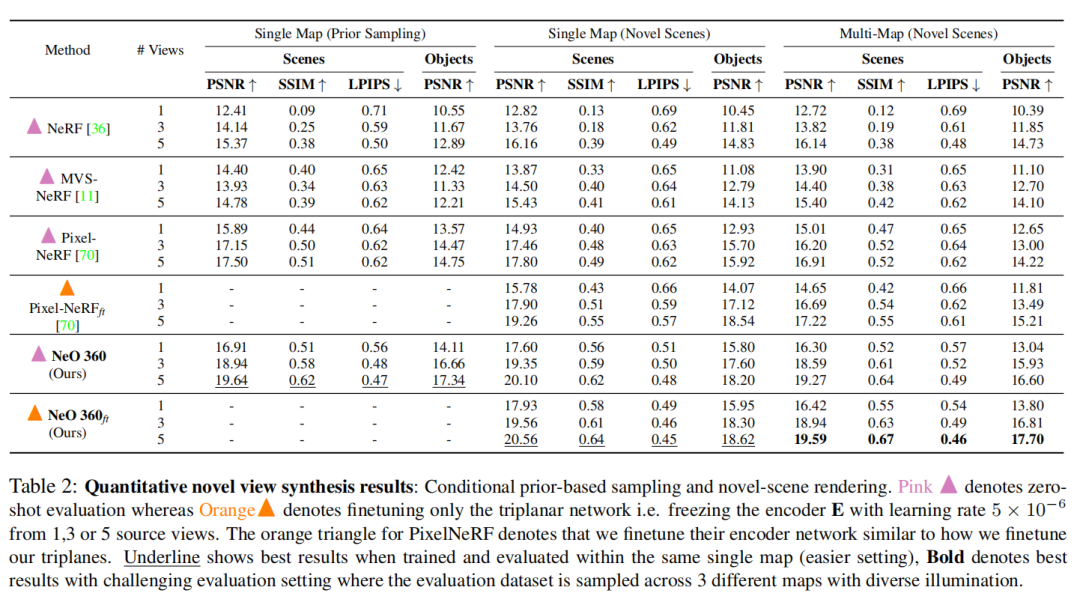

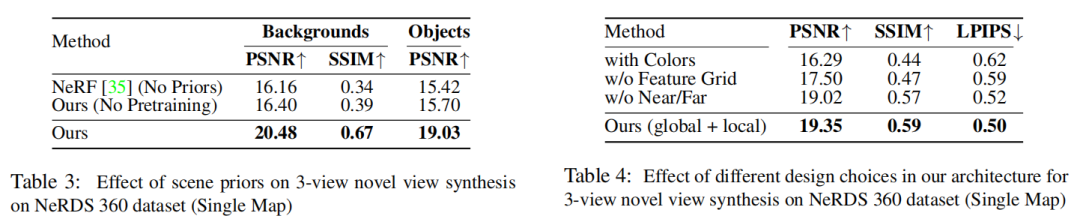

- 本文提出的?法顯著優(yōu)于 NeRDS 360 數(shù)據(jù)集上的小樣本新穎視圖合成任務(wù)的所有基線, 有著 3-view novel-view 合成任務(wù)的 1.89 PNSR 和 0.11 SSIM 絕對(duì)提升值。

NeRDS 360 多視角數(shù)據(jù)集:

為什么構(gòu)建這個(gè)數(shù)據(jù)集?

- 獲取精確的地面真實(shí) 3D 和 2D 信息(如更密集的視點(diǎn)標(biāo)注、3D 邊界框、語(yǔ)義和實(shí)例圖)具有挑戰(zhàn)性,因此可用于訓(xùn)練和測(cè)試的戶外場(chǎng)景非常有限。

- 之前的方案主要集中在使用現(xiàn)有的戶外場(chǎng)景數(shù)據(jù)集進(jìn)行重建,這些數(shù)據(jù)集是安裝在自車載體上的攝像頭捕獲的全景視圖。在相鄰攝像頭視圖之間幾乎沒(méi)有重疊部分,而這種特征已被證明對(duì)于訓(xùn)練 NeRF 和多視圖重建方法很有用。隨著自車快速移動(dòng)以及感興趣的對(duì)象在僅幾個(gè)視圖中被觀察到(通常小于 5 個(gè)),針對(duì)這些場(chǎng)景優(yōu)化基于對(duì)象的神經(jīng)輻射模型變得更加具有挑戰(zhàn)性。

數(shù)據(jù)集是怎樣的?

為了應(yīng)對(duì)這些挑戰(zhàn),本文提出了?個(gè)?于 3D 城市場(chǎng)景理解的?規(guī)模數(shù)據(jù)集。與現(xiàn)有數(shù)據(jù)集相?,本文的數(shù)據(jù)集由 75 個(gè)具有不同背景的戶外城市場(chǎng)景組成,包含超過(guò) 15,000 張圖像。這些場(chǎng)景提供 360°半球形視圖,捕捉各種照明條件下照亮的不同前景物體。此外,本文的數(shù)據(jù)集包含不限于前向駕駛視圖的場(chǎng)景,解決了先前數(shù)據(jù)集的局限性,例如攝像機(jī)視圖之間有限的重疊和覆蓋范圍。?于泛化評(píng)估的最接近的現(xiàn)有數(shù)據(jù)集是 DTU(80 個(gè)場(chǎng)景),主要包含室內(nèi)物體,不提供多個(gè)前景物體或背景場(chǎng)景。

數(shù)據(jù)集如何生成的?

本文使? Parallel Domain ?成合成數(shù)據(jù)以渲染?保真 360° 場(chǎng)景。本文選擇 3 個(gè)不同的地圖,即 SF 6thAndMission, SF GrantAndCalifornia and SF VanNessAveAndTurkSt 并在所有 3 個(gè)地圖上采樣 75 個(gè)不同場(chǎng)景作為本文的背景(3 個(gè)地圖上的所有 75 個(gè)場(chǎng)景都是彼此顯著不同的道路場(chǎng)景,在城市的不同視?拍攝)。本文選擇 50 種不同紋理的 20 輛不同的汽?進(jìn)?訓(xùn)練,并從每個(gè)場(chǎng)景中的 1 到 4 輛汽?中隨機(jī)采樣進(jìn)?渲染。本文將此數(shù)據(jù)集稱為NeRDS 360: NeRF for Reconstruction, Decomposition and Scene Synthesis of 360° outdoor scenes。訓(xùn)練集:本文總共?成了 15k 個(gè)渲染圖。通過(guò)在距汽?中?固定距離的半球形圓頂中對(duì) 200 個(gè)攝像機(jī)進(jìn)?采樣。測(cè)試集:本文提供了 4 輛不同汽?和不同背景的 5 個(gè)場(chǎng)景進(jìn)?測(cè)試,其中包括 100 個(gè)均勻分布在上半球的攝像機(jī),與訓(xùn)練時(shí)使?的攝像機(jī)分布不同。

本文使?不同的驗(yàn)證相機(jī)分布來(lái)測(cè)試本文的?法泛化到訓(xùn)練期間未?過(guò)的視點(diǎn)以及未?過(guò)的場(chǎng)景的能?。由于遮擋、背景多樣性以及具有各種閃電和陰影的渲染對(duì)象,本文的數(shù)據(jù)集和相應(yīng)的任務(wù)極具挑戰(zhàn)性。本文的任務(wù)需要重建 360° 使?少量觀察(即 1 到 5)的完整場(chǎng)景的半球形視圖,如Figure 5 中 的紅?攝像機(jī)所示。?使?所有 100 個(gè)半球視圖進(jìn)?評(píng)估,如Figure 5 中的綠?攝像機(jī)所示。因此,本文的任務(wù)需要強(qiáng)?的先驗(yàn)知識(shí)來(lái)合成室外場(chǎng)景的新穎視圖。

方法:

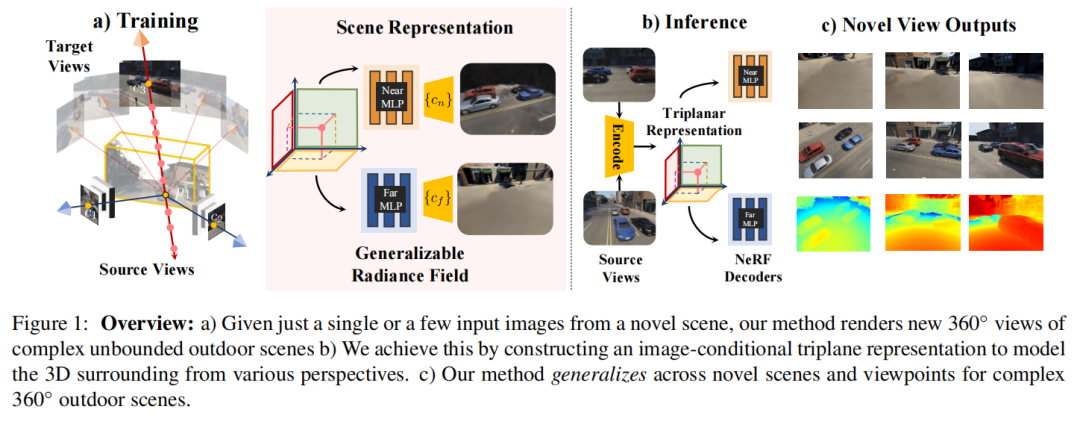

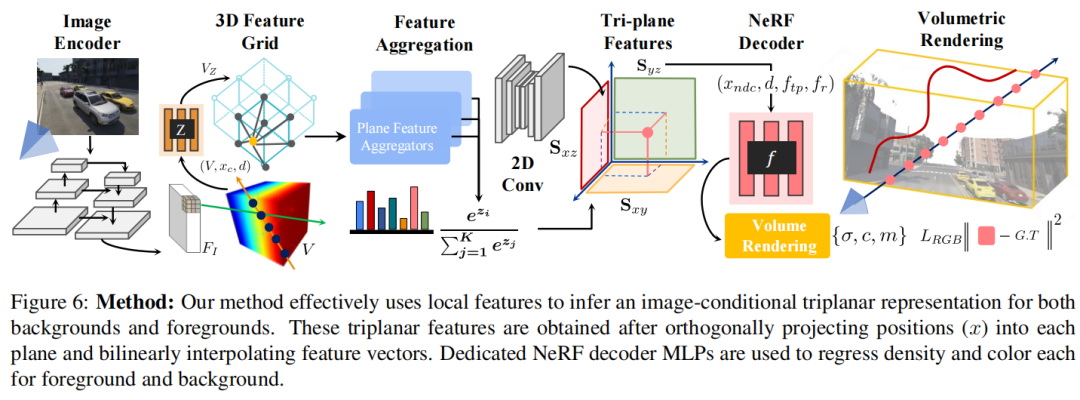

給定新場(chǎng)景的?個(gè)視圖的 RGB 圖像,NeO 360 進(jìn)行新穎視圖合成并渲染360度場(chǎng)景的3D場(chǎng)景表示。為了實(shí)現(xiàn)這??標(biāo),本文采?了由三平?表示組成的混合局部和全局特征表示,可以查詢?nèi)魏问澜琰c(diǎn)。形式上,如Figure 1所示,給定?些輸?圖像,的?個(gè)復(fù)雜的場(chǎng)景,其中n=1到5、以及他們相應(yīng)的相機(jī)位子,γγγ其中γ,NeO 360推斷近遠(yuǎn)背景的密度和輻射場(chǎng)(類似于 NeRF++),兩者的主要區(qū)別是NeO 360使?混合局部和全局特征來(lái)調(diào)節(jié)輻射場(chǎng)解碼器,?不是像經(jīng)典 NeRF 公式中所采?的那樣僅使?位置和觀察?向。

Image-Conditional Triplanar Representation(圖像條件三平?表示)

雖然NeRF能夠產(chǎn)??保真場(chǎng)景合成,但局限于很難推?到新穎場(chǎng)景。為了有效地使?場(chǎng)景先驗(yàn)并從?量?界 360° 數(shù)據(jù)中學(xué)習(xí),本文提出了?種圖像條件三平?表示,這種表示能夠?qū)哂型暾?表現(xiàn)?的 3D 場(chǎng)景進(jìn)??規(guī)模建模,?不會(huì)忽略其任何維度(如在 2D 或基于 BEV 的表示中)并避免??復(fù)雜性(如在基于體素的表示中)。本文的三平?表示由三個(gè)軸對(duì)?的正交平?組成,其中是空間分辨率,每個(gè)平面具有維特征。為了從輸?圖像構(gòu)建特征三平?,方法如下:

- 本文?先使?經(jīng)過(guò) ImageNet 預(yù)訓(xùn)練的 ConvNet backbone E提取低分辨率空間特征表示,其將原始輸入的圖像轉(zhuǎn)化為長(zhǎng)寬分別變?yōu)?/2的特征圖。然后根據(jù)相機(jī)位姿和內(nèi)參沿著每條射線反投影為3D特征體數(shù)據(jù)。

- 由于沿相機(jī)光線的所有特征在?格中都是相同的,因此本文通過(guò)額外的 MLP 進(jìn)?步學(xué)習(xí)各個(gè)特征的深度,,它將?格中的輸入體數(shù)據(jù)特征、在相機(jī)坐標(biāo)系中的網(wǎng)格位置和在世界坐標(biāo)系下的網(wǎng)格的方向用concatenated連接轉(zhuǎn)換到相機(jī)坐標(biāo)下輸出深度編碼特征。接下來(lái)通過(guò)在獨(dú)立的體特征維度上使用可學(xué)習(xí)的權(quán)重獲得三平?特征:其中的代表MLPs特征聚合,代表在維度累加之后的softmax得分。將特征投影到各個(gè)平?的動(dòng)機(jī)之?是避免 3D CNN 的計(jì)算??復(fù)雜性,同時(shí)? BEV 或 2D 特征表示更具表現(xiàn)?但該類方法?基于體素的表示在計(jì)算上更有效,但省略 軸會(huì)損害它們的表達(dá)能?。相反,本文依靠 2D 卷積將構(gòu)建的圖像條件三平?轉(zhuǎn)換為新的 通道輸出,其中、同時(shí)對(duì)平?的空間維度進(jìn)?上采樣到圖像特征空間。學(xué)習(xí)到的卷積充當(dāng)修復(fù)?絡(luò)來(lái)填充缺失的特征。本文的三平?表示充當(dāng)全局特征表示,因?yàn)橹庇^上,從不同?度檢查時(shí)可以更好地表示復(fù)雜場(chǎng)景。這是因?yàn)槊總€(gè)都可以提供補(bǔ)充信息,可以幫助更有效地理解場(chǎng)景。

Deep Residual Local Features (深層殘差局部特征)

對(duì)于接下來(lái)的輻射場(chǎng)解碼階段,本文還使?特征作為渲染 MLP 的殘差連接。本文獲得從通過(guò)投影世界點(diǎn)使?其相機(jī)參數(shù)γ進(jìn)?源視圖,并通過(guò)雙線性插值在投影像素位置提取特征。請(qǐng)注意,局部和全局特征提取路徑共享相同的權(quán)重θ和編碼器。本文發(fā)現(xiàn),對(duì)于復(fù)雜的城市?界場(chǎng)景,僅使?局部特征導(dǎo)致遮擋和遠(yuǎn)處 360° 視角表現(xiàn)不佳。另???,僅使?全局特征會(huì)導(dǎo)致幻覺(jué)。本文的?法有效地結(jié)合了局部和全局特征表示,從?產(chǎn)?更準(zhǔn)確的 360° 從最?的?限場(chǎng)景的單?視圖進(jìn)?視圖合成。

Decoding Radiance Fields(解碼輻射場(chǎng))

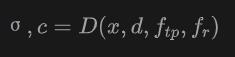

輻射場(chǎng)解碼器是用來(lái)預(yù)測(cè)顏?和密度σ對(duì)于任意 3D 位置和任意觀看?向從三平?和殘差特征 。本文使?模塊化實(shí)現(xiàn)的渲染 MLP。MLP 表示為:

其中,通過(guò)正交投影點(diǎn)進(jìn)?每個(gè)平?并執(zhí)?雙線性采樣獲得,且由三個(gè)雙線性采樣向量連接成

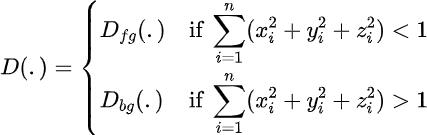

。本文使用輸入圖像的視圖空間來(lái)建立本文的坐標(biāo)系,然后在這個(gè)特定的坐標(biāo)系中展示位置和攝像機(jī)射線。Near and Far Decoding MLPs類似于NeRF++,本文定義了兩個(gè)渲染MLP來(lái)解碼顏?和密 度信息,如下所示:

本文定義?個(gè)坐標(biāo)重映射函數(shù) (M) 類似于原始 NeRF++收縮位于單位球體之外的 3D 點(diǎn), 這有助于更多對(duì)象在渲染 MLP 中獲得較低的分辨率。在查詢階段的三平?表示,本文使?在現(xiàn)實(shí)世界坐標(biāo)中的?收縮坐標(biāo),因?yàn)楸疚牡谋硎臼瞧??不是球體。對(duì)于渲染,本文使?各?的放縮后的坐標(biāo)?于調(diào)節(jié) MLP。Optimizing radiance fields for few-shot novel-view synthesis給定源視圖的局部和全局特征,在完成體積渲染和合成近處和遠(yuǎn)處背景后,使用專用的解碼顏色和強(qiáng)度近背景和遠(yuǎn)背景MLPs解碼器和

:?標(biāo)圖像中采樣的像素位置:從近和遠(yuǎn)的MLPs渲染輸出中獲得的合成顏色。

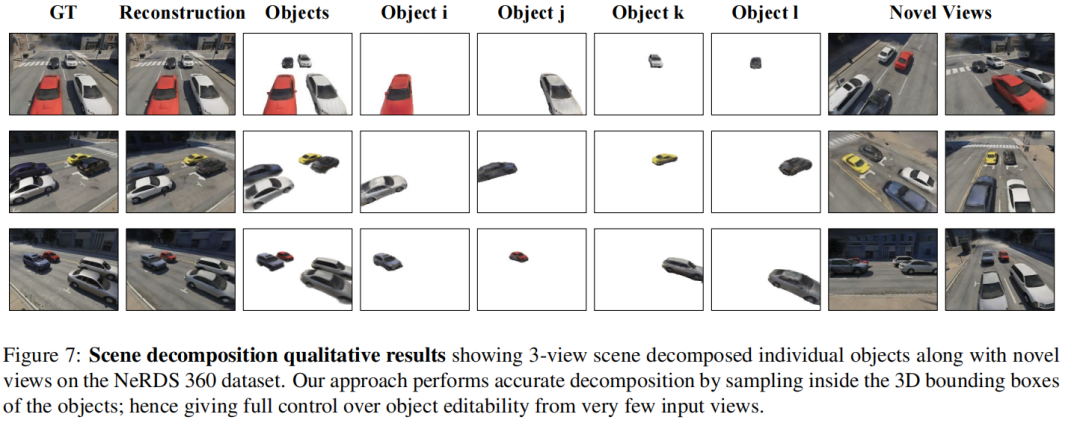

Scene Editing and Decomposition(場(chǎng)景編輯與分解)

給定從檢測(cè)器獲得的 3D 邊界框,本文可以通過(guò)簡(jiǎn)單地對(duì)對(duì)象的 3D 邊界框內(nèi)的光線進(jìn)?采樣,獲得單個(gè)對(duì)象和背景輻射率,并在這些特定的處雙線性插值特征在本文的三平?特征?格中的位置,使得編輯和重新渲染單個(gè)對(duì)象變得簡(jiǎn)單。本文通過(guò)考慮對(duì)象 3D 邊界框 內(nèi)的特征來(lái)執(zhí)?準(zhǔn)確的對(duì)象重新渲染,以渲染前景MLP。本質(zhì)上,本文將組合的可編輯場(chǎng)景渲染公式劃分為渲染對(duì)象、近背景和遠(yuǎn)背景。

實(shí)驗(yàn):

baselines:

- NeRF:Vanilla NeRF 方法過(guò)擬合給定 RGB 圖像的場(chǎng)景

- PixelNeRF ?種可推?的 NeRF 變體,利?局部圖像特征進(jìn)?少鏡頭新穎視圖合成

- MVSNeRF:通過(guò)從源圖像構(gòu)建cost-volume獲得的局部特征來(lái)擴(kuò)展 NeRF 進(jìn)?少視圖合成

- NeO 360:本文提出的架構(gòu)將局部和全局特征結(jié)合起來(lái),用于通用場(chǎng)景表示學(xué)習(xí)。

結(jié)論:

在本?中,本文提出了 NeO 360,這是 NeRF ?法的可推?擴(kuò)展,?于?界360°場(chǎng)景。本文的?法依賴于圖像條件三平?表示來(lái)進(jìn)?少量新穎的視圖合成。為了為?界場(chǎng)景建?強(qiáng)?的先驗(yàn),本文提出了?個(gè)?規(guī)模數(shù)據(jù)集 NERDS 360 來(lái)研究 360 度設(shè)置中的視圖合成、重建和分解。本文的?法的性能明顯優(yōu)于其他可推?的 NeRF 變體,并且在新場(chǎng)景上進(jìn)?測(cè)試時(shí)實(shí)現(xiàn)了更?的性能。對(duì)于未來(lái)的?作,本文將探索如何使?所提出的?法來(lái)構(gòu)建較 少依賴標(biāo)記數(shù)據(jù)的先驗(yàn),例如推理過(guò)程中的 3D 邊界框,?是依賴運(yùn)動(dòng)線索在沒(méi)有標(biāo)記數(shù)據(jù)的情況下進(jìn)?有效的場(chǎng)景分解。

原文鏈接:https://mp.weixin.qq.com/s/rjJlJbbb_oFah5nZoSYQwA