異步爬蟲進階:使用Asyncio和Aiohttp實現高效異步爬取

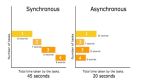

異步處理概述: 異步處理是一種編程模式,它允許同時執行多個任務而不需要等待前一個任務完成。這種方式可以提高程序的效率,特別是在涉及到網絡請求、數據庫查詢等IO密集型操作時。異步處理通過將任務分解為小的可獨立執行的部分,并以非阻塞的方式執行這些部分來實現高效處理。

使用異步IO庫進行異步爬取:

asyncio庫:Python的asyncio庫提供了一種編寫異步代碼的方式,它基于協程(coroutines)和事件循環(event loop)模型。使用asyncio可以編寫異步代碼,并通過await關鍵字來等待IO操作的完成。以下是一個使用asyncio和aiohttp庫進行異步爬取的示例:

import asyncio

import aiohttp

async def fetch(session, url):

async with session.get(url) as response:

return await response.text()

async def main():

async with aiohttp.ClientSession() as session:

urls = ['http://example.com', 'http://example.org', 'http://example.net']

tasks = []

for url in urls:

task = asyncio.create_task(fetch(session, url))

tasks.append(task)

responses = await asyncio.gather(*tasks)

for response in responses:

print(response)

asyncio.run(main())aiohttp庫:aiohttp是一個基于asyncio實現的異步HTTP客戶端庫。它提供了簡單易用的API來進行HTTP請求和響應處理。在上述示例中,我們使用了aiohttp庫來發送異步HTTP請求。

優化Scrapy性能: Scrapy是一個強大的Python爬蟲框架,它具有豐富的功能和靈活的架構。以下是一些優化Scrapy性能的方法:

并發請求數:通過設置CONCURRENT_REQUESTS參數來控制同時發送的請求數量。適當增加并發請求數可以加快爬取速度,但要注意不要設置過高導致服務器負載過大。可以通過調整CONCURRENT_REQUESTS參數的值進行優化。

下載延遲:通過設置DOWNLOAD_DELAY參數來控制請求之間的延遲時間。添加適當的延遲可以減輕對目標網站的壓力,并避免被封IP。可以根據目標網站的反爬蟲策略和服務器負載情況調整DOWNLOAD_DELAY的值。

使用異步處理:Scrapy提供了Twisted框架的支持,可以利用Twisted的異步特性來提高爬取效率。可以使用deferred對象、異步回調函數等來實現異步處理,避免阻塞調整并發數和下載延遲的組合:通過調整并發請求數和下載延遲的組合,可以優化Scrapy的性能。增加并發請求數同時降低下載延遲可能會加快爬取速度,但需要注意不要過度請求目標網站。可以進行一些實驗和測試,找到最佳的組合方式。

使用合適的下載器中間件和擴展:Scrapy提供了下載器中間件和擴展機制,可以自定義請求和響應的處理過程。通過編寫自定義的下載器中間件和擴展,可以對請求進行優化,如添加代理、設置請求頭等,以及對響應進行處理,如解析HTML、提取數據等。合理使用這些機制可以提高爬取效率。

使用合適的調度器:Scrapy默認使用的是基于優先級隊列的調度器。如果目標網站的鏈接數量非常龐大,可以考慮使用其他調度器,如Redis調度器或Bloom Filter調度器,來提高調度效率和去重功能。

控制爬蟲的深度和范圍:合理控制爬蟲的深度和范圍可以避免不必要的爬取和資源浪費。通過設置DEPTH_LIMIT參數和allowed_domains屬性,可以限制爬蟲的深度和范圍,只爬取目標頁面及相關鏈接。

使用緩存:對于頻繁訪問的頁面或數據,可以考慮使用緩存機制。通過緩存響應數據,可以避免重復請求和處理,提高爬取效率。

避免重復請求:通過設置DUPEFILTER_CLASS參數,可以使用不同的去重機制來避免發送重復請求。Scrapy默認使用的是基于哈希的去重機制,但也可以自定義去重邏輯,根據具體情況選擇合適的去重方式。

使用分布式爬蟲:如果需要處理大規模的數據或高并發情況,可以考慮使用分布式爬蟲。將爬取任務分發到多個節點上,可以提高爬取速度和效率。

通過以上方法,可以有效地優化Scrapy的性能,提高爬取效率和并發處理能力。然而,具體的優化策略和參數設置需要根據具體的爬取目標和環境進行調整和測試,以獲得最佳的性能優化結果。