Meta-Transformer 多模態學習的統一框架

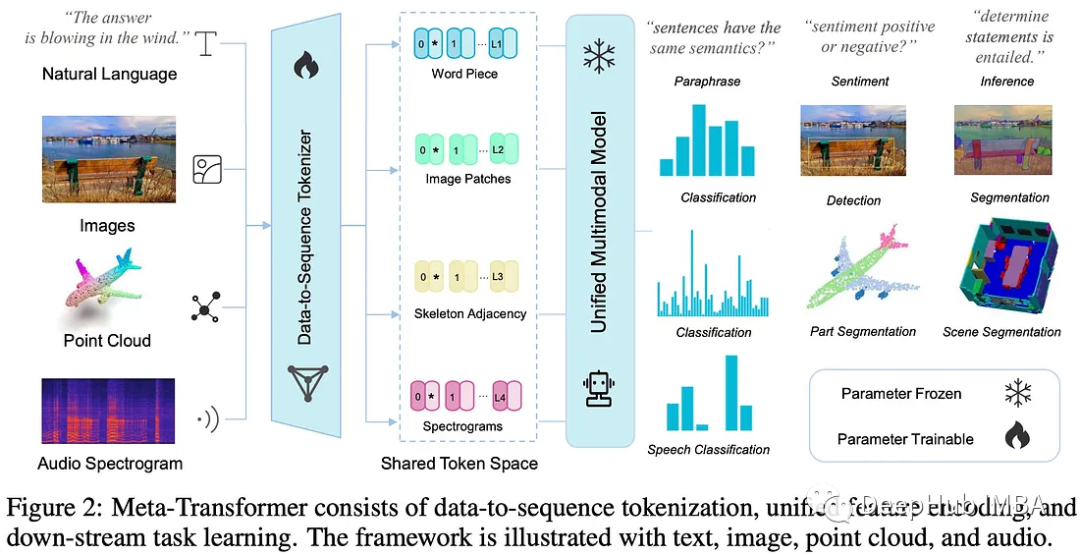

Meta-Transformer是一個用于多模態學習的新框架,用來處理和關聯來自多種模態的信息,如自然語言、圖像、點云、音頻、視頻、時間序列和表格數據,雖然各種數據之間存在固有的差距,但是Meta-Transformer利用凍結編碼器從共享標記空間的輸入數據中提取高級語義特征,不需要配對的多模態訓練數據。該框架由統一的數據標記器、模式共享編碼器和用于各種下游任務的任務頭組成。它是在不同模式下使用未配對數據執行統一學習的第一次努力。實驗表明,它可以處理從基礎感知到實際應用和數據挖掘的廣泛任務。

Meta-Transformer

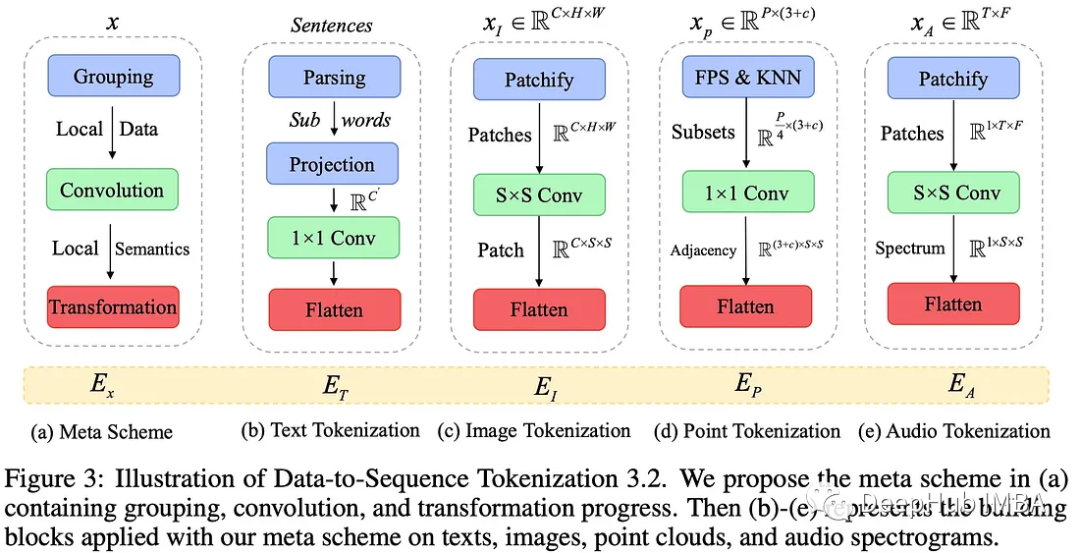

數據到序列的令牌標記

研究人員提出了一種元標記化方案,將來自不同模式(如文本、圖像、點云和音頻)的數據轉換為共享空間中的標記嵌入。

對于自然語言,他們使用了帶有30000個標記詞匯表的WordPiece 嵌入,它將單詞分割成子單詞,并將每個輸入文本轉換成一組標記嵌入。

對于圖像,他們將圖像重塑為一系列平坦的2D補丁,然后利用投影層投影嵌入維度。該操作也可用于紅外圖像,而線性投影用于高光譜圖像。他們用3D卷積代替2D卷積層用于視頻識別。

對于點云,采用最遠點采樣(FPS)操作將原始點云從原始輸入空間轉換為標記嵌入空間,以固定采樣比對原始點云的代表性骨架進行采樣。然后,使用k -最近鄰(KNN)對相鄰點進行分組,并構建鄰接矩陣來捕獲3D物體和場景的結構信息。

對于音頻頻譜圖,使用Mel濾波器組和Hamming窗口對音頻波形進行預處理,以將波分割成間隔。然后將頻譜圖從時間和頻率維度分割成補丁,然后將其平面化為標記序列。

統一的編碼器

在將原始輸入從各種模式轉換為標記(令牌)嵌入后,研究人員使用了一個統一的Transformer 編碼器,其中包含了固定的參數來編碼這些令牌。基于ViT模型的編碼器在LAION-2B數據集上進行對比學習預訓練,提高編碼器的通用標記編碼能力。對于文本理解,他們使用來自CLIP的預訓練文本標記器將句子轉換為子詞,然后轉換為詞嵌入。

論文中作者提到的“模態不可知學習”,一個可學習的標記(xCLS)被添加到標記嵌入序列的開始。該令牌的最終隱藏狀態充當輸入序列的摘要表示,通常用于識別任務。位置嵌入也會被添加到標記嵌入中。

Transformer 編碼器由多個堆疊的多頭自關注層和MLP塊組成,對這些嵌入序列進行處理。作者指出,添加更復雜的2d感知位置嵌入并不能顯著提高圖像識別性能。

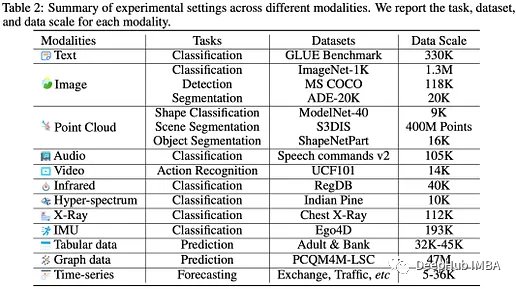

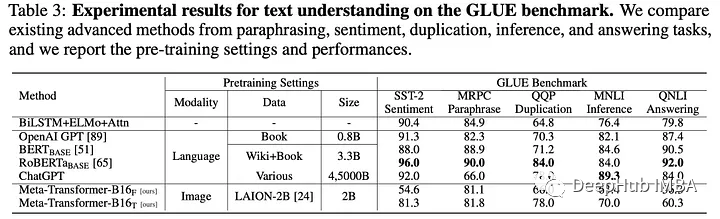

實驗結果

Meta-Transformer模型在各種語言和圖像理解任務中雖然并不總是優于其他先進的方法,但也表現出了很好的效果。

在GLUE基準測試的文本理解任務中,Meta-Transformer在情感、釋義、復制、推理和回答任務方面得分相對較高。雖然它的表現不如BERT、RoBERTa和ChatGPT等模型,但它在理解自然語言方面表現出了新的希望,尤其是在微調之后。

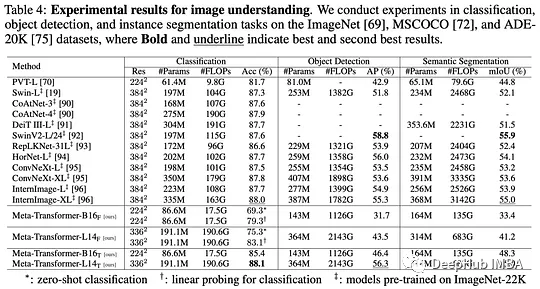

在圖像理解任務上,Meta-Transformer在幾個方面優于Swin Transformer系列和interimage等模型。當與CLIP文本編碼器相結合時,它在零樣本分類方面提供了強有力的結果。它在目標檢測和語義分割任務上也優于其他模型,顯示了它在圖像理解方面的熟練程度。

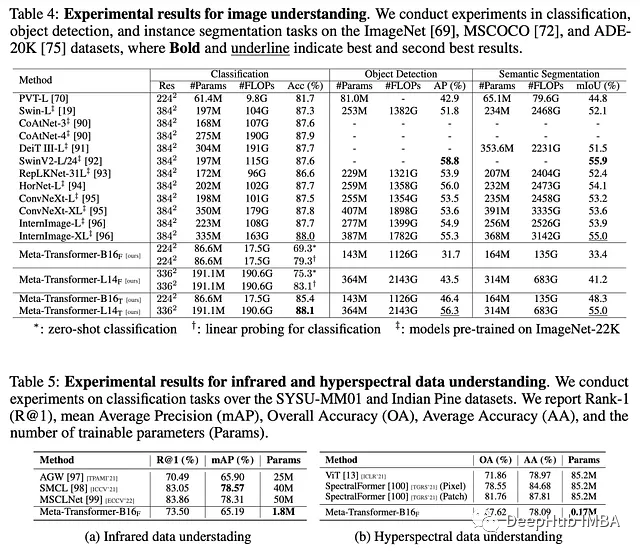

Meta-Transformer在處理紅外和高光譜圖像識別任務方面也被證明是有效的,分別在RegDB和Indian Pine數據集上進行了測試。盡管Meta-Transformer沒有登頂排行榜,但其結果也很不錯,展示了處理與紅外圖像和高光譜圖像相關的挑戰的潛力。

在x射線圖像處理方面,Meta-Transformer取得了94.1%的性能,表明其在醫學圖像分析方面的實用性。

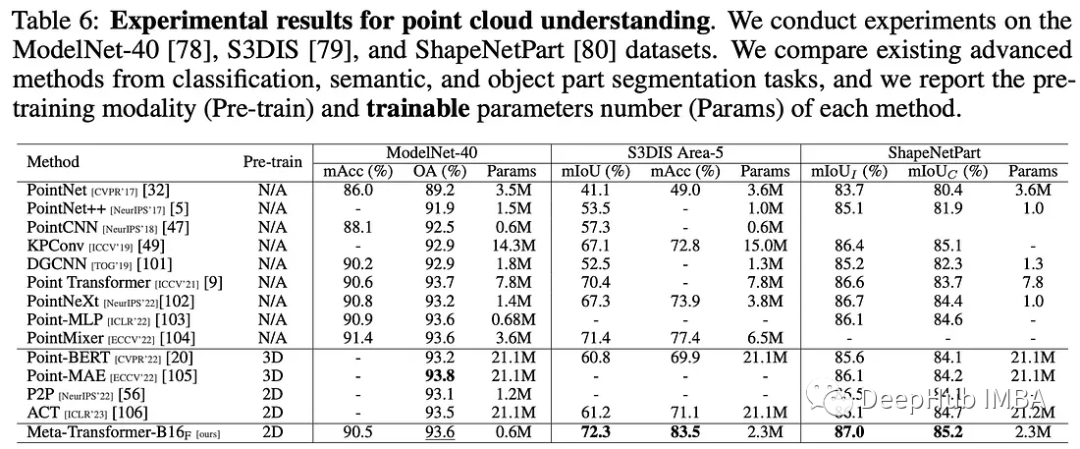

在點云理解任務中,Meta-Transformer在ModelNet-40、S3DIS和ShapeNetPart數據集上與其他模型相比,它在可訓練參數較少的情況下獲得了較高的準確率分數,強調了它在這一領域的效率。

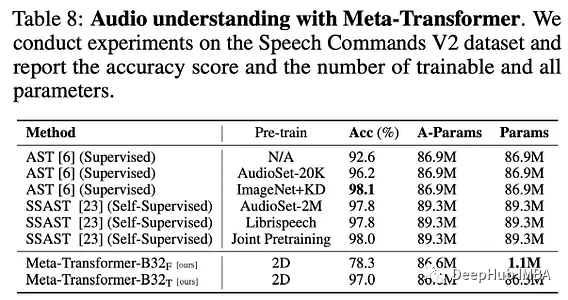

在音頻識別任務中,Meta-Transformer具有與AST和SSAST等現有音頻Transformer模型競爭的優勢,在調整參數時達到97.0%的高精度。盡管AST的性能很好,但像AST這樣的模型具有更多可訓練的參數。

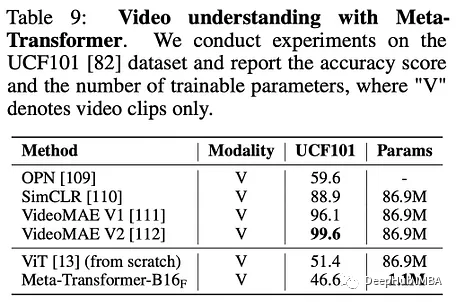

在視頻理解任務中,正如在UCF101數據集上測試的那樣,Meta-Transformer在準確性方面并不優于其他最先進的方法。但是它的突出之處在于其明顯較少的可訓練參數,這表明了統一的多模式學習和較低的體系結構復雜性的潛在好處。

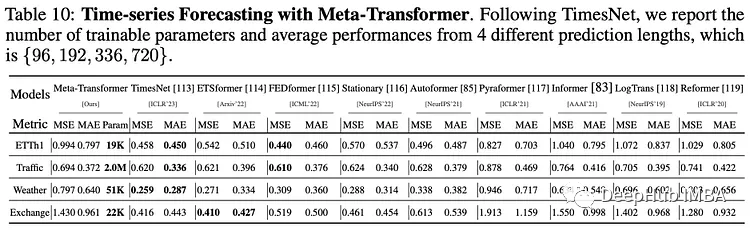

在時間序列預測任務中,Meta-Transformer在ETTh1、Traffic、Weather和Exchange數據集等基準測試上優于幾種現有方法,同時只需要很少的可訓練參數。

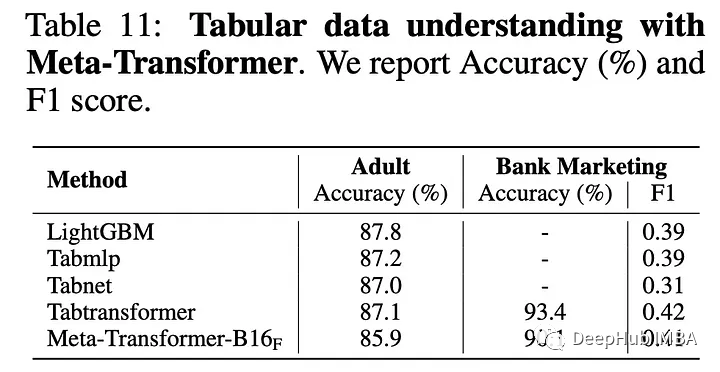

在表格數據理解任務中,Meta-Transformer在成人普查和銀行營銷數據集上表現出色。它在銀行營銷數據集上的表現優于其他模型,這表明它在理解復雜數據集方面具有潛力。

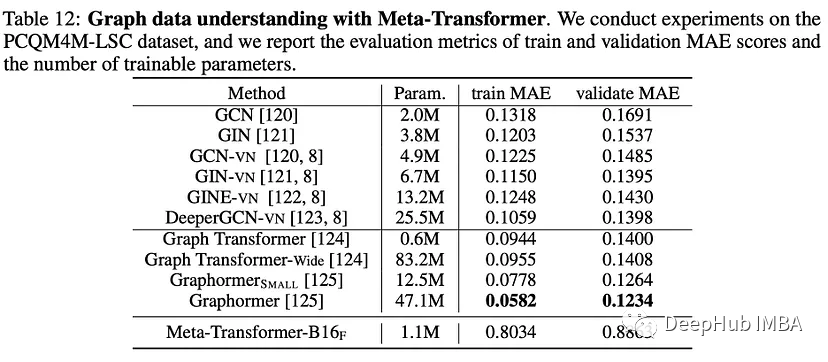

在PCQM4M-LSC數據集的圖理解任務中,當前的Meta-Transformer架構在結構數據學習方面表現并不好,graphhormer模型的表現優于它,這方面還要改進。

在Ego4D數據集的分類任務中,Meta-Transformer的準確率達到73.9%。總的來說,這些發現突出了Meta-Transformer在不同領域的多功能性和有效性。

上面有幾個結果都表明Meta-Transformer的參數少,模型效率更高,它的其中一個主要的限制是計算復雜度為O(n2x D)。