谷歌AGI機(jī)器人大招!54人天團(tuán)憋7個(gè)月,強(qiáng)泛化強(qiáng)推理,DeepMind和谷歌大腦合并后新成果

本文經(jīng)AI新媒體量子位(公眾號(hào)ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

爆火的大模型,正在重塑谷歌DeepMind的機(jī)器人研究。

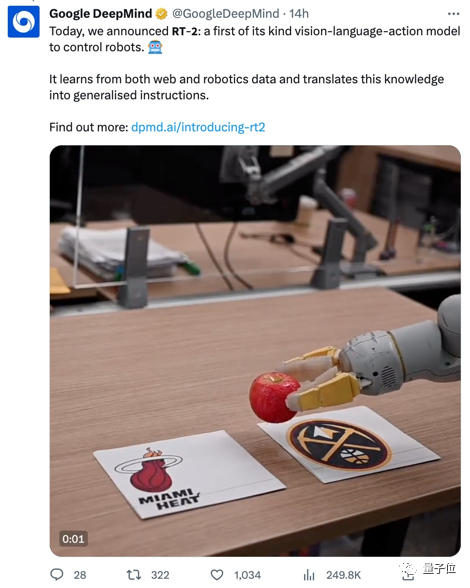

最新成果之一,就是他們耗時(shí)7個(gè)月打造的機(jī)器人項(xiàng)目RT-2,狠狠在網(wǎng)上火了一把:

效果究竟有多好?

只需用人話(huà)下達(dá)命令,面前這個(gè)小家伙就能揮動(dòng)機(jī)械臂,思考并完成“主人的任務(wù)”。

像是給流行歌手霉霉(Taylor Swift)遞水、或是辨認(rèn)明星球隊(duì)Logo:

甚至能主動(dòng)思考,讓它“撿起已滅絕的動(dòng)物”,就能從獅子、鯨魚(yú)、恐龍這三個(gè)塑料玩具中準(zhǔn)確pick恐龍。

用網(wǎng)友的話(huà)來(lái)說(shuō),別小看這個(gè)能力,這是實(shí)現(xiàn)了從“滅絕的動(dòng)物”到“塑料恐龍”的邏輯飛躍。

更“要命”的是,它還能輕松解決“給疲憊的人選一種飲料”這種需要結(jié)合思想鏈的多階段推理問(wèn)題——一聽(tīng)到命令小手就直奔紅牛而去,簡(jiǎn)直不要太聰明。

有網(wǎng)友看完感嘆:

等不及了,趕緊快進(jìn)到給人類(lèi)洗碗吧(手動(dòng)狗頭)

據(jù)了解,谷歌DeepMind這項(xiàng)成果由54位研究員合作產(chǎn)出,前前后后拉扯7個(gè)月,最終才變成我們看到的這樣“so easy”。

《紐約時(shí)報(bào)》介紹稱(chēng),谷歌DeepMind機(jī)器人技術(shù)主管Vincent Vanhoucke認(rèn)為,大模型徹底改變了他們部門(mén)的研究方向:

由于(大模型)這一變化,我們不得不重新考慮整個(gè)研究項(xiàng)目。

我們之前研究的很多東西,都已經(jīng)完全失效了。

所以,RT-2究竟能實(shí)現(xiàn)什么樣的效果,這研究又具體是怎么一回事兒?

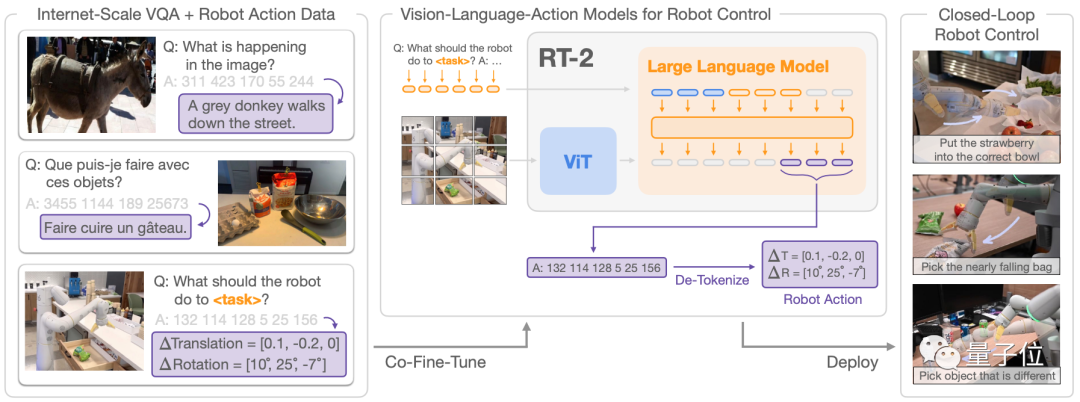

將多模態(tài)大模型“塞進(jìn)”機(jī)械臂

這個(gè)名叫RT-2(Robotic Transformer 2)的機(jī)器人項(xiàng)目,是去年年底發(fā)布的RT-1的“進(jìn)化版”。

相比于其他的機(jī)器人研究,RT-2的核心優(yōu)勢(shì)在于,不僅能理解“人話(huà)”,還能對(duì)“人話(huà)”進(jìn)行推理,并轉(zhuǎn)變?yōu)闄C(jī)器人能理解的指令,從而分階段完成任務(wù)。

具體來(lái)說(shuō),它具備三大能力——符號(hào)理解(Symbol understanding)、推理(Reasoning)和人類(lèi)識(shí)別(Human recognition)。

第一個(gè)能力是“符號(hào)理解”,能將大模型預(yù)訓(xùn)練的知識(shí),直接延展到機(jī)器人此前沒(méi)見(jiàn)過(guò)的數(shù)據(jù)上。例如機(jī)器人數(shù)據(jù)庫(kù)中雖然沒(méi)有“紅牛”,但它卻能從大模型的知識(shí)中理解并掌握“紅牛”的外貌,并拿捏物品。

第二個(gè)能力是“推理”,這也是RT-2的核心優(yōu)勢(shì),要求機(jī)器人掌握數(shù)學(xué)、視覺(jué)推理和多語(yǔ)言理解三大技能。

技能一,包含數(shù)學(xué)邏輯推理的命令,“將香蕉放到2+1的總和的位置”:

技能二,視覺(jué)推理,像是“將草莓放進(jìn)正確的碗中”:

技能三,多語(yǔ)言理解,即使不用英語(yǔ)也能完成指令,例如用西班牙語(yǔ)命令它“從一堆物品中挑出最與眾不同的那個(gè)”:

第三個(gè)能力是人類(lèi)識(shí)別,準(zhǔn)確識(shí)別并理解人類(lèi)的行為,像開(kāi)頭看到的“將水遞給泰勒·斯威夫特”例子就是能力展現(xiàn)之一。

那么,這三個(gè)能力是怎么實(shí)現(xiàn)的?

簡(jiǎn)單來(lái)說(shuō),就是將視覺(jué)-文本多模態(tài)大模型(VLM)具備的“推理”、“識(shí)別”、“數(shù)學(xué)”等能力,和機(jī)器人的操作能力結(jié)合起來(lái)。

為了實(shí)現(xiàn)這一點(diǎn),研究人員直接給視覺(jué)-文本大模型(VLM)增加了一個(gè)模態(tài),叫做“機(jī)器人動(dòng)作模態(tài)”,從而把它變成了視覺(jué)-文本-動(dòng)作大模型(VLA)。

隨后,將原本非常具體的機(jī)器人動(dòng)作數(shù)據(jù),轉(zhuǎn)變成文本token。

例如將轉(zhuǎn)動(dòng)度數(shù)、放到哪個(gè)坐標(biāo)點(diǎn)等數(shù)據(jù),轉(zhuǎn)變成文本“放到某個(gè)位置”。

這樣一來(lái),機(jī)器人數(shù)據(jù)也能被用到視覺(jué)-語(yǔ)言數(shù)據(jù)集中進(jìn)行訓(xùn)練,同時(shí)在進(jìn)行推理的過(guò)程中,原本的文本指令也會(huì)被重新轉(zhuǎn)化為機(jī)器人數(shù)據(jù),實(shí)現(xiàn)控制機(jī)器人等一系列操作。

沒(méi)錯(cuò),就是這么簡(jiǎn)單粗暴(手動(dòng)狗頭)

在這次的研究中,團(tuán)隊(duì)主要基于谷歌的一系列基礎(chǔ)大模型來(lái)“做升級(jí)”,包括50億和550億的PaLI-X、30億的PaLI以及120億的PaLM-E。

為了提升大模型本身的能力,研究人員也下了不少功夫,把最近爆火的思維鏈、向量數(shù)據(jù)庫(kù)和無(wú)梯度架構(gòu)(no-gradient architectures)都用上了。

這一系列操作,也讓RT-2和去年發(fā)布的RT-1相比,具有了不少新優(yōu)勢(shì)。

下面就來(lái)看看具體的實(shí)驗(yàn)結(jié)果。

性能可達(dá)RT-1三倍

RT-2使用上一代機(jī)器人模型RT-1的數(shù)據(jù)進(jìn)行訓(xùn)練(也就是說(shuō)數(shù)據(jù)沒(méi)變,只是方法不同了)。

這些數(shù)據(jù)是用13個(gè)機(jī)器人在辦公室搭建的一個(gè)廚房環(huán)境中耗時(shí)17個(gè)月收集到的。

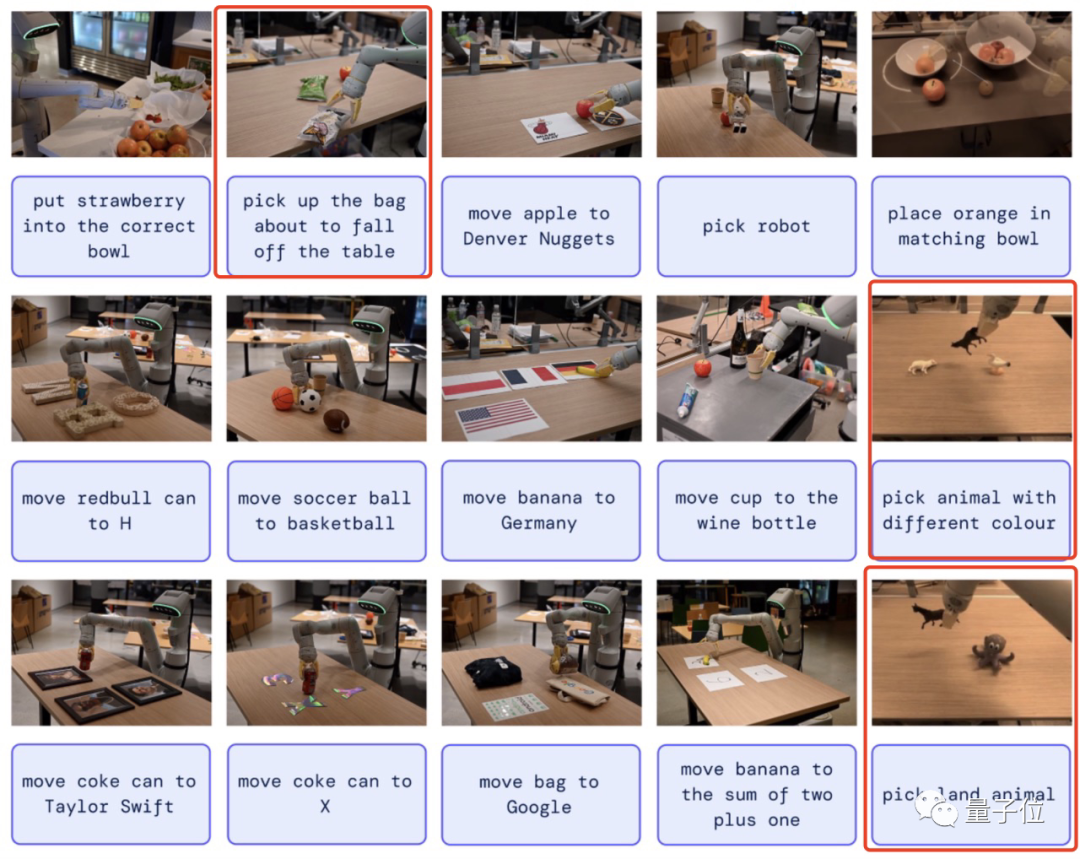

在實(shí)際測(cè)試中(一共歷經(jīng)6000次),作者給了RT-2許多以前未見(jiàn)過(guò)的物體,需要RT-2在微調(diào)數(shù)據(jù)之外進(jìn)行語(yǔ)義理解來(lái)完成任務(wù)。

結(jié)果完成的都相當(dāng)不錯(cuò):

包括從簡(jiǎn)單的識(shí)別字母、國(guó)旗、人物到從玩偶中識(shí)別陸生動(dòng)物、選出顏色不相同的那只,甚至是撿起快要從桌上掉下去的零食等復(fù)雜的命令。

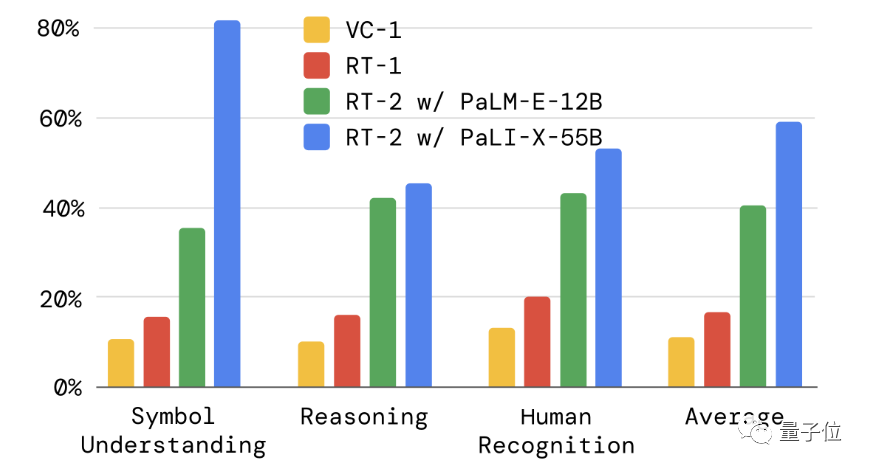

而從符號(hào)理解、推理和人類(lèi)識(shí)別這三個(gè)細(xì)分能力上來(lái)看,RT-2的兩個(gè)變體都比RT-1和另一種視覺(jué)預(yù)訓(xùn)練方法VC-1要好很多,性能最高可達(dá)3倍。

如前文所述,這兩個(gè)變體分別在120億參數(shù)的PaLM-E和550億參數(shù)的PaLI-X上進(jìn)行訓(xùn)練。

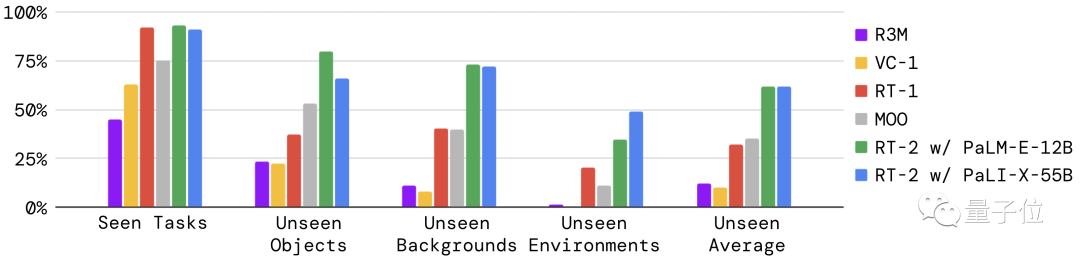

具體的泛化能力評(píng)估上,通過(guò)與多個(gè)基線(xiàn)模型的多類(lèi)細(xì)分測(cè)試,最終發(fā)現(xiàn)RT-2性能提高了大約2倍。

(稍顯遺憾的是,我們還沒(méi)看到它和其他團(tuán)隊(duì)最新基于LLM的機(jī)器人方法進(jìn)行對(duì)比)

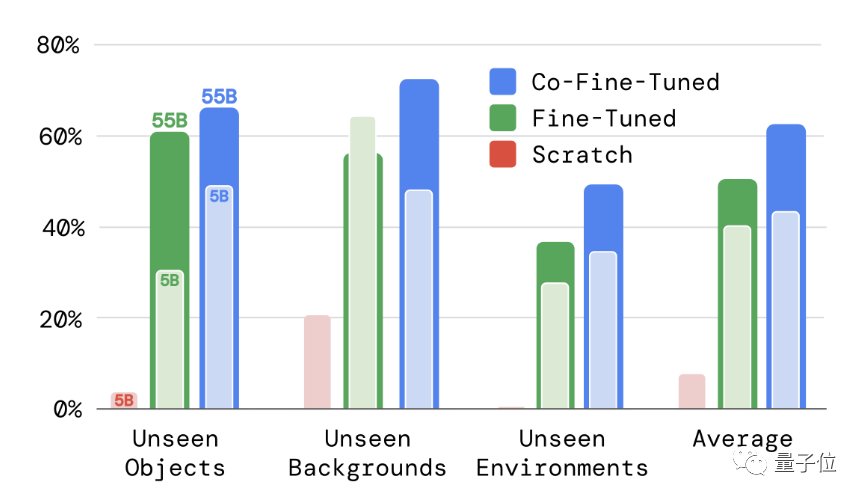

而為了更好地理解RT-2的不同設(shè)置如何影響泛化結(jié)果,作者又設(shè)計(jì)了兩大類(lèi)評(píng)估:

一是在模型尺寸上,僅在RT-2 PaLI-X變體分別采用50億參數(shù)與550億參數(shù)進(jìn)行訓(xùn)練;

二是訓(xùn)練方法上,分別采用從頭開(kāi)始訓(xùn)練模型vs微調(diào)vs協(xié)同微調(diào)的方法。

最終結(jié)果表明,視覺(jué)語(yǔ)言模型預(yù)訓(xùn)練權(quán)重的重要性以及模型泛化能力有隨著模型大小而提高的趨勢(shì)。

另外,作者還在開(kāi)源語(yǔ)言表基準(zhǔn)上評(píng)估了RT-2,結(jié)果顯示它在模擬基準(zhǔn)上實(shí)現(xiàn)了SOTA結(jié)果(90%vs之前的77%)。

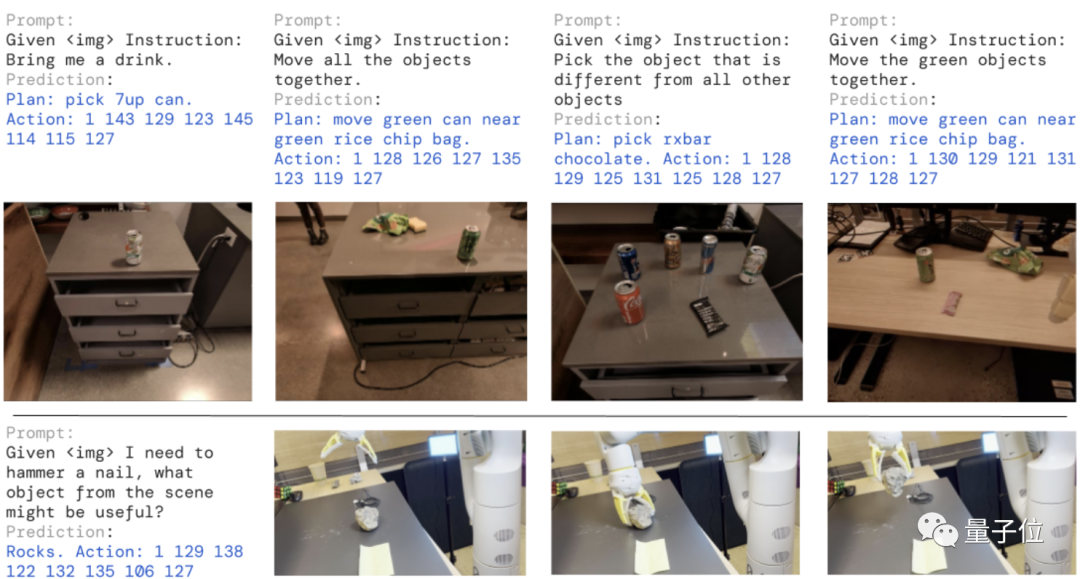

最后,由于RT-2 PaLM-E變體是一個(gè)視覺(jué)-語(yǔ)言-動(dòng)作模型,可以在單個(gè)神經(jīng)網(wǎng)絡(luò)中充當(dāng)LLM、VLM和機(jī)器人控制器,因此RT-2還可以執(zhí)行可控的思想鏈推理。

如下圖所示的5個(gè)需要推理的任務(wù)中(尤其最后一個(gè)非常有意思:選擇可以替代錘子的物品),它接到命令后會(huì)先輸出自然語(yǔ)言步驟,然后再給出具體的動(dòng)作token。

最最后,總結(jié)來(lái)說(shuō),這個(gè)最新的RT-2模型,不僅能更好地適用于不同的、機(jī)器此前沒(méi)見(jiàn)過(guò)的場(chǎng)景中,泛化能力更好了;與此同時(shí),由于有了更好的大模型加持,它也掌握了一些有難度的新能力,比如推理。

One More Thing

谷歌將機(jī)器人研究的重心放在大模型上,似乎也不是“空穴來(lái)風(fēng)”。

就在這兩天,他們和哥倫比亞大學(xué)合作的一篇關(guān)于“用大模型幫助獲取更多機(jī)器人操作技能”的論文,同樣很火:

這篇論文提出了一種新的框架,不僅能讓機(jī)器人很好地適應(yīng)大模型,同時(shí)還能保留原本機(jī)器人的基礎(chǔ)操作和控制能力:

和RT-2有所不同的是,這一項(xiàng)目已經(jīng)開(kāi)源:

屬實(shí)是用大模型帶動(dòng)整個(gè)機(jī)器人部門(mén)升級(jí)了。

再聯(lián)想到前不久李飛飛團(tuán)隊(duì)的具身智能成果,可以說(shuō),用大模型帶動(dòng)機(jī)器人著實(shí)成為一種研究趨勢(shì),且已經(jīng)讓我們看到了一波非常有潛力的進(jìn)展。

對(duì)于這個(gè)研究方向,你有哪些期待?

項(xiàng)目地址:https://robotics-transformer2.github.io/