谷歌·Bard“史詩級”更新:定制化的中文服務(wù),開放圖像分析功能

今年三月份,谷歌宣布生成式AI Bard推出Beta測試版,當(dāng)時的版本只面向美國和英國用戶開放公測,且暫時只支持英語。

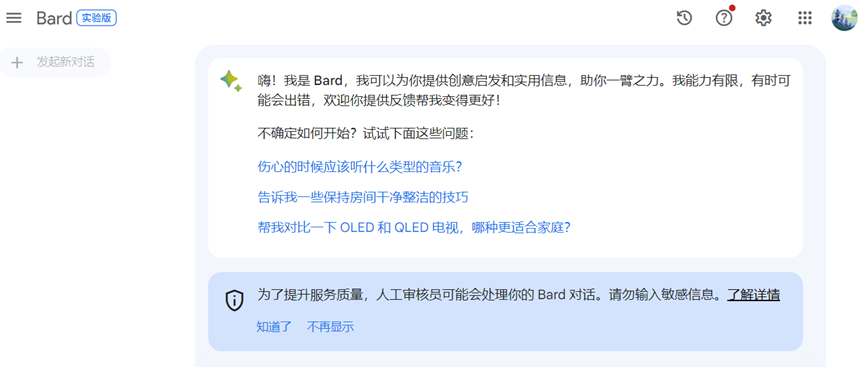

圖注:Bard已經(jīng)有專屬中文界面!堪稱定制化的中文服務(wù)

圖注:Bard已經(jīng)有專屬中文界面!堪稱定制化的中文服務(wù)

今天,Bard發(fā)布重大更新!Bard 支持的語言目前新增了 40 多種,包括阿拉伯語、中文(簡體/繁體)、德語、印地語、西班牙語等。

圖片

圖片

同時,谷歌還增加了推出 Bard 的地區(qū),包括歐盟的 27 個國家/地區(qū)和巴西。不過仍然沒包含中國。

圖片

圖片

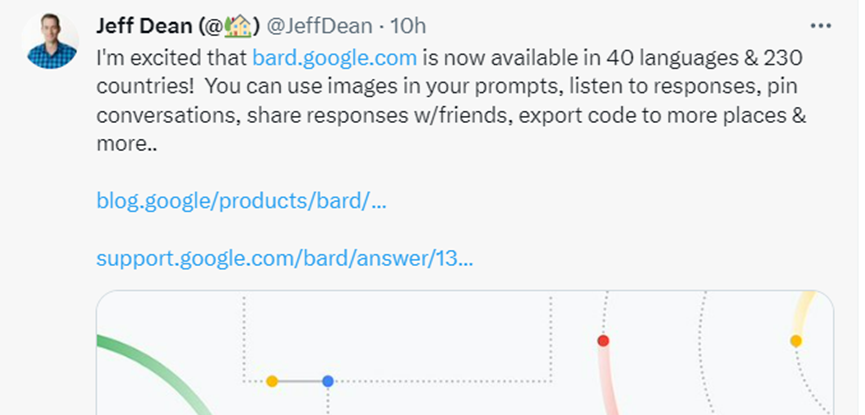

對于此次更新,稱之為“史詩級”:Today we’re announcing Bard’s biggest expansion to date.

1.Bard 支持 Google 智能鏡頭:與 Bard 對話時,你可以上傳圖片及文字,并要求Bard提供有關(guān)圖片的信息,相關(guān)功能暫時只支持英語。

圖片

圖片

2.Bard 可以朗讀回答內(nèi)容了:在 Bard 中添加了文字轉(zhuǎn)語音功能。該功能支持 40 多種語言,包括印地語、西班牙語和英語(美國)。

3.固定對話和近期對話:可以隨時返回之前與 Bard 的對話繼續(xù)互動,還可根據(jù)需要整理對話。

4.與他人分享 Bard對話:利用可分享的鏈接,讓其他人只需輕輕一點,即可輕松流暢地查看你的 Bard 對話內(nèi)容和相關(guān)信息來源。

圖注:修改回答

圖注:修改回答

5.修改 Bard 的回答:推出了 5 個新選項,可用來修改 Bard 的回答。只需點按相應(yīng)的選項,即可讓回答內(nèi)容變得更加簡單一點、詳盡一點、簡短一點、專業(yè)一點或隨意一點。

6.將 Python 代碼導(dǎo)出至 Replit:除了 Google Colab 之外,還可以將 Python 代碼導(dǎo)出到 Replit。

關(guān)于谷歌的Bard計劃

目前Bard 是一個實驗項目,由Google 的 PaLM 2 模型提供支持,讓用戶能夠與生成式 AI 協(xié)同合作。

自從OpenAI在2022年11月發(fā)布ChatGPT后,Google似乎一直在努力迎頭趕上其AI的發(fā)展。

2023年5月的Google I/O年度大會有了實質(zhì)性的動作。在長達(dá)兩小時的主題演講中,谷歌CEO Sundar Pichai和其他高管演講者,更是多達(dá)140次以上提到了“生成式AI”。

谷歌全力投入到科技潮流中。盡管Bard的用戶數(shù)未能達(dá)到ChatGPT的水平,但近期增長顯著,今日的更新可能進(jìn)一步推動其增長。

相比ChatGPT,Bard的最大優(yōu)勢是巨大的信息資源,他們可以依托谷歌的搜索工具獲取最新信息,根據(jù)自己的梳理給出答案。此前ChatGPT的訓(xùn)練數(shù)據(jù)最新只到2021年,無法回答2022年之后的信息咨詢。此外,Bard的回復(fù)速度也明顯快于ChatGPT。

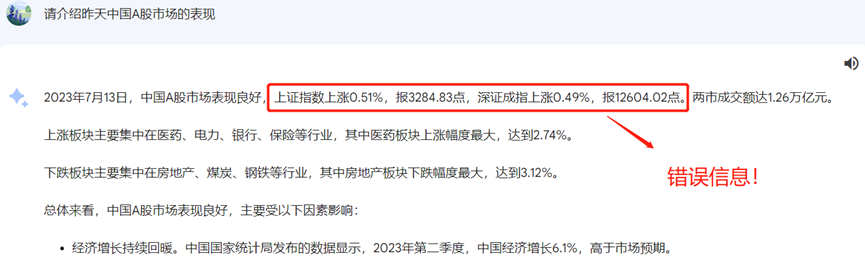

Bard可以聯(lián)網(wǎng)搜索信息,意味著用戶可以直接詢問今天的體育比賽比分、股價價格走勢、系列新聞動態(tài)。

文摘菌試了一下,搜索中文資料的功能,感覺非常差。

圖注:Bard的中文搜索功能

圖注:Bard的中文搜索功能

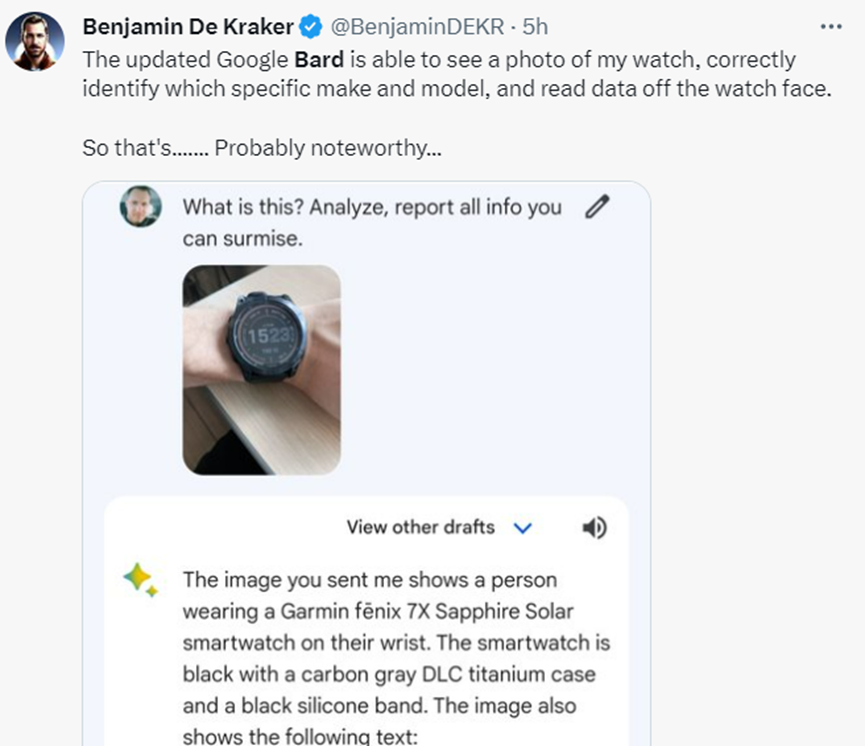

不過,有網(wǎng)友表示,Bard的精準(zhǔn)識圖功能異常強大:更新后的Google Bard能夠查看我的手表的照片,正確識別手表的特定品牌和型號,并從手表表面讀取數(shù)據(jù)。

圖片

圖片

谷歌人工智能現(xiàn)狀:骨干研究員“出逃”

從體驗上可以看出,谷歌Bard的功能在生成文本,理解內(nèi)容方面不如GPT-4;在上下文窗口容納方面沒“卷”過Claude。雖然新增了“精準(zhǔn)識圖”功能,但能釋放的生產(chǎn)力肯定不如前者。

似乎谷歌的AI之路這兩年總是慢了半拍。究其原因,除了猶豫是否發(fā)布與ChatGPT類似的聊天機器人的“墨跡”的性格,可能還和“留不住人”的企業(yè)文化有關(guān)。彭博社消息,Transformer合作者Llion Jones將于本月底離開谷歌。

圖片

圖片

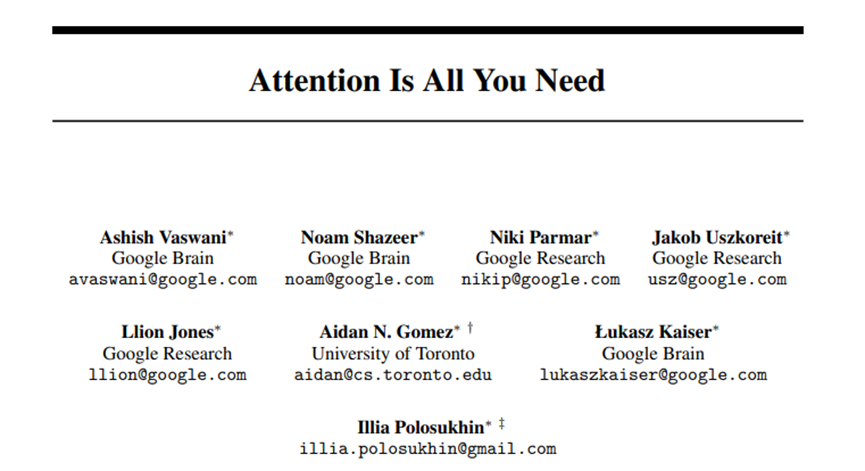

Transformer來源于論文“Attention is All You Need”,這篇開山之作奠定了今天生成式AI和大模型的基石。算上Llion Jones,當(dāng)時署名的6位谷歌研究員,已經(jīng)全部離職。

圖片

圖片

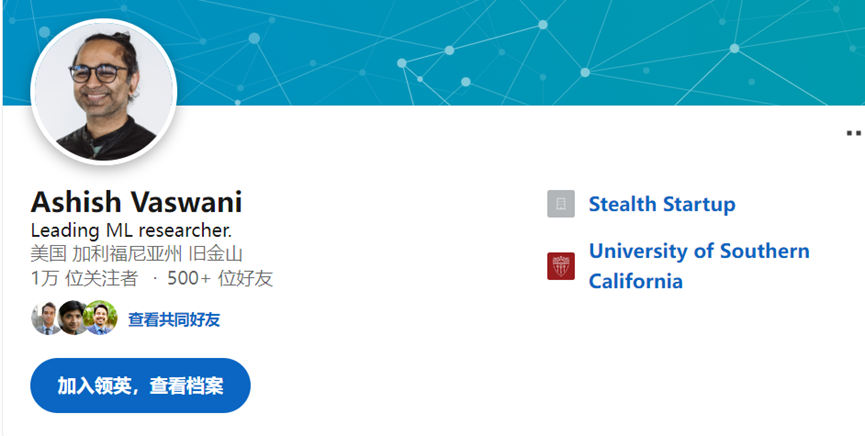

Ashish Vaswani在Google Brain工作了五年后離職,創(chuàng)辦了Adept(生成性AI工具);

圖片

圖片

Noam Shazeer在Google工作了21年,現(xiàn)在是Character.AI的首席執(zhí)行官;

圖片

圖片

Niki Parmar在Google工作后與Vaswani一起創(chuàng)立了Adept,但后來她也離開了Adept創(chuàng)立了新的公司;

圖片

圖片

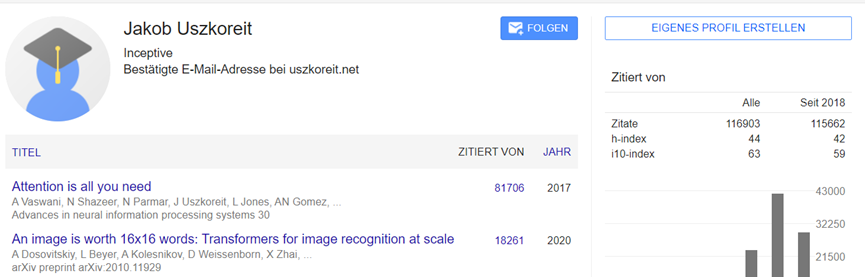

Jakob Uszkoreit在Google工作13年,現(xiàn)在他是Inceptive的聯(lián)合創(chuàng)始人;

圖片

圖片

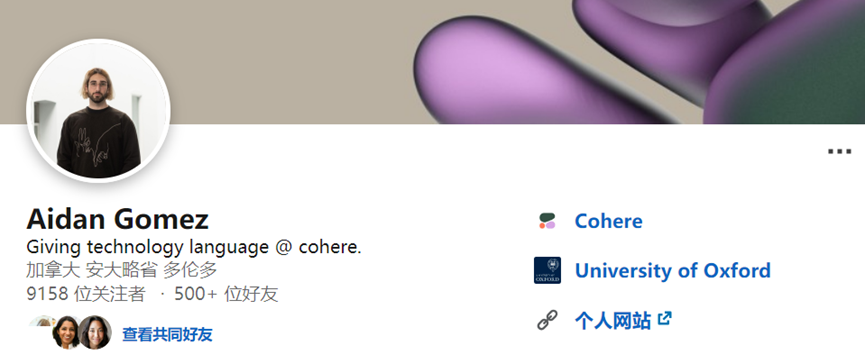

Aidan Gomez現(xiàn)在是Cohere的聯(lián)合創(chuàng)始人和首席執(zhí)行官;

圖片

圖片

Lukasz Kaiser離開Google后加入了OpenAI,他對OpenAI的GPT-4做出了重要貢獻(xiàn);

圖片

圖片

Illia Polosukhin在Google工作三年后創(chuàng)立了NEAR,致力打造Web3系統(tǒng)。

此外,還有一些重磅論文的重要作者也離開谷歌。例如:提出通用的端到端的序列學(xué)習(xí)方的論文“Sequence to Sequence Learning with Neural Networks”。

圖片

圖片

Ilya Sutskever著名論文“序列-to-序列”的第一作者,在谷歌待了3年,于2015年離開谷歌,目前是OpenAI的首席科學(xué)家。

圖片

圖片

Google的首個聊天機器人Meena 的技術(shù)論文“Towards a Human-like Open-Domain Chatbot”,被認(rèn)為是大語言模型的又一個重要里程碑,論文提出了一種想法,即創(chuàng)建一個大型語言模型,對任何問題生成像人一樣的回應(yīng),無需硬編碼(hard-coded)訓(xùn)練。

但里面的兩個研究員Daniel De Freitas和Romal Thoppilan都已經(jīng)離職,前者在Google Brain工作了五年,后者工作了七年,現(xiàn)在兩者共同成立了Character.AI。

圖片

圖片

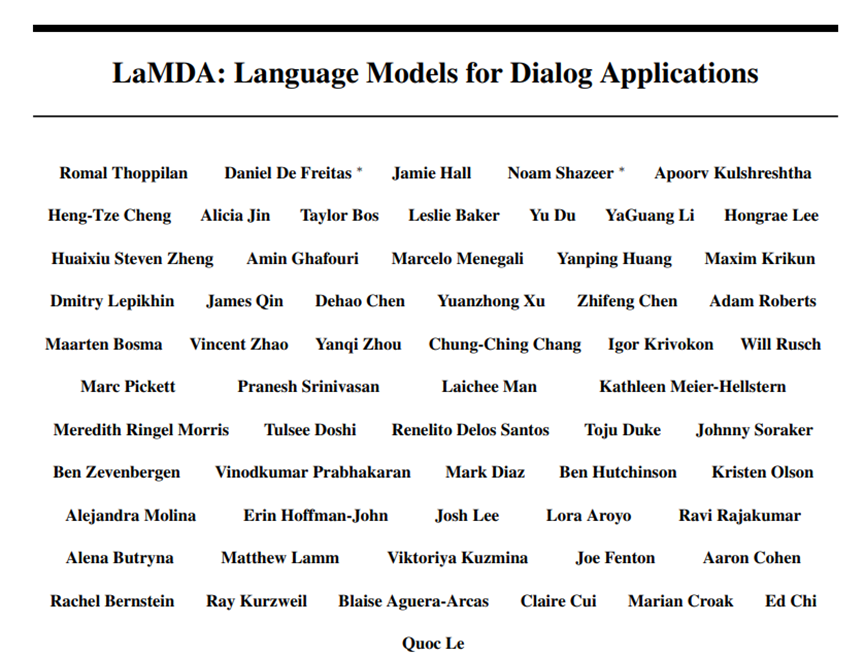

論文“LaMDA: Language Models for Dialog Applications”是Bard聊天機器人的技術(shù)基礎(chǔ),比Meena更強大,目前LaMDA的幾位主要研究人員已經(jīng)離開谷歌,加入了Character.AI,包括前面提到的:Noam Shazeer、Daniel De Freitas。此外,在谷歌工作了四年的Alicia Jin也已經(jīng)加入了Character.AI。

圖片

圖片

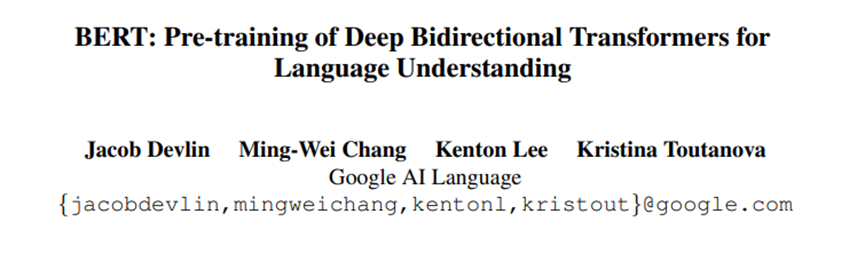

BERT是一種基于Transformer模型的自然語言處理工具,它通過預(yù)測隱藏或"掩碼"的詞來更好地理解文本。例如,如果你查詢"你能否為別人在藥店買藥",它會理解到"別人"是查詢的關(guān)鍵部分。自2019年Google將BERT納入搜索以來,它已經(jīng)極大地提高了搜索的準(zhǔn)確性。這篇論文由Jacob Devlin領(lǐng)導(dǎo),他曾短暫在OpenAI工作,但最近又回到了Google。

圖片

圖片

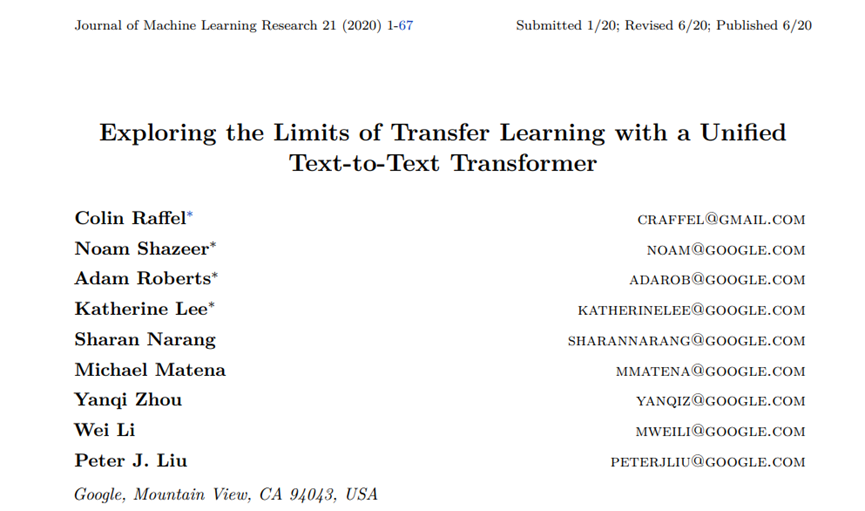

論文“Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer”提出了著名的T5架構(gòu),這篇論文的主導(dǎo)者Colin Raffel,也在2021年離開Google Brain。Raffel現(xiàn)在是北卡羅來納大學(xué)教堂山分校的助理教授,并在Hugging Face每周擔(dān)任一天的研究員,用戶可以在那里共享大型語言模型和數(shù)據(jù)集。

圖片

圖片

圖片

圖片

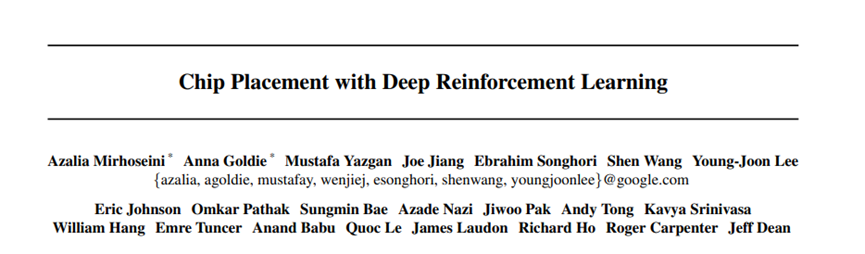

論文“Chip placement with deep reinforcement learning”和“A graph placement methodology for fast chip design” 能利用AI在芯片設(shè)計中達(dá)到最大性能,同時減少面積和電力使用。這些發(fā)現(xiàn)幫助Google設(shè)計了專為機器學(xué)習(xí)任務(wù)的TPU芯片。論文的兩位重要作者M(jìn)irhoseini和Goldie在2022年離開Google,加入了開發(fā)大型語言模型和名為Claude的聊天機器人的Anthropic。

至于離職的原因,有員工表示,在AI發(fā)展如此激動人心的時刻,初創(chuàng)公司為研究人員提供了機會,讓他們擁有更多的自主權(quán),并可能產(chǎn)生更大的影響。

換句話說,在谷歌推出新的想法 “太難了”,因為一旦失敗會對大公司聲譽造成非常大的影響。