大家都在吐槽GPT-4變「笨」了,可能是架構(gòu)重新設(shè)計惹的禍

距離 OpenAI 最初發(fā)布 GPT-4 已經(jīng)過去差不多 4 個月的時間了。然而,隨著時間的推移,近期,網(wǎng)上開始出現(xiàn)了一些質(zhì)疑聲,他們認為世界上最強大的 GPT-4 變得不那么強大了。

有些業(yè)內(nèi)人士認為,這可能和 OpenAI 對該系統(tǒng)的重大重新設(shè)計有關(guān)。

其實,最近幾周,我們或多或少的在網(wǎng)上看到 GPT-4 的用戶們對其性能下降怨聲載道,有用戶稱這個模型與其先前的推理能力以及其他輸出相比變得「懶惰(lazier)」和「愚笨(dumber)」。

不僅如此,在 Twitter 和 OpenAI 的在線開發(fā)者論壇的評論中,用戶們表達了對這一問題的不滿,例如 GPT-4 的邏輯能力減弱、錯誤回答增多、對提供的信息失去追蹤能力……

GPT-4 到底變得如何了,我們看看網(wǎng)友反饋。

GPT-4「變笨」,抱怨聲不斷

一位使用 GPT-4 進行網(wǎng)站開發(fā)的網(wǎng)友寫道:「現(xiàn)在的 GPT-4 非常令人失望。那感覺就像你開了一個月的法拉利,它突然變成了一輛破舊的皮卡車。照這樣下去,我不確定我是否愿意為此付費。」

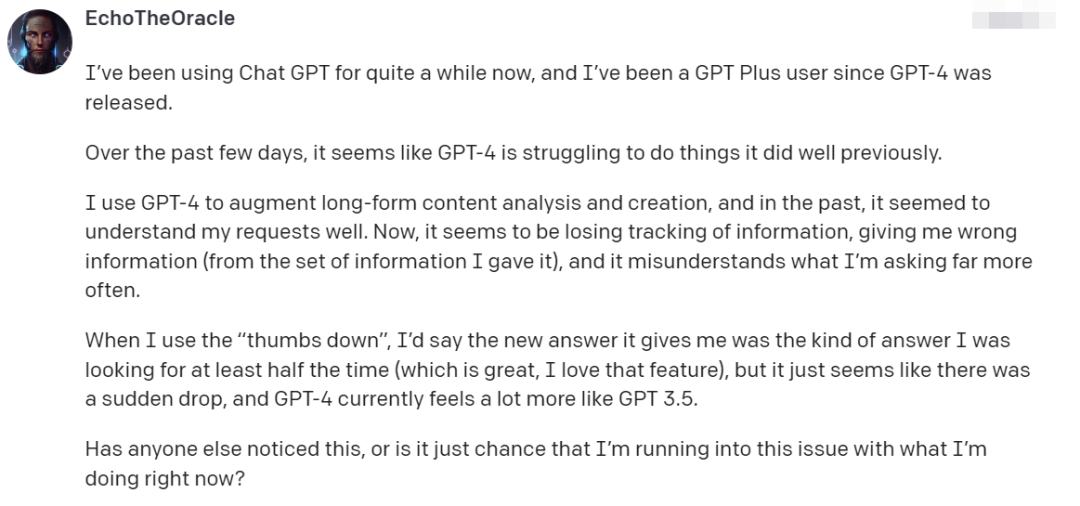

還有用戶表示:「我使用 ChatGPT 已經(jīng)有一段時間了,自從 GPT-4 發(fā)布以來,我一直是 GPT Plus 的付費用戶。過去幾天里,GPT-4 似乎在之前做得很好的事情上遇到了困難。我在使用 GPT-4 時,過去,它似乎能很好地理解我的請求。現(xiàn)在,它對信息的追蹤能力下降了,給我提供的信息有誤,而且經(jīng)常誤解我的問題。」

圖片

圖片

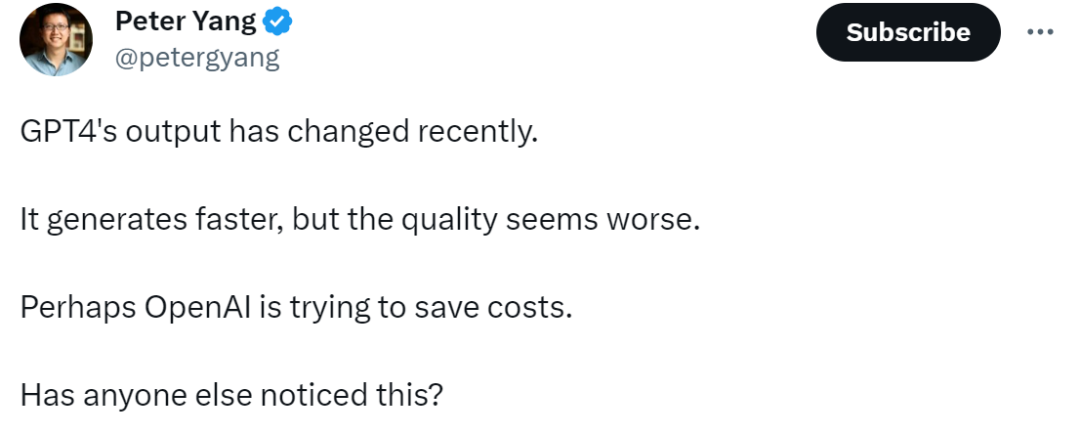

Roblox 的產(chǎn)品負責(zé)人 Peter Yang 在 Twitter 上聲稱,GPT-4 的輸出速度變快了,但輸出質(zhì)量卻更差了。例如一些簡單的問題,比如讓它輸出更清晰簡潔、更有創(chuàng)意的文字任務(wù)上。GPT-4 給出的結(jié)果在我看來,質(zhì)量下降了:

圖片

圖片

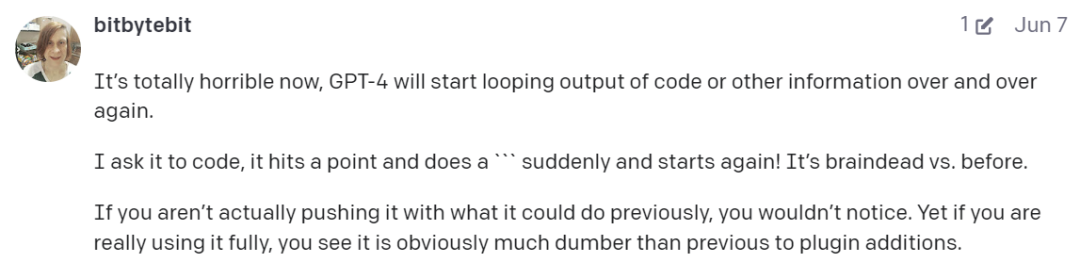

「GPT-4 開始一遍又一遍地循環(huán)輸出代碼和其他信息。與之前相比,它就像腦死亡了一樣。如果你沒有真正見識過它之前的能力,你可能不會注意到。但如果你之前充分使用了 GPT-4,你會明顯感覺到它變得更愚蠢。」另一位用戶抱怨道。

圖片

圖片

「我對 GPT-4 的反應(yīng)質(zhì)量也有同樣的問題,有誰知道一種方法來排除或糾正這種情況?」

圖片

圖片

「我確實注意到了這一點。在一天中的某些時候,它似乎只記得最近的提示。但在一整天的使用中,GPT-4 性能似乎有波動,不同時間進行嘗試,感覺性能不一樣。」

圖片

圖片

通過網(wǎng)友的反饋,看來大家都感受到了 GPT-4 變笨的事實。

從前是又慢又貴,現(xiàn)在是快但不準(zhǔn)確

去年年底,OpenAI 發(fā)布 ChatGPT 震驚整個 AI 界,最初 ChatGPT 運行在 GPT-3 和 GPT-3.5 之上。3 月中旬,GPT-4 發(fā)布,并迅速成為開發(fā)者和其他科技行業(yè)人士的首選模型。

GPT-4 被認為是廣泛可用的最強大的 AI 模型,具備多模態(tài)功能,可以理解圖像和文本輸入。根據(jù) Lamini 創(chuàng)業(yè)公司首席執(zhí)行官 Sharon Zhou 的說法,它雖然慢但非常準(zhǔn)確。

然而,幾周前,情況開始發(fā)生轉(zhuǎn)變,雖然 GPT-4 變得更快,但性能明顯下降了,這引發(fā)了整個 AI 社區(qū)的討論,根據(jù) Sharon Zhou 和其他專家的說法,這意味著一個重大的變化正在進行中。

他們認為 OpenAI 正在創(chuàng)建幾個較小的 GPT-4 模型,這些模型的功能類似于大型模型,但運行成本更低。

幾天前 SemiAnalysis 發(fā)布的一篇付費訂閱內(nèi)容也談到這一點。文中提到了 OpenAI 能夠通過使用混合專家(MoE)模型來保持合理成本。他們在模型中使用了 16 個專家模型,每個專家模型大約有 111B 個參數(shù)。這些專家模型中的 2 個被路由到每個前向傳遞。

「這些較小的專家模型分別針對不同的任務(wù)和領(lǐng)域進行了訓(xùn)練。可能會有一個針對生物學(xué)的迷你 GPT-4,以及其他可用于物理學(xué)、化學(xué)等的小模型。當(dāng)一個 GPT-4 用戶提出問題時,新系統(tǒng)會知道將該查詢發(fā)送給哪個專家模型。新系統(tǒng)可能會決定將查詢發(fā)送給兩個或多個專家模型,然后將結(jié)果合并起來。」Sharon Zhou 表示。

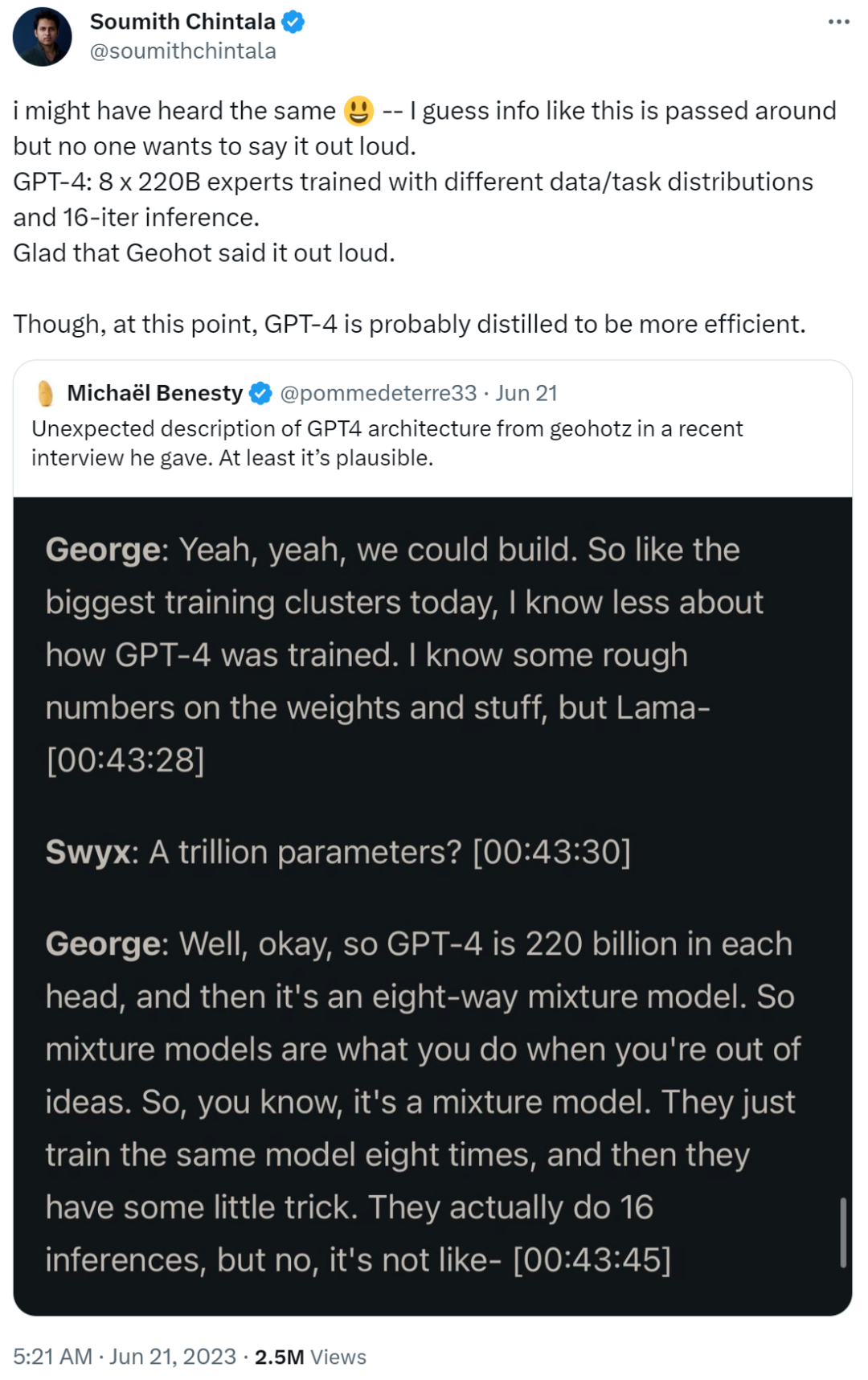

開發(fā)人員George Hotz 在最近的播客中描述了 GPT-4 是 8 路混合模型。

圖片

圖片

值得一提的是,艾倫人工智能研究所創(chuàng)始 CEO Oren Etzioni 在網(wǎng)絡(luò)上看到這些信息后,給 Business Insider 發(fā)了一封電子郵件寫道:「我『推測』這些猜測大致準(zhǔn)確,但我沒有證據(jù)。」

Oren Etzioni 認為:使用 MoE 方法主要是為了讓生成式模型輸出質(zhì)量更高、成本更低、響應(yīng)更快。

eEtzioni 補充道:「正確使用混合模型的確可以同時滿足上述需求,但通常需要在成本和質(zhì)量之間進行權(quán)衡。在這種情況下,有傳聞稱 OpenAI 正在犧牲一些質(zhì)量來降低成本,但這只是傳聞。」

實際上,2022 年 OpenAI 總裁 Greg Brockman 曾與幾位同事共同撰寫了一篇關(guān)于 MoE 方法的文章。

這篇文章中提到:「采用 MoE 方法,模型可以在不增加計算成本的情況下支持更多參數(shù)。」

Sharon Zhou 表示:「GPT-4 最近幾周的性能下降很可能與訓(xùn)練和 OpenAI 推出的小型專家 GPT-4 模型有關(guān)。當(dāng)用戶測試它時,我們會問很多不同的問題。它不會回答得很好,但它會從我們那里收集數(shù)據(jù),并且會改進和學(xué)習(xí)。」