英偉達H100用11分鐘訓完GPT-3,PyTorch創始人:不要只看時間

昨天,老黃又「贏麻了」!

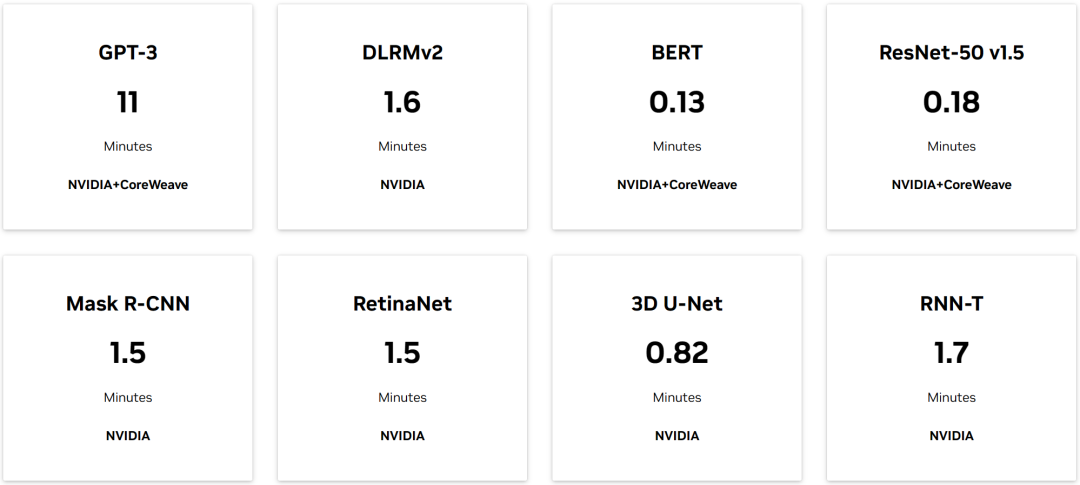

為啥呢?原來在最新的 MLPerf 基準測試中,英偉達 H100 GPU 芯片組在以下八項基準測試中全部創下了新紀錄,同時成為唯一一個跑完所有測試的硬件平臺。

據悉,最新 MLPerf Training v3.0 包含了基于 GPT-3 175B 的大型語言模型(LLM)測試,側重于生成式 AI 能力。

圖源:MLPerf benchmarks。

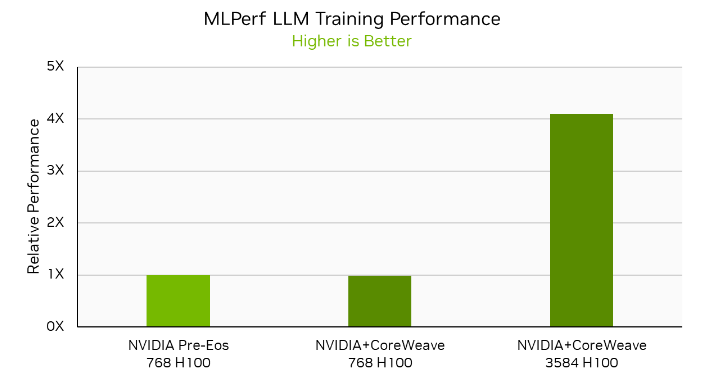

LLM 訓練測試中還使用了專注于 GPU 加速的云計算服務提供商 CoreWeave 提供的 NVIDIA HGX H100 基礎設施,在多個規模上聯合提交了 LLM 工作負載。

出來的結果令人振奮:在 896 個英特爾 Xeon Platinum 8462Y 和 3584 個英偉達 H100 芯片的合作下,僅僅用了 11 分鐘就完成了基于 GPT-3 的 LLM 訓練任務。

圖片

圖片

一時之間,AI 社區響起了老黃贏麻了的歡呼聲。

可結果真如此嗎?今天有人對此事提出了質疑。

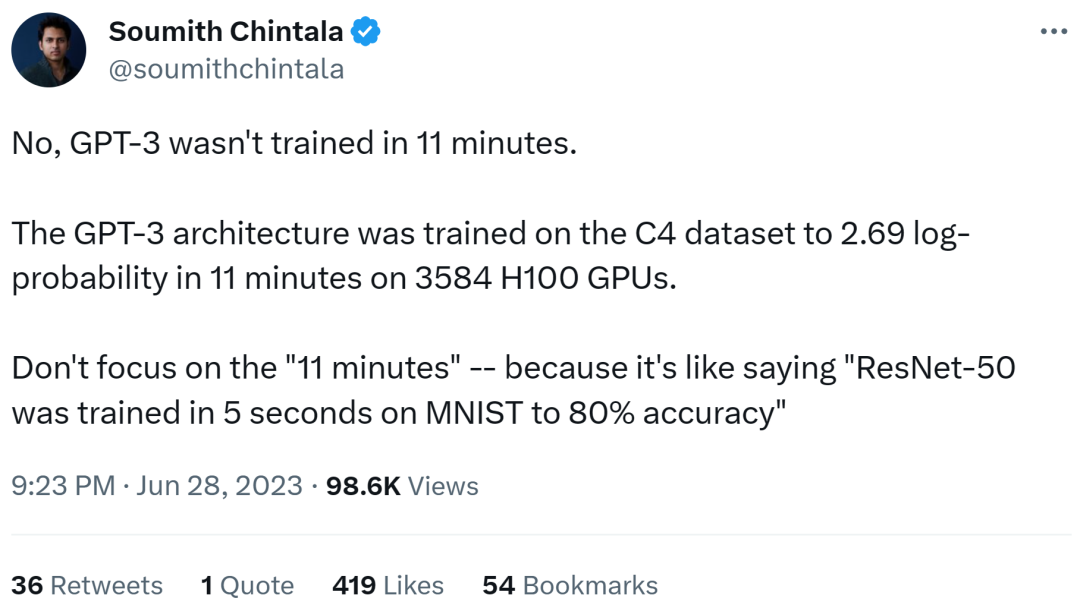

先是 PyTorch 創始人 Soumith Chintala,他認為 GPT-3 并沒有在 11 分鐘內訓練完成。使用 3584 個 H100 GPU,GPT-3 架構在 C4 數據集上訓練了 11 分鐘,對數概率為 2.69。

這里不要只關注「11 分鐘」,因為這就像說「ResNet-50 在 MNIST(其實這里他想說的是 CIFAR100)上,5 秒內訓練達到了 80%的準確率。」

圖片

圖片

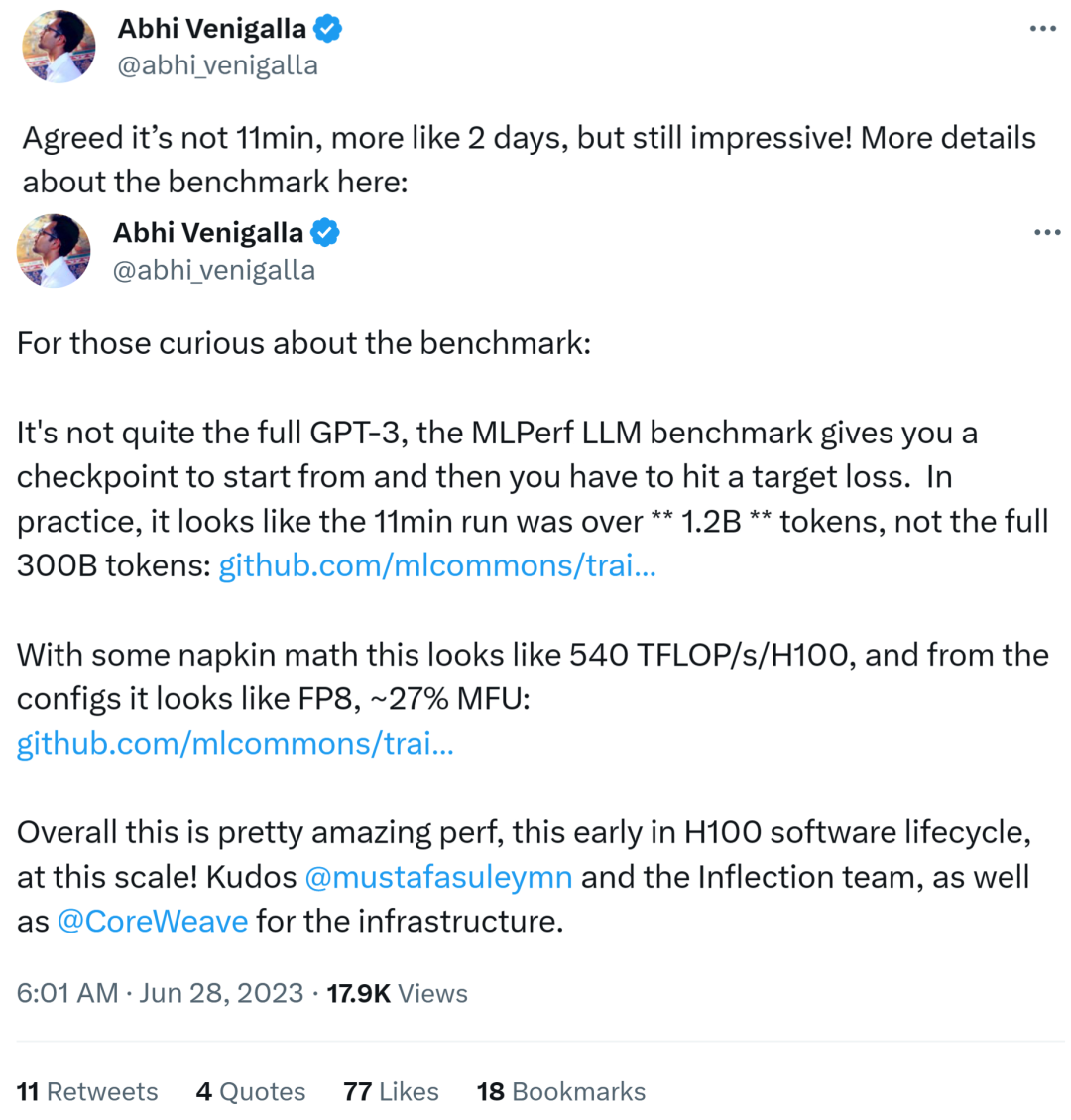

推特用戶 @abhi_venigalla 對 Soumith 的觀點表示贊同,他是生成式 AI 創業公司 MosaicML 的研究者。他認為 MLPerf 基準測試中訓練 GPT-3 的時間更可能是 2 天。

在他看來,該基準測試并不是完整的 GPT-3。MLPerf 的 LLM 基準只提供了一個開始的檢查點,然后必須達到目標損失。

因此,該基準 11 分鐘跑完 GPT-3 只覆蓋 1.2B 的 token,而非完整的 300B token。此外看起來更像是 540 TFLOPs/H100,從配置上看像 FP8,~27% MFU。

不過他也承認,從 H100 在其軟件生命周期早期這一點來看,以此規模實現現在這種性能也相當驚人。

圖片

圖片

所以,最新 MLPerf 基準測試中 11 分鐘訓完 GPT-3 是不是被誤解呢?評論區的小伙伴也可以發表下自己的觀點。