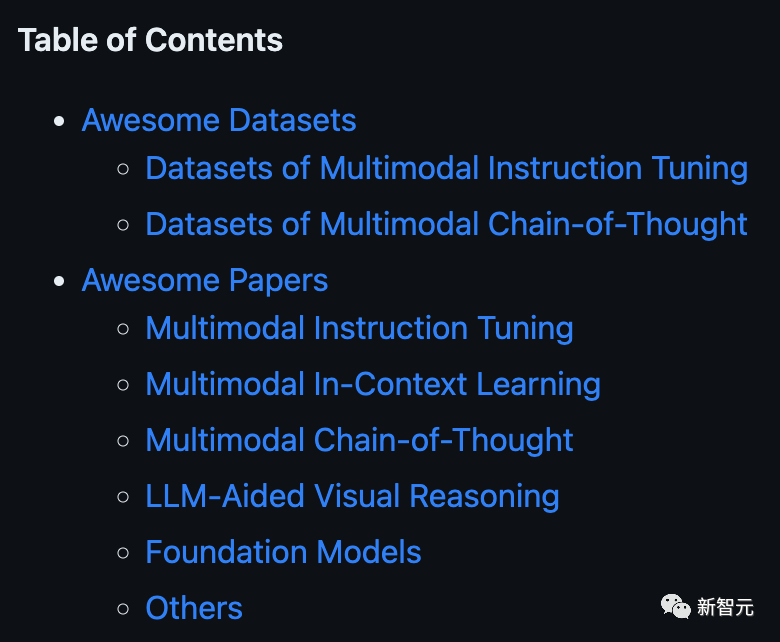

「多模態LLM」最新介紹!數據、論文集直接打包帶走

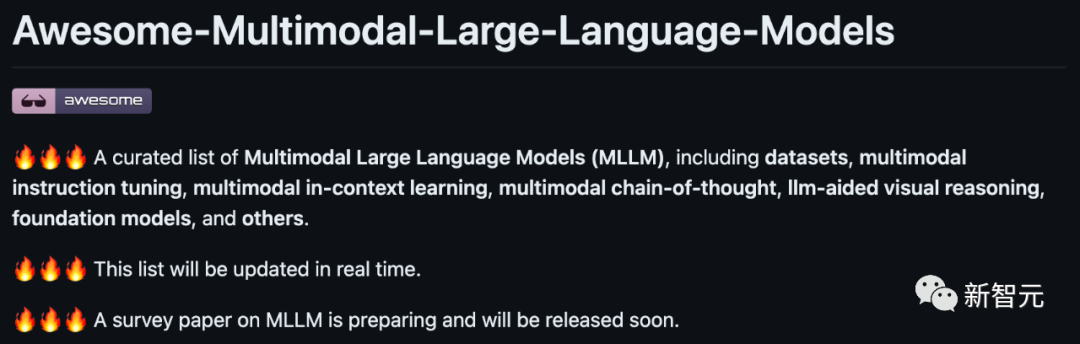

進展跟蹤鏈接(Awesome-MLLM,實時更新):https://github.com/BradyFU/Awesome-Multimodal-Large-Language-Models

近年來,大型語言模型Large Language Models(LLM)的研究取得了顯著的進展(例如GPT-3,LLaMa,ChatGPT,GPT-4),這些模型在各項自然語言處理(NLP)任務上展現了出色的性能。

通過在海量數據上預訓練,LLM獲得了豐富的知識以及強大的推理能力。只需要輸入一些用戶指令,這些模型就可以解析指令、進行推理并給出符合用戶預期的回答。

LLM具有的一些典型能力包括:

- · 執行訓練時未見過的新任務;

- · 通過少量樣例完成新任務;

- · 通過推理鏈條執行復雜的推理任務;

- · 協調各種模型與工具完成復合任務。

這些能力背后蘊含著眾多關鍵思想和技術,包括指令微調(Instruction Tuning),上下文學習(In-Context Learning)和思維鏈(Chain of Thought)等。

多模態大型語言模型

盡管大語言模型在NLP領域取得了長足的發展,相應的模型與技術在多模態領域則較少探索,且傳統視覺-語言模型仍存在著泛化性不足以及缺乏推理能力等局限。

為此,近期眾多學者將注意力轉向一個新興的方向:多模態大型語言模型Multimodal Large Language Models(MLLM)。

其主要思想是以LLM作為「大腦」對輸入的多模態信息進行整合、推理、分析和決斷,從而完成人類交付的任務。

從發展通用人工智能的視角看,相比于LLM,MLLM又向前邁進了一步,且具有以下優點:

· 更符合人類認知世界的習慣。人類具有多種感官,接受多種模態信息,這些信息常常是互補的、協同作用的。因此,使用多模態信息一般可以更好地認知與完成復雜任務;

· 更加強大與用戶友好(User-Friendly)的接口。通過支持多模態輸入,用戶可以通過更加靈活的方式傳達信息;

· 更廣泛的任務支持。LLM通常只能完成NLP相關任務,而MLLM通過接入多模態可以完成更多任務。

從系統設計的角度來看,MLLM可以分為兩類:

· LLM作為推理器的、支持多模態輸入的認知推理系統;

· LLM作為規劃器/調度器/決策器的多工具協作系統。

前者一般通過可訓練的多模態轉換接口將多模態信息轉化為LLM可以直接接收、處理的形態,使LLM可以基于這些多模態信息以及用戶指令進行認知與推理。

后者通常以LLM作為規劃器/調度器/決策器[1],將用戶交付的復雜任務分解為更簡單的子任務,并派發給合適的模型/工具,最后整合結果并輸出。

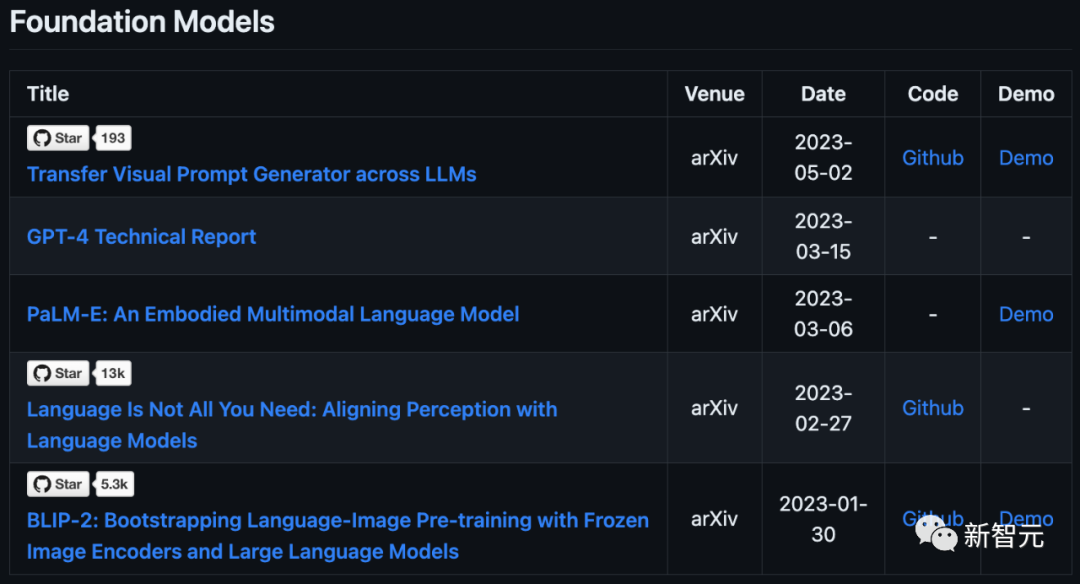

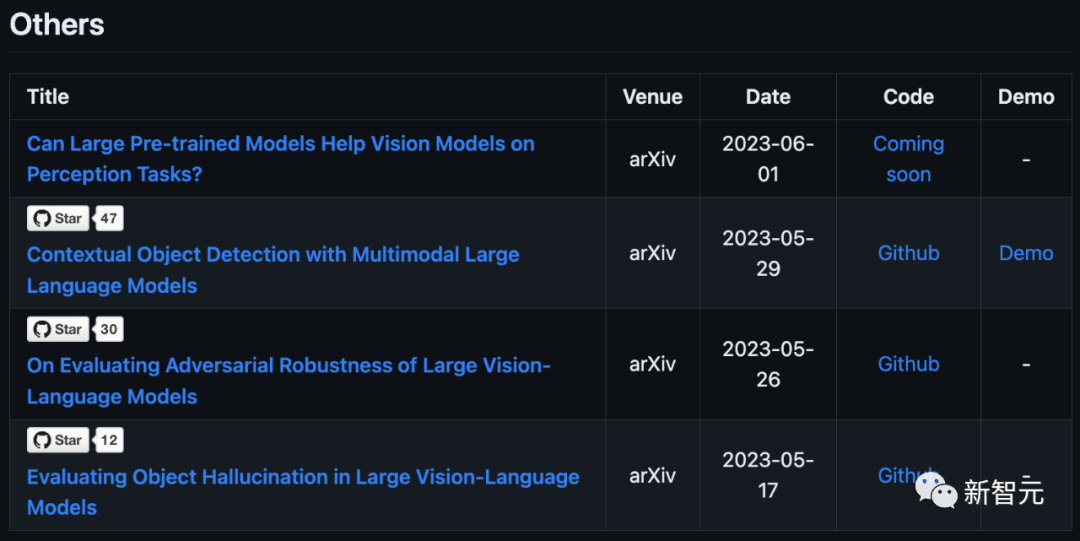

我們采取另一種視角,聚焦于MLLM背后的關鍵技術與實現方式,對相關工作進行了調研與總結,將MLLM劃分為以下幾類:

· 多模態指令微調(Multimodal Instruction Tuning)

· 多模態上下文學習(Multimodal In-Context Learning)

· 多模態思維鏈(Multimodal Chain-of-Thought)

· LLM輔助的視覺推理(LLM-Aided Visual Reasoning)

下面我們將對這幾類工作進行簡要介紹。

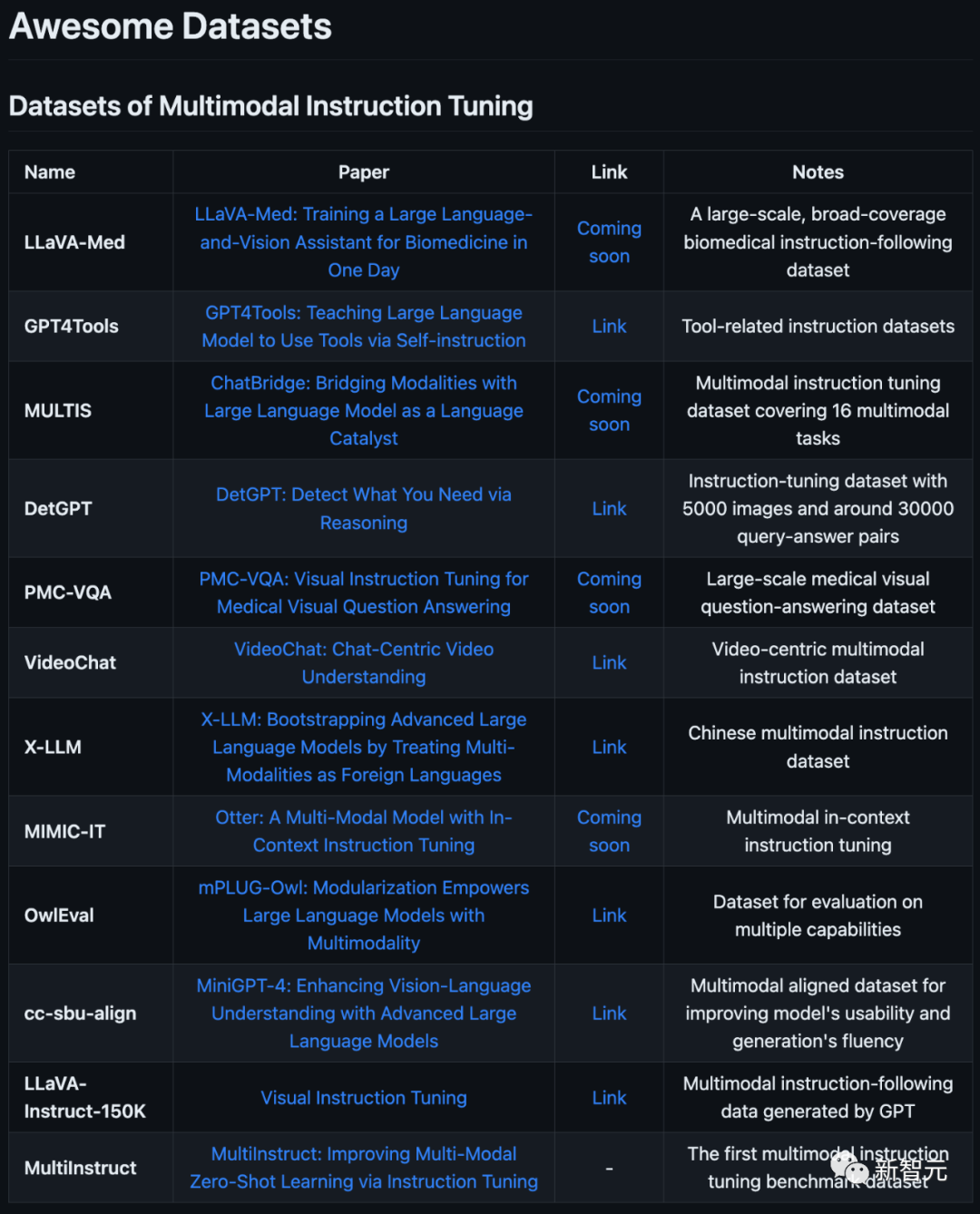

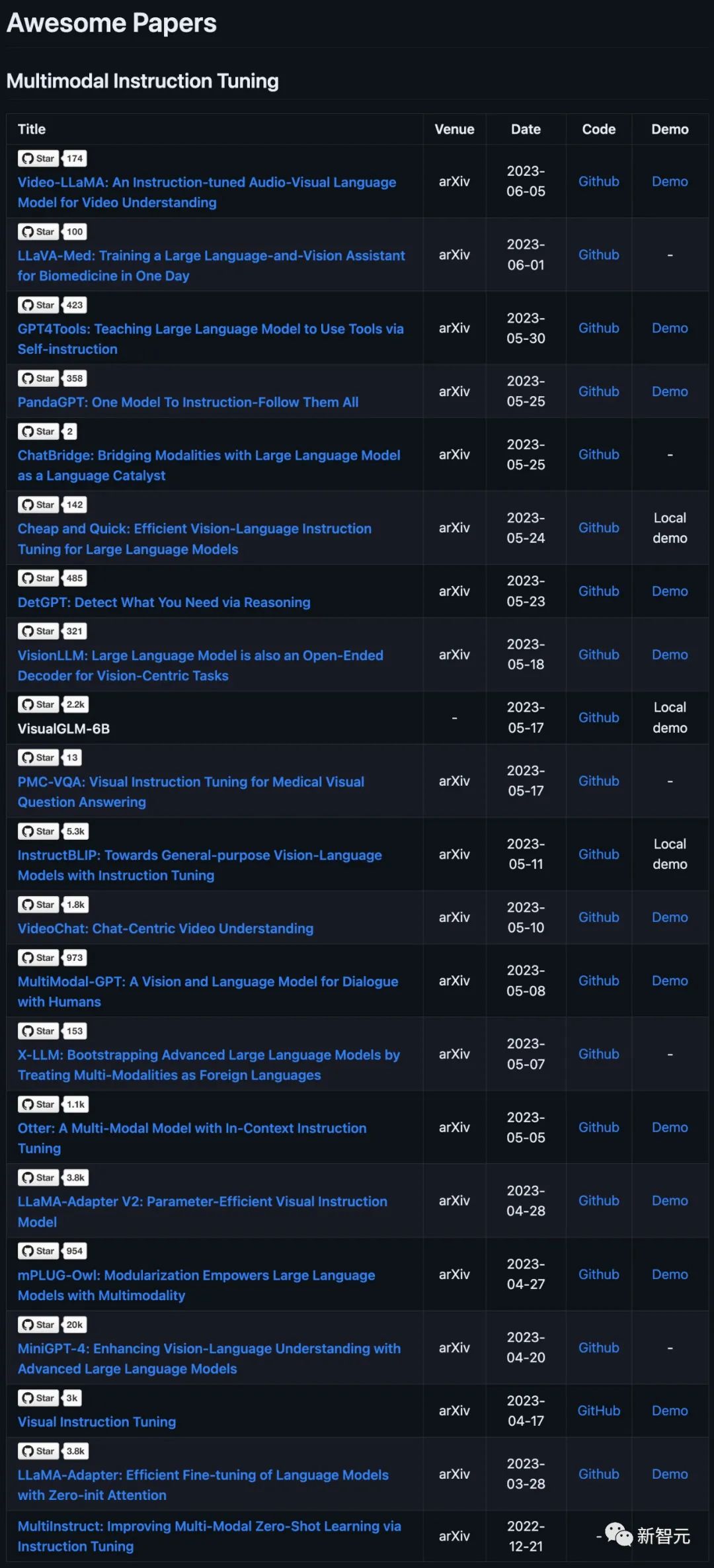

多模態指令微調(Multimodal Instruction Tuning)

多模態指令微調的基本做法是使用統一的模板將各類數據統一起來,并以指令的形式描述任務需求,形成多模態指令數據,再使用這種數據去微調MLLM。

由于訓練與測試時的指令形式具有一致性,LLM可以憑借其強大的語義理解和推理能力,更靈活地泛化到其他任務,獲得強大的零樣本學習能力。

多模態指令數據的基本形式可以概括為(指令,多模態輸入,回答)三元組。

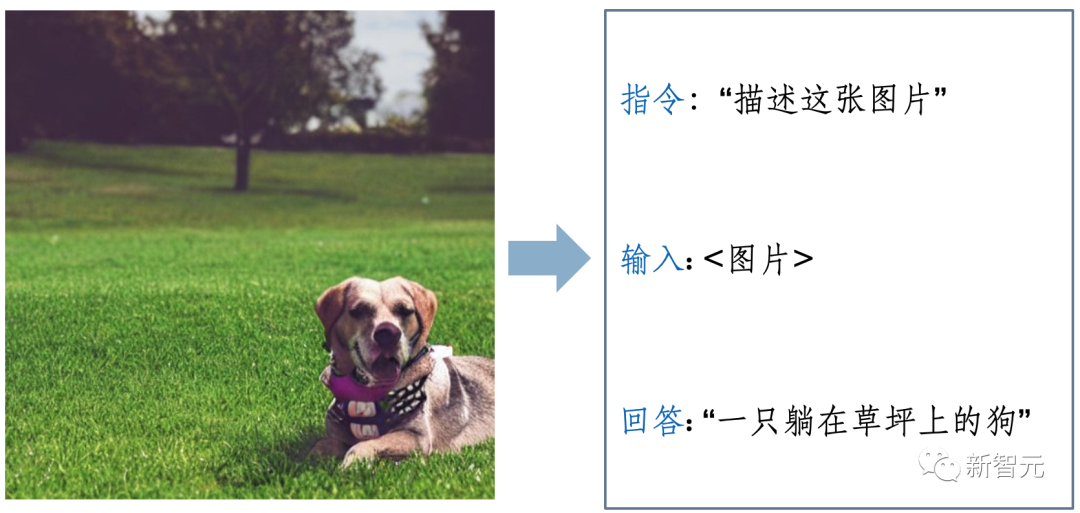

一種直觀的獲得這種數據的方式是改造基準(Benchmark)數據集,我們以圖像描述(Image Captioning)為例,如下圖1所示:

圖1. 多模態指令數據示例

原本的Caption數據樣本包括一張圖片和一段文字描述(Ground Truth),這種數據-GT的配對數據自然構成了指令數據的多模態輸入和回答部分。

指令部分則為相應任務的描述,一般由人工編寫或者調用GPT生成。

在進行多模態指令微調時,MLLM轉化多模態輸入并送入LLM中,LLM基于多模態信息與指令文本預測答案。

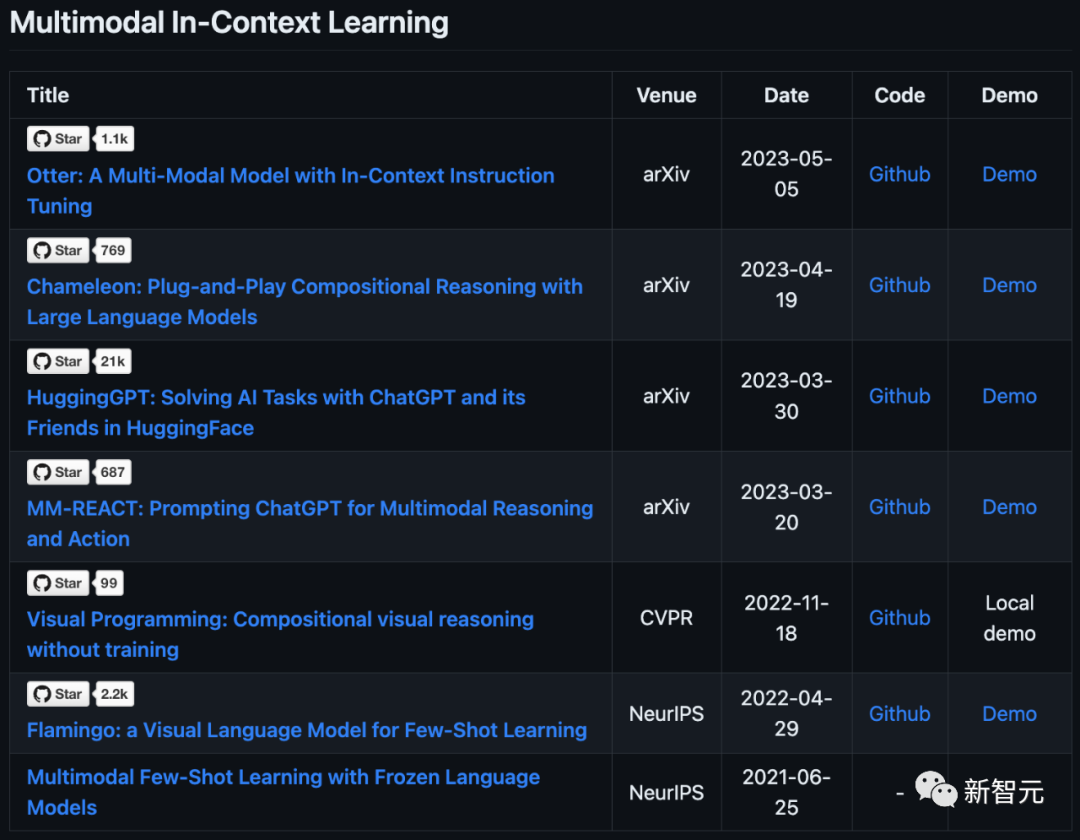

多模態上下文學習(Multimodal In-Context Learning)

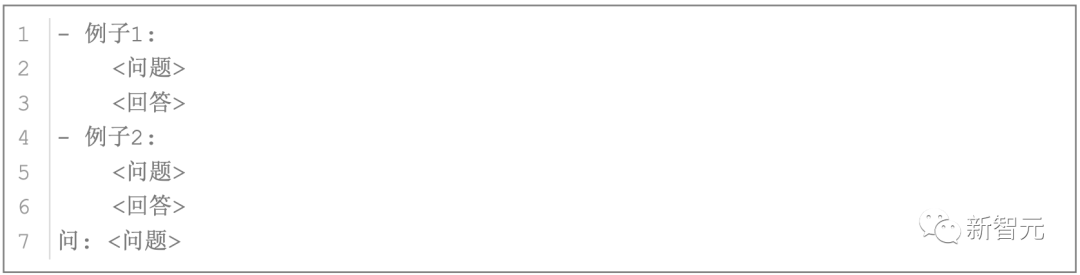

多模態上下文學習的核心思想是從類比中學習。比如,我們在學習時一般接觸到的形式如下:

通過學習例題,我們在遇到新的問題時,可以通過類比例題學習基本思想與方法,從而解決新的問題。

此外,例題還能規范我們的回答格式,更有利于得到正確的、符合預期要求的答案。

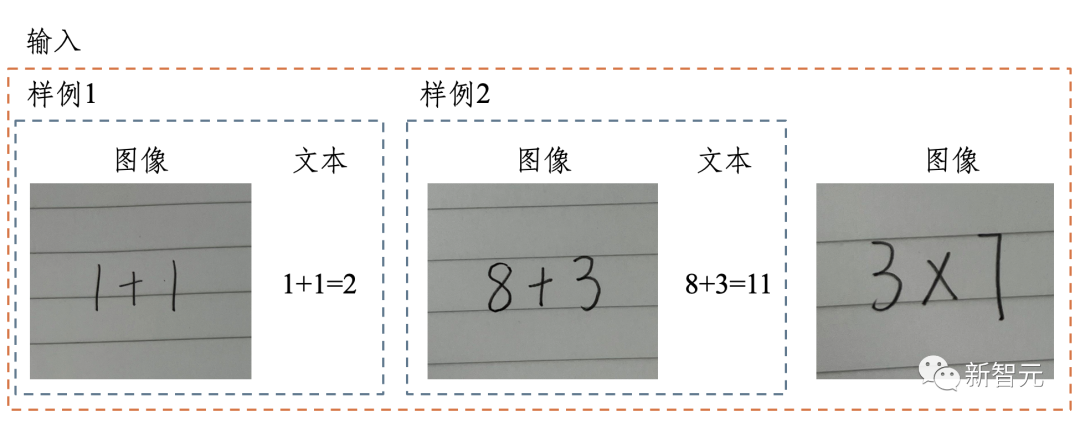

如下圖2所示,通過樣例讓模型預測3x7的計算結果。

圖2. 多模態上下文數據示例,通過樣例讓模型預測3x7的計算結果

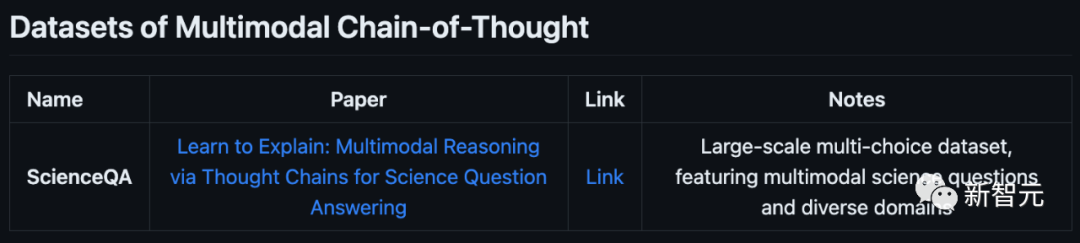

多模態思維鏈(Multimodal Chain-of-Thought)

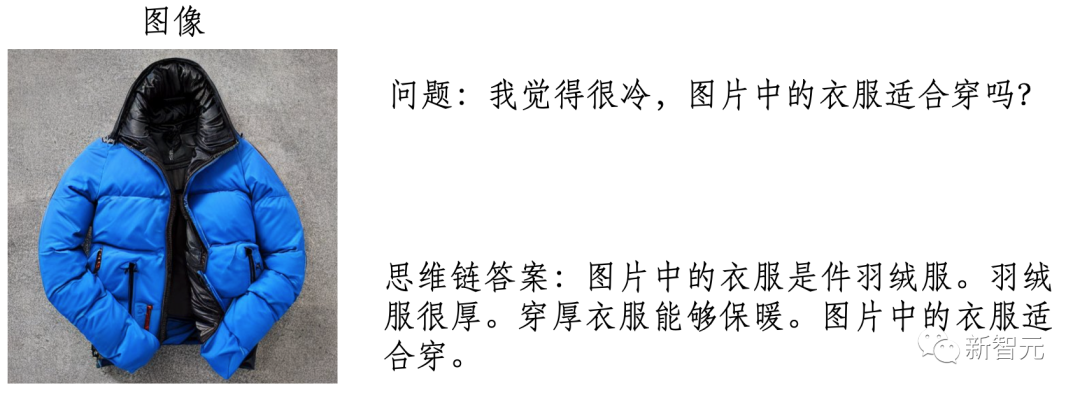

思維鏈即一系列中間推理步驟[2]。多模態思維鏈的基本思想是使模型學會逐步輸出中間步驟,最后推理出最終答案,如下圖3所示:

圖3. 多模態思維鏈數據示例

相比于直接輸出答案的方式,思維鏈:

· 更符合人類推理習慣:基于之前的推理步驟與結果,逐步導向最終答案;

· 適用于復雜的推理任務,將復雜問題分步求解,提高回答的準確性。

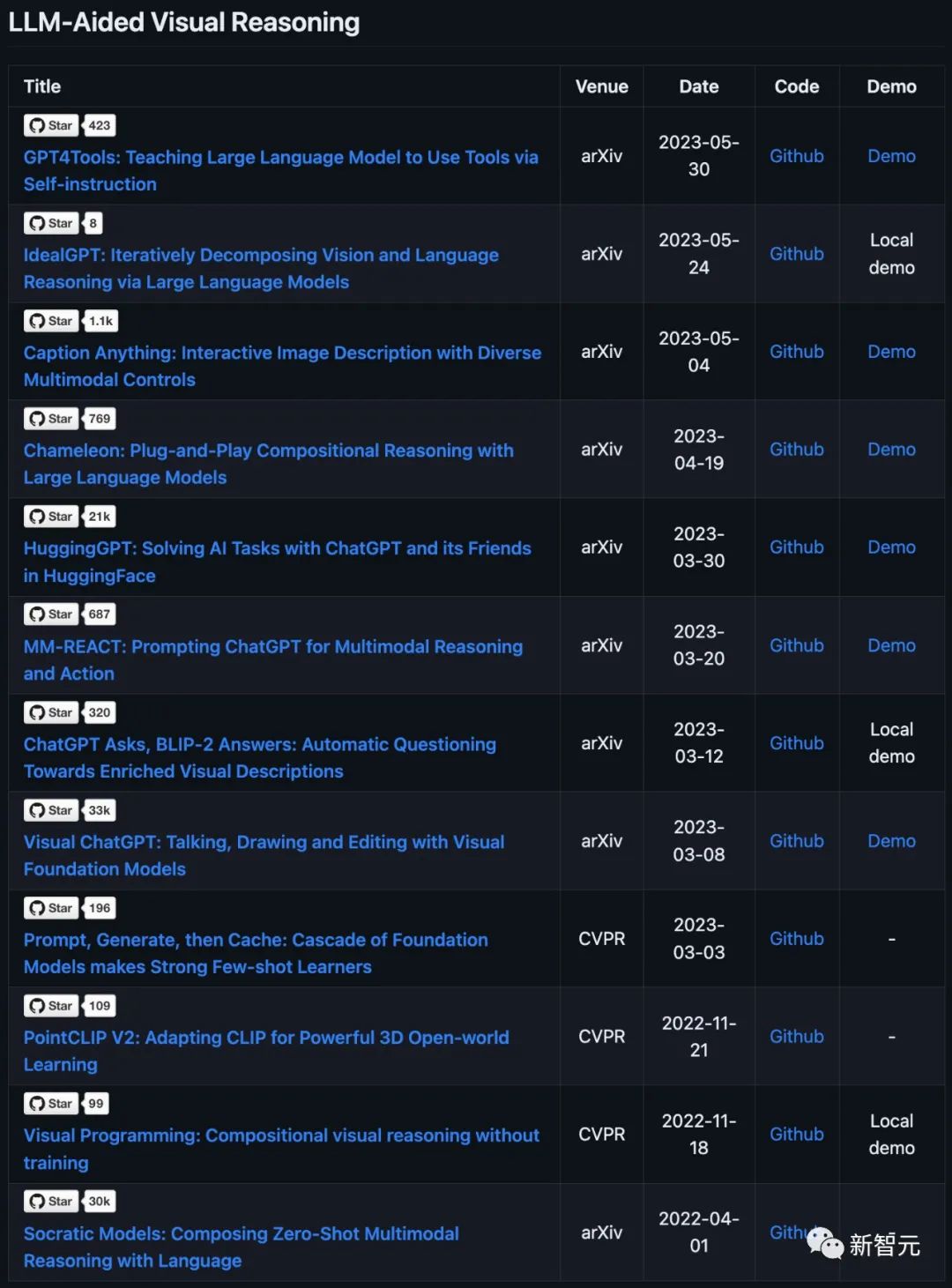

LLM輔助的視覺推理(LLM-Aided Visual Reasoning)

利用LLM作為決策與推理機構,調用各種多模態模型和工具并整合輸出,得到最后的答案。根據完成任務的方式一般可分為單輪模型與多輪模型。

單輪模型的基本思想是由LLM作為規劃器、調度器和決策器協調各個模型/工具完成任務,一般需要完成以下職能[1]:

· 規劃器:將復雜任務分解為可解的子任務;

· 調度器:將子任務派發給合適的模型/工具;

· 決策器:管理子任務執行順序,整合子任務結果得到最終答案。

多輪模型基于迭代的思想,不斷積累視覺認知,直到足夠自信得到最終答案。在這個過程中,LLM需要整合之前的步驟 (提出的問題與已獲得的視覺認知信息),判斷是否可以輸出最終答案[3]。

相關論文詳見:https://github.com/BradyFU/Awesome-Multimodal-Large-Language-Models