離視覺大一統更近一步:分割一切之后,Meta又開源一組多用途大模型

在開源了「分割一切」的 SAM 模型后,Meta 在「視覺基礎模型」的路上越走越遠。

這次,他們開源的是一組名叫 DINOv2 的模型。這些模型能產生高性能的視覺表征,無需微調就能用于分類、分割、圖像檢索、深度估計等下游任務。

這組模型具有如下特征:

- 使用自監督的方式進行訓練,而不需要大量的標記數據;

- 可以用作幾乎所有 CV 任務的骨干,不需要微調,如圖像分類、分割、圖像檢索和深度估計;

- 直接從圖像中學習特征,而不依賴文本描述,這可以使模型更好地理解局部信息;

- 可以從任何圖像集合中學習;

- DINOv2 的預訓練版本已經可用,并可以在一系列任務上媲美 CLIP 和 OpenCLIP。

- 論文鏈接:https://arxiv.org/pdf/2304.07193.pdf

- 項目鏈接:https://dinov2.metademolab.com/

論文概覽

學習非特定任務的預訓練表示已成為自然語言處理的標準。大家可以「按原樣」使用這些功能(無需微調),并且它們在下游任務上的表現明顯優于特定任務模型的性能。這一成功得益于使用輔助目標對大量原始文本進行預訓練,例如語言建模或詞向量,這些不需要監督。

隨著 NLP 領域發生這種范式轉變,預計類似的「基礎」模型將出現在計算機視覺中。這些模型應該生成在任何任務上「開箱即用」的視覺特征,無論是在圖像級別(例如圖像分類)還是像素級別(例如分割)。

這些基礎模型有很大希望可以集中在文本引導(text-guided)的預訓練上,即使用一種文本監督的形式來指導特征的訓練。這種形式的文本引導預訓練限制了可以保留的有關圖像的信息,因為標題僅近似于圖像中的豐富信息,并且更精細、復雜的像素級信息可能無法通過此監督被發現。此外,這些圖像編碼器需要已經對齊好的文本 - 圖像語料庫,不能提供其文本對應物的靈活性,也就是說不能僅從原始數據中學習。

文本引導預訓練的替代方法是自監督學習,其中特征僅從圖像中學習。這些方法在概念上更接近語言建模等前置任務,并且可以在圖像和像素級別捕獲信息。然而,盡管它們有可能去學習通用特征,但自監督學習的大部分效果提升都是在小型精編數據集 ImageNet1k 的預訓練背景下取得的。一些研究人員已經嘗試將這些方法擴展到 ImageNet-1k 之外的一些努力,但他們專注于未經篩選的數據集,這通常會導致性能質量顯著下降。這是由于缺乏對數據質量和多樣性的控制,而數據質量和多樣性對于產生良好的結果至關重要。

在這項工作中,研究者探討了如果在大量精編數據上進行預訓練,自監督學習是否有可能去學習通用的視覺特征。它們重新審視了現有的在圖像和 patch 級別學習特征的判別性自監督方法,例如 iBOT,并在更大數據集下重新考慮他們的一些設計選擇。研究者的大多數技術貢獻都是為了在擴展模型和數據大小時穩定和加速判別性自監督學習而量身定制的。這些改進使他們方法的速度提升到了類似的判別性自監督方法的 2 倍左右,需要的內存減少到了后者的 1/3,使他們能夠利用更長的訓練和更大的 batch size。

關于預訓練數據,他們構建了一個自動 pipeline ,用于從大量未經篩選的圖像集合中過濾和重新平衡數據集。這個靈感來自 NLP 中使用的 pipeline ,其中使用數據相似性而不是外部元數據,并且不需要手動注釋。在處理圖像時的一個主要困難是重新平衡概念并且要避免在一些主導模式下出現過擬合。在這項工作中,樸素聚類方法可以很好地解決此問題,研究人員們收集了一個由 142M 圖像組成的小而多樣化的語料庫來驗證他們的方法。

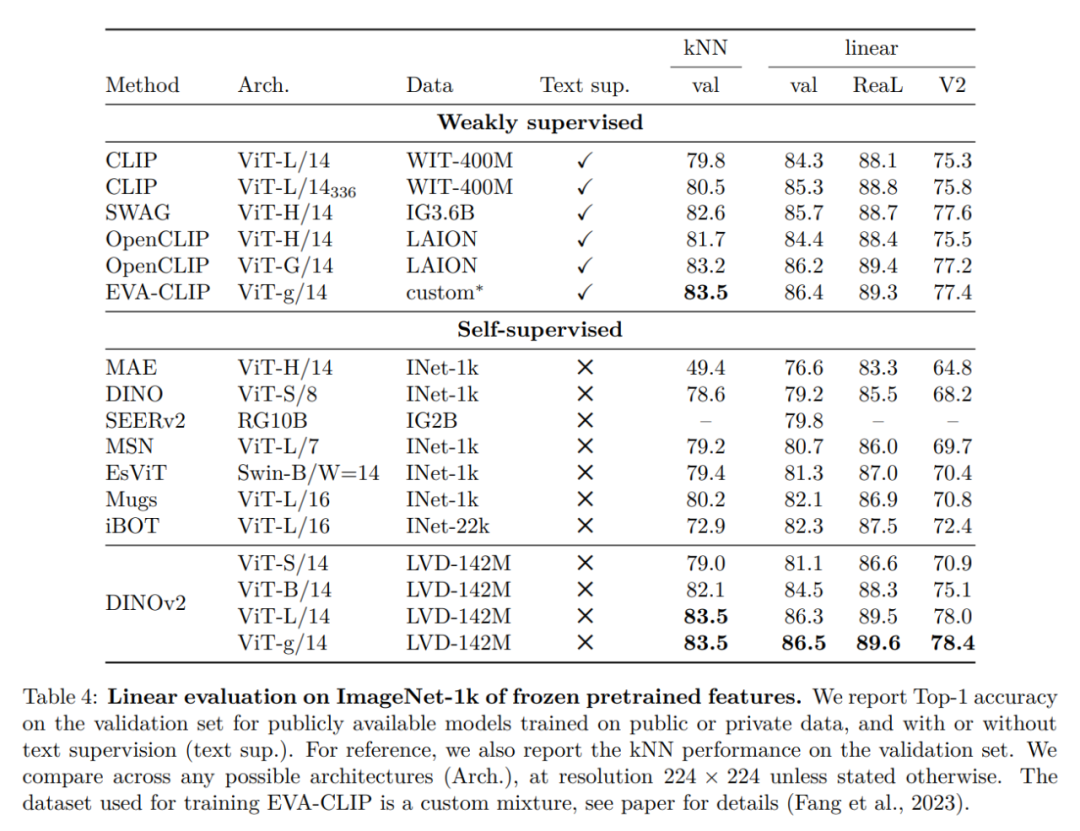

最后,研究者們提供了各種預訓練的視覺模型,稱為 DINOv2,在他們的數據上使用不同的視覺 Transformer(ViT)架構進行訓練。他們發布了所有模型和代碼,以在任何數據上重新訓練 DINOv2。在擴展時,他們在圖像和像素級別的各種計算機視覺基準測試上驗證了 DINOv2 的質量,如圖 2 所示。最后研究者們得出結論,單獨的自監督預訓練是學習可遷移凍結特征的良好候選者,可媲美最好的公開可用的弱監督模型。

數據處理

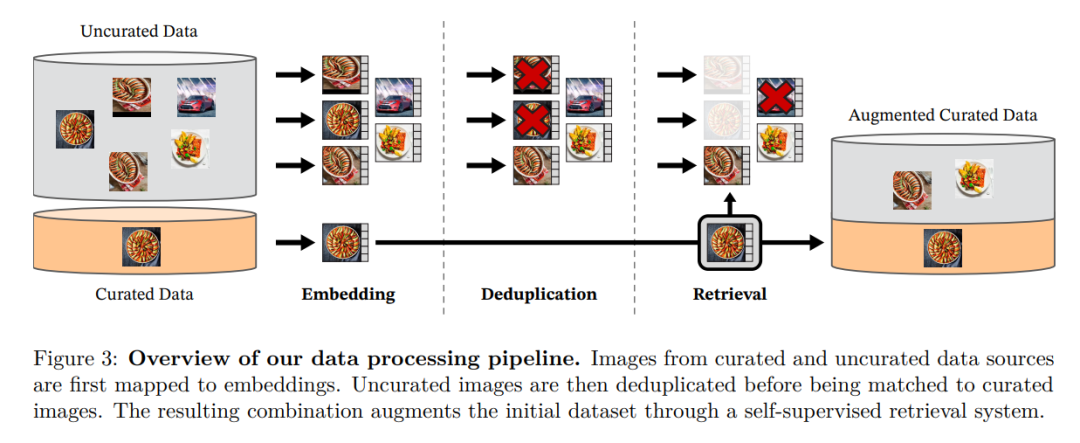

研究者通過從大量未篩選的數據中檢索與多個精編數據集中的圖像接近的圖像來組裝他們的精編 LVD-142M 數據集。他們在論文中介紹了數據管道中的主要組成部分,包括精選 / 未篩選的數據源、圖像重復數據刪除步驟和檢索系統。整條 pipeline 不需要任何元數據或文本,直接處理圖像,如圖 3 所示。請讀者參閱附錄 A,了解有關模型方法的更多詳細信息。

圖 3:數據處理的 pipeline 概述。來自精編和非精編的數據源的圖像首先被映射到嵌入。然后,非精編的圖像在與標準圖像匹配之前對重復數據刪除。由此產生的組合通過自監督檢索系統進一步豐富擴充了初始數據集。

判別性自監督預訓練

研究人員通過一種判別性的自監督方法學習他們的特征,該方法可以看作是 DINO 和 iBOT 損失的結合,并以 SwAV 為中心。他們還添加了一個正則化器來傳播特征和一個簡短的高分辨率訓練階段。

高效實現

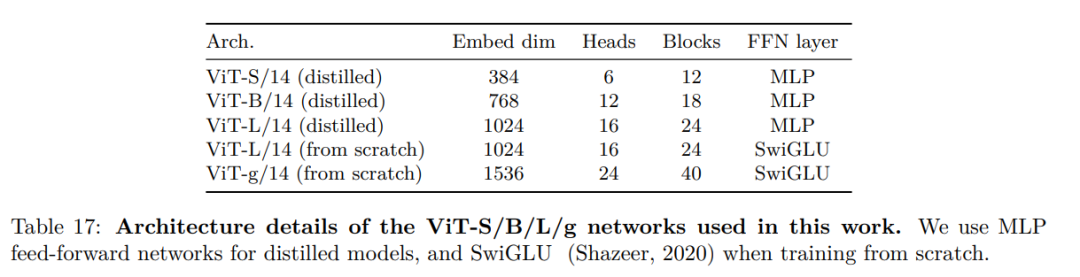

他們考慮了幾項改進,以在更大范圍內訓練模型。使用 PyTorch 2.0 在 A100 GPU 上訓練模型,該代碼也可與用于特征提取的預訓練模型一起使用。模型的詳細信息在附錄表 17 中。在相同的硬件下,與 iBOT 實現相比,DINOv2 代碼僅使用 1/3 的內存,運行速度提高到了前者的 2 倍。

實驗結果

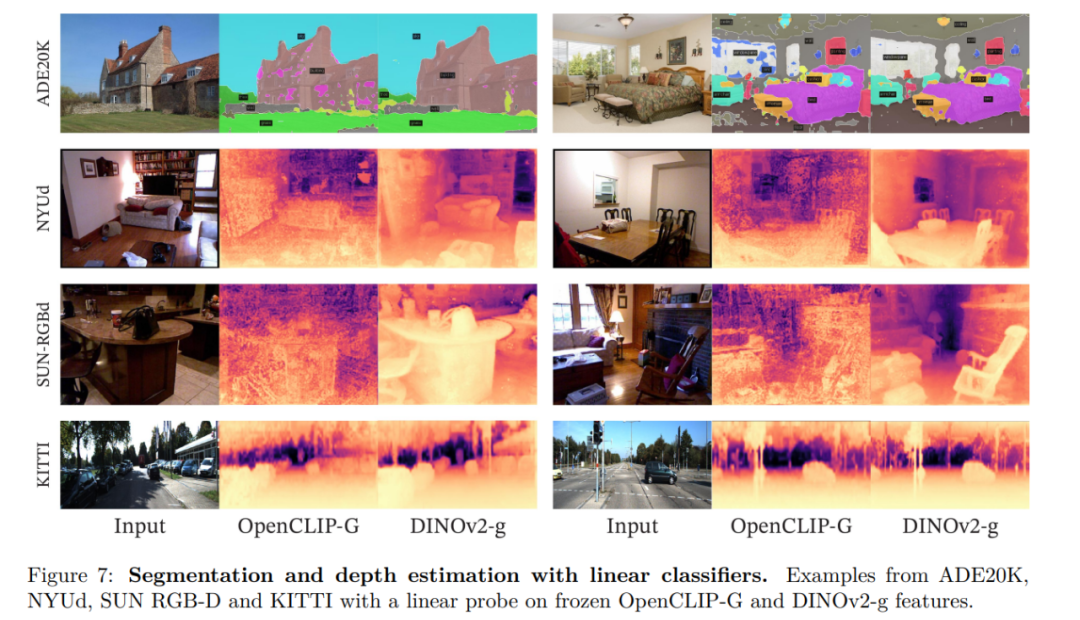

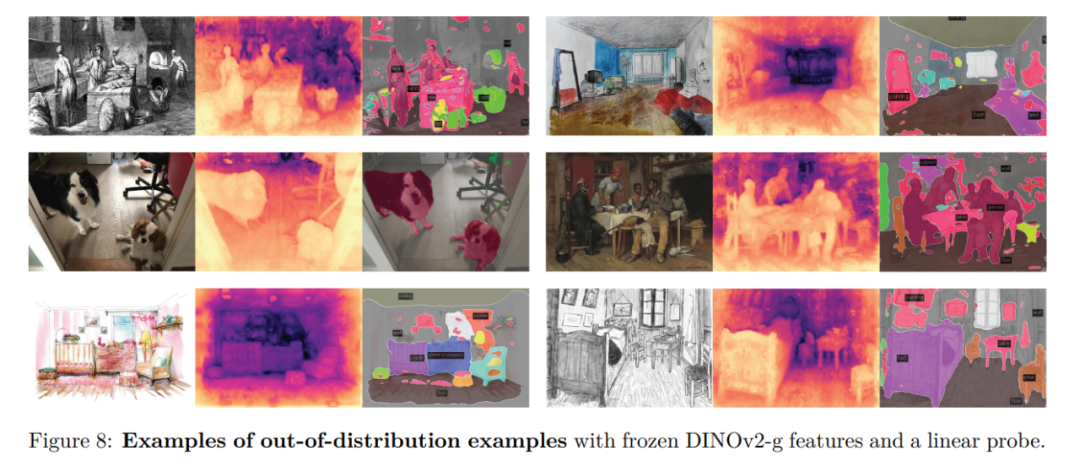

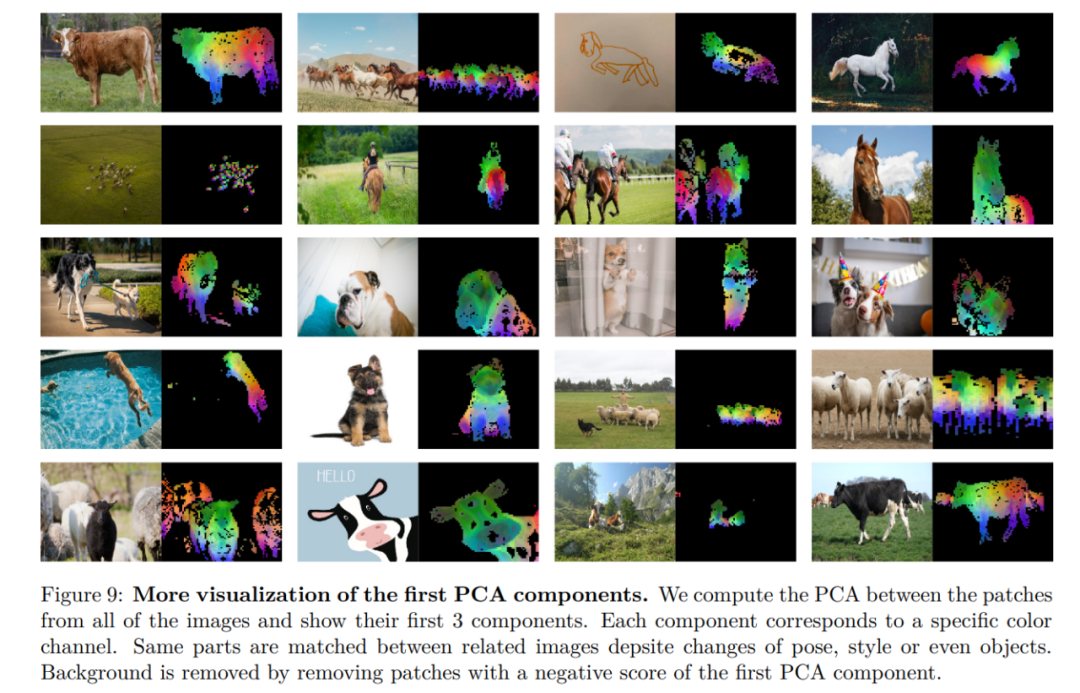

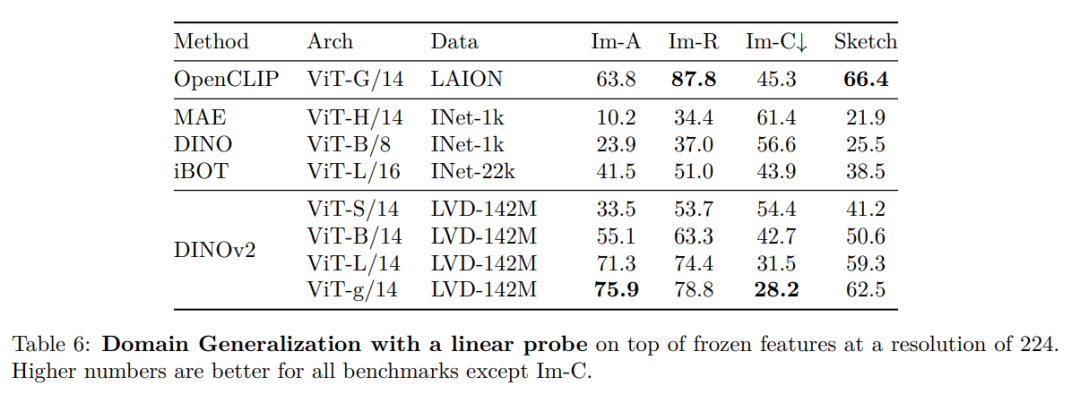

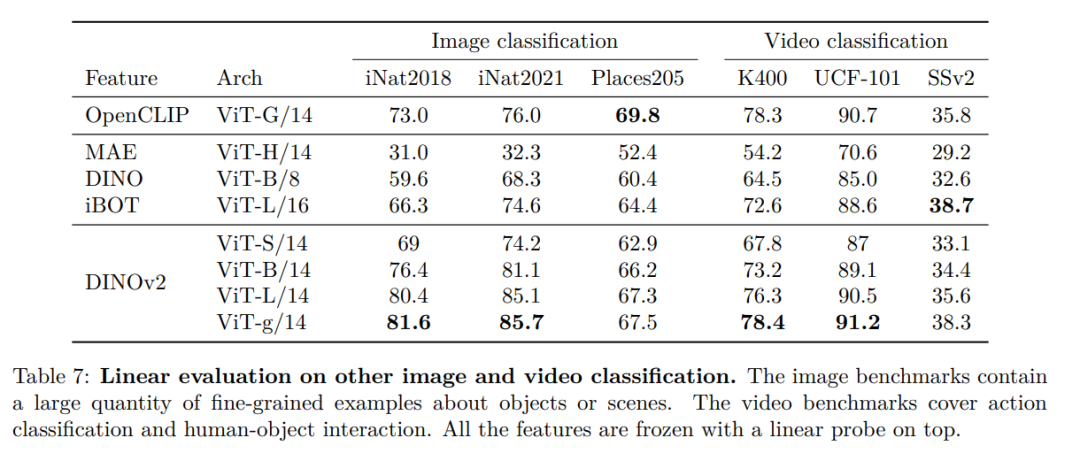

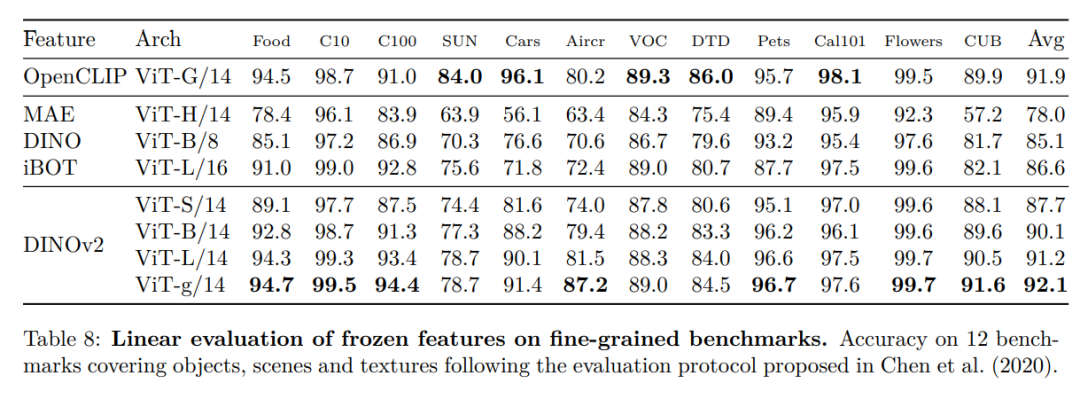

在本節中,研究者將介紹新模型在許多圖像理解任務上的實證評估。他們評估了全局和局部圖像表示,包括類別和實例級識別、語義分割、單目深度預測和動作識別。

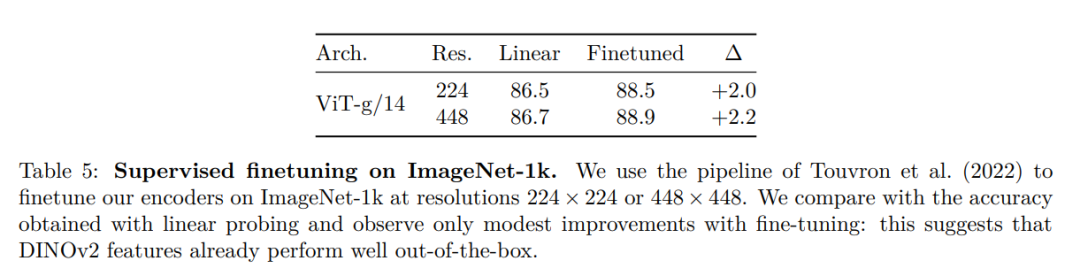

ImageNet 分類

其他圖像和視頻分類基準

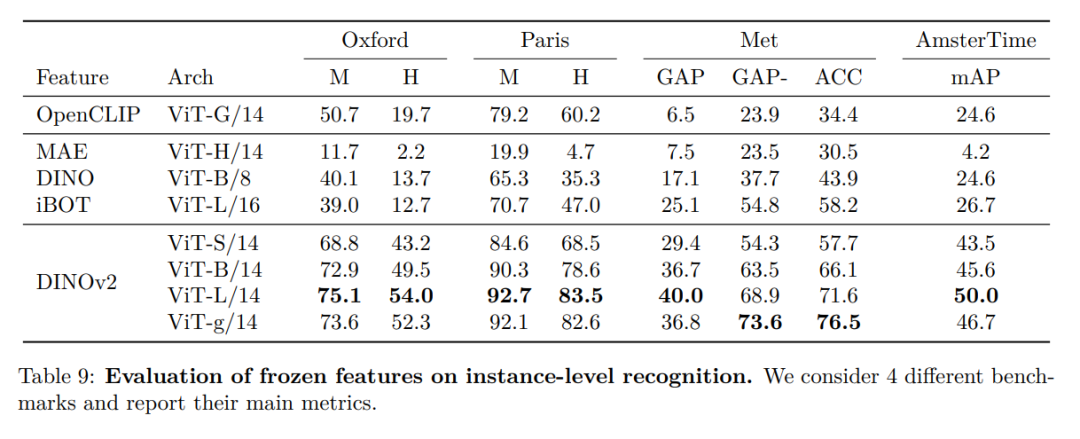

實例識別

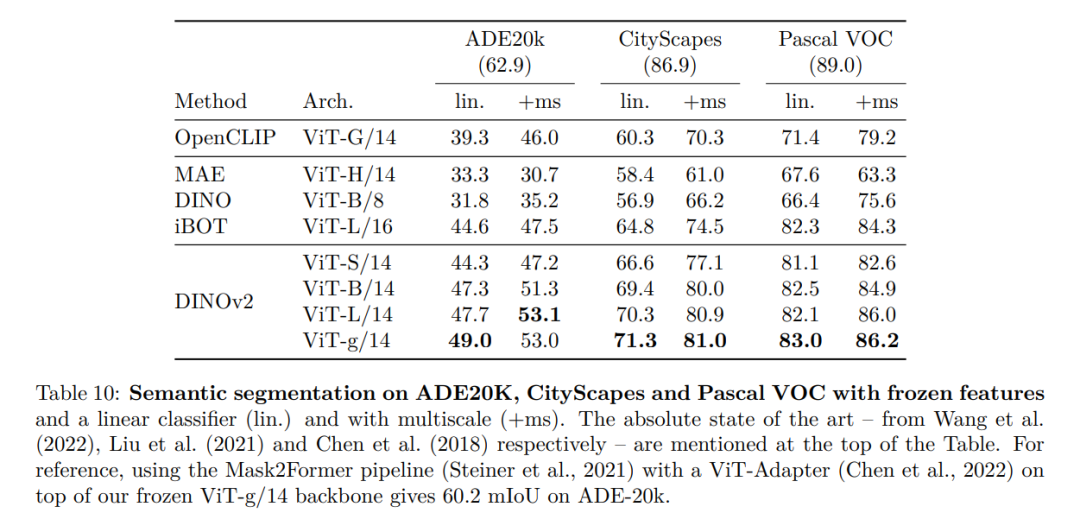

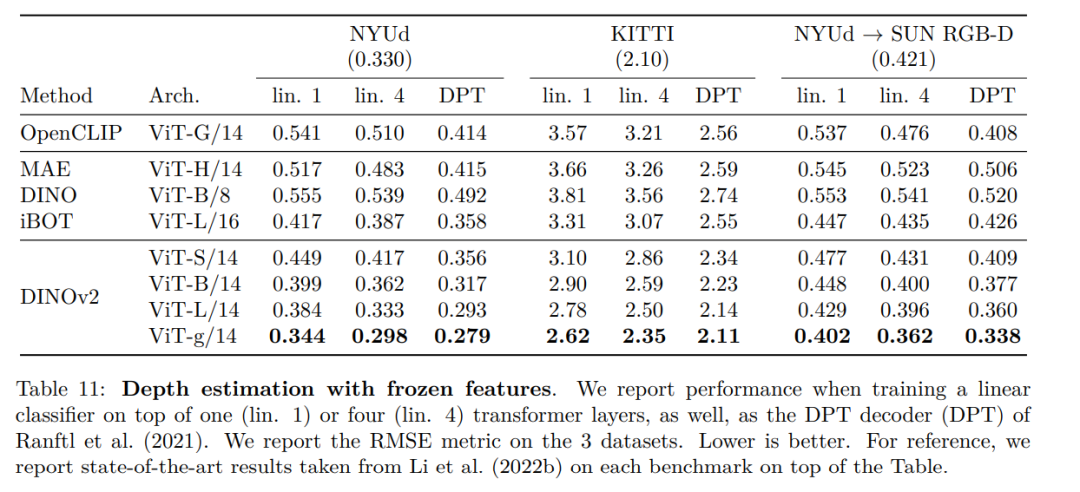

密集識別任務

定性結果