對于我們日常的數據清理、預處理和分析方面的大多數任務,Pandas已經綽綽有余。但是當數據量變得非常大時,它的性能開始下降。

我們以前的兩篇文章來測試Pandas 1.5.3、polar和Pandas 2.0.0之間的性能了,Polars 正好可以解決大數據量是處理的問題,所以本文將介紹如何將日常的數據ETL和查詢過濾的Pandas轉換成polars。

Polars的優勢

Polars是一個用于Rust和Python的DataFrame庫。

- Polars利用機器上所有可用的內核,而pandas使用單個CPU內核來執行操作。

- Polars比pandas相對輕量級,沒有依賴關系,這使得導入Polars的速度更快。導入Polars只需要70毫秒,而導入pandas需要520毫秒。

- Polars進行查詢優化減少了不必要的內存分配。它還能夠以流方式部分或全部地處理查詢。

- Polars可以處理比機器可用RAM更大的數據集。

ETL

Extract, Transform, and Load (ETL)的過程是怎樣的:

“提取、轉換和加載(ETL)是將來自多個數據源的數據組合到稱為數據倉庫的過程。ETL使用一組業務規則來清理和組織原始數據,并為存儲、數據分析和機器學習(ML)做好準備。可以通過數據分析解決特定的業務智能需求(例如預測業務決策的結果、生成報告、減少操作效率低下,等等)。

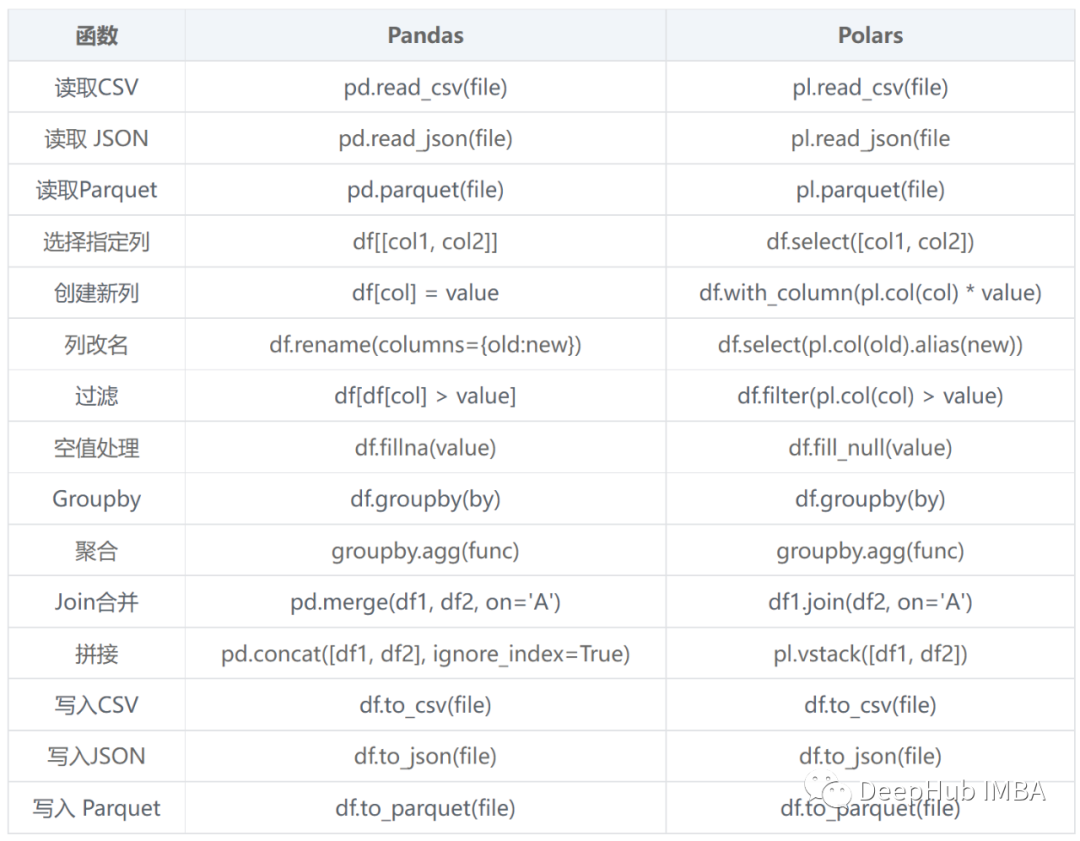

Polars和Pandas都支持從各種來源讀取數據,包括CSV、Parquet和JSON。

df = pl.read_csv('data.csv')

df = pl.read_parquet('data.parquet')

df = pl.read_json('data.json')對于數據的讀取方面和Pandas基本一致。

轉換是ETL中最重要、最困難和最耗時的步驟。

polar支持Pandas函數的一個子集,所以我們可以使用熟悉的Pandas函數來執行數據轉換。

df = df.select(['A', 'C'])

df = df.rename({‘A’: ‘ID’, ‘C’: ‘Total’})

df = df.filter(pl.col('A') > 2)

df = df.groupby('A').agg({'C': 'sum'})

這些Pandas函數都可以直接使用。

創建新列:

df = df.with_column(pl.col(‘Total’) / 2, ‘Half Total’)

處理空值:

df = df.fill_null(0)

df_filled = df.fill_null('backward')

df = df.fillna(method='ffill')

Dataframe 的合并

#pandas

df_join = pd.merge(df1, df2, on='A')

#polars

df_join = df1.join(df2, on='A')

連接兩個DF

#pandas

df_union = pd.concat([df1, df2], ignore_index=True)

#polars

df_union = pl.vstack([df1, df2])

polar使用與Pandas相同的函數來將數據保存到CSV、JSON和Parquet文件中。

# CSV

df.to_csv(file)

# JSON

df.to_json(file)

# Parquet

df.to_parquet(file)

最后,如果你還需要使用Pandas做一些特殊的操作,可以使用:

這可以將polar的DF轉換成pandas的DF。

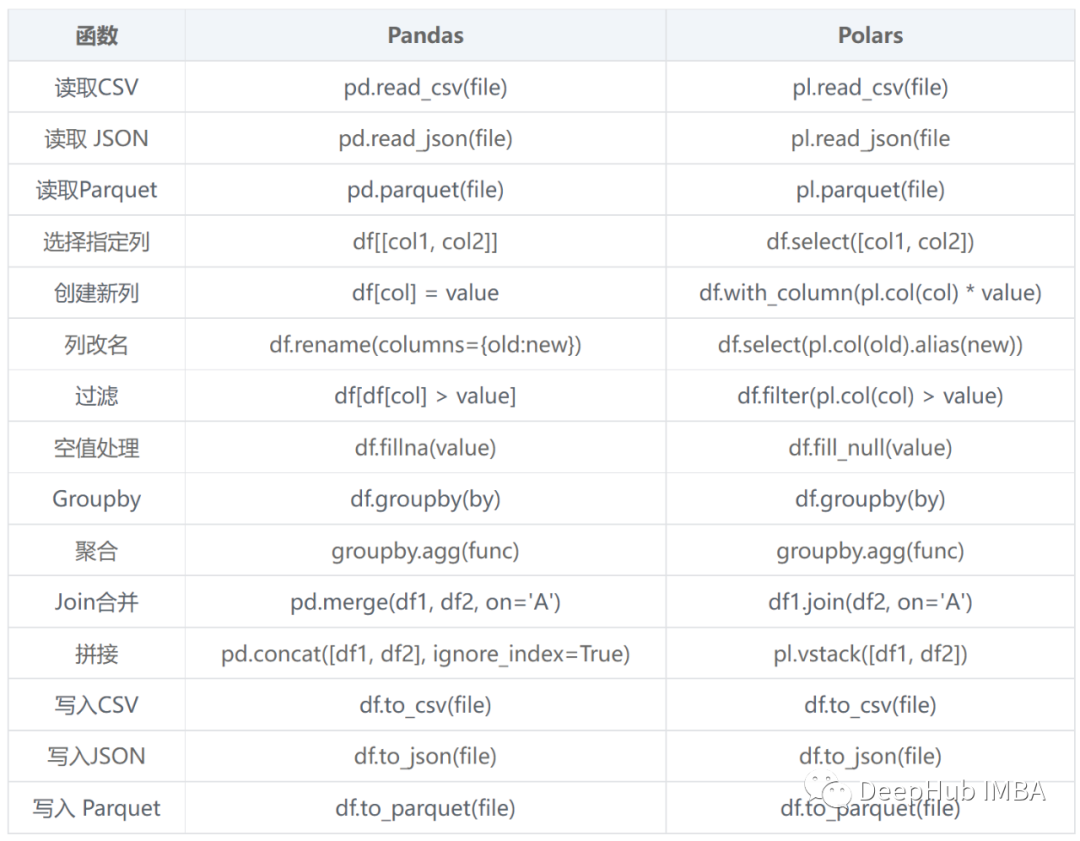

最后我們整理一個簡單的表格:

數據的查詢過濾

我們的日常工作中,數據的查詢是最重要,也是用的最多的,所以在這里我們再整理下查詢過濾的操作。

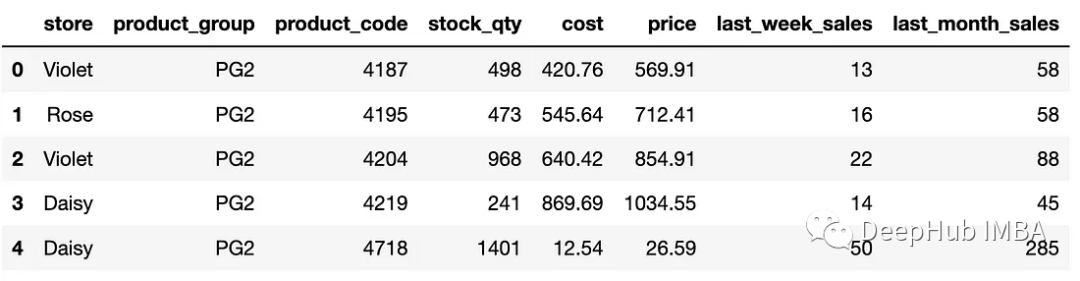

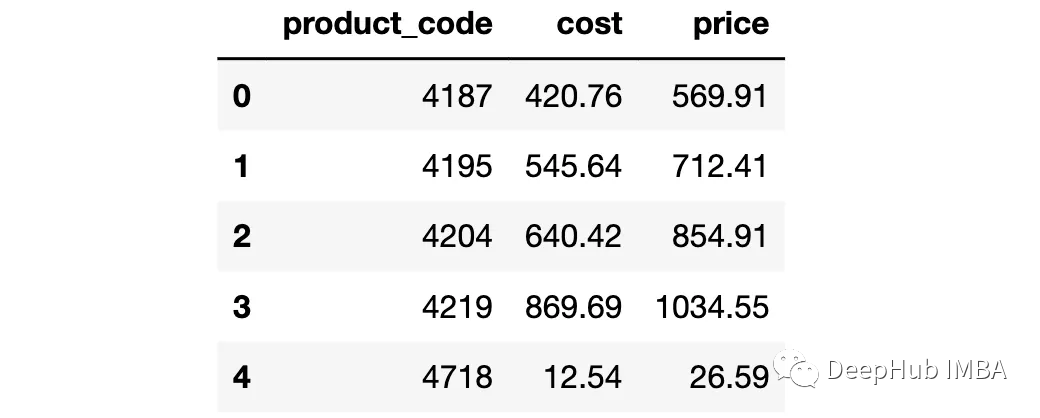

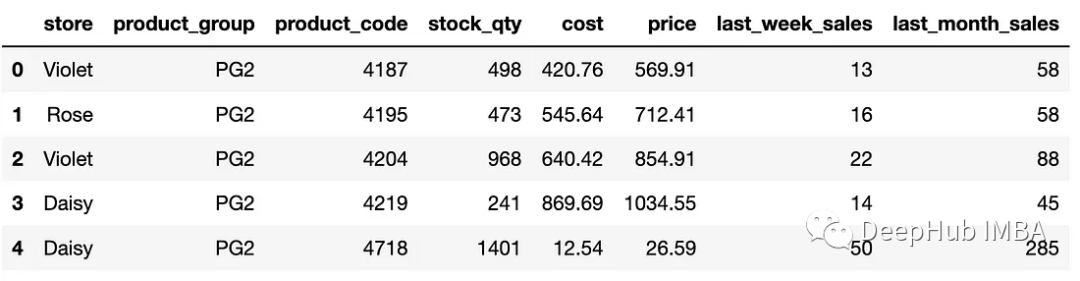

首先創建一個要處理的DataFrame。

# pandas

import pandas as pd

# read csv

df_pd = pd.read_csv("datasets/sales_data_with_stores.csv")

# display the first 5 rows

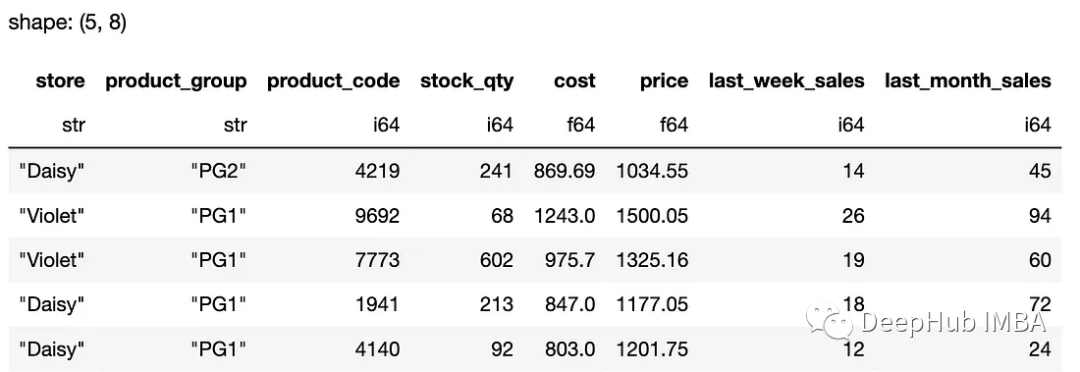

df_pd.head()

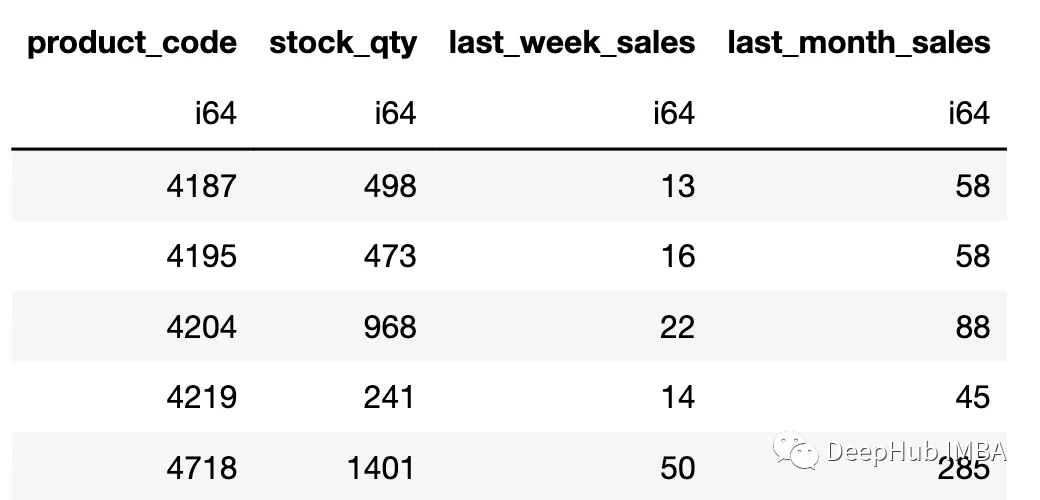

# polars

import polars as pl

# read_csv

df_pl = pl.read_csv("datasets/sales_data_with_stores.csv")

# display the first 5 rows

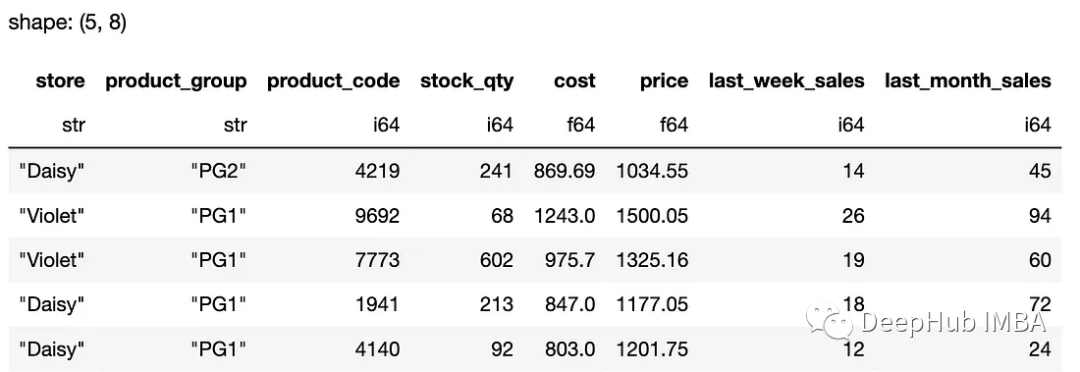

df_pl.head()

polars首先顯示了列的數據類型和輸出的形狀,這對我們來說非常好。下面我們進行一些查詢,我們這里只顯示一個輸出,因為結果都是一樣的:

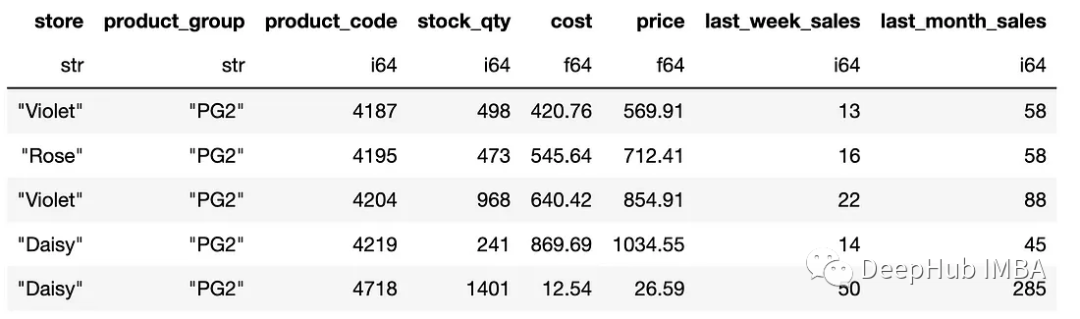

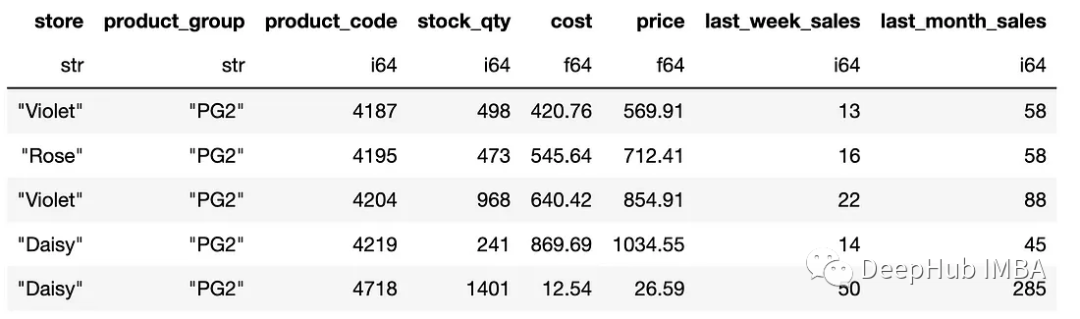

1、按數值篩選

# pandas

df_pd[df_pd["cost"] > 750]

df_pd.query('cost > 750')

# polars

df_pl.filter(pl.col("cost") > 750)

2、多個條件查詢

pandas和polar都支持根據多個條件進行過濾。我們可以用“and”和“or”邏輯組合條件。

# pandas

df_pd[(df_pd["cost"] > 750) & (df_pd["store"] == "Violet")]

# polars

df_pl.filter((pl.col("cost") > 750) & (pl.col("store") == "Violet"))

3、isin

pandas的isin方法可用于將行值與值列表進行比較。當條件包含多個值時,它非常有用。這個方法的polar版本是" is_in "。

# pandas

df_pd[df_pd["product_group"].isin(["PG1", "PG2", "PG5"])]

# polars

df_pl.filter(pl.col("product_group").is_in(["PG1", "PG2", "PG5"]))

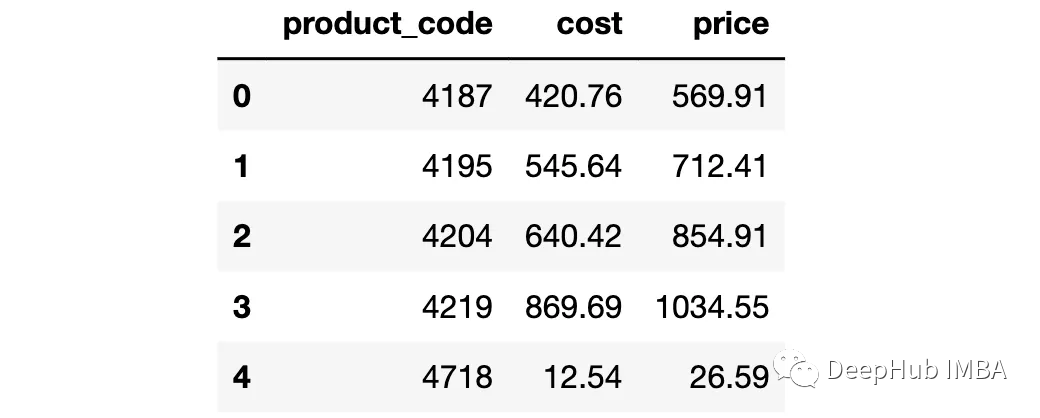

4、選擇列的子集

為了選擇列的子集,我們可以將列名傳遞給pandas和polar,如下所示:

cols = ["product_code", "cost", "price"]

# pandas (both of the following do the job)

df_pd[cols]

df_pd.loc[:, cols]

# polars

df_pl.select(pl.col(cols))

5、選擇行子集

pandas中可以使用loc或iloc方法選擇行。在polar則更簡單。

# pandas

df_pd.iloc[10:20]

# polars

df_pl[10:20]

選擇相同的行,但只選擇前三列:

# pandas

df_pd.iloc[10:20, :3]

# polars

df_pl[10:20, :3]

如果要按名稱選擇列:

# pandas

df_pd.loc[10:20, ["store", "product_group", "price"]]

# polars

df_pl[10:20, ["store", "product_group", "price"]]

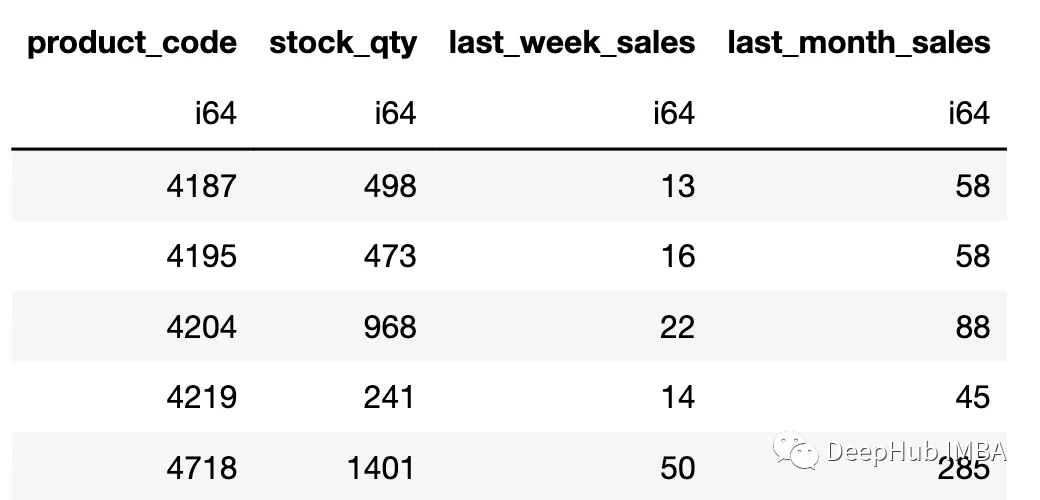

按數據類型選擇列:

我們還可以選擇具有特定數據類型的列。

# pandas

df_pd.select_dtypes(include="int64")

# polars

df_pl.select(pl.col(pl.Int64))

總結

可以看到polar與pandas非常相似,所以如果在處理大數據集的時候,我們可以嘗試使用polar,因為它在處理大型數據集時的效率要比pandas高,我們這里只介紹了一些簡單的操作,如果你想了解更多,請看polar的官方文檔:

https://pola-rs.github.io/polars-book/user-guide/coming_from_pandas.html