首個超大規(guī)模GAN模型!生成速度比Diffusion快20+倍,0.13秒出圖,最高支持1600萬像素

??AIGC爆火的背后,從技術(shù)的角度來看,是圖像生成模型的架構(gòu)發(fā)生了巨大的變化。

隨著OpenAI發(fā)布DALL-E 2,自回歸和擴(kuò)散模型一夜之間成為大規(guī)模生成模型的新標(biāo)準(zhǔn),而在此之前,生成對抗網(wǎng)絡(luò)(GAN)一直都是主流選擇,并衍生出StyleGAN等技術(shù)。

從GAN切換到擴(kuò)散模型的架構(gòu)轉(zhuǎn)變也引出了一個問題:能否通過擴(kuò)大GAN模型的規(guī)模,比如說在 LAION 這樣的大型數(shù)據(jù)集中進(jìn)一步提升性能嗎?

最近,針對增加StyleGAN架構(gòu)容量會導(dǎo)致不穩(wěn)定的問題,來自浦項科技大學(xué)(韓國)、卡內(nèi)基梅隆大學(xué)和Adobe研究院的研究人員提出了一種全新的生成對抗網(wǎng)絡(luò)架構(gòu)GigaGAN,打破了模型的規(guī)模限制,展示了 GAN 仍然可以勝任文本到圖像合成模型。

論文鏈接:https://arxiv.org/abs/2303.05511

項目鏈接:https://mingukkang.github.io/GigaGAN/

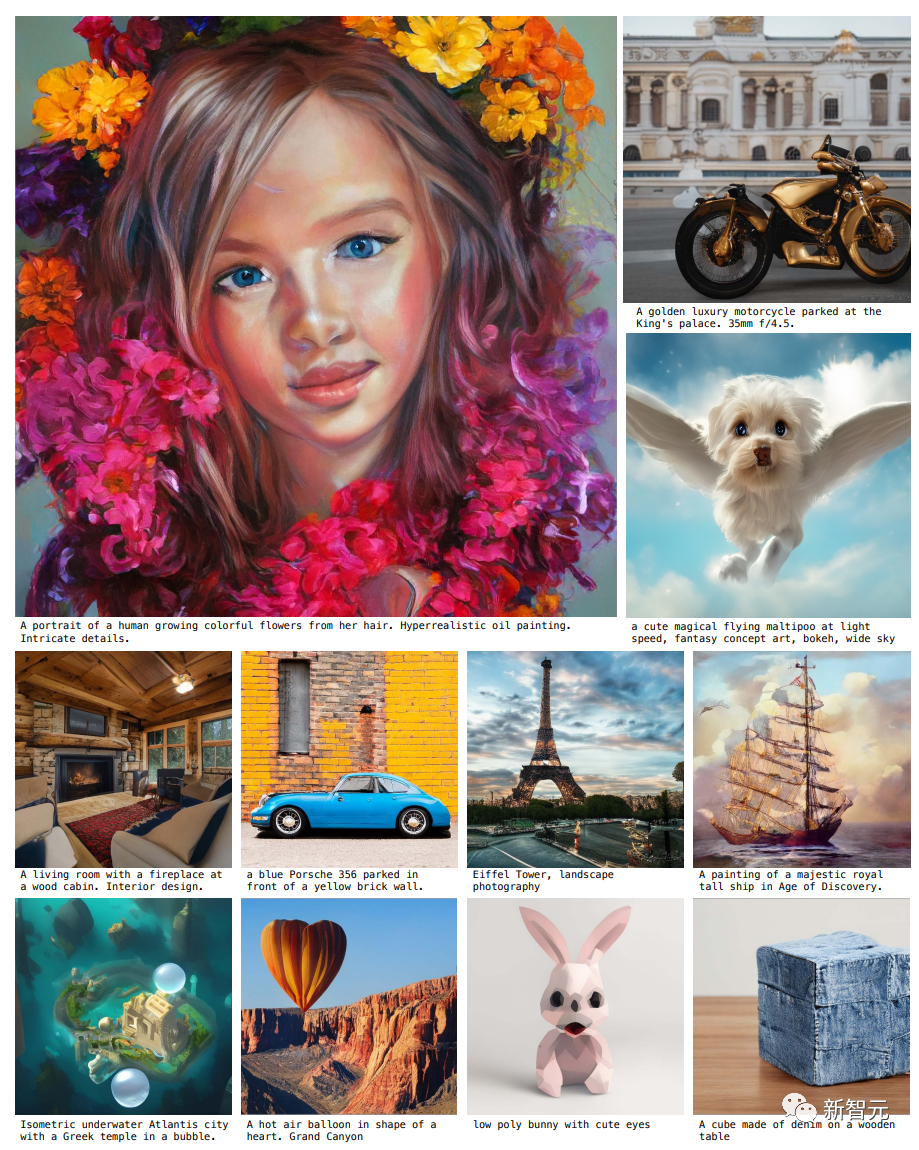

GigaGAN有三大優(yōu)勢。

1. 它在推理時速度更快,相比同量級參數(shù)的Stable Diffusion-v1.5,在512分辨率的生成速度從2.9秒縮短到0.13秒。

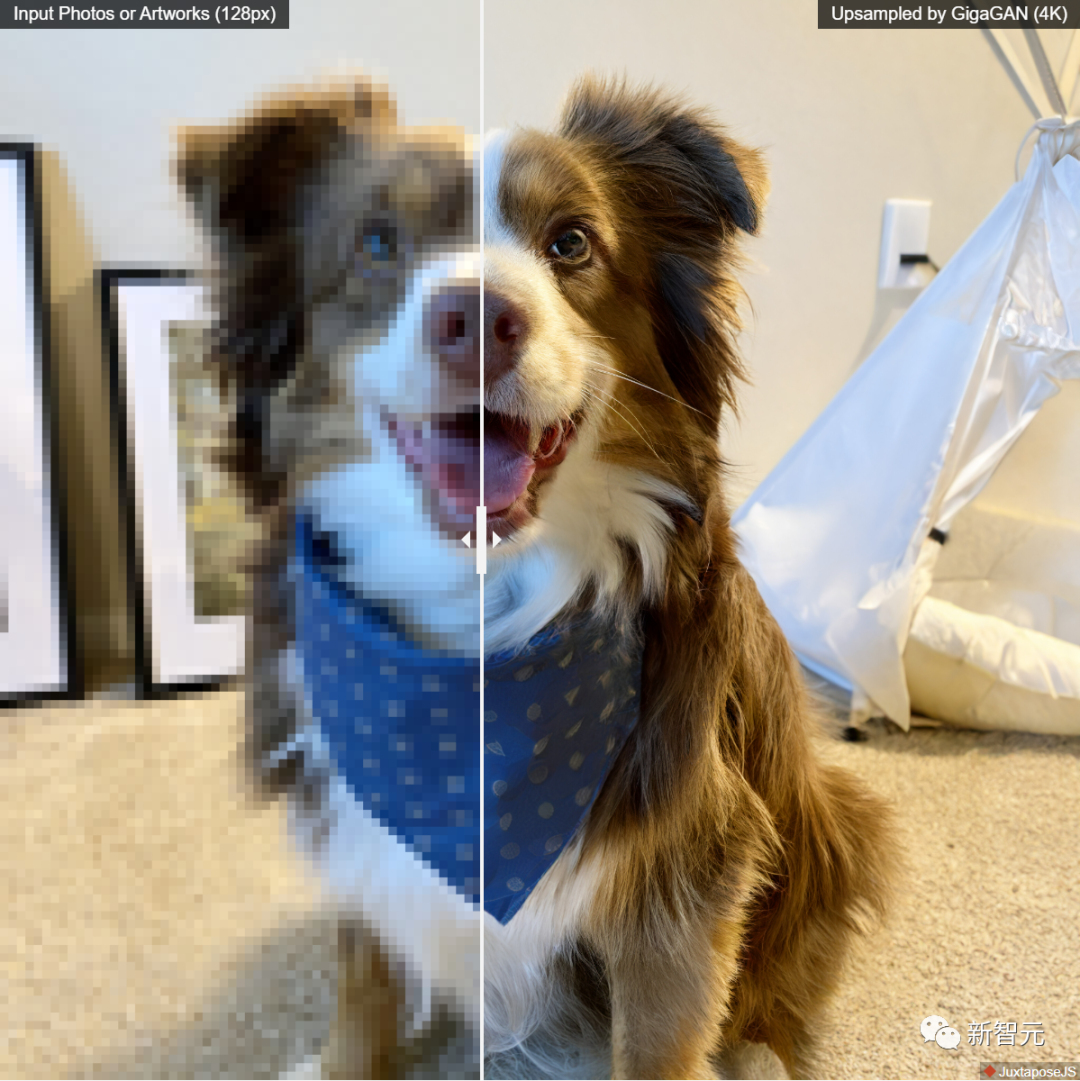

2. 可以合成高分辨率的圖像,例如,在3.66秒內(nèi)合成1600萬像素的圖像。

3. 支持各種潛空間編輯應(yīng)用程序,如潛插值、樣式混合和向量算術(shù)操作等。

最近發(fā)布的一系列模型,如DALL-E 2、Imagen、Parti和Stable Diffusion,開創(chuàng)了圖像生成的新時代,在圖像質(zhì)量和模型靈活性方面達(dá)到了前所未有的水平。

現(xiàn)在占主導(dǎo)地位的范式「擴(kuò)散模型」和「自回歸模型」,都依賴于迭代推理這把雙刃劍,因為迭代方法能夠以簡單的目標(biāo)進(jìn)行穩(wěn)定的訓(xùn)練,但在推理過程中會產(chǎn)生更高的計算成本。

與此形成對比的是生成對抗網(wǎng)絡(luò)(GAN),只需要一次forward pass即可生成圖像,因此本質(zhì)上是更高效的。

雖然GAN模型主導(dǎo)了生成式建模的「前一個時代」,但由于訓(xùn)練過程中的不穩(wěn)定性,對GAN進(jìn)行擴(kuò)展需要仔細(xì)調(diào)整網(wǎng)絡(luò)結(jié)構(gòu)和訓(xùn)練考慮,因此GANs雖然在為單個或多個對象類別建模方面表現(xiàn)出色,但擴(kuò)展到復(fù)雜的數(shù)據(jù)集上(更不用說開放世界物體生成了),仍然具有挑戰(zhàn)性。

所以目前超大型的模型、數(shù)據(jù)和計算資源都主要集中在擴(kuò)散和自回歸模型上。

在這項工作中,研究人員主要解決以下問題:

GAN能否繼續(xù)擴(kuò)大規(guī)模并有可能從這些資源中受益?或者說GAN已經(jīng)到達(dá)極限了?是什么阻礙了GAN的進(jìn)一步擴(kuò)展?能否克服這些障礙?

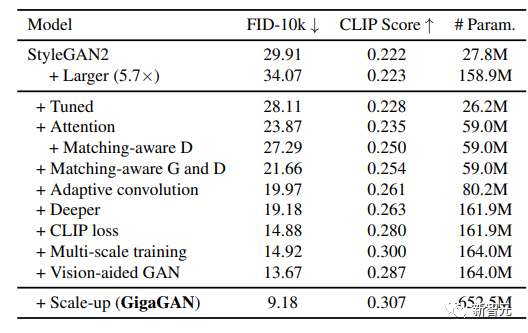

研究人員首先用StyleGAN2進(jìn)行實驗,觀察到簡單地擴(kuò)展骨干網(wǎng)會導(dǎo)致不穩(wěn)定的訓(xùn)練,在確定了幾個關(guān)鍵問題后,提出了在增加模型容量的同時穩(wěn)定訓(xùn)練的技術(shù)。

首先,通過保留一個濾波器庫(a bank of filters),并采取一個特定樣本的線性組合來有效地擴(kuò)展生成器的容量。

改編了幾個在擴(kuò)散模型上下文中常用的技術(shù),并確認(rèn)它們可以為GANs帶來了類似的性能提升,例如將自注意力機(jī)制(僅圖像)和交叉注意力(圖像-文本)與卷積層交織在一起可以提高性能。

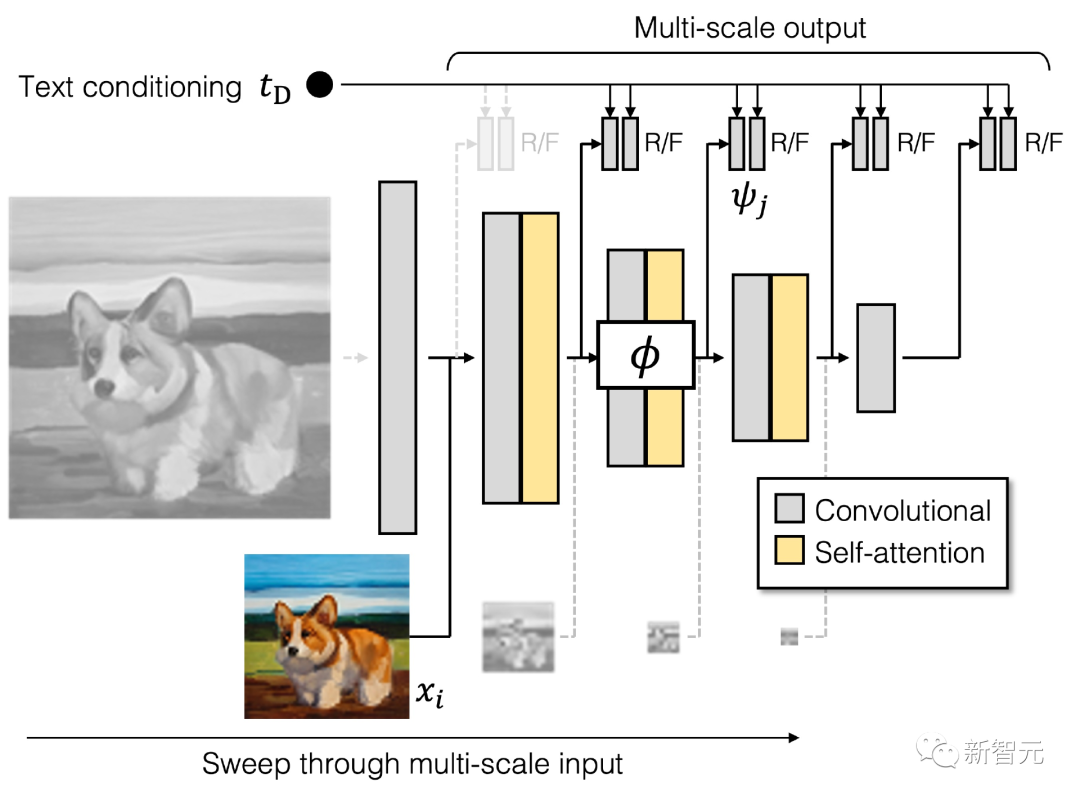

此外,研究人員重新引入了多尺度訓(xùn)練(multi-scaletraining),找到了一個新的方案可以改善圖像-文本對齊和生成輸出的低頻細(xì)節(jié)。

多尺度訓(xùn)練可以讓基于GAN的生成器更有效地使用低分辨率塊中的參數(shù),從而具有更好的圖像-文本對齊和圖像質(zhì)量。

生成器

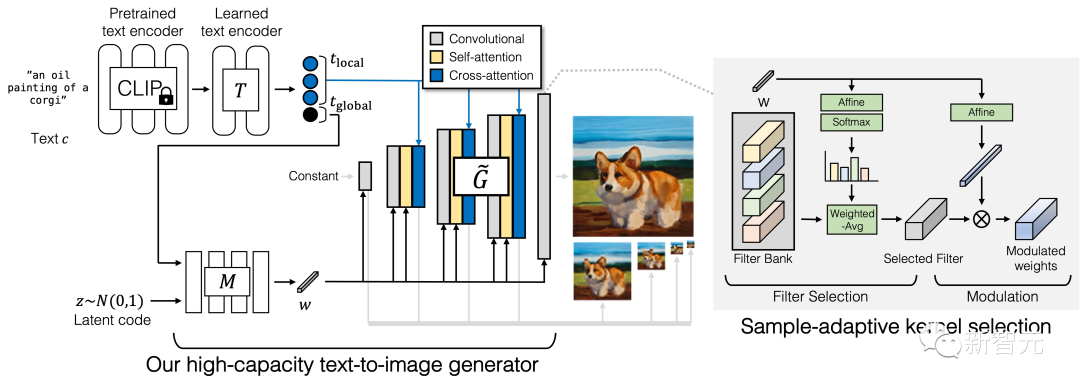

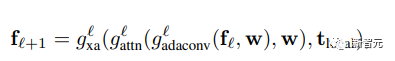

GigaGAN的生成器由文本編碼分支(text encoding branch)、樣式映射網(wǎng)絡(luò)(style mapping network)、多尺度綜合網(wǎng)絡(luò)(multi-scale synthesis network)組成,并輔以穩(wěn)定注意力(stable attention)和自適應(yīng)核選擇(adaptive kernel selection)。

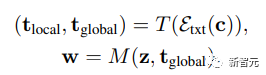

在文本編碼分支中,首先使用一個預(yù)先訓(xùn)練好的 CLIP 模型和一個學(xué)習(xí)的注意層 T 來提取文本嵌入,然后將嵌入過程傳遞給樣式映射網(wǎng)絡(luò) M,生成與 StyleGAN 類似的樣式向量 w

合成網(wǎng)絡(luò)采用樣式編碼作為modulation,以文本嵌入作為注意力來生成image pyramid,在此基礎(chǔ)上,引入樣本自適應(yīng)核選擇算法,實現(xiàn)了基于輸入文本條件的卷積核自適應(yīng)選擇。

判別器

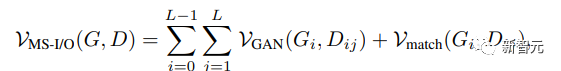

與生成器類似,GigaGAN的判別器由兩個分支組成,分別用于處理圖像和文本條件。

文本分支處理類似于生成器的文本分支;圖像分支接收一個image pyramid作為輸入并對每個圖像尺度進(jìn)行獨立的預(yù)測。

公式中引入了多個額外的損失函數(shù)以促進(jìn)快速收斂。

對大規(guī)模文本-圖像合成任務(wù)進(jìn)行系統(tǒng)的、受控的評估是困難的,因為大多數(shù)現(xiàn)有的模型并不公開可用,即使訓(xùn)練代碼可用,從頭開始訓(xùn)練一個新模型的成本也會過高。

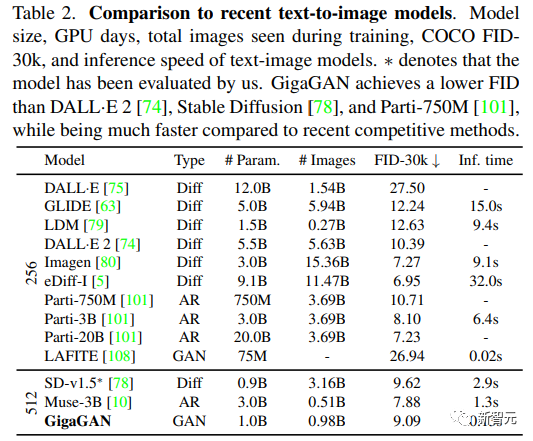

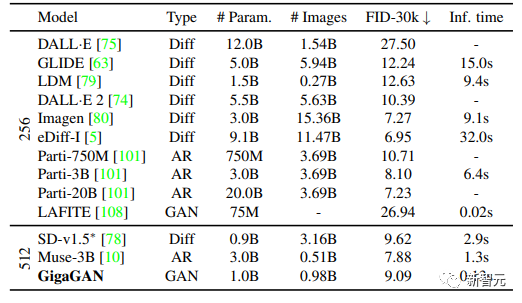

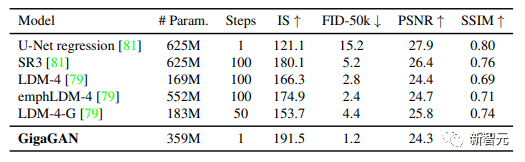

研究人員選擇在實驗中與Imagen、Latent Diffusion Models(LDM)、Stable Diffusion和Parti進(jìn)行對比,同時承認(rèn)在訓(xùn)練數(shù)據(jù)集、迭代次數(shù)、批量大小和模型大小方面存在相當(dāng)大的差異。

對于定量評價指標(biāo),主要使用Frechet Inception Distance(FID)來衡量輸出分布的真實性,并使用CLIP分?jǐn)?shù)來評價圖像-文本對齊。

文中進(jìn)行了五個不同的實驗:

1. 通過逐步納入每個技術(shù)組件來展示提出方法的有效性;

2. 文本-圖像合成結(jié)果表明,GigaGAN表現(xiàn)出與穩(wěn)定擴(kuò)散(SD-v1.5)相當(dāng)?shù)腇ID,同時生成的結(jié)果比擴(kuò)散或自回歸模型快數(shù)百倍;

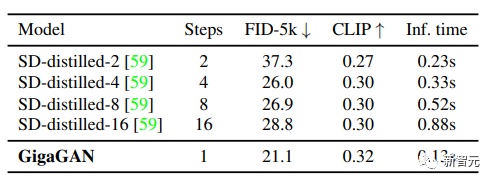

3. 將GigaGAN與基于蒸餾的擴(kuò)散模型進(jìn)行對比,顯示GigaGAN可以比基于蒸餾的擴(kuò)散模型更快地合成更高質(zhì)量的圖像;

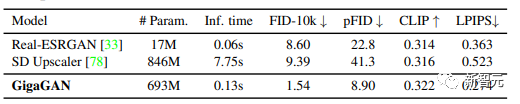

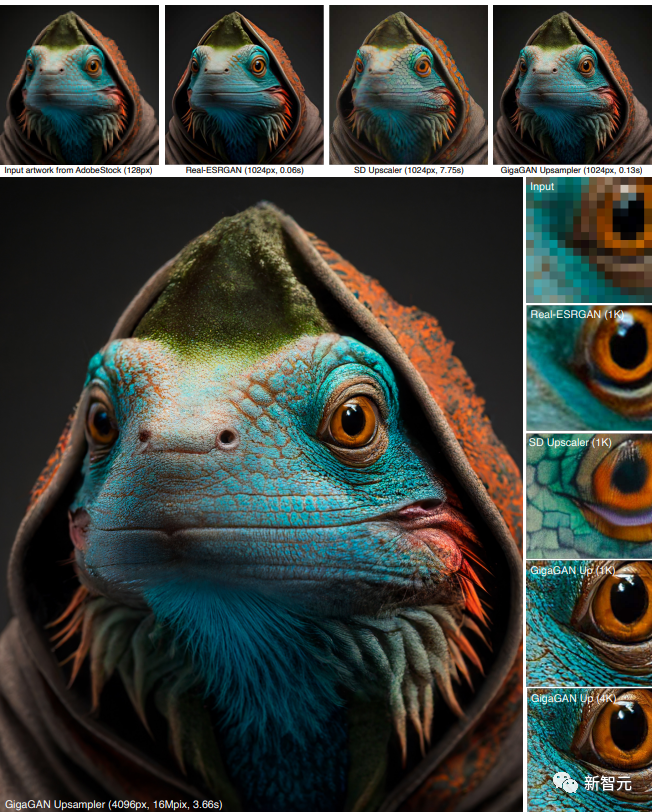

4. 驗證了GigaGAN的上采樣器在有條件和無條件的超分辨率任務(wù)中比其他上采樣器的優(yōu)勢;

5. 結(jié)果表明大規(guī)模GANs仍然享有GANs的連續(xù)和分解潛伏空間的操作,實現(xiàn)了新的圖像編輯模式。

經(jīng)過調(diào)參,研究人員在大規(guī)模的數(shù)據(jù)集,如LAION2B-en上實現(xiàn)了穩(wěn)定和可擴(kuò)展的十億參數(shù)GAN(GigaGAN)的訓(xùn)練。

并且該方法采用了多階段的方法,首先在64×64下生成,然后上采樣到512×512,這兩個網(wǎng)絡(luò)是模塊化的,而且足夠強(qiáng)大,能夠以即插即用的方式使用。

結(jié)果表明,盡管在訓(xùn)練時從未見過擴(kuò)散模型的圖像,但基于文本條件的GAN上采樣網(wǎng)絡(luò)可以作為基礎(chǔ)擴(kuò)散模型(如DALL-E 2)的高效、高質(zhì)量的上采樣器。

這些成果加在一起,使得GigaGAN遠(yuǎn)遠(yuǎn)超過了以前的GAN模型,比StyleGAN2大36倍,比StyleGAN-XL和XMC-GAN大6倍。

雖然GiGAN的10億參數(shù)量仍然低于最近發(fā)布的最大合成模型,如Imagen(3B)、DALL-E 2(5.5B)和Parti(20B),但目前還沒有觀察到關(guān)于模型大小的質(zhì)量飽和度。

GigaGAN在COCO2014數(shù)據(jù)集上實現(xiàn)了9.09的zero-shot FID,低于DALL-E 2、Parti-750M和Stable Diffusion的FID

提示插值(Prompt interpolation)

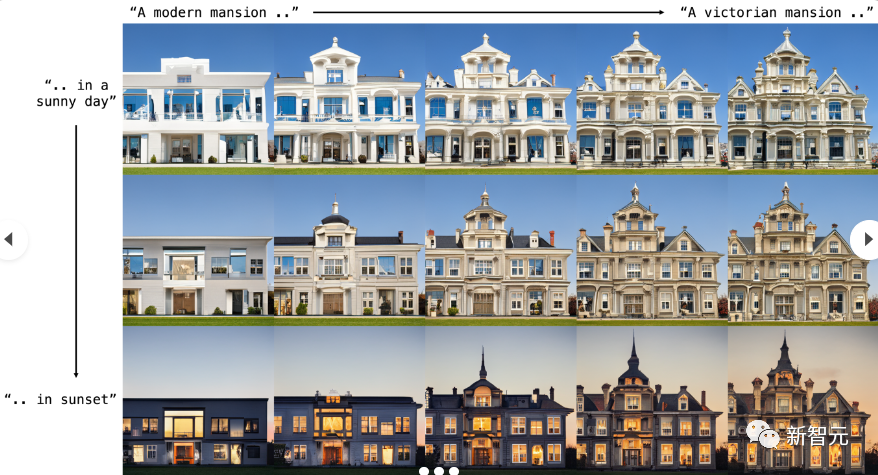

GigaGAN可以在提示之間平滑地插值,下圖中的四個角是由同一潛碼生成,但帶有不同的文本提示。

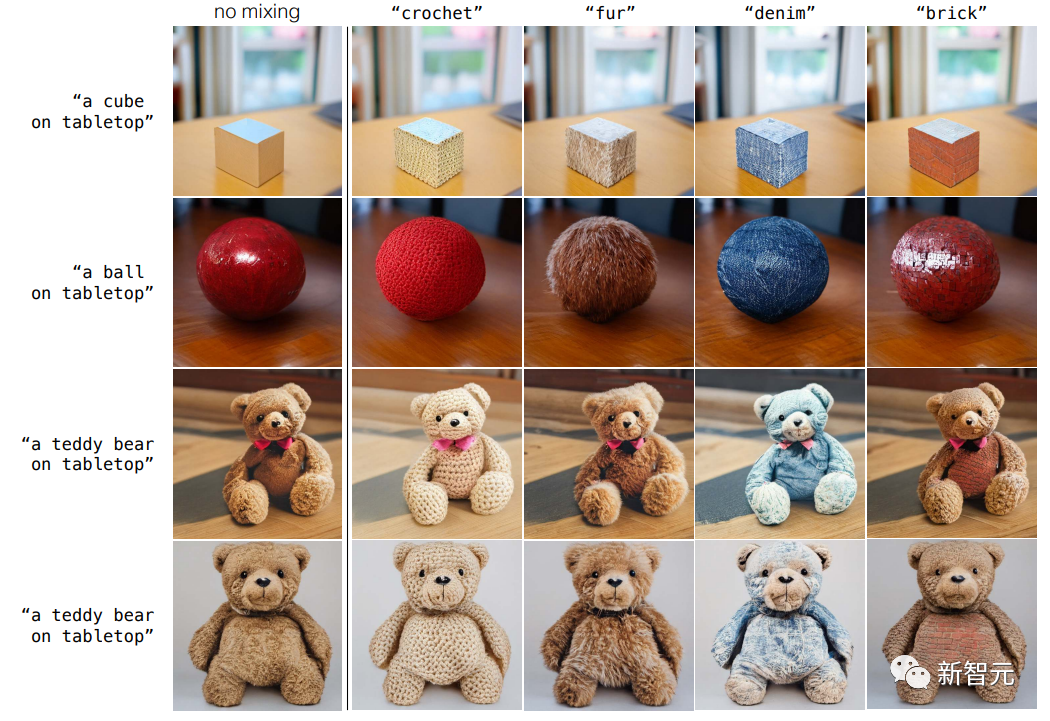

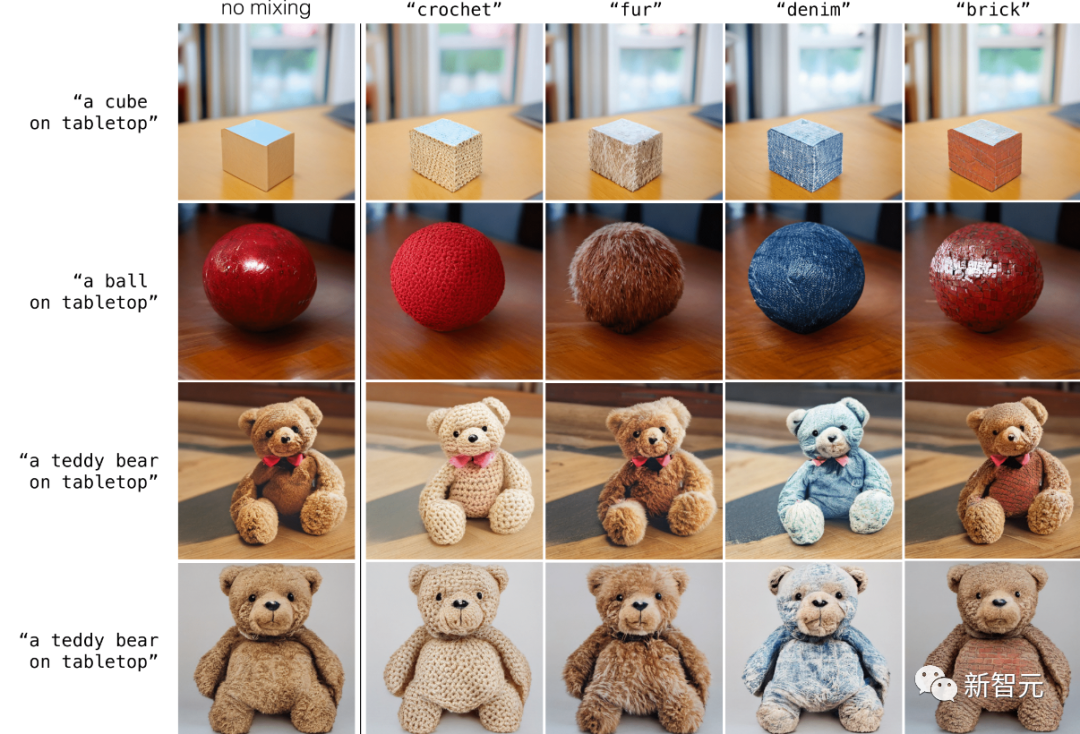

解耦提示混合(Disentangled prompt mixing)

GigaGAN 保留了一個分離的潛空間,使得能夠?qū)⒁粋€樣本的粗樣式與另一個樣本的精細(xì)樣式結(jié)合起來,并且GigaGAN 可以通過文本提示直接控制樣式。

粗到精風(fēng)格交換(Coarse-to-fine sytle swapping)

基于 GAN 的模型架構(gòu)保留了一個分離的潛在空間,使得能夠?qū)⒁粋€樣本的粗樣式與另一個樣本的精樣式混合在一起。

參考資料:?

https://mingukkang.github.io/GigaGAN/