GPT-4太強,OpenAI也不懂!智能到底是怎么突然「涌現」的?

2023年至今,ChatGPT和GPT-4始終霸占在熱搜榜上,一方面外行人都在驚嘆于AI怎么突然如此強大,會不會革了「打工人」的命;另一方面,其實內行人也不明白,為什么模型規模在突破某一界限后,突然就「涌現」出了驚人的智能。

出現智能是好事,但模型不可控、不可預測、不可解釋的行為,卻讓整個學術界陷入了迷茫與深思。

突然變強的超大模型

先出一道簡單的題目,下面這幾個emoj代表了什么電影?

最簡單的語言模型往往只能續寫出「The movie is a movie about a man who is a man who is a man」;中等復雜度模型的答案則更接近,給出的答案是「The Emoji Movie」;但最復雜的語言模型只會給出一個答案:海底總動員「Finding Nemo」

實際上這個prompt也是為測試各種大型語言模型能力而設計的204項任務之一。

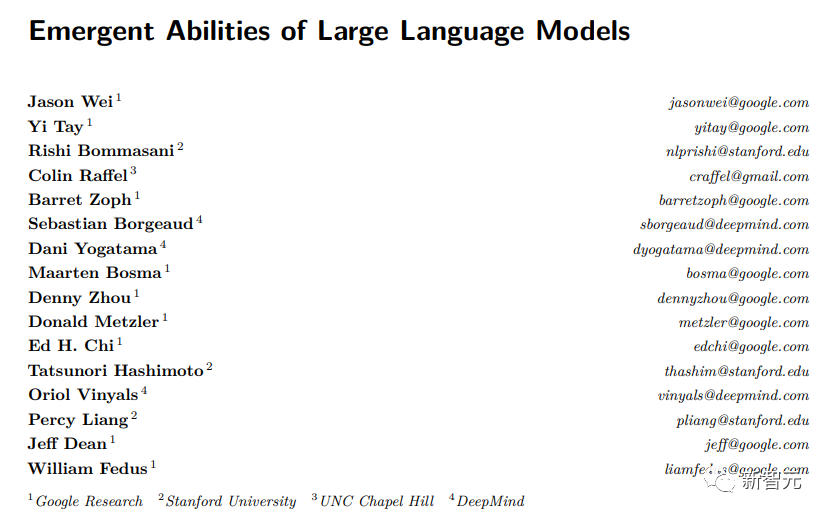

Google Research的計算機科學家Ethan Dyer參與組織了這次測試,他表示,雖然構建BIG-Bench數據集的時候我已經準備好了迎接驚喜,但當真的見證這些模型能做到的時候,還是感到非常驚訝。

驚訝之處在于,這些模型只需要一個提示符:即接受一串文本作為輸入,并且純粹基于統計數據一遍又一遍地預測接下來是什么內容。

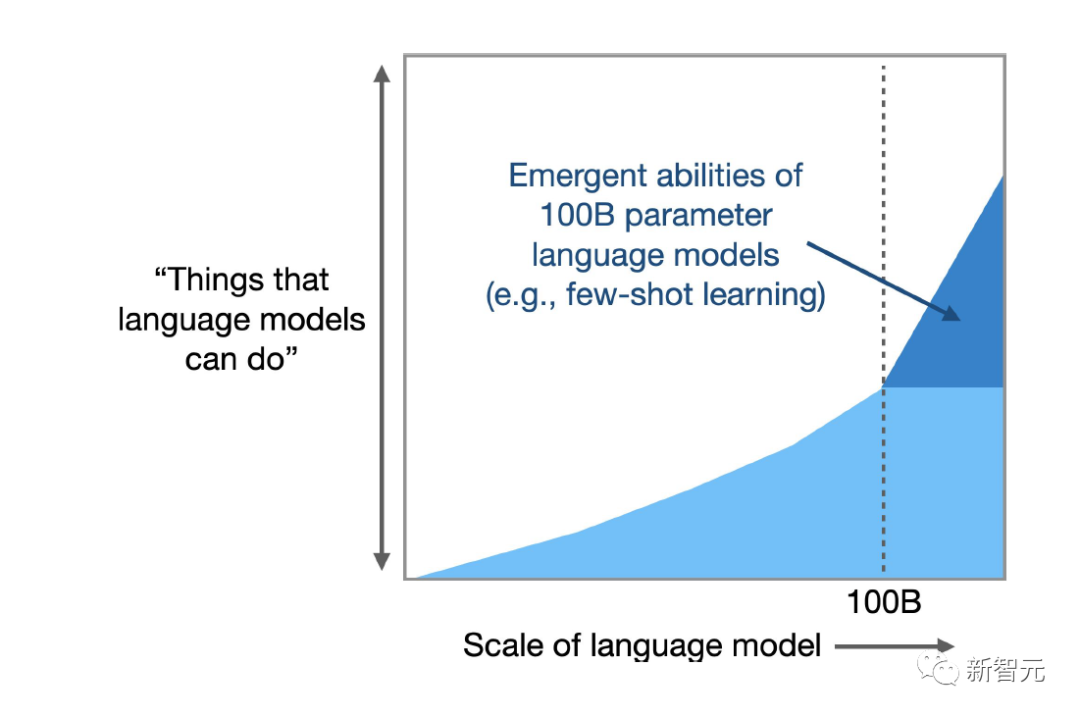

計算機科學家曾預計,擴大規模可以提高已知任務的性能,但他們沒有預料到模型會突然能夠處理這么多新的、不可預測的任務。

Dyer最近參與的一項調研結果顯示,LLM 可以產生數百種「涌現」(emergent)能力,即大型模型可以完成的任務,小型模型無法完成,其中許多任務似乎與分析文本無關,比如從乘法計算到生成可執行的計算機代碼,還包括基于Emoji符號的電影解碼等。

新的分析表明,對于某些任務和某些模型,存在一個復雜性閾值,超過這個閾值,模型的功能就會突飛猛進。

研究人員也提出了涌現能力的另一個負面影響:隨著復雜性的增加,一些模型在回答中顯示出新的偏見(biases)和不準確性。

斯坦福大學的計算機科學家 Rishi Bommasani 表示,我所知道的任何文獻中都沒有討論過語言模型可以做這些事情。

去年,Bommasani 參與編制了一份包含幾十種涌現行為的清單,其中包括在Dyer的項目中發現的幾種行為,并且這個名單還在繼續變長。

論文鏈接:https://openreview.net/pdf?id=yzkSU5zdwD

目前研究人員不僅在競相發現更多的涌現能力,而且還在努力找出它們發生的原因和方式,本質上是試圖對不可預測性進行預測。

理解涌現可以揭示圍繞人工智能和一般機器學習的深層次問題的答案,比如復雜模型是否真的在做一些新的事情,或者只是在統計方面變得非常擅長,它還可以幫助研究人員利用潛在的優勢和減少涌現風險。

人工智能初創公司 Anthroic 的計算機科學家Deep Ganguli表示,我們不知道如何判斷哪種應用程序的危害能力將會出現,無論是正常出現的還是不可預測的。

涌現的涌現(The Emergence of Emergence)

生物學家、物理學家、生態學家和其他科學家使用「涌現」一詞來描述當一大群事物作為一個整體時出現的自組織、集體行為。

比如無生命的原子組合產生活細胞; 水分子產生波浪; 椋鳥的低語以變化但可識別的模式在天空中飛翔; 細胞使肌肉運動和心臟跳動。

重要的是,涌現能力在涉及大量獨立部分的系統中都有出現,但是研究人員直到最近才能夠在 LLM 中發現這些能力,或許是因為這些模型已經發展到了足夠大的規模。

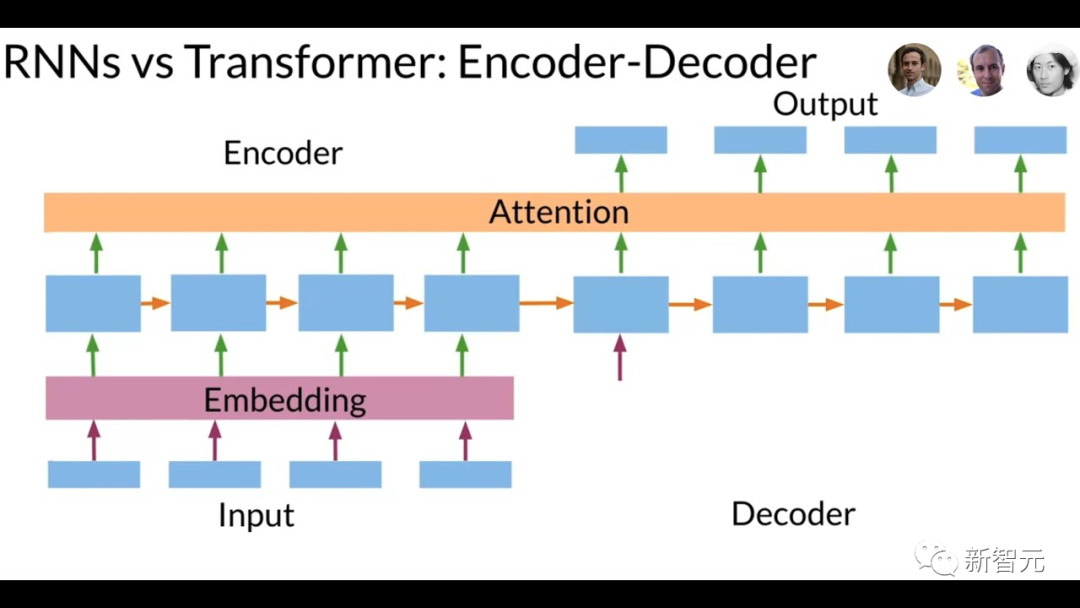

語言模型已經存在了幾十年,但直到五年前最強大的武器還是基于循環神經網絡(RNN),訓練方法就是輸入一串文本并預測下一個單詞是什么;之所以叫循環(recurrent),是因為模型從自己的輸出中進行學習,即把模型的預測反饋到網絡中,以改善性能。

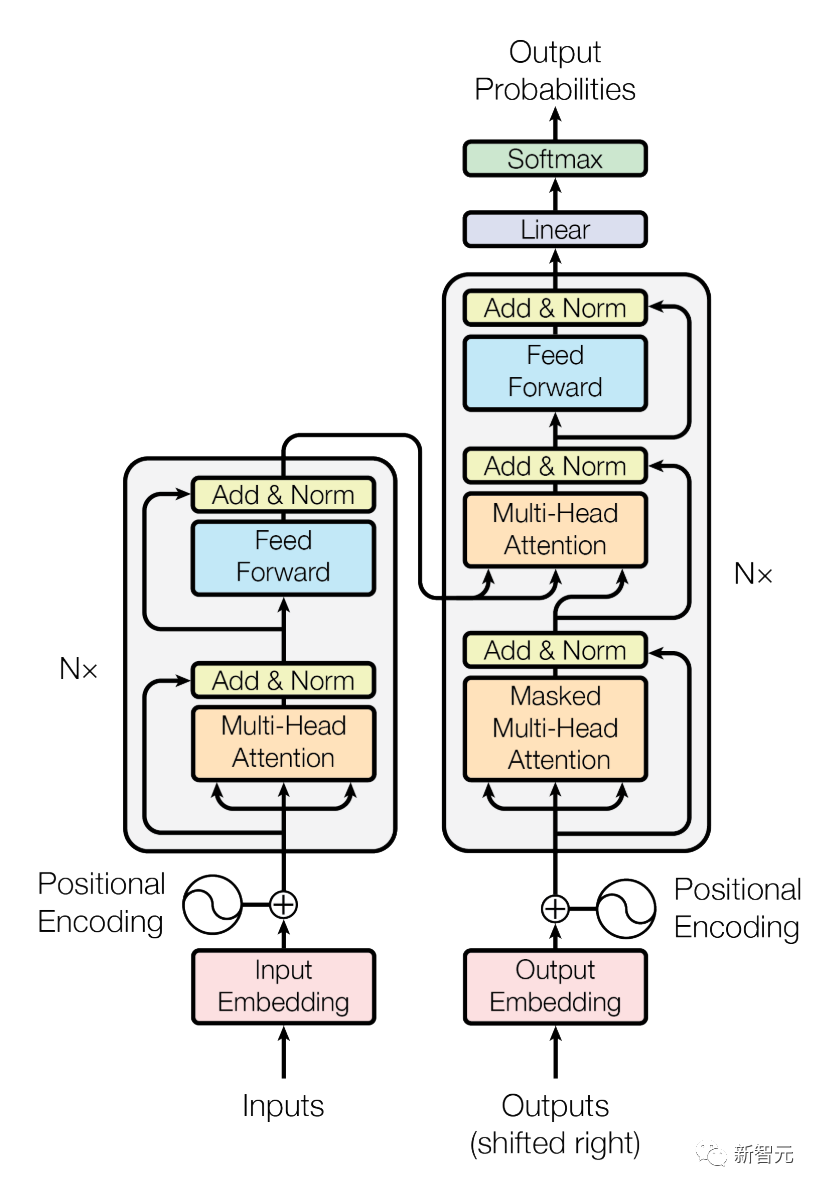

2017年,谷歌大腦的研究人員引入了一種名為Transformer的全新架構,相比循環網絡逐字分析一個句子,Transformer可以同時處理所有的單詞,也就意味著Transformer可以并行處理大量文本。

通過增加模型中的參數數量以及其他因素,Transformer使語言模型的復雜性得以快速擴展,其中參數可以被認為是單詞之間的連接,模型通過在訓練期間調整這些連接的權重以改善預測結果。

模型中的參數越多,建立聯系的能力就越強,模擬人類語言的能力也就越強。

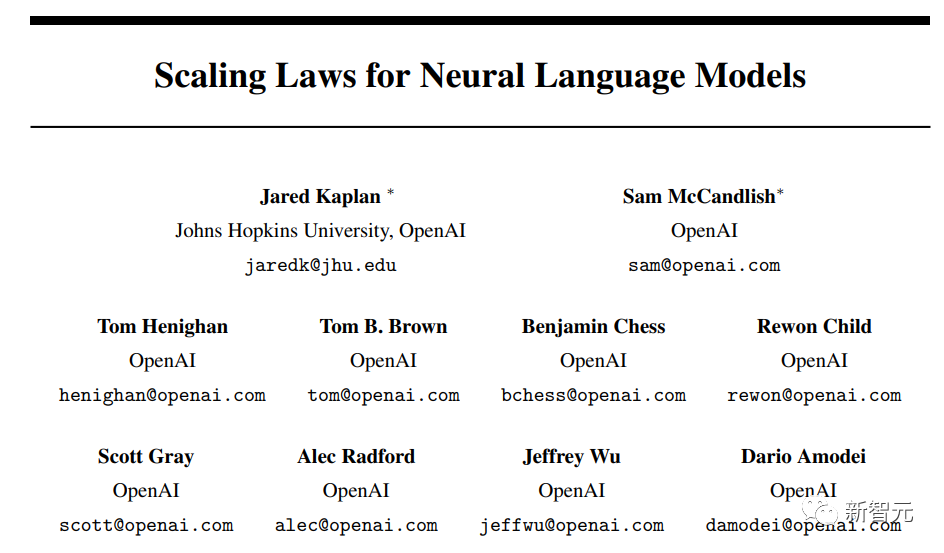

正如預期的那樣,OpenAI 研究人員在2020年進行的一項分析發現,隨著模型規模的擴大,它們的準確性和能力都有所提高。

論文鏈接:https://arxiv.org/pdf/2001.08361.pdf

隨著 GPT-3(擁有1750億參數)和谷歌的 PaLM (可擴展至5400億參數)等模型的發布,用戶發現了越來越多的涌現能力。

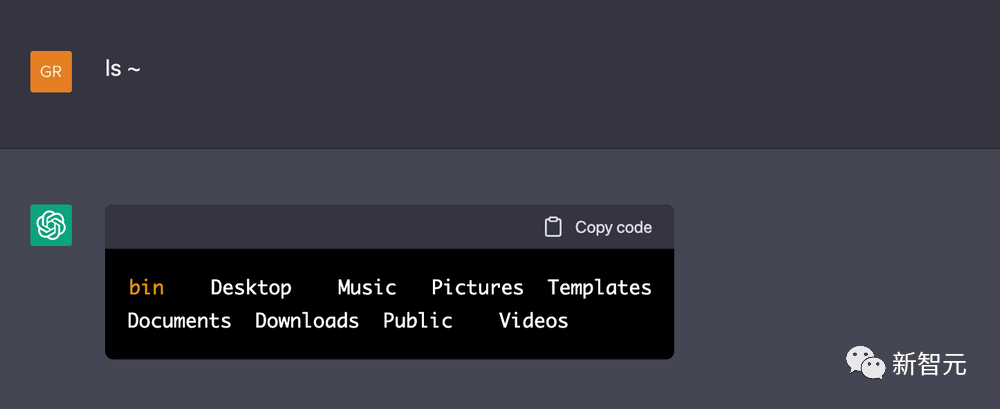

一位 DeepMind 的工程師甚至報告說,他可以讓 ChatGPT 認為自己是一個 Linux 終端,并運行一些簡單的數學代碼來計算前10個素數。值得注意的是,ChatGPT可以比在真正的 Linux 機器上運行相同的代碼更快地完成任務。

與電影Emoji符號任務一樣,研究人員沒有理由認為一個用于預測文本的語言模型可以模仿計算機終端,許多涌現行為都展現了語言模型的Zero-shot或Few-shot學習能力,即LLM可以解決以前從未見過或很少見過的問題的能力。

大批研究人員發現了 LLM 可以超越訓練數據約束的跡象,他們正在努力更好地掌握涌現的樣子以及它是如何發生的,第一步就是完全地記錄下來。

超越模仿游戲

2020年,Dyer 和Google Research的其他人預測,LLM 將產生變革性影響,但這些影響具體是什么仍然是一個懸而未決的問題。

因此,他們要求各個研究團隊提供困難且多樣化任務的例子以找到語言模型的能力邊界,這項工作也被稱為「超越模仿游戲的基準」(BIG-bench,Beyond the Imitation Game Benchmark)項目,名字來源于阿蘭 · 圖靈提出的「模仿游戲」,即測試計算機是否能以令人信服的人性化方式回答問題,也叫做圖靈測試。

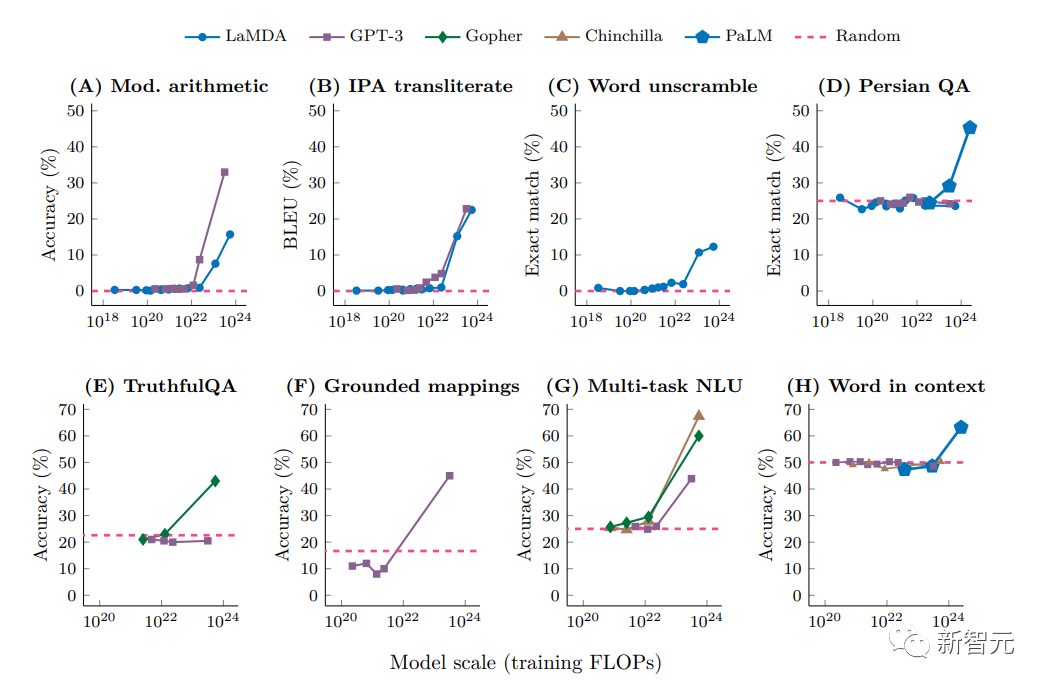

正如所預料的那樣,在某些任務上,隨著復雜性的增加,模型的性能平穩且可預測地得到改善;而在其他任務中,擴大參數的數量并沒有產生任何改善。

但是,在大約5% 的任務中,研究人員發現了所謂的「突破」(breakthroughs),即在一定閾值范圍內,性能出現了快速、戲劇性的躍升,該閾值隨任務和模型的不同而變化。

例如,參數相對較少(只有幾百萬)的模型不能成功地完成三位數加法或兩位數乘法的問題,但對于數百億個參數,某些模型的精度會大幅提高。

其他任務也出現了類似的跳躍,包括解碼國際音標、解讀單詞的字母、識別印度英語(印地語和英語的結合)段落中的冒犯性內容,以及生成類似于斯瓦希里諺語的英語對等詞。

但是研究人員很快意識到模型的復雜性并不是唯一的驅動因素,如果數據質量足夠高,一些意想不到的能力可以從參數較少的較小模型中獲得,或者在較小的數據集上訓練,此外query的措辭也會影響模型回復的準確性。

去年,在該領域的旗艦會議 NeurIPS 上發表的一篇論文中,Google Brain的研究人員展示了如何讓模型利用提示對自己進行解釋(思維鏈推理),比如如何正確地解決math word問題,而同樣的模型如果沒有提示就不能正確地解決。

論文鏈接:https://neurips.cc/Conferences/2022/ScheduleMultitrack?event=54087

Google Brain的科學家Yi Tay致力于系統研究breakthroughs,他指出,最近的研究表明,思維鏈的提示改變了模型的規模曲線,也改變了涌現的點,使用思維鏈式提示可以引發 BIG 實驗中沒有發現的涌現行為。

布朗大學研究語言計算模型的計算機科學家Ellie Pavlick認為,最近的這些發現至少提出了兩種可能性:

第一個是,正如與生物系統相比較所顯示的那樣,較大的模型確實會自發地獲得新的能力,這很可能是因為這個模型從根本上學到了一些新的和不同的東西,而這些東西在小尺寸模型中沒有的,而這正是我們所希望的情況,當模型擴大規模時,會發生一些根本性的轉變。

另一種不那么聳人聽聞的可能性是,看似突破性的事件可能是一個內部的、由統計數據驅動的、通過思維鏈式推理運作的過程,大型 LLM 可能只是學習啟發式算法,對于那些參數較少或者數據質量較低的參數來說,啟發式算法是無法實現的。

但是她認為,找出這些解釋中哪一個更有可能依賴于能夠理解 LLM 是如何運行的,因為我們不知道它們在引擎蓋下是如何工作的,所以我們不能說這些猜測中哪些更合理。

隱藏在未知力量下的陷阱

谷歌在二月份發布了類ChatGPT產品Bard,不過在演示中卻暴露出了一個事實性錯誤,這也帶來了一個啟示,雖然越來越多的研究人員開始依賴這些語言模型來做基本的工作,但是并不能相信這些模型的輸出結果,需要人來進一步檢查他們的工作。

涌現導致了不可預測性,而不可預測性也隨規模的擴大而增加,使研究人員難以預測廣泛使用的后果。

想要研究涌現現象,那你必須先在頭腦中有一個案例,在研究規模的影響之前,你無法知道可能會出現什么能力或局限性。

某些有害行為也會在某些模型中涌現,最近對 LLM 的分析結果表明,社會偏見的涌現往往伴隨著大量的參數,也就是說大型模型會突然變得更有偏見,如果不能解決這一風險,就可能危及這些模型的研究對象。