全面了解大語言模型,這有一份閱讀清單

大型語言模型已經引起了公眾的注意,短短五年內,Transforme等模型幾乎完全改變了自然語言處理領域。此外,它們還開始在計算機視覺和計算生物學等領域引發革命。

鑒于Transformers對每個人的研究進程都有如此大的影響,本文將為大家介紹一個簡短的閱讀清單,供機器學習研究人員和從業者入門使用。

下面的列表主要是按時間順序展開的,主要是一些學術研究論文。當然,還有許多其他有用的資源。例如:

- Jay Alammar撰寫的《The Illustrated Transformer》

- Lilian Weng撰寫的《The Transformer Family》

- Xavier Amatriain撰寫的《Transformer models: an introduction and catalog — 2023 Edition》

- Andrej Karpathy寫的nanoGPT庫

對主要架構和任務的理解

如果你是Transformers、大型語言模型新手,那么這幾篇文章最適合你。

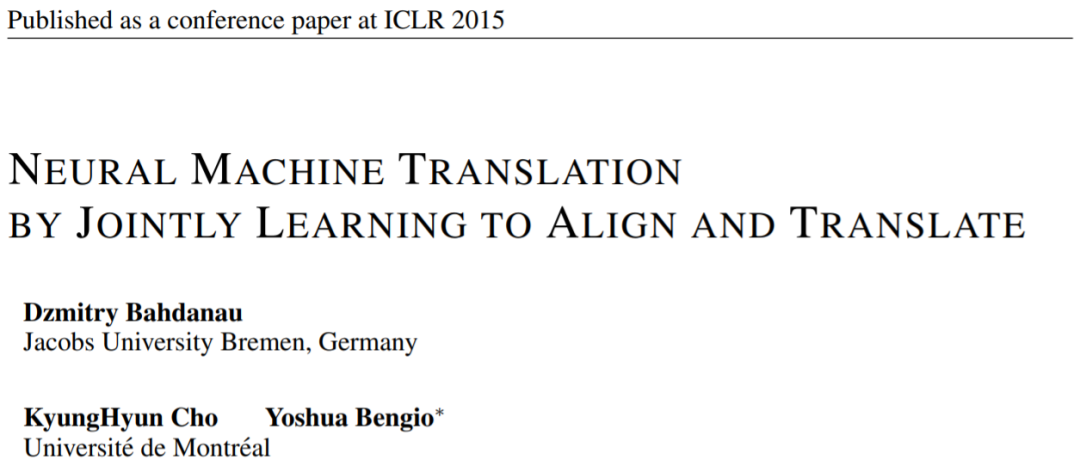

論文1:《Neural Machine Translation by Jointly Learning to Align and Translate》?

論文地址:https://arxiv.org/pdf/1409.0473.pdf

本文引入了一種循環神經網絡(RNN)注意力機制,提高了模型遠程序列建模能力。這使得RNN能夠更準確地翻譯較長的句子——這也是后來開發原始Transformer架構的動機。

圖源: https://arxiv.org/abs/1409.0473

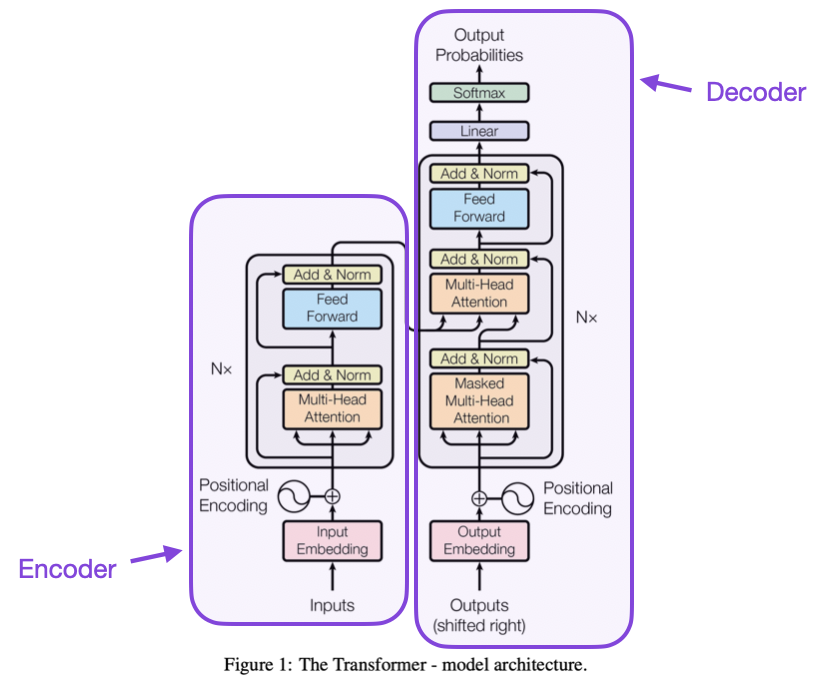

論文2:《Attention Is All You Need》?

論文地址:https://arxiv.org/abs/1706.03762

本文介紹了由編碼器和解碼器組成的原始Transformer架構,這些部分將在以后作為單獨模塊進行相關介紹。此外,本文還介紹了縮放點積注意力機制、多頭注意力塊和位置輸入編碼等概念,這些概念仍然是現代Transformer的基礎。

圖源:https://arxiv.org/abs/1706.03762

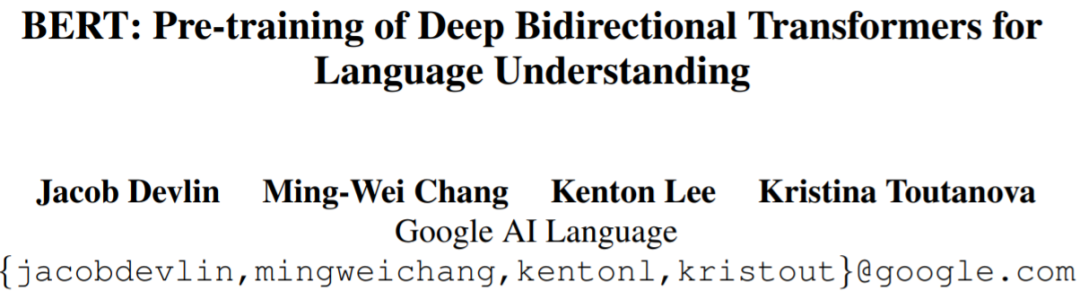

論文3:《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》?

論文地址:https://arxiv.org/abs/1810.04805

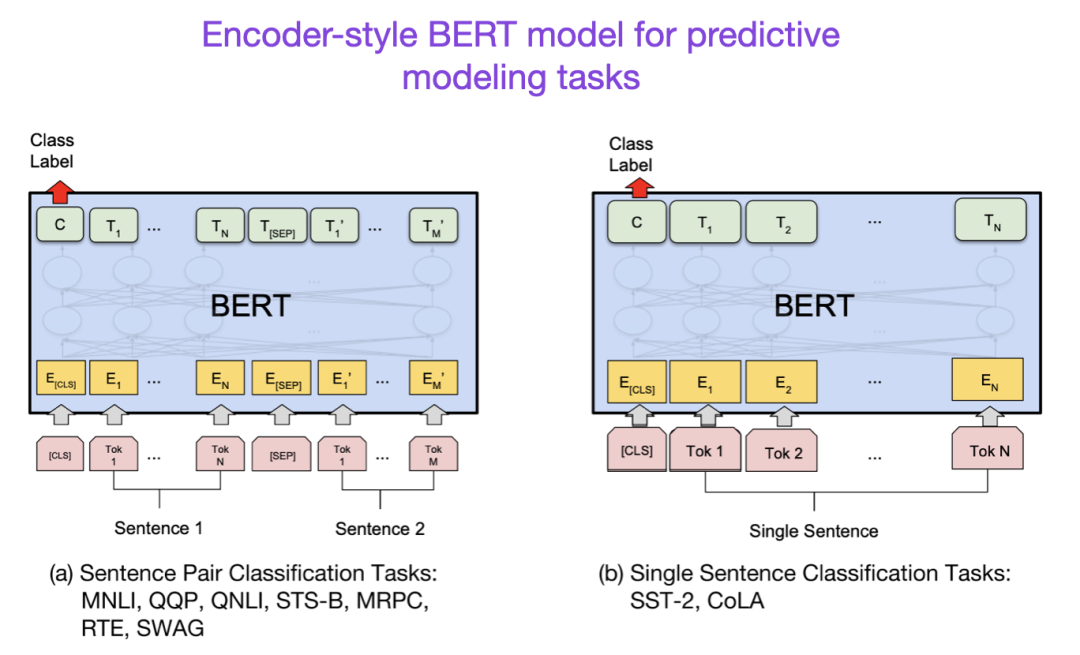

大型語言模型研究遵循最初的Transformer架構,然后開始向兩個方向延伸:用于預測建模任務(如文本分類)的Transformer和用于生成建模任務(如翻譯、摘要和其他形式的文本創建)的Transformer 。

BERT論文介紹了掩碼語言建模原始概念,如果你對這個研究分支感興趣,那么可以跟進RoBERTa,其簡化了預訓練目標。

圖源:https://arxiv.org/abs/1810.04805

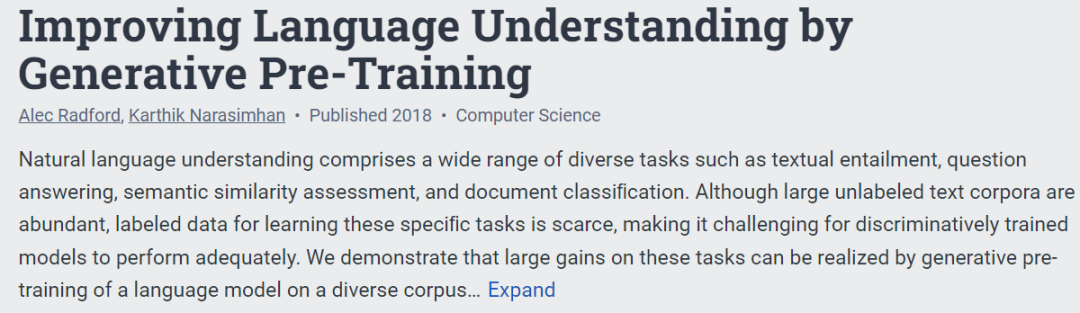

論文4:《Improving Language Understanding by Generative Pre-Training》

論文地址:https://www.semanticscholar.org/paper/Improving-Language-Understanding-by-Generative-Radford-Narasimhan/cd18800a0fe0b668a1cc19f2ec95b5003d0a5035

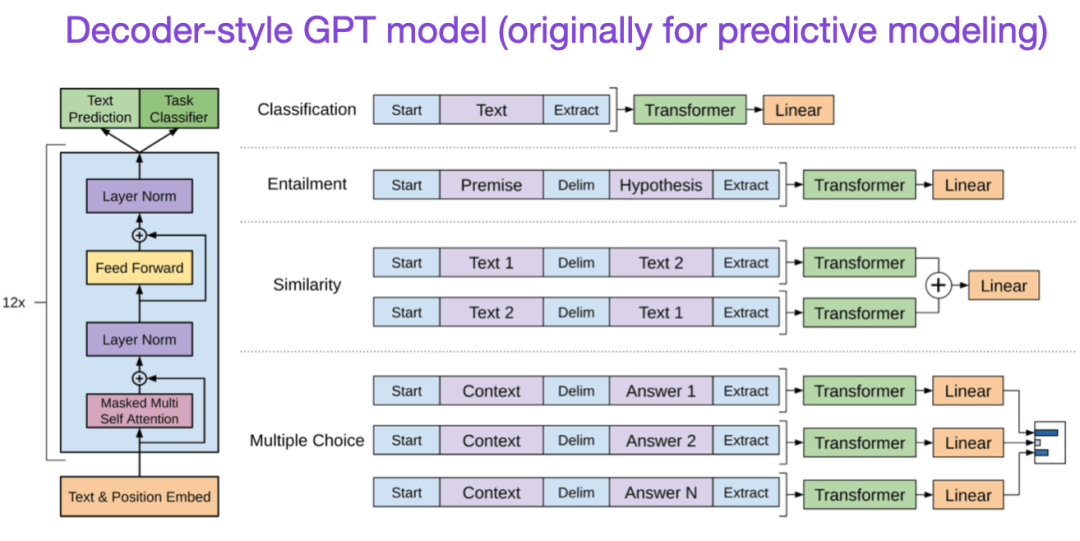

最初的GPT論文介紹了流行的解碼器風格的架構和通過下一個單詞預測進行預訓練。BERT由于其掩碼語言模型預訓練目標,可以被認為是一個雙向Transformer,而GPT是一個單向自回歸模型。雖然GPT嵌入也可以用于分類,但GPT方法是當今最有影響力的LLMs(如ChatGPT)的核心。

如果你對這個研究分支感興趣,那么可以跟進GPT-2和GPT-3的論文。此外,本文將在后面單獨介紹InstructGPT方法。

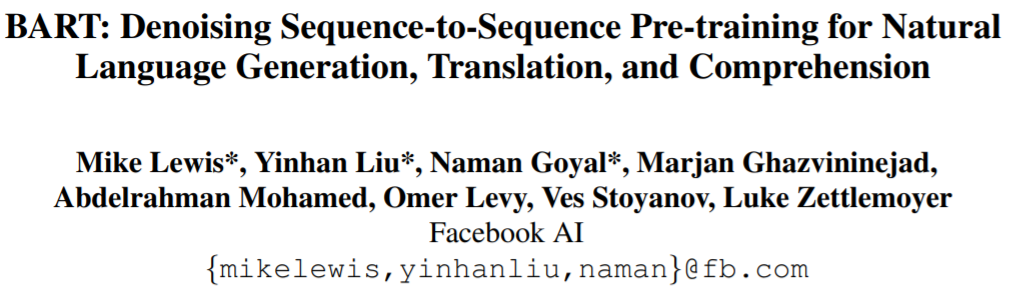

論文5:《BART: Denoising Sequence-to-Sequence Pre-training for Natural Language Generation, Translation, and Comprehension》

論文地址 https://arxiv.org/abs/1910.13461.

如上所述, BERT型編碼器風格的LLM通常是預測建模任務的首選,而GPT型解碼器風格的LLM更擅長生成文本。為了兩全其美,上面的BART論文結合了編碼器和解碼器部分。

擴展定律與效率提升

如果你想了解更多關于提高Transformer效率的技術,可以參考以下論文

- 論文1:《A Survey on Efficient Training of Transformers》?

- 論文地址:https://arxiv.org/abs/2302.01107?

- 論文2:《FlashAttention: Fast and Memory-Efficient Exact Attention with IO-Awareness》

- 論文地址:?https://arxiv.org/abs/2205.14135?

- 論文3:《Cramming: Training a Language Model on a Single GPU in One Day》

- 論文地址:https://arxiv.org/abs/2212.14034

- 論文4:《Training Compute-Optimal Large Language Models》

- 論文地址:https://arxiv.org/abs/2203.15556

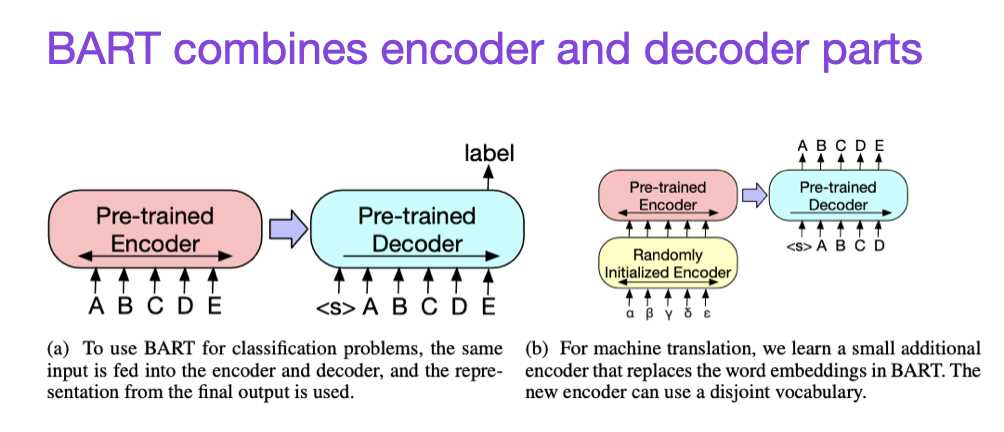

此外,還有論文《Training Compute-Optimal Large Language Models》

論文地址:https://arxiv.org/abs/2203.15556

本文介紹了700億參數的Chinchilla模型,該模型在生成建模任務上優于流行的1750億參數的GPT-3模型。然而,它的主要點睛之處在于,當代大型語言模型訓練嚴重不足。

本文定義了用于大型語言模型訓練的線性scaling law。例如,雖然Chinchilla的大小只有GPT-3的一半,但它的表現優于GPT-3,因為它是在1.4萬億(而不是3000億)token上進行訓練的。換句話說,訓練token的數量和模型大小一樣重要。

對齊——將大型語言模型朝著預期的目標和興趣引導

近年來出現了許多相對強大的大型語言模型,它們可以生成真實的文本(例如GPT-3和Chinchilla)。就常用的預訓練范式而言,目前似乎已經達到了一個上限。

為了使語言模型更能幫助到人類,減少錯誤信息和不良語言,研究人員設計了額外的訓練范式來微調預訓練的基礎模型,包括如下論文。

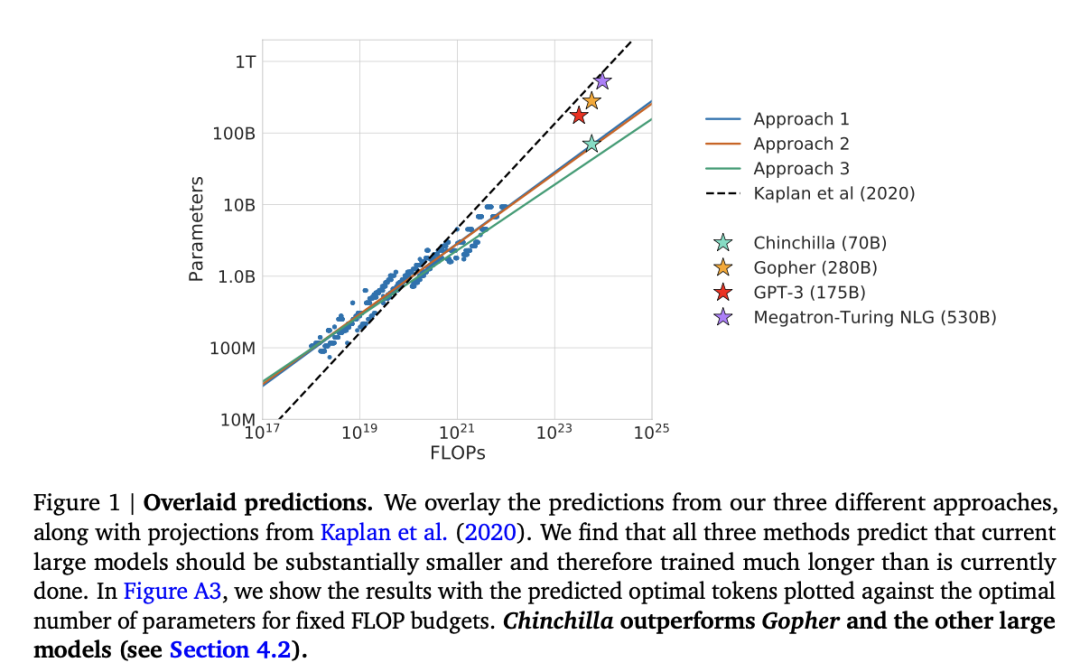

- 論文1:《Training Language Models to Follow Instructions with Human Feedback》

- 論文地址:https://arxiv.org/abs/2203.02155

在這篇所謂的InstructGPT論文中,研究人員使用了RLHF(Reinforcement Learning from Human Feedback)。他們從預訓練的GPT-3基礎模型開始,并使用監督學習對人類生成的提示響應對進行進一步微調(步驟1)。接下來,他們要求人類對模型輸出進行排序以訓練獎勵模型(步驟2)。最后,他們使用獎勵模型通過近端策略優化(步驟3)使用強化學習來更新預訓練和微調的GPT-3模型。

順便說一句,這篇論文也被稱為描述ChatGPT背后思想的論文——根據最近的傳言,ChatGPT是InstructGPT的擴展版本,它在更大的數據集上進行了微調。

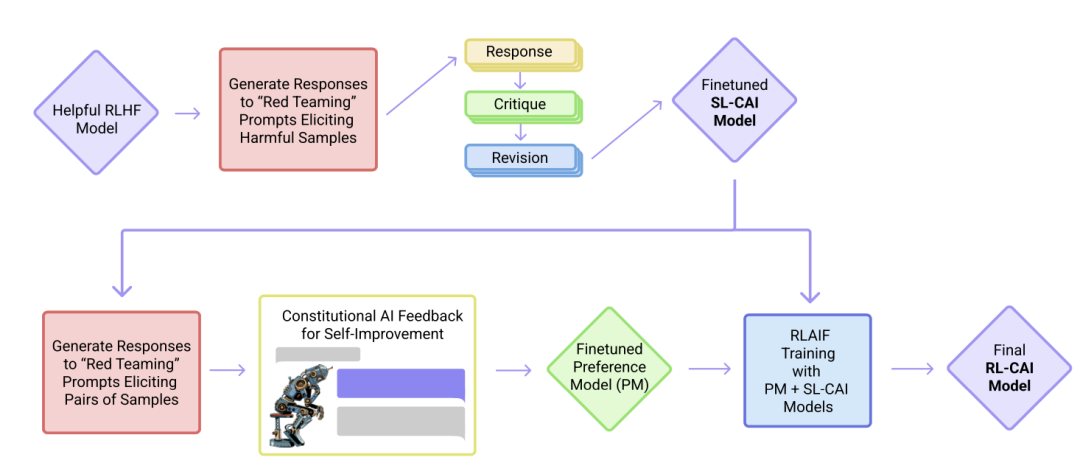

- 論文2:《Constitutional AI: Harmlessness from AI Feedback》

- 論文地址:https://arxiv.org/abs/2212.08073

在這篇論文中,研究人員進一步推進了對齊的想法,提出了一種創建「harmless」的AI系統的訓練機制。研究人員提出了一種基于規則列表(由人類提供)的自訓練機制,而不是直接由人類監督。與上面提到的InstructGPT論文類似,所提出的方法使用了強化學習方法。

總結?

本文對上方表單的排列盡量保持簡潔美觀,建議重點關注前10篇論文,以了解當代大型語言模型背后的設計、局限和演變。

如果想深入閱讀,建議參考上述論文中的參考文獻。或者,這里有一些額外的資源,供讀者進一步研究:

GPT的開源替代方案

- 論文1:《BLOOM: A 176B-Parameter Open-Access Multilingual Language Model》

- 論文地址:https://arxiv.org/abs/2211.05100

- 論文2:《OPT: Open Pre-trained Transformer Language Models》

- 論文地址:https://arxiv.org/abs/2205.01068

ChatGPT的替代方案

- 論文1《LaMDA: Language Models for Dialog Applications》

- 論文地址:https://arxiv.org/abs/2201.08239

- 論文2:《Improving alignment of dialogue agents via targeted human judgements》

- 論文地址:https://arxiv.org/abs/2209.14375

- 論文3:《BlenderBot 3: a deployed conversational agent that continually learns to responsibly engage》

- 論文地址:https://arxiv.org/abs/2208.03188

計算生物學中的大型語言模型

- 論文1:《 ProtTrans: Towards Cracking the Language of Life’s Code Through Self-Supervised Learning 》

- 論文地址:https://arxiv.org/abs/2007.06225

- 論文2:《Highly accurate protein structure prediction with AlphaFold》

- 論文地址:https://www.nature.com/articles/s41586-021-03819-2

- 論文3:《Large Language Models Generate Functional Protein Sequences Across Diverse Families》

- 論文地址:https://www.nature.com/articles/s41587-022-01618-2