一句話為視頻加特效;迄今為止最全昆蟲大腦圖譜

目錄:

- Composer: Creative and Controllable Image Synthesis with Composable Conditions

- Structure and Content-Guided Video Synthesis with Diffusion Models

- The connectome of an insect brain

- Uncertainty-driven dynamics for active learning of interatomic potentials

- Combinatorial synthesis for AI-driven materials discovery

- Masked Images Are Counterfactual Samples for Robust Fine-tuning

- One Transformer Fits All Distributions in Multi-Modal Diffusion at Scale

- ArXiv Weekly Radiostation:NLP、CV、ML 更多精選論文(附音頻)

論文 1:Composer: Creative and Controllable Image Synthesis with Composable Conditions

- 作者:Lianghua Huang 等

- 論文地址:https://arxiv.org/pdf/2302.09778v2.pdf

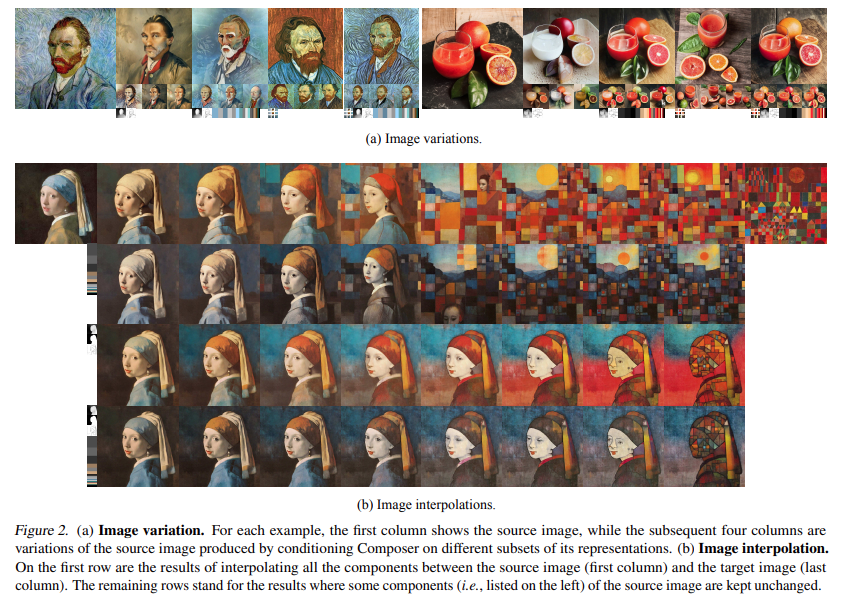

摘要:在 AI 繪畫領域,很多研究者都在致力于提升 AI 繪畫模型的可控性,即讓模型生成的圖像更加符合人類要求。前段時間,一個名為 ControlNet 的模型將這種可控性推上了新的高峰。大約在同一時間,來自阿里巴巴和螞蟻集團的研究者也在同一領域做出了成果,本文是這一成果的詳細介紹。

推薦:AI 繪畫新思路:國產開源 50 億參數新模型,合成可控性、質量實現飛躍。

論文 2:Structure and Content-Guided Video Synthesis with Diffusion Models

- 作者:Patrick Esser 等

- 論文地址:https://arxiv.org/pdf/2302.03011.pdf

摘要:相信很多人已經領會過生成式 AI 技術的魅力,特別是在經歷了 2022 年的 AIGC 爆發之后。以 Stable Diffusion 為代表的文本到圖像生成技術一度風靡全球,無數用戶涌入,借助 AI 之筆表達自己的藝術想象……

相比于圖像編輯,視頻編輯是一個更具有挑戰性的議題,它需要合成新的動作,而不僅僅是修改視覺外觀,此外還需要保持時間上的一致性。在這條賽道上探索的公司也不少。前段時間,谷歌發布的 Dreamix 以將文本條件視頻擴散模型(video diffusion model, VDM)應用于視頻編輯。

近日,曾參與創建 Stable Diffusion 的 Runway 公司推出了一個新的人工智能模型「Gen-1」,該模型通過應用文本 prompt 或參考圖像指定的任何風格,可將現有視頻轉化為新視頻。比如將「街道上的人」變成「粘土木偶」,只需要一行 prompt。

推薦:加特技只需一句話 or 一張圖,Stable Diffusion 的公司把 AIGC 玩出了新花樣。

論文 3:The connectome of an insect brain

- 作者:MICHAEL WINDING 等

- 論文地址:https://www.science.org/doi/10.1126/science.add9330

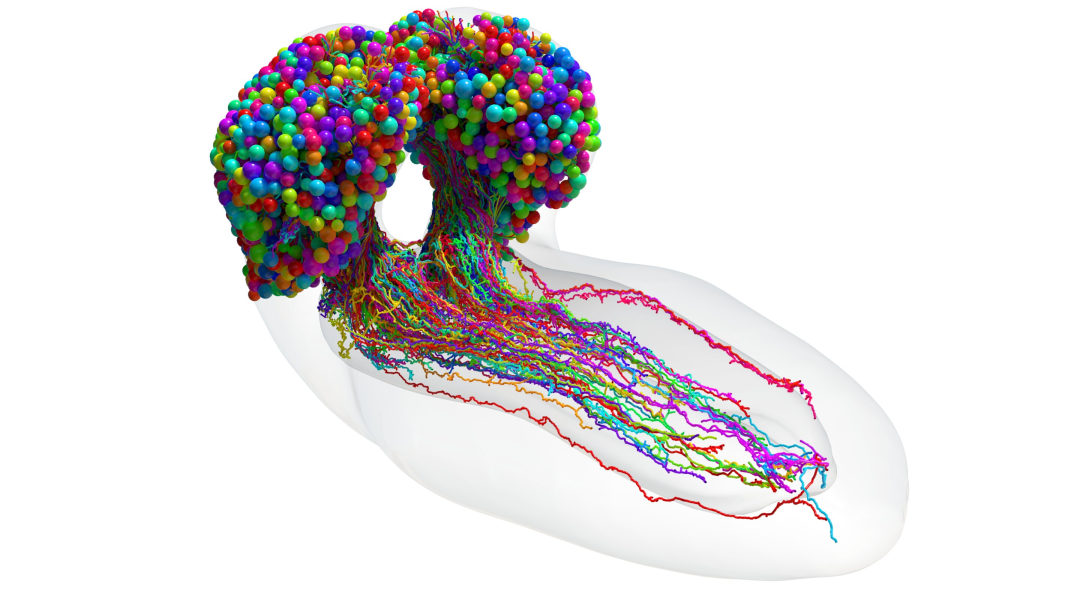

摘要:研究人員完成了迄今為止最先進的昆蟲大腦圖譜,這是神經科學領域的一項里程碑式成就,使科學家更接近對思維機制的真正理解。

由約翰斯?霍普金斯大學和劍橋大學領導的國際團隊制作了一張驚人的詳細圖譜,描繪了果蠅幼蟲大腦中的每一個神經連接,這是一個與人類大腦相當的原型科學模型。該研究可能會支持未來的大腦研究并激發新的機器學習架構。

推薦:迄今為止最全昆蟲大腦圖譜,可能激發新的機器學習架構。

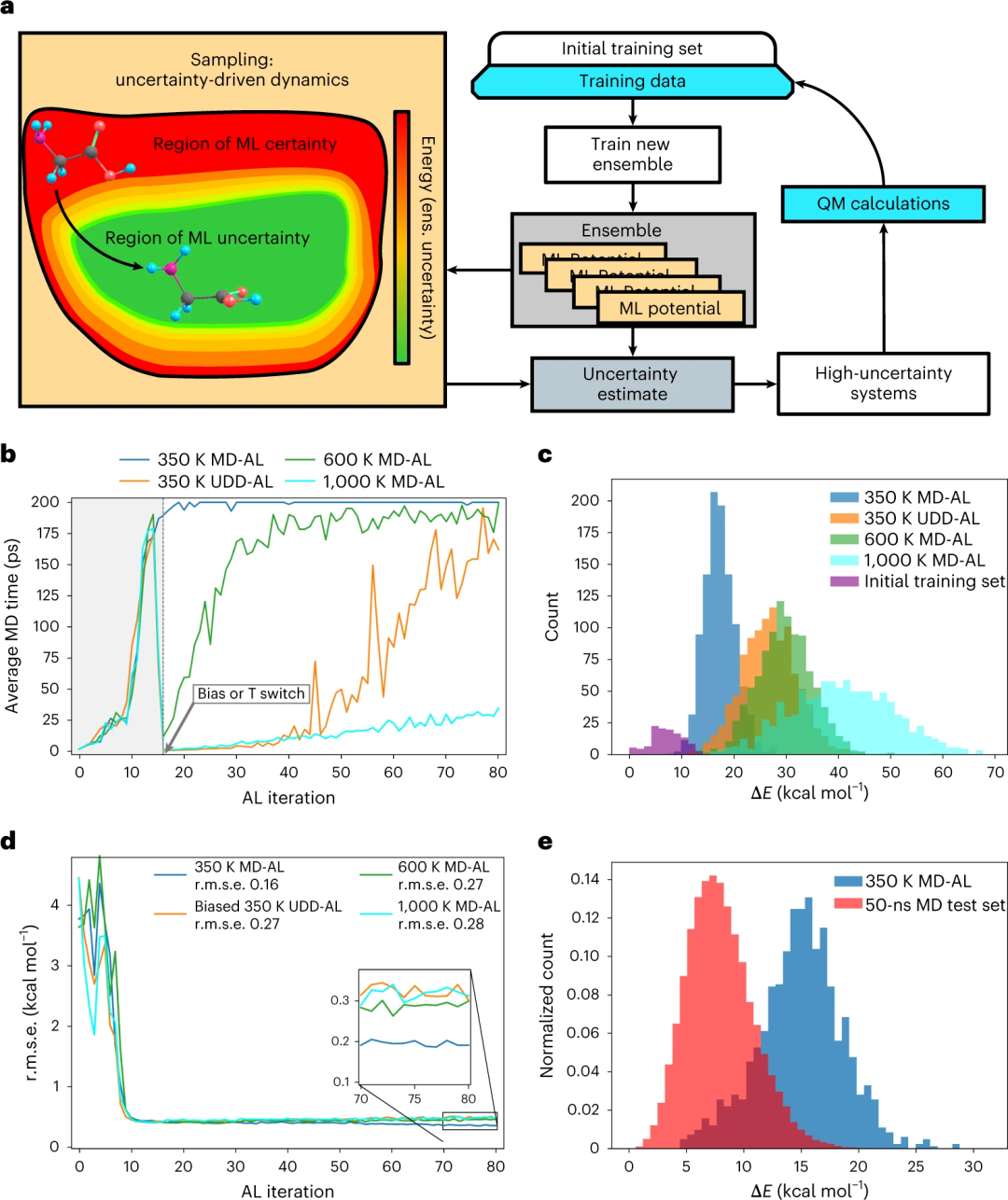

論文 4:Uncertainty-driven dynamics for active learning of interatomic potentials

- 作者:Maksim Kulichenko 等

- 論文地址:https://www.nature.com/articles/s43588-023-00406-5

摘要:機器學習 (ML) 模型,如果針對高保真量子模擬的數據集進行訓練,可以產生準確高效的原子間勢。主動學習 (AL) 是迭代生成不同數據集的強大工具。在這種方法中,ML 模型提供了不確定性估計及其對每個新原子構型的預測。如果不確定性估計超過某個閾值,則該構型將包含在數據集中。

近日,來自美國洛斯阿拉莫斯國家實驗室的研究人員制定了一種策略:主動學習的不確定性驅動動力學 (UDD-AL),以更快地發現有意義地擴充訓練數據集的構型。UDD-AL 修改了分子動力學模擬中使用的勢能面,以支持存在較大模型不確定性的構型空間區域。UDD-AL 的性能在兩個 AL 任務中得到了證明。下圖為甘氨酸測試用例的 UDD-AL 和 MD-AL 方法比較。

推薦:Nature 子刊 | 不確定性驅動、用于主動學習的動力學用于自動采樣。

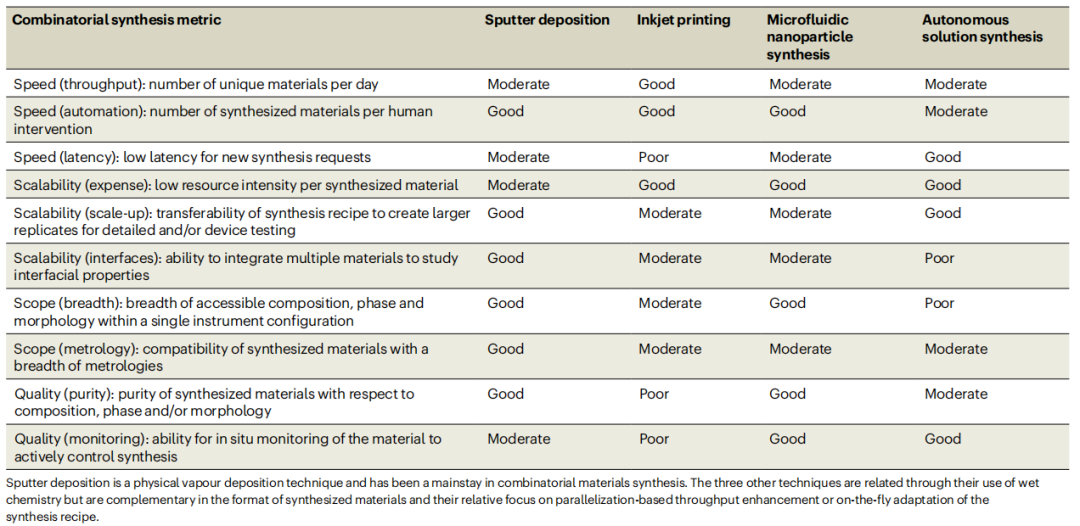

論文 5:Combinatorial synthesis for AI-driven materials discovery

- 作者:John M. Gregoire 等

- 論文地址:https://www.nature.com/articles/s44160-023-00251-4

摘要:合成是固態材料實驗的基石,任何合成技術必然涉及改變一些合成參數,最常見的是成分和退火溫度。「組合合成」通常是指自動化 / 并行化材料合成,以創建具有一個或多個合成參數系統變化的材料集合。人工智能控制的實驗工作流程對組合合成提出了新的要求。

在此,加州理工學院的研究人員概述了組合合成,設想了由組合合成和 AI 技術的共同開發推動的加速材料科學的未來。并建立了評估不同技術之間權衡的十個指標,涵蓋速度、可擴展性、范圍和質量。這些指標有助于評估一項技術對給定工作流程的適用性,并說明組合合成的進步將如何開創加速材料科學的新時代。如下為組合合成平臺的合成指標和各自評價。

推薦:Nature Synthesis 綜述:人工智能驅動材料發現的組合合成。

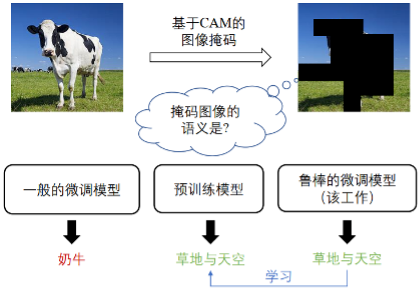

論文 6:Masked Images Are Counterfactual Samples for Robust Fine-tuning

- 作者:Yao Xiao 等

- 論文地址:https://arxiv.org/abs/2303.03052

摘要:中山大學人機物智能融合實驗室(HCP)在 AIGC 及多模態大模型方面成果豐碩,在近期的 AAAI 2023、CVPR 2023 先后入選了十余篇,位列全球研究機構的第一梯隊。其中一個工作實現了用因果模型來顯著提升多模態大模型在調優中的可控及泛化性 ——《Masked Images Are Counterfactual Samples for Robust Fine-tuning》。

推薦:中山大學 HCP 實驗室新突破:用因果范式再升級多模態大模型。

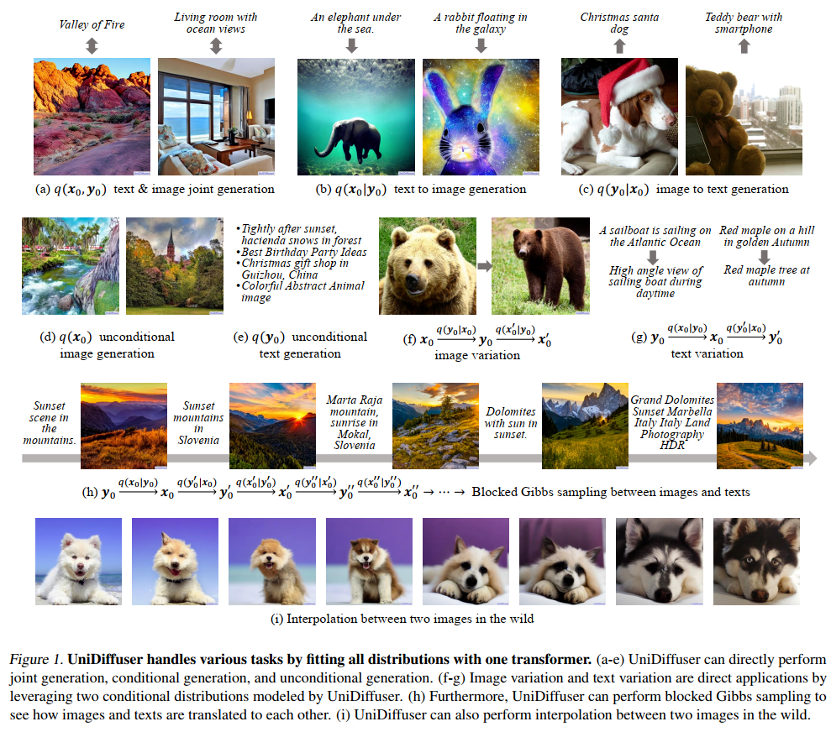

論文 7:One Transformer Fits All Distributions in Multi-Modal Diffusion at Scale

- 作者:Fan Bao 等

- 論文地址:https://ml.cs.tsinghua.edu.cn/diffusion/unidiffuser.pdf

摘要:該論文提出了一個為多模態設計的概率建模框架 UniDiffuser,并采用該團隊提出的基于 transformer 的網絡架構 U-ViT,在開源的大規模圖文數據集 LAION-5B 上訓練了一個十億參數量的模型,使得一個底層模型能夠高質量地完成多種生成任務(圖 1)。簡單來講,除了單向的文生圖,還能實現圖生文、圖文聯合生成、無條件圖文生成、圖文改寫等多種功能,大幅提升文圖內容的生產效率,也進一步提升了生成式模型的應用想象力。

推薦:清華朱軍團隊開源首個基于 Transformer 的多模態擴散大模型,文圖互生、改寫全拿下。

ArXiv Weekly Radiostation

機器之心聯合由楚航、羅若天、梅洪源發起的ArXiv Weekly Radiostation,在 7 Papers 的基礎上,精選本周更多重要論文,包括NLP、CV、ML領域各10篇精選,并提供音頻形式的論文摘要簡介。

本周 10 篇 NLP 精選論文是:

1. GLEN: General-Purpose Event Detection for Thousands of Types. (from Martha Palmer, Jiawei Han)

2. An Overview on Language Models: Recent Developments and Outlook. (from C.-C. Jay Kuo)

3. Learning Cross-lingual Visual Speech Representations. (from Maja Pantic)

4. Translating Radiology Reports into Plain Language using ChatGPT and GPT-4 with Prompt Learning: Promising Results, Limitations, and Potential. (from Ge Wang)

5. A Picture is Worth a Thousand Words: Language Models Plan from Pixels. (from Honglak Lee)

6. Do Transformers Parse while Predicting the Masked Word?. (from Sanjeev Arora)

7. The Learnability of In-Context Learning. (from Amnon Shashua)

8. Is In-hospital Meta-information Useful for Abstractive Discharge Summary Generation?. (from Yuji Matsumoto)

9. ChatGPT Participates in a Computer Science Exam. (from Ulrike von Luxburg)

10. Team SheffieldVeraAI at SemEval-2023 Task 3: Mono and multilingual approaches for news genre, topic and persuasion technique classification. (from Kalina Bontcheva)

本周 10 篇 CV 精選論文是:

1. From Local Binary Patterns to Pixel Difference Networks for Efficient Visual Representation Learning. (from Matti Pietik?inen, Li Liu)

2. Category-Level Multi-Part Multi-Joint 3D Shape Assembly. (from Wojciech Matusik, Leonidas Guibas)

3. PartNeRF: Generating Part-Aware Editable 3D Shapes without 3D Supervision. (from Leonidas Guibas)

4. Exploring Recurrent Long-term Temporal Fusion for Multi-view 3D Perception. (from Xiangyu Zhang)

5. Grab What You Need: Rethinking Complex Table Structure Recognition with Flexible Components Deliberation. (from Bing Liu)

6. Unified Visual Relationship Detection with Vision and Language Models. (from Ming-Hsuan Yang)

7. Contrastive Semi-supervised Learning for Underwater Image Restoration via Reliable Bank. (from Huan Liu)

8. InstMove: Instance Motion for Object-centric Video Segmentation. (from Xiang Bai, Alan Yuille)

9. ViTO: Vision Transformer-Operator. (from George Em Karniadakis)

10. A Simple Framework for Open-Vocabulary Segmentation and Detection. (from Jianfeng Gao, Lei Zhang)

本周 10 篇 ML 精選論文是:

1. Generalizing and Decoupling Neural Collapse via Hyperspherical Uniformity Gap. (from Bernhard Sch?lkopf)

2. AutoTransfer: AutoML with Knowledge Transfer -- An Application to Graph Neural Networks. (from Jure Leskovec)

3. Relational Multi-Task Learning: Modeling Relations between Data and Tasks. (from Jure Leskovec)

4. Interpretable Outlier Summarization. (from Samuel Madden)

5. Visual Prompt Based Personalized Federated Learning. (from Dacheng Tao)

6. Interpretable Joint Event-Particle Reconstruction for Neutrino Physics at NOvA with Sparse CNNs and Transformers. (from Pierre Baldi)

7. FedLP: Layer-wise Pruning Mechanism for Communication-Computation Efficient Federated Learning. (from Fei Wang, Khaled B. Letaief)

8. Traffic4cast at NeurIPS 2022 -- Predict Dynamics along Graph Edges from Sparse Node Data: Whole City Traffic and ETA from Stationary Vehicle Detectors. (from Sepp Hochreiter)

9. Achieving a Better Stability-Plasticity Trade-off via Auxiliary Networks in Continual Learning. (from Thomas Hofmann)

10. Steering Prototype with Prompt-tuning for Rehearsal-free Continual Learning. (from Dimitris N. Metaxas)