網(wǎng)暴又奪生命!用AI打擊鍵盤俠和網(wǎng)絡噴子,能否拯救被網(wǎng)暴者的命運?

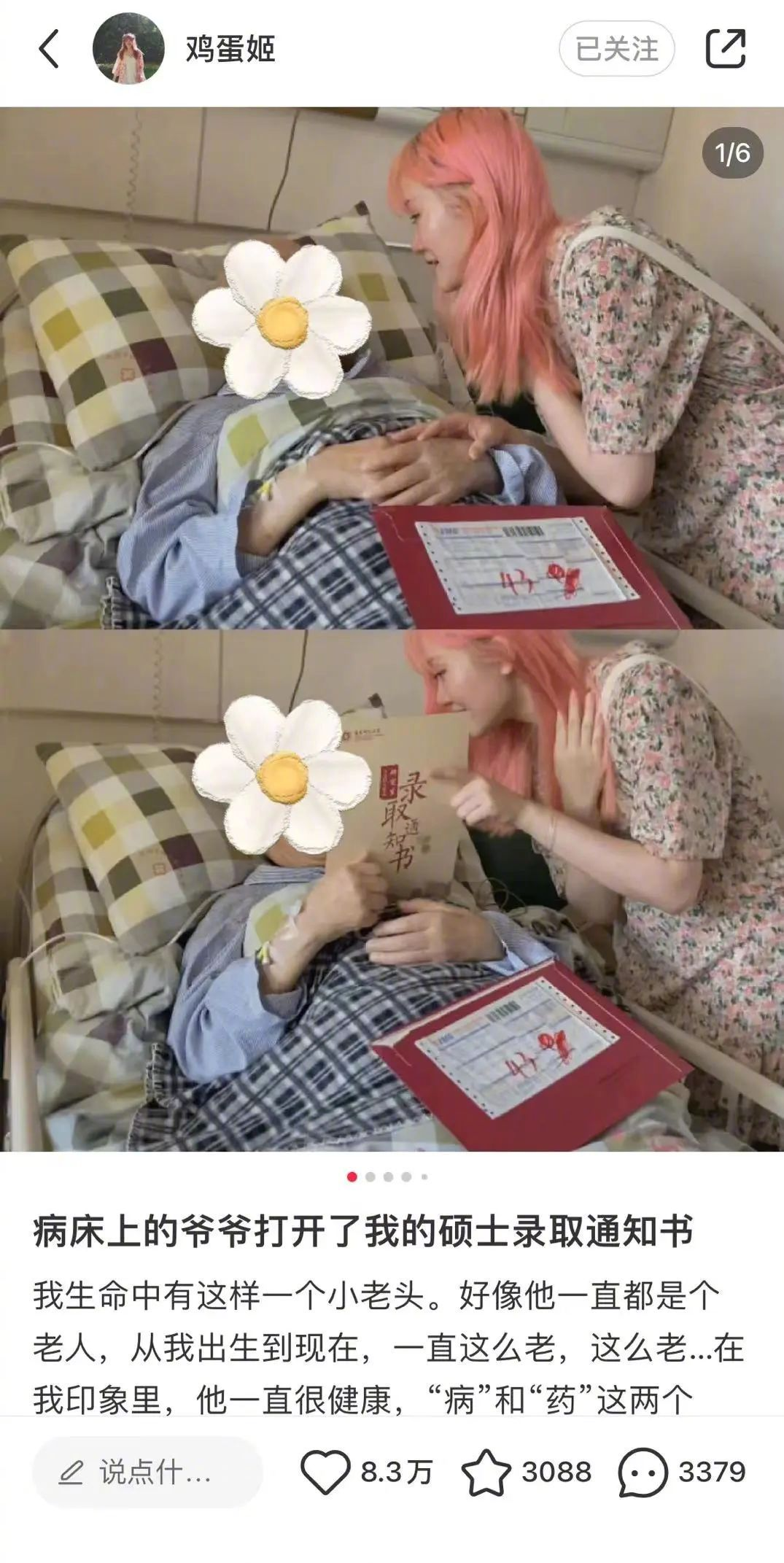

?一個95后女生自殺了,起因只是在網(wǎng)上發(fā)布了這么一篇博文。

這篇充滿溫情的博文發(fā)布后,主人公鄭靈華卻遭遇到了大量的造謠和謾罵。

有人質(zhì)疑她的身份,造謠說她是“陪酒女”,只是因為她的頭發(fā)是粉色的;有人造謠她是“老少戀”、“恰流量”、“騙子精”,造謠她利用爺爺?shù)牟赍X。

如是總總,不堪入目。盡管很多媒體對謠言進行了辟謠,但是鄭靈華沒有收到道歉,甚至鄭靈華在拿起法律武器維權的時候,依然受到騷擾。

最終,鄭靈華患上抑郁癥,不久前結(jié)束了自己的生命。

這樣的事情在互聯(lián)網(wǎng)上發(fā)生過很多次,這種彌漫在網(wǎng)絡世界的“人言可畏”不僅讓人觀感惡心,甚至能奪取人們的生命,這樣的行為也有個專門的名詞——網(wǎng)絡暴力,簡稱“網(wǎng)暴”。

那么在AI已經(jīng)可以和人類對答如流的今天,AI是否可以在識別網(wǎng)暴行為中發(fā)揮作用呢?

突破兩大難點,識別網(wǎng)暴言論準確率超90%

盡管大部分互聯(lián)網(wǎng)平臺都已經(jīng)上線了一些識別特別言論的系統(tǒng),但是這些系統(tǒng)大多只是針對關鍵的詞進行檢測和刪除,顯然是不夠智能的,稍加注意就能繞開這些限制。

事實上,準確識別網(wǎng)暴言論,需要做到兩點:

- 如何聯(lián)系上下文準確識別網(wǎng)暴言論?

- 如何高效識別網(wǎng)暴言論?

第一點關注的是網(wǎng)暴言論的內(nèi)容,因為網(wǎng)絡上大部分信件和留言都是分段的,往往是在對話中,網(wǎng)暴行為逐漸變得嚴重,最終釀成惡果。

第二點關注的是速度,畢竟互聯(lián)網(wǎng)環(huán)境下,要處理的數(shù)據(jù)太多了,如果檢測需要很久,那么這個系統(tǒng)將毫無實際價值,也不會得到采用。

英國的一組研究人員開發(fā)了一種新的人工智能模型,稱為 BiCapsHate,它克服了這兩個挑戰(zhàn),研究結(jié)果1月19日發(fā)表在《IEEE Transactions on Computational Social Systems》上的一項論文中。

該模型由五層深層神經(jīng)網(wǎng)絡組成,它從一個輸入層開始,處理輸入文本,然后到一個 embedding 層,將文本嵌入到一個數(shù)字表示中,然后是 BiCaps 層學習順序和語言上下文表示,dense層為最終分類準備模型,最后輸出層輸出結(jié)果。

BiCaps 層是最重要的組成部分,它通過膠囊網(wǎng)絡(capsule networks)有效地獲取輸入文本前后方向不同方向的上下文信息。得益于豐富的手工調(diào)試的淺層和深層輔助功能(包括Hatebase詞典),使模型信息更加豐富。研究人員在五個基準數(shù)據(jù)集上進行了廣泛的實驗,以證明所提出的BiCapsHate模型的有效性。總體結(jié)果顯示,BiCapsHate優(yōu)于現(xiàn)有的最先進的方法,包括fBERT, HateBERT和ToxicBERT。

在平衡和非平衡數(shù)據(jù)集上,BiCapsHate分別達到94%和92% f-score的準確率。

速度快,可以在GPU運行

塔里克 · 安瓦爾(Tarique Anwar)是約克大學計算機科學系的講師,他參與了這項研究。他指出,網(wǎng)上的爭論往往會導致負面的、可恨的和辱罵性的“網(wǎng)暴”評論,而現(xiàn)有的社交媒體平臺的內(nèi)容審查做法無法控制這種情況。

他說:“此外,網(wǎng)上仇恨言論有時會映射現(xiàn)實環(huán)境,導致犯罪和暴力行為。”,塔里克 · 安瓦爾也表示,網(wǎng)上仇恨言論導致身體暴力和暴亂的例子有好幾次。

為了幫助解決這個問題,塔里克 · 安瓦爾的團隊決定開發(fā) BiCapsHate,并且取得了非常好的效果。

正如安瓦爾指出的那樣,語言在某些情況下可能是模棱兩可的,即一個詞在一種語境中可能是正面的,而在另一種語境中可能是就是負面的。此前的模型在這方面都不夠優(yōu)秀,如 HateBERT、 toxicBERT 和 fBERT,這些人工智能能夠在一定程度上捕捉上下文,但是塔里克 · 安瓦爾認為“這些仍然不夠好”。

BiCapsHate 的另一個優(yōu)點是該模型能夠使用有限的硬件資源執(zhí)行計算。“(其他模型)需要像 GPU 這樣的高端硬件資源,以及用于計算的高端系統(tǒng),”塔里克 · 安瓦爾解釋說。“相反,BiCapsHate……可以在 CPU 機器上執(zhí)行,即使你只有8GB的內(nèi)存。”

值得注意的是,到目前為止,該人工智能已經(jīng)被開發(fā)和測試,僅用于分析英語言論,因此它將需要被改編為其他語言。與更激烈的仇恨言論相比,它也不太善于發(fā)現(xiàn)帶有溫和或微妙的仇恨語氣的攻擊性詞語。

研究人員希望下一步能夠探索評估在線表達仇恨的用戶的心理健康狀況的方法。如果有人擔心這個人精神不穩(wěn)定,并且可能對現(xiàn)實世界中的人施加身體暴力,可以考慮早期干預來降低發(fā)生這種情況的可能性。?