開挖擴散模型小動作,生成圖像幾乎原版復制訓練數據,隱私要暴露了

去噪擴散模型是一類新興的生成神經網絡,通過迭代去噪過程從訓練分布中生成圖像。與之前的方法(如 GANs 和 VAEs)相比,這類擴散模型產生的樣本質量更高,且更容易擴展和控制。因此,經過快速發展,它們已經可以生成高分辨率圖像,而公眾也對諸如 DALL-E 2 這樣的大型模型產生了極大的興趣。

生成擴散模型的魅力在于它們合成新圖像的能力,從表面上看,這些圖像不同于訓練集中的任何東西。而事實上,過去大規模的訓練工作沒有發現過擬合會成為問題,隱私敏感領域的研究人員甚至建議可以用擴散模型來保護隱私,通過生成合成示例來生成真實圖像。這一系列的工作是在擴散模型沒有記憶和重新生成訓練數據的假設下進行的。而這樣做將違反所有的隱私保障,并滋生模型泛化和數字偽造方面的許多問題。

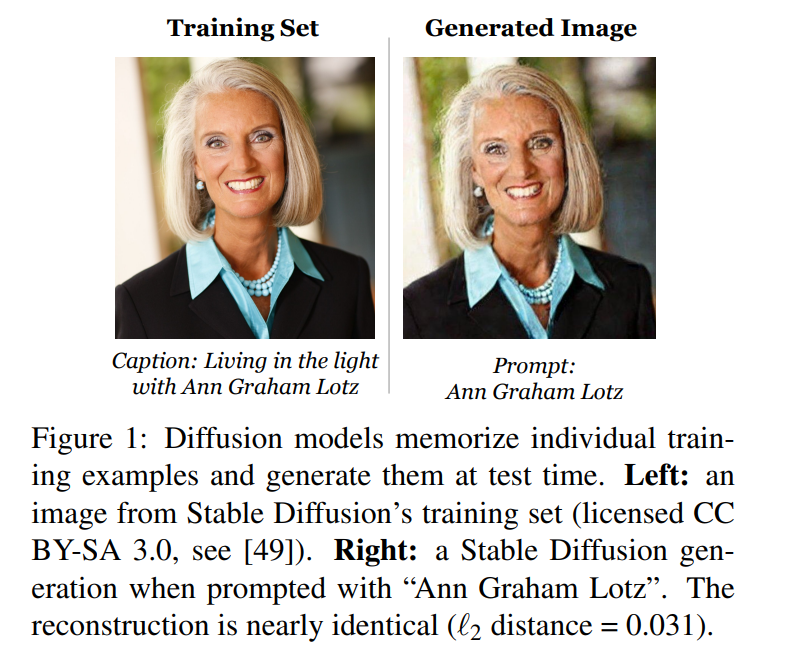

本文中,來自谷歌、 DeepMind 等機構的研究者證明了 SOTA 擴散模型確實可以記憶和重新生成單個訓練示例。

論文地址:https://arxiv.org/pdf/2301.13188v1.pdf

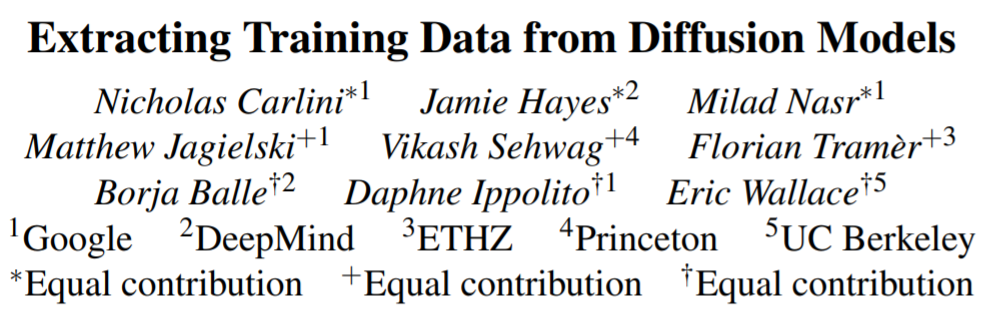

首先,研究提出并實現了圖像模型中記憶的新定義。然后,研究設計了分為兩階段的數據提取入侵(data extraction attack),使用標準方法生成圖像,并對一些圖像進行標記。研究將該方法應用于 Stable Diffusion 和 Imagen,從而提取了 100 多個幾乎相同的訓練圖像副本,這些圖像中,既有個人可識別照片也有商標 logo(如圖 1)。

為了更好地理解記憶的方式和其中的緣由,研究者在 CIFAR10 上訓練了數百個擴散模型,以分析模型精度、超參數、增強和重復數據刪除對隱私的影響。擴散模型是研究評估中私密度最低的圖像模型形式,它們泄漏的訓練數據是 GANs 的兩倍之多。更糟的是,研究還發現現有的隱私增強技術無法提供可接受的隱私 - 效用權衡。總的來說,本文強調了日益強大的生成模型和數據隱私之間存在著緊張的關系,并提出了關于擴散模型如何工作以及如何被妥善部署的問題。

為什么要做這項研究?

理解擴散模型如何記憶和重新生成訓練數據的背后存在著兩個動機。

第一個是了解隱私風險。重新生成從互聯網上抓取數據的擴散模型可能會帶來與語言模型類似的隱私和版權風險。比方說,已經有人指出,記憶和重新生成受版權保護的文本和源代碼存在著潛在的侵權指標。那么同理,復制專業藝術家創作的圖像也會被稱為數字偽造,藝術界為此展開了一場爭論。

第二個是理解泛化。除了數據隱私,理解擴散模型如何以及為什么記憶訓練數據有助于理解它們的泛化能力。例如,大規模生成模型的一個常見問題是,它們令人印象深刻的結果是來自真正的生成,還是直接復制和重新混合訓練數據的結果。通過研究記憶,可以提供生成模型執行這種數據復制速率的具體經驗描述。

從 SOTA 擴散模型中提取數據

從 Stable Diffusion 中提取數據

現在從 Stable Diffusion(最大、最流行的開源擴散模型)中提取訓練數據。

本次提取將先前工作的方法應用于圖像,包括兩個步驟:

1. 使用標準抽樣方式的擴散模型并使用前一節的已知 prompt 生成多個示例。

2. 進行推理,將新一代的模型與已記憶的訓練模型相分離。

為了評估入侵的有效性,研究從訓練數據集中選擇了 35 萬個重復次數最多的示例,并為每個提示生成 500 個候選圖像(總共生成 1.75 億張圖像)。

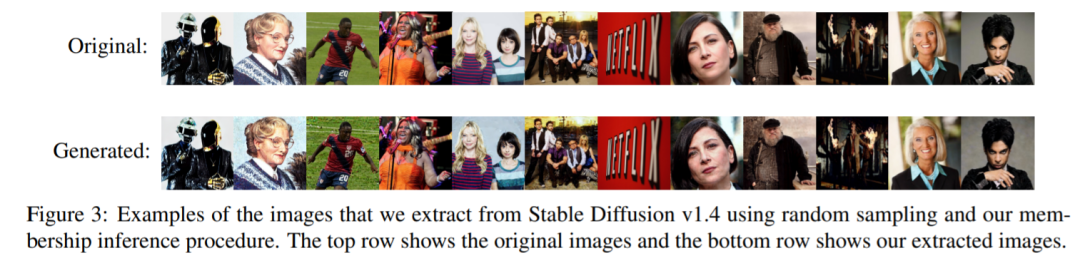

首先,研究對所有這些生成的圖像進行排序,以確定哪些是記憶訓練數據生成的圖像。然后,將這些生成的每張圖像與論文中定義 1 下的訓練圖像進行比較,并將每張圖像注釋為提取或未提取。研究發現有 94 張圖像被提取,為了確保這些圖像不僅是符合某些任意的定義,研究還通過視覺分析手動注釋了前 1000 張生成的圖像,這些圖像要么是記憶的,要么是沒有記憶的,并且發現另外 13 張(總共 109 張圖像)幾乎是訓練示例的副本,即使它們不符合研究 L_2 范數定義。圖 3 顯示了提取圖像的子集,這些圖像以近乎完美像素的精度再現。

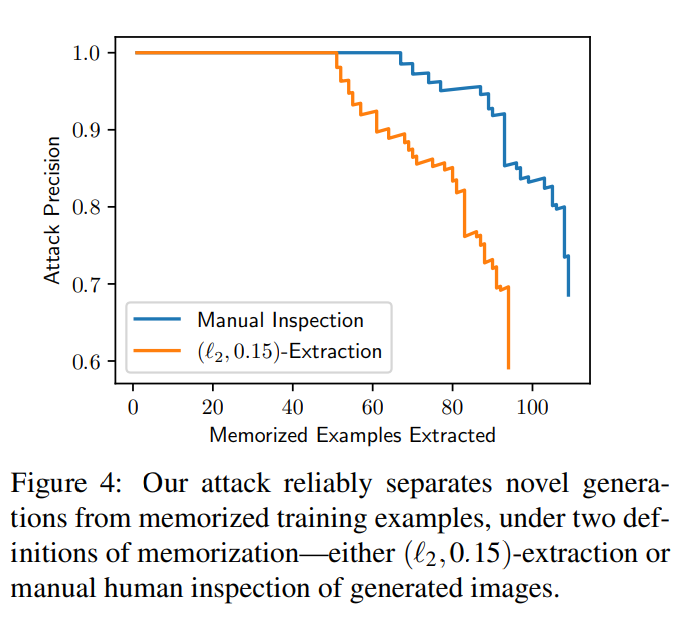

實驗還給出了在有給定帶注釋的有序圖像集的情況下,計算曲線,評估提取的圖像數量與入侵的假陽性率。入侵異常精確:在 1.75 億張生成的圖像中,可以識別出 50 張 0 假陽性的記憶圖像,并且所有的記憶圖像都可以以 50% 以上的精度提取。圖 4 包含了兩種記憶定義的精度 - 召回曲線。

從圖像中提取數據

盡管 Stable Diffusion 是目前公開可用的擴散模型中最佳選擇,但一些非公開模型使用更大的模型和數據集獲得了更強的性能。先前研究發現,較大的模型更容易記住訓練數據,因此該研究對 Imagen(一個 20 億參數的文本 - 圖像擴散模型)展開了研究。

令人驚訝的是,研究發現在 Imagen 中入侵非分布圖像比在 Stable Diffusion 中更有效。在 Imagen 上,研究嘗試提取出 500 張 out-of - distribution(OOD)得分最高的圖像。Imagen 記憶并復制了其中 3 個圖像(這三個圖像在訓練數據集中是獨有的)。相比之下,當研究將相同的方法應用于 Stable Diffusion 時,即使在嘗試提取 10,000 個最離群的樣本后,也未能識別任何記憶。因此,在復制和非復制圖像上,Imagen 比 Stable Diffusion 的私密性更差。這可能是由于 Imagen 使用的模型比 Stable Diffusion 更大,因此記得的圖像也就更多。此外,Imagen 在更小的數據集上進行了更多的迭代訓練,這也可以有助于提高記憶水平。