2022年最值得關注的十篇論文,你都看了嗎?來卷來學習

2022 年 1 月,擴散模型第一次吸引了我的眼球。當時我判斷到將會有某些大事發生,然而卻未曾預料到幾個月后會出現什么:DALLE-2、Imagen、Stable Diffusion 以及其它許多模型。

對于大型語言模型來說,2022 也是非常重要的一年,最近面世的 ChatGPT 更是錦上添花,搶盡了風頭。

在回顧今年發表的十篇值得關注的論文前,我們可以先看看 12 月的 AI 要聞以及麥肯錫的一份人工智能全景報告和行業調查綜述。

昨天,今天,明天?

簡單來說,有兩篇論文引起了我的注意。

第一篇:視覺 Transformer(ViT)學習什么?

論文鏈接:https://arxiv.org/pdf/2212.06727.pdf

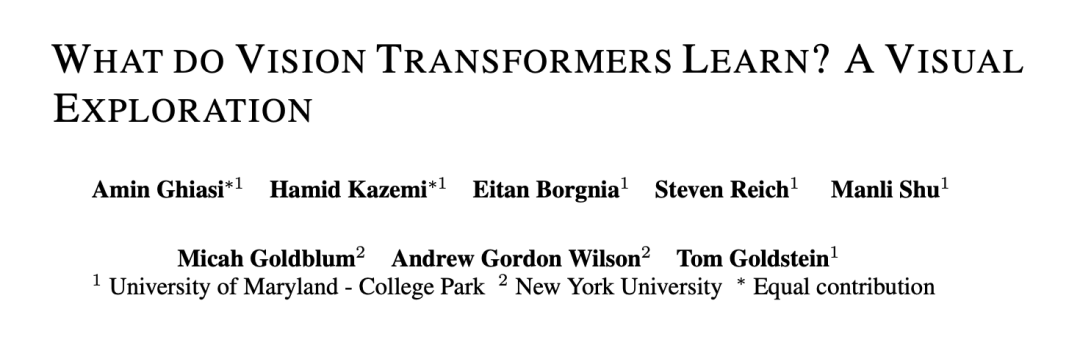

關于視覺的探索顯示,ViT 學習的歸納偏置或特征與卷積神經網絡(CNN)學習的那些相似。例如,ViT 的 early layers 捕捉邊緣和紋理,而 later layers 學習更復雜的表征以捕捉更廣泛的概念。

視覺 Transformer 從 early layers(左)到 deeper layers(右)的可視化特征過程。?

關于生成建模,ViT 傾向于生成比 CNN 更高質量的背景,這就提出了 ViT 如何處理預測任務中的背景和前景的這一問題。當背景被消除時,ViT 似乎比 CNN 更善于預測目標類別,并且在前景被消除時它們也依然表現得更好。這表明,ViT 在依賴基于其存在的某些特征時可能更具選擇性,或者說,總體更為魯棒。

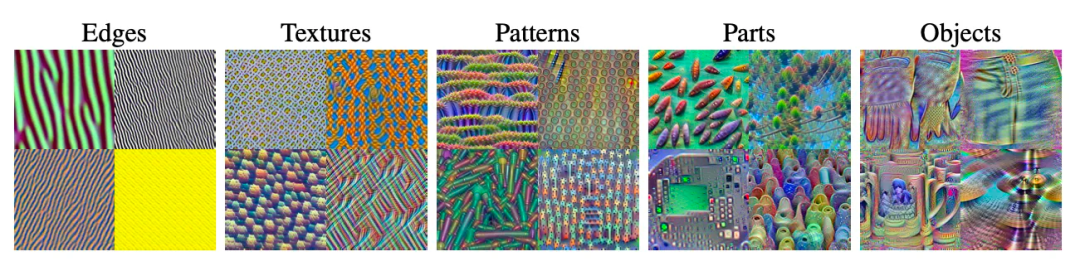

第二篇:一種生成蛋白質的擴散模型

論文鏈接:https://www.biorxiv.org/content/10.1101/2022.12.09.519842v1

在圖像生成領域,擴散模型已經帶來了突破性的性能,那么生成蛋白質結構呢?研究人員開發了一種新的蛋白質合成擴散模型,稱為 RoseTTAFold Diffusion(RFDiffusion),這種蛋白質是從零開始創造的,而非來自于自然界中早已存在的蛋白質。

區分 de novo 蛋白質(在實驗室中使用沒有進化歷史的氨基酸序列合成)與諸如 AlphaFold、 AlphaFold2 等系統(使用現有氨基酸序列數據預測蛋白質 3D 結構)十分重要。但值得注意的是,AlphaFold2 曾被用于驗證 RDiffusion 研究的結果。

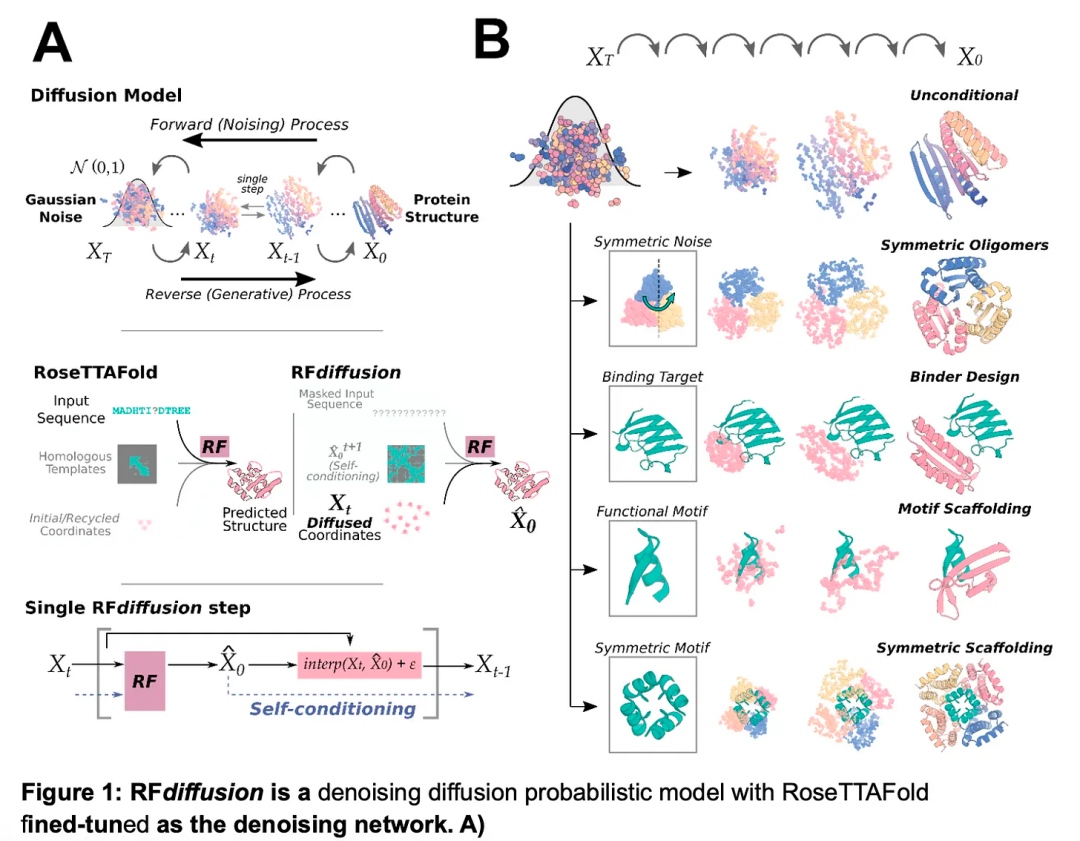

然后再談談最近的行業趨勢。今天,在產業中實際使用的技術是什么?根據麥肯錫最近的 AI 全景報告 —— 并不是大型語言模型(Transformer)。特別說明,由于樣本規模和代表性的限制,該報告中的調查結果可能無法準確反映所有公司的經驗。

圖源:麥肯錫 2022 年全景報告。?

自然語言處理在行業內一直受到追捧,但其受歡迎程度經常被計算機視覺應用超越。但現在,我們第一次看到計算機視覺和自然語言處理幾乎總是緊密聯系在一起。

與此同時,自然語言文本理解(可能指文本分類)的受歡迎程度幾乎是自然語言「生成」的兩倍。請注意,自然語言生成的新聞通常會占據熱點首頁:如 GPT-3、Galactica、ChatGPT 等。(文本理解可能包括摘要,摘要也是「生成」的,所以我假設它在這里主要指的是類似分類的任務。那么反過來說,類別(categories)也是可以重疊的。)

值得注意的是,Transformer 的排名墊底。

似乎許多公司尚未采用類似 BERT 的語言模型編碼器來進行文本理解和分類。相反,他們可能仍在使用基于詞袋模型( bag-of-word-based)的分類器或遞歸神經網絡。同樣,類似 GPT 的模型解碼器似乎還沒有廣泛應用于語言生成,因而文本生成可能仍嚴重依賴循環神經網絡和其他傳統方法。

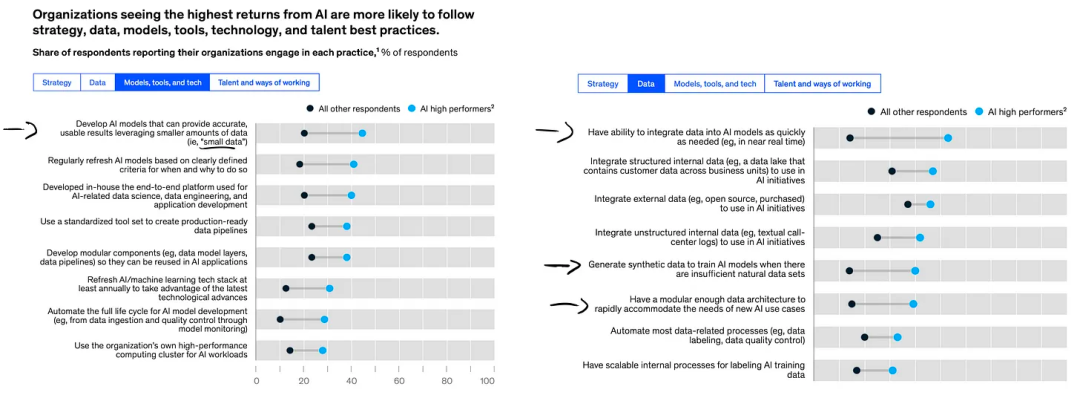

基于下圖,我發現了一些有趣的其他見解:

圖源:2022 年麥肯錫 AI 全景報告。

- 能夠利用「小數據」非常重要。當數據不可用時,生成合成數據的能力非常有用。

- 盡快將數據集成到 AI 模型中的能力是在競爭中脫穎而出的關鍵。那么,良好的軟件框架和基礎設備設置可能起到舉足輕重的作用。

- 不幸的是,大多數高績效公司迄今仍不關心模型的可解釋性。

十大年度論文?

以下將介紹我在 2022 年閱讀到的排名前三的論文。當然,今年發表的論文中還有很多其他主題是更令人興奮、永恒且具有影響力的。

2022 年,保持前三名的成績顯然具有挑戰性,因而下面還附了一個擴展列表,列出了我排名前十榜單中的其余七篇論文。

一、ConvNeXt

論文鏈接:https://arxiv.org/pdf/2201.03545.pdf

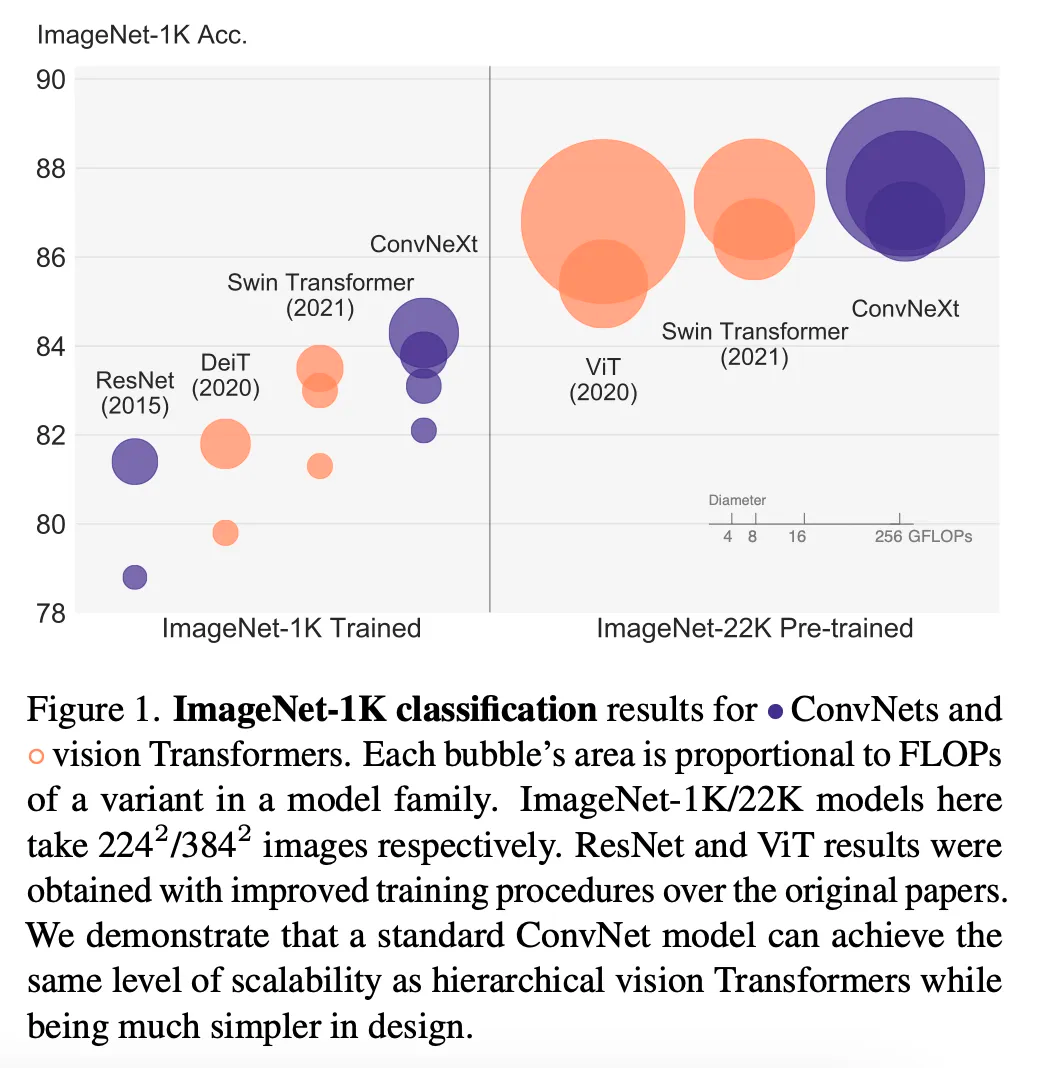

《A ConvNet for the 2020s》這篇論文我愿稱之為全年最佳,因為作者們能夠設計出一種純卷積架構,其性能優于諸如 Swin Transformer 等流行的視覺 Transformer(當然,也優于在它之前出現的所有卷積神經網絡)。

當卷積神經網絡不僅應用于分類,還用于目標檢測和實例分割時,這種所提到的 ConvNeXt 架構很可能成為新的默認架構 —— 例如,它可以用作 Mask R-CNN 的骨干網絡(backbone)。

正如作者們在論文中所述,他們受到了當前視覺 Transformer 訓練機制以及 Swin Transformer 混合架構表明卷積層仍然相關的事實啟發。這均是因為純視覺 Transformer 架構缺乏有用的歸納偏置,例如平移同變性和參數共享(即卷積中的「滑動窗口」)。

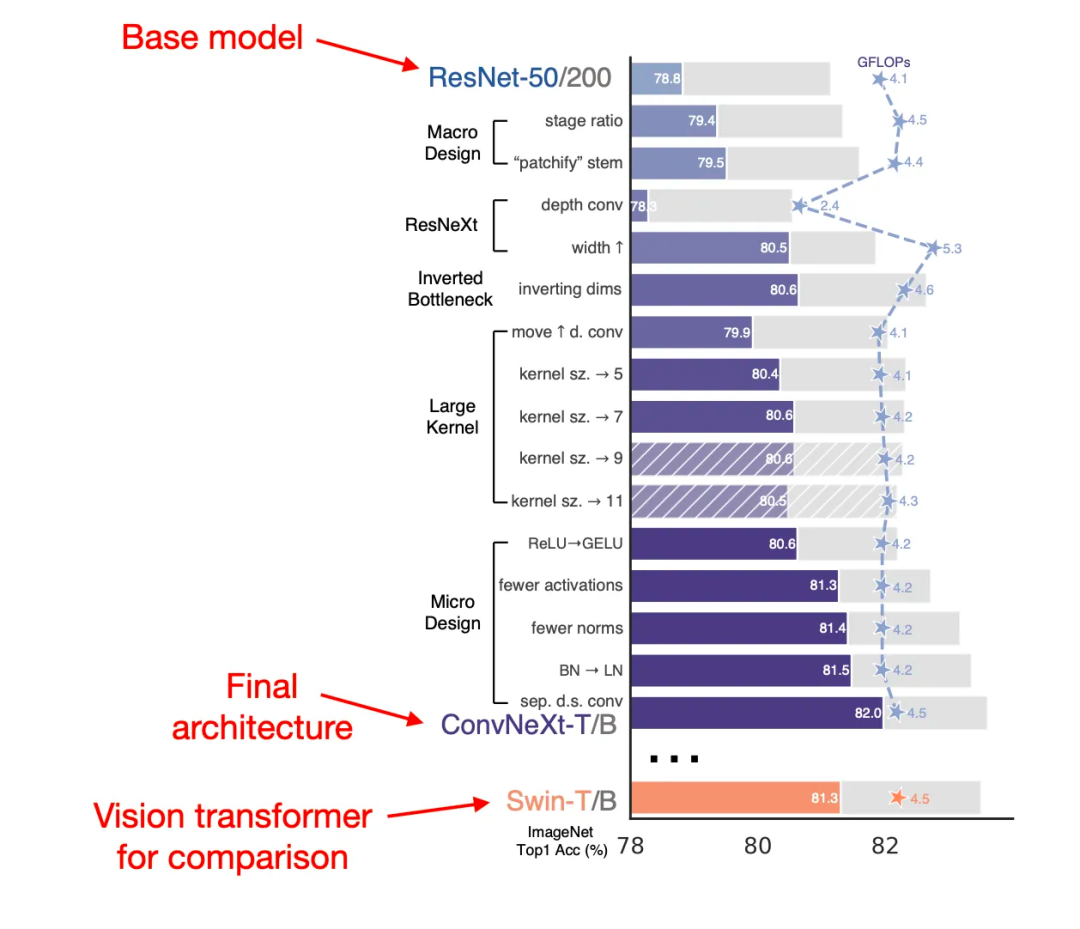

為了開發 ConvNeXt,作者們從 ResNet-50 基礎架構出發,并采用了從現代 ViT 訓練機制中運用的架構修改和訓練機制。即使是賦予在卷積神經網絡的背景,這些本來也沒什么新奇。然而,新穎之處卻在于作者們有效地使用、分析和組合了這些技術。

他們采用了哪些技術?這可以列一個很長的清單,包括深度卷積、反向瓶頸層設計、AdamW、LayerNorm 技術等等,具體的匯總你可以在下圖中找到。此外,作者還使用了數據增強技術,如 Mixup、Cutmix 等。

二、MaxViT

盡管隨著上述的 ConvNext 出世,卷積神經網絡再度受到歡迎,但目前來說 ViT 仍然搶盡風頭(并非刻意雙關)。

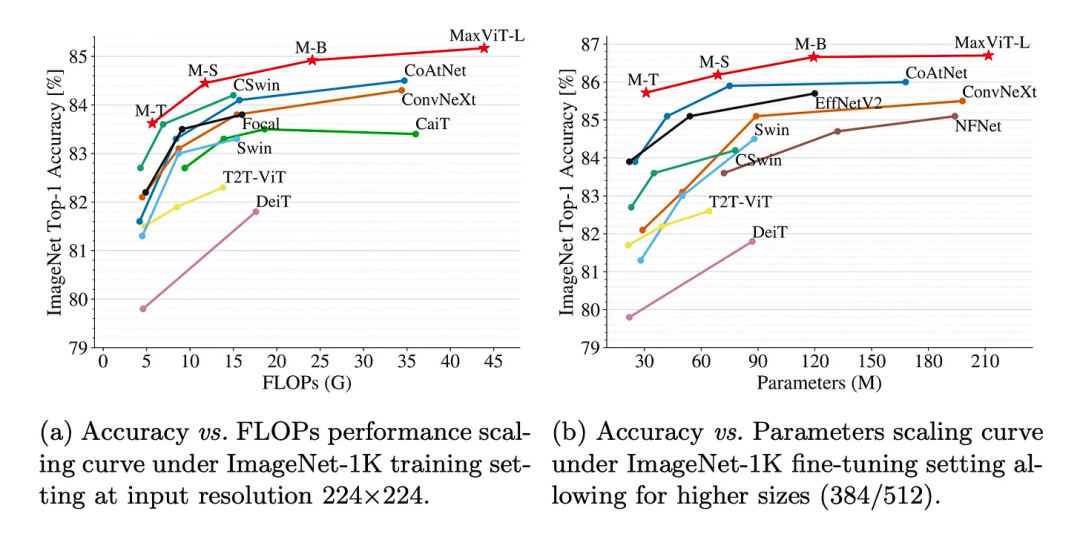

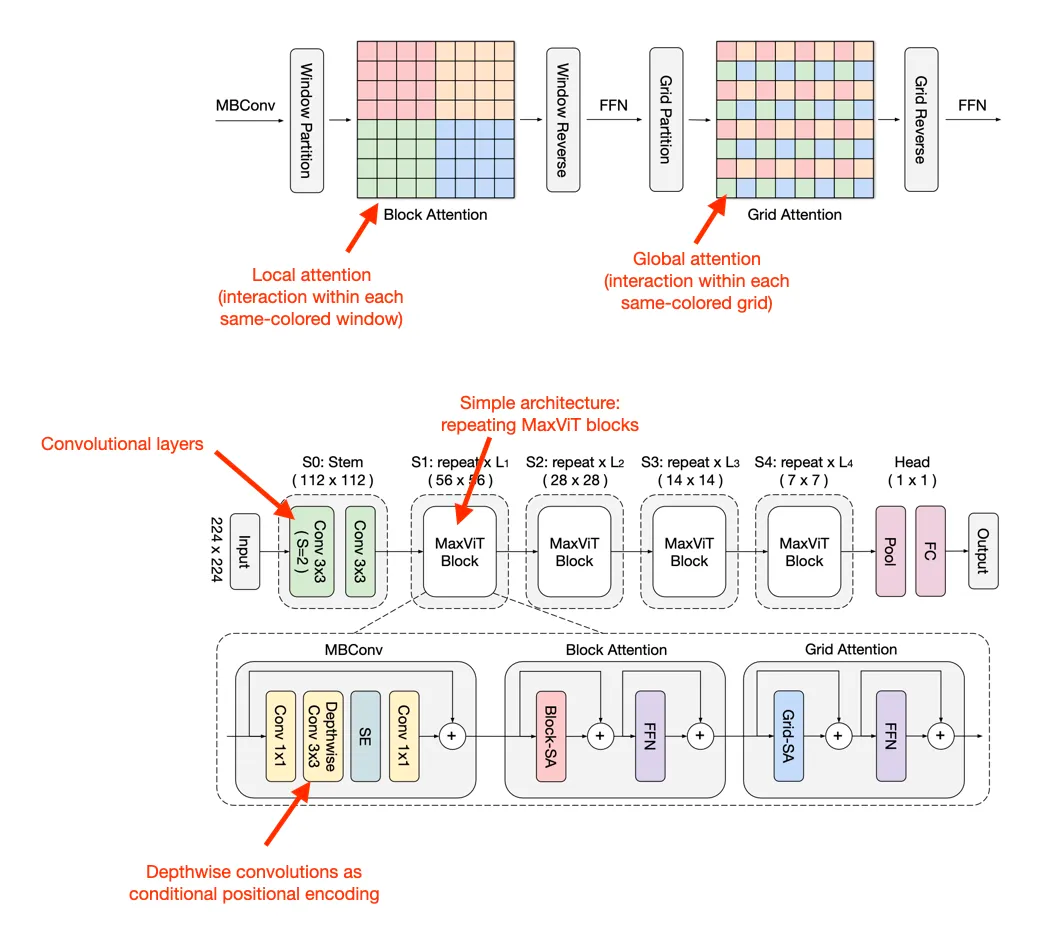

MaxViT:多軸視覺 Transformer 突出顯示了近年來視覺 Transformer 的發展。雖然早期的視覺 Transformer 具有二次復雜度,但已經可以通過許多手段來將視覺 Transformer 應用于具有線性縮放復雜度的更大圖像中。

2022 年 9 月發布的 MaxViT,目前是 ImageNet 基準測試中的 SOTA 模型。?

在 MaxViT 中,這是通過將注意力塊(attention block)分解為具有局部 - 全局交互的兩個部分來實現的:

- 局部注意力(「塊注意力」);

- 全局注意力(「網格注意力」)。

值得一提的是,MaxViT 是一種也具備卷積層特征的卷積 Transformer 混合模型。它可以用于預測建模(包括分類、目標檢測和實例分割)以及生成建模。

順便提一句,在谷歌學術上搜索「視覺 Transformer」,僅 2022 年就產出了 5000 多個結果。這個結果雖然可能包括誤報,但仍可表明人們對于視覺 Transformer 的廣泛歡迎程度和感興趣程度。

不過不用擔心,視覺 Transformer 不會完全取代我們喜愛的卷積神經網絡。相反,正如 MaxViT 所強調的,當前的趨勢是將視覺 Transformer 和卷積網絡一起整合到混合架構中。

三、Stable Diffusion

在 ChatGPT 成為最先進的模型之前,Stable Diffusion 早已在互聯網和社交媒體上普及。這個概念其實最早來源于 2021 年 12 月上傳的論文《High-Resolution Image Synthesis with Latent Diffusion Models》。

由于這篇論文在 2022 年 CVPR 會議上發表,并在 2022 年 8 月憑借 Stable Diffusion 受到高度關注,我認為將其列入 2022 年的 TOP3 論文名單是公平合理的。

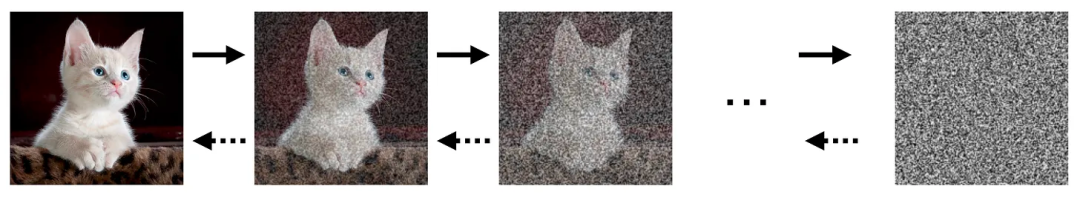

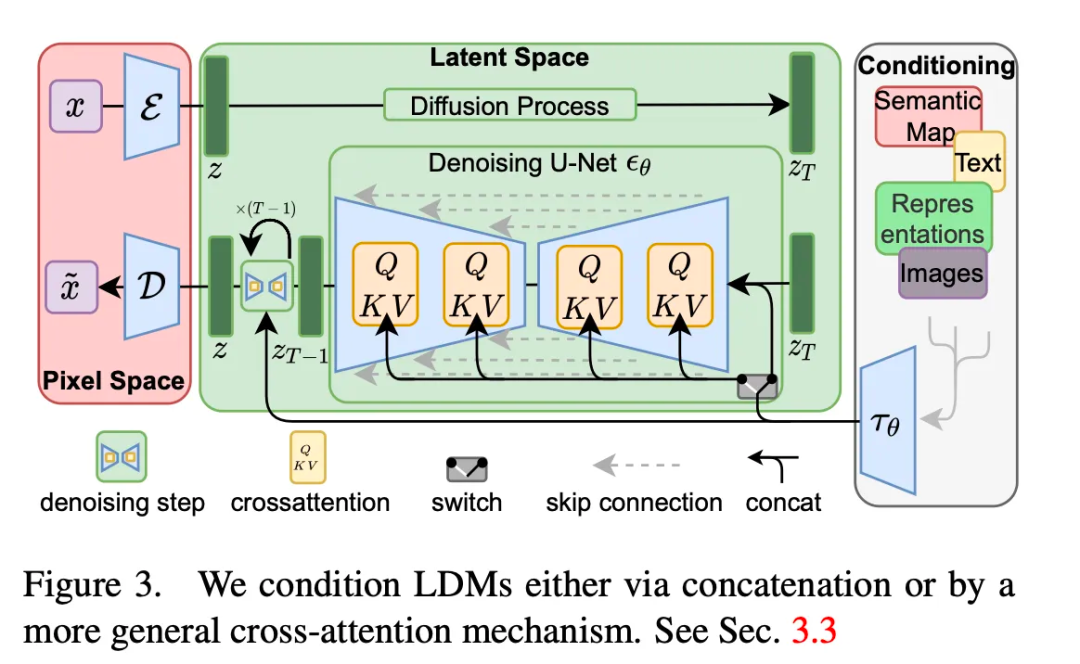

擴散模型是一種概率模型,被設計用于通過逐漸對正態分布變量進行去噪來學習數據集分布。這個過程對應于學習長度為 T 的固定的馬爾可夫鏈(Markov Chain)的逆過程。

擴散模型的圖示。?

與使用生成器 (Generator) 和鑒別器 (Discriminator) 之間的極大極小博弈(minimax game)訓練的 GAN 不同,擴散模型是使用最大似然估計(MLE)訓練的基于似然的模型。這有助于避免模式坍塌和其他訓練不穩定性。

擴散模型已經存在了一段時間,但眾所周知,在訓練和推理過程中,從中取樣仍非常昂貴。上述 2022 年論文的作者提到過,5 天的運行時間僅能采樣 50k 張圖像。

《High-Resolution Image Synthesis with Latent Diffusion Models》一文的新穎之處在于人們可以使用預訓練的自編碼器在潛在空間中應用擴散,而非直接使用原始圖像的全分辨率原始像素輸入空間。

?

?

上文提到的訓練過程可以分為兩個階段:首先,對自編碼器進行預處理,將輸入圖像編碼到較低維度的潛在空間中,以降低復雜性。第二,在預訓練的自動編碼器隱層表征上訓練擴散模型。

在潛在空間中進行運算,降低了用于訓練和推理的擴散模型的計算成本和復雜性,并可以生成高質量的結果。

本文的另一個貢獻是一般條件下的交叉注意力機制( cross-attention mechanism)。因此,除了無條件圖像生成之外,所提出的潛在擴散模型還能夠進行圖像修復、類條件圖像合成、超分辨率圖像重建以及文本到圖像合成 —— 后者正是 DALLE-2 和 Stable Diffusion 聞名的原因。

接下來介紹我的排名榜前十論文中后七篇論文的概述:

四、《「通才」智能體》(A Generalist Agent)。在本文中,研究人員介紹了 Gato,它能夠執行從玩游戲到控制機器人等 600 多種不同任務。

論文鏈接:https://arxiv.org/abs/2205.06175

五、《訓練最優計算的大型語言模型》(Training Compute-Optimal Large Language Models)。為了在訓練期間實現最優計算,研究人員認為通過相同的因子來縮放模型大小和訓練 token 的數量都很有必要。他們創建了一個名為 Chinchilla 的模型,例如,該模型的性能優于 Gopher,可以使用比 Gopher 四分之一的參數輸出四倍之多的數據。

論文鏈接:https://arxiv.org/abs/2203.15556

六、《PaLM:使用 Pathways 縮放語言模型》(PaLM: Scaling Language Modeling with Pathways):文中提出的 PaLM 模型在各種 BIG-bench 任務上都展示了令人驚嘆的自然語言理解和生成能力。在某種程度上,它甚至能識別出因果關系。

論文鏈接:https://arxiv.org/abs/2204.02311

七、《基于大規模弱監督方法的魯棒語音識別》(Robust Speech Recognition via Large-Scale Weak Supervision)。本文介紹了 Whisper 模型,該模型在多語言任務上接受了 68 萬小時的訓練,并表現出了對各種基準數據集(benchmarks)的魯棒泛化性。本文介紹的 Whisper 模型給我留下了深刻的印象。我用它來為我的兩門課程深度學習基礎 —— 運用現代開源棧學習深度學習以及深度學習引言(Deep Learning Fundamentals – Learning Deep Learning With a Modern Open Source Stack)生成字幕。

論文鏈接:https://arxiv.org/abs/2212.04356

八、《再論表格深度學習的預訓練目標》(Revisiting Pretraining Objectives for Tabular Deep Learning)。我喜歡閱讀大量有關 Tabular 數據的深度學習論文。但我尤其鐘愛這篇論文,因為它強調并提醒我們在附加(通常未標記)數據上進行模型預訓練是多么重要。(使用如 XGBoost 等基于樹模型無法輕松做到這一點。)

論文鏈接:https://arxiv.org/abs/2207.03208

九、《為什么基于樹的模型在表格數據上的性能仍然優于基于深度學習的模型?》 (??Why do tree-based models still outperform deep learning on tabular data???)。該文的主要收獲是基于樹的模型(隨機森林和 XGBoost)的性能優于在中型數據集(10k 訓練示例)上應用表格數據的深度學習方法。但是隨著數據集大小的增加(這里:10k → 50k),基于樹的模型和深度學習之間的差距變得越來越小。遺憾的是,這篇論文沒有包含特別多最先進的深度表格網絡,不過它進行了魯棒性分析和有趣的討論,絕對值得一讀。

論文鏈接:https://arxiv.org/abs/2207.08815

十、《用語言模型預測原子級蛋白質結構的進化程度》(Evolutionary-scale prediction of atomic level protein structure with a language model)。該論文提出了迄今為止預測蛋白質三維結構的最大語言模型,它也比以前的方法運算更快,同時還保持著同樣的準確性。該模型創建了 ESM 宏基因組圖譜,是宏基因組蛋白質的第一個大規模結構表征,具有超過 6.17 億個蛋白質結構。

論文鏈接:https://www.biorxiv.org/content/10.1101/2022.07.20.500902v3