摩爾定律失效怎么辦?神經形態計算專家:把重點變成樹突學習

?1965 年,戈登?摩爾歸納了一條經驗之談:集成電路上可以容納的晶體管數目大約每經過 18 個月到 24 個月就會增加一倍。換言之,處理器的性能大約每兩年翻一倍。

這條經驗之談被稱為「摩爾定律」,之后的四十年里,半導體芯片制造工藝確實以令人目眩的速度成倍提高。但近年來,摩爾定律的加倍效應已在放緩,甚至有人預言在不久的將來會失效。

業界紛紛提出各種方案應對這種發展瓶頸,來自斯坦福大學的神經形態工程師 Kwabena Boahen 最近提出了一種新思路:人工神經元應該模仿生物神經元的樹突,而非突觸。研究論文發表在《Nature》上。

論文地址:https://www.nature.com/articles/s41586-022-05340-6

當前,神經形態計算旨在通過模仿構成人腦的神經元和突觸的機制來實現人工智能(AI)。人工神經網絡反復調整連接神經元的突觸,以修改每個突觸的「權重」,即一個神經元對另一個神經元的影響強度,然后神經網絡確定由此產生的行為模式是否更善于找到解決方案。隨著時間的推移,系統會發現哪些模式最適合計算結果,并采用這些模式作為默認模式。

神經網絡通常包含很多層神經元,例如 GPT-3 擁有 1750 億個權重,連接相當于 830 萬個神經元,深度為 384 層。隨著神經網絡規模和功能的不斷增加,它們變得越來越昂貴和耗能。以 GPT-3 為例,OpenAI 花費 460 萬美元讓 9200 個 GPU 運行兩周來訓練這個大型模型。Kwabena Boahen 說:「GPT-3 在訓練期間消耗的能量轉化為碳排放相當于 1300 輛汽車。」

這也是 Boahen 提出神經網絡下一步應該嘗試數圖學習的重要原因。模仿神經網絡中的樹突將增加傳輸信號中傳達的信息量,讓 AI 系統不再需要 GPU 云中的兆瓦級功率,在手機等移動設備上就可以支持運行。

樹突可以大量分支,允許一個神經元與許多其他神經元連接。已有研究發現,樹突從其分支接收信號的順序決定了其響應的強度。

Boahen 提出的樹突計算模型只有在接收到來自神經元的精確序列信號時才會做出反應。這意味著每個樹突都可以編碼數據,而不僅僅是 0/1 這樣簡單的電信號。基礎系統將變得更加強大,這取決于它擁有的連接數量和接收到的信號序列的長度。

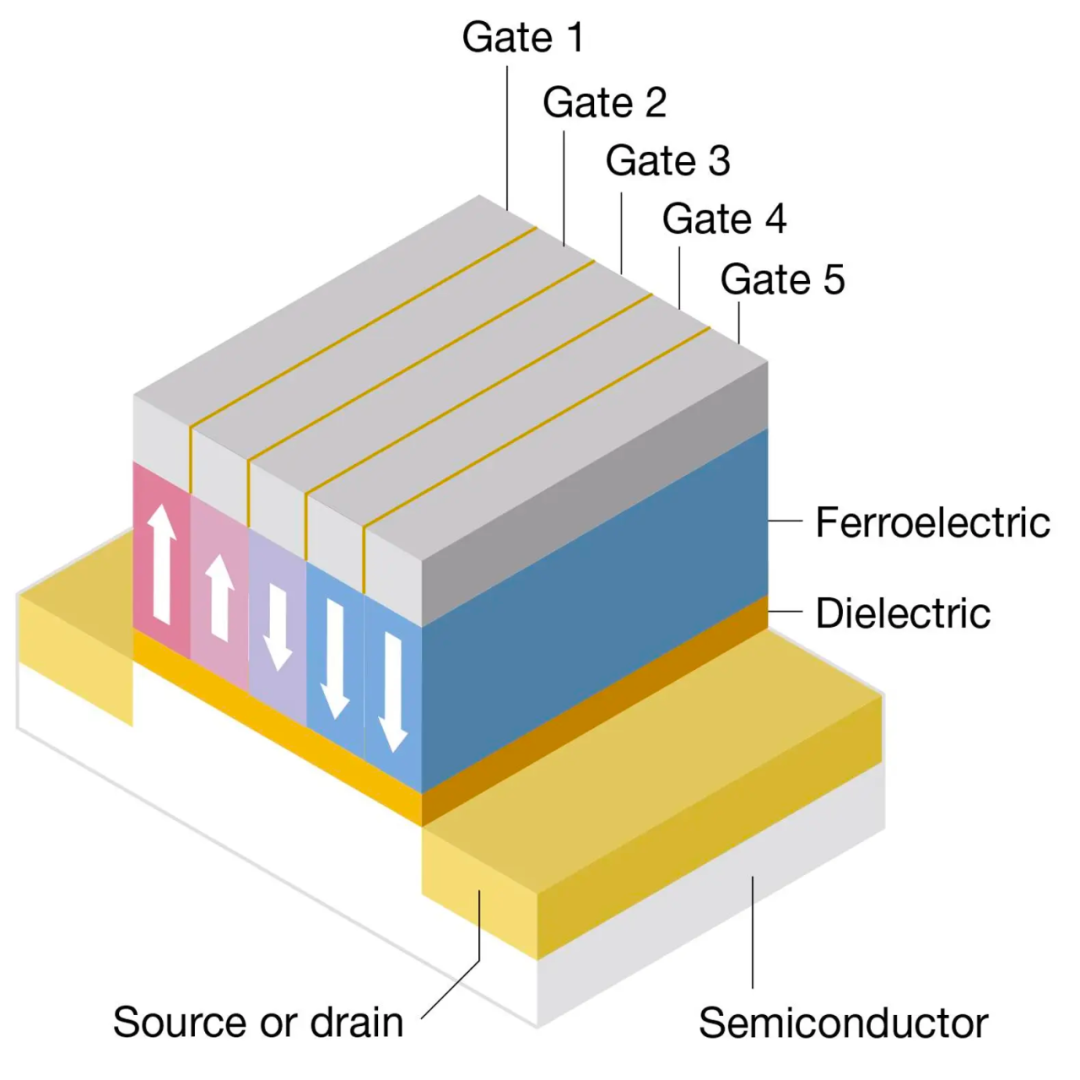

在實際構建方面,Boahen 提出用鐵電 FET(FeFET)來模擬樹突,具有 5 個柵極的 1.5 微米長的 FeFET 就可以模擬具有 5 個突觸的 15 微米長的樹突。Boahen 說,這種構建版本可能會在「3D 芯片」中實現。

感興趣的讀者可以閱讀論文原文,了解更多研究細節。

參考鏈接:https://spectrum.ieee.org/dendrocentric-learning?