一文盤點(diǎn)NeurIPS'22杰出論文亮點(diǎn)!英偉達(dá)AI大佬一句話總結(jié)每篇重點(diǎn),一并看透今年技術(shù)趨勢(shì)

本文經(jīng)AI新媒體量子位(公眾號(hào)ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

15篇NeurIPS’22杰出論文重磅出爐,具體亮點(diǎn)都是啥?

來(lái)來(lái)來(lái),大佬已經(jīng)幫你總結(jié)好了!

師從李飛飛,現(xiàn)在在英偉達(dá)工作的大佬,用49條推文,帶你回顧過(guò)去一年AI圈的重要研究。

雖然到不了NeurIPS’22的現(xiàn)場(chǎng),但也能提前在推特上體驗(yàn)下大會(huì)的盛況。

總結(jié)推文發(fā)出之后,立刻在網(wǎng)上掀起一陣熱度,眾多AI大佬都在轉(zhuǎn)發(fā)。

還有人從中看出了今年的技術(shù)趨勢(shì)。

每篇亮點(diǎn)都是啥?

總結(jié)這一線程的老哥名叫Linxi”Jim”Fan(以下簡(jiǎn)稱Jim)。

對(duì)于每篇論文,他都給出了一句話提煉亮點(diǎn),并簡(jiǎn)要解釋了自己的看法,還將論文地址和相關(guān)拓展鏈接一并附上。

具體都講了啥,我們一篇篇來(lái)看~

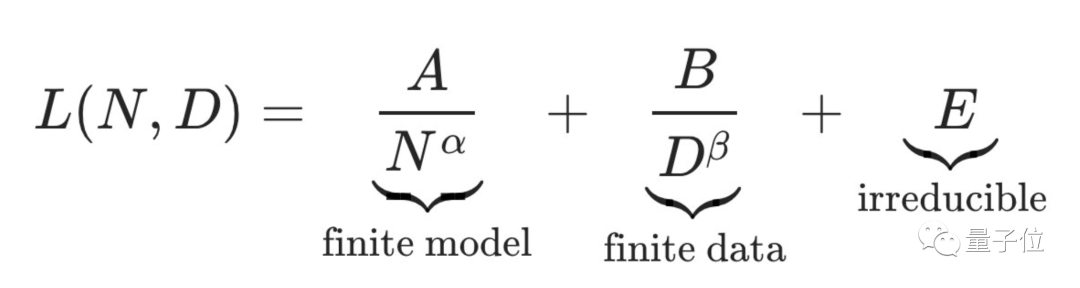

1、訓(xùn)練計(jì)算最優(yōu)的大語(yǔ)言模型

一句話總結(jié):提出一個(gè)700億規(guī)模的新語(yǔ)言模型“Chinchilla”,效果比千億級(jí)別GPT-3、Gopher更強(qiáng)。

Jim表示,通過(guò)這個(gè)模型,研究人員證明了想要實(shí)現(xiàn)“計(jì)算最優(yōu)”,模型大小和訓(xùn)練數(shù)據(jù)規(guī)模必須同等縮放。

這意味著,目前大多數(shù)大語(yǔ)言模型的訓(xùn)練數(shù)據(jù)是不夠的。

再考慮到新的縮放定律,即使將模型參數(shù)擴(kuò)大到千萬(wàn)億級(jí),效果恐怕也不及將訓(xùn)練token提升4倍。

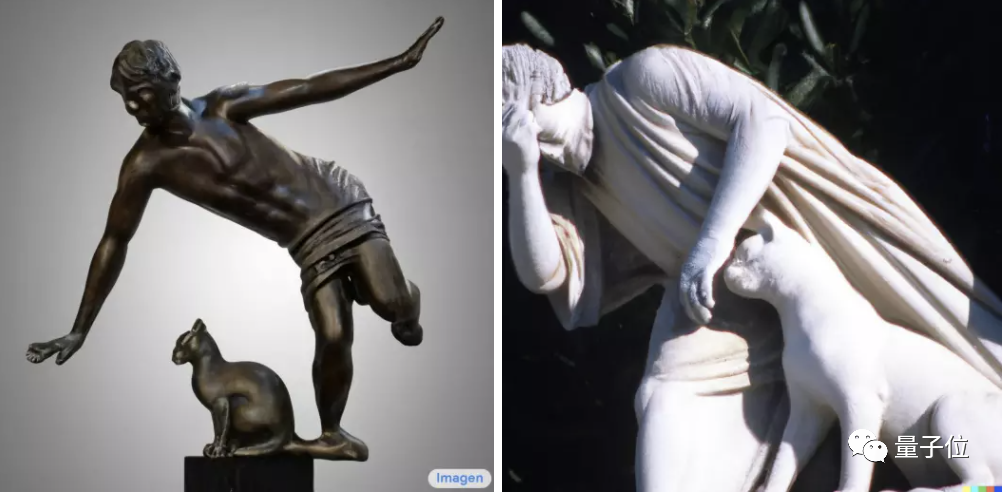

2、谷歌Imagen的強(qiáng),在于文本編碼器

一句話總結(jié):Imagen是一個(gè)大型從文本到圖像的超分辨率擴(kuò)散模型,可以生成逼真圖像,并且在評(píng)級(jí)中擊敗了Dall·E 2。

Jim指出,和Dall·E 2相比,Imagen使用了更為強(qiáng)大的文本編碼器T5-XXL,這直接影響了它的語(yǔ)言理解能力。

比如同題對(duì)比中,左邊是谷歌Imagen選手眼中的“貓貓絆倒人類雕像”,右邊DALL·E 2選手的創(chuàng)作則是醬嬸兒的:

3、ProcTHOR:房間模型模擬器

一句話總結(jié):ProcTHOR是一個(gè)可以生成大量定制化、可實(shí)際應(yīng)用房間模型的AI。

和Chinchilla一樣,ProcTHOR也需要大量數(shù)據(jù)來(lái)訓(xùn)練,然后從中摸索出自己的生成方案。

該成果由艾倫人工智能實(shí)驗(yàn)室提出,在此之前他們還為家用機(jī)器人提出了一些模型,如AI2THOR 和 ManipulaTHOR,可以讓他們感知房間環(huán)境。

4、MineDojo:看70000小時(shí)《我的世界》視頻學(xué)會(huì)人類高級(jí)技巧

一句話總結(jié):該研究提出一個(gè)由3個(gè)智能體(agent)組成的“具身GPT-3”,可以感知無(wú)限世界并在其中行動(dòng)。

研究團(tuán)隊(duì)認(rèn)為,想要訓(xùn)練出通才agent需要具備3方面因素:

第一、一個(gè)開放的環(huán)境,可以包含無(wú)限不同種類的任務(wù)(比如地球就是個(gè)開放環(huán)境);

第二、一個(gè)大規(guī)模知識(shí)庫(kù),可以教會(huì)AI做什么事、該做哪些事;

第三、足夠靈活的代理框架,能將知識(shí)轉(zhuǎn)化為實(shí)際操作。

綜上,《我的世界》是一個(gè)絕佳的訓(xùn)練場(chǎng)地。研究團(tuán)隊(duì)讓AI看了70000小時(shí)《我的世界》視頻后,它學(xué)會(huì)了使用鉆石鎬、打造“簡(jiǎn)易避難所”等人類玩家的高級(jí)操作。

值得一提的是,該成果的模擬套件、數(shù)據(jù)庫(kù)、算法代碼、預(yù)訓(xùn)練模型,甚至注釋工具,全部對(duì)外開源!

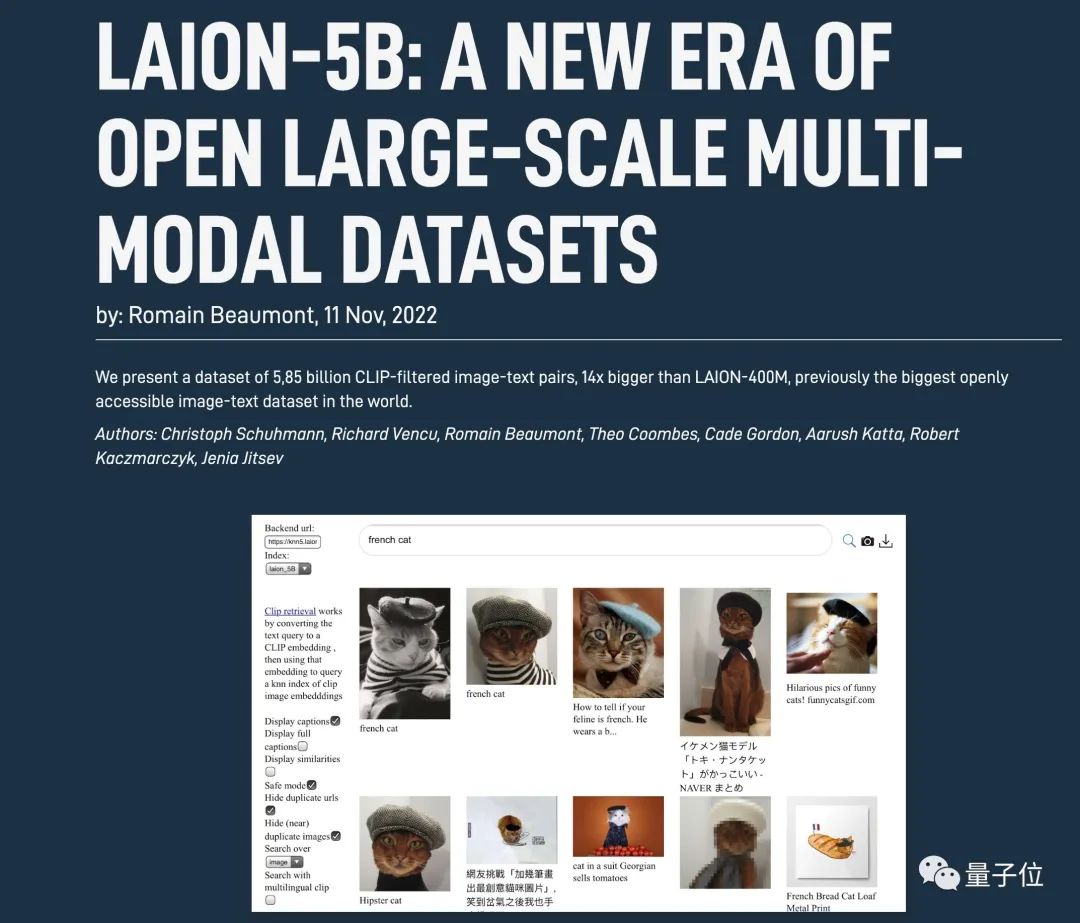

5、LAION-5B:史上最大規(guī)模公共開放的多模態(tài)圖文數(shù)據(jù)集

一句話總結(jié):一個(gè)包含58.5億個(gè)CLIP過(guò)濾的圖像-文本對(duì)數(shù)據(jù)集。

LAION-5B不用過(guò)多介紹了,Stable Diffusion使用正是它。

該數(shù)據(jù)集獲得了今年NeurIPS最杰出數(shù)據(jù)集論文獎(jiǎng)。

目前Stable Diffusion 2也已經(jīng)上線了。

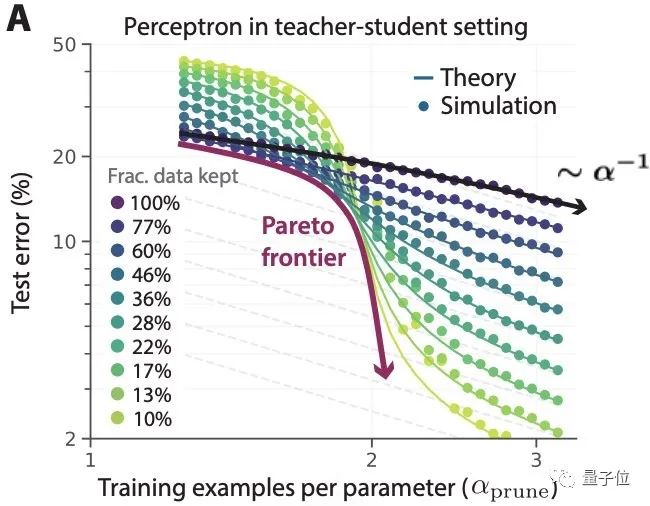

6、超越神經(jīng)網(wǎng)絡(luò)縮放定律:通過(guò)數(shù)據(jù)集修剪擊敗冪律

一句話總結(jié):通過(guò)仔細(xì)篩選訓(xùn)練示例、而不是盲目收集更多數(shù)據(jù),有可能大大超越神經(jīng)網(wǎng)絡(luò)的縮放定律。

該研究中,Meta和斯坦福的學(xué)者們通過(guò)數(shù)據(jù)蒸餾,縮小數(shù)據(jù)集規(guī)模,但是保持模型性能不下降。

實(shí)驗(yàn)驗(yàn)證,在剪掉ImageNet 20%的數(shù)據(jù)量后,ResNets表現(xiàn)和使用原本數(shù)據(jù)時(shí)的正確率相差不大。

研究人員表示,這也為AGI實(shí)現(xiàn)找出了一條新路子。

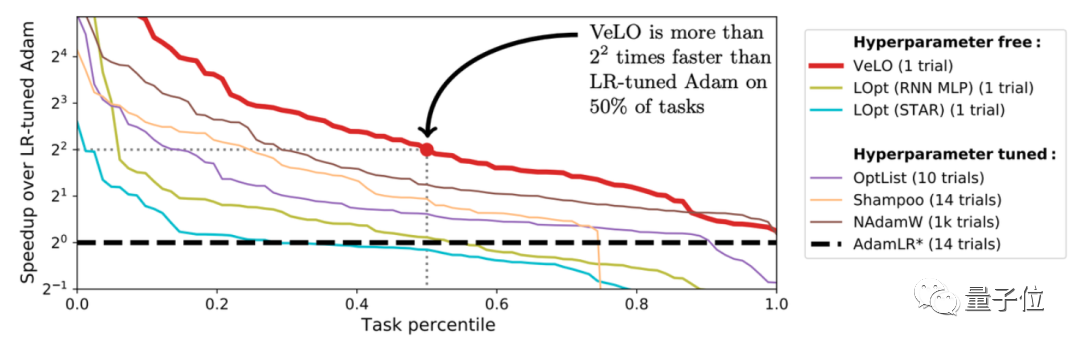

7、讓AI自己調(diào)超參數(shù)

一句話總結(jié):使用超級(jí)隨機(jī)梯度下降法,實(shí)現(xiàn)自動(dòng)調(diào)超參數(shù)。

谷歌大腦設(shè)計(jì)了一個(gè)基于AI的優(yōu)化器VeLO,整體由LSTM(長(zhǎng)短期記憶網(wǎng)絡(luò))和超網(wǎng)絡(luò)MLP(多層感知機(jī))構(gòu)成。

其中每個(gè)LSTM負(fù)責(zé)設(shè)置多個(gè)MLP的參數(shù),各個(gè)LSTM之間則通過(guò)全局上下文信息進(jìn)行相互協(xié)作。

采用元訓(xùn)練的方式,VeLO以參數(shù)值和梯度作為輸入,輸出需要更新的參數(shù)。

結(jié)果表明,VeLO在83個(gè)任務(wù)上的加速效果超過(guò)了一系列當(dāng)前已有的優(yōu)化器。

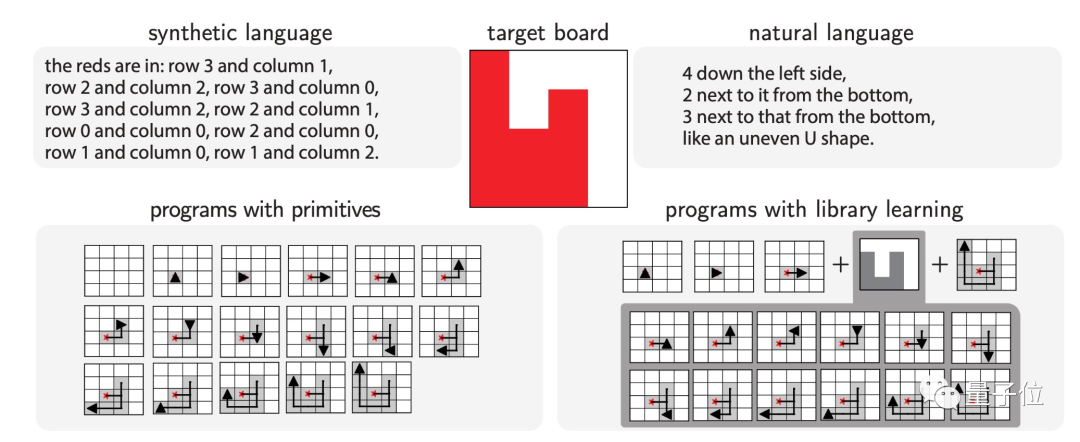

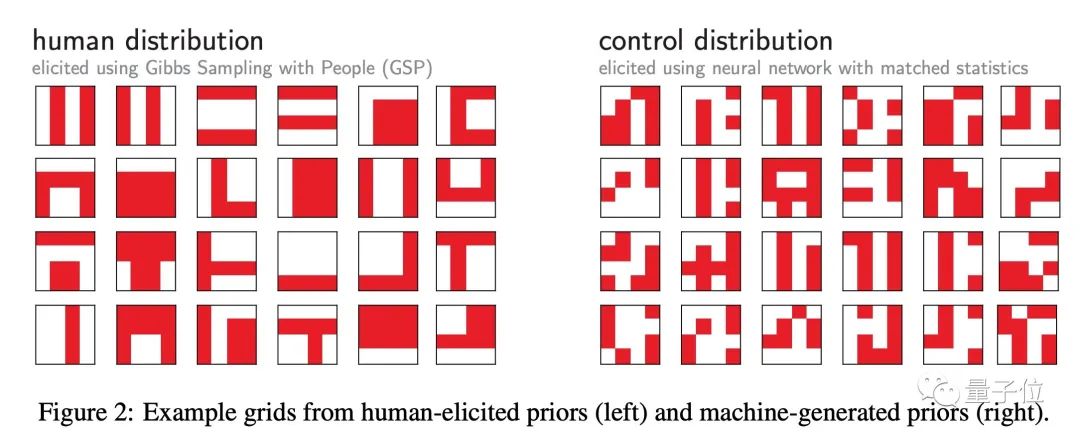

8、利用自然語(yǔ)言和程序抽象讓機(jī)器學(xué)會(huì)人類歸納性偏好

一句話總結(jié):利用自然語(yǔ)言描述和引導(dǎo)程序,讓智能體的行為更像人類。

論文表明,語(yǔ)言和程序中存儲(chǔ)了大量人類抽象先驗(yàn)知識(shí),智能體可以在元強(qiáng)化學(xué)習(xí)設(shè)置中學(xué)到這些歸納性偏好。

如下是是否使用人類抽象先驗(yàn)知識(shí)的對(duì)比:

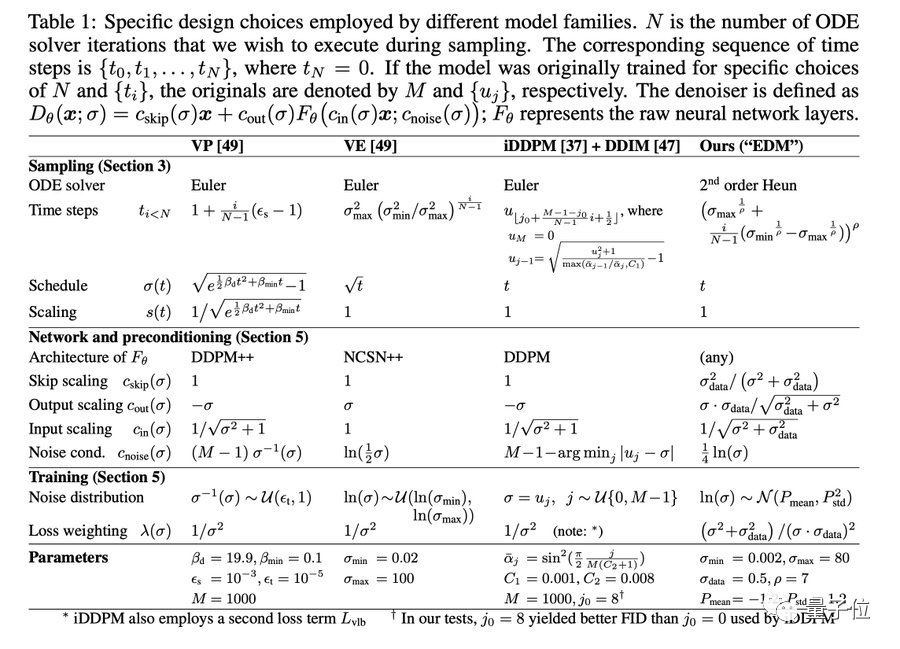

9、新方法提高擴(kuò)散模型生成結(jié)果

一句話總結(jié):英偉達(dá)通過(guò)對(duì)擴(kuò)散模型的訓(xùn)練流程進(jìn)行分析,得到新的方法來(lái)提高最后生成的結(jié)果。

此次研究提出了很多實(shí)用的方法改進(jìn)了模型的生成效果:

- 一個(gè)新的采樣過(guò)程,大大減少了合成過(guò)程中的采樣步數(shù);

- 改進(jìn)了訓(xùn)練過(guò)程中噪聲水平的分布;

- 其他一些改進(jìn)方法,如non-leaking增強(qiáng),即不會(huì)將生成分布暴露給生成器。

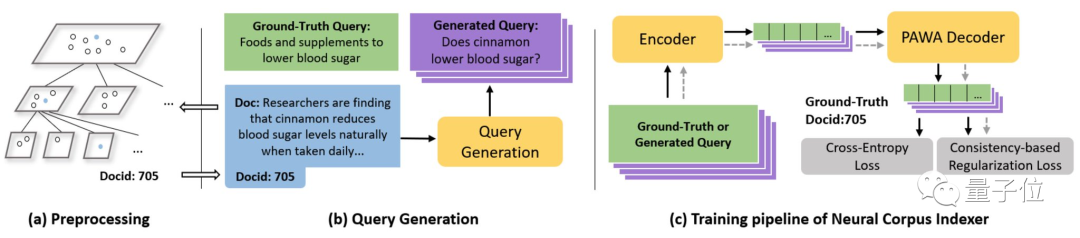

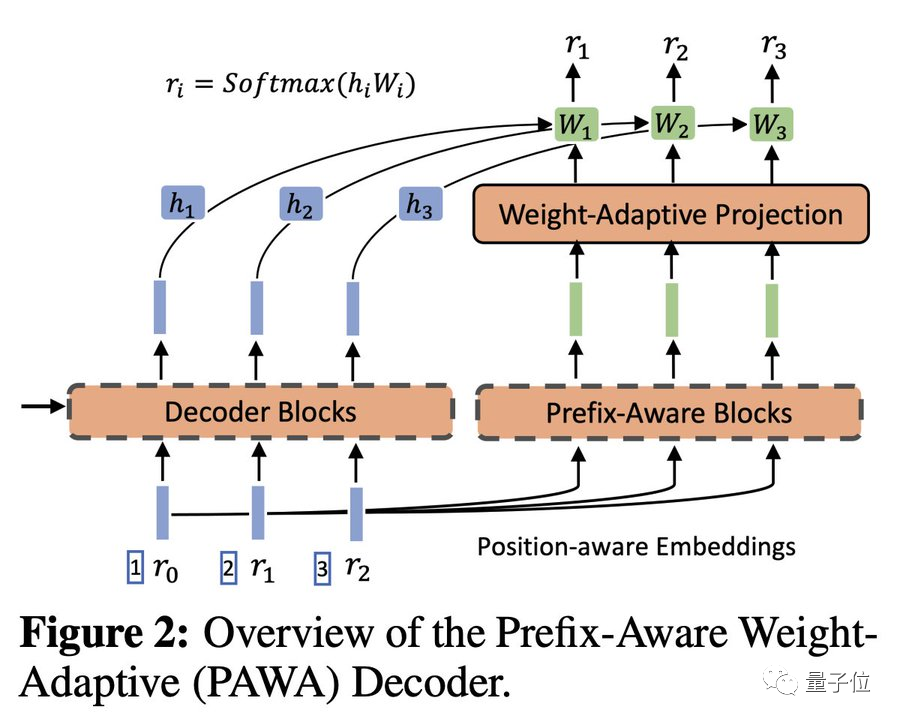

10、神經(jīng)語(yǔ)料庫(kù)索引器(NCI)

一句話總結(jié):NCI可以直接為特定的查詢生成相關(guān)的文檔標(biāo)識(shí)符,并顯著提高信息檢索性能。

傳統(tǒng)的檢索系統(tǒng)是基于文檔向量嵌入和最近鄰搜索。

而NCI則使用了一個(gè)端到端的可微模型,極大地簡(jiǎn)化了搜索管道,并且有可能在單個(gè)框架中統(tǒng)一檢索、排序和Q&A。

11、一種新的采樣方法

一句話總結(jié):加州大學(xué)設(shè)計(jì)出一個(gè)最有效的算法從多個(gè)分布中進(jìn)行采樣,按需采樣。

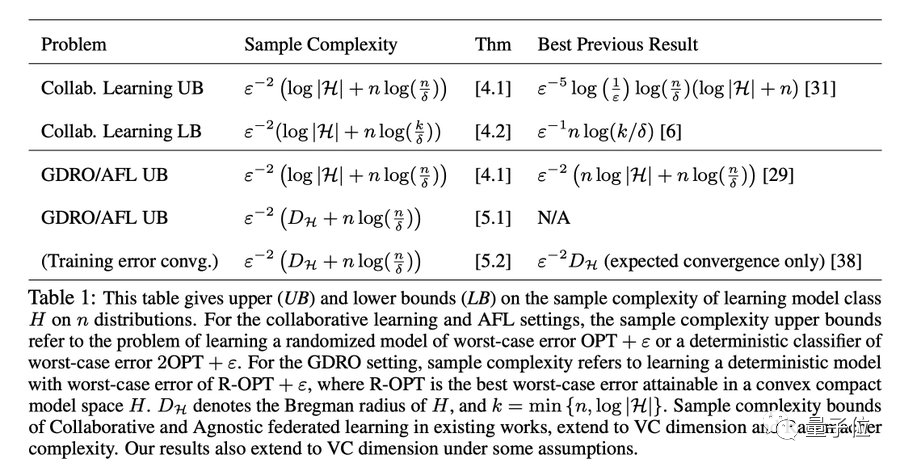

研究利用隨機(jī)零和博弈的方法研究了多重分布學(xué)習(xí)問(wèn)題。

多重分布學(xué)習(xí)在機(jī)器學(xué)習(xí)公平性、聯(lián)邦學(xué)習(xí)以及多主題協(xié)作中都有著重要的應(yīng)用。

在這其中,分布可能是不平衡或重疊的,所以最佳的算法應(yīng)該按需采樣。

12、分布外樣本(OOD)檢測(cè)是可學(xué)習(xí)的嗎?

一句話總結(jié):OOD檢測(cè)在某些條件下是不可學(xué)習(xí)的,但是這些條件不適用于一些實(shí)際情況。

Jim表示,具體來(lái)講,我們所熟悉的監(jiān)督式學(xué)習(xí)的測(cè)試數(shù)據(jù)是內(nèi)部分發(fā)的,但現(xiàn)實(shí)世界卻是混亂的。

而這個(gè)研究運(yùn)用PAC學(xué)習(xí)理論,提出了3個(gè)具體的不可能性定理,推斷應(yīng)用于實(shí)際環(huán)境中確定OOD檢測(cè)的可行性。

更重要的是,此項(xiàng)工作還為現(xiàn)有的OOD檢測(cè)方法提供了理論基礎(chǔ)。

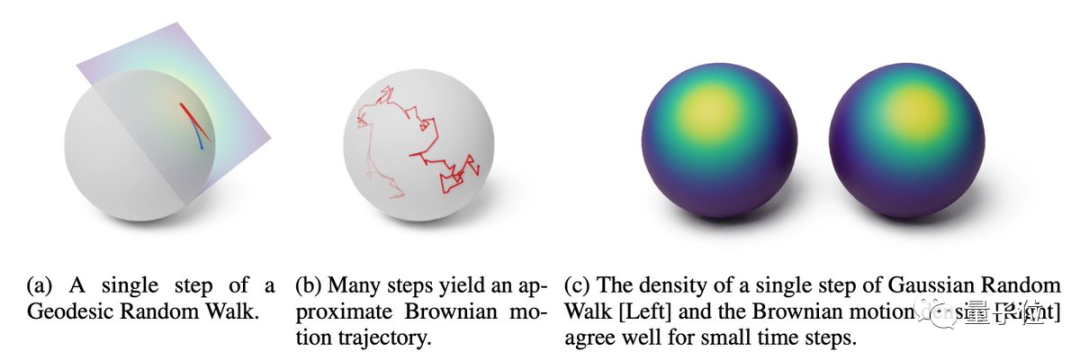

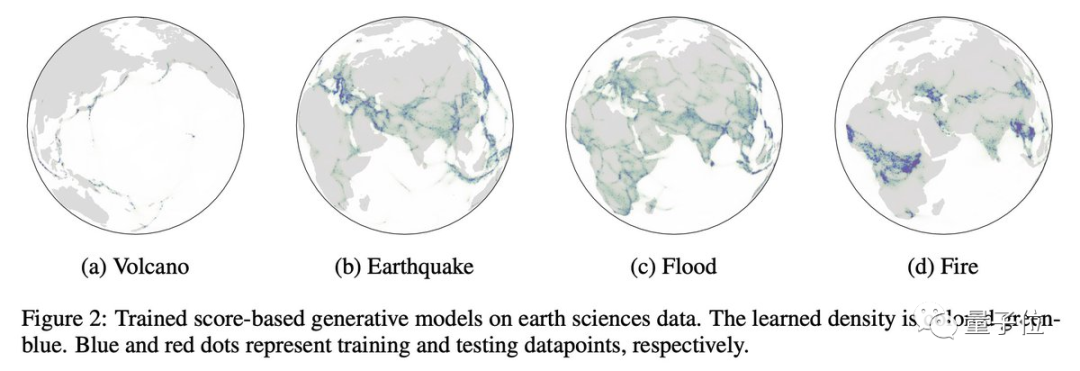

13、基于黎曼得分的生成模型(RSGMs)

一句話總結(jié):這是一類將模型擴(kuò)展到黎曼流形的生成模型(與歐幾里德空間中的數(shù)據(jù)相反)。

擴(kuò)散模型目前已經(jīng)在人工智能領(lǐng)域取得了很大的進(jìn)展,不過(guò)大多數(shù)模型都被假設(shè)是一個(gè)扁平的流形。

但在機(jī)器人學(xué)、地球科學(xué)或蛋白質(zhì)折疊等領(lǐng)域,數(shù)據(jù)也能很好地在黎曼流形上描述。

這項(xiàng)研究使得Stable Diffusion有望應(yīng)用在氣候科學(xué)上。

14、SGD的高維極限定理

一句話總結(jié):研究用一個(gè)統(tǒng)一的方法,了解在高維情況下具有恒定步長(zhǎng)的隨機(jī)梯度下降的縮放極限。

其核心貢獻(xiàn)是發(fā)展一個(gè)統(tǒng)一的方法,在連續(xù)步長(zhǎng)之下,使我們了解SGD在高維的比例限制。

研究團(tuán)隊(duì)還在目前正流行的模型中證明了這個(gè)方法,示例也展示了很好的效果:

包括收斂的多模態(tài)時(shí)間尺度以及收斂到次優(yōu)解決方案,概率從隨機(jī)初始化開始有界地遠(yuǎn)離零。

15、RODEO:減小估計(jì)梯度方法REINFORCE的方差。

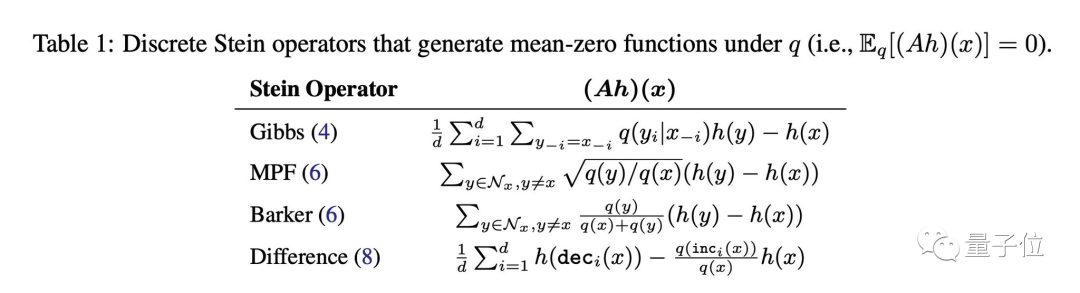

一句話總結(jié):利用Stein算子控制變量來(lái)增強(qiáng)REINFORCE的性能。

離散變量使神經(jīng)網(wǎng)絡(luò)不可微,所以估計(jì)梯度的一種常見方法是REINFORCE,但這種方法又存在很大的方差。

本文提出了一種利用Stein算子控制變量增強(qiáng)REINFORCE的高性能方法:“ RODEO”。

并且,這種控制變量可以在線調(diào)整以最小化方差,并且不需要對(duì)目標(biāo)函數(shù)進(jìn)行額外的評(píng)估。

在基準(zhǔn)生成建模任務(wù)中,例如訓(xùn)練二進(jìn)制變分自動(dòng)編碼器,在具有相同數(shù)量的函數(shù)估計(jì)的情況下,研究的梯度估計(jì)器實(shí)現(xiàn)了有史以來(lái)最低的方差。

大佬來(lái)自英偉達(dá),師從李飛飛

總結(jié)這一超強(qiáng)線程的大佬Jim,現(xiàn)就職于英偉達(dá)。

他的研究方向是開發(fā)具有通用能力的自主智能體,如上讓AI學(xué)會(huì)《我的世界》人類玩家技巧的論文,正是他的成果。

他博士就讀于斯坦福大學(xué)視覺實(shí)驗(yàn)室,師從李飛飛。

曾在谷歌云、OpenAI、百度硅谷AI實(shí)驗(yàn)室等實(shí)習(xí)。