英偉達(dá):從圖像中抽象出概念再生成新的圖像,網(wǎng)友:人類幼崽這個(gè)技能AI終于學(xué)會(huì)了

本文經(jīng)AI新媒體量子位(公眾號(hào)ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

早在2017年,就有網(wǎng)友吐槽:2歲幼童只要見(jiàn)過(guò)一次犀牛的照片,就能在其他圖片里認(rèn)出不同姿勢(shì)、視角和風(fēng)格的卡通犀牛,但AI卻做不到。

直到現(xiàn)在,這一點(diǎn)終于被科學(xué)家攻克了!

最新研究發(fā)現(xiàn),只要給AI喂3-5張圖片,AI就能抽象出圖片里的物體或風(fēng)格,再隨機(jī)生成個(gè)性化的新圖片。

有網(wǎng)友評(píng)價(jià):非常酷,這可能是我這幾個(gè)月來(lái)看到的最好的項(xiàng)目。

它是如何工作的?

讓我們先來(lái)看幾個(gè)例子。

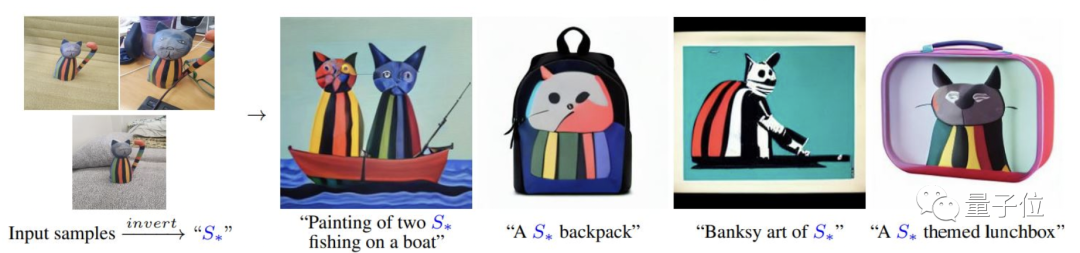

當(dāng)你上傳3張不同角度的陶瓷貓照片,可能會(huì)得到以下4張新圖像:兩只在船上釣魚(yú)的陶瓷貓、陶瓷貓書(shū)包、班克斯藝術(shù)風(fēng)格的貓以及陶瓷貓主題的午餐盒。

同樣的例子還有藝術(shù)品:

鎧甲小人:

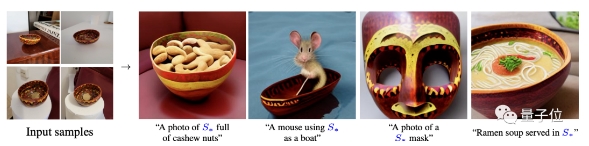

碗:

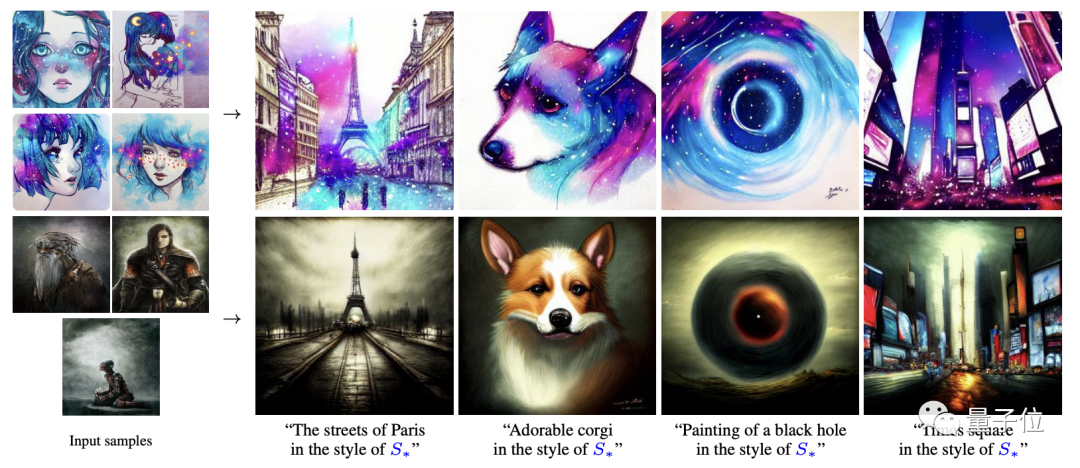

不只是提取圖像中的物體,AI還能生成特定風(fēng)格的新圖像。

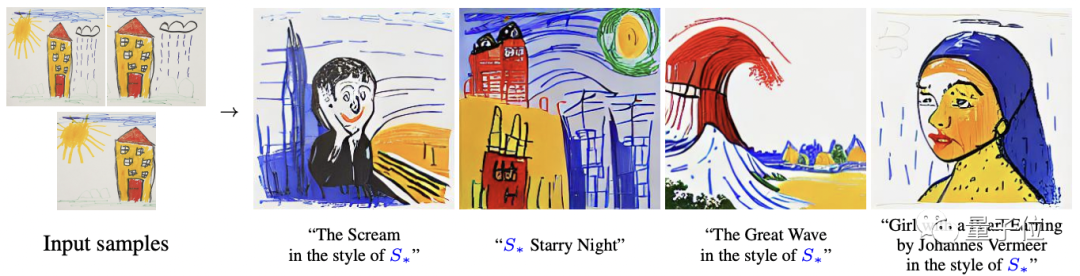

例如下圖,AI提取了輸入圖像的繪畫(huà)風(fēng)格,生成了一系列該風(fēng)格的新畫(huà)作。

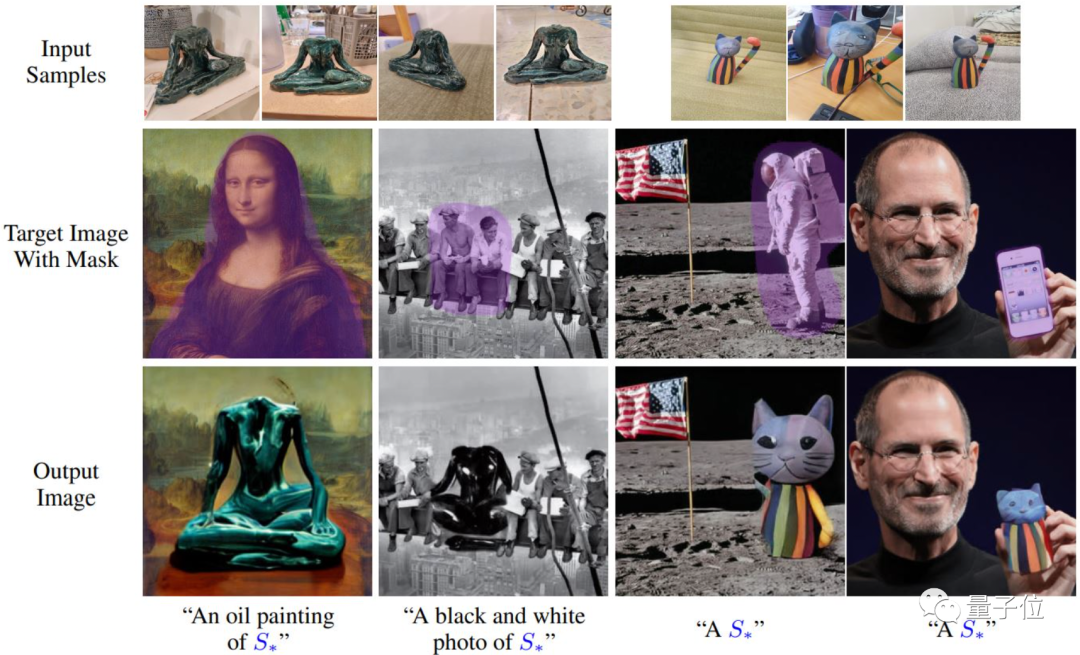

更神奇的是,它還能將兩組輸入圖像相結(jié)合,提取一組圖像中的物體,再提取另一組的圖像風(fēng)格,兩者結(jié)合,生成一張嶄新的圖像。

除此之外,有了這個(gè)功能,你還可以對(duì)一些經(jīng)典圖像“下手”,給它們添加一些新元素。

那么,這么神奇的功能背后是什么原理呢?

盡管近兩年來(lái),大規(guī)模文本-圖像模型,如DALL·E、CLIP、GLIDE等,已經(jīng)被證明有很強(qiáng)的自然語(yǔ)言推理能力。

但有一點(diǎn):如果用戶提出一些特定的需求,比如生成一張包含我最喜歡的童年玩具的新照片,或者把孩子的涂鴉變成一件藝術(shù)品,這些大規(guī)模模型都很難做到。

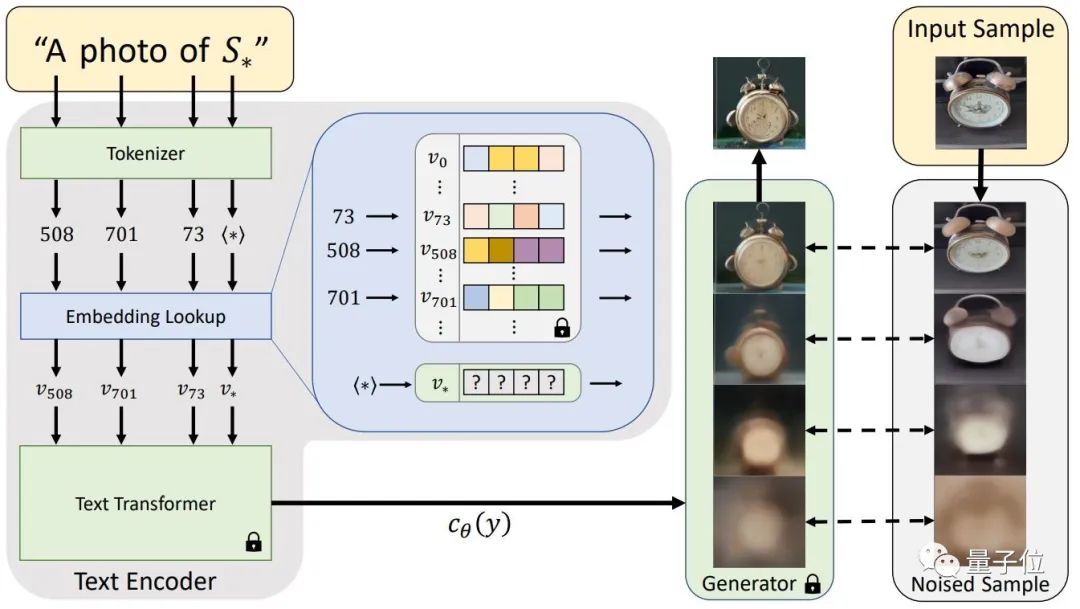

為了應(yīng)對(duì)這一挑戰(zhàn),研究給出了一個(gè)固定的、預(yù)先訓(xùn)練好的文本-圖像模型和一個(gè)描述概念的小圖像集(用戶輸入的3-5張圖像),目標(biāo)是找到一個(gè)單一的詞嵌入,從小集合中重建圖像。由于這種嵌入是通過(guò)優(yōu)化過(guò)程發(fā)現(xiàn)的,于是稱之為“文本倒置(Textual Inversion)”。

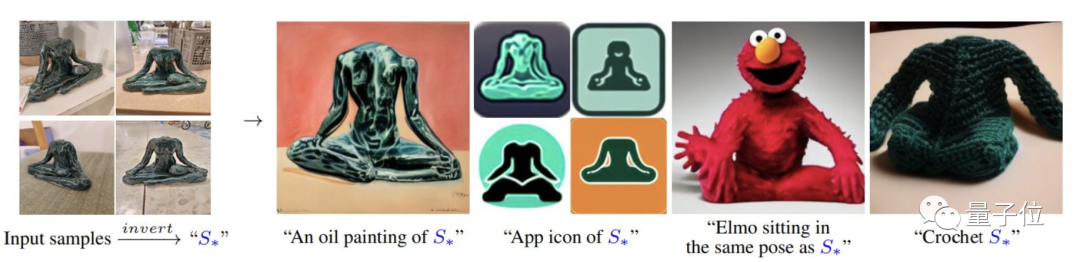

具體來(lái)說(shuō),就是先抽象出用戶輸入圖像中的物體或風(fēng)格,并轉(zhuǎn)換為“S?”這一偽詞(pseudo-word),這時(shí),這個(gè)偽詞就可以被當(dāng)作任何其他詞來(lái)處理,最后根據(jù)“S?”組合成的自然語(yǔ)句,生成個(gè)性化的新圖像,比如:

“一張S?在海灘上的照片”、”一幅掛在墻上的S?的油畫(huà)”、”以S2?的風(fēng)格畫(huà)一幅S1?”。

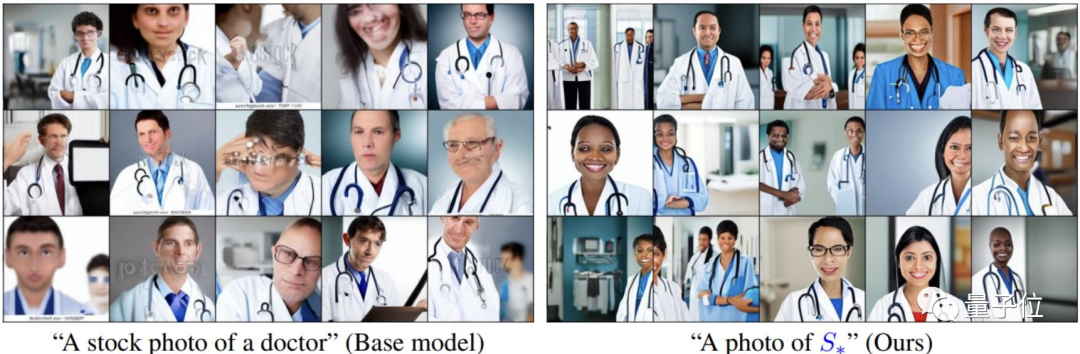

值得注意的是,由于本次研究應(yīng)用了一個(gè)小規(guī)模、經(jīng)過(guò)策劃的數(shù)據(jù)集,因此在生成圖像時(shí)能有效地避免刻板印象。

例如下圖,當(dāng)提示“醫(yī)生”時(shí),其他模型傾向于生成白種人和男性的圖像,而本模型生成圖像中則增加了女性和其他種族的人數(shù)。

目前,該項(xiàng)目的代碼和數(shù)據(jù)已開(kāi)源,感興趣的小伙伴可以關(guān)注一下。

作者介紹

該篇論文來(lái)自特拉維夫大學(xué)和英偉達(dá)的研究團(tuán)隊(duì),作者分別是Rinon Gal、Yuval Alaluf、Yuval Atzmon、Or Patashnik、Amit H. Bermano、Gal Chechik、Daniel Cohen-Or。

第一作者Rinon Gal,是特拉維夫大學(xué)的計(jì)算機(jī)科學(xué)博士生,師從Daniel Cohen-Or和Amit Bermano,主要研究方向是在減少監(jiān)督的條件下生成2D和3D模型,目前在英偉達(dá)工作。