《自然》:機器視覺行為理解與腦神經有內在關聯?上交盧策吾團隊構建映射模型

當行為主體在執行某個行為時,其大腦是否產生了對應的穩定腦神經模式映射?如果存在穩定映射,是否能運用機器學習方法發現未知行為神經回路?

為了回答這一系列行為理解的本質問題,近日一項發表在《自然》上的工作對行為理解機理進行了研究。該論文的兩位共同通訊作者為上海交通大學的盧策吾教授與Salk研究院Kay M. Tye教授。

論文鏈接:https://www.nature.com/articles/s41586-022-04507-5 該成果基于計算機視覺技術定量闡釋了機器視覺行為理解與腦神經的內在關聯,并首次建立了其穩定映射模型。形成計算機視覺行為分析發現行為神經回路這一運用人工智能解決神經科學基礎問題的新研究范式,具體為計算機智能算法通過大規模對小鼠社交和競爭行為視頻的理解,發現了控制 “動物社會層級(Social Hierarchy)行為”的神經回路,面向回答哺乳動物是如何判斷其他個體與自己在社會群體地位高低并做出行為決策的問題,其形成的新研究范式也進一步推動了人工智能與基礎科學問題前沿交叉(AI for Science)領域的發展。

具體研究內容如下:

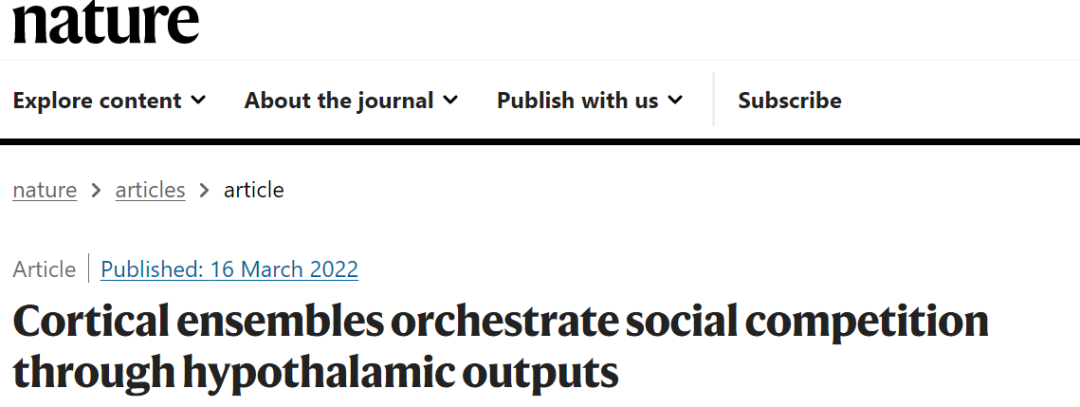

圖1. 視覺行為檢測-腦神經信號關聯模型:(a)小鼠視覺行為理解(b)系統框架與模型學習。

圖1. 視覺行為檢測-腦神經信號關聯模型:(a)小鼠視覺行為理解(b)系統框架與模型學習。

視覺行為檢測-腦神經信號關聯模型:我們以小鼠群為實驗對象,為每只小鼠佩戴無線電生理記錄設備,以記錄社交活動中的特定腦區內側前額葉皮層 (mPFC)的序列腦神經信號。同時,通過多個攝像頭跟蹤定位每只小鼠,基于盧策吾教授團隊研究開發的姿態估計(如alphapose)與行為分類研究成果提取行為語義標簽,達到小鼠的姿態估計準確率高于人眼水平。基于提出系統自動采集的大量數據,隱馬爾可夫模型訓練從“小鼠mPFC腦區的神經活動信號”到“行為標簽”的回歸模型,發現訓練后在測試集上仍然有穩定映射關系,揭示了行為視覺類型與其行為主體大腦中的腦神經信號模式存在穩定的映射關系。

模型應用:控制動物社會層級(Social Hierarchy)行為神經回路發現:基于視覺行為檢測-腦神經信號關聯模型,我們可以發現新的行為神經回路。“動物社會層級”行為神經控制機理(比如,低等級小鼠會讓高等級小鼠優先進食,低等級小鼠會表現出服從行為)一直是學界重要問題,即哺乳動物是如何判斷其他個體與自己的社會群體地位高低的?其背后的神經控制機制是怎么樣的?由于動物社會層級行為是復雜行為概念,該問題一直為學界未所突破的難題。我們在大規模的小鼠群體競爭視頻中,定位 “動物社會層級”行為基于上述系統和模型,并同時記錄到動物社會層級行為的腦部活動狀態,深度解析了動物社會層級行為在大腦中的形成機制,即發現內側前額葉皮層-外側下丘腦(mPFC-LH)回路具有控制動物社會層級行為的功能,并得到嚴格生物學實驗的證實。該研究形成了基于機器視覺學習發現未知行為功能神經回路的新研究范式,也進一步推動了人工智能解決基礎科學問題(AI for Science)的發展。

盧策吾團隊行為理解研究

上述工作是盧策吾團隊多年的行為理解方面積累的一部分。機器如何理解行為,需要全面地回答以下三個問題:

1. 機器認知角度:如何讓機器看懂行為?

2. 神經認知角度:機器認知語義與神經認知的內在關聯是什么?

3. 具身認知角度:如何將行為理解知識遷移到的機器人系統?

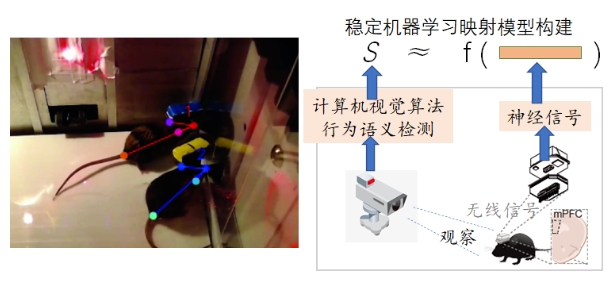

圖2. 盧策吾團隊圍繞行為理解主要工作

此次在《自然》上發表的工作正是想回答第二個問題,對于其他兩個問題團隊主要工作有:

1、如何讓機器看懂行為?

主要工作包括:

- 人類行為知識引擎HAKE(Human Activity Knowledge Engine)

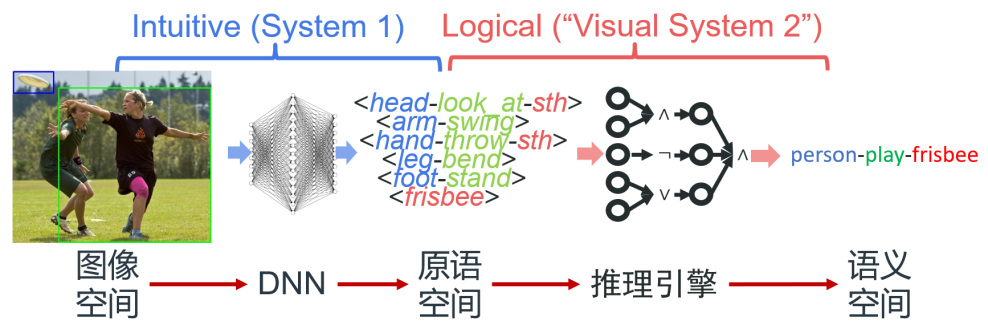

為探索可泛化、可解釋、可擴展的行為識別方法,要克服行為模式和語義間的模糊聯系、數據分布長尾等問題。區別于一般的直接深度學習“黑盒”模式,團隊構建了知識引導與數據驅動的行為推理引擎HAKE(開源網站:http://hake-mvig.cn/home/):

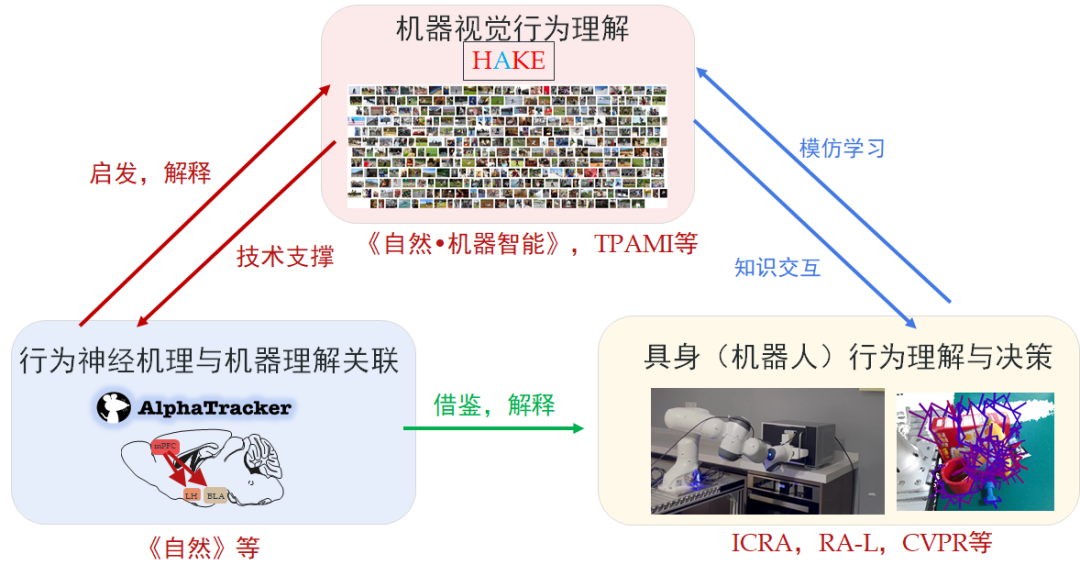

圖3. HAKE系統框架

HAKE將行為理解任務分為兩階段,首先將視覺模式映射到人體局部狀態原語空間,用有限且接近完備的原子的原語表達多樣的行為模式;隨后將原語依據邏輯規則進行編程,以可推理行為語義。HAKE提供了大型的行為原語知識庫以支持高效的原語分解,并借助組合泛化和可微神經符號推理完成行為理解,具有以下特點(發表TPAMI,CVPR等計算機視覺頂刊頂會十余篇):

(1)規則可學習:HAKE可根據少量人類行為-原語的先驗知識進行邏輯規則的自動挖掘和驗證,即對原語組合規則進行總結,并在實際數據上進行演繹驗證,以發現有效且可泛化的規則,發現未知行為規則,如圖4。

圖4. 學習未見行為規則

(2)人類性能upper bound:在87類復雜行為實例級別行為檢測測試集(10,000張圖像)上,具備完備原語檢測的HAKE系統的性能甚至可接近人類的行為感知性能,驗證了其巨大潛力。

(3)行為理解“圖靈測試”:

圖5. 讓機器(HAKE)和人類抹去部分像素使得無法理解圖中行為,圖靈測試表明,HAEK的“抹去手法”和人類十分相似。

我們還提出了一種特殊“圖靈測試”:若機器可以從圖像中抹去關鍵像素,使得人類被試者也無法分辨該行為時,即認為其可以較好地理解該行為。分別讓HAKE和人類去做這種抹去操作。并請另一批志愿者做圖靈測試,問這個抹去操作是人類還是HAKE操作。人類分辨的正確率約為59.55%(隨機猜50%),說明HAKE的“抹去手法”和人類十分相似,側面印證了在行為“可解釋性”的理解上與人類相近。

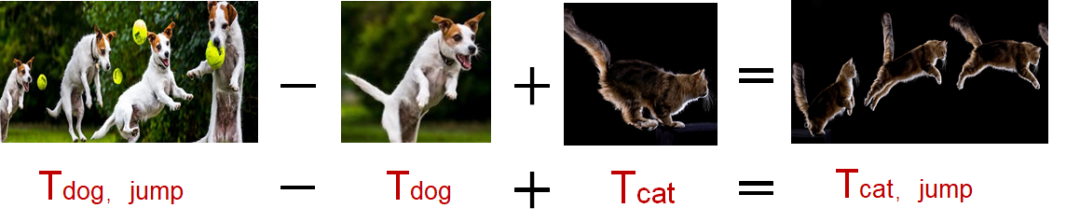

- 行為對象可泛化的腦啟發計算模型(《自然?機器智能》)

對于某個特定行為(如“洗”),人類大腦能抽象出泛化的行為動態概念,適用于不同的視覺對象(如衣服、茶具、鞋),并以此做出行為識別。神經科學領域研究發現,對于連續視覺信號輸入,在人類的記憶形成過程中,時空動態信息與物體對象信息是通過兩個相對獨立的信息通路到達海馬體以形成完整的記憶,這個帶來行為對象可泛化的可能性。

圖6. 解耦合地處理行為對象概念和行為動態概念,帶來的泛化性。

基于腦科學啟發,盧策吾團隊通過模仿人類的認知行為對象與動態概念在各種腦區獨立工作的機制,提出了適用于高維度信息的半耦合結構模型(SCS),實現自主發掘(awareness)行為視覺對象概念與行為動態概念,將兩種概念分別記憶存儲在相對獨立的兩部分神經元上。在深度耦合模型框架下設計信息獨立誤差反傳(decouple back-propagation)機制,約束兩類神經元只關注自己的概念,初步實現了行為理解對行為主體對象的泛化。所提出半耦合結構模型工作發表在《自然?機器智能》,并獲得2020年世界人工智能大會優秀青年論文獎。

視頻序列 對象神經元 動態神經元

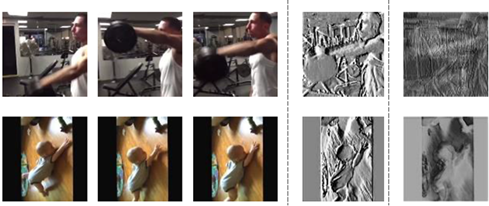

圖7.可視化表征“視覺對象”與“行為動態概念”的神經元《自然?機器智能》

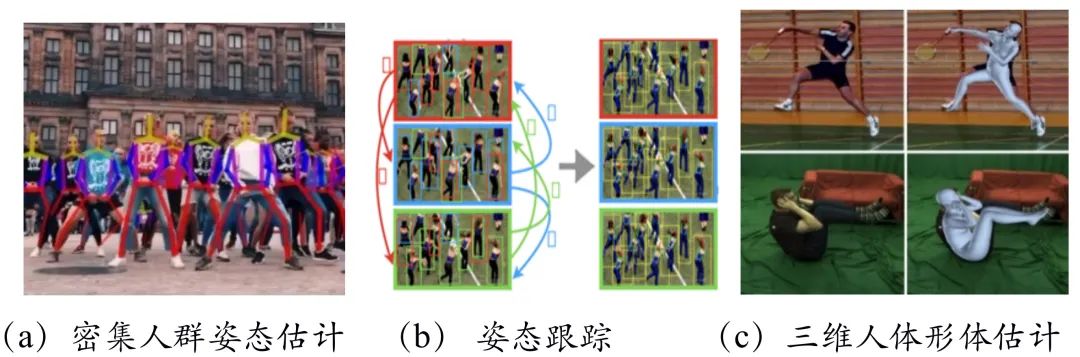

- 人體姿態估計

人體姿態估計是行為理解的重要基礎,該問題是一個在結構約束下獲取精準感知的問題,圍繞結構約束下感知問題,提出圖競爭匹配、姿態流全局優化、神經-解析混合的逆運動優化等算法,系統性地解決人體運動結構感中密集人群干擾大、姿態跟蹤不穩定、三維人體常識性錯誤嚴重等難題,前后發表CVPR,ICCV等計算機視覺頂會論文20多篇;

圖8. 結構感知的工作。相關研究成果積累形成開源系統AlphaPose(https://github.com/MVIG-SJTU/AlphaPose),在開源社區GitHub上獲得5954 Star(Fork數為1656),GitHub排名前十萬份之1.6。被傳感器領域、機器人領域、醫學領域、城市建設領域廣泛使用。在姿態估計后,團隊進一步形成開源視頻行為理解開源框架Alphaction(https://github.com/MVIG-SJTU/AlphAction)。

2、如何將行為理解知識遷移到的機器人系統?

探索結合第一人稱角度理解人類行為本質,從單純考慮“她/他在做什么”到聯合考慮“我在做什么”。這種研究范式也正是 “具身智能”(Embodied AI)的研究思路。探索將該理解能力與學習得到的行為知識遷移到具身智能本體(人形機器人),使機器人初步具有“人類行為能力”,最后驅動機器人完成真實世界的部分任務,為通用服務機器人奠定基礎。

以上科學問題的解決將:(1)大大提高行為語義檢測性能和提升語義理解范圍;(2)有力地提高智能體(特別是人形機器人)對真實世界的理解能力,同時根據完成任務過程中真實世界的反饋檢驗機器對行為概念本質的理解程度,為通用智能機器人的實現打下重要基礎。 近年來盧策吾團隊在具身智能領域聯合非夕科技構建通用物體抓取框架GraspNet(https://graspnet.net/anygrasp.html),實現了任意場景下剛體、可變形物體、透明物體等各種類型的未見物體的抓取,首次將PPH(picks per hour)指標超越人類水平,為之前性能最優的DexNet算法的三倍,相關論文發表一年內被引用70次。物體抓取是機器人操作的第一步,為該項目打下良好基礎。

機器人行為-物體模型交互感知實現機器人行為執行能力與物體知識理解聯合學習與迭代提高,通過機器人交互本質上降低物體模型感知估計誤差,并基于物體知識的理解進一步提高機器人行為執行能力。比起之前純視覺物體識別,交互帶來新的信息源,帶來感知性能本質提高。如圖9與視頻所示,

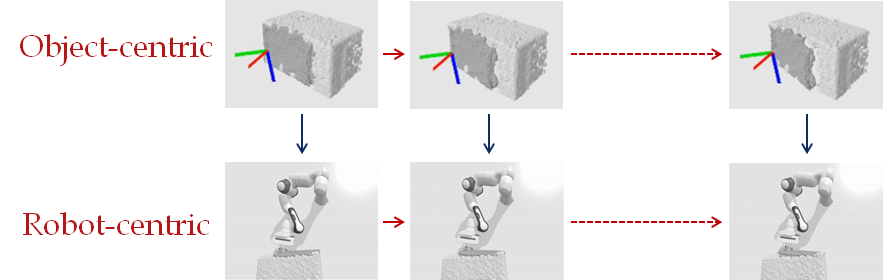

圖9. 物體知識模型-機器人行為決策迭代提高

圖10. 交互感知:機器人行為能力(上圖)與模型理解能力(下圖)聯合學習 (邊執行行為,邊提高糾正感知)

相關工作是發表在ICRA 2022上的論文《SAGCI-System: Towards Sample-Efficient, Generalizable, Compositional, and Incremental Robot Learning》(SAGCI 系統:面向樣本高效、可擴展、可組合和可增量的機器人學習框架)。

- 網站:https://mvig.sjtu.edu.cn/research/sagci/index.html

- 視頻:https://www.bilibili.com/video/BV1H3411H7be/

盧策吾,上海交通大學教授,博士生導師,研究方向為人工智能。2018年被《麻省理工科技評論》評選為中國35歲以下創新精英35人(MIT TR35),2019年獲求是杰出青年學者。