這四款Python分詞工具,你用過嗎?

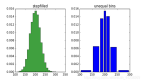

1、 jieba 分詞 github地址:

https://github.com/fxsjy/jieba

“結巴”分詞,可以說是 GitHub 最受歡迎的分詞工具,支持自定義詞典,支持多種分詞模式,立志成為 Python 中最好的中文分詞組件。

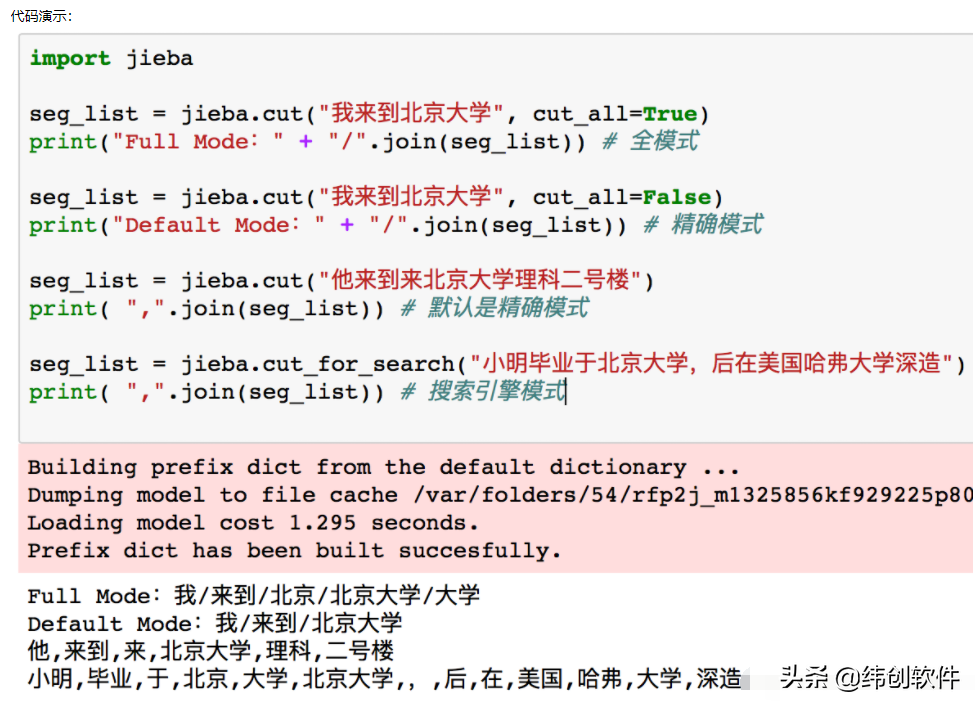

2. pkuseg 分詞 github地址:

https://github.com/lancopku/pkuseg-python

pkuseg 的特點是支持多種不同的分詞領域,新聞、網絡、醫藥、v旅游等領域的分詞訓練模型,相比于其他分詞工具,不但可以自由的選擇不同模型,而且可以提供更高的分詞準確率。

3. FoolNLTK 分詞 github地址:

https://github.com/rockyzhengwu/FoolNLTK

FoolNLTK 分詞是基于BiLSTM模型訓練而來的,支持用戶自定義詞典,有人說它是最準確的開源中文分詞,不知道你有沒有嘗試過呢?

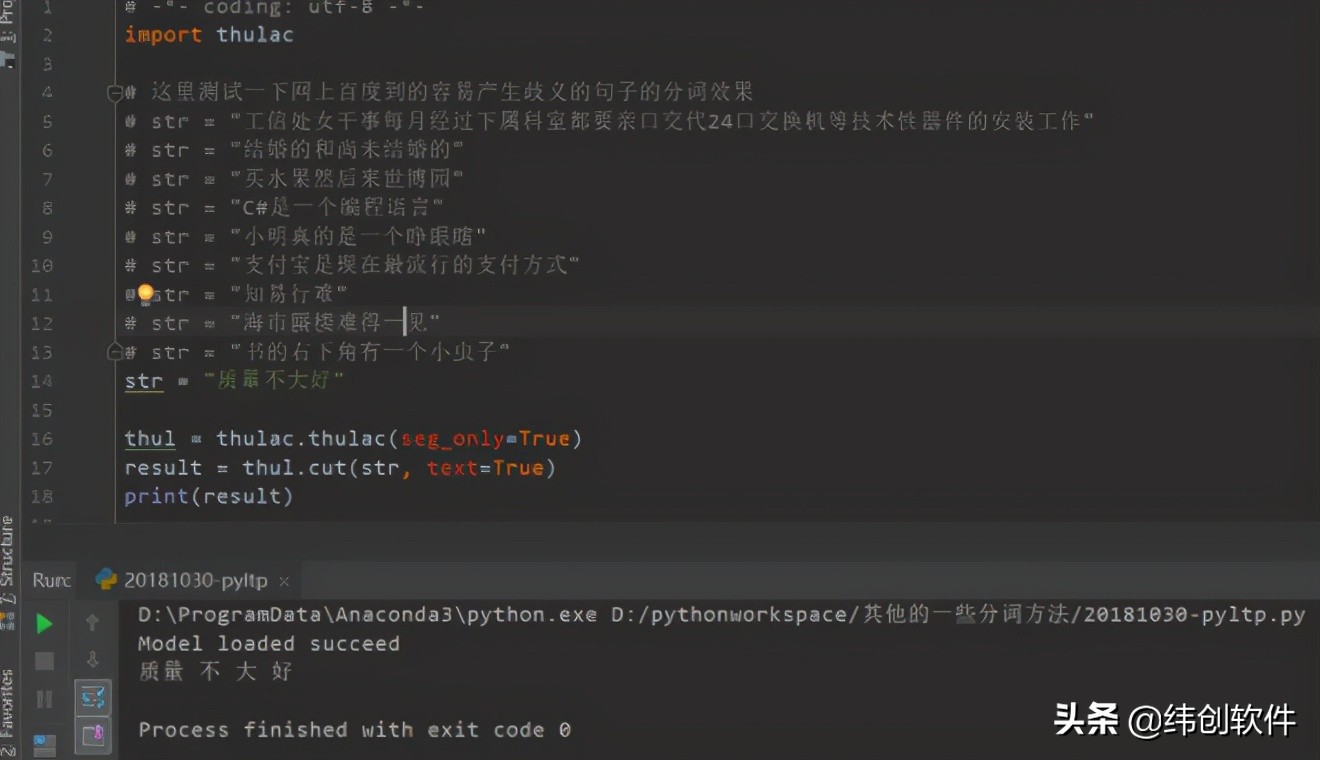

4. THULAC github地址:

https://github.com/thunlp/THULAC-Python

THULAC由清華大學自然語言處理與社會人文計算實驗室,研制推出的具有詞性標注功能的中文詞法分析工具包。能分析出某個詞是名詞還是動詞或者形容詞。利用我們集成的目前世界上規模最大的人工分詞和詞性標注中文語料庫(約含5800萬字)訓練而成,模型標注能力強大。該工具包在標準數據集Chinese Treebank(CTB5)上分詞的F1值可達97.3%,詞性標注的F1值可達到92.9%,與該數據集上最好方法效果相當。速度較快。

跟同事聊起分詞工具,他們很多人在用的還是結巴分詞,配合用戶自定義詞典,解決常見的網絡詞語。你在用哪個工具呢?