大數據Spark運行環境:Standalone模式與配置詳解

大數據Spark運行環境:Standalone模式與相關配置詳解

Standalone模式

這里我們來看看只使用Spark自身節點運行的集群模式,也就是我們所謂的獨立部署(Standalone)模式。Spark的Standalone模式體現了經典的master-slave模式。

集群規劃:

1 解壓縮文件

將spark-3.0.0-bin-hadoop3.2.tgz.tgz文件上傳到Linux并解壓縮在指定位置

- tar -zxvf spark-3.0.0-bin-hadoop3.2.tgz -C /opt/module

- cd /opt/module

- mv spark-3.0.0-bin-hadoop3.2 spark-standalone

2 修改配置文件

1) 進入解壓縮后路徑的conf目錄,修改slaves.template文件名為slaves

- mv slaves.template slaves

2) 修改slaves文件,添加work節點

- hadoop102hadoop103hadoop104

3) 修改spark-env.sh.template文件名為spark-env.sh

- mv spark-env.sh.template spark-env.sh

4) 修改spark-env.sh文件,添加JAVA_HOME環境變量和集群對應的master節點

- export JAVA_HOME=/opt/module/jdk1.8.0_212

- SPARK_MASTER_HOST=hadoop102SPARK_MASTER_PORT=7077

注意:7077端口,相當于hadoop3.x內部通信的8020端口,此處的端口需要確認自己的虛擬機配置

5) 分發spark-standalone目錄

- xsync spark-standalone

3 啟動集群

1) 執行腳本命令:

- sbin/start-all.sh

2) 查看三臺服務器運行進程

- ================hadoop102================

- 3330 Jps

- 3238 Worker

- 3163 Master

- ================hadoop103================

- 2966 Jps

- 2908 Worker

- ================hadoop104================

- 2978 Worker

- 3036 Jps

3) 查看Master資源監控Web UI界面: http://hadoop102:8080

4 提交應用

- bin/spark-submit \

- --class org.apache.spark.examples.SparkPi \

- --master spark://hadoop102:7077 \

- ./examples/jars/spark-examples_2.12-3.0.0.jar \

- 10

- --class表示要執行程序的主類

- --master spark://hadoop102:7077 獨立部署模式,連接到Spark集群

- spark-examples_2.12-3.0.0.jar 運行類所在的jar包

- 數字10表示程序的入口參數,用于設定當前應用的任務數量

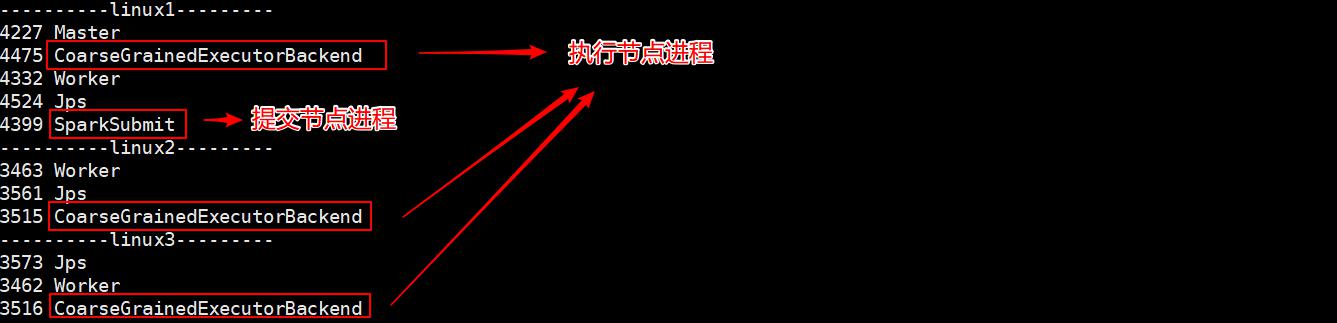

執行任務時,會產生多個Java進程

執行任務時,默認采用服務器集群節點的總核數,每個節點內存1024M。

5 配置歷史服務

由于spark-shell停止掉后,集群監控hadoop102:4040頁面就看不到歷史任務的運行情況,所以開發時都配置歷史服務器記錄任務運行情況。

1) 修改spark-defaults.conf.template文件名為spark-defaults.conf

- mv spark-defaults.conf.template spark-defaults.conf

2) 修改spark-default.conf文件,配置日志存儲路徑

- spark.eventLog.enabled true

- spark.eventLog.dir hdfs://hadoop102:8020/directory

注意:需要啟動hadoop集群,HDFS上的directory目錄需要提前存在。

- sbin/start-dfs.sh

- hadoop fs -mkdir /directory

3) 修改spark-env.sh文件, 添加日志配置

- export SPARK_HISTORY_OPTS="

- -Dspark.history.ui.port=18080

- -Dspark.history.fs.logDirectory=hdfs://hadoop102:8020/directory

- -Dspark.history.retainedApplications=30"

注:寫成一行!!空格隔開!!!

- 參數1含義:WEB UI訪問的端口號為18080

- 參數2含義:指定歷史服務器日志存儲路徑

- 參數3含義:指定保存Application歷史記錄的個數,如果超過這個值,舊的應用程序信息將被刪除,這個是內存中的應用數,而不是頁面上顯示的應用數。

4) 分發配置文件

- xsync conf

5) 重新啟動集群和歷史服務

- sbin/start-all.sh

- sbin/start-history-server.sh

6) 重新執行任務

- bin/spark-submit \

- --class org.apache.spark.examples.SparkPi \

- --master spark://hadoop102:7077 \

- ./examples/jars/spark-examples_2.12-3.0.0.jar \

- 10

7) 查看歷史服務:http://hadoop102:18080

6 配置高可用(HA)

所謂的高可用是因為當前集群中的Master節點只有一個,所以會存在單點故障問題。所以為了解決單點故障問題,需要在集群中配置多個Master節點,一旦處于活動狀態的Master發生故障時,由備用Master提供服務,保證作業可以繼續執行。這里的高可用一般采用Zookeeper設置

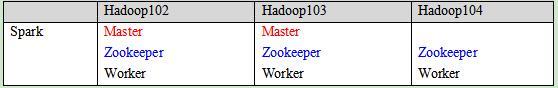

集群規劃:

1) 停止集群

- sbin/stop-all.sh

2) 啟動Zookeeper

3) 修改spark-env.sh文件添加如下配置

- 注釋如下內容:

- #SPARK_MASTER_HOST=hadoop102#SPARK_MASTER_PORT=7077

- 添加如下內容:#Master監控頁面默認訪問端口為8080,但是會和Zookeeper沖突,所以改成8989,也可以自定義,訪問UI監控頁面時請注意

- SPARK_MASTER_WEBUI_PORT=8989

- export SPARK_DAEMON_JAVA_OPTS="

- -Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=hadoop102,hadoop103,hadoop104 -Dspark.deploy.zookeeper.dir=/spark"

注:寫成一行!!空格隔開!!!

4) 分發配置文件

- xsync conf/

5) 啟動集群

- sbin/start-all.sh

6) 啟動hadoop103的單獨Master節點,此時hadoop103節點Master狀態處于備用狀態

- [bigdata@hadoop103 spark-standalone]$ sbin/start-master.sh

7) 提交應用到高可用集群

- bin/spark-submit \

- --class org.apache.spark.examples.SparkPi \

- --master spark://hadoop102:7077,hadoop103:7077 \

- ./examples/jars/spark-examples_2.12-3.0.0.jar \

- 10

8) 停止hadoop102的Master資源監控進程

9) 查看hadoop103的Master 資源監控Web UI,稍等一段時間后,hadoop103節點的Master狀態提升為活動狀態