牛掰!一次線上商城系統(tǒng)高并發(fā)優(yōu)化實戰(zhàn)!

對于線上系統(tǒng)調(diào)優(yōu),它本身是個技術(shù)活,不僅需要很強(qiáng)的技術(shù)實戰(zhàn)能力,很強(qiáng)的問題定位,問題識別,問題排查能力,還需要很豐富的調(diào)優(yōu)能力。

圖片來自 Pexels

本篇文章站在實戰(zhàn)角度,從問題識別,問題定位,問題分析,提出解決方案,實施解決方案,監(jiān)控調(diào)優(yōu)后的解決方案和調(diào)優(yōu)后的觀察等角度來與大家交流分享線上高并發(fā)調(diào)優(yōu)整個閉環(huán)過程。

項目簡要情況概述

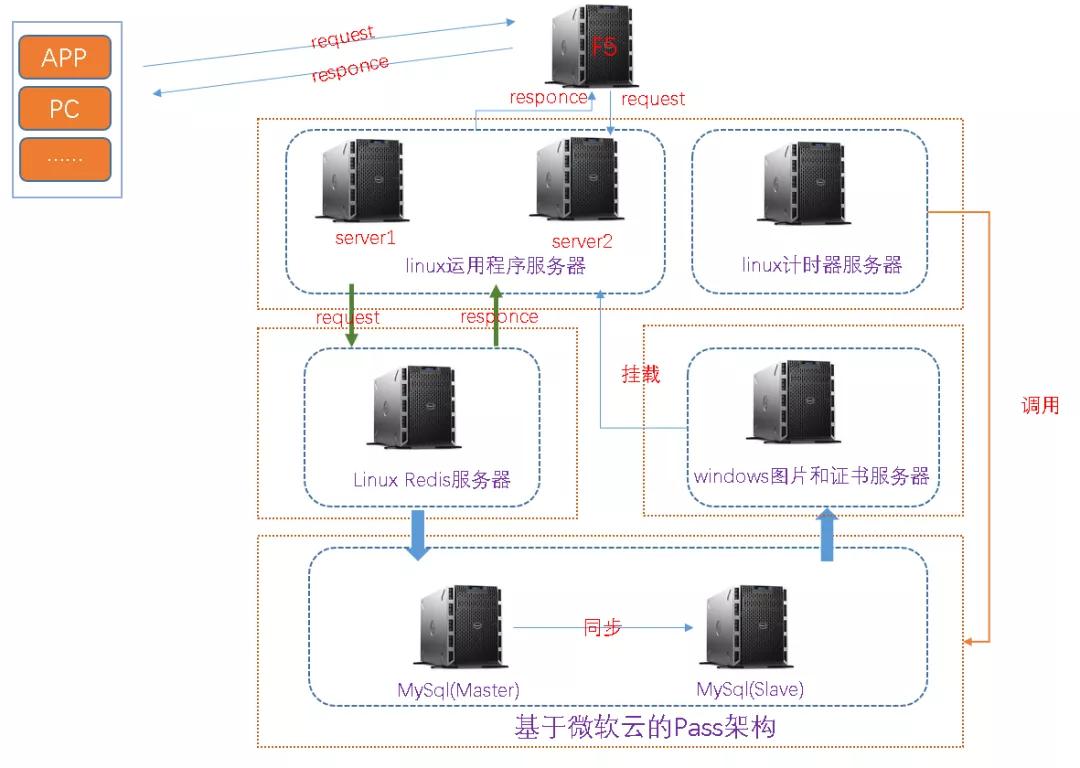

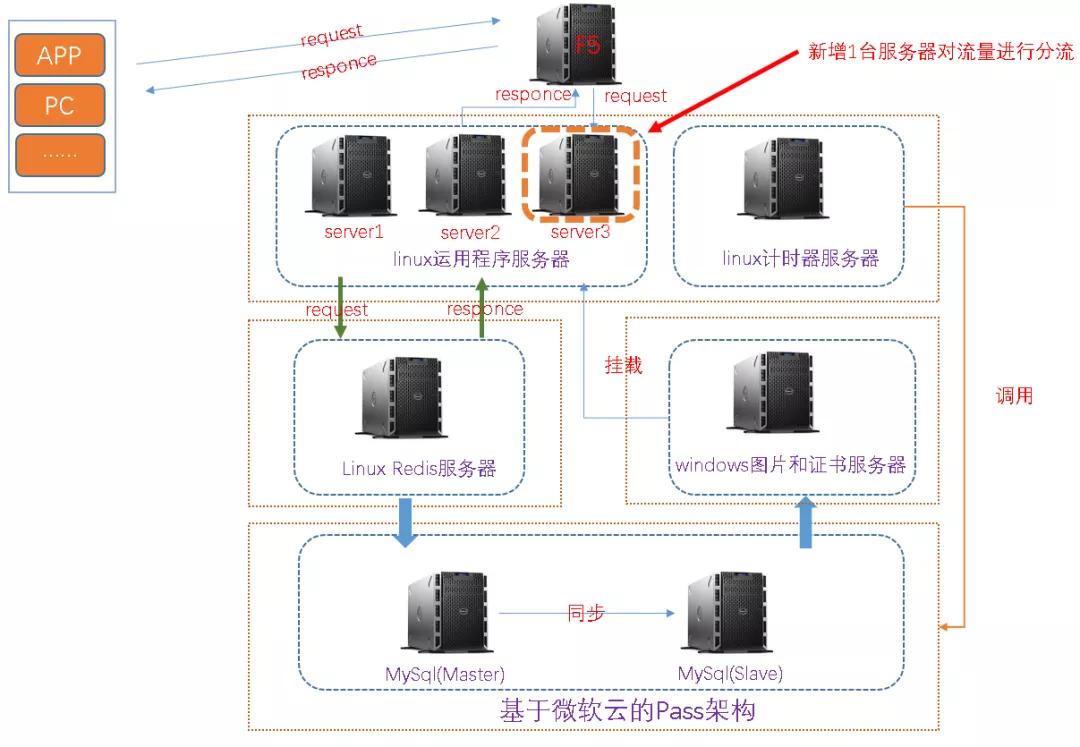

該項目為基于 SSM 架構(gòu)的商城類單體架構(gòu)項目,其中有一個秒殺重磅模塊,如下為當(dāng)前線上環(huán)境的簡要架構(gòu)部署圖。

大致描述一下:

- 項目為 SSM 架構(gòu)。

- 服務(wù)器類別:1 臺負(fù)載均衡服務(wù)器(F5),3 臺運用程序服務(wù)器,1 臺計時器服務(wù)器,1 臺 Redis 服務(wù)器,1 臺圖片服服務(wù)器和 1 臺基于 Pass 架構(gòu)的 MySQL 主從服務(wù)器(微軟云)。

- 調(diào)用邏輯:上圖為簡要調(diào)用邏輯。

何為單體架構(gòu)項目

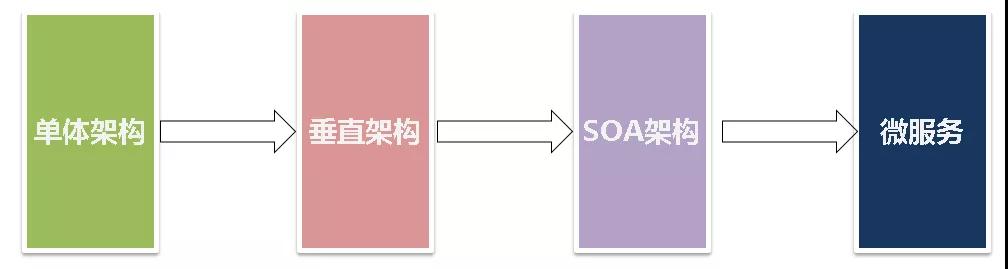

從架構(gòu)發(fā)展角度,軟件項目經(jīng)歷了如下階段的發(fā)展:

- 單體架構(gòu):可理解為傳統(tǒng)的前后端未分離的架構(gòu)。

- 垂直架構(gòu):可理解為前后端分離架構(gòu)。

- SOA 架構(gòu):可理解為按服務(wù)類別,業(yè)務(wù)流量,服務(wù)間依賴關(guān)系等服務(wù)化的架構(gòu),如以前的單體架構(gòu) ERP 項目,劃分為訂單服務(wù),采購服務(wù),物料服務(wù)和銷售服務(wù)等。

- 微服務(wù):可理解為一個個小型的項目,如之前的 ERP 大型項目,劃分為訂單服務(wù)(訂單項目),采購服務(wù)(采購項目),物料服務(wù)(物料項目)和銷售服務(wù)(銷售項目),以及服務(wù)之間調(diào)用。

本 SSM 項目引發(fā)的線上問題

①當(dāng)秒殺的時候,CPU 暴增

該系統(tǒng)每天秒殺分為三個時間端:10 點,13 點和 20 點,如下為秒殺的簡要頁面:

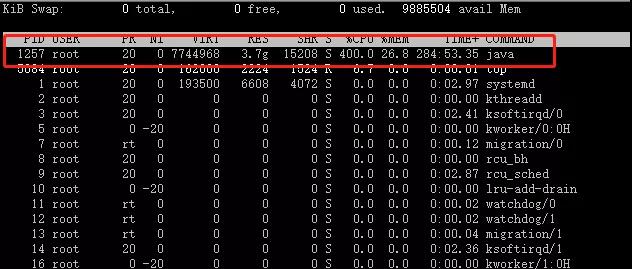

②單臺運用服務(wù)器 CPU

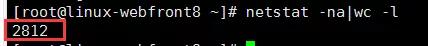

③單臺運用服務(wù)器請求數(shù)

④rdis 連接數(shù)(info clients)

這個未保存截圖,記得是 600 左右:

- connected_clients:600

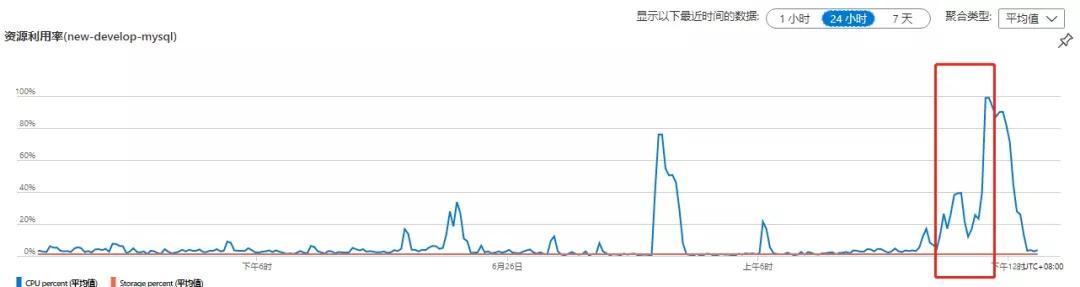

⑤MySQL 請求截圖

排查過程及分析

排查思路

根據(jù)服務(wù)部署和項目架構(gòu),從如下幾個方面排查:

- 運用服務(wù)器:排查內(nèi)存,CPU,請求數(shù)等。

- 文件圖片服務(wù)器:排查內(nèi)存,CPU,請求數(shù)等。

- 計時器服務(wù)器:排查內(nèi)存,CPU,請求數(shù)等。

- Redis 服務(wù)器:排查內(nèi)存,CPU,連接數(shù)等。

- DB 服務(wù)器:排查內(nèi)存,CPU,連接數(shù)等。

排查過程

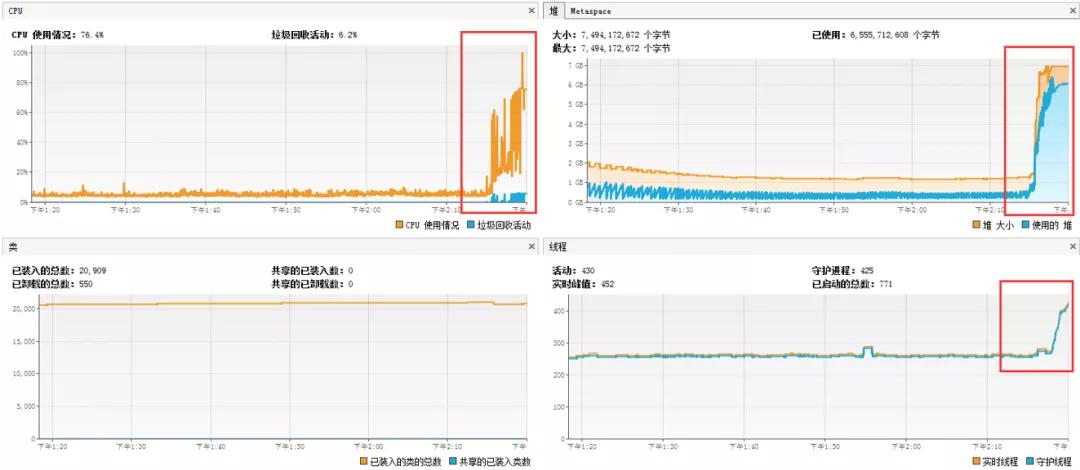

在秒殺后 30 分鐘內(nèi):

①運用程序服務(wù)器 CPU 暴增,內(nèi)存暴增,造成 CPU 和內(nèi)存暴增的根本原因是請求數(shù)過高,單臺運用服務(wù)器達(dá)到 3000 多。

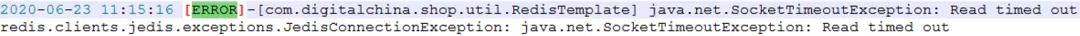

②Redis 請求超時,如下圖:

③JDBC 連接超時,如下圖:

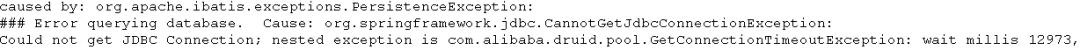

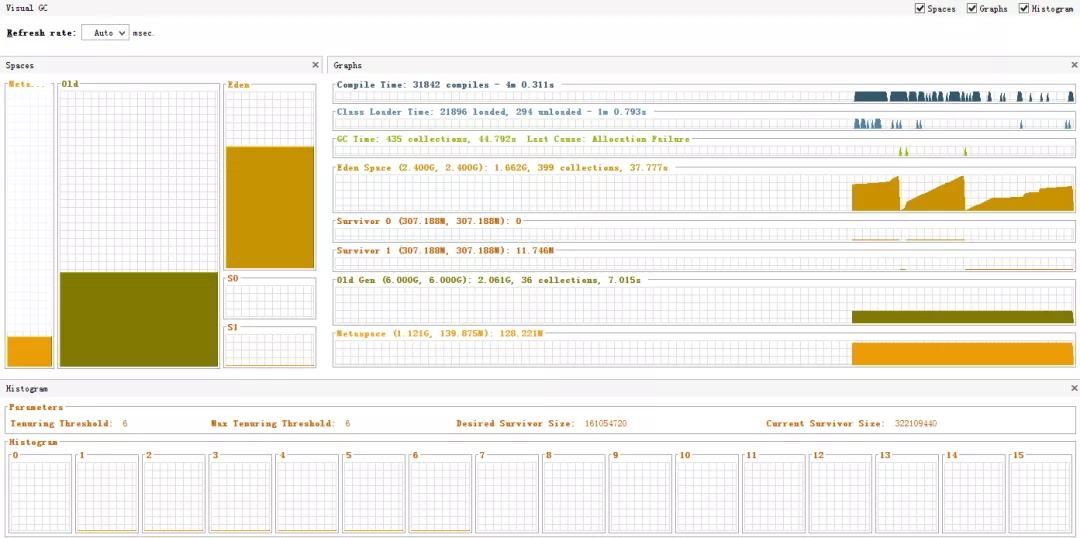

④通過 GC 查看,發(fā)現(xiàn) 24 小時內(nèi),F(xiàn)ullGC 發(fā)生了 152 次,如下圖:

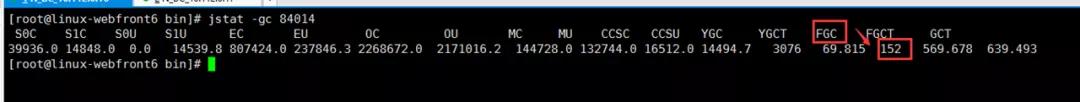

⑤再看看堆棧,發(fā)現(xiàn)有一些線程阻塞和死鎖。

jstat -l pid,也可以通過 VisualVM 分析:

⑥發(fā)現(xiàn)有 2000 多個線程請求無效資源,如下圖:

造成本次系統(tǒng)異常主要因素分析

造成本次系統(tǒng)異常主要因素分析如下:

- 在秒殺時,請求量過高,導(dǎo)致運用服務(wù)器負(fù)載過高。

- Redis 連接池滿,獲取不到連接,connot get a connection from thread pool。

- JDBC 連接池滿,獲取不到連接和超時。

- 存在大對象代碼,如向 List 集合中不停添加對象,不能及時回收對象導(dǎo)致內(nèi)存增加,頻繁發(fā)生 Full GC。

- Tomcat 并發(fā)參數(shù),JVM 優(yōu)化參數(shù),Jedis 配置參數(shù),JDBC 配置參數(shù)不合理。

- 未對請求量進(jìn)行削峰和限流。

- 資源連接未及時釋放,如 Redis 連接,JDBC 連接未及時釋放。

最終解決方案

①增加運用服務(wù),做流量削峰和分流

由于該項目未增加 MQ,因此只能采用硬負(fù)載,增加服務(wù)器水平擴(kuò)展方式來實現(xiàn)流量削峰和流量分流:

②優(yōu)化 JVM 參數(shù),如下為本次優(yōu)化后的參數(shù):

- JAVA_OPTS="-server -Xmx9g -Xms9g -Xmn3g -Xss500k -XX:+DisableExplicitGC -XX:MetaspaceSize=2048m -XX:MaxMetaspaceSize=2048m -XX:+UseConcMarkSweepGC -XX:+CMSParallelRemarkEnabled -XX:LargePageSizeInBytes=128m -XX:+UseFastAccessorMethods -XX:+UseCMSInitiatingOccupancyOnly -XX:CMSInitiatingOccupancyFraction=70 -Dfile.encoding=UTF8 -Duser.timezone=GMT+08"

關(guān)于這個 JVM 參數(shù)的優(yōu)化,JVM 理論是怎樣的,官方建議是怎樣的,實戰(zhàn)是怎樣的,將在下篇文章中分析。

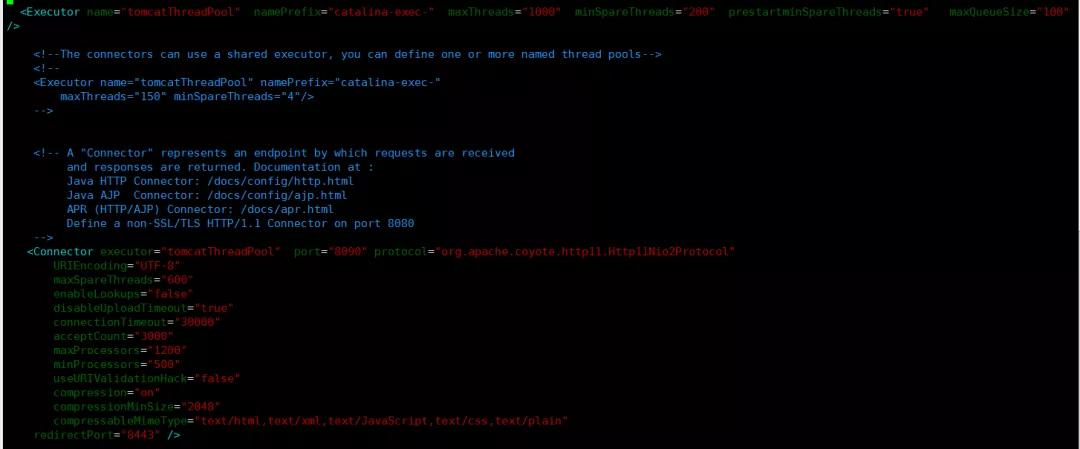

③優(yōu)化 Tomcat 并發(fā)相關(guān)參數(shù)

主要是兩方面:

- 修改 bio 協(xié)議為 nio2 。

- 根據(jù)服務(wù)器配置,業(yè)務(wù)場景,業(yè)務(wù)流量等合理設(shè)置相關(guān)參數(shù),盡量達(dá)到最優(yōu)。

關(guān)于 Tomcat 相關(guān)參數(shù)優(yōu)化,在接下來的文章中分析。

④Redis 和 JDBC 參數(shù)優(yōu)化

由于涉及到安全性問題,這里不列出。

⑤代碼優(yōu)化

代碼優(yōu)化如下:

- 優(yōu)化掉大對象。

- 優(yōu)化未及時釋放的對象和連接資源。

⑥解決 000 多個線程請求無效資源問題:

- 在conf/context.xml增大緩存

- <Resource

- cachingAllowed = "true"

- cacheMaxSize = "102400"

- />

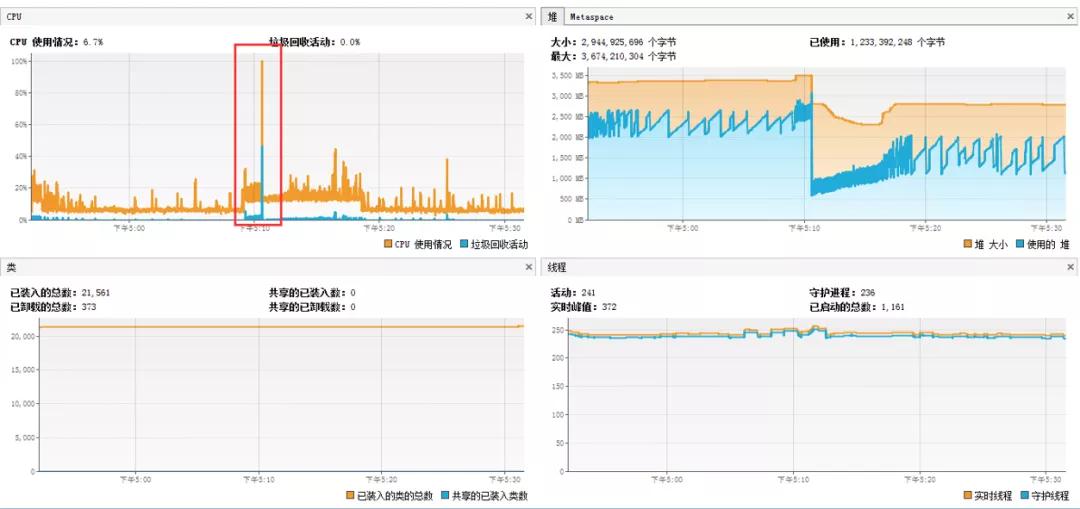

最終優(yōu)化結(jié)果

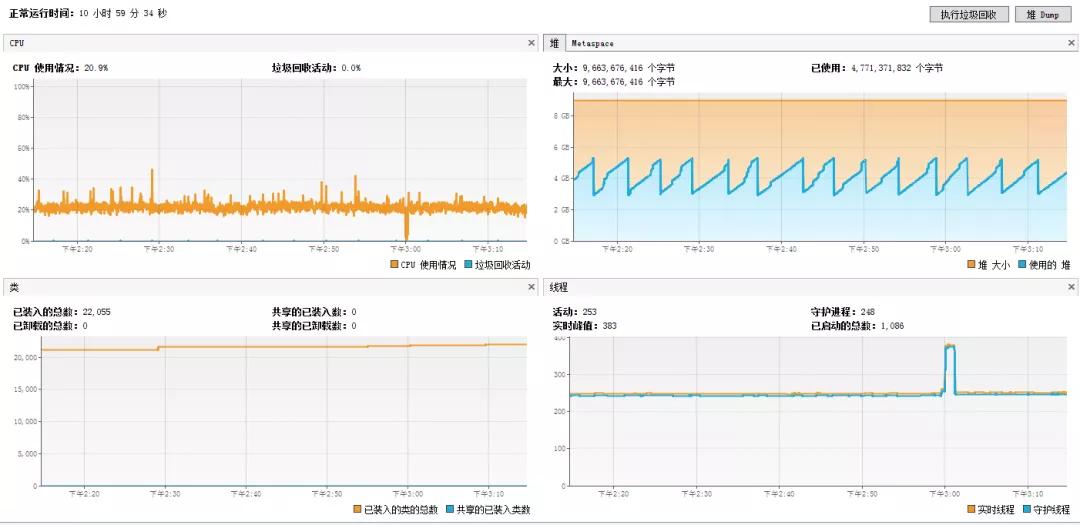

經(jīng)過幾天觀察,系統(tǒng)平穩(wěn)。

基本監(jiān)控,如下圖:

GC,如下圖:

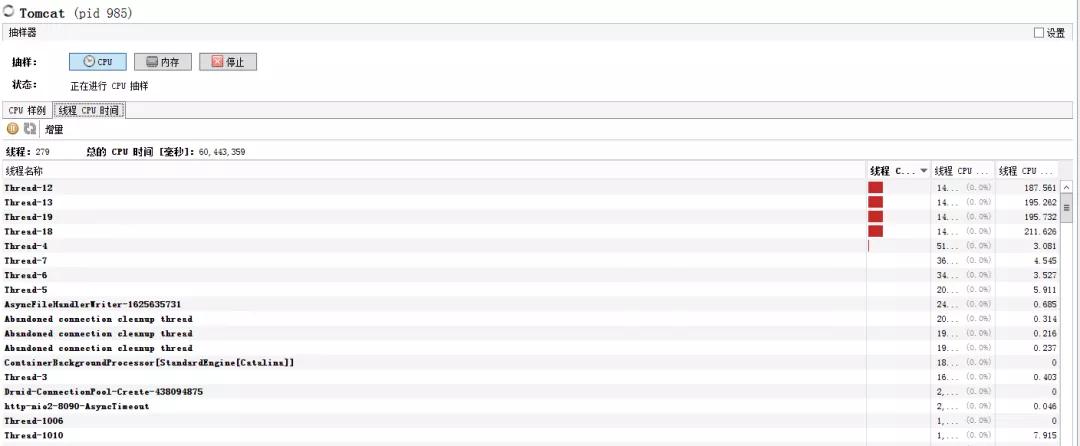

抽樣器 CPU 和內(nèi)存:

總結(jié)

由于篇幅的限制有些細(xì)節(jié)和優(yōu)化手段未在本篇文章中提及。雖然解決了該問題,但是從長遠(yuǎn)來看,該單體項目任然存在很大的問題和隱患。

下面隨便舉幾個:

前后端緊耦合,未分離。

- 由于該系統(tǒng)秒殺業(yè)務(wù)屬于非持續(xù)性并發(fā),即局部性并發(fā),當(dāng)前并未做局部并發(fā)架構(gòu)的調(diào)整。

- 由于該系統(tǒng)秒殺業(yè)務(wù)與該項目緊緊耦合在一起,未進(jìn)行隔離,未獨立成單獨模塊,未單獨部署,從而存在因秒殺業(yè)務(wù)造成整個系統(tǒng)癱瘓的風(fēng)險。

- 未做流量削峰和流量限流,如加 MQ 等軟手段。

- Redis 為做高可用集群。

作者:Alan_beijing

編輯:陶家龍

出處:http://www.cnblogs.com/wangjiming/