揭秘AI基礎設施堆棧,更快部署AI項目

譯文【51CTO.com快譯】隨著許多公司加大對AI的投入,開發人員和工程師面臨越來越大的壓力,要求他們在整個企業更快地在大規模環境下部署AI項目。

在這個快速發展的環境中,僅僅評估不斷擴大的AI工具和服務生態系統是個重大挑戰,這些工具和服務常常是為不同的用戶和目的設計的。

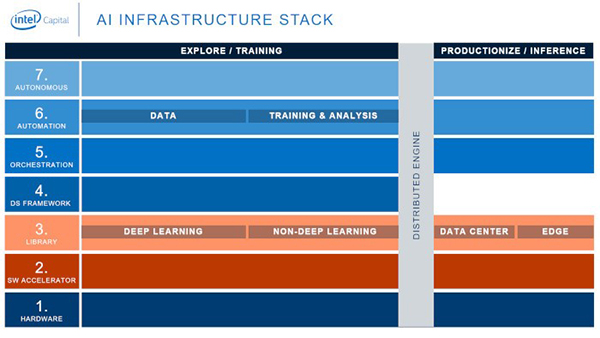

為了應對這一挑戰,我們制作了AI基礎設施堆棧(AI Infrastructure Stack),這個生態圖直觀顯示了AI技術堆棧的各層和每一層內的供應商,更清楚地闡明了AI生態系統。

在英特爾資本公司,這有助于我們確定我們認為將對AI未來產生最大積極影響的投資,但它也有助于開發人員和工程師確定他們需要的資源,以最卓有成效的方式交付AI項目。

圖1. AI基礎設施堆棧

該技術基礎設施堆棧專注于滿足開發AI方面基本需求的橫向解決方案,不管它部署在哪種類型的公司或行業。我們不包括針對特定行業的縱向解決方案。

該堆棧由7層組成,每層又分為兩部分,這包括針對全然不同的工作負載、數據量、計算和內存需求以及SLA構建的解決方案:

- 探索/訓練解決方案,通過算法處理數據并創建模型。

- 生產/推理解決方案,需要建議時,使用經過訓練的模型予以響應——比如識別電子商務網站上“你可能也喜歡”的產品建議,或者決定何時對自動駕駛汽車踩剎車。

連接一切的是企業的分布式引擎——跨計算資源分配工作負載的計算平臺。

棧的層數為:

- 硬件。合適的硬件是在數據中心中運行的訓練解決方案的基礎,也是在數據中心和邊緣設備中運行的推理解決方案的基礎。

- 軟件加速器。這些是用于優化機器學習(ML)庫的編譯器和低級內核。

- 庫。這些是用于訓練ML模型的庫。

- 數據科學框架。這一層包括將庫與其他工具集成起來的工具。

- 編排。這些工具打包、部署和管理ML訓練和模型推理的執行。沒有這一層,DevOps就不可能實現。

- 自動化。這些工具簡化并部分自動化為模型訓練及其他ML任務準備數據的工作。

- 自主。這一層的工具將使構建、部署或維護ML模型的諸方面實現自動化。這就是AI訓練AI的地方。

每一層的工具和服務加速了AI的開發和部署;然而與所有新興技術一樣,在決定使用哪種工具和服務時需要權衡和取舍。比如說,AutoML可以加快ML模型的開發,但是訓練可能不如自定義模型來得準確。

用戶要根據項目的需求來決定在每個層中使用哪些工具和服務。

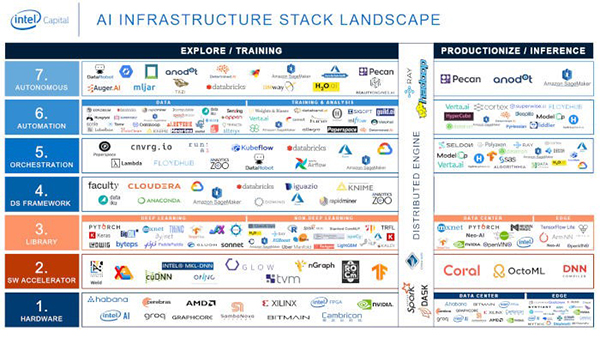

圖2. AI基礎設施堆棧的更高層的詳細視圖。

AI價值鏈的頂端是編排、自動化和自主這幾層——自主層通過使AI更容易被任何人(而不僅僅是數據科學家)訪問和使用,對實現AI的大眾化變得更至關重要。

雖然這幾層是整個堆棧的最新層,其中AI工具和服務支持AI的持續集成和持續部署(CI/CD),不過要注意:創新出現在整個堆棧中——打破新的邊界,提高可用性,并將AI引入到新的社區。

最后,我們用工具、服務和公司(許多是開源)方面的例子來填充模型。它們不包括市場上的所有選擇,它們對考慮AI解決方案的那些人來說就是樣本,每一層都有一系列可靠的選擇。

圖3. AI基礎設施堆棧中工具、服務和公司的代表性例子。

AI不再處于起步階段。對于力求利用AI來改進產品和服務,或者提高效率和改進決策的公司來說,現在有一個豐富的生態系統,其中的諸多工具和服務可用于構建、部署和監控ML和AI模型。

密切關注這個領域的所有動向以及各組成部分如何結合在一起,這關系到你的AI項目的成敗。

原文標題:Demystifying the AI Infrastructure Stack,作者:Assaf Araki

【51CTO譯稿,合作站點轉載請注明原文譯者和出處為51CTO.com】