2019年ML & NLP領域的十大研究熱點

本文轉自雷鋒網,如需轉載請至雷鋒網官網申請授權。

NLP 知名博主 Sebastian Ruder 的年度報告!

2019 年過去了,對于 AI 界而言,過去的一年可謂是“激流勇進”的一年,一方面,整個 AI 界的研究情緒高漲,推動了 AI 技術的迅猛發展;另一方面,迅猛發展的背后,技術的局限性也日益凸顯,研究者們針對這些局限性也在積極探索,并各顯身手地提出了不計其數的新方法和研究方向。

但能從中脫穎而出并產生較大影響力的方法和研究方向,又有哪些?值得在未來一年中繼續深入探索的又有多少?

NLP 領域知名博主 Sebastian Ruder 博士就基于他的研究工作撰寫了一份《2019年ML & NLP 領域十大研究熱點》的總結報道。

我們看他怎么說:

這篇文章匯總了我認為 2019 年在ML 和 NLP 領域出現的十個最振奮人心和具有影響力的研究方向。針對每個熱點,我會總結在過去一年所取得的主要進展,簡述為何我認為其重要,并對未來做一個小小的展望。

以下是這十個研究熱點:

一、通用無監督預訓練

1、發生了什么?

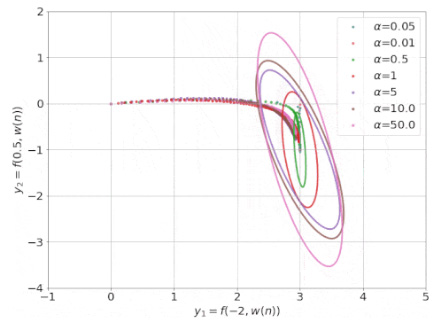

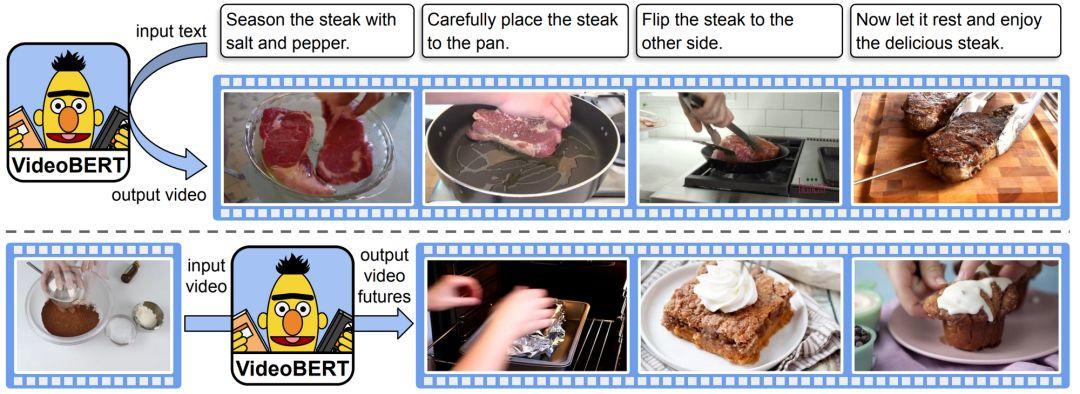

受到BERT (Devlin等人, 2019)及其變體大熱的影響,過去一年中,無監督預訓練是NLP 領域中的一個流行的研究方向。各種 BERT 變體用在了多模態的環境下,主要在涉及圖像,視頻以及文本環境(如下圖所示)。

VideoBERT(Sun等人,2019年),一種最新的BERT多模態變體,根據配方(上面)生成視頻“令牌”,并根據視頻令牌(下面)預測不同時間尺度的未來令牌。

無監督預訓練也開始“入侵”以前由監督方法占主導地位的領域。比如:

在生物學中,有研究者在蛋白質序列上預訓練Transformer語言模型(Rives等人,2019);

在計算機視覺中,也有研究者利用包括CPC(Hénaff 等人,2019),MoCo(He等人,2019)和PIRL(Misra&van der Maaten,2019)以及 BigBiGAN 生成器( Donahue&Simonyan,2019)在內的自監督方法提高 ImageNet 上的樣本效率和改善圖像生成;

在語音方面,使用多層CNN(Schneider等人,2019)或雙向CPC(Kawakami等人,2019)所學得的表示,在更少訓練數據下的表現優于當前最好模型。

2、為什么重要?

無監督預訓練可以在帶有更少標記樣本的數據上訓練模型,這為以前無法滿足數據需求的許多不同領域中的應用提供了新的可能性。

3、接下來是什么?

無監督預訓練仍有很大的進步空間,盡管迄今為止它在單個領域都取得了很大進步,未來將重點放在如何更緊密地集成多模態數據,將是一個有趣的問題。

二、“中獎彩票”子網絡

1、發生了什么?

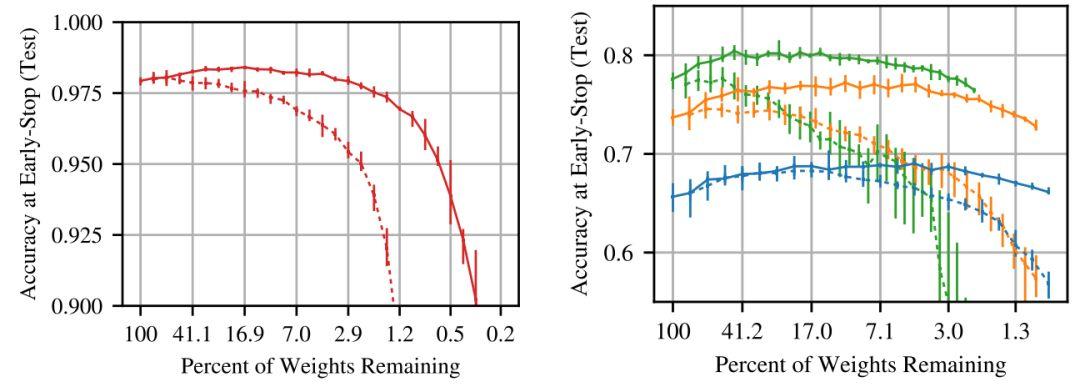

Frankle 和 Carbin 在2019 年的研究中發現了“中獎彩票”現象,即一個隨機初始化、密集前饋網絡中的一些子網經過極好的初始化,以至于單獨訓練這些子網就可達到與訓練整個網絡類似的準確率,如下圖所示。

在不同的剪枝率下測試中獎彩票子網絡(實線)與隨機采樣子網(虛線)的準確性(Frankle&Carbin,2019)。

雖然最初的剪枝程序僅適用于小型視覺任務,但后來的工作(Frankle等人,2019)在訓練的早期而非初始化時應用修剪,這使得剪枝程序可以找到更深層模型的小型子網。Yu等人,(2019)也在NLP和RL模型中發現了LSTM和Transformer的“中獎彩票”初始化。

盡管“中獎彩票”仍然很難找,但好消息是這些“中獎彩票”似乎在不同數據集和優化器之間具有可轉移性(Morcos等人,2019)。

2、為什么重要?

現今神經網絡變得越來越大,用于訓練和預測的成本也越來越高。若能識別出具有可比性能的小型子網,便可以用更少的資源進行訓練和推理,從而可以加快模型的迭代速度,并為設備上計算和邊緣計算提供新的應用場景。

3、接下來是什么?

目前找到“中獎彩票”的代價仍然太高,無法在計算資源匱乏環境下提供實際的好處。修剪過程中不易受噪聲影響且更魯棒的一次性修剪方法或可緩解這種情況。

研究使“中獎彩票”特別的原因,或許還能幫助我們更好地理解神經網絡的初始化以及其學習動力學。

三、神經正切核

1、發生了什么?

這個研究方向可能有點反直覺,具體來說就是無限寬的神經網絡比窄的神經網絡更容易從理論上進行研究。

研究表明,在無限寬的情況下,神經網絡可以近似為帶有神經正切核 (Neural Tangent Kernel ,NTK; Jacot等人, 2018)的線性模型。下圖是其訓練過程的動態圖示。

其中動圖可以查看原文

然而在實踐中,這些模型的表現不如有限深度模型(Novak等人,2019; Allen-Zhu等人,2019;Bietti&Mairal,2019),這限制了將新發現應用于標準方法。

但最近的工作(Li 等人,2019;Arora 等人,2019)已大大縮小了與標準方法的性能差距(具體請參閱Chip Huyen針對其他相關的NeurIPS 2019論文寫的博文,https://huyenchip.com/2019/12/18/key-trends-neurips-2019.html)。

2、為什么重要?

NTK也許是我們分析神經網絡理論行為的最強大的工具,盡管它有其局限性,即實際的神經網絡仍然比 NTK 對應的方法的表現更好。

雖然到目前為止該研究方向理論上的見解還沒有轉化為經驗上的收獲,但這可能有助于我們打開深度學習的黑匣子。

3、下一步是什么?

與標準方法的差距,似乎主要由于此類方法的有限寬度所導致,這些可能會在將來的工作中體現出來。這還將有望幫助將無限寬度限制下的一些理論上的見解轉換得更符合實際設置。

最終,NTK 或可為我們闡明神經網絡的訓練動力學和泛化行為。

四、無監督多語言學習

1、發生了什么?

多年來,跨語言表示主要集中在單詞級別上的表示。在無監督預訓練的基礎上,過去的一年見證了諸如多語言BERT,XLM(Conneau&Lample,2019)和 XLM-R(Conneau等人,2019)等跨語言模型的深入發展。

雖然這些模型沒有使用任何明確的跨語言信號,但它們即便在沒有共享詞匯或聯合訓練情況下實現的跨語言的泛化效果,依舊令人驚訝(Artetxe 等人,2019; Karthikeyan等人,2019; Wu等人,2019 )。

這些深度模型還帶來了無監督 MT 的改進(Song 等人,2019; Conneau&Lample,2019),在前年(2018年)取得了長足的進步基礎上,在去年又從統計和神經方法的更原則性結合中,獲得了改進( Artetxe 等人,2019)。

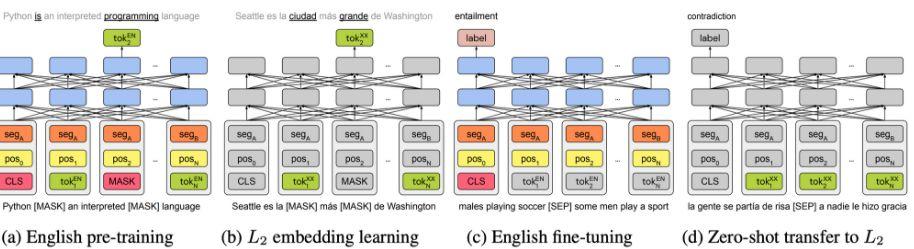

另一個令人振奮的進展則是,從現成的預訓練英語表示中引伸出深層多語言模型(Artetxe等人,2019; Tran,2020),如下圖所示。

Artetxe等人(2019)的單語種遷移方法的四步驟。

2、為什么重要?

即用型跨語言表示使訓練模型所需的非英語語言樣本更少。此外,若可以使用英語標記的數據,則這些方法可實現幾乎免費的零樣本轉移。最終,這些方法可以幫助我們更好地理解不同語言之間的關系。

3、下一步是什么?

目前尚不清楚為什么這些方法在沒有任何跨語言監督的情況下如此有效。更好地了解這些方法的工作方式,將使我們能夠設計出功能更強大的方法,還有可能揭示出關于不同語言結構的一些見解。

另外,我們不僅應該專注于零樣本轉移,還應該在目標語言中考慮小樣本學習問題。

五、更魯棒的基準數據集

當下的發展,定有些烏七八糟的事情。

—Nie et al. (2019) ,引自 Shakespeare《哈姆雷特》(There is something rotten in the state of Denmak,丹麥國里,定有些烏七八糟的事)

1、發生了什么?

針對最近新開發出來的 NLP 數據集如 HellaSWAG (Zellers et al., 2019) ,當前最先進的模型也難以應對。

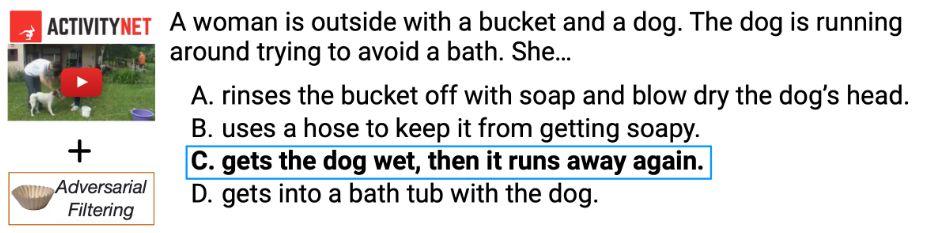

研究者需要人工過濾樣本,僅明了地保留那些當前最先進模型處理失敗的樣本(請參閱下面的示例)。可以重復多次“人在回環”的對抗管理過程,來創建對當前方法更具挑戰性的數據集,例如在最近提出的的 Adversarial NLI(Nie等人,2019)基準測試中,就可以實現這一點。

來自HellaSWAG數據集的多項選擇句補全示例即使對于最新的模型也很難回答。大多數困難的例子都位于一個復雜的“戈爾德洛克區”,大致由三個上下文句子和兩個生成的句子組成(Zellers等人,2019)。

2、為什么重要?

許多研究人員已經觀察到,當前的NLP模型并沒有學到預期學到的內容,而是采用淺層啟發并結合數據中的表層線索的方法(又稱為“聰明漢斯時刻”)。隨著數據集變得更加魯棒難學,我們希望(能迫使)模型最終去學習數據中真正的潛在關系。

3、下一步是什么?

隨著模型變得更好,大多數數據集將需要不斷改進,否則就會很快過時。專用的基礎設施和工具對于促進此過程很有必要。

此外,應在數據集上先運行合適的基準方法,例如,包括使用不同數據變體(例如輸入不完整)的簡單方法和模型,以使數據集的初始版本盡可能魯棒。

六、用于科學研究的 ML 和 NLP

1、發生了什么?

機器學習已在基礎科學問題上取得了一些重大進展。例如,有研究(Pfau等人,2019)將深層神經網絡應用于蛋白質折疊和多電子Schrödinger方程。

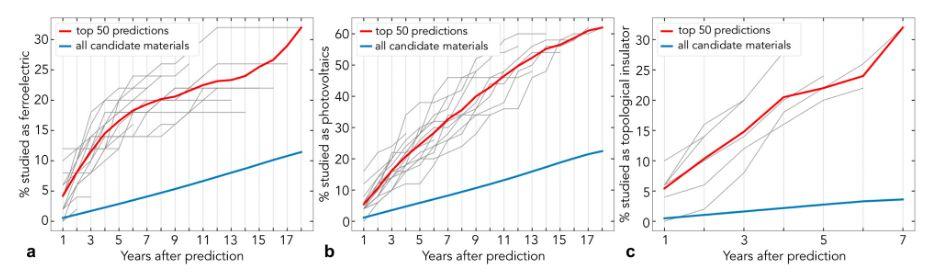

在自然語言處理方面,即便是一些標準方法,在結合領域專業知識后所產生的影響也能令人興奮。其中有一項研究使用詞嵌入技術來分析材料科學文獻中的潛在知識(Tshitoyan等人,2019),以將其用于預測材料是否具有某些特性(請參見下圖)。

使用在不同時間段的摘要上訓練得到的詞嵌入預測將在未來的摘要中研究哪些材料作為鐵電材料(a),光伏材料(b)和拓撲絕緣體(c ),與所有候選材料相比,更有可能對前50個預測材料進行研究(Tshitoyan等人,2019)。

在生物學中,許多數據(例如基因和蛋白質)本質上是序列數據。因此,自然可將LSTM和Transformers等NLP方法用于蛋白質分類(Strodthoff等人,2019; Rives等人,2019)。

2、為什么重要?

科學可以說是ML最有影響力的應用領域之一。解決方案可對許多其他領域產生重大影響,并且有助于解決實際問題。

3、下一步是什么?

從對物理問題中的能量建模(Greydanus等人,2019)到求解微分方程(Lample&Charton,2020),ML方法一直在科學的新應用中不斷擴大。看看2020年在哪種問題上的應用將會產生最大的影響也是挺有趣的。

七、修復 NLG 中的解碼錯誤

1、發生了什么?

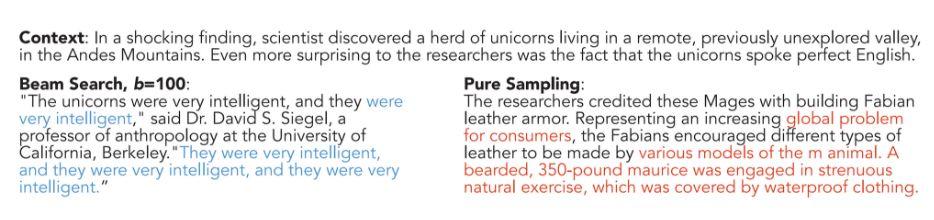

盡管功能越來越強大,但自然語言生成(NLG)模型仍然經常產生重復或胡言亂語,如下圖所示。

GPT-2使用光束搜索和純(貪婪)采樣產生的重復(藍色)和胡言亂語(紅色)(Holtzman等人,2019)。

事實表明,這主要是最大似然訓練的結果。我很高興看到已經有一些旨在改善這一點的研究工作,與此同時,在建模方面也取得了一些進展。這種改進或者通過采用新采樣的方法獲得,例如核采樣(Holtzman等人,2019),或者通過使用新的損失函數獲得(Welleck等人,2019)。

另一個令人驚訝的發現是,更好的搜索不會帶來更好的生成:當前模型在某種程度上依賴于不完善搜索和波束搜索錯誤。在機器翻譯的情況下,精確搜索通常會返回空翻譯(Stahlberg&Byrne,2019)。這表明搜索和建模方面的進步必須齊頭并進。

2、為什么重要?

自然語言生成是NLP中最普遍的任務之一。在 NLP 和 ML 研究中,大多數論文都集中在改進模型上,而流程中的其他部分通常被忽略。

對于NLG,需要注意的是,我們的模型仍然存在缺陷,并且可以通過修復搜索或訓練過程來改善輸出。

3、下一步是什么?

盡管有更強大的模型以及遷移學習在NLG的成功應用(Song等人,2019; Wolf等人,2019),模型預測仍然存在許多瑕疵,識別和理解此類瑕疵的成因,將是未來重要的研究方向。

八、增強預訓練模型

1、發生了什么?

在過去一年,我很高興看到研究者為預訓練模型提出了增加新功能的方法。一些方法用知識庫增強了預訓練模型,以改善實體名稱建模(Liu等人,2019)和事實回憶(Logan 等人,2019)。其它研究則使預訓練模型能夠通過訪問許多預定義的可執行的程序,來執行簡單的算術推理(Andor 等人,2019)。

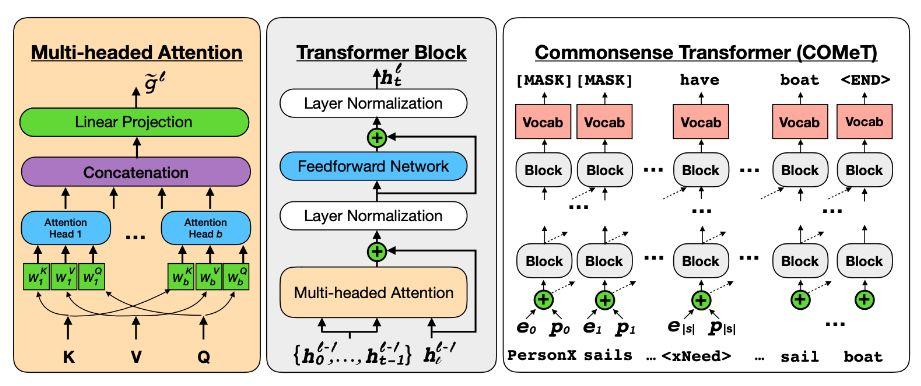

由于大多數模型具有較弱的歸納偏差并可以從數據中學習大多數知識,因此增強預訓練模型的另一種方法是增強訓練數據本身,例如捕捉常識(Bosselut等人,2019),如下圖所示。

具有多頭注意的標準Transformer。經過訓練的模型可以根據給定的主題和關系來預測知識庫三元組的對象(Bosselut等人,2019)。

2、為什么重要?

模型正變得越來越強大,但是模型無法從文本中學到很多東西。特別是在處理更復雜的任務時,可用數據可能十分有限,以至于無法使用事實或常識來學得顯式的推理,并且可能經常需要更強的歸納偏差。

3、下一步是什么?

隨著將模型應用于更具挑戰性的問題,對組合進行修改將變得越來越有必要。將來,我們可能會結合功能強大的預訓練模型和可學習的組合程序(Pierrot等人,2019)。

九、高效長程的 Transformer

1、發生了什么?

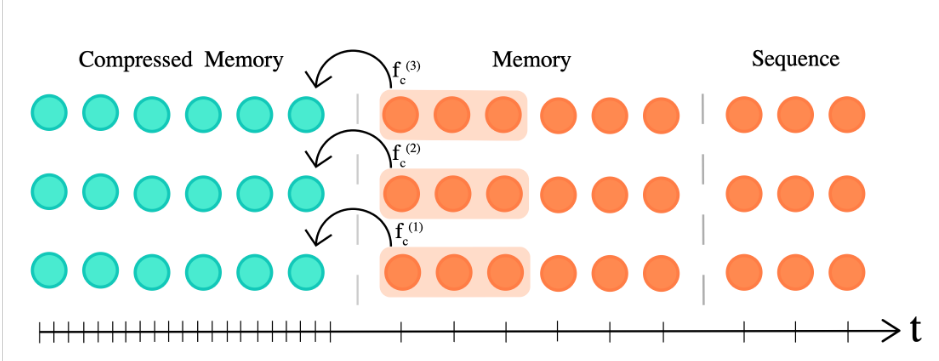

過去一年中,Transformer 架構實現了一些改進(Vaswani等人,2017)。例如Transformer-XL(Dai等人,2019)和Compressive Transformer(Rae等人,2020)使該架構能夠更好地捕獲長程依賴關系。

與此同時,許多方法試圖通過使用不同的(通常是稀疏的)注意力機制來提高 Transformer 的效率,例如利用自適應稀疏注意力(Correia等人,2019),自適應注意力跨度(Sukhbaatar等人,2019),乘積鍵注意力( Lample等人,2019),以及局部敏感哈希(Kitaev等人,2020)等方法,來提高 Transformer 效率。

在基于Transformer 的預訓練方面,出現了更有效的變體,例如使用參數共享的ALBERT(Lan等人,2020)和使用了更有效的預訓練任務的ELECTRA(Clark等人,2020)。不過,也有一些預訓練模型雖然不使用Transformer,但是更加有效,例如一元文件模型 VAMPIRE(Gururangan等人,2019)和基于QRNN的MultiFiT(Eisenschlos等人,2019)。

該領域的另一個趨勢是,將大型 BERT 模型提煉成較小的模型(Tang等人,2019; Tsai等人,2019; Sanh等人,2019)。

2、為什么重要?

Transformer 架構自提出以來,一直極具影響力。它是NLP中大多數最新模型的組成部分,并且已成功應用于許多其他領域(請參見第1和第6節)。因此,對 Transformer 體系結構的任何改進都有可能產生強烈的“波紋效應”。

3、下一步是什么?

從業者從 Transformer 取得的以上改進中獲益可能還需要一段時間,但是鑒于預訓練模型的普遍性和易用性,這段時間也不會太長。

總體而言,強調效率的模型架構有希望繼續成為關注的焦點,稀疏性則是關鍵趨勢之一。

十、更可靠的分析方法

1、發生了什么?

過去的一年中,ML 和 NLP 研究的主要趨勢之一是,分析模型的論文數量在增加。

實際上,過去的一年中我最喜歡的幾篇論文,就是這類分析模型的論文。2019 年早些時候,Belinkov 和 Glass 曾針對分析方法做了一份非常出色的調查報告。

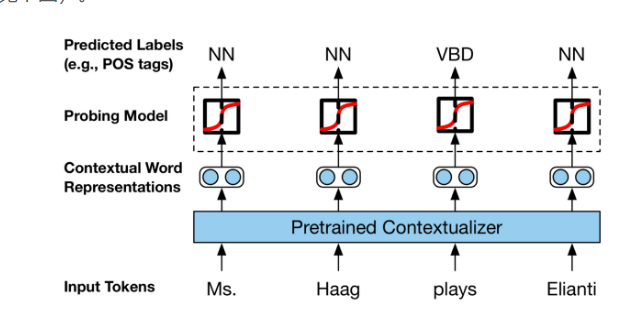

在我的印象中,過去一年首次出現很多致力于分析單個模型 BERT 的論文的現象(此類論文被稱為 BERTology)。在這種情況下,旨在了解模型是否通過預測某些屬性來捕獲形態、語法等的探針,已成為一種常用工具(參見下圖)。

用于研究表示中語言知識的探針的設置(Liu等人,2019)。

我特別贊賞使探針更可靠的論文(Liu 等人,2019 ; Hewitt&Liang,2019)。而可靠性也正是對話領域發展道路上關于注意力是否能提供有意義解釋的研究主題(Jain&Wallace,2019; Wiegreffe&Pinter,2019; Wallace,2019)。

最近ACL 2020 上關于 NLP 模型的可解釋性和模型分析的Track 論文,就是人們對分析方法的持續興趣的最好例證。

2、為什么重要?

實際上,當前最先進的分析方法使用起來往往是一個黑匣子。為了開發更好的模型并在現實世界中應用它們,我們需要了解為什么模型會做出某些決定。然而,我們目前用于解釋模型預測的方法仍然十分有限。

3、下一步是什么?

我們需要做出更多的工作來解釋可視化范圍之外的預測,因為這些預測通常是不可靠的。這個方向上的一個重要趨勢是,更多數據集正在提供人為解釋(Camburu等人,2018; Rajani等人,2019; Nie等人,2019)。

所有文中提到的相關論文和工作,可以前往原文地址 https://ruder.io/research-highlights-2019/ 獲取。