百度高級安全工程師吳登輝:Web防火墻大數據分析實踐

原創吳登輝表示,本次分享是站在一個甲方的角度,詳細的闡述了利用大數據安全分析技術對百度Web防火墻的海量日志包括訪問日志和攔截日志進行多角度分析,帶大家感知未知Web攻擊,并為其他安全產品提供情報支持。

安全運維體系里最常見的四大痛點

透過百度的安全體系建設,安全建設之困主要有主動漏洞發現、WAF和IPS做的攻擊阻斷、IDS做的攻擊檢測、XSRC或者Wooyun做的漏洞報告四方面的痛點。

主動漏洞發現。主動漏洞發現掃描器到底能發現多少個漏洞,這是個未知答案。因為存在身份認證和掃描器URL不全問題。對于一些需要身份認證的掃描頁面,假如用戶是一條刪除記錄的操作,掃描很可能給線上業務帶來傷害。如果在公司用掃描器時,帶上身份認證進行登錄的形式,很有可能造成線上數據一團糟。 掃描器UIL為什么不全,是因為有很多URL不一定爬蟲能夠爬到,是受限于爬蟲的。

攻擊阻斷。不要以為發布WAF和IPS就不備受攻擊,使用WAF不是百分之百解決你的問題,它只是使你的黑客攻擊更加困難了而已。黑客只要想攻擊,他還是有辦法的。

攻擊檢測。傳統的攻擊檢測是上了一臺設備,做了攻擊檢測,運維人員應都有感受。當Web黑客用掃描器時,如遇某種情況,掃描器會觸發一千多條報警,面臨運維人員每天面臨這樣幾千條報警,放棄是必然。

漏洞報告。感覺利用XSRC能夠能夠攔截到攻擊,不被發現。真實情況是在被黑以后,黑客怕被警察抓,就在黑完之后,在Wooyun上發報告,以顯示自己是一個白帽子。但是他在你網站上做了什么事情,并無人知曉。

從入侵檢測角度談大數據安全

了解綜上這些甲方苦逼運維人員的痛苦之后,我們從從一個入侵檢測角度來談大數據安全。吳登輝表示,入侵檢測并不是針對一條報警,畫一個攻擊圖,說哪個IP在哪個地方攻擊你,展示在大屏幕上里,這樣做并沒有實際意義。而是通過從海量數據中發現一些傳統設備發現不了的問題,同時解決某些問題,如解決海量報警的問題。下面將從入侵監測角度從數據采集、數據分析、基礎架構、數據分析實踐四方面談大數據安全。

數據采集。數據采集也要講究方法,如把所有系統的數據全部采集過來那是采集狂魔。如只采集系統已有的數據放在集群上是采集懶人。安全數據采集是要有針對性的采集數據,甚至需要開發特定的采集探針,有效的數據會保證你最后的分析事半功倍。

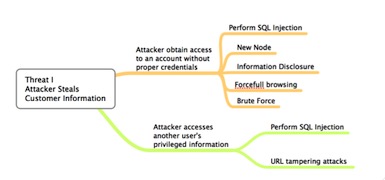

按攻擊樹和Cyber kill Chain采集數據

可按照攻擊樹和Cyber kill Chain來采集數據,構建攻擊場景。黑客到底有多少攻擊手法,來攻擊我們,在這條攻擊路徑上的所有日志,都可以采集來。

數據分析。通過機器學習發現異常,但異常的結果會比較多。其次要人工標定分析,人工標定分析就可以產出一個規則情報,之后將規則情報反饋給分析系統,會產生更多的信息。這個流程其實是一個閉環的,情報是通過我們學習發現異常里面出現的,并且通過分析師分析得出。最終規則情報是反饋給現有分析系統。

基礎架構。如上圖,大數據有很多種系統架構,吳登輝表示,真正的系統架構應該是可以實現交互式搜索,情報易集成可動態配置,支持機器學習模型訓練以及支持實時模型調用。

分析實踐。為了發現繞過Web防火墻的攻擊行為,并提取攻擊情報,包括掃描器payload惡意攻擊IP等。需要從HTTP請求的各個角度,PATH, QUERY, UA, SESSION等多個維度進行分析。并采用基于統計、機器學習,對PATH,QUERY,SESSION等建立模型的分析方法。包括:參數分布,請求頻率,SESSION請求寬度,404比例等。分析實踐有QUERY模型、PATH模型和SESSION模型。

實踐的效果

吳登輝在分享接近尾聲時,分享了實踐效果。他說到:“日輸入數據是3T多,這邊是保守的數據,這是去年一開始3T,現在已經接了安全網的數據,其實是不止3T的。產出的異常,就是3T日志里面異常是十幾兆,經過進一步剝離發現是千條。WAF總共50條規則,給WAF增加了十幾條規則。同時又改善了WAF十幾條規則,也就是說你可以認為WAF大部分規則都被我們這個系統調整過。另外一個發現眾多繞過WAF的Webshell,發現很多有趣的payload”。

講師簡介:

吳登輝,百度高級安全工程師。歷經安全運維,安全測試,安全開發。對企業安全體系建設,以及安全大數據分析具有較為深入的了解。曾就職于華為,負責二進制方面的漏洞挖掘工作。入職百度后,曾負責web安全測試、移動app安全評估以及一些安全規范安全體系的建立等,也參與了百度安全中心的建立。目前,主要負責web日志的安全分析。