基于多租戶的云計算Overlay網絡

云計算已經成為當前企業IT建設的常規形態,而在云計算中大量采用和部署的虛擬化幾乎成為一個基本的技術模式。

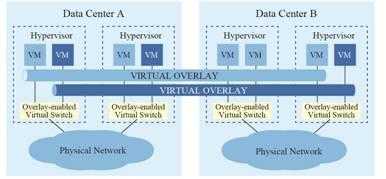

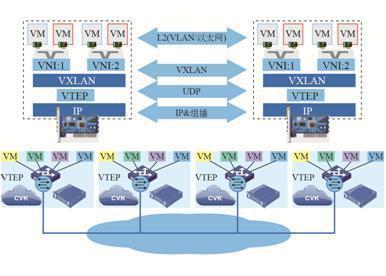

服務器虛擬化技術的廣泛部署,極大增加了數據中心的計算密度,而且,因為虛擬機本身不受物理計算環境的約束,基于業務的靈活性變更要求,需要在網絡中無限制地遷移到目的物理位置,(如圖1所示)虛機增長的快速性以及虛機遷移成為一個常態性業務。

圖1 虛擬化的快速增長及帶來的密集遷移效應

1 云計算虛擬化網絡的挑戰與革新

在云中,虛擬計算負載的高密度增長及靈活性遷移在一定程度上對網絡產生了壓力,然而當前虛擬機的規模與可遷移性受物理網絡能力約束,云中的業務負載不能與物理網絡脫離。

虛擬機遷移范圍受到網絡架構限制

由于虛擬機遷移的網絡屬性要求,其從一個物理機上遷移到另一個物理機上,要求虛擬機不間斷業務,則需要其IP地址、MAC地址等參數維保持不變,如此則要求業務網絡是一個二層網絡,且要求網絡本身具備多路徑多鏈路的冗余和可靠性。傳統的網絡生成樹(STPSpaning Tree Protocol)技術不僅部署繁瑣榮,且協議復雜,網絡規模不宜過大,限制了虛擬化的網絡擴展性。基于各廠家私有的的IRF/vPC等設備級的(網絡N:1)虛擬化技術,雖然可以簡化拓撲簡化、具備高可靠性的能力,但是對于網絡有強制的拓撲形狀限制,在網絡的規模和靈活性上有所欠缺,只適合小規模網絡構建,且一般適用于數據中心內部網絡。而為了大規模網絡擴展的TRILL/SPB/FabricPath/VPLS等技術,雖然解決了上述技術的不足,但對網絡有特殊要求,即網絡中的設備均要軟硬件升級而支持此類新技術,帶來部署成本的上升。

虛擬機規模受網絡規格限制

在大二層網絡環境下,數據流均需要通過明確的網絡尋址以保證準確到達目的地,因此網絡設備的二層地址表項大小(即MAC地址表),成為決定了云計算環境下虛擬機的規模的上限,并且因為表項并非百分之百的有效性,使得可用的虛機數量進一步降低,特別是對于低成本的接入設備而言,因其表項一般規格較小,限制了整個云計算數據中心的虛擬機數量,但如果其地址表項設計為與核心或網關設備在同一檔次,則會提升網絡建設成本。雖然核心或網關設備的MAC與ARP規格會隨著虛擬機增長也面臨挑戰,但對于此層次設備能力而言,大規格是不可避免的業務支撐要求。減小接入設備規格壓力的做法可以是分離網關能力,如采用多個網關來分擔虛機的終結和承載,但如此也會帶來成本的上升。

網絡隔離/分離能力限制

當前的主流網絡隔離技術為VLAN(或VPN),在大規模虛擬化環境部署會有兩大限制:一是VLAN數量在標準定義中只有12個比特單位,即可用的數量為4000個左右,這樣的數量級對于公有云或大型虛擬化云計算應用而言微不足道,其網絡隔離與分離要求輕而易舉會突破4000;二是VLAN技術當前為靜態配置型技術(只有EVB/VEPA的802.1Qbg技術可以在接入層動態部署VLAN,但也主要是在交換機接主機的端口為常規部署,上行口依然為所有VLAN配置通過),這樣使得整個數據中心的網絡幾乎為所有VLAN被允許通過(核心設備更是如此),導致任何一個VLAN的未知目的廣播數據會在整網泛濫,無節制消耗網絡交換能力與帶寬。

對于小規模的云計算虛擬化環境,現有的網絡技術如虛擬機接入感知(VEPA/802.1Qbg)、數據中心二層網絡擴展(IRF/vPC/TRILL/FabricPath)、數據中心間二層技術(OTV/EVI/TRILL)等可以很好的滿足業務需求,上述限制不成為瓶頸。然而,完全依賴于物理網絡設備本身的技術改良,目前看來并不能完全解決大規模云計算環境下的問題,一定程度上還需要更大范圍的技術革新來消除這些限制,以滿足云計算虛擬化的網絡能力需求。在此驅動力基礎上,逐步演化出Overlay的虛擬化網絡技術趨勢。

#p#

2 Overlay虛擬化網絡的技術標準及比較

2.1 Overlay技術形態

Overlay在網絡技術領域,指的是一種網絡架構上疊加的虛擬化技術模式,其大體框架是對基礎網絡不進行大規模修改的條件下,實現應用在網絡上的承載,并能與其它網絡業務分離,并且以基于IP的基礎網絡技術為主(如圖2所示)。其實這種模式是以對傳統技術的優化而形成的。早期的就有標準支持了二層Overlay技術,如RFC3378(Ethernet in IP),就是早期的在IP上的二層Overlay技術。并且基于Ethernet over GRE的技術,H3C與Cisco都在物理網絡基礎上發展了各自的私有二層Overlay技術——EVI(Ethernet Virtual Interconnection)與OTV(Overlay Transport Virtualization)。EVI與OTV都主要用于解決數據中心之間的二層互聯與業務擴展問題,并且對于承載網絡的基本要求是IP可達,部署上簡單且擴展方便。

圖2 Overlay網絡模型

隨著云計算虛擬化的驅動,基于主機虛擬化的Overlay技術出現,在服務器的Hypervisor內vSwitch上支持了基于IP的二層Overlay技術,從更靠近應用的邊緣來提供網絡虛擬化服務,其目的是使虛擬機的部署與業務活動脫離物理網絡及其限制,使得云計算的網絡形態不斷完善。(如圖3所示)主機的vSwitch支持基于IP的Overlay之后,虛機的二層訪問直接構建在Overlay之上,物理網不再感知虛機的諸多特性,由此,Overlay可以構建在數據中心內,也可以跨越數據中心之間。

圖3 hypervisor支持的二層Overlay

2.2 Overlay如何解決當前的主要問題

針對前文提出的三大技術挑戰,Overlay在很大程度上提供了全新的解決方式。

針對虛機遷移范圍受到網絡架構限制的解決方式

Overlay是一種封裝在IP報文之上的新的數據格式,因此,這種數據可以通過路由的方式在網絡中分發,而路由網絡本身并無特殊網絡結構限制,具備良性大規模擴展能力,并且對設備本身無特殊要求,以高性能路由轉發為佳,且路由網絡本身具備很強的的故障自愈能力、負載均衡能力。采用Overlay技術后,企業部署的現有網絡便可用于支撐新的云計算業務,改造難度極低(除性能可能是考量因素外,技術上對于承載網絡并無新的要求)。

針對虛機規模受網絡規格限制的解決方式

虛擬機數據封裝在IP數據包中后,對網絡只表現為封裝后的的網絡參數,即隧道端點的地址,因此,對于承載網絡(特別是接入交換機),MAC地址規格需求極大降低,最低規格也就是幾十個(每個端口一臺物理服務器的隧道端點MAC)。當然,對于核心/網關處的設備表項(MAC/ARP)要求依然極高,當前的解決方案仍然是采用分散方式,通過多個核心/網關設備來分散表項的處理壓力。(另一種更分散的方式便是虛擬網絡路由服務方式,詳見后文描述)。

針對網絡隔離/分離能力限制的解決方式

針對VLAN數量4000以內的限制,在Overlay技術中引入了類似12比特VLAN ID的用戶標識,支持千萬級以上的用戶標識,并且在Overlay中沿襲了云計算“租戶”的概念,稱之為Tenant ID(租戶標識),用24或64比特表示。針對VLAN技術下網絡的TRUANK ALL(VLAN穿透所有設備)的問題,Overlay對網絡的VLAN配置無要求,可以避免網絡本身的無效流量帶寬浪費,同時Overlay的二層連通基于虛機業務需求創建,在云的環境中全局可控。

2.3 Overlay主要技術標準及比較

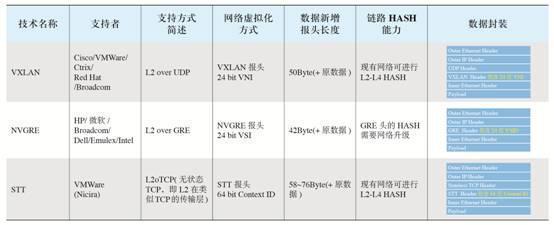

目前,IETF在Overlay技術領域有如下三大技術路線正在討論,為簡單起見,本文只討論基于IPv4的Overlay相關內容(如圖4所示)。

VXLAN。VXLAN是將以太網報文封裝在UDP傳輸層上的一種隧道轉發模式,目的UDP端口號為4798;為了使VXLAN充分利用承載網絡路由的均衡性,VXLAN通過將原始以太網數據頭(MAC、IP、四層端口號等)的HASH值作為UDP的號;采用24比特標識二層網絡分段,稱為VNI(VXLAN Network Identifier),類似于VLAN ID作用;未知目的、廣播、組播等網絡流量均被封裝為組播轉發,物理網絡要求支持任意源組播(ASM)。

NVGRE。NVGRE是將以太網報文封裝在GRE內的一種隧道轉發模式;采用24比特標識二層網絡分段,稱為VSI(Virtual Subnet Identifier),類似于VLAN ID作用;為了使NVGRE利用承載網絡路由的均衡性,NVGRE在GRE擴展字段flow ID,這就要求物理網絡能夠識別到GRE隧道的擴展信息,并以flow ID進行流量分擔;未知目的、廣播、組播等網絡流量均被封裝為組播轉發。

STT。STT利用了TCP的數據封裝形式,但改造了TCP的傳輸機制,數據傳輸不遵循TCP狀態機,而是全新定義的無狀態機制,將TCP各字段意義重新定義,無需三次握手建立TCP連接,因此稱為無狀態TCP;以太網數據封裝在無狀態TCP;采用64比特Context ID標識二層網絡分段;為了使STT充分利用承載網絡路由的均衡性,通過將原始以太網數據頭(MAC、IP、四層端口號等)的HASH值作為無狀態TCP的源端口號;未知目的、廣播、組播等網絡流量均被封裝為組播轉發。

VXLAN NVGRE SST

圖4 三種數據詳細封裝

這三種二層Overlay技術,大體思路均是將以太網報文承載到某種隧道層面,差異性在于選擇和構造隧道的不同,而底層均是IP轉發。如表1所示為這三種技術關鍵特性的比較:VXLAN和STT對于現網設備對流量均衡要求較低,即負載鏈路負載分擔適應性好,一般的網絡設備都能對L2-L4的數據內容參數進行鏈路聚合或等價路由的流量均衡,而NVGRE則需要網絡設備對GRE擴展頭感知并對flow ID進行HASH,需要硬件升級;STT對于TCP有較大修改,隧道模式接近UDP性質,隧道構造技術屬于革新性,且復雜度較高,而VXLAN利用了現有通用的UDP傳輸,成熟性極高。總體比較,VLXAN技術相對具有優勢。

表1 IETF三種Overlay技術的總體比較

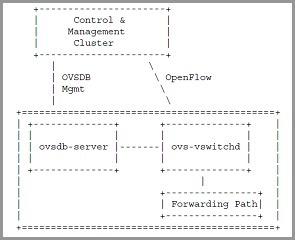

IETF討論的Overlay技術,主要聚焦在數據轉發層面的實現上,控制層面并無涉及,因此在基本實現上依賴于不同廠家的控制層面設計,IETF討論稿《draft-pfaff-ovsdb-proto-02.pdf》則針對Open vSwitch提供了一種控制管理模型的建議(如圖5所示),但在細節實現上仍不是很明確。

圖5 IETF draft討論的OVS管理方式

#p#

3 多租戶的Overlay網絡架構

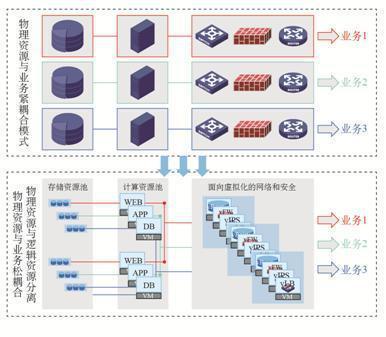

3.1 數據中心虛擬化網絡的發展階段

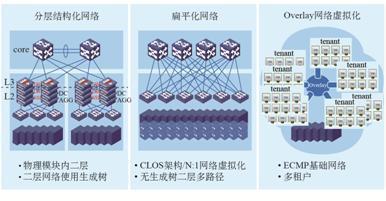

隨著虛擬化技術在數據中心、云計算中的不斷深入應用,伴隨著網絡技術的發展,數據中心的二層組網結構出現了階段性的架構變化(如圖6所示)。

圖6 階段性網絡與虛擬化的匹配

分層結構化網絡

早期的數據中心網絡,虛擬化需求非常少,并沒有強烈的大二層技術要求,多是面向一定的業務應用系統構建網絡模塊,并且規模一般不大,性能要求也不高。數據中心使用多層架構,網關層面比較低,業務的二層訪問基本可以在網絡模塊內解決,只需要通過基礎的生成樹技術來支撐模塊內的二層網路可靠性運行即可。

扁平化網絡

隨著虛擬化在X86架構服務器上的流行及廣泛部署,模塊化的數據中心網絡結構已經不能滿足虛擬機大范圍遷移要求,而生成樹協議的復雜性也嚴重影響大規模網絡的穩定運行。由此網絡本身技術出現適應虛擬化的變革,包含TRILL/FabricPath/VSS/vPC/IRF等新的技術出現并大量部署,同時為了使得網絡進一步感知虛讓你因為機的業務生命周期,IEEE還制訂了802.1Qbg(即VEPA技術)與802.1BR來配合二層網絡技術增強對虛擬機的感知能力。為了保證網絡的高性能業務要求,出現了應對高密虛擬化云計算環境的CLOS網絡架構。

Overlay網絡虛擬化

當進入云計算時代,云的業務需求與網絡之間出現了前文提到的挑戰,網絡技術再次發生變革,以Overlay的虛擬化方式來支撐云與虛擬化的建設要求,并實現大規模的多租戶能力,網絡進入Overlay虛擬化架構階段。

3.2 Overlay網絡的組成模式

Overlay的本質是L2 Over IP的隧道技術,在服務器的vSwitch、物理網絡上技術框架已經就緒,并且從當前的技術選擇來看,雖然有多種隧道同時實現,但是以L2 over UDP模式實現的VXLAN技術具備較大優勢,并且在ESXi和Open vSwitch、當前網絡的主流芯片已經實現,預計會成為主流的Overlay技術選擇,因此后文的Overlay網絡均參考VXLAN相關的技術組成描述,其它NVGRE、STT等均類似。

Overlay網絡架構有多種實現,就純大二層的實現,可分為主機實現方式和網絡實現方式;而在最終實現Overlay與網絡外部數據連通的連接方式上,則更有多種實現模式,并且對于關鍵網絡部件將有不同的技術要求。

3.2.1 基于主機的Overlay虛擬化網絡

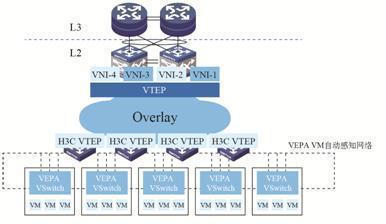

(如圖7所示)目前的虛擬化主機軟件在vSwitch內支持VXLAN,使用VTEP(VXLAN Tunnel End Point)封裝和終結VXLAN的隧道。

圖7 基于主機的Overlay虛擬化網絡

VXLAN運行在UDP上,物理網絡只要支持IP轉發,則所有IP可達的主機即可構建一個大范圍二層網絡。這種vSwitch的實現,屏蔽了物理網絡的模型與拓撲差異,將物理網絡的技術實現與計算虛擬化的關鍵要求分離開來,幾乎可以支持以太網在任意網絡上的透傳,使得云的計算資源調度范圍空前擴大。

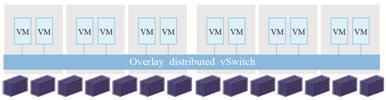

特別的,為了使得VXLAN Overlay網絡更加簡化運行管理,便于云的服務提供,各廠家使用集中控制的模型,將分散在多個物理服務器上的vSwitch構成一個大型的、虛擬化的分布式Overlay vSwitch(如圖8所示),只要在分布式vSwitch范圍內,虛擬機在不同物理服務器上的遷移,便被視為在一個虛擬的設備上遷移,如此大大降低了云中資源的調度難度和復雜度。

圖8 分布式Overlay vSwitch

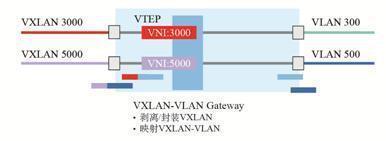

基于主機的Overlay網絡數據流量出入物理網絡,需要實現VXLAN的Overlay流量與傳統的以太網數據流量之間的封裝與解封裝過程,而執行這個過程操作的功能點,被稱為Overlay/VXLAN Gateway(如圖9所示)。因為VXLAN網絡的VTEP功能點本身就是VXLAN的封裝與解封裝隧道點,因此VXLAN Gateway首先需要具備VTEP功能,形態可以是vSwitch、物理交換機等,只是對于網絡中的虛機或其它設備地址表項的處理有所差異。

圖9 Overlay Gateway(VXLAN)

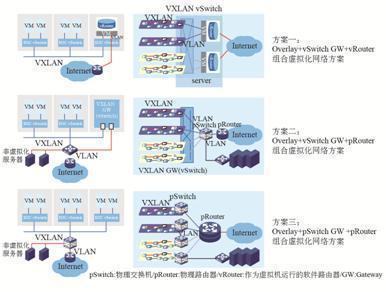

VXLAN Ovelay網絡與物理網絡連通有以下三種組網方案(如圖10所示)。

方案一:Overlay虛擬化網絡+vSwitch GW+vRouter

Overlay的vSwitch本身具備隧道的封裝與解封裝能力,因此,H3C提供一種虛擬路由器來配合這種基本方式。將在硬件路由器中運行的軟件vSR(基于H3C Comware平臺的路由軟件包)作為虛擬機運行在主機中,提供Overlay網絡的虛擬路由功能(即vRouter能力),vRouter的接口同時連接到VXLAN的網絡和VLAN基本功能的物理網絡。從vSwitch接收到的VXLAN數據包被解除封裝后,進入vRouter路由接口,可以被路由到外部網絡;反之,vRouter接收到外部網絡的數據可以進入VXLAN網絡。

該方案的好處是:涉及Overlay的功能均在主機虛擬化環境vSwitch實現,并且虛擬路由功能使得Overlay網絡部署更加靈活,極大降低外部物理網絡要求。

方案二:Overlay虛擬化網絡+vSwitch GW+pRouter

本方案使用服務器中的vSwitch專門用作VXLAN的Gateway功能,而數據的路由功能,則由外部網絡物理路由器承擔。該方案除了不具備虛擬路由能力,Overlay的功能也都在主機虛擬化環境vSwitch實現,同時可以支持虛機與非虛擬化的物理服務器之間的二層數據通信要求。

方案三:Overlay虛擬化網絡+pSwitch GW+pRouter

當物理交換機支持VXLAN功能,則pSwitch與vSwicth可以實現Overlay的統一虛擬化組網,物理交換機執行VXLAN Gateway功能,不僅可以實現Overlay網絡在物理網絡上的終結,也可以支持虛機與非虛擬化服務器的混合組網業務,因為基于物理實現(物理交換機+物理路由器),整體網絡可以達到極高性能。

圖10 VXLAN Overlay網絡與物理網絡的連通方案

3.2.2 基于物理網絡的Overlay虛擬化

(如圖11所示)該方案在網絡架構上與TRILL/FabricPath等技術類似,但是因為對于非VTEP要求的網絡只需要IP轉發,它比TRILL/FabricPath構建的成本更低,技術要求也更加簡單,同時也容易構建多個數據中心之間的網絡連接。

為了解決網絡對虛擬機的感知與自動化控制,結合IEEE的802.1Qbg/VEPA技術,可以使得網絡的Overlay與計算虛擬化之間產生關聯,這樣既可以保持服務器內部網絡的簡化,使用基本的VEPA,利用外部網絡強化來保證高能力的控制要求,又在物理網絡Overlay的虛擬化基礎上增強了虛機在云中大范圍調度的靈活性。

圖11 物理網絡的Overlay+VEPA

3.3 基于Overlay網絡的多租戶與網絡服務——H3Cloud云網融合路線

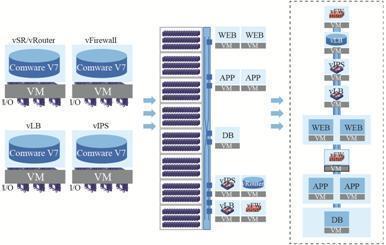

對于計算資源豐富的數據中心,Overlay網絡使得虛擬機不再為物理網絡所限制,但是對于網絡的L4-L7深度服務,在云計算環境下需求更為強烈,資源動態調度的計算環境,需要動態可調度的網絡服務支撐。因此將傳統的L4-L7服務轉換為可云化的、可動態調度的服務資源,成為Overlay網絡環境下的必須集成框架(如圖12所示)。H3C基于Comware V7軟件平臺的L4-L7產品系列,可在虛擬化網絡環境下資源化,以虛擬服務單元運行,分別提供對應路由器、防火墻、負載均衡、深度防御的vSR/vRouter、vFW、vLB、vIPS,利用數據中心計算資源與Overlay網絡集成,提供等同于傳統的L4-L7網絡服務能力。

圖12 Overlay網絡集成服務虛擬化

在Overlay環境下的虛擬化網絡服務,必須具備靈活的可分配性、可擴展性及可調度性,因此,自動化的編排組織能力顯得非常重要(如圖13所示)。除了將虛擬服務資源化,還要具備業務邏輯的組合關聯,這些與物理網絡L4-L7服務的固定配置管理不同,所有的網絡服務資源也是在計算池中,要實現相應的業務關聯和邏輯,難以通過物理網絡實現,在Overlay網絡的連通與編排下則相對易于實現。這種集成思路也將是H3C服務虛擬化的主要模式。

圖13 基于Overlay虛擬化網絡的服務編排

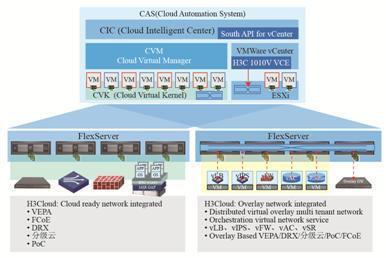

H3C云計算解決方案核心的架構是云網融合。在當前的特色方案系列均充分利用了云計算與物理網絡融合、結合的特點,如:

VEPA——提供網絡計算自動化的感知關聯與自動化部署;

FCoE——統一交換的計算、存儲網絡;

DRX——基于H3C LB與虛擬機管理平臺關聯的虛機資源動態擴展;

PoC(Point of Cloud)——借助云端網絡連通云計算中心與路由器集成X86虛擬化計算部件的統一云分支擴展;

分級云——通過層級化網絡構建縱向層次化云架構。

針對云計算即將進入Overlay階段,H3C的技術路線目標是在H3Cloud架構中進一步實現Overlay虛擬化網絡的融合(如圖14所示)。新一階段的云網融合,不僅包含分布式的Overlay、多租戶的虛擬化網絡,還將不斷集成逐步產品化的虛擬網絡服務部件(目前已經可提供vSR/vFW的服務部件),而對于原有的VEPA/FCoE/DRX/PoC/分級云等方案,將在基于Overlay的虛擬化網絡架構下重新構建和集成,實現技術演進和延續的完整性。

圖14 云網融合:H3Cloud從物理網絡到Overlay虛擬網絡的集成

4 結束語

Overlay的網絡架構是物理網絡向云和虛擬化的深度延伸,云的資源化能力可以脫離物理網絡的多種限制,但兩個網絡本身卻是需要連通交互才能實現云的服務能力,隨著技術的發展,主機的Overlay技術也將向硬件化發展,并逐步會成為物理網絡的一部分。但Overlay尚沒有深度成熟,還需要較長時間發展和應用,其中的問題會逐步暴露和解決。