高效、可泛化的高斯重建框架,只需3張視圖即可快速推理,45秒便可完成優化

3D 重建和新視圖合成技術在虛擬現實和增強現實等領域有著廣泛的應用。NeRF 通過隱式地將場景編碼為輻射場,在視圖合成上取得了顯著的成功。然而,由于 NeRF 依賴于耗時的逐場景優化,極大地限制了其實用性。為了解決這一問題,出現了一些可泛化的 NeRF 方法,旨在通過網絡前饋的方式從多視圖中重建場景。然而,由于基于 NeRF 的方法需要在射線上查詢密集的點進行渲染,因此速度受到了限制。最近,3D Gaussian Splatting(3D-GS)采用了各向異性 3D 高斯來顯式表示場景,并通過可微分的光柵化器實現了實時高質量的渲染。

然而,3D-GS 同樣依賴于每個場景的優化,每個場景需要幾十分鐘的時間。為了解決這個問題,后續出現了一些泛化性的高斯重建工作,嘗試將 3D-GS 推廣到未見過的場景,然而,這些方法的訓練和渲染效率還有待提升且主要局限于物體或人體的重建。

基于此,來自華中科技大學、南洋理工大學、大灣區大學和上海人工智能實驗室的研究者聯合提出了一種高效的、可泛化的高斯重建模型,稱為 MVSGaussian,用于未見過的一般場景的新視圖合成。

- 論文名稱:Fast Generalizable Gaussian Splatting Reconstruction from Multi-View Stereo

- 論文地址:https://arxiv.org/abs/2405.12218

- 項目主頁:https://mvsgaussian.github.io/

- 代碼開源:https://github.com/TQTQliu/MVSGaussian

- 演示視頻:https://youtu.be/4TxMQ9RnHMA

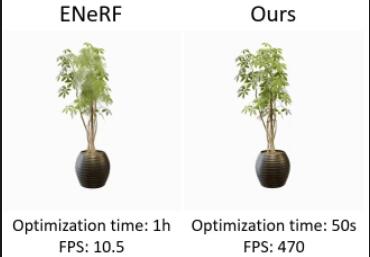

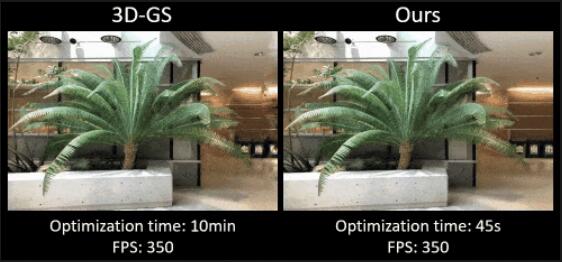

該模型能夠從稀疏多視角圖像中學習場景的 3D 高斯表征。通過結合多視角立體(MVS)的顯式幾何推理和高斯濺射實時渲染的優勢,MVSGaussian 在泛化推理上表現出色,能夠以最快的速度實現最佳的視圖渲染質量。此外,MVSGaussian 在逐場景優化方面也有顯著優勢,僅需 45 秒(約為 3D-GS 的 1/10)即可完成高質量的實時渲染。

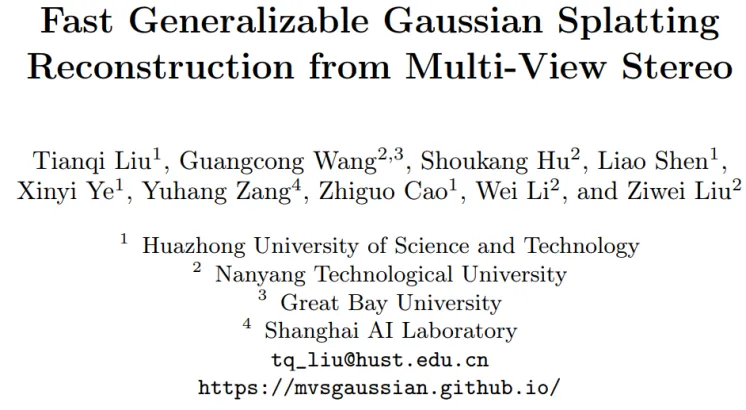

圖 1 無論是泛化推理還是逐場景優化,MVSGaussian 在視圖質量、渲染速度和優化時間都表現出了明顯的優勢。

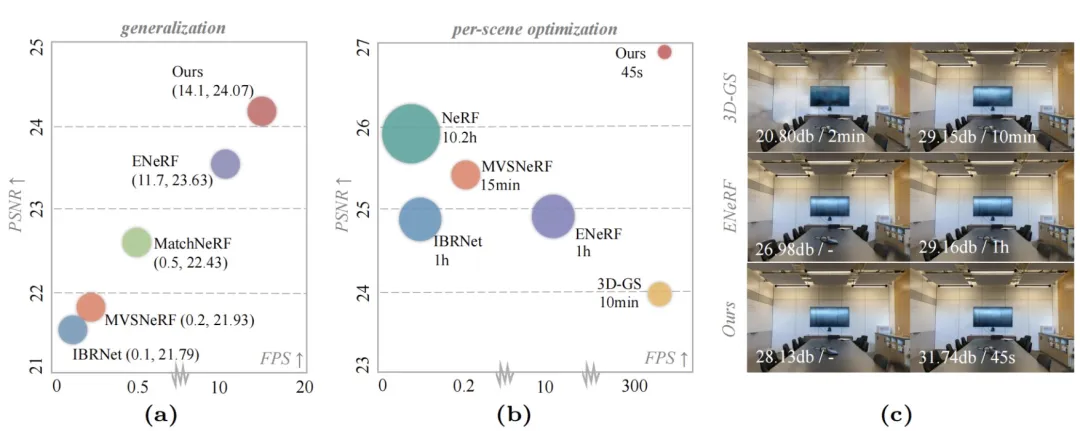

圖 2 渲染視圖質量隨優化時間(迭代次數)的變化對比。由于可泛化模型提供了良好的初始化,MVSGaussian 后續只需要較短的優化時間 (較少的迭代次數) 便可以實現高質量的視圖合成。

基本原理

設計一種高效的、可泛化的高斯濺射框架,我們面臨以下幾個關鍵挑戰:

1)與使用隱式表示的 NeRF 不同,3D-GS 顯式地使用數百萬個 3D 高斯球來表達場景。將預訓練的 3D-GS 應用于未見過的場景時,3D 高斯球的參數(如位置和顏色)會顯著不同。設計一種通用的表征來適配 3D-GS 是一項非平凡的任務。

2)可泛化 NeRF 方法通過體渲染實現了令人印象深刻的視圖合成效果。然而,高斯濺射的泛化能力尚未被充分探索。在濺射過程中,每個高斯球會對圖像的某一區域內的多個像素做出貢獻,同時每個像素的顏色由多個高斯球的貢獻累積得到。高斯球和像素之間的顏色對應是一個更加復雜的多對多關系,這對模型的泛化能力構成了挑戰。

3)可泛化的 NeRF 方法表明,對特定場景進行進一步微調可以顯著改善合成視圖的質量,但這需要耗費大量時間進行優化。盡管 3D-GS 比 NeRF 更快,但仍然需要較長的時間。因此,設計一種基于可泛化模型進行快速逐場景優化的方法是一個非常有前景的研究方向。

針對上述挑戰,我們給出了我們的解決方案。

1)由于每個場景對應的高斯球的位置分布是不同的,因此我們利用多視角立體(MVS)顯式建模場景的幾何,推理得到深度。接著,我們對估計的深度所對應的 3D 點編碼特征,以建立像素對齊的高斯表征。

2)基于編碼的特征,我們可以通過 MLP 將其解碼為高斯參數,從而利用濺射技術渲染視圖。然而,我們發現這種方式的泛化能力有限。我們的見解是,濺射方式在顏色貢獻方面引入了復雜的多對多關系,即高斯球與像素之間的關系,這對泛化提出了挑戰。因此,我們提出了一種簡單而有效的深度感知的體渲染方法來增強泛化能力,即采用單一采樣點的體渲染方式。最終的渲染視圖是通過對濺射技術和體渲染技術渲染的視圖進行平均得到的。

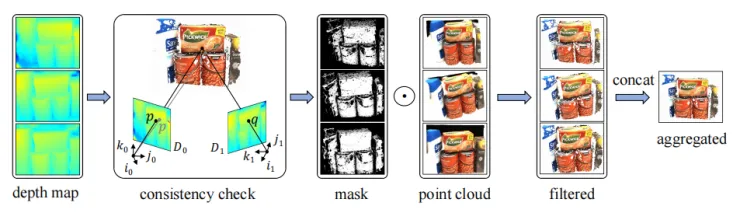

3)預訓練的可泛化模型可以從多個視角生成大量 3D 高斯,這些高斯點云可以作為后續逐場景優化的初始化。然而,由于 MVS 方法的固有局限性,可泛化模型預測的深度可能并不完全準確,導致生成的高斯點云中存在噪聲。直接將這些高斯點云拼接在一起會產生大量噪聲。此外,大量的點會降低后續優化和渲染速度。一個直觀的解決方案是對拼接的點云進行降采樣。然而,雖然能減少噪聲,但也會減少有效點的數量。我們的見解是,一個好的聚合策略應盡可能地減少噪聲點并保留有效點,同時確保點的總數不過大。為此,我們引入了一種基于多視圖幾何一致性的聚合策略。具體而言,我們遵循同一 3D 點在不同視角下的預測深度應具有一致性的原則,通過計算來自不同視角的高斯深度的重投影誤差來濾除噪聲點。

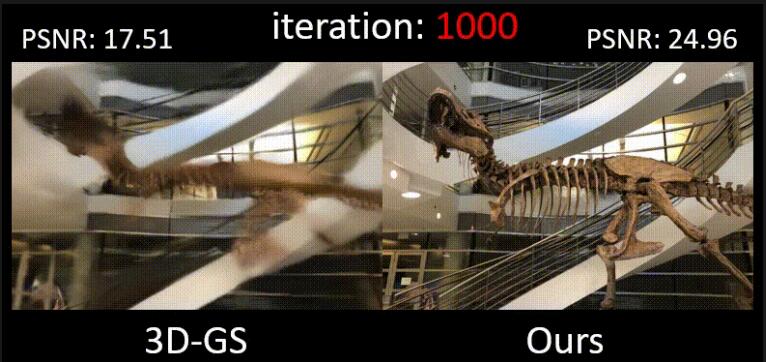

圖 3 可泛化高斯濺射框架。首先使用特征金字塔網絡(FPN)從輸入視圖中提取特征,這些特征被扭曲到目標視角,構建代價體,再通過 3D CNNs 正則化生成深度。接著,對于深度對應的 3D 點,我們通過匯聚多視圖和空間信息編碼特征,建立像素對齊的高斯表征。這些特征隨后被解碼為高斯參數和體渲染參數,通過這兩種方式渲染得到兩個視圖,最終的結果是這兩個視圖的平均值。

圖 4 一致性聚合。使用可泛化模型生成深度圖和高斯點云,我們首先對深度圖進行多視圖幾何一致性檢查,以得到用于過濾不可靠點的 mask。隨后,將經過濾的點云拼接成一個點云,作為逐場景優化的初始化。

結果比較

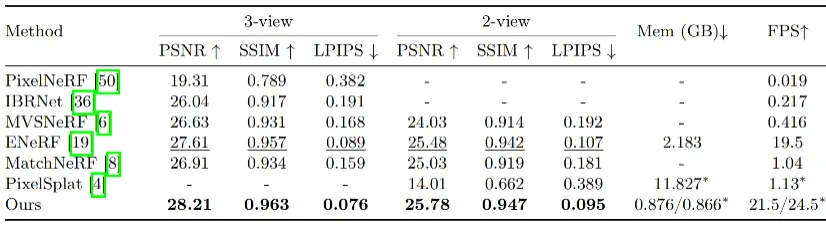

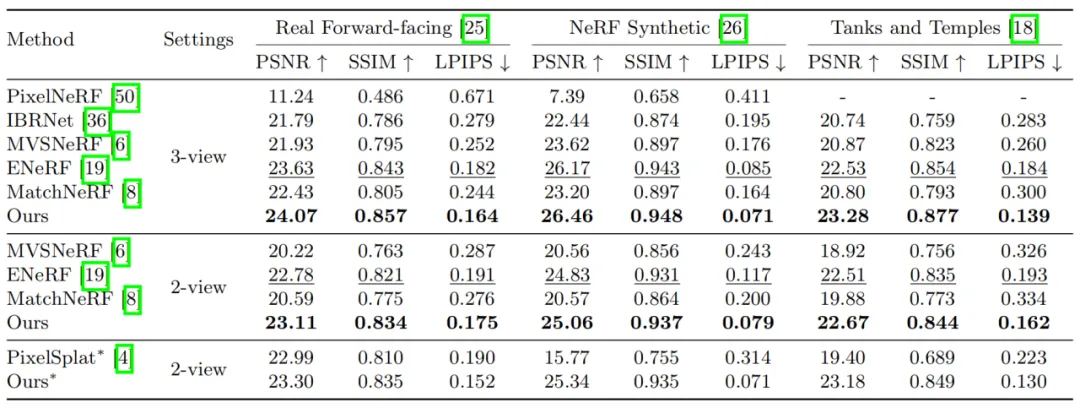

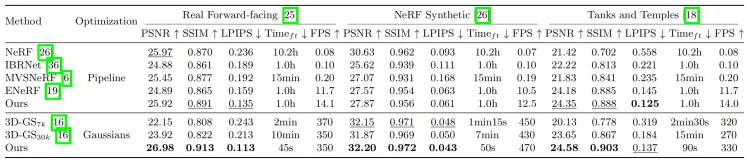

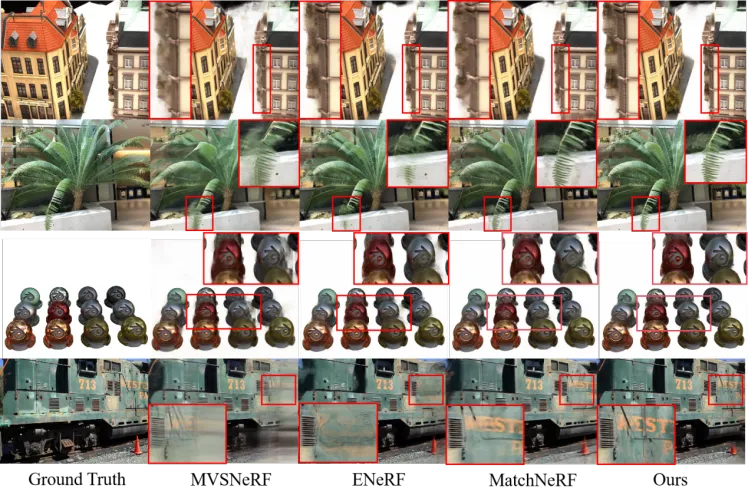

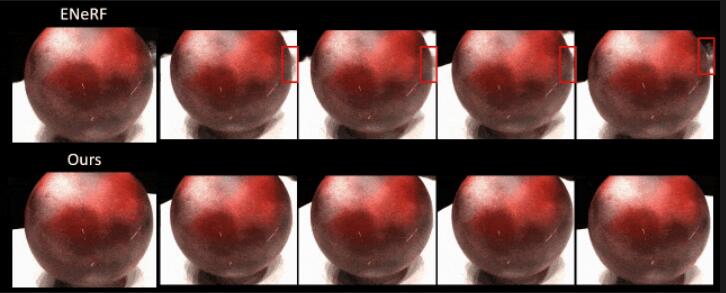

本文在廣泛使用的 DTU、Real Forward-facing、NeRF Synthetic 和 Tanks and Temples 數據集上進行了評估,報告了 PSNR、SSIM、LPIPS 和 FPS 等指標。在泛化推理方面(表 1 和表 2),MVSGaussian 展現出了卓越的性能,以最快的速度和最小的內存開銷實現了更好的性能。在逐場景優化方面(表 3),MVSGaussian 能夠在最短的優化時間內(大約是 3D-GS 的 1/10)實現最佳的視圖合成效果,并且保持了與 3D-GS 相當的實時渲染速度。定性的視圖和視頻對比中也展示了 MVSGaussian 能夠合成高質量的視圖,具有更多的場景細節和更少的偽影。更多視頻結果請見項目主頁。

表 1 DTU 測試集上的泛化定量結果。

表 2 Real Forward-facing、NeRF Synthetic 和 Tanks and Temples 數據集上的泛化定量結果。

表 3 逐場景優化后的定量結果。

圖 5 泛化推理的結果對比。

圖 6 泛化結果的視頻對比

圖 7 逐場景優化后的結果對比。

圖 8 逐場景優化后的視頻對比。

結語

在本文中,我們提出了 MVSGaussian,這是一種新穎的可泛化高斯濺射方法,用于從多視圖中重建場景。具體來說,我們利用 MVS 推理幾何,建立像素對齊的高斯表征。此外,我們提出了一種混合高斯渲染方法,該方法結合了高效的深度感知體渲染以增強泛化能力。除了直接泛化推理外,我們的模型還可以針對特定場景進行快速地微調。為了實現快速優化,我們引入了一種多視圖幾何一致性聚合策略,以提供高質量的初始化。與通常需要數十分鐘微調和幾秒鐘渲染每張圖像的可泛化 NeRF 相比,MVSGaussian 實現了實時渲染,并具有更高的合成質量。

此外,與 3D-GS 相比,MVSGaussian 在減少訓練計算成本的同時,實現了更好的視圖合成效果。大量實驗驗證了 MVSGaussian 在泛化性能、實時渲染速度和快速逐場景優化方面達到了最先進的水平。然而,由于 MVSGaussian 依賴于多視角立體(MVS)進行深度估計,因此它繼承了 MVS 的局限性,例如在紋理較弱或有鏡面反射的區域深度準確性降低,導致視圖質量下降。

本文轉自 機器之心 ,作者:機器之心

原文鏈接:??https://mp.weixin.qq.com/s/Y9uXxNMgliV9p-ne_bGpEw??