ACL 2024 | 提升大模型持續(xù)學(xué)習(xí)性能,哈工大、度小滿提出共享注意力框架SAPT

本論文作者趙偉翔是哈爾濱工業(yè)大學(xué)社會(huì)計(jì)算與信息檢索研究中心 2021 級直博生,導(dǎo)師為趙妍妍教授和秦兵教授,主要研究方向?yàn)閷υ捪到y(tǒng)、大語言模型對齊等。他曾以第一作者在 ACL、AAAI、IJCAI、COLING 等會(huì)議上發(fā)表論文。

個(gè)人主頁: https://circle-hit.github.io/

在大模型實(shí)際部署落地的過程中,如何賦予大模型持續(xù)學(xué)習(xí)的能力是一個(gè)至關(guān)重要的挑戰(zhàn)。這使其能夠動(dòng)態(tài)適應(yīng)新的任務(wù)并不斷獲得新的知識(shí)。大模型的持續(xù)學(xué)習(xí)主要面臨兩個(gè)重大挑戰(zhàn),分別是災(zāi)難性遺忘和知識(shí)遷移。災(zāi)難性遺忘是指模型在學(xué)習(xí)新任務(wù)時(shí),會(huì)忘記其已掌握的舊任務(wù)。知識(shí)遷移則涉及到如何在學(xué)習(xí)新任務(wù)時(shí)有效地應(yīng)用舊任務(wù)的知識(shí)來提升新任務(wù)學(xué)習(xí)的效果。

為了有效應(yīng)對以上難題,哈工大聯(lián)合度小滿推出針對大模型的共享注意力持續(xù)學(xué)習(xí)框架 SAPT,相應(yīng)論文已被自然語言處理頂級會(huì)議 ACL 2024 接收。

- 論文:SAPT: A Shared Attention Framework for Parameter-Efficient Continual Learning of Large Language Models

- 論文地址:https://arxiv.org/abs/2401.08295

研究動(dòng)機(jī)

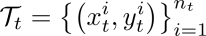

現(xiàn)有面向大模型的持續(xù)學(xué)習(xí)的工作大都基于參數(shù)高效微調(diào) (Parameter-Efficient Tuning, PET) 而開展,并且可以被抽象為由學(xué)習(xí)模塊和選擇模塊組成的工作框架。如圖 1 中虛線所示,當(dāng)新任務(wù)對話生成到達(dá)時(shí),學(xué)習(xí)模塊會(huì)為其分配一個(gè)單獨(dú)的 PET 塊來學(xué)習(xí)任務(wù)特定的知識(shí),然后將其保存在 PET 資源池中,以供后續(xù)在測試樣本到來時(shí)(任務(wù)序號(hào)在測試階段無法獲取),選擇模塊能夠自動(dòng)地為其選擇所屬的 PET 塊,得到測試輸入的結(jié)果。然而,當(dāng)前工作中每個(gè)模塊的設(shè)計(jì)在有效應(yīng)對災(zāi)難性遺忘和知識(shí)遷移挑戰(zhàn)方面都表現(xiàn)出一定的局限性。

一方面,學(xué)習(xí)模塊的設(shè)計(jì)旨在促進(jìn)不同任務(wù)之間的知識(shí)遷移。不幸的是,學(xué)習(xí)模塊分配的 PET 只學(xué)習(xí)當(dāng)前任務(wù)特定知識(shí)的現(xiàn)狀阻斷了存儲(chǔ)在已習(xí)得的 PET 塊中的來自先前任務(wù)知識(shí)的潛在遷移,并阻礙它們協(xié)助當(dāng)前新任務(wù)知識(shí)的獲取。

另一方面,選擇模塊在緩解災(zāi)難性遺忘方面發(fā)揮著關(guān)鍵作用,因?yàn)橹挥挟?dāng)它能夠自動(dòng)選擇當(dāng)前輸入所屬的 PET 塊時(shí),大模型基座才能成功完成當(dāng)前任務(wù)。然而,當(dāng)前工作中基于拼接或相加來自所有任務(wù)的 PET 塊的設(shè)計(jì)無法有效緩解災(zāi)難性遺忘。

更重要的是,他們忽略了將這兩個(gè)模塊進(jìn)行對齊來同時(shí)解決災(zāi)難性遺忘和知識(shí)遷移。直覺上來看(如圖 1 中的實(shí)線所示),為了促進(jìn)新任務(wù)學(xué)習(xí)時(shí)的知識(shí)遷移,學(xué)習(xí)模塊應(yīng)該依靠任務(wù)相關(guān)性來利用先前 PET 塊中最相關(guān)的知識(shí)。而后選擇模塊可以自然地重復(fù)這一注意力過程,通過尋找屬于每個(gè)測試輸入的相應(yīng) PET 塊的組合來抵抗災(zāi)難性遺忘。在本工作中,這種注意力過程被稱為共享注意力。由此,這兩個(gè)模塊的端到端對齊能夠通過這種共享注意力而建立。

問題定義和設(shè)定

持續(xù)學(xué)習(xí)旨在解決學(xué)習(xí)連續(xù)而來的任務(wù)序列中的挑戰(zhàn)。形式上,任務(wù)序列中

每個(gè)任務(wù)依次而來。每個(gè)任務(wù)

包含一個(gè)單獨(dú)的目標(biāo)數(shù)據(jù)集,其大小為 。在任意時(shí)間步 t,模型不僅需要掌握第 t 個(gè)任務(wù),而且還要保持其在之前所有任務(wù)上的性能不發(fā)生明顯衰減。

。在任意時(shí)間步 t,模型不僅需要掌握第 t 個(gè)任務(wù),而且還要保持其在之前所有任務(wù)上的性能不發(fā)生明顯衰減。

在本工作中,我們深入研究更具挑戰(zhàn)性和實(shí)用性的持續(xù)學(xué)習(xí)設(shè)定,即不同任務(wù)的任務(wù)序號(hào)不可獲取:在測試階段,模型面對輸入樣本時(shí)不知道它們屬于哪個(gè)特定任務(wù)。

圖 1 當(dāng)前基于學(xué)習(xí)模塊和選擇模塊進(jìn)行大模型持續(xù)學(xué)習(xí)的概念化框架。其中,虛線表示現(xiàn)有工作的流程,實(shí)現(xiàn)表示本工作提出方法的工作流程。

方法介紹

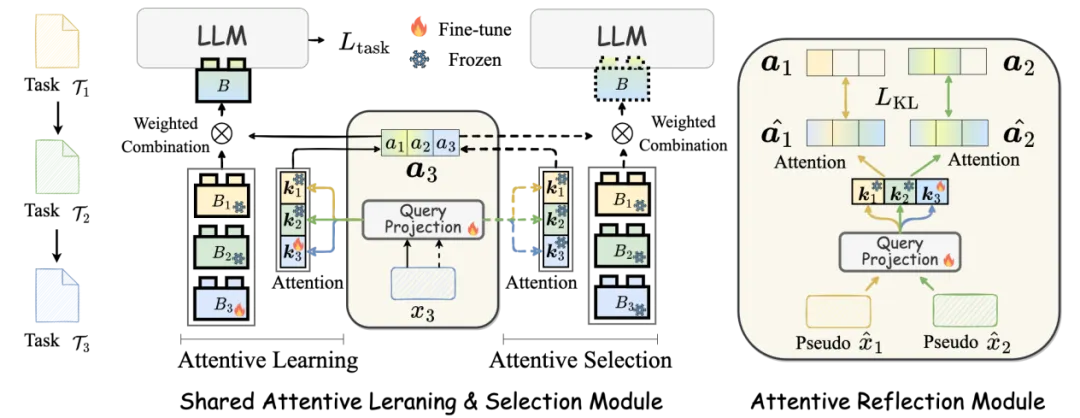

本文提出了針對大語言模型的共享注意力持續(xù)學(xué)習(xí)框架 SAPT,為同時(shí)應(yīng)對災(zāi)難性遺忘和知識(shí)遷移的挑戰(zhàn)提供了有效的解決方案。SAPT 的整體架構(gòu)由兩個(gè)關(guān)鍵組件組成,如圖 2 所示:共享注意力學(xué)習(xí)與選擇模塊(SALS)和注意力反思模塊(ARM)。在 SALS 中,注意力學(xué)習(xí)(實(shí)線)和注意力選擇(虛線)通過共享注意力操作對齊。然后在 ARM 中,我們通過生成的偽樣本幫助 SALS 回憶來自以前任務(wù)輸入對應(yīng)的正確的注意力權(quán)重。

圖 2 我們提出的 SAPT 的整體架構(gòu),有共享注意力學(xué)習(xí)與選擇模塊(左)和注意力反思模塊構(gòu)成(右)。

共享注意力學(xué)習(xí)與選擇模塊(SALS):

- 注意力學(xué)習(xí):為了獲取來自先前任務(wù)的相關(guān)知識(shí),當(dāng)?shù)?t 個(gè)任務(wù)到達(dá)時(shí),通過 Query Projection 層生成查詢向量和可學(xué)習(xí)的鍵值

- 進(jìn)行注意力運(yùn)算,將所有之前的 PET 塊的參數(shù)

- 和當(dāng)前

- 通過加權(quán)組合進(jìn)行聚合,用于第 t 個(gè)任務(wù)的學(xué)習(xí)。

- 注意力選擇:該部分通過重復(fù)注意力學(xué)習(xí)時(shí)的相同的注意力過程,得到現(xiàn)有 PET 塊在每個(gè)輸入樣本上的最佳組合,并結(jié)合到 LLM 上,完成對當(dāng)前樣本的測試。

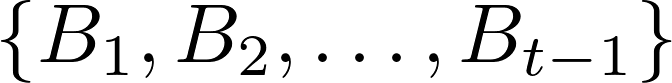

注意力反思模塊(ARM):

然而,隨著依次而來的新任務(wù)不斷更新 SALS 會(huì)導(dǎo)致該模塊僅針對最新任務(wù)進(jìn)行最佳注意力組合,從而導(dǎo)致忘記以前任務(wù)相應(yīng)的注意力組合系數(shù)。由此,ARM 模塊確保來自先前任務(wù)的輸入仍然可以正確地執(zhí)行相應(yīng)的共享注意力操作,以識(shí)別每個(gè)任務(wù)特定的 PET 塊的組合。具體方法基于生成式回放得到偽樣本,用來對 Query Projection 層進(jìn)行約束。

實(shí)驗(yàn)結(jié)果

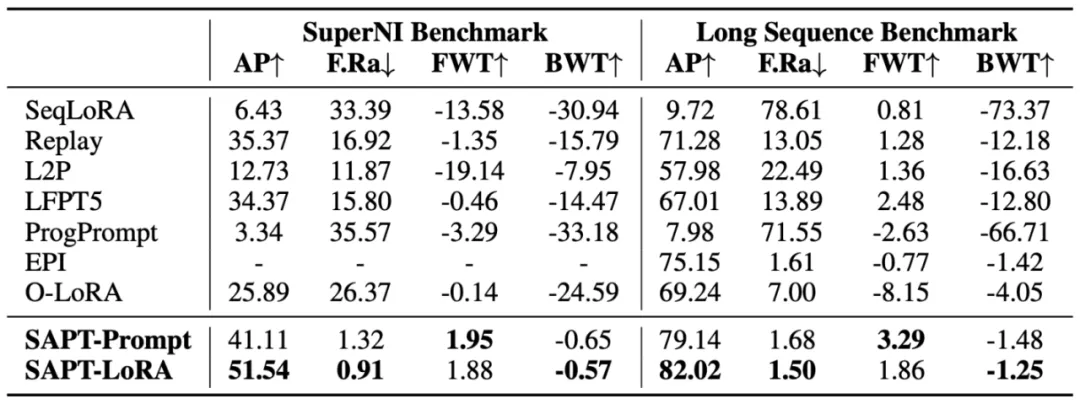

我們基于 Prompt Tuning 和 LoRA 這兩個(gè)具有代表性的參數(shù)高效微調(diào)方法,在 SuperNI Benchmark,Long Sequence Benchmark 兩個(gè)評測基準(zhǔn)上進(jìn)行了實(shí)驗(yàn),評價(jià)指標(biāo)為:平均性能(AP)、遺忘率(F.Ra)、前向遷移 (FWT) 以及反向遷移 (BWT)。如表 1 中結(jié)果所示,SAPT 具有最高的 AP 和最低的 F.Ra,表明其能夠有效應(yīng)對災(zāi)難性遺忘。與此同時(shí),其在 FWT 和 BWT 上也具有最優(yōu)的表現(xiàn),體現(xiàn)出 SAPT 能夠?qū)崿F(xiàn)有效的知識(shí)遷移。

表 1 基于 T5-Large 模型在兩個(gè)持續(xù)學(xué)習(xí)基準(zhǔn)的總體結(jié)果

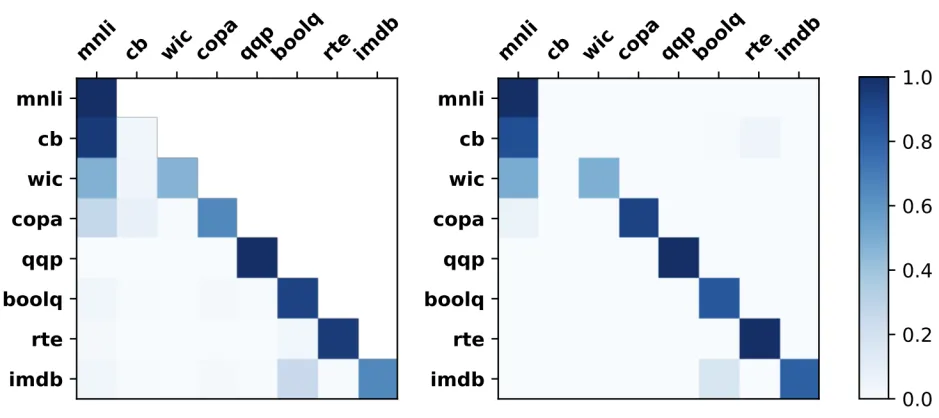

圖 3 展示了在訓(xùn)練(左圖)和測試(右圖)期間共享注意力的分布示意圖。我們可以觀察到:(1)PET 塊的學(xué)習(xí)和選擇過程是完全對齊的,兩個(gè)熱力圖幾乎具有相同的布局。(2)知識(shí)遷移確實(shí)發(fā)生在注意力學(xué)習(xí)過程中,以幫助 SAPT 獲取新知識(shí)。這些進(jìn)一步驗(yàn)證了 SAPT 處理災(zāi)難性遺忘和知識(shí)遷移的有效性。

圖 3 共享注意力的可視化結(jié)果。

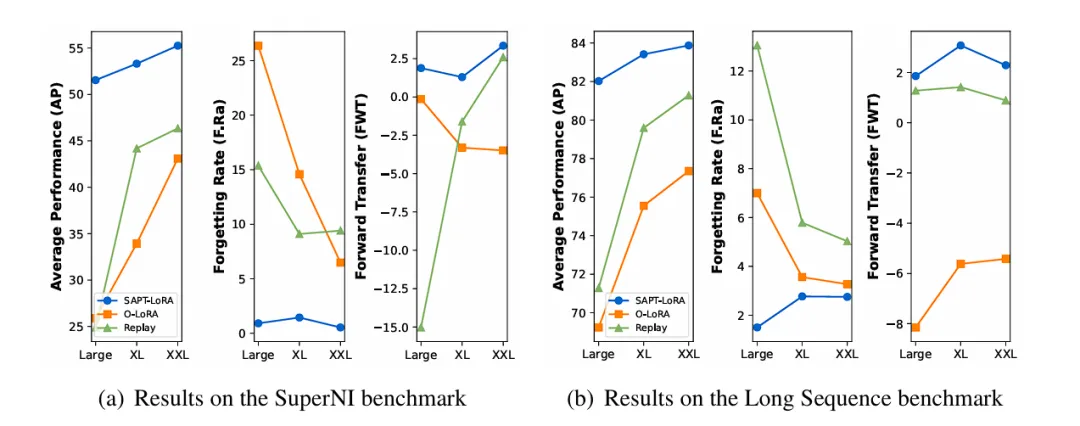

我們將實(shí)驗(yàn)采用的基礎(chǔ)大模型拓展到了不同的規(guī)模,我們實(shí)驗(yàn)分析了 T5 模型大小如何影響 SAPT 的性能。圖 4 顯示了隨著逐漸增大的基礎(chǔ)模型大小,即 Large(770M)、XL(3B)和 XXL(11B),SAPT、O-LoRA 和 Replay 在 AP、F.Ra 和 FWT 方面的表現(xiàn)。總體而言,隨著基礎(chǔ)模型大小的增加,在抵抗災(zāi)難性遺忘和促進(jìn)知識(shí)遷移方面,SAPT 始終能夠展現(xiàn)出比基線方法更優(yōu)越的性能。

圖 4 SAPT 基于不同規(guī)模的 T5 模塊的實(shí)驗(yàn)結(jié)果

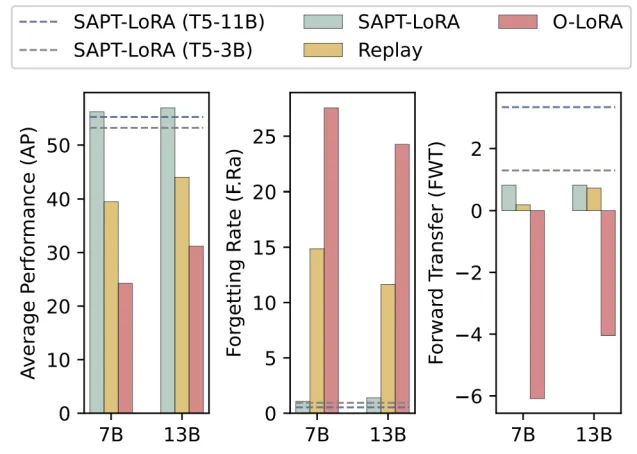

我們也將基礎(chǔ)大模型拓展到了不同的架構(gòu)。圖 5 展示了基于不同大小的 T5 和 LLaMA-2 在 SuperNI 基準(zhǔn)上的 SAPT 和基線方法的結(jié)果。可以觀察到,SAPT 依舊能夠有效地緩解災(zāi)難性遺忘并促進(jìn)不同模型架構(gòu)間的知識(shí)遷移。此外,平均性能隨著模型基礎(chǔ)能力的增強(qiáng)而提高(LLaMA-2 > T5),這進(jìn)一步證明了我們提出的 SAPT 的通用性。

圖 5 SAPT 基于不同架構(gòu)的大模型的實(shí)驗(yàn)結(jié)果。

更多詳細(xì)內(nèi)容可以參考論文原文。論文提出的方法未來將結(jié)合到度小滿軒轅大模型中,歡迎大家訪問!

本文轉(zhuǎn)自 機(jī)器之心 ,作者:機(jī)器之心