精細化圖像編輯!LocInv:優化交叉注意力泄漏問題(國科大&巴塞羅那自治大學)

論文鏈接:https://arxiv.org/pdf/2405.01496

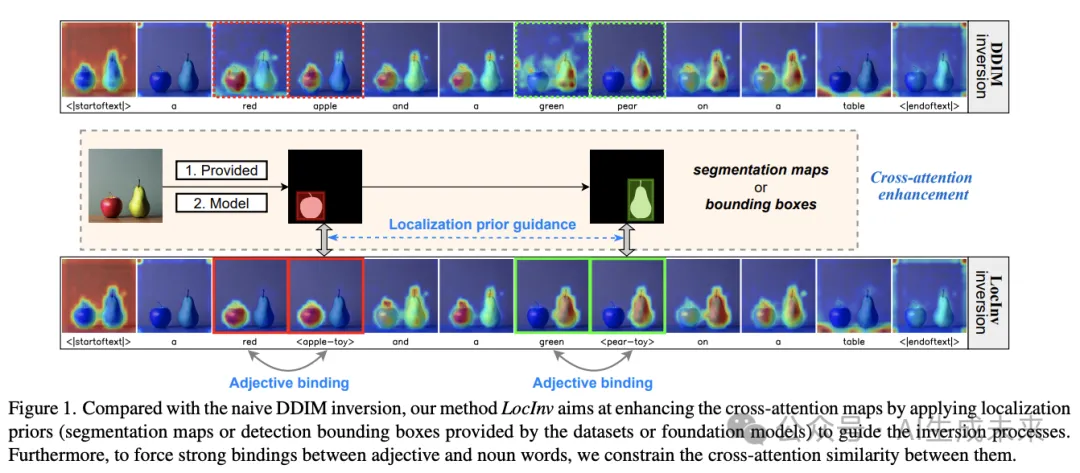

大規模文本到圖像(T2I)擴散模型展示了基于文本prompt的顯著生成能力。基于T2I擴散模型,圖像編輯研究旨在賦予用戶通過改變文本prompt來操作生成的圖像。然而,現有的圖像編輯技術往往會在超出預期目標區域的意外區域進行編輯,主要是由于交叉注意力圖中的不準確性。為了解決這個問題,本文提出了感知反演(LocInv),它利用分割圖或邊界框作為額外的定位先驗來在擴散過程的去噪階段中優化交叉注意力圖。通過動態更新文本輸入中對應于名詞的token,本文迫使交叉注意力圖與文本prompt中的正確名詞和形容詞緊密對齊。基于這種技術,本文實現了對特定對象的精細圖像編輯,同時防止對其他區域進行不需要的更改。本文的方法LocInv,基于公開可用的Stable Diffusion,在COCO數據集的子集上進行了廣泛評估,無論是在定量上還是在定性上都得到了優越的結果。

介紹

文本到圖像(T2I)模型取得了顯著的進展,并展示了生成多樣且逼真圖像的前所未有的能力。T2I模型是在龐大的語言-圖像數據集上進行訓練的,需要大量的計算資源。然而,盡管它們具有令人印象深刻的能力,但它們并不直接支持實際圖像編輯,并且它們通常缺乏精確控制圖像中特定區域的能力。

最近的關于文本引導圖像編輯的研究允許用戶僅使用文本prompt來操縱圖像。在本文中,專注于文本引導編輯,旨在改變圖像中特定源對象的視覺外觀。現有的一些方法[29, 37, 39, 52]使用DDIM反演來獲得圖像的初始潛在代碼,然后在去噪階段應用他們提出的編輯技術。然而,目前的文本引導編輯方法容易導致圖像區域的意外變化。這是由于現有編輯技術在交叉注意力圖的精確性上的重度依賴所致。

DPL觀察到DDIM和NTI的交叉注意力圖不僅與相應的對象相關。這一現象歸因于交叉注意力泄漏,這是阻礙這些圖像編輯方法應用于復雜多對象圖像的主要因素。為了解決這個問題,DPL通過引入額外的注意力損失來增強交叉注意力。然而,DPL依賴于名詞及其相關對象之間相對較弱的連接。這種連接有時傾向于較弱,并導致性能不佳。此外,鑒于最近文本為基礎的分割和檢測基礎模型的進展,現在可以很容易地將強大的定位先驗自動引入到通用應用中。

在本文中,引入了定位先驗以提供增強的對抗交叉注意力泄漏的方法。引入定位先驗后,本文的方法,名為定位感知反演(LocInv),涉及在每個時間步更新與對象相關的token表示,這是一種類似于動態prompt學習的技術。在分割和檢測場景中,本文優化了兩個損失,即相似性損失和重疊損失,以確保交叉注意力圖與提供的先驗密切對齊。此外,為了適應形容詞描述其相關名詞詞的情況,本文還加入了額外的相似性損失來加強它們之間的聯系。在實驗中,本文對從MSCOC收集的COCO-edit數據集上的交叉注意力圖的質量進行了定量評估。本文進一步將LocInv與P2P結合起來,與其他圖像編輯方法進行比較。LocInv展現出優越的評估指標和改進的用戶評估。此外,本文還以定性的方式展示了Word-Swap和Attribute-Edit的prompt編輯結果。

相關工作

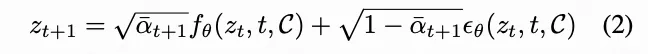

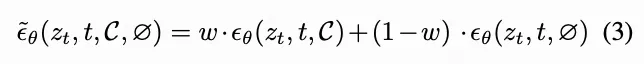

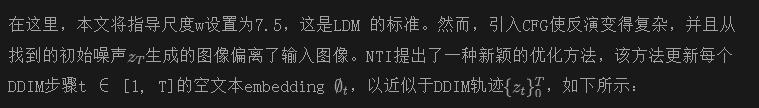

基于反演的編輯 主要依賴于DDIM反演,該方法通過確定性地計算和編碼上下文信息到潛在空間中,然后使用這種潛在表示重構原始圖像,在編輯任務中顯示了潛力。然而,當應用無分類器指導(CFG)時,DDIM在文本引導擴散模型中被發現缺乏必要的意義編輯。利用對空文本embedding的優化,Null-Text反演(NTI)在應用CFG時進一步提高了圖像重建質量,并保留了Stable Diffusion模型豐富的文本引導編輯能力。負面prompt反演(NPI)和ProxNPI在生成類似的競爭性重建結果的同時,減少了反演步驟的計算成本。直接反演通過在每個時間步調整編輯方向來進一步增強反演技術,以提供必要的內容保護和編輯保真度。IterInv 將反演泛化到DeepFloyd-IF T2I模型。

文本引導編輯 方法[3, 10, 26, 28, 29]采用了大型預訓練文本到圖像(T2I)模型來進行可控圖像編輯。其中,Imagic和P2P通過Stable Diffusion(SD)模型嘗試進行結構保持編輯。然而,Imagic 需要為每張圖像微調整個模型。而P2P則無需對模型進行微調,而是通過將原始圖像的交叉注意力映射分配給相應文本token中的編輯后圖像來重新訓練圖像結構。InstructPix2Pix是對P2P的擴展,允許使用人類般的指令進行圖像編輯。NTI進一步使P2P能夠處理真實圖像。最近,pix2pix-zero提出了噪聲正則化和交叉注意力指導,以重新訓練給定圖像的結構。DiffEdit通過對比根據不同文本prompt條件預測而生成突出顯示輸入圖像區域的mask。PnP證明了通過操縱T2I模型中的空間特征和自注意力映射可以保留圖像結構。

還有文本引導修補方法[15, 33, 38, 45]來實現給定用戶特定mask的編輯目的。例如,Blended diffusion從預先訓練的無條件擴散模型中進行了調整,并使用CLIP分數鼓勵輸出與文本prompt對齊。混合潛在擴散(BLD)進一步擴展到了LDM。然而,修補方法主要集中在填充指定區域的任意對象,同時確保與周圍區域的視覺連貫性。這些方法并不固有地保留源對象和目標對象之間的語義相似性,這是圖像翻譯效果所需的。

基于文本的分割和檢測模型旨在在預訓練后利用語言泛化特性對任意類別進行分割或檢測。其中最具代表性的基于prompt的分割模型之一是SAM。給定一張圖像和視覺prompt(框、點、文本或mask),SAM分別使用圖像和prompt編碼器對圖像和promptembedding進行編碼,然后將它們合并在一個輕量級的mask解碼器中,以預測分割mask。類似的工作還包括CLIPSeg、OpenSeg、GroupViT等。對于基于prompt的目標檢測器,GroundingDINO以將DINO檢測器與語言預訓練相結合,實現了開放集泛化,成為最先進的方法之一。除此之外,MaskCLIP、Xdecoder、UniDetector也提供基于prompt的檢測器。通過利用這些基礎模型,本文可以獲取定位信息作為有價值的語義先驗,以增強圖像反演。這反過來又有助于整體提高圖像編輯性能。

方法

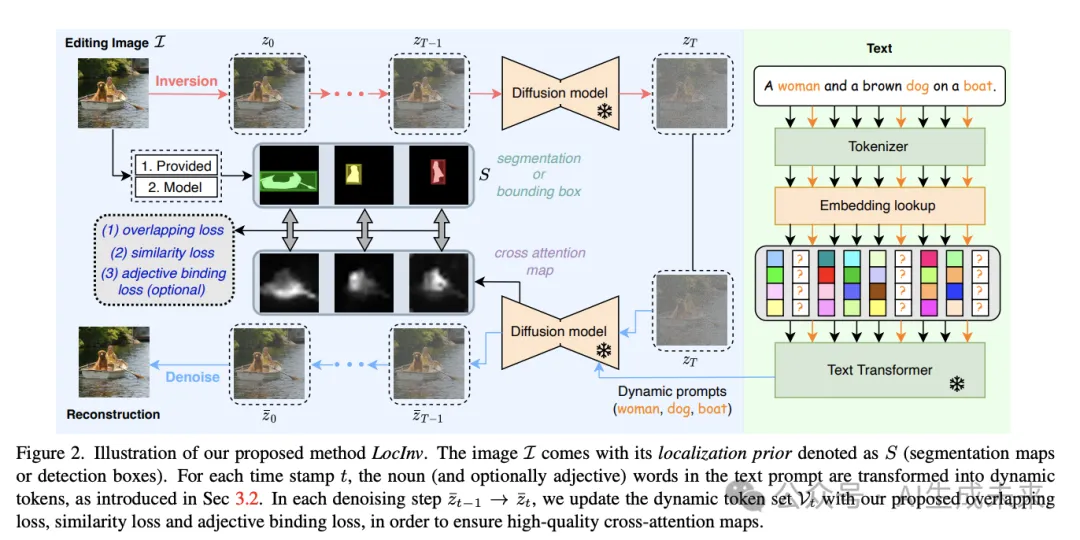

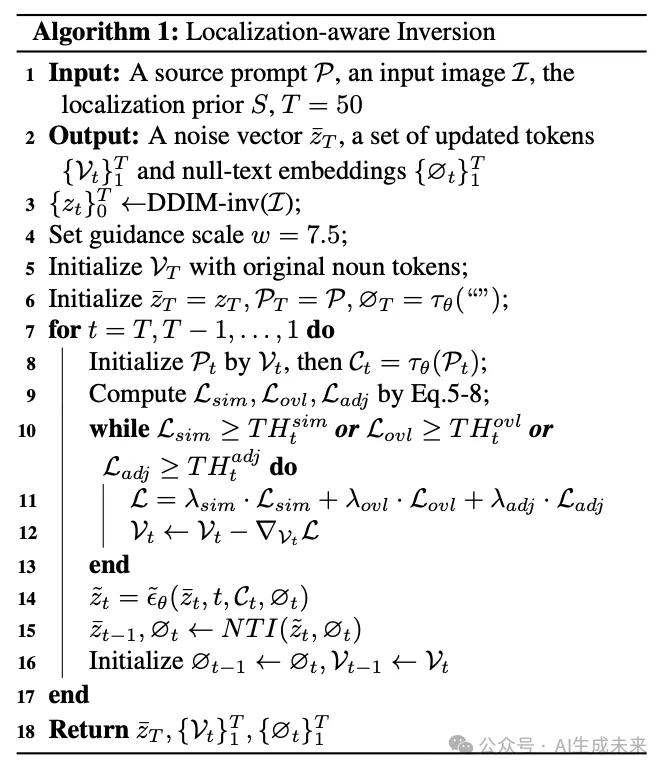

在本節中,提供LocInv的描述。本文方法的示意圖如下圖2所示,偽代碼如下算法1所示。

初步

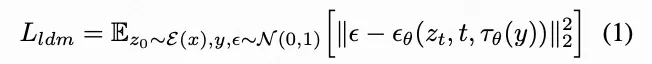

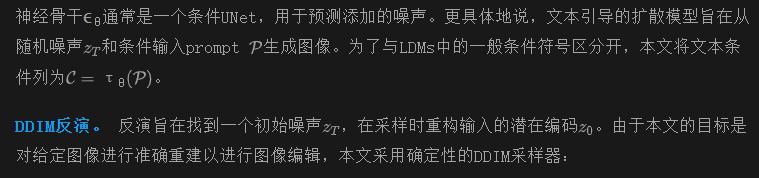

動態Prompt學習

基于文本的圖像編輯采用由初始prompt 描述的圖像,并旨在根據用戶指定的修改后prompt 對其進行修改。初始prompt用于計算交叉注意力圖。正如在前文中討論的那樣,當面對復雜情景時,交叉注意力泄漏是現有基于文本的編輯方法面臨的挑戰。DPL引入了三種損失來增強注意力圖與名詞之間的對齊,這依賴于圖像和prompt之間固有的連接,在現實世界的情況下并不總是可靠的。本節介紹本文的方法,稱為LocInv,它利用從現有分割圖(分割先驗)或檢測框(檢測先驗)派生的定位先驗。這些信息可以在最近基礎模型的幫助下輕松獲得,并有潛力顯著增強交叉注意力圖的質量。為簡化起見,本文統一將分割圖和檢測框表示為S。

LocInv: Localization-aware Inversion

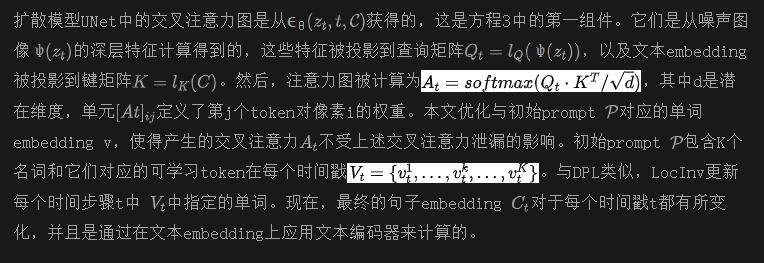

為了在每個時間步更新token表示,本文提出了幾種損失來優化embedding向量Vt:本文設計了一個損失來處理交叉注意力圖與其相應位置先驗S之間的相似性,另一個損失則確保高度重疊。

相似性損失。 相似性定義為注意力圖和位置先驗之間的余弦距離。

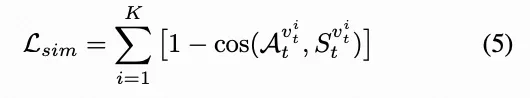

然而,本文的實驗結果表明,僅使用相似性損失會導致較低的交并比(IoU)曲線。鑒于注意力圖是連續函數,本文另外引入了一個重疊損失來溫和地限制交叉注意力。

重疊損失。 該損失被定義為定位先驗中注意力圖所占比例,如下所示:

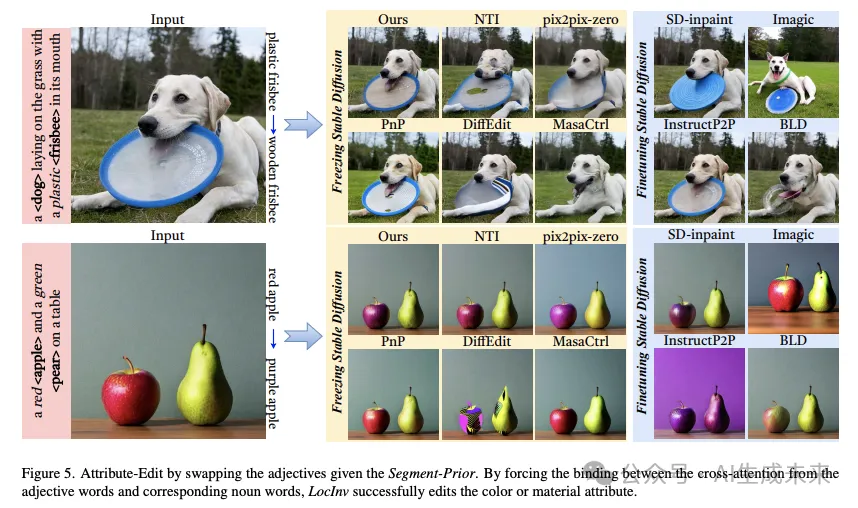

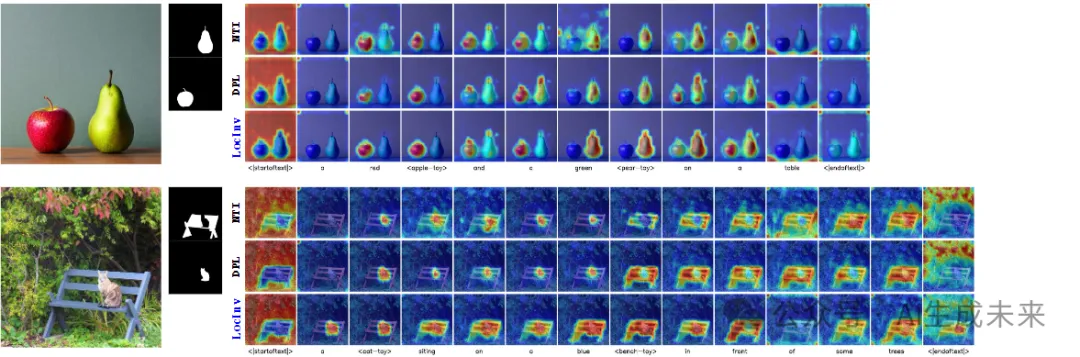

形容詞結合

現有的文本引導圖像編輯方法主要集中在將源對象轉換為目標對象。然而,通常用戶希望改變對象的外觀。在文本引導圖像編輯中,通常會通過改變由形容詞描述的對象屬性來實現這一點。然而,現有的方法在編輯源對象的屬性時失敗了(如下圖5所示)。本文將這種情況歸因于形容詞和其對應名詞之間的交叉注意力不一致(如上圖1所示)。

實驗

本文基于開源的Stable Diffusion 進行了各種實驗來展示LocInv,這是根據以前的方法 [37, 39, 52] 進行的。所有實驗都在R6000 GPU上完成。

數據集。 為了對超參數進行定量消融研究,并部分用于定性編輯比較,本文從MS-COCO數據集 [30] 中選擇了315張圖像作為COCO-edit的子集。本文從各種搜索prompt(包括飛機、蘋果、香蕉、熊、長椅等概念)中構建了這個子集,并存儲了用于實驗的地面真實分割/檢測圖像。總體上,有7個帶有單個對象(名詞)的搜索prompt,以及6個帶有多個對象的prompt。更詳細的信息請參見原文附錄資料。

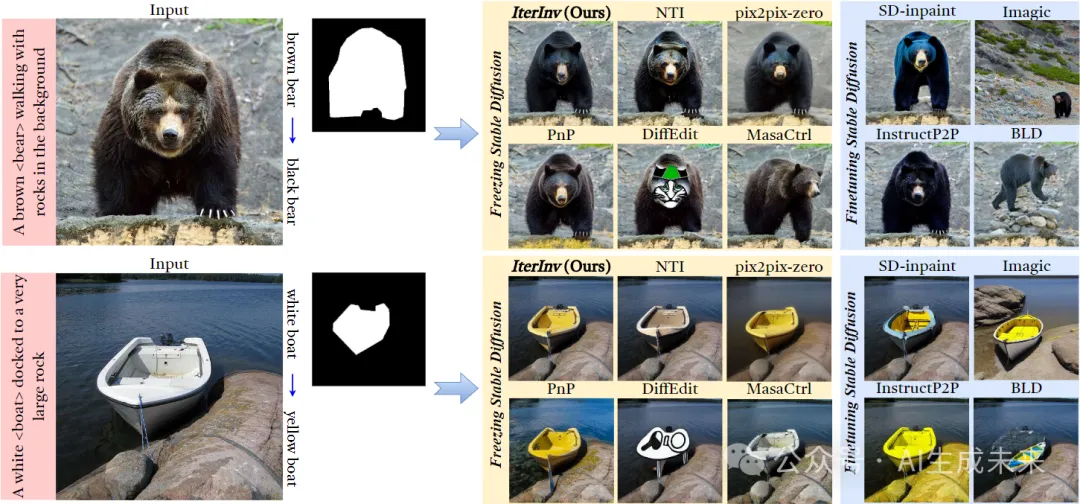

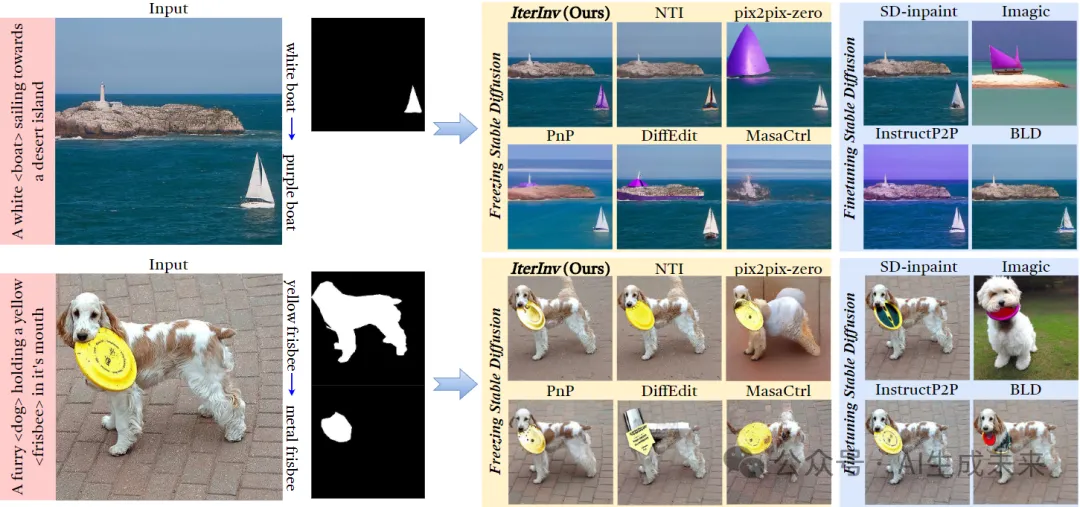

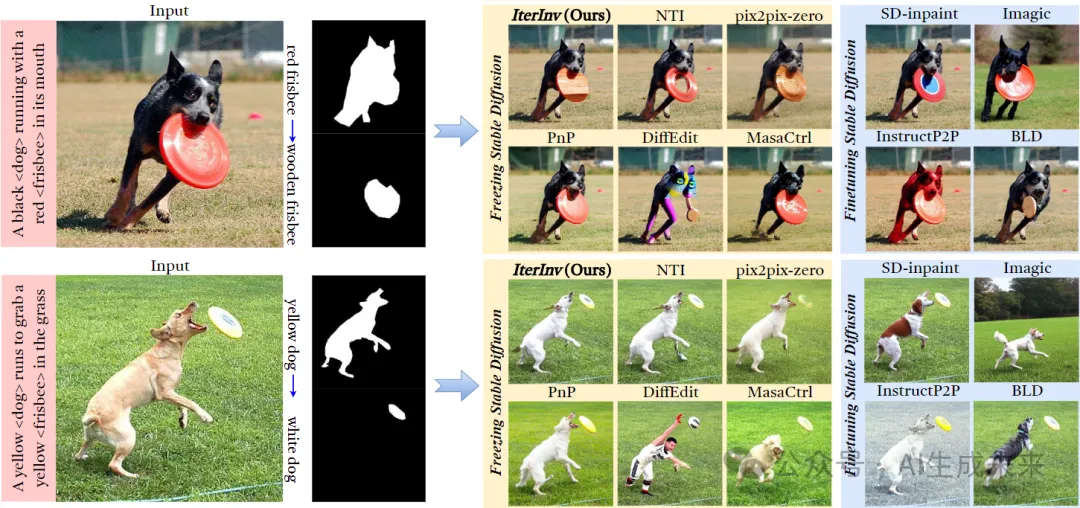

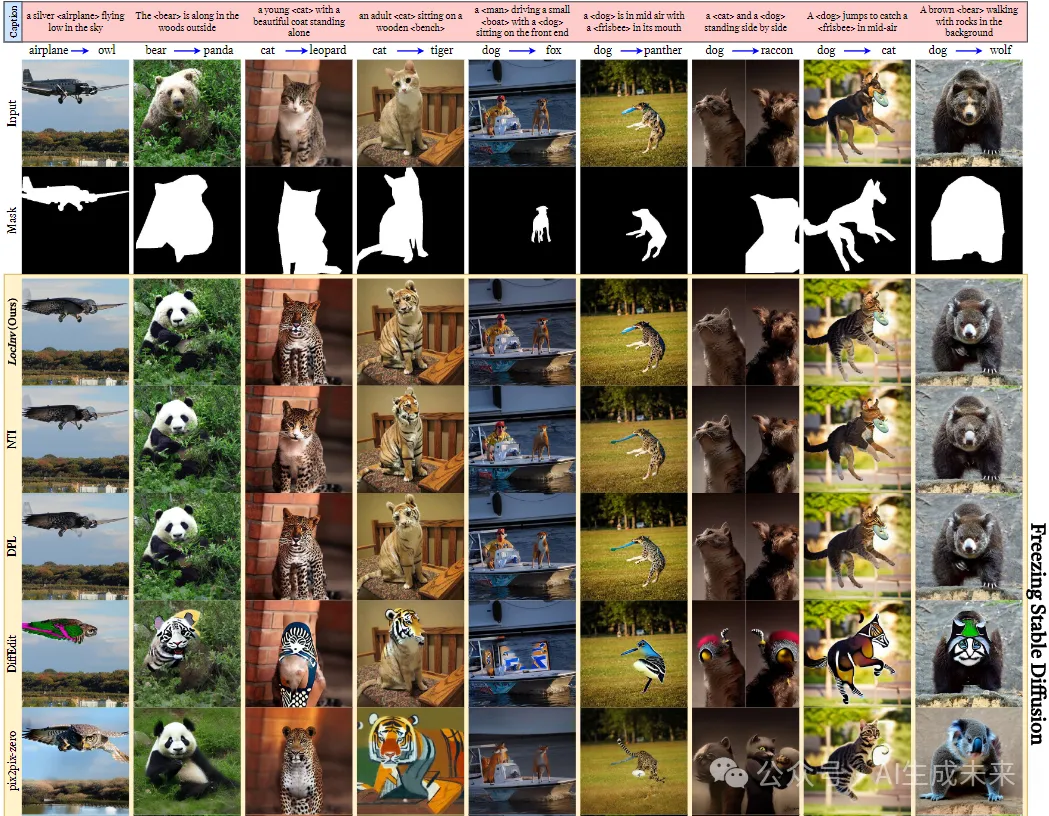

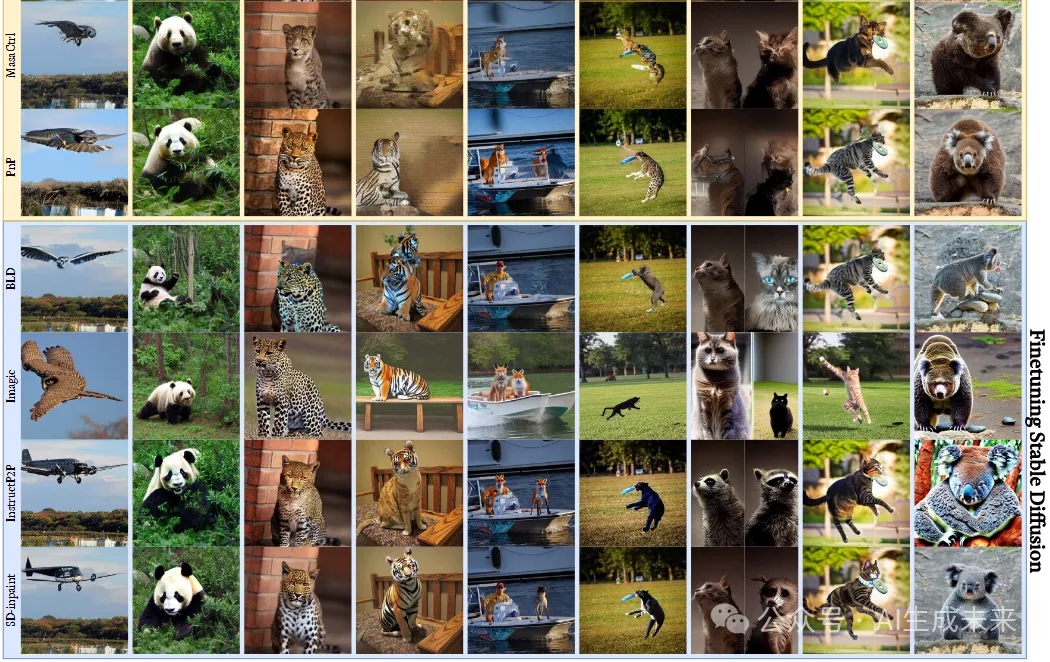

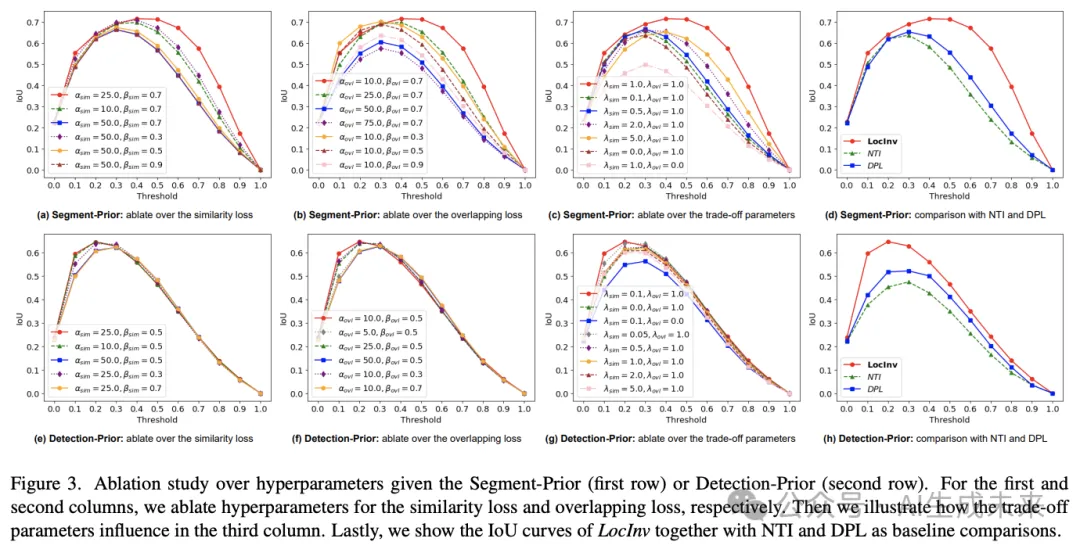

比較方法。 本文組織了兩組方法進行定性和定量比較。第一組方法是凍結Stable Diffusion模型,包括NTI、DPL、pix2pix-zero、PnP、DiffEdit 和 MasaCtrl。第二組方法是對大型預訓練的T2I模型進行微調,作為特定的圖像編輯模型,例如SD-inpaint、InstructPix2Pix和 Imagic,或者將mask視為涂鴉位置進行修復,包括SD-inpaint和 BLD。

評估指標。 為了定量評估方法的性能,本文采用了一些成熟的度量標準,包括 LPIPS、SSIM、PSNR、CLIP-Score和 DINO-Sim,來評估編輯后的完整圖像。此外,為了說明背景保留的質量,本文按照 DirectInversion的方法計算了 LPIPS、SSIM、PSNR 和 MSE 指標,用于mask外的區域。

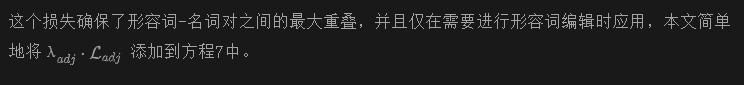

消融實驗

對于消融研究,本文在COCO-edit數據集上進行實驗。為了定量評估LocInv的定位性能,本文將閾值從0.0變化到1.0,從交叉注意力圖中獲取分割mask。然后,本文使用分割真值計算交并比(IoU)指標進行比較。本文的方法可以同時使用分割圖和檢測邊界框作為定位先驗。在這里,本文考慮了這兩種情況的超參數。

在下圖3中,本文對相似性損失和重疊損失進行消融研究。從圖 3-(c)(g) 可以看出,僅應用其中一種損失并不能確保令人滿意的性能。在經驗上,本文發現分割和檢測先驗的最佳超參數為 對于形容詞綁定損失,由于缺乏足夠的圖像-文本對進行消融研究,本文經驗性地將超參數設置為 。本文中的所有結果均使用這些超參數設置生成。

圖像編輯評估

對于圖像編輯,將LocInv與P2P圖像編輯方法結合起來。在本文中,主要關注包括詞語交換和屬性編輯在內的定位編輯任務。

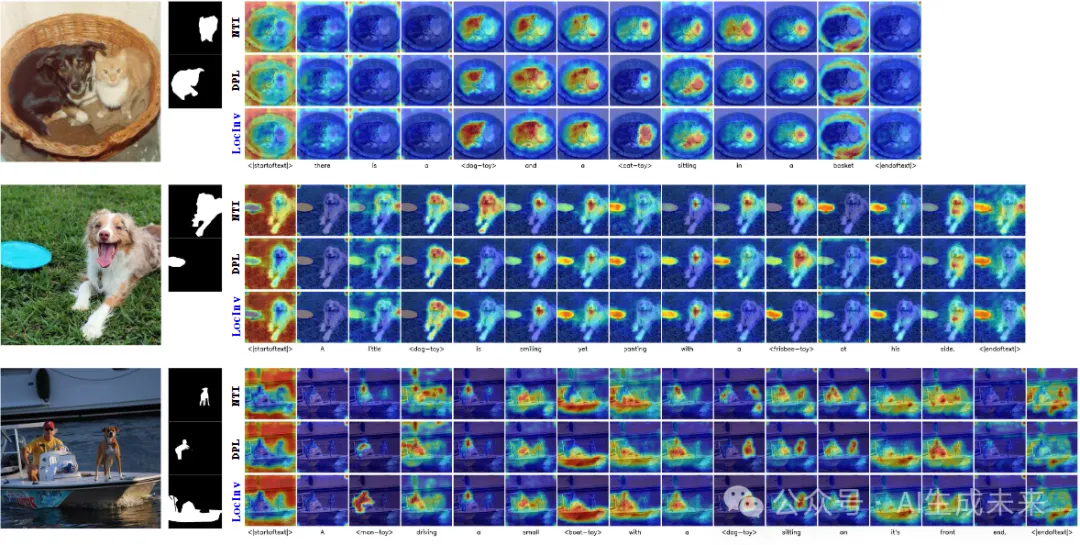

詞語交換。如下圖4所示,本文通過使用分割圖作為定位先驗,比較了LocInv與各種方法在原始圖像中交換一個對象的效果。本文的方法LocInv更成功地將源對象轉換為目標對象,并保持語義相似性。

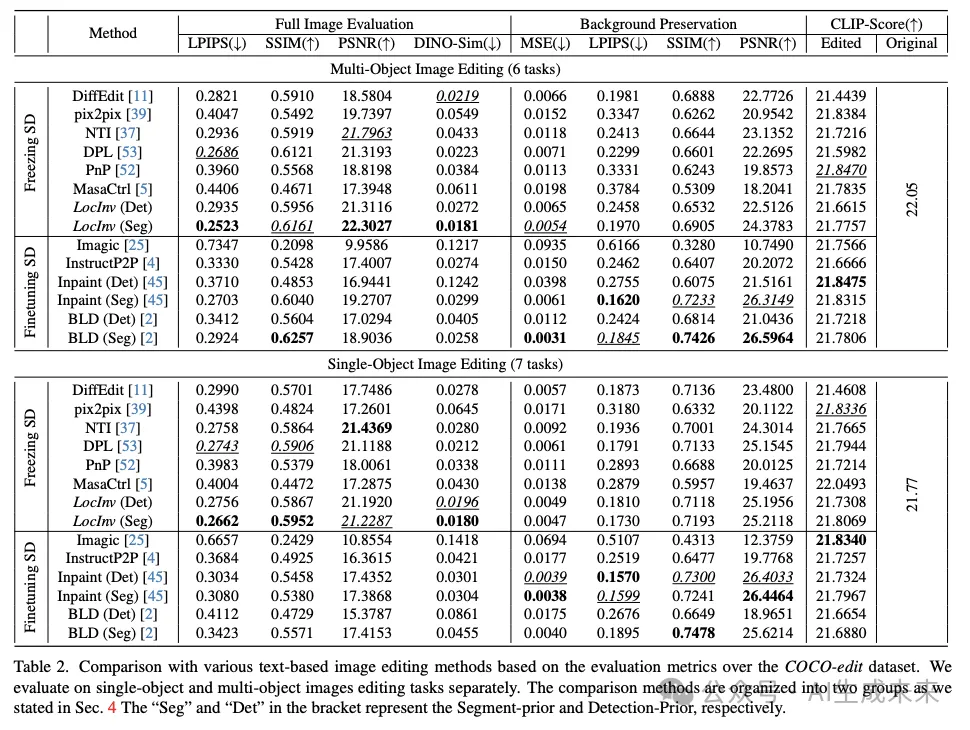

在下表2中,針對COCOEdit數據集中每組圖像設計了一個編輯任務(詳細信息請參見原文補充材料)。在單個對象和多個對象的編輯任務中,LocInv在完整圖像評估方面表現更好,并且僅在背景保留方面(因為這些方法不會更改背景像素)比涂鴉方法[2, 45]差一些。值得注意的是,LocInv不需要對基本模型進行微調,從而具有更好的時間復雜度,并且在T2I模型中沒有遺忘。

在下表1中,詢問了二十位參與者從編輯質量和背景保留兩個方面評估圖像編輯性能。在兩種情況下,LocInv都優于這六種凍結SD模型的方法。用戶研究的詳細信息請參見補充材料。

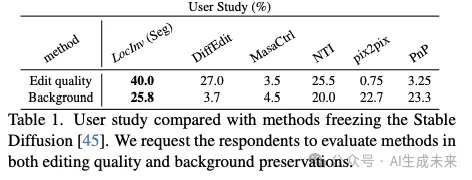

屬性編輯。 此外,LocInv在另一個編輯方面表現突出,即其他方法往往忽視的屬性編輯。這種能力在下圖5中有所體現。

通過強制形容詞詞語與其對應的名詞對象進行綁定,本文實現了準確修改它們的屬性(顏色、材質等)的能力。

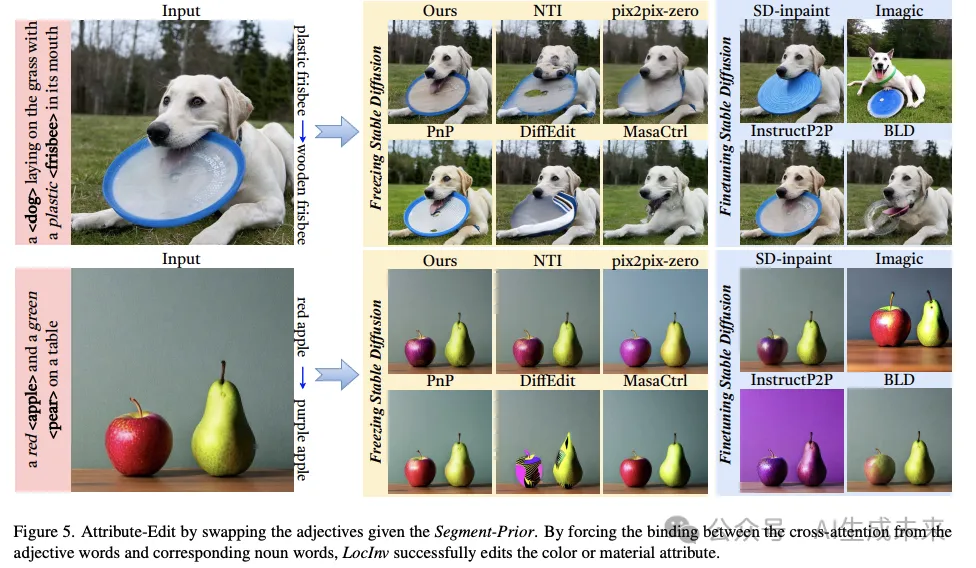

與以前的方法(包括NTI、DDIM和DPL)相比

我們的方法顯著改進了交叉注意力圖

結論

本文提出了基于定位感知的反演(LocInv)來解決使用文本到圖像擴散模型進行圖像編輯時的交叉注意力泄漏問題。本文建議使用分割或檢測作為先驗來更新prompt中每個名詞詞語的動態token。由此產生的交叉注意力圖對交叉注意力泄漏的影響較小。因此,這些大大改進的交叉注意力圖導致了文本引導圖像編輯的顯著改進結果。實驗結果證實,LocInv在復雜的多對象場景中取得了優異的結果。最后,展示了本文的方法還可以將形容詞詞語綁定到它們對應的名詞,從而為形容詞生成準確的交叉注意力圖,并允許屬性編輯,這在以前的文本引導圖像編輯中尚未得到很好的探索。

本文轉自 Chuanming Tang等 ,作者:AI生成未來