好萊塢級(jí)運(yùn)鏡一鍵克隆!港中文&浙大&快手聯(lián)合發(fā)布CamCloneMaster:顛覆影視制作

文章鏈接:https://arxiv.org/pdf/2506.03140

項(xiàng)目鏈接:https://camclonemaster.github.io/

亮點(diǎn)直擊

- CamCloneMaster,一種新穎的框架,能夠?qū)崿F(xiàn)基于參考視頻的精確相機(jī)控制來(lái)生成視頻。該框架無(wú)需相機(jī)參數(shù)或測(cè)試時(shí)微調(diào),為用戶提供了便捷直觀的體驗(yàn)。

- CamCloneMaster通過(guò)標(biāo)記拼接(token concatenation)這一簡(jiǎn)單高效的方法,在單一模型中集成了相機(jī)控制的圖像到視頻(I2V)生成和視頻到視頻(V2V)重生成功能,無(wú)需額外的控制模塊。

- 構(gòu)建了用于相機(jī)克隆學(xué)習(xí)的Camera Clone數(shù)據(jù)集:一個(gè)大規(guī)模、高質(zhì)量的配對(duì)視頻集合,包含相同相機(jī)軌跡和動(dòng)態(tài)場(chǎng)景。該數(shù)據(jù)集將公開發(fā)布以推動(dòng)未來(lái)研究。

總結(jié)速覽

解決的問(wèn)題

- 繁瑣的相機(jī)參數(shù)控制:現(xiàn)有方法依賴顯式的相機(jī)參數(shù)序列作為控制條件,用戶需手動(dòng)構(gòu)建復(fù)雜的相機(jī)運(yùn)動(dòng)軌跡,操作不便。

- 相機(jī)參數(shù)估計(jì)不準(zhǔn)確:從參考視頻中估計(jì)相機(jī)參數(shù)的精度受限,影響生成視頻的相機(jī)運(yùn)動(dòng)控制效果。

- 計(jì)算成本高:現(xiàn)有方法(如MotionClone)需額外的測(cè)試時(shí)微調(diào)或運(yùn)動(dòng)表示提取,引入額外計(jì)算開銷。

- 缺乏專用數(shù)據(jù)集:缺少包含相同相機(jī)軌跡或動(dòng)態(tài)場(chǎng)景的配對(duì)視頻數(shù)據(jù)集,制約模型訓(xùn)練。

提出的方案

- CamCloneMaster框架:

- 無(wú)需顯式相機(jī)參數(shù)或測(cè)試時(shí)微調(diào),直接通過(guò)參考視頻克隆相機(jī)運(yùn)動(dòng)。

- 支持統(tǒng)一的圖像到視頻(I2V)和視頻到視頻(V2V)任務(wù),用戶可通過(guò)參考視頻指定相機(jī)運(yùn)動(dòng)或內(nèi)容。

- 模型設(shè)計(jì):

- 將條件標(biāo)記(參考視頻信息)與噪聲視頻標(biāo)記直接拼接為統(tǒng)一輸入序列,避免額外控制模塊,參數(shù)高效。

- Camera Clone數(shù)據(jù)集:

- 使用Unreal Engine 5構(gòu)建大規(guī)模合成數(shù)據(jù)集,包含39.1K場(chǎng)景、391K視頻、97.75K相機(jī)軌跡,覆蓋多樣環(huán)境與動(dòng)態(tài)內(nèi)容。

應(yīng)用的技術(shù)

- 端到端訓(xùn)練框架:通過(guò)直接學(xué)習(xí)參考視頻的相機(jī)運(yùn)動(dòng),繞過(guò)顯式參數(shù)估計(jì)。

- 標(biāo)記拼接(Token Concatenation):簡(jiǎn)化控制流程,統(tǒng)一處理?xiàng)l件與生成內(nèi)容。

- 合成數(shù)據(jù)生成:基于規(guī)則自動(dòng)生成多樣化相機(jī)軌跡,模擬真實(shí)拍攝場(chǎng)景。

達(dá)到的效果

- 控制便捷性:用戶僅需提供參考視頻即可復(fù)現(xiàn)復(fù)雜相機(jī)運(yùn)動(dòng),降低使用門檻。

- 性能優(yōu)勢(shì):

- 相機(jī)控制準(zhǔn)確性:在RealEstate10K和經(jīng)典電影片段測(cè)試中,相機(jī)運(yùn)動(dòng)復(fù)現(xiàn)精度優(yōu)于現(xiàn)有方法。

- 視覺(jué)質(zhì)量:生成視頻的動(dòng)態(tài)效果和畫面質(zhì)量獲用戶主觀評(píng)價(jià)認(rèn)可(47人參與實(shí)驗(yàn))。

- 多功能支持:?jiǎn)我荒P屯瑫r(shí)支持I2V(給定圖像+相機(jī)運(yùn)動(dòng)參考)和V2V(給定視頻+運(yùn)動(dòng)參考)任務(wù),擴(kuò)展應(yīng)用場(chǎng)景。

CamCloneMaster

CamCloneMaster設(shè)計(jì)。首先介紹基礎(chǔ)模型的組成部分,接著解釋從參考視頻中提取相機(jī)運(yùn)動(dòng)作為引導(dǎo)的方法,最后介紹CamCloneMaster的訓(xùn)練策略。

初步:基礎(chǔ)模型

訓(xùn)練目標(biāo)采用簡(jiǎn)單的均方誤差(MSE)損失:

通過(guò)Token拼接注入?yún)⒖家曨l

訓(xùn)練策略

本文的目標(biāo)是通過(guò)參考視頻微調(diào)模型以實(shí)現(xiàn)相機(jī)運(yùn)動(dòng)克隆,同時(shí)保留其基礎(chǔ)生成能力。為兼顧效率與能力保留,僅選擇性微調(diào)DiT塊中的3D時(shí)空注意力層。為使單一模型同時(shí)具備圖像到視頻和視頻到視頻能力,我們采用平衡訓(xùn)練策略:50%為相機(jī)控制的圖像到視頻生成,50%為視頻到視頻重生成。

相機(jī)克隆數(shù)據(jù)集

構(gòu)建三元組需滿足兩個(gè)關(guān)鍵要求:

- 同步多視角采集:多個(gè)相機(jī)需以不同軌跡同時(shí)拍攝同一場(chǎng)景;

- 配對(duì)軌跡:不同地點(diǎn)需存在相同相機(jī)軌跡的配對(duì)鏡頭。實(shí)現(xiàn)策略如下:在單個(gè)地點(diǎn)部署10臺(tái)同步相機(jī),每臺(tái)按預(yù)設(shè)的10種獨(dú)特軌跡拍攝;為創(chuàng)建配對(duì)軌跡,將3D場(chǎng)景地點(diǎn)分為四組,確保每組內(nèi)所有地點(diǎn)復(fù)現(xiàn)相同的10種相機(jī)軌跡。相機(jī)軌跡通過(guò)設(shè)計(jì)規(guī)則自動(dòng)生成,涵蓋基礎(chǔ)移動(dòng)、弧形運(yùn)動(dòng)等復(fù)雜路徑。

最終數(shù)據(jù)集包含:

- 40個(gè)場(chǎng)景中39.1K個(gè)不同地點(diǎn)拍攝的391K條視覺(jué)真實(shí)視頻

- 97.75K種多樣相機(jī)軌跡

- 基于這些視頻構(gòu)建的1,155K個(gè)三元組視頻集每條視頻分辨率576×1,008,共154幀。

實(shí)驗(yàn)

實(shí)驗(yàn)設(shè)置

評(píng)估集:

- 相機(jī)運(yùn)動(dòng)參考:從RealEstate10K測(cè)試集隨機(jī)選取1,000條視頻,提供1,000種相機(jī)軌跡并附帶相機(jī)參數(shù)(作為參數(shù)依賴方法的條件輸入)。

- 內(nèi)容參考:從Koala-36M隨機(jī)選取1,000條視頻(圖像到視頻任務(wù)中僅使用首幀作為條件輸入)。

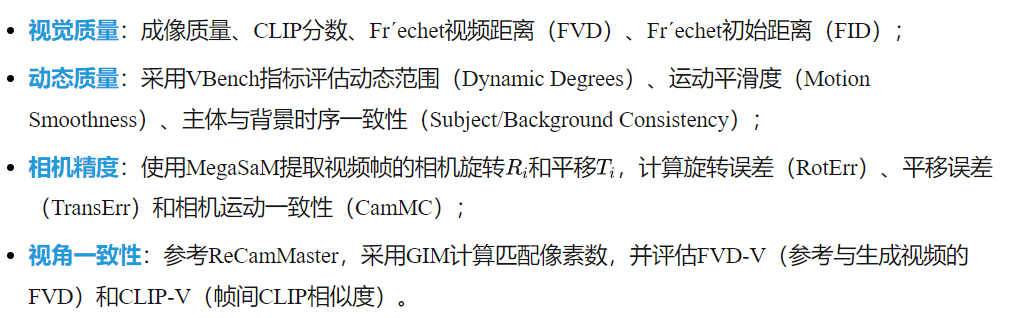

評(píng)估指標(biāo):

與前沿方法對(duì)比

相機(jī)控制的圖像到視頻生成

基線方法:對(duì)比Plücker嵌入相機(jī)表示的CameraCtrl和CamI2V,以及無(wú)訓(xùn)練框架MotionClone(通過(guò)稀疏時(shí)序注意力權(quán)重克隆參考視頻運(yùn)動(dòng))。MotionClone雖無(wú)需相機(jī)參數(shù),但難以處理復(fù)雜相機(jī)運(yùn)動(dòng)。

定量結(jié)果:如下表1所示,CamCloneMaster在相機(jī)控制(RotErr/TransErr/CamMC)上顯著優(yōu)于其他方法,同時(shí)保持更優(yōu)的視覺(jué)與動(dòng)態(tài)質(zhì)量。

定性結(jié)果:如下圖4所示,本文的方法精準(zhǔn)克隆參考相機(jī)運(yùn)動(dòng)(如左例帆船細(xì)節(jié)結(jié)構(gòu)與右例猴子復(fù)雜運(yùn)動(dòng)),而CameraCtrl/CamI2V難以跟蹤復(fù)合軌跡(如左例平移旋轉(zhuǎn)組合),MotionClone則因泛化性限制無(wú)法保持主體一致性。

相機(jī)控制的視頻到視頻重生成

基線方法:對(duì)比需要相機(jī)參數(shù)輸入的DaS、ReCamMaster和TrajectoryCrafter。DaS通過(guò)3D點(diǎn)跟蹤從內(nèi)容參考視頻提取動(dòng)態(tài)信息,ReCamMaster采用視頻條件機(jī)制,TrajectoryCrafter則從內(nèi)容參考構(gòu)建點(diǎn)云并渲染新視角作為控制信號(hào)。

定量結(jié)果:如上表1和下表2所示,CamCloneMaster在多項(xiàng)指標(biāo)上超越基線方法。本文的方法不僅能精確控制相機(jī)并保持高視覺(jué)質(zhì)量,還能有效保留內(nèi)容參考的動(dòng)態(tài)場(chǎng)景。

定性結(jié)果:如下圖5所示,基線方法普遍無(wú)法生成準(zhǔn)確相機(jī)運(yùn)動(dòng)的視頻。具體而言,DaS和TrajectoryCrafter會(huì)產(chǎn)生明顯偽影,而本文的方法能精準(zhǔn)克隆參考視頻的相機(jī)運(yùn)動(dòng),輸出具有高視覺(jué)質(zhì)量和時(shí)序一致性的結(jié)果。

用戶研究

本文通過(guò)用戶研究揭示相機(jī)位姿精度對(duì)參數(shù)化方法的重要性及其獲取挑戰(zhàn)。參與者需比較成對(duì)視頻:一組使用真實(shí)相機(jī)參數(shù)生成,另一組使用MegaSam估計(jì)參數(shù)生成,選擇哪組視頻的相機(jī)運(yùn)動(dòng)更匹配參考。實(shí)驗(yàn)基于CamI2V、CameraCtrl和ReCamMaster三種參數(shù)化方法,從合成數(shù)據(jù)集中隨機(jī)選取12條帶真實(shí)參數(shù)的相機(jī)運(yùn)動(dòng)參考視頻。47名參與者的結(jié)果(下表3)顯示:

- 參數(shù)化方法的相機(jī)運(yùn)動(dòng)保真度高度依賴輸入?yún)?shù)精度;

- 即使最先進(jìn)的位姿估計(jì)模型也難以提供足夠精確的參數(shù),這驗(yàn)證了我們提出的基于參考的相機(jī)控制框架的必要性。

另一項(xiàng)用戶研究從主觀角度評(píng)估不同方法。從網(wǎng)絡(luò)收集24條1080×1920分辨率的相機(jī)運(yùn)動(dòng)參考和12條內(nèi)容參考。測(cè)試時(shí),參與者同時(shí)觀看4個(gè)隨機(jī)排序的視頻(本文的方法+3個(gè)任務(wù)相關(guān)基線方法生成結(jié)果),從三個(gè)維度評(píng)估:

- 相機(jī)精度:相機(jī)運(yùn)動(dòng)與參考視頻的匹配度;

- 視頻-文本一致性:內(nèi)容與文本提示的契合度;

- 時(shí)序一致性。47名參與者的結(jié)果(下表4)表明本文的方法在各項(xiàng)指標(biāo)上均獲得最多用戶偏好。

消融實(shí)驗(yàn)

條件注入機(jī)制的消融實(shí)驗(yàn)。本文的模型通過(guò)將條件tokens與噪聲潛在tokens沿幀維度拼接來(lái)實(shí)現(xiàn)視頻生成的條件控制。本文驗(yàn)證了這種幀拼接方式與廣泛使用的通道拼接的對(duì)比效果。同時(shí)測(cè)試了僅在時(shí)序DiT塊層內(nèi)拼接條件標(biāo)記的方案,因?yàn)闂l件tokens與噪聲tokens之間的顯式注意力僅限于3D時(shí)空注意力層。最后,將token拼接與類ControlNet架構(gòu)進(jìn)行對(duì)比,后者通過(guò)復(fù)制DiT塊提取參考視頻特征,再通過(guò)特征加法注入基礎(chǔ)模型。下表5結(jié)果表明,在所有層中拼接條件標(biāo)記對(duì)最優(yōu)性能至關(guān)重要(第2、4行)。我們認(rèn)為全局視頻屬性(如相機(jī)運(yùn)動(dòng))需要高層表征,因此即使是不含顯式注意力機(jī)制的層也對(duì)提取這些屬性起關(guān)鍵作用。此外,標(biāo)記拼接優(yōu)于類ControlNet的特征加法(第3、4行),這可能是因?yàn)樘卣骷臃〞?huì)加大模型區(qū)分參考內(nèi)容與運(yùn)動(dòng)線索的難度。

訓(xùn)練策略的消融實(shí)驗(yàn)。僅微調(diào)DiT塊中的3D時(shí)空注意力層,并凍結(jié)其余參數(shù)。下表6結(jié)果顯示,僅微調(diào)3D時(shí)空注意力層可提升相機(jī)克隆精度,同時(shí)保持更好的視覺(jué)質(zhì)量。

結(jié)論與局限性

CamCloneMaster,一種新穎的視頻生成相機(jī)控制方法,支持直觀且用戶友好的操作。CamCloneMaster無(wú)需相機(jī)參數(shù)或測(cè)試時(shí)微調(diào)即可復(fù)制參考視頻的相機(jī)運(yùn)動(dòng)。另一創(chuàng)新是簡(jiǎn)潔高效的架構(gòu),無(wú)需額外控制模塊即可將相機(jī)控制的圖像到視頻生成(I2V)與視頻到視頻再生(V2V)統(tǒng)一于單一模型中。我們還構(gòu)建了高質(zhì)量合成數(shù)據(jù)集用于訓(xùn)練。

局限性。盡管tokens拼接策略在相機(jī)控制視頻生成中表現(xiàn)優(yōu)異,但會(huì)增加計(jì)算負(fù)擔(dān)。未來(lái)工作將探索稀疏注意力或潛在丟棄等方法以降低開銷。

本文轉(zhuǎn)自AI生成未來(lái) ,作者:AI生成未來(lái)