LawLLM:面向美國法律體系的法律大語言模型 原創(chuàng) 精華

摘要

在法律分析這一快速發(fā)展的領(lǐng)域中,由于法律語言的復(fù)雜性(通常包含專業(yè)術(shù)語、復(fù)雜句法和歷史背景),尋找相關(guān)案例并準(zhǔn)確預(yù)測(cè)司法結(jié)果具有挑戰(zhàn)性。此外,相似案例與判例案例之間的微妙差異需要深厚的法律知識(shí)理解。研究人員常常混淆這些概念,導(dǎo)致難以開發(fā)專門技術(shù)來有效處理這些細(xì)致入微的任務(wù)。

本文介紹了法律大語言模型(LawLLM),這是一個(gè)專為美國法律領(lǐng)域設(shè)計(jì)的、能夠應(yīng)對(duì)這些挑戰(zhàn)的多任務(wù)模型。LawLLM在相似案例檢索(SCR)、判例案例推薦(PCR)和法律判決預(yù)測(cè)(LJP)方面表現(xiàn)出色。通過明確區(qū)分判例案例和相似案例,我們提供了關(guān)鍵性的概念澄清,為未來研究開發(fā)針對(duì)這些任務(wù)的專門策略指明了方向。我們?yōu)槊總€(gè)任務(wù)提出了定制化的數(shù)據(jù)預(yù)處理技術(shù),將原始法律數(shù)據(jù)轉(zhuǎn)化為可訓(xùn)練的格式。

此外,我們還在LawLLM中運(yùn)用了上下文學(xué)習(xí)(ICL)和先進(jìn)的信息檢索方法等技術(shù)。評(píng)估結(jié)果表明,在零樣本和少樣本場(chǎng)景下,LawLLM始終優(yōu)于現(xiàn)有基線模型,提供了無與倫比的多任務(wù)能力,填補(bǔ)了法律領(lǐng)域的關(guān)鍵空白。代碼和數(shù)據(jù)可在https://github.com/Tizzzzy/Law_LLM獲取。

1 引言

大語言模型(LLMs)的發(fā)展推動(dòng)了計(jì)算語言學(xué)的重大進(jìn)步,尤其影響了法律分析等領(lǐng)域。鑒于法律語言的特性(包含復(fù)雜術(shù)語和特定情境的邏輯框架),LLMs在這一領(lǐng)域展現(xiàn)出前所未有的能力[21]。LLMs與法律領(lǐng)域的結(jié)合顯著提高了律師和法官等法律從業(yè)者的工作效率,能夠準(zhǔn)確解讀他們的自然語言輸入并生成最相關(guān)的回應(yīng),從而減少了對(duì)大量法律文本進(jìn)行人工審閱的需求。此外,LLMs還能為律師提供新穎的見解,揭示在復(fù)雜案件中被忽視的細(xì)節(jié)和觀點(diǎn)。法律領(lǐng)域的最新發(fā)展已經(jīng)展示了LLMs在提升法律判決預(yù)測(cè)和處理各類法律任務(wù)方面的潛力。例如,LM-CompEval-Legal[26]等研究系統(tǒng)評(píng)估了LLMs的效能,而PLJP[33]和LoT[11]等項(xiàng)目則專注于整合領(lǐng)域特定模型并推進(jìn)LLMs對(duì)法律推理的理解。

盡管這些模型已展現(xiàn)出前景,但仍存在研究挑戰(zhàn)。首先,這些模型通常只應(yīng)對(duì)單任務(wù)挑戰(zhàn)。相比之下,LawLLM創(chuàng)新性地同時(shí)支持多個(gè)法律任務(wù),能對(duì)復(fù)雜法律數(shù)據(jù)集進(jìn)行更細(xì)致的分析,填補(bǔ)了該領(lǐng)域的關(guān)鍵空白。其次,法律領(lǐng)域中另一個(gè)存在爭(zhēng)議的領(lǐng)域是判例案例與相似案例之間的區(qū)別[22]。為判例案例推薦開發(fā)的模型多種多樣,從基于專家知識(shí)的模型到基于自然語言處理的模型[2,16,18,20]。這些方法通常將法律文本轉(zhuǎn)化為嵌入表示,并在嵌入層面計(jì)算相似度,這有助于判例選擇。但我們認(rèn)為,這種方法更側(cè)重于識(shí)別具有文本和上下文相似性的相似案例,而非判例案例。

在我們的研究中,我們強(qiáng)調(diào)了兩者之間的關(guān)鍵區(qū)別。首先,判例案例必須在輸入法律案件之前已經(jīng)結(jié)案,確保其與當(dāng)前考慮案件的相關(guān)性和適用性。其次,判例案例是法官在做出決定時(shí)實(shí)際考慮過的案例,而不像相似案例可能未被考慮。第三,相似案例在案件敘述或案件類別上具有文本和主題相似性,而判例案例在表面上可能看似無關(guān)。還需注意的是,雖然法律案件的判例案例有時(shí)可能與相似案例相同,但情況并非總是如此。

本文介紹了法律大語言模型(LawLLM),這是一個(gè)能夠執(zhí)行相似案例檢索(SCR)、判例案例推薦(PCR)和法律判決預(yù)測(cè)(LJP)的多任務(wù)LLM。為構(gòu)建LawLLM,我們使用美國真實(shí)法律數(shù)據(jù)集對(duì)Gemma-7B[29]進(jìn)行指令微調(diào),使其能夠執(zhí)行LJP、PCR和SCR任務(wù)。所有三個(gè)任務(wù)的指令都屬于分類類別。通過這樣做,我們可以有效減少模型的無關(guān)和噪聲選項(xiàng),從而提高其性能。圖1展示了LawLLM的總體構(gòu)想。LawLLM的開發(fā)還包括三種創(chuàng)新的預(yù)處理方法,將非結(jié)構(gòu)化法律數(shù)據(jù)轉(zhuǎn)化為可訓(xùn)練的格式。具體而言,對(duì)于LJP,我們從原始數(shù)據(jù)集中總結(jié)和提取判決結(jié)果,并應(yīng)用零樣本和少樣本上下文學(xué)習(xí)(ICL)[13,36]技術(shù)來提升模型性能。在PCR中,LawLLM將真實(shí)法律案例的判例關(guān)系構(gòu)建為知識(shí)圖譜(KG),將每個(gè)案例視為由判例連接連接的獨(dú)特實(shí)體[25]。此外,SCR任務(wù)創(chuàng)建了一個(gè)法律案例向量數(shù)據(jù)庫,并整合了先進(jìn)的信息檢索(IR)技術(shù)[8,12]。

我們的研究將LawLLM定位為法律LLM領(lǐng)域的開創(chuàng)性模型。我們的主要貢獻(xiàn)如下:

- 我們提出了LawLLM,它擅長(zhǎng)處理一系列法律任務(wù),包括LJP、PCR和SCR。這種多任務(wù)功能對(duì)于滿足法律領(lǐng)域多樣化需求至關(guān)重要。

- LawLLM區(qū)分了判例案例和相似案例,明確了每個(gè)任務(wù)的目標(biāo)。這種澄清使未來研究能夠?yàn)檫@些任務(wù)開發(fā)量身定制的策略。

- 實(shí)驗(yàn)結(jié)果表明,LawLLM在所有三個(gè)任務(wù)上都優(yōu)于包括GPT-4模型在內(nèi)的所有基線模型。這些結(jié)果凸顯了LawLLM在法律領(lǐng)域的強(qiáng)大能力。

2 相關(guān)工作

法律AI正在顯著提高法律界的效率和效力。AI技術(shù),特別是大語言模型(LLMs),正在引領(lǐng)自動(dòng)化復(fù)雜任務(wù)的潮流,如文檔分析、案件預(yù)測(cè)和法律研究[34,38]。LLMs利用先進(jìn)算法和數(shù)據(jù)分析來處理和生成法律文本,從而在速度和準(zhǔn)確性上帶來顯著提升[39]。本節(jié)我們將介紹法律AI和LLMs在法律實(shí)踐中的各種應(yīng)用。

2.1 判例案例推薦

判例案例推薦是法律實(shí)踐的一個(gè)基本方面,因?yàn)榧韧袥Q會(huì)顯著影響當(dāng)前法律決定。該領(lǐng)域已從早期的基于關(guān)鍵詞搜索和手動(dòng)標(biāo)注發(fā)展到更復(fù)雜的AI驅(qū)動(dòng)模型,提高了檢索效率和上下文相關(guān)性。吳等人[34]提出了判例增強(qiáng)法律判決預(yù)測(cè)框架,將LLMs與領(lǐng)域?qū)I(yè)知識(shí)相結(jié)合,顯著提高了法律預(yù)測(cè)準(zhǔn)確性。馬等人[17]開發(fā)了結(jié)構(gòu)化法律案例檢索系統(tǒng),利用法律文檔中的結(jié)構(gòu)信息來提高案例搜索精度和上下文相關(guān)性。此外,蘇等人[27]提出了Caseformer。這一創(chuàng)新的預(yù)訓(xùn)練框架從大量法律文本語料庫中學(xué)習(xí),以優(yōu)化跨多種語言的案例檢索和情境化。

2.2 相似案例檢索

除了判例推薦外,檢索相似案例(即事實(shí)或法律問題相似的案例)對(duì)于全面法律分析和策略制定至關(guān)重要。傳統(tǒng)上,這一過程需要大量人工勞動(dòng),專業(yè)人員需要梳理龐大的案例數(shù)據(jù)庫[17,19]。如今,NLP和機(jī)器學(xué)習(xí)的進(jìn)步改變了這一任務(wù),允許跨文檔提取和比較語義內(nèi)容。康等人[14]通過整合關(guān)聯(lián)知識(shí)增強(qiáng)了基于相似性的檢索。這種方法通過利用相似性和關(guān)聯(lián)分析來優(yōu)化檢索結(jié)果,該技術(shù)在醫(yī)療診斷和IT服務(wù)管理等其他領(lǐng)域也被證明有效。曼達(dá)爾等人[19]在印度最高法院數(shù)據(jù)集上分析了文本相似性技術(shù),發(fā)現(xiàn)TF-IDF等傳統(tǒng)方法優(yōu)于BERT等現(xiàn)代上下文感知模型。吳等人[32]研究了中國司法系統(tǒng)中的語義檢索,開發(fā)了一個(gè)為案例生成知識(shí)圖譜的模型,以提高審判準(zhǔn)確性和公平性。這些技術(shù)進(jìn)步大大簡(jiǎn)化了法律研究,使其更加高效和全面。

2.3 法律判決預(yù)測(cè)

預(yù)測(cè)法律判決涉及基于對(duì)歷史數(shù)據(jù)和既定法律標(biāo)準(zhǔn)的深入分析來估計(jì)潛在判決結(jié)果。該領(lǐng)域的初始模型相對(duì)簡(jiǎn)單,主要依賴無法捕捉法律推理多方面的線性算法。王和金[31]的CNN-BiGRU多任務(wù)學(xué)習(xí)模型通過利用相關(guān)法律子任務(wù)的共享信息提高了預(yù)測(cè)準(zhǔn)確性。查爾基迪斯等人[3]使用歐洲人權(quán)法院數(shù)據(jù),通過分層BERT為長(zhǎng)法律文本建立了穩(wěn)健的性能基準(zhǔn)。魯斯納琴科等人[23]展示了基于注意力的方法可以通過優(yōu)化文檔預(yù)處理和競(jìng)賽背景下的注意力機(jī)制來提高系統(tǒng)性能。這些模型不僅能預(yù)測(cè)結(jié)果,還不斷從新案例中學(xué)習(xí)以提高準(zhǔn)確性,展示了LLMs在法律判決預(yù)測(cè)中的適應(yīng)性。

2.4 法律領(lǐng)域中的LLMs

在大語言模型(LLMs)發(fā)展之前,研究人員探索了特定領(lǐng)域的預(yù)訓(xùn)練語言模型(PLMs),例如基于Longformer架構(gòu)處理長(zhǎng)中文法律文檔的Lawformer[35]。隨著LLMs受到關(guān)注,研究人員發(fā)現(xiàn)像GPT-4這樣的模型能夠成功通過律師資格考試,展示了在法律推理和文本生成方面的強(qiáng)大能力[15]。這一成功促使法律領(lǐng)域?qū)S肔LMs的發(fā)展,例如利用對(duì)話式AI改善用戶與法律系統(tǒng)交互的Chatlaw[5]。在這方面,SaulLM-7B作為首個(gè)專門用于理解和生成法律文本的LLM被推出,利用大量法律語料庫實(shí)現(xiàn)了最先進(jìn)的性能[4]。LLMs的影響超越了特定任務(wù),擴(kuò)展到更廣泛的法律操作。這些應(yīng)用范圍從文檔自動(dòng)化(LLMs協(xié)助起草和審查法律文件)到合規(guī)監(jiān)控(確保符合監(jiān)管標(biāo)準(zhǔn))[28]。LLMs簡(jiǎn)化了非專業(yè)人士的復(fù)雜法律流程,降低了獲取法律建議的門檻[9]。LLMs的廣泛應(yīng)用展示了其在法律領(lǐng)域的廣泛適用性和持續(xù)創(chuàng)新的潛力。

盡管這些當(dāng)代研究取得了成功,但這些模型主要專注于利用LLMs的理解和能力來執(zhí)行一般性法律問答。然而,LawLLM旨在利用LLMs的理解和學(xué)習(xí)能力來預(yù)測(cè)和執(zhí)行法律領(lǐng)域內(nèi)的特定任務(wù)。

3 方法論

在本研究中,我們提出了法律大語言模型(LawLLM),以解決法律領(lǐng)域內(nèi)的三個(gè)關(guān)鍵任務(wù):相似案例檢索(SCR)、判例案例推薦(PCR)和法律判決預(yù)測(cè)(LJP)。我們的方法框架如圖2所示,分為四個(gè)獨(dú)立部分:數(shù)據(jù)預(yù)處理、SCR處理、PCR處理和LJP處理。

3.1 數(shù)據(jù)預(yù)處理

我們的方法始于從法律數(shù)據(jù)庫系統(tǒng)收集案例數(shù)據(jù),記為D。我們確保所有收集的原始案例數(shù)據(jù)di∈D包含以下各種信息:

di={標(biāo)題,日期,法官,原告,原告律師,被告,被告律師,案件詳情,判例關(guān)系}。

如圖2左上角所示,數(shù)據(jù)預(yù)處理包括三個(gè)主要步驟:

圖2:我們的法律大型語言模型(LawLLM)概覽:數(shù)據(jù)預(yù)處理位于左上角,以綠色顯示;相似案例檢索處理位于右上角,以黃色顯示;判例推薦位于左下角,以紅色顯示;法律判決預(yù)測(cè)位于右下角,以藍(lán)色顯示。

步驟1. 鑒于案件詳情中文本內(nèi)容的龐大規(guī)模及其通常隱含的判決結(jié)果,我們使用GPT-4[1]模型提取核心信息并總結(jié)每個(gè)案例。這一步驟減少了信息過載,并確保我們的數(shù)據(jù)集適應(yīng)Gemma的約束,特別是令牌大小限制。GPT-4預(yù)處理指令如下:

我有一個(gè)法律案例描述,需要兩個(gè)不同的信息:

1.摘要:請(qǐng)?zhí)峁┌讣脑敿?xì)摘要,重點(diǎn)關(guān)注事實(shí)和事件。排除任何關(guān)于判決結(jié)果的信息。

2.判決:說明案件的判決結(jié)果,考慮以下類別:

- 原告勝訴

- 被告勝訴

- 和解

- 案件駁回

- 不確定

如果提到了判決結(jié)果,請(qǐng)僅用所選類別回答。如果結(jié)果未明確提及或無法從給定信息中推斷,請(qǐng)僅回答"不確定"。

請(qǐng)按以下格式回復(fù):

對(duì)于摘要,以"Answer 1:"開頭

對(duì)于判決,以"Answer 2:"開頭

以下是案件描述:

[案件描述...]

此步驟的輸出包括摘要案例和標(biāo)記的判決結(jié)果,格式如下:

{案件摘要,判決}=LLM(案件詳情,最大令牌|di)。 (2)

對(duì)于每個(gè)法律案例di,我們將數(shù)據(jù)重新組織為新格式d′i,定義為:

d′i={標(biāo)題,日期,法官,原告,原告律師,被告,被告律師,案件摘要}。

D′={(d′1,v′1),(d′2,v′2),...,(d′n,v′n)}. (4)

在將D′分為訓(xùn)練和測(cè)試數(shù)據(jù)時(shí)存在一些約束。我們確保所有法律案例至少具有五個(gè)判例關(guān)系。為確保訓(xùn)練平衡,訓(xùn)練數(shù)據(jù)集包含25%的以下每個(gè)類別:原告勝訴、被告勝訴、和解和案件駁回。我們還確保所有測(cè)試法律案例至少具有五個(gè)與訓(xùn)練數(shù)據(jù)集連接的判例關(guān)系,更多解釋見第4.1節(jié)數(shù)據(jù)劃分。

步驟2. 在步驟1之后,所有訓(xùn)練法律案例d′i使用OpenAI嵌入模型轉(zhuǎn)化為高維向量。該向量數(shù)據(jù)庫隨后用于基于語義和上下文相似性檢索前k個(gè)相似案例。

步驟3. 此步驟涉及將訓(xùn)練數(shù)據(jù)集中的判例案例關(guān)系轉(zhuǎn)化為知識(shí)圖譜(KG)。定義為KG=(E,R,L),其中E表示實(shí)體,R表示二元關(guān)系(表示判例關(guān)系),L?E×R×E表示構(gòu)成圖邊的三元組集合。每個(gè)三元組(es,r,et)∈L表示通過關(guān)系r從源實(shí)體es到目標(biāo)實(shí)體et的有向邊。KG數(shù)據(jù)結(jié)構(gòu)簡(jiǎn)化了識(shí)別相關(guān)判例案例的復(fù)雜任務(wù),將其轉(zhuǎn)化為實(shí)體預(yù)測(cè)問題,即給定查詢(es,r,?),模型將預(yù)測(cè)缺失的實(shí)體。

我們進(jìn)一步為SCR、PCR和LJP任務(wù)定制數(shù)據(jù)處理,確保LawLLM的穩(wěn)健和有效實(shí)施。

3.2 相似案例檢索

如圖2右上角所示,SCR過程分為兩個(gè)階段:訓(xùn)練(步驟1-2)和測(cè)試(步驟3-4)。

訓(xùn)練階段。在訓(xùn)練期間,每個(gè)訓(xùn)練案例d′i輸入到向量數(shù)據(jù)庫,生成前10個(gè)候選案例。這些案例隨后按隨機(jī)順序排列,并格式化為SCR訓(xùn)練指令。以下是SCR模型輸入的示例:

指令:

您是一位法律專家,專門比較用戶提供的法律案例與候選法律案例列表,其中包括標(biāo)題和內(nèi)容。您的主要功能是根據(jù)提供的描述,從列表中識(shí)別并輸出最相似案例的標(biāo)題。

您應(yīng)僅輸出案例標(biāo)題,不包含任何其他信息。

考慮以下選項(xiàng):

選項(xiàng)1:

[案例1...]

選項(xiàng)2:

選項(xiàng)10:

[案例10...]

輸入:

[輸入案例...]

在此場(chǎng)景中,SCR任務(wù)指令屬于分類類別,為模型提供10個(gè)案例以選擇最相似的一個(gè)。需要注意的是,前0個(gè)相似案例是案例d′i本身,因此在實(shí)際操作中,我們從向量數(shù)據(jù)庫中檢索前1到前10個(gè)相似案例,此選擇中的前1個(gè)案例作為此訓(xùn)練任務(wù)的真實(shí)標(biāo)簽。

測(cè)試階段。測(cè)試階段與訓(xùn)練過程類似,我們最初從向量數(shù)據(jù)庫中檢索前10個(gè)相似案例。然而,在測(cè)試期間,我們檢索排名從前0到前9的案例,因?yàn)闇y(cè)試案例本身不包含在向量數(shù)據(jù)庫中。模型的預(yù)期響應(yīng)取決于我們使用的評(píng)估指標(biāo):前1、前3和前5。對(duì)于前1指標(biāo),我們期望LawLLM將最相似案例識(shí)別為第一個(gè)結(jié)果。前3指標(biāo)評(píng)估模型的答案是否在前三個(gè)檢索到的候選案例中,而前5指標(biāo)將此評(píng)估擴(kuò)展到前五個(gè)候選案例。

3.3 判例案例推薦

LawLLM中的判例案例推薦(PCR)采用了一種獨(dú)特方法,利用判例案例知識(shí)圖譜(KG),這與通常推測(cè)潛在判例關(guān)系的傳統(tǒng)PCR方法不同。我們的系統(tǒng)依賴于已確認(rèn)的判例對(duì),如圖2左下角所示,其中步驟1和2構(gòu)成訓(xùn)練階段,步驟3-5是測(cè)試階段。

訓(xùn)練階段。從先前建立的KG中,對(duì)于每個(gè)確認(rèn)的三元組(es,r,et),我們使用BERT嵌入[7]評(píng)估各種案例特征(如法官、案件詳情、原告或被告)之間的相似性,記為{F1,F2,...Fj}。我們計(jì)算每個(gè)特征對(duì)F1i和F2i的相似性分?jǐn)?shù)Si,如下:

Si=sim(BERT(F1i),BERT(F2i)), i∈{1?j}

所有特征中最高的相似性分?jǐn)?shù)決定了其判例關(guān)系的主要因素:

主要因素=max(S1,S2,...,Sj).

在創(chuàng)建訓(xùn)練輸入時(shí),我們?yōu)槟P吞峁┛偣?0個(gè)選項(xiàng)。真實(shí)判例案例et隨機(jī)放置在這些選項(xiàng)中,其他9個(gè)選項(xiàng)填充來自向量數(shù)據(jù)庫的相似但非判例案例。此設(shè)置旨在教導(dǎo)模型文本相似性不一定意味著判例關(guān)系。模型的預(yù)期輸出包括正確的判例案例et及其選擇理由(即哪個(gè)主要因素導(dǎo)致此判例關(guān)系)。以下是模型輸入的示例:

指令:

您是一位法律專家,專門比較用戶提供的法律案例與候選法律案例列表,其中包括標(biāo)題和內(nèi)容。您的主要功能是根據(jù)提供的描述,從列表中識(shí)別并輸出判例案例。

您應(yīng)僅輸出推理過程和案例標(biāo)題。

考慮以下選項(xiàng):

選項(xiàng)1:

[案例1...]

選項(xiàng)2:

選項(xiàng)10:

[案例10...]

輸入:

[輸入案例...]

測(cè)試階段。對(duì)于每個(gè)測(cè)試案例,由于我們確保訓(xùn)練數(shù)據(jù)集中至少存在五個(gè)判例案例,我們可以從KG(由訓(xùn)練數(shù)據(jù)集構(gòu)建)中識(shí)別k個(gè)判例案例作為真實(shí)標(biāo)簽,其中k與前k評(píng)估指標(biāo)一致。對(duì)于前1指標(biāo),選擇一個(gè)真實(shí)判例案例,而對(duì)于前3和前5指標(biāo),分別選擇3個(gè)和5個(gè)真實(shí)標(biāo)簽。剩余的10?k個(gè)位置填充相似案例。然后,模型的任務(wù)是從k個(gè)判例案例中選擇一個(gè),并解釋其選擇背后的推理。

3.4 法律判決預(yù)測(cè)

法律判決預(yù)測(cè)(LJP)處理利用數(shù)據(jù)預(yù)處理階段構(gòu)建的數(shù)據(jù)集D′。該數(shù)據(jù)集將每個(gè)處理后的法律案例d′i與其對(duì)應(yīng)的判決v′i配對(duì)。如圖2右下角所示,訓(xùn)練階段包括步驟1,測(cè)試階段包括其余步驟。

訓(xùn)練階段。我們使用(d′i,v′i)建立一個(gè)四分類訓(xùn)練輸入,原告勝訴、被告勝訴、和解或案件駁回。每個(gè)案例對(duì)應(yīng)的判決v′i作為訓(xùn)練標(biāo)簽。以下是模型輸入的示例:

指令:

您是一位法律專家,專門預(yù)測(cè)法律案例的結(jié)果。利用您的內(nèi)部知識(shí)庫預(yù)測(cè)判決。您的主要功能是預(yù)測(cè)用戶提供的法律案例的可能判決。

您應(yīng)僅輸出判決結(jié)果,不包含任何其他信息。

考慮以下選項(xiàng):

- 被告勝訴

- 原告勝訴

- 和解

- 案件駁回

輸入:

[輸入案例...]

測(cè)試階段。在測(cè)試階段,我們?cè)诹銟颖竞蜕贅颖旧舷挛膶W(xué)習(xí)(ICL)場(chǎng)景下評(píng)估LawLLM。在少樣本ICL中,我們?yōu)槊總€(gè)測(cè)試案例d′i增強(qiáng)額外的上下文信息,一個(gè)相似案例和一個(gè)判例案例。其判例案例來自我們的KG,隨機(jī)選擇一個(gè)包含在測(cè)試輸入中。同時(shí),從向量數(shù)據(jù)庫中檢索一個(gè)最相似案例。這種方法確保模型的預(yù)測(cè)受到相關(guān)法律判例和相似案例事實(shí)的影響,從而提高判決預(yù)測(cè)的準(zhǔn)確性和可靠性。

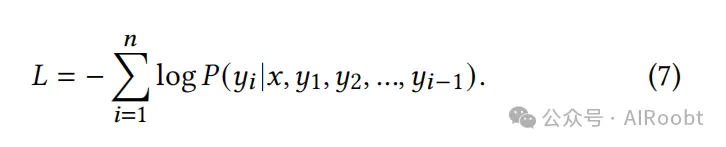

3.5 統(tǒng)一模型微調(diào)

我們的方法涉及對(duì)LawLLM采用統(tǒng)一的微調(diào)策略,利用包含三個(gè)任務(wù)的組合數(shù)據(jù)集。該數(shù)據(jù)集記為Datasetcombined=LJP⊕PCR⊕SCR。我們采用前沿的4位量化低秩適應(yīng)(LoRA)技術(shù)對(duì)Gemma模型進(jìn)行指令微調(diào)。我們?cè)贚oRA期間使用交叉熵?fù)p失函數(shù)L。它計(jì)算模型預(yù)測(cè)的令牌概率與預(yù)期輸出序列中實(shí)際令牌概率之間的差異。在以下方程中,n表示預(yù)期輸出序列的長(zhǎng)度,x表示輸入指令,yi表示預(yù)期輸出序列中的第i個(gè)令牌。

4 實(shí)驗(yàn)

在本節(jié)中,我們進(jìn)行實(shí)驗(yàn)以評(píng)估LawLLM在三個(gè)任務(wù)上的性能:相似案例檢索(SCR)、判例案例推薦(PCR)和法律判決預(yù)測(cè)(LJP)。

4.1 實(shí)驗(yàn)設(shè)置

數(shù)據(jù)集。我們?cè)贑aseLaw數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),該數(shù)據(jù)集由哈佛法學(xué)院圖書館創(chuàng)新實(shí)驗(yàn)室作為CaseLaw項(xiàng)目[10]啟動(dòng)。該數(shù)據(jù)庫包含來自美國各州和聯(lián)邦法院的廣泛案例。該項(xiàng)目主要致力于通過其案例訪問項(xiàng)目(CAP)實(shí)現(xiàn)美國法律信息的民主化訪問,旨在提供免費(fèi)和公開的訪問。我們實(shí)驗(yàn)中使用的CaseLaw數(shù)據(jù)集的統(tǒng)計(jì)數(shù)據(jù)如表1所示。

表1:數(shù)據(jù)集統(tǒng)計(jì)

評(píng)估指標(biāo)。如前所述,我們采用前k指標(biāo)來評(píng)估SCR和PCR任務(wù)的性能。具體來說,我們使用前1、前3和前5指標(biāo)。這些指標(biāo)衡量模型從10個(gè)選項(xiàng)池中識(shí)別正確答案的精確度。例如,前1指標(biāo)要求模型返回前一個(gè)選擇作為答案。前3和前5指標(biāo)提供更多靈活性,允許正確答案在前三個(gè)或前五個(gè)選擇中的任何位置。

除了前k指標(biāo)外,我們還使用"未找到"指標(biāo)評(píng)估模型的幻覺率。該指標(biāo)跟蹤完全虛構(gòu)且與10個(gè)給定選擇不匹配的響應(yīng)比例。通過測(cè)量"未找到"率,我們旨在了解模型產(chǎn)生與提供選項(xiàng)無關(guān)答案的頻率,從而洞察其可靠性。

對(duì)于LJP任務(wù),我們采用準(zhǔn)確率和F1分?jǐn)?shù)[24]指標(biāo)來衡量模型的性能。準(zhǔn)確率計(jì)算所有案例中正確預(yù)測(cè)判決的比例,提供了整體預(yù)測(cè)性能的直接度量。F1分?jǐn)?shù)范圍從0到1,將精確率和召回率結(jié)合為單個(gè)調(diào)和平均值,提供了模型有效性的平衡評(píng)估。

數(shù)據(jù)劃分。如前所述,我們的數(shù)據(jù)根據(jù)三個(gè)約束進(jìn)行劃分。

- 約束1:對(duì)于PCR,我們采用前k評(píng)估指標(biāo),這意味著每個(gè)案例必須至少具有五個(gè)判例案例,允許我們識(shí)別k個(gè)真實(shí)標(biāo)簽。

- 約束2:我們必須確保在評(píng)估測(cè)試案例時(shí),其真實(shí)判例案例可以在由訓(xùn)練案例形成的知識(shí)圖譜中找到。因此,每個(gè)測(cè)試案例必須至少在訓(xùn)練數(shù)據(jù)中存在五個(gè)判例案例。

- 約束3:為確保法律判決預(yù)測(cè)(LJP)的平衡模型訓(xùn)練,訓(xùn)練數(shù)據(jù)的判決分布應(yīng)包含每個(gè)可能結(jié)果的25%:原告勝訴、被告勝訴、和解和駁回。

這些方法導(dǎo)致總共1,000,000個(gè)案例用于訓(xùn)練,200,000個(gè)案例用于測(cè)試。

比較基線。我們的模型針對(duì)包括LLaMa2-7b[30]、Gemma-7b[29]、Vicuna-13b[37]和Guanaco-13b[6]在內(nèi)的先進(jìn)基線進(jìn)行評(píng)估,以及更大更先進(jìn)的GPT-3.5和GPT-4模型[1]。每個(gè)模型都經(jīng)過相同的測(cè)試階段,以確保在法律領(lǐng)域內(nèi)對(duì)其多任務(wù)能力進(jìn)行一致和公平的比較。

實(shí)現(xiàn)細(xì)節(jié)。我們使用A40 GPU對(duì)模型進(jìn)行了10個(gè)epoch的訓(xùn)練。為確保兼容性,我們監(jiān)控輸入令牌大小,將其限制在4096個(gè)令牌以內(nèi),以符合Gemma的最大令牌容量。此外,我們將模型的dropout率配置為0.1,并將學(xué)習(xí)率設(shè)置為2e^{-4}。

4.2 相似案例檢索結(jié)果

根據(jù)表2,LawLLM在所有類別中都優(yōu)于基線模型。具體而言,它在前1、前3和前5檢索率中實(shí)現(xiàn)了最高的準(zhǔn)確率,分別為29.8%、63.2%和81.6%。值得注意的是,它還表現(xiàn)出最小的幻覺,如0.1%的未找到率所示。

表2:SCR測(cè)試結(jié)果

相比之下,GPT-4表現(xiàn)出強(qiáng)大的性能,前1、前3和前5準(zhǔn)確率分別為27.5%、52.5%和70.5%,且未找到率低至0.5%。GPT-3.5也表現(xiàn)良好,尤其在前3和前5指標(biāo)中。另一方面,像LLaMa2-7b和Guanaco-13b這樣的模型顯示出更高的未找到率,表明傾向于產(chǎn)生幻覺。

結(jié)果強(qiáng)調(diào)了我們的LawLLM模型在準(zhǔn)確檢索相似案例同時(shí)最小化生成無關(guān)或不存在案例風(fēng)險(xiǎn)方面的有效性。

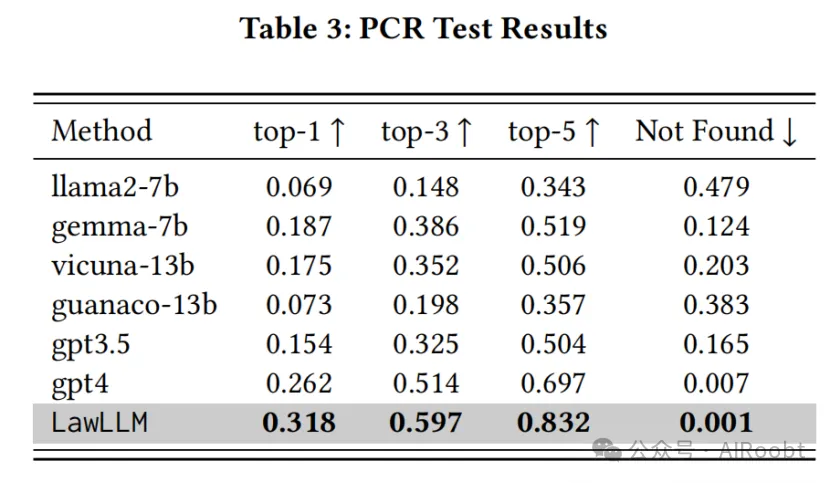

4.3 判例案例推薦結(jié)果

根據(jù)表3,LawLLM模型再次優(yōu)于其他基線方法。它在前1率31.8%、前3率59.7%和前5率83.2%方面取得了最佳結(jié)果。此外,LawLLM模型表現(xiàn)出較低的未找到率0.1%。

在基線模型中,GPT-4表現(xiàn)強(qiáng)勁,在前1、前3和前5指標(biāo)中具有高準(zhǔn)確率,同時(shí)未找到率非常低,表明推薦可靠且準(zhǔn)確。相比之下,像LLaMa2-7b和Guanaco-13b這樣的模型顯示出更高的未找到率,突顯了提供相關(guān)案例推薦的挑戰(zhàn)。總體結(jié)果表明LawLLM模型在PCR任務(wù)中的有效性,在準(zhǔn)確性和可靠性方面都超過了基線模型。

表3:PCR測(cè)試結(jié)果

比較SCR和PCR結(jié)果時(shí),一個(gè)值得注意的發(fā)現(xiàn)是大多數(shù)基線模型在PCR任務(wù)中與SCR相比表現(xiàn)出性能下降。例如,GPT-4模型在SCR前k和"未找到"指標(biāo)中得分為27.4%、52.6%、70.8%、0.5%,而在PCR任務(wù)中其得分降至26.2%、51.4%、69.7%和0.7%。這種下降突顯了識(shí)別判例案例比相似案例更困難,因?yàn)槟P驮诖_定判例關(guān)系時(shí)不能僅依賴文本相似性。相反,它們必須考慮法律相關(guān)性等細(xì)微因素。這種性能差異強(qiáng)化了我們先前的斷言,即判例案例與相似案例不同,強(qiáng)調(diào)了在法律領(lǐng)域中區(qū)分這兩個(gè)概念的重要性。

我們進(jìn)行了一項(xiàng)分析,以確定在top-1、top-3和top-5設(shè)置下,LawLLM在確定判例關(guān)系時(shí)主要考慮的因素。該分析涉及將我們的模型選擇每個(gè)因素作為主要決定因素的頻率與真實(shí)標(biāo)簽(GT)分布進(jìn)行比較。如表4所示,GT分布主要偏向"案件詳情"因素,對(duì)其他因素也有一定偏向。在top-1場(chǎng)景中,當(dāng)10個(gè)選項(xiàng)中有1個(gè)正確判例案例和9個(gè)相似案例時(shí),我們的模型強(qiáng)烈關(guān)注"案件詳情"因素。這種偏向可能源于GT分布對(duì)"案件詳情"的重視,導(dǎo)致我們的模型在面對(duì)眾多作為潛在干擾的相似案例時(shí)優(yōu)先考慮這一因素。然而,隨著正確答案池?cái)U(kuò)展到top-3和top-5場(chǎng)景中的3個(gè)和5個(gè),LawLLM開始略微多樣化其關(guān)注點(diǎn),包括其他因素,盡管"案件詳情"仍然占主導(dǎo)地位。這一趨勢(shì)表明,隨著正確答案數(shù)量的增加,LawLLM會(huì)調(diào)整其關(guān)注點(diǎn),采取更平衡的方法,同時(shí)仍反映GT數(shù)據(jù)的主要傾向。

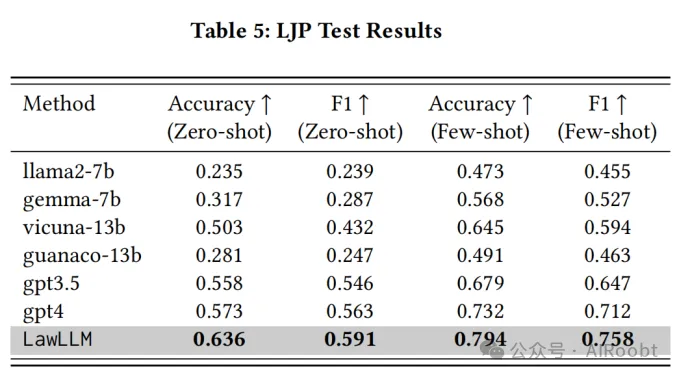

4.4 法律判決預(yù)測(cè)結(jié)果

如表5所示,LawLLM在LJP任務(wù)的零樣本和少樣本場(chǎng)景中均超越了所有基線方法。在零樣本場(chǎng)景中,LawLLM的準(zhǔn)確率為0.636,F(xiàn)1分?jǐn)?shù)為0.591,顯著優(yōu)于排名第二的GPT-4模型(準(zhǔn)確率0.573,F(xiàn)1分?jǐn)?shù)0.563)。在少樣本場(chǎng)景中,LawLLM保持了其卓越性能,準(zhǔn)確率達(dá)到0.794,F(xiàn)1分?jǐn)?shù)為0.758。

這些結(jié)果相較于最接近的競(jìng)爭(zhēng)對(duì)手GPT-4(準(zhǔn)確率0.732,F(xiàn)1分?jǐn)?shù)0.712)有顯著提升。此外,所有模型在少樣本上下文學(xué)習(xí)(ICL)場(chǎng)景中的表現(xiàn)均優(yōu)于零樣本設(shè)置。例如,LLaMA2-7b的準(zhǔn)確率從0.235提升至0.473,F(xiàn)1分?jǐn)?shù)從0.239提升至0.455。這一模式表明,所有模型都能通過結(jié)合少量ICL示例受益,從而更好地理解任務(wù)。

5. 結(jié)論與未來工作

在本研究中,我們提出了法律大語言模型(LawLLM),這是一個(gè)專為美國法律領(lǐng)域設(shè)計(jì)的多任務(wù)LLM。通過為每個(gè)任務(wù)定制獨(dú)特的數(shù)據(jù)處理技術(shù),LawLLM能夠有效處理相似案例檢索(SCR)、判例案例推薦(PCR)和法律判決預(yù)測(cè)(LJP)。此外,我們強(qiáng)調(diào)了判例關(guān)系與文本相似性之間的關(guān)鍵區(qū)別,為未來開發(fā)任務(wù)專用模型的研究提供了重要見解。我們的實(shí)驗(yàn)結(jié)果一致表明,LawLLM優(yōu)于現(xiàn)有基線模型,展現(xiàn)了其卓越的多任務(wù)能力。

未來,我們計(jì)劃通過納入更多法律任務(wù)來擴(kuò)展LawLLM的范圍,進(jìn)一步提升其多功能性和實(shí)際適用性。這將涉及探索法律分析中的新興挑戰(zhàn),并整合反映多樣化法律背景的新數(shù)據(jù)集。此外,我們計(jì)劃改進(jìn)數(shù)據(jù)處理技術(shù)和上下文學(xué)習(xí)方法,以增強(qiáng)模型對(duì)法律細(xì)節(jié)和判例的理解。

本文轉(zhuǎn)載自公眾號(hào)AIRoobt ,作者:Dong Shu等

原文鏈接:??https://mp.weixin.qq.com/s/5lPoaiOz7dVo6GsgE86aqw??