突發!DeepSeek開源新版V3,再次震驚國外

昨晚,國內著名大模型平臺DeepSeek開源了V3模型的最新版本0324。

不過DeepSeek相當低調,國內的公眾號、國外的社交平臺沒有做任何宣傳,就是“悄悄”地把模型上傳到huggingface。

根據國外網友測試顯示,V3-0324最大亮點之一就是代碼能力,只需要簡單的文本提示就能快速開發各種網站、App,可以比肩目前全球最強的閉源代碼模型Claude 3.7 Sonnet思維鏈版本。

但V3-0324是開源且免費的,推理效率更快。

開源地址:https://huggingface.co/deepseek-ai/DeepSeek-V3-0324/tree/main

有網友表示,新版V3 在不到 60 秒的時間內解開了一道密碼謎題。Sonnet 3.7 花了大約 5 分鐘卻未能解開。

這就是為什么我不介意中國領先。他們有人力資源,這個巨人已經覺醒,我們將從中獲得更好的科技成果。

有網友分析,認為這很可能是去年年底發布的 DeepSeek V3 的一次迭代更新,就像 OpenAI 一直在更新他們的模型一樣,而沒有真正增加模型的編號(我不知道我們已經見過多少個 gpt-4 的迭代版本)。

DeepSeek V3 實際上比 R1 更適合許多創意寫作任務,因為它更快。速度很重要,因為你可以更快速地進行多次迭代。幻覺和準確性不足并不是大問題,因為人類應該編輯和批準文本。

DeepSeek的影響凸顯了一個重要的技術轉變。

還有人立刻對V3-0324進行了評測,一次性開發了一個網站寫了800多行代碼且沒有出現任何錯誤。這是免費的、開源的、超級快的。很高興看到這些開源模型如何給大公司施加壓力,促使它們以更低的成本構建更好的模型。

新版V3 模型僅用一個提示就完成了這個登陸頁面的編碼。這個新的 DeepSeek-V3 模型在編程能力上已經達到了和 Claude 3.7 Sonnet 相同的水平,同時還是無限制且免費的。

提示詞:用 HTML/CSS/JS 編寫一個現代化的登陸頁面,并將所有內容放到一個文件中!

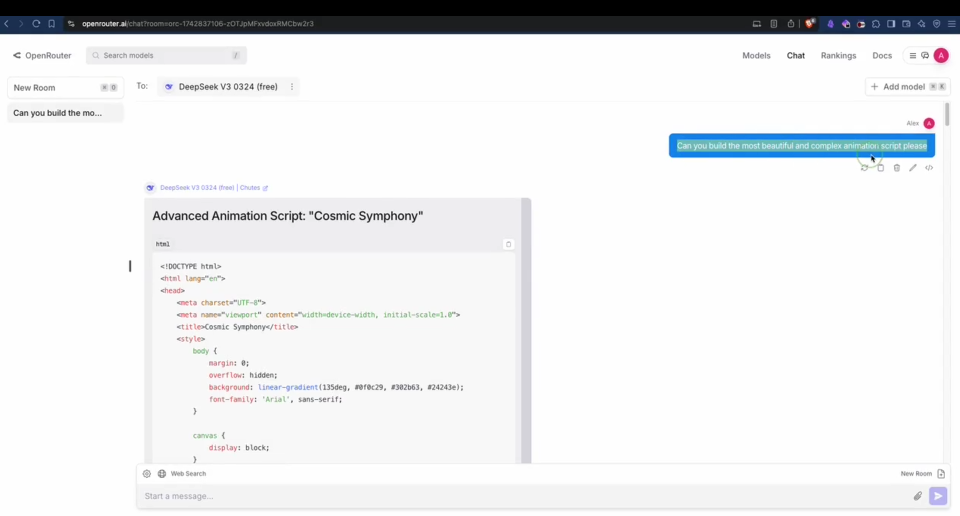

我讓新的 DeepSeek V3 模型構建最美麗且復雜的動畫腳本。只用一個 HTML/JS 腳本!

該網友還補充道“我們正在與未來對話”,相當滿意V3的代碼能力。

V3簡單介紹

V3是一個擁有 6710 億參數的專家混合模型(Moe),其中370 億參數處于激活狀態。

在傳統的大模型中,通常會采用密集的神經網絡結構,模型需要對每一個輸入token都會被激活并參與計算,會耗費大量算力。

此外,傳統的混合專家模型中,不平衡的專家負載是一個很大難題。當負載不均衡時,會引發路由崩潰現象,這就好比交通擁堵時道路癱瘓一樣,數據在模型中的傳遞受到阻礙,導致計算效率大幅下降。

為了解決這個問題,常規的做法是依賴輔助損失來平衡負載。然而,這種方法存在一個弊端,那就是輔助損失一旦設置過大,就會對模型性能產生負面影響,就像為了疏通交通而設置過多限制,卻影響了整體的通行效率。

DeepSeek對V3進行了大膽創新,提出了輔助損失免費的負載均衡策略,引入“偏差項”。在模型訓練過程中,每個專家都被賦予了一個偏差項,它會被添加到相應的親和力分數上,以此來決定top-K路由。

模型會持續監測每一批訓練數據中專家的負載情況。如果某個專家負載過重,就像一座橋梁承受了過多的車輛,此時就減小其偏差項;反之,如果負載過輕,就增加偏差項。

通過這種動態調整, V3能夠在訓練過程中有效平衡專家負載,而且相比那些僅依靠純輔助損失來平衡負載的模型,它的性能得到了顯著提升。

此外,V3還采用了節點受限的路由機制,以限制通信成本。在大規模分布式訓練中,跨節點的通信開銷是一個重要的性能瓶頸。通過確保每個輸入最多只能被發送到預設數量的節點上,V3 能夠顯著減少跨節點通信的流量,從而提高訓練效率。

這種路由機制不僅減少了通信開銷,還使得模型能夠在保持高效的計算-通信重疊的同時,擴展到更多的節點和專家。

根據國外開源評測平臺kcores-llm-arena對V3-0324最新測試數據顯示,其代碼能力達到了328.3分,超過了普通版的Claude 3.7 Sonnet(322.3),可以比肩334.8分的思維鏈版本。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區