DeepSeek開源DeepEP,公開大模型訓(xùn)練效率暴漲秘訣!

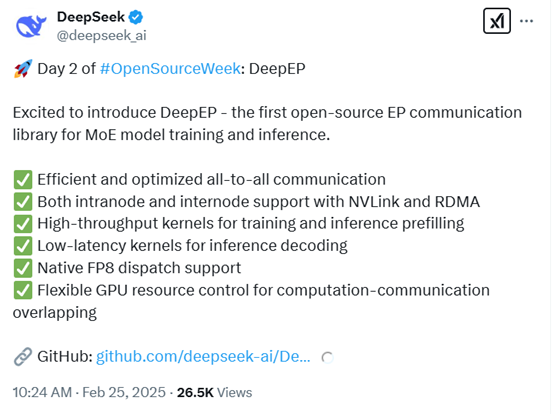

DeepSeek開啟了本周連續(xù)5天技術(shù)分享的第2天,開源了專為混合專家模型(MoE)訓(xùn)練和推理設(shè)計的開源EP通信庫——DeepEP。

值得一提的是,DeepSeek昨天開源的FlashMLA已經(jīng)超過7000顆星,成為github霸榜項目。今天這個已經(jīng)破1000顆星啦。

開源地址:https://github.com/deepseek-ai/DeepEP

通常在MoE模型中,不同的GPU節(jié)點往往需要分工合作處理數(shù)據(jù),而All-to-All通信是一種常見的模式,用來實現(xiàn)GPU之間數(shù)據(jù)的互相交換。

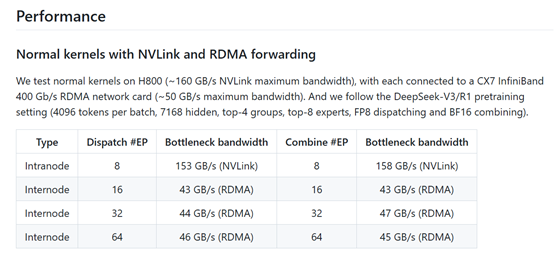

DeepEP通過高效且優(yōu)化的All-to-All通信機制,支持節(jié)點內(nèi)部和節(jié)點之間的通信,分別利用NVLink和RDMA實現(xiàn)。

例如,假設(shè)你有4個GPU,每個GPU專注于處理部分“專家模塊”,通過All-to-All通信,GPU1需要將部分?jǐn)?shù)據(jù)發(fā)給GPU2,同時也從GPU3接收數(shù)據(jù)。DeepEP優(yōu)化了這種通信方式,讓數(shù)據(jù)交換更快更高效。

同時,DeepEP還支持高吞吐量和低延遲內(nèi)核。高吞吐量內(nèi)核適用于訓(xùn)練中的數(shù)據(jù)批量處理階段,比如預(yù)填充大批量數(shù)據(jù)時,能夠顯著提升訓(xùn)練速度。而低延遲內(nèi)核則針對推理解碼階段,低延遲的計算能夠讓生成結(jié)果更快。

例如,推理時,如果GPT模型正在完成一句話生成,低延遲內(nèi)核會減少每個單詞生成的等待時間。

DeepEP原生支持FP8分發(fā)。FP8是一種更低精度的計算格式,相比于傳統(tǒng)的FP16或FP32,更節(jié)省顯存和計算資源,同時還能保持一定的精度。例如,在使用超大MoE模型生成文本時,使用FP8可以顯著減少計算成本,DeepEP天生支持這種低精度操作。

此外,DeepEP還實現(xiàn)了計算與通信的重疊。在深度學(xué)習(xí)中,通信(傳輸數(shù)據(jù))和計算往往是分階段進行的,而DeepEP可以讓這兩者同時進行,進一步提升整體效率。例如,在訓(xùn)練過程中,一個GPU可以在等待通信完成的同時,繼續(xù)處理其他計算任務(wù),從而避免浪費時間。

網(wǎng)友表示,DeepSeek 對混合專家模型的優(yōu)化程度令人矚目,這類模型因其規(guī)模和復(fù)雜性而極難處理。DeepEP利用 NVLink 和 RDMA 等前沿硬件,如此精準(zhǔn)地應(yīng)對挑戰(zhàn)并支持 FP8 數(shù)據(jù)格式,實在是太厲害了。

更多 CUDA 內(nèi)核!又是出色的成果!

DeepEP來了,它將給 AI 模型訓(xùn)練帶來革命性變化!

本文轉(zhuǎn)自 AIGC開放社區(qū) ,作者:AIGC開放社區(qū)