LLM合集:視頻生成新王炸!Step-Video-T2V,全方位碾壓開源與商業模型

1. Step-Video-T2V Technical Report: The Practice, Challenges, and Future of Video Foundation Model

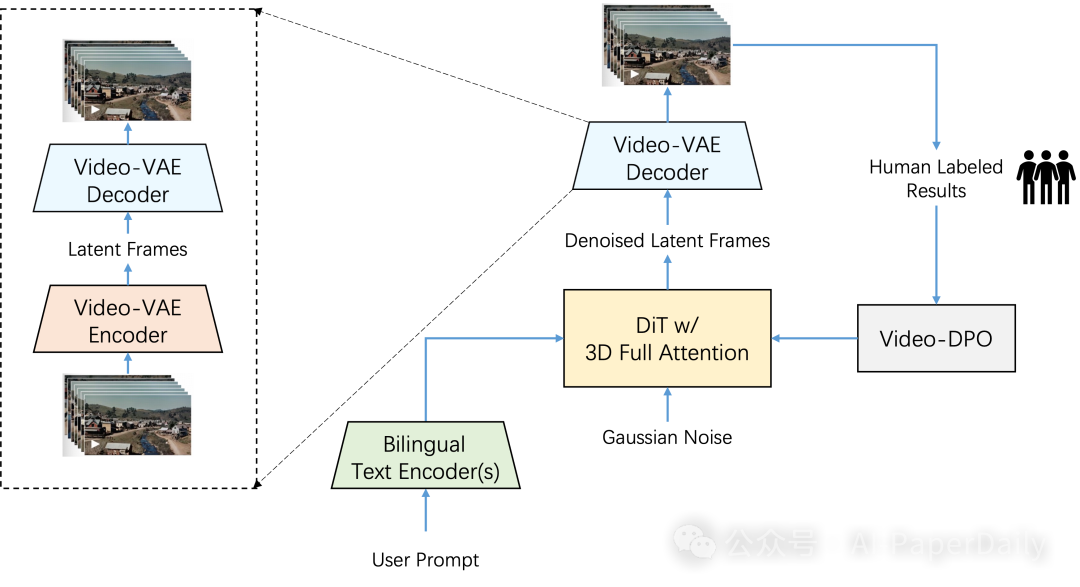

我們提出了 Step-Video-T2V,這是個有 300 億參數的超厲害的文本到視頻預訓練模型,它能生成有 204 幀那么長的視頻內容。為了做好視頻生成這個任務,我們專門設計了一個深度壓縮變分自動編碼器,也就是 Video-VAE。它能把空間壓縮到 16x16,時間上壓縮 8 倍,還能保證視頻重建的質量非常高。。

用戶要是輸入提示內容,我們用兩個雙語文本編碼器來處理,不管是英語還是中文都沒問題。我們還通過 Flow Matching 訓練了一個帶 3D 全注意力機制的 DiT 模型,它能把輸入的噪聲去掉,變成有用的潛在幀。另外,我們還用了基于視頻的 DPO 方法,也就是視頻 - DPO,這么做是為了減少視頻里的瑕疵,讓生成的視頻看起來畫質更好。

我們還整理了詳細的訓練策略,這里面的關鍵要點和一些發現也都能分享給大家。我們在新的視頻生成基準 Step-Video-T2V-Eval 上測試了 Step-Video-T2V 的性能,結果表明,不管跟開源的還是商業的引擎比,它的文本轉視頻能力都是最牛的。要是大家想深入了解,我們會在https://github.com/stepfun-ai/Step-Video-T2V 分享 Step-Video-T2V 和 Step-Video-T2V-Eval 。

論文: ??https://arxiv.org/pdf/2502.10248??

2. Region-Adaptive Sampling for Diffusion Transformers

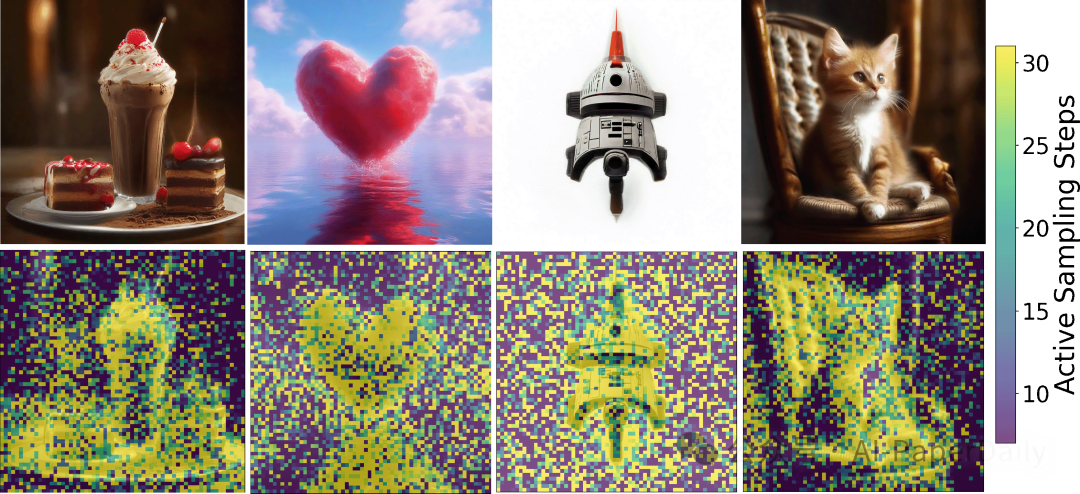

擴散模型在生成任務中很受歡迎,但多次順序前向傳遞影響實時性能。此前加速方法因卷積 U-Net 結構限制,無法利用圖像空間區域變化。

擴散 transformer(DiTs)能靈活處理不同數量標記,基于此我們提出無需訓練的 RAS 采樣策略,它可根據 DiT 模型關注點,動態分配不同區域采樣比例。 我們發現模型采樣時聚焦語義重要區域,且這些區域連續性強。RAS 利用這一特性,只更新關注區域,其他區域用上一步噪聲更新,依據上一步結果確定關注區域,利用時間一致性。

在 Stable Diffusion 3 和 Lumina-Next-T2I 上測試,RAS 最高分別提速 2.36 倍和 2.51 倍,圖像質量略有下降。用戶研究表明,RAS 生成質量與人評估相當,速度提升 1.6 倍。

論文: ??https://arxiv.org/pdf/2502.10389??

3. Large Language Diffusion Models

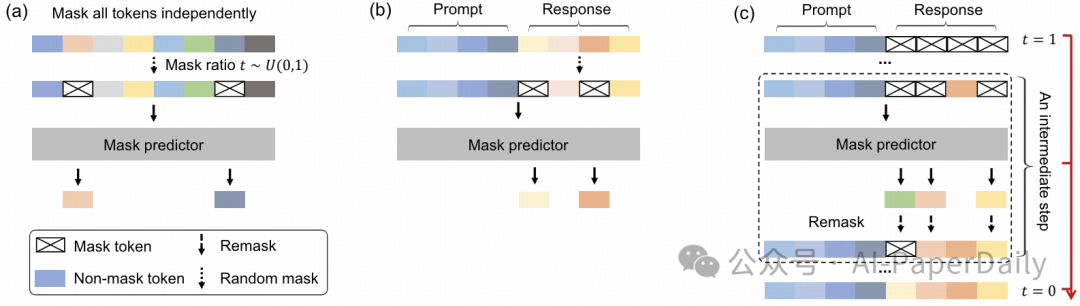

一直以來,大家都覺得自回歸模型(ARMs)是大語言模型(LLMs)的核心基礎。但今天我們提出了 LLaDA,這是一種擴散模型,它不走尋常路,是從預訓練和監督微調(SFT)這個全新的范式出發,完全從頭開始訓練的。

LLaDA 的原理其實不難理解,它通過正向的數據掩碼過程,還有一個反向過程來對分布進行建模。這里面起關鍵作用的是一個基礎 Transformer,它負責預測那些被掩碼的令牌。通過不斷優化似然性邊界,LLaDA 提供了一種很靠譜的生成方法,能夠進行概率推理。

在各種基準測試中,LLaDA 的表現相當驚艷。它展現出了強大的擴展能力,直接超越了我們自己搭建的自回歸模型基線。更讓人意想不到的是,LLaDA 8B 在上下文學習方面,居然能和 LLaMA3 8B 這樣厲害的大型語言模型一較高下。而且在微調之后,從案例研究來看,它在指令執行能力上,比如多輪對話,表現得非常出色。還有啊,LLaDA 還解決了反轉詛咒這個難題,在反轉詩歌完成任務中,連 GPT-4o 都不是它的對手。

論文: ??https://arxiv.org/pdf/2502.09992??

4. MM-RLHF: The Next Step Forward in Multimodal LLM Alignment

最近這些年,多模態大語言模型(MLLMs)確實取得了不小的進步,好多模型的表現都挺厲害。不過呢,這里面其實有個問題,大部分先進的模型都沒有好好地去和人類的偏好對齊。為啥會這樣呢?現在的對齊研究,主要是在一些特定的小領域有成果,像減少模型產生幻覺這方面,確實有進展。但有個更重要的問題卻一直沒怎么被深入研究,那就是按照人類的偏好來調整模型,到底能不能讓MLLM的能力得到系統性的提升呢?

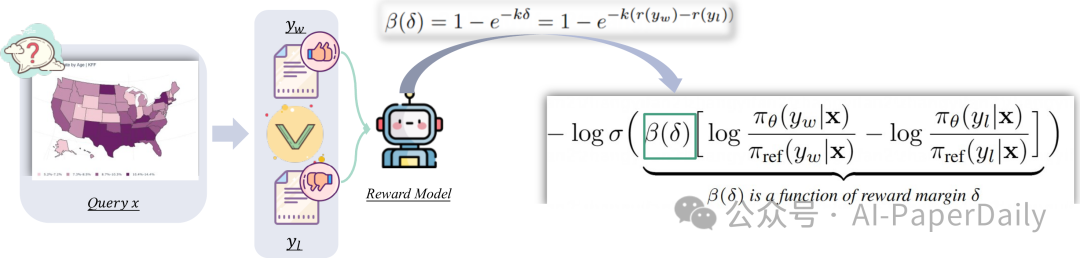

為了解決這個問題,我們提出了MM-RLHF數據集,這里面有12萬對經過人工仔細標注的偏好對比數據。和以前的那些數據集比起來,我們這個強太多了,數據量更大,涵蓋的范圍更廣,多樣性十足,質量也特別高。

有了這個數據集,我們還提出了一些新點子。一方面,我們做了個基于批評的獎勵模型。以前的獎勵機制就只是給個簡單的分數,我們這個不一樣,在打分之前,會先對模型的輸出給出詳細的評價和建議。這樣一來,大家就能更清楚模型好在哪、不好在哪,反饋的信息也更有用。另一方面,我們還提出了動態獎勵縮放方法。簡單來說,就是根據獎勵信號的情況,靈活調整每個樣本的損失權重,這樣就能把那些高質量的對比對利用得更充分。

為了驗證這些方法好不好用,我們做了大量的測試。在10個不同的維度,還有27個不同的基準測試里,都對我們的方法進行了嚴格的評估。結果特別讓人驚喜,模型的性能有了明顯的提升,而且在各種測試里表現都很穩定。就拿LLaVA-ov-7B這個模型舉例,用我們的MM-RLHF數據集和對齊算法對它進行微調之后,它的對話能力提高了19.5%,安全性更是提升了60%。

論文: ??https://arxiv.org/pdf/2502.10391??

本文轉載自 ??AI-PaperDaily??,作者: AI-PaperDaily