VLLM 與 Ollama:如何選擇合適的輕量級 LLM 框架?

VLLM是一款經(jīng)過優(yōu)化的推理引擎,在令牌生成速度和內(nèi)存管理效率上表現(xiàn)出色,是大規(guī)模AI應(yīng)用的理想之選。Ollama則是一個輕量級、易上手的框架,讓在本地電腦上運(yùn)行開源大語言模型變得更加簡單。

那么,這兩個框架該選哪一個呢?接下來,我們會從性能、易用性、適用場景、替代方案,以及詳細(xì)的安裝步驟等方面進(jìn)行全面對比,幫助你做出更合適的選擇。

一、VLLM和Ollama是什么?基礎(chǔ)知識解析

在深入探討之前,我們先來了解一下這兩個框架的核心功能。

什么是VLLM?

VLLM(超大型語言模型)是SKYPILOT開發(fā)的推理優(yōu)化框架,主要用于提升大語言模型在GPU上的運(yùn)行效率。它的優(yōu)勢體現(xiàn)在以下幾個方面:

- 快速令牌生成:采用連續(xù)批處理技術(shù),讓令牌生成速度大幅提升。

- 高效內(nèi)存利用:借助PagedAttention技術(shù),在處理大上下文窗口時,能有效控制GPU內(nèi)存消耗。

- 無縫集成:與PyTorch、TensorFlow等主流深度學(xué)習(xí)平臺兼容,可輕松融入AI工作流程。

VLLM深受AI研究人員和需要大規(guī)模高性能推理的企業(yè)青睞。

什么是奧拉瑪(Ollama)?

Ollama是一個本地大語言模型運(yùn)行時環(huán)境,能簡化開源AI模型的部署和使用流程。它具備以下特點(diǎn):

- 預(yù)打包模型豐富:內(nèi)置了LLaMA、Mistral、Falcon等多種模型。

- 硬件適配性強(qiáng):針對日常使用的硬件進(jìn)行了CPU和GPU推理優(yōu)化,無論是MacBook、PC還是邊緣設(shè)備,都能流暢運(yùn)行AI模型。

- 操作便捷:提供簡潔的API和命令行界面(CLI),開發(fā)人員只需簡單配置,就能快速啟動大語言模型。

對于想在個人電腦上嘗試AI模型的開發(fā)人員和AI愛好者來說,Ollama是個不錯的選擇。

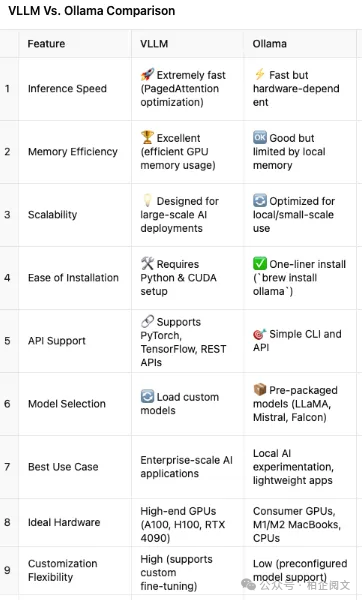

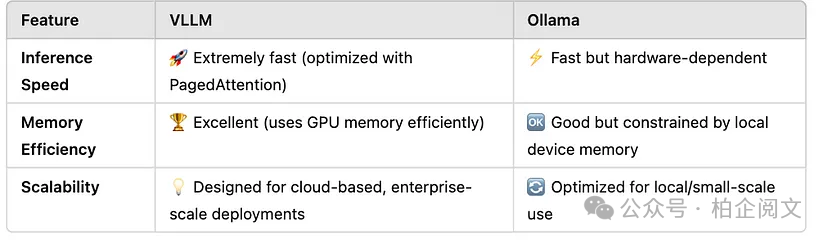

二、性能大比拼:速度、內(nèi)存與可擴(kuò)展性

性能是衡量推理框架優(yōu)劣的關(guān)鍵指標(biāo),下面我們從速度、內(nèi)存效率和可擴(kuò)展性三個方面,對VLLM和Ollama進(jìn)行對比。

關(guān)鍵性能指標(biāo)分析

VLLM借助PagedAttention技術(shù),在推理速度上優(yōu)勢明顯,處理大上下文窗口時也能游刃有余。這讓它成為聊天機(jī)器人、搜索引擎、AI寫作輔助工具等高性能AI應(yīng)用的首選。

Ollama的速度也還不錯,但受限于本地硬件配置。在MacBook、PC和邊緣設(shè)備上運(yùn)行小型模型時表現(xiàn)良好,不過遇到超大模型就有些力不從心了。

結(jié)論:Ollama更適合初學(xué)者,而需要深度定制的開發(fā)人員則可以選擇VLLM。

三、應(yīng)用場景:VLLM和Ollama分別適用于哪些場景?

VLLM的最佳應(yīng)用場景

- 企業(yè)AI應(yīng)用:如客戶服務(wù)聊天機(jī)器人、AI驅(qū)動的搜索引擎等。

- 云端高端GPU部署:適用于A100、H100、RTX 4090等高端GPU的云端大語言模型部署。

- 模型微調(diào)與定制:方便進(jìn)行模型微調(diào)和運(yùn)行自定義模型。

- 大上下文窗口需求:適用于對上下文窗口要求較高的應(yīng)用。

不太適用的場景:個人筆記本電腦、日常AI實(shí)驗(yàn)。

Ollama的最佳應(yīng)用場景

- 本地設(shè)備運(yùn)行:無需借助云資源,就能在Mac、Windows或Linux系統(tǒng)的設(shè)備上運(yùn)行大語言模型。

- 本地模型試驗(yàn):不需要復(fù)雜的設(shè)置,就能在本地輕松試驗(yàn)各種模型。

- 簡易API集成:開發(fā)人員可以通過簡單的API將AI功能集成到應(yīng)用程序中。

- 邊緣計算應(yīng)用:在邊緣計算場景中表現(xiàn)出色。

不太適用的場景:大規(guī)模AI部署、高強(qiáng)度GPU計算任務(wù)。

總結(jié):VLLM更適合AI工程師,而Ollama則是開發(fā)人員和AI愛好者的好幫手。

四、如何上手使用?(分步指南)

VLLM入門教程

- 安裝依賴項(xiàng):在命令行中輸入pip install vllm,按提示完成安裝。

- 在LLaMA模型上運(yùn)行推理:在Python環(huán)境中,輸入以下代碼:

from vllm import LLM

llm = LLM(model="meta-llama/Llama-2-7b")

output = llm.generate("What is VLLM?")上述代碼中,首先從vllm?庫中導(dǎo)入LLM?類,然后創(chuàng)建LLM?對象,并指定使用meta-llama/Llama-2-7b?模型。最后,使用generate方法輸入問題“What is VLLM?”,就能得到模型的輸出結(jié)果。

Ollama入門教程

- 安裝Ollama(Mac/Linux系統(tǒng)):在終端中輸入brew install ollama,等待安裝完成。

- 下載并運(yùn)行模型:在終端輸入ollama run mistral,即可下載并運(yùn)行Mistral模型。

- 調(diào)用Ollama的API:在Python環(huán)境中,使用以下代碼調(diào)用API:

import requests

response = requests.post("http://localhost:11434/api/generate", jsnotallow={"model": "mistral", "prompt": "Tell me a joke"})

print(response.json())上述代碼中,首先導(dǎo)入requests?庫,然后使用requests.post?方法向本地的Ollama API發(fā)送請求,請求地址為http://localhost:11434/api/generate?,并在請求中指定使用的模型為mistral,輸入的提示內(nèi)容為“Tell me a joke”。最后,打印API返回的結(jié)果。

總結(jié):Ollama安裝更簡單,而VLLM的定制性更強(qiáng)。