腦電合成自然語(yǔ)音!LeCun轉(zhuǎn)發(fā)Nature子刊新成果,代碼開(kāi)源

腦機(jī)接口最新進(jìn)展登上Nature子刊,深度學(xué)習(xí)三巨頭之一的LeCun都來(lái)轉(zhuǎn)發(fā)。

這次是用神經(jīng)信號(hào)進(jìn)行語(yǔ)音合成,幫助因神經(jīng)系統(tǒng)缺陷導(dǎo)致失語(yǔ)的人群重新獲得交流的能力。

具體來(lái)說(shuō),來(lái)自紐約大學(xué)的研究團(tuán)隊(duì)開(kāi)發(fā)了一個(gè)新型的可微分語(yǔ)音合成器,可以利用一個(gè)輕型的卷積神經(jīng)網(wǎng)絡(luò)將語(yǔ)音編碼為一系列可解釋的語(yǔ)音參數(shù)(如音高,響度,共振峰頻率等),并通過(guò)可微分語(yǔ)音合成器重新合成語(yǔ)音。

通過(guò)將神經(jīng)信號(hào)映射到這些語(yǔ)音參數(shù),研究者構(gòu)建了一個(gè)高度可解釋且可應(yīng)用于小數(shù)據(jù)量情形的神經(jīng)語(yǔ)音解碼系統(tǒng),可生成聽(tīng)起來(lái)自然的語(yǔ)音。

研究人員共收集了48位受試者的數(shù)據(jù)并嘗試進(jìn)行語(yǔ)音解碼,對(duì)未來(lái)的高準(zhǔn)確度的腦機(jī)接口應(yīng)用提供了驗(yàn)證。

結(jié)果表明,該框架能夠處理高低不同空間采樣密度,并且可以處理左、右半球的腦電信號(hào),顯示出了強(qiáng)大的語(yǔ)音解碼潛力。

神經(jīng)信號(hào)的語(yǔ)音解碼,難!

此前,馬斯克的Neuralink公司已經(jīng)在一位受試者腦內(nèi)成功植入電極,可以完成簡(jiǎn)單的光標(biāo)操控以實(shí)現(xiàn)打字等功能。

然而,神經(jīng)-語(yǔ)音解碼通常被認(rèn)為復(fù)雜度更高。

開(kāi)發(fā)神經(jīng)-語(yǔ)音解碼器和其他的高精度腦機(jī)接口模型的嘗試大多數(shù)依賴(lài)于一種特殊的數(shù)據(jù):皮層電圖(ECoG)記錄的受試者數(shù)據(jù),通常是從癲癇病人的治療過(guò)程中收集。

利用患有癲癇的患者植入的電極,在發(fā)音時(shí)收集大腦皮層數(shù)據(jù),這些數(shù)據(jù)具有高時(shí)空分辨率,已經(jīng)在語(yǔ)音解碼領(lǐng)域幫助研究者獲得了一系列很顯著的成果。

不過(guò),神經(jīng)信號(hào)的語(yǔ)音解碼還面臨著兩大挑戰(zhàn)。

- 用于訓(xùn)練個(gè)性化神經(jīng)到語(yǔ)音解碼模型的數(shù)據(jù)在時(shí)間上是非常有限的,通常只有十分鐘左右,而深度學(xué)習(xí)模型往往需要大量的訓(xùn)練數(shù)據(jù)來(lái)驅(qū)動(dòng)。

- 人類(lèi)的發(fā)音非常多樣,哪怕是同一個(gè)人重復(fù)說(shuō)出相同的單詞,語(yǔ)速、語(yǔ)調(diào)和音調(diào)等也會(huì)有變化,這給模型構(gòu)建的表征空間增加了復(fù)雜性。

早期的解碼神經(jīng)信號(hào)到語(yǔ)音的嘗試主要依賴(lài)于線(xiàn)性模型,模型通常不需要龐大的訓(xùn)練數(shù)據(jù)集,可解釋性強(qiáng),但是準(zhǔn)確率很低。

近期的基于深度神經(jīng)網(wǎng)絡(luò),尤其是利用卷積和循環(huán)神經(jīng)網(wǎng)絡(luò)架構(gòu),在模擬語(yǔ)音的中間潛在表示和合成后語(yǔ)音質(zhì)量?jī)蓚€(gè)關(guān)鍵維度上進(jìn)行了很多的嘗試。例如,有研究將大腦皮層活動(dòng)解碼成口型運(yùn)動(dòng)空間,然后再轉(zhuǎn)化為語(yǔ)音,雖然解碼性能強(qiáng)大,但重建的聲音聽(tīng)起來(lái)不自然。

另一方面,一些方法通過(guò)利用wavenet聲碼器、生成對(duì)抗網(wǎng)絡(luò)(GAN)等,雖然成功重建了自然聽(tīng)感的語(yǔ)音,但準(zhǔn)確度有限。

最近一項(xiàng)發(fā)表在Nature的研究,在一個(gè)植入了設(shè)備的患者身上,通過(guò)使用量化的HuBERT特征作為中間表示空間和預(yù)訓(xùn)練的語(yǔ)音合成器將這些特征轉(zhuǎn)換成語(yǔ)音,實(shí)現(xiàn)了既準(zhǔn)確又自然的語(yǔ)音波形。

然而,HuBERT特征不能表示發(fā)音者特有的聲學(xué)信息,只能生成固定統(tǒng)一的發(fā)音者聲音,因此需要額外的模型將這種通用聲音轉(zhuǎn)換為特定患者的聲音。此外,這項(xiàng)研究和大多數(shù)先前的嘗試采用了非因果(non-causal)架構(gòu),這可能限制其在需要時(shí)序因果(causal)操作的腦機(jī)接口實(shí)際應(yīng)用中的使用。

構(gòu)建可微分語(yǔ)音合成器

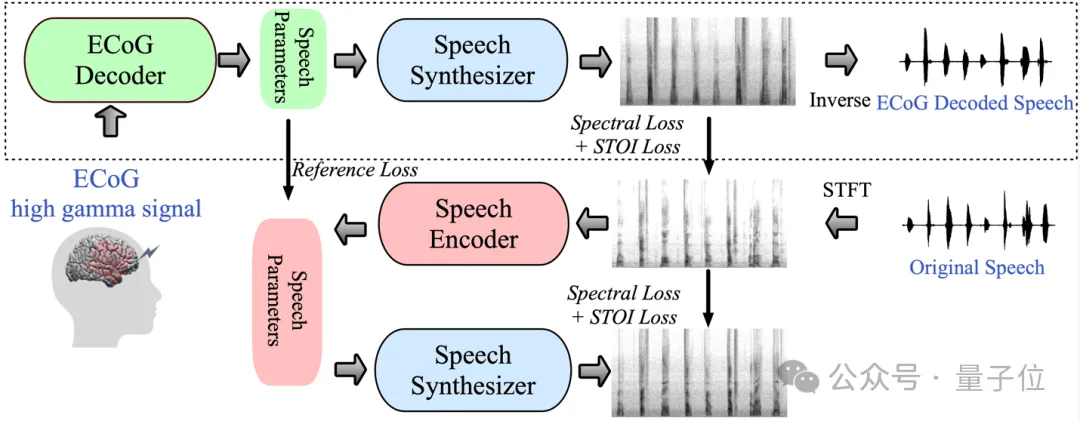

紐約大學(xué)Video Lab和Flinker Lab的研究團(tuán)隊(duì)介紹了一個(gè)新型的從腦電(ECoG)信號(hào)到語(yǔ)音的解碼框架,構(gòu)建了一個(gè)低維度的中間表示(low dimension latent representation),該表示通過(guò)僅使用語(yǔ)音信號(hào)的語(yǔ)音編解碼模型生成。

△神經(jīng)語(yǔ)音解碼框架

具體來(lái)說(shuō),框架由兩部分組成:

一部分是ECoG解碼器,它能將ECoG信號(hào)轉(zhuǎn)化為我們可以理解的聲學(xué)語(yǔ)音參數(shù)(比如音高、是否發(fā)聲、響度、以及共振峰頻率等);

另一部分是語(yǔ)音合成器,它將這些語(yǔ)音參數(shù)轉(zhuǎn)化為頻譜圖。

研究人員構(gòu)建了一個(gè)可微分語(yǔ)音合成器,這使得在訓(xùn)練ECoG解碼器的過(guò)程中,語(yǔ)音合成器也可以參與訓(xùn)練,共同優(yōu)化以減少頻譜圖重建的誤差。

這個(gè)低維度的潛在空間具有很強(qiáng)的可解釋性,加上輕量級(jí)的預(yù)訓(xùn)練語(yǔ)音編碼器生成參考用的語(yǔ)音參數(shù),幫助研究者構(gòu)建了一個(gè)高效的神經(jīng)語(yǔ)音解碼框架,克服了神經(jīng)語(yǔ)音解碼領(lǐng)域數(shù)據(jù)非常稀缺的問(wèn)題。

該框架能產(chǎn)生非常接近說(shuō)話(huà)人自己聲音的自然語(yǔ)音,并且ECoG解碼器部分可以插入不同的深度學(xué)習(xí)模型架構(gòu),也支持因果操作(causal operations)。

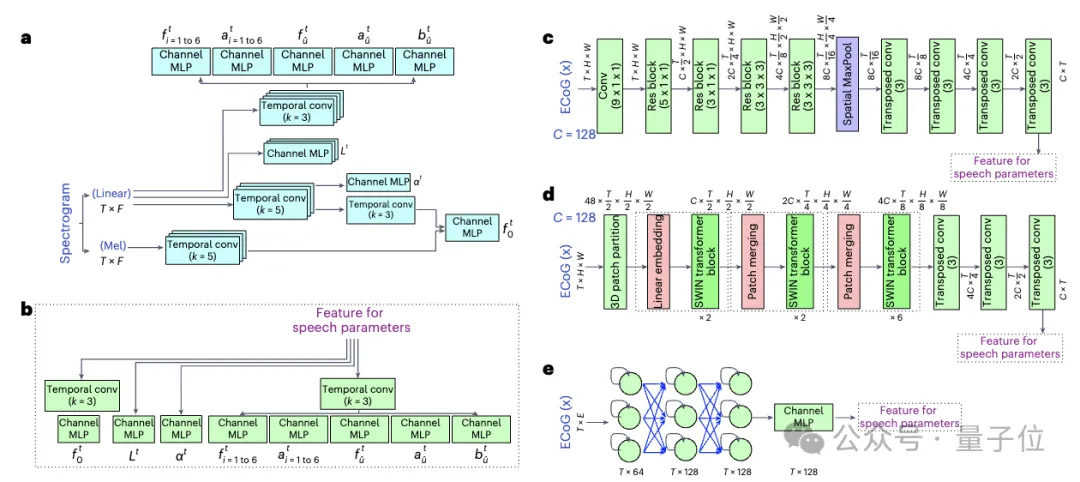

研究人員共收集并處理了48名神經(jīng)外科病人的ECoG數(shù)據(jù),使用多種深度學(xué)習(xí)架構(gòu)(包括卷積、循環(huán)神經(jīng)網(wǎng)絡(luò)和Transformer)作為ECoG解碼器。

該框架在各種模型上都展現(xiàn)出了高準(zhǔn)確度,其中以卷積(ResNet)架構(gòu)獲得的性能最好。本文研究人員提出的框架僅通過(guò)因果操作和相對(duì)較低的采樣率(low-density, 10mm spacing)就能實(shí)現(xiàn)高準(zhǔn)確度。

他們還展示了能夠從大腦的左右半球都進(jìn)行有效的語(yǔ)音解碼,將神經(jīng)語(yǔ)音解碼的應(yīng)用擴(kuò)展到了右腦。

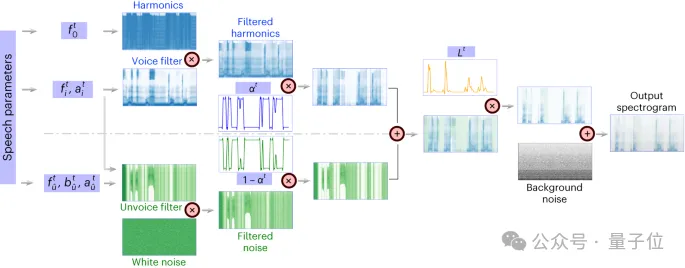

△可微分語(yǔ)音合成器架構(gòu)

可微分語(yǔ)音合成器(speech synthesizer),使得語(yǔ)音的重合成任務(wù)變得非常高效,可以用很小的語(yǔ)音合成高保真的貼合原聲的音頻。

可微分語(yǔ)音合成器的原理借鑒了人的發(fā)生系統(tǒng)原理,將語(yǔ)音分為Voice(用于建模元音)和Unvoice(用于建模輔音)兩部分。

Voice部分可以首先用基頻信號(hào)產(chǎn)生諧波,由F1-F6的共振峰組成的濾波器濾波得到元音部分的頻譜特征。

對(duì)于Unvoice部分,研究人員則是將白噪聲用相應(yīng)的濾波器濾波得到對(duì)應(yīng)的頻譜,一個(gè)可學(xué)習(xí)的參數(shù)可以調(diào)控兩部分在每個(gè)時(shí)刻的混合比例,在此之后通過(guò)響度信號(hào)放大,加入背景噪聲來(lái)得到最終的語(yǔ)音頻譜。

△語(yǔ)音編碼器和ECoG解碼器

研究結(jié)果

一、具有時(shí)序因果性的語(yǔ)音解碼結(jié)果

?

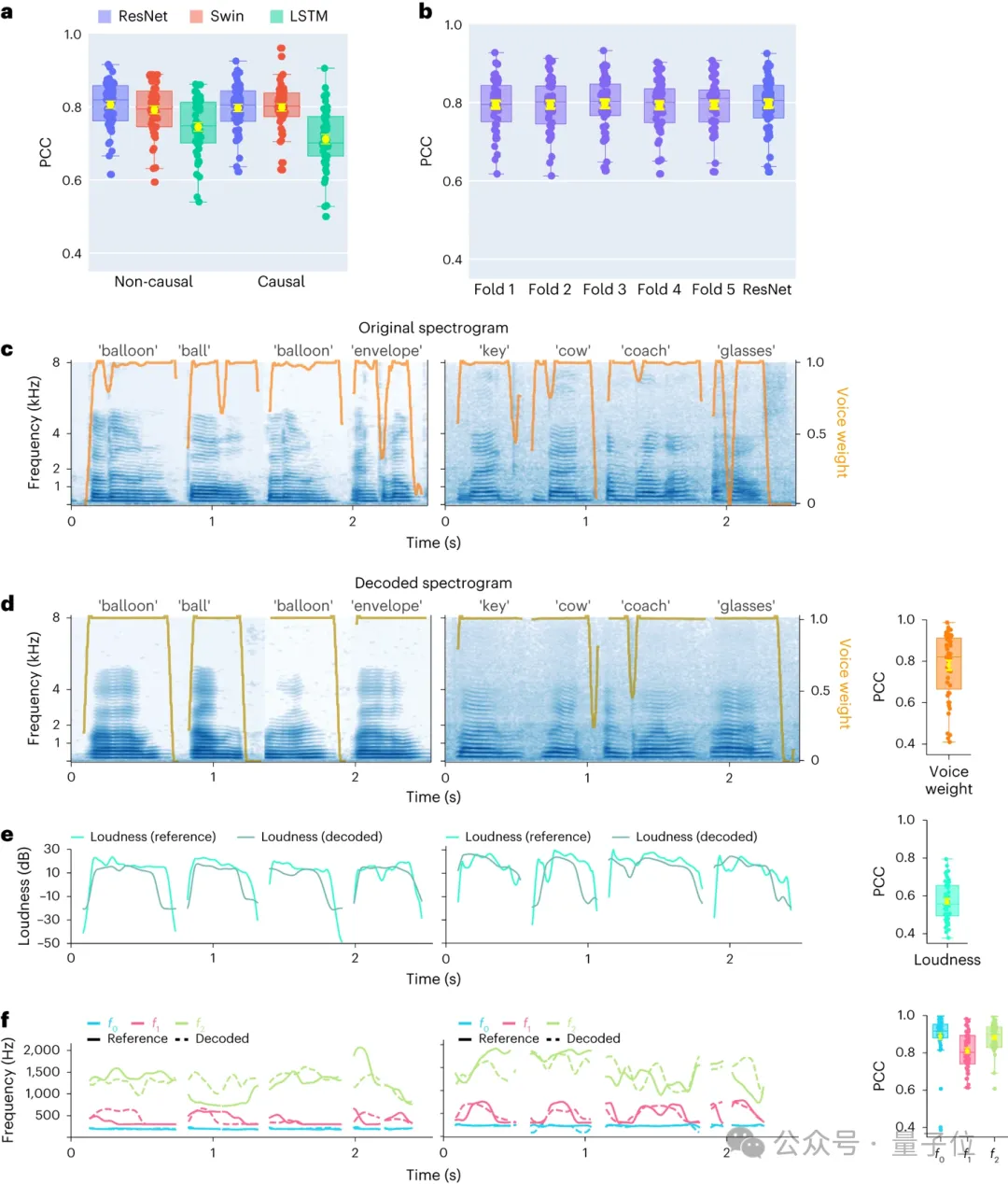

首先,研究人員直接比較不同模型架構(gòu)卷積(ResNet)、循環(huán)(LSTM)和Transformer(3D Swin)在語(yǔ)音解碼性能上的差異。

值得注意的是,這些模型都可以執(zhí)行時(shí)間上的非因果(non-causal)或因果操作。

解碼模型的因果性對(duì)大腦-計(jì)算機(jī)接口(BCI)應(yīng)用具有重大意義:因果模型僅利用過(guò)去和當(dāng)前的神經(jīng)信號(hào)生成語(yǔ)音,而非因果模型還會(huì)使用未來(lái)的神經(jīng)信號(hào),這在實(shí)時(shí)應(yīng)用中不可行。

因此,他們專(zhuān)注于比較相同模型在執(zhí)行非因果和因果操作時(shí)的性能。

結(jié)果發(fā)現(xiàn),即使是因果版本的ResNet模型也能與非因果版本媲美,二者之間沒(méi)有顯著差異。同樣,因果和非因果版本的Swin模型性能相近,但因果版本的LSTM模型性能顯著低于非因果版本。

研究人員展示了幾個(gè)關(guān)鍵語(yǔ)音參數(shù)的平均解碼準(zhǔn)確率(N=48),包括聲音權(quán)重(用于區(qū)分元音和輔音)、響度、音高f0、第一共振峰f1和第二共振峰f2。準(zhǔn)確重建這些語(yǔ)音參數(shù),尤其是音高、聲音權(quán)重和前兩個(gè)共振峰,對(duì)于實(shí)現(xiàn)精確的語(yǔ)音解碼和自然地模仿參與者聲音的重建至關(guān)重要。

結(jié)果表明,無(wú)論是非因果還是因果模型,都能得到合理的解碼結(jié)果,這為未來(lái)的研究和應(yīng)用提供了積極的指引。

二、對(duì)左右大腦神經(jīng)信號(hào)語(yǔ)音解碼以及空間采樣率的研究

?

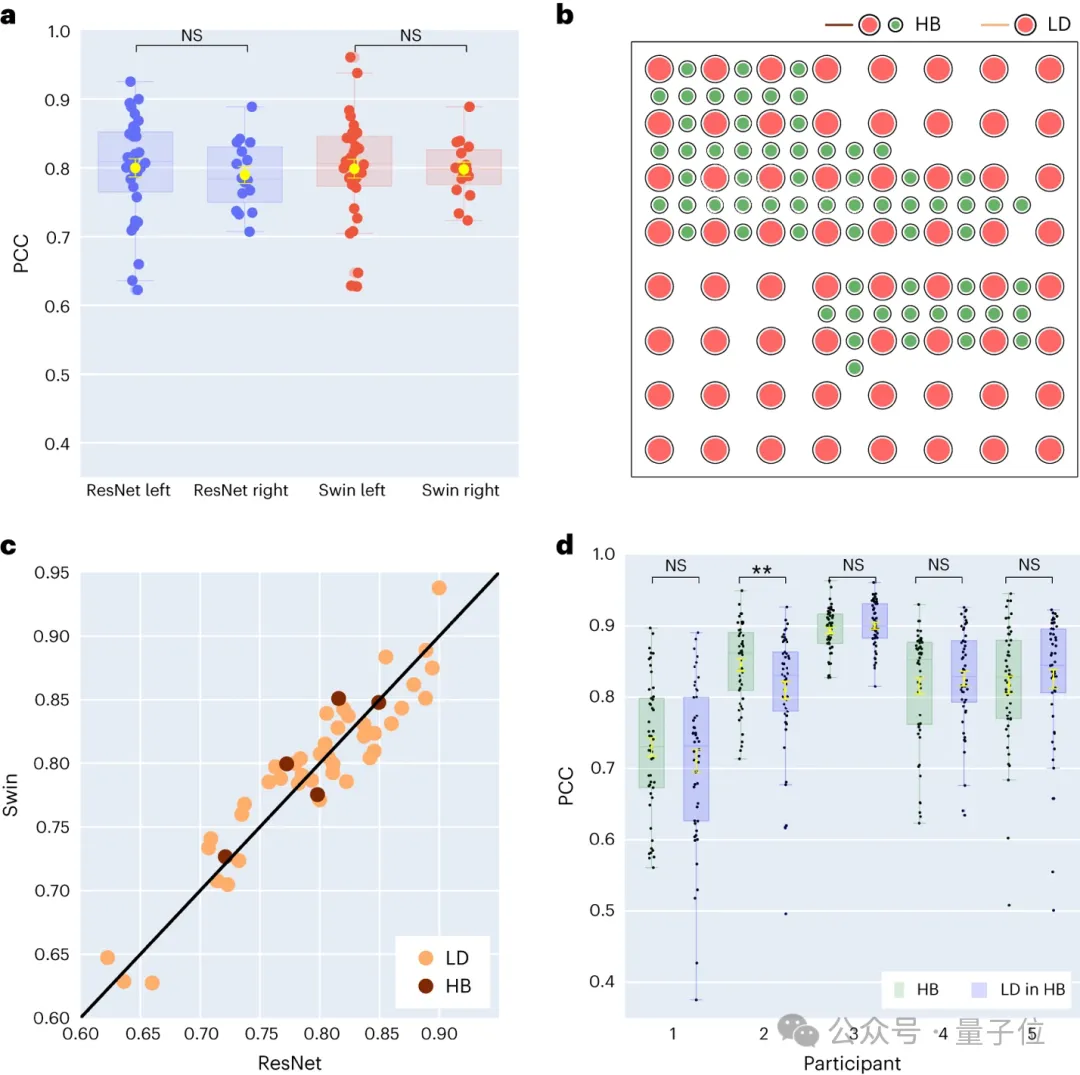

研究人員進(jìn)一步對(duì)左右大腦半球的語(yǔ)音解碼結(jié)果進(jìn)行了比較。多數(shù)研究集中關(guān)注主導(dǎo)語(yǔ)音和語(yǔ)言功能的左腦半球,而對(duì)從右腦半球解碼語(yǔ)言信息的關(guān)注較少。

針對(duì)這一點(diǎn),他們比較了參與者左右大腦半球的解碼表現(xiàn),以此驗(yàn)證使用右腦半球進(jìn)行語(yǔ)音恢復(fù)的可能性。

在研究收集的48位受試者中,有16位受試者的ECoG信號(hào)采集自右腦。

通過(guò)對(duì)比 ResNet 和 Swin 解碼器的表現(xiàn),發(fā)現(xiàn)右腦半球也能夠穩(wěn)定地進(jìn)行語(yǔ)音解碼,與左腦半球的解碼效果相差較小。

這意味著,對(duì)于左腦半球受損、失去語(yǔ)言能力的患者來(lái)說(shuō),利用右腦半球的神經(jīng)信號(hào)恢復(fù)語(yǔ)言也許是一個(gè)可行的方案。

接著,他們還探討了電極采樣密度對(duì)語(yǔ)音解碼效果的影響。

之前的研究多采用較高密度的電極網(wǎng)格(0.4 mm),而臨床中通常使用的電極網(wǎng)格密度較低(LD 1 cm)。有五位參與者使用了混合類(lèi)型(HB)的電極網(wǎng)格,這類(lèi)網(wǎng)格雖然主要是低密度采樣,但其中加入了額外的電極。剩余的四十三位參與者都采用低密度采樣。這些混合采樣(HB)的解碼表現(xiàn)與傳統(tǒng)的低密度采樣(LD)相似。

這表明模型能夠從不同空間采樣密度的大腦皮層中學(xué)習(xí)到語(yǔ)音信息,這也暗示臨床通常使用的采樣密度對(duì)于未來(lái)的腦機(jī)接口應(yīng)用也許是足夠的。

三、對(duì)于左右腦不同腦區(qū)對(duì)語(yǔ)音解碼貢獻(xiàn)度的研究

?

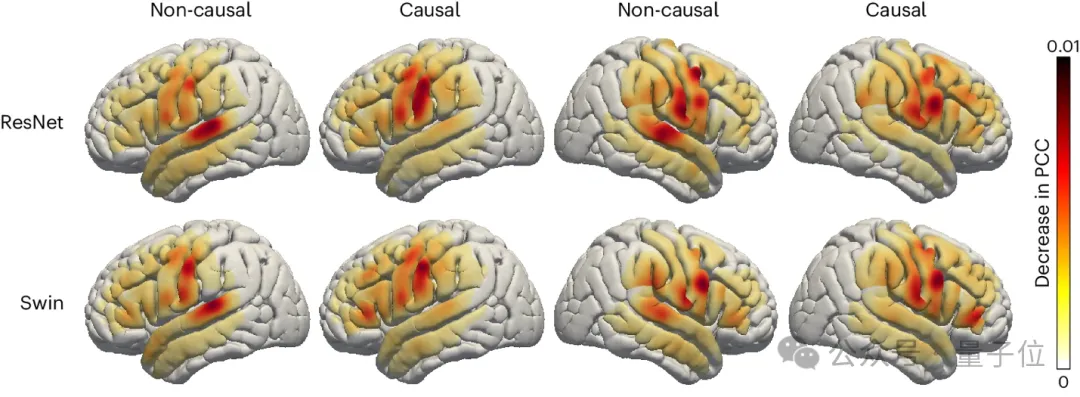

研究人員也考察了大腦的語(yǔ)音相關(guān)區(qū)域在語(yǔ)音解碼過(guò)程中的貢獻(xiàn)程度,這對(duì)于未來(lái)在左右腦半球植入語(yǔ)音恢復(fù)設(shè)備提供了重要的參考。

采用了遮擋技術(shù)(occlusion analysis)來(lái)評(píng)估不同大腦區(qū)域?qū)φZ(yǔ)音解碼的貢獻(xiàn)度。

通過(guò)對(duì)比 ResNet 和 Swin 解碼器的因果與非因果模型,發(fā)現(xiàn)聽(tīng)覺(jué)皮層在非因果模型中的貢獻(xiàn)更大,這側(cè)面佐證了在實(shí)時(shí)語(yǔ)音解碼應(yīng)用中,必須使用因果模型,因?yàn)樵趯?shí)時(shí)語(yǔ)音解碼中,我們無(wú)法利用神經(jīng)反饋信號(hào)。

此外,無(wú)論是在右腦還是左腦半球,傳感運(yùn)動(dòng)皮層尤其是腹部區(qū)域的貢獻(xiàn)度相似,這暗示在右半球植入神經(jīng)假肢也許是一個(gè)可行的方案。

最后總結(jié)來(lái)說(shuō),該研究在腦機(jī)接口上面取得了一系列的進(jìn)展,不過(guò)研究人員也提到了目前模型的一些限制,比如解碼流程需要有與ECoG記錄配對(duì)的語(yǔ)音訓(xùn)練數(shù)據(jù),這對(duì)失語(yǔ)患者可能不適用。

未來(lái)他們希望開(kāi)發(fā)能處理非網(wǎng)格數(shù)據(jù)的模型架構(gòu),以及更好地利用多病人、多模態(tài)腦電數(shù)據(jù)。

對(duì)于腦機(jī)接口領(lǐng)域來(lái)說(shuō),目前的研究還處于相當(dāng)早期的階段,伴隨著硬件技術(shù)的迭代和深度學(xué)習(xí)技術(shù)的快速進(jìn)展,科幻電影中出現(xiàn)的腦機(jī)接口設(shè)想會(huì)愈發(fā)趨近實(shí)現(xiàn)。

論文鏈接:https://www.nature.com/articles/s42256-024-00824-8

GitHub鏈接:https://github.com/flinkerlab/neural_speech_decoding

更多生成的語(yǔ)音例子:https://xc1490.github.io/nsd/

本文轉(zhuǎn)自 量子位 ,作者:量子位