CAG來了,RAG慌了?

CAG:Cache-Augmented Generation 緩存增強生成。

不要做 RAG 了:當緩存增強生成對于知識任務就足夠時

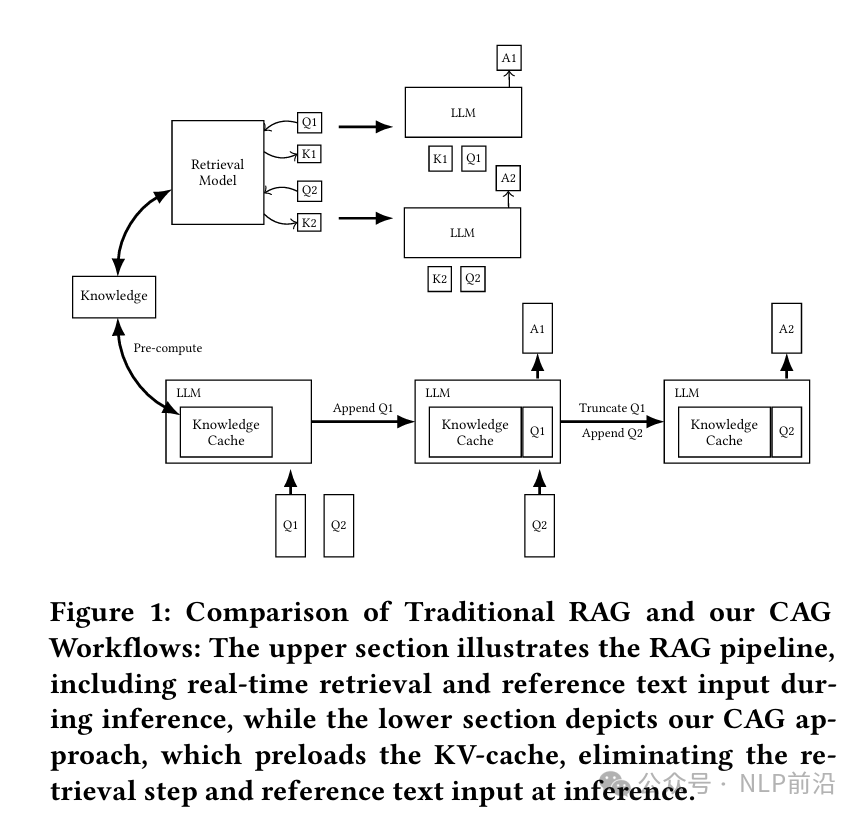

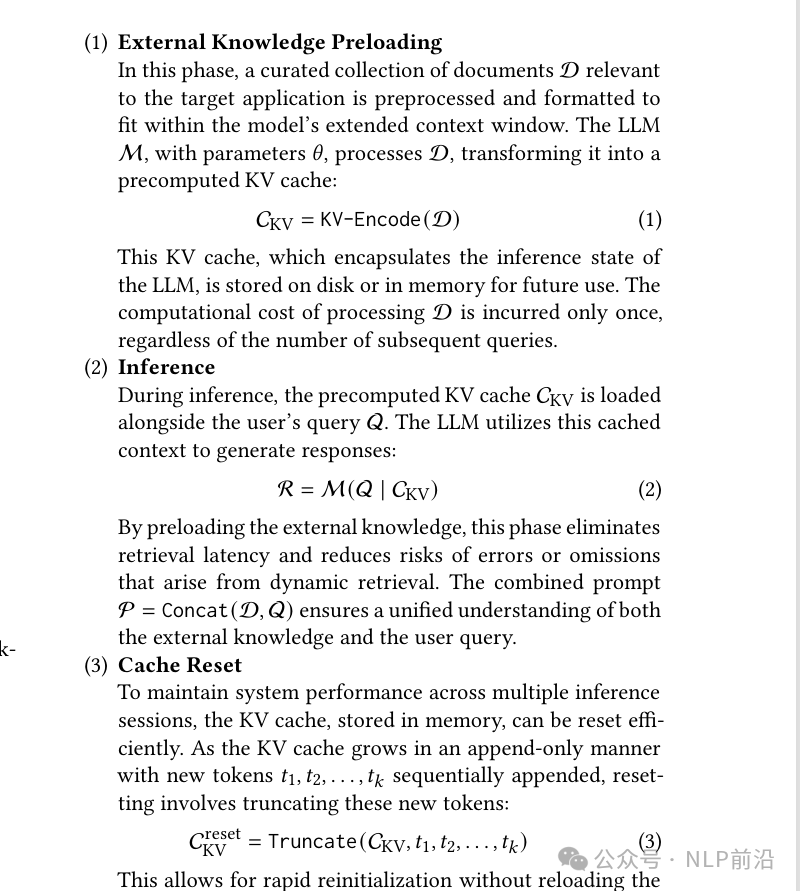

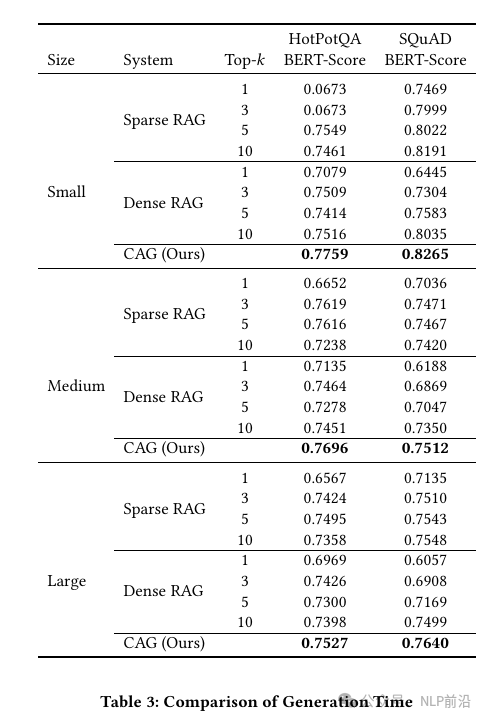

檢索增強生成(RAG)作為一種通過整合外部知識源來增強語言模型的有效方法,已經得到了廣泛應用。然而,RAG 引入了檢索延遲、文檔選擇潛在錯誤和系統復雜性增加等挑戰。隨著具有顯著擴展上下文窗口的大型語言模型(LLMs)的出現,本文提出了一種替代范式,即緩存增強生成(CAG),它繞過了實時檢索。我們的方法涉及預先加載所有相關資源,特別是當檢索的文檔或知識有限且可管理時,將其加載到 LLM 的擴展上下文中,并緩存其運行時參數。在推理過程中,模型利用這些預先加載的參數來回答查詢,而無需額外的檢索步驟。比較分析表明,CAG 消除了檢索延遲,并最小化了檢索錯誤,同時保持了上下文相關性。在多個基準測試中的性能評估突出了長上下文 LLMs 在哪些場景下優于或補充了傳統的 RAG 管道。這些發現表明,對于某些應用,尤其是那些知識庫受限的應用,CAG 提供了一種簡化和高效的替代方案,與 RAG 相比,在降低復雜性的同時實現可比或更優的結果。

感覺還是longcontext VS RAG,隨便寫寫,好像容易被噴。

套了層緩存的殼。

{context} + prompt + query

CAG對{context}部分的KV提前緩存, RAG的{context}部分是動態的。

3個階段: 緩存 -> 推理 -> cacheReset(就是應對多輪,超長了,截斷一下)

優勢:(引用)

- 知識庫有限且可控:當需要處理的文檔或知識量不大時,CAG 可以輕松勝任。

- 追求極致效率:對于需要快速響應的應用,CAG 的優勢更加突出。

- 需要一致的上下文理解:CAG 可以讓模型對所有知識有更全面的理解,從而生成更準確、更一致的回答。

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦