EarthMarker:首個視覺提示遙感多模態大模型 原創

?摘要:近年來,提示學習技術的發展使用戶能夠通過多輪對話與人工智能(AI)工具互動,從而實現對圖像的交互式理解。然而,僅靠普通語言指令難以有效傳遞復雜遙感(RS)場景中的信息,這限制了對圖像潛在內容的深入理解。此外,由于自然場景和遙感數據在領域上的顯著差異,現有的提示策略難以直接應用于遙感數據解讀。為解決這些問題,本文提出了首個基于視覺提示的多模態大語言模型(MLLM),名為EarthMarker,用于遙感領域。EarthMarker通過利用視覺提示(如框和點)實現圖像、區域和點級別的遙感圖像解讀。模型開發了一種共享視覺編碼方法,建立輸入圖像的多尺度表示和各種視覺提示之間的空間模式解釋關系。隨后,將混合視覺-空間表示與語言指令結合,構建聯合提示,從而解釋遙感圖像中的復雜內容。為彌合自然數據與遙感數據之間的領域差距,并有效地將自然場景的領域級知識遷移到遙感領域,EarthMarker引入了一種跨領域學習策略。此外,為應對遙感視覺提示數據的不足,本文構建了名為RSVP的數據集,包含多模態、多粒度的視覺提示指令。通過廣泛的實驗表明,EarthMarker在多粒度遙感圖像解讀方面表現出競爭力,標志著視覺提示學習框架在遙感圖像多粒度解讀中的重大進展。

EarthMarker:數據集全部開源中!含365萬條視覺-語言聯合提示指令數據!

- 論文:https://ieeexplore.ieee.org/document/10817639

- 開源鏈接:https://github.com/wivizhang/EarthMarker

同系列模型:

EarthGPT:國內首個遙感大模型,100萬多模態指令數據集已全部開源!

- 論文鏈接:https://ieeexplore.ieee.org/document/10547418

- 開源鏈接:https://github.com/wivizhang/EarthGPT

引言

視覺提示(Visual prompting)是當前自然領域中的研究熱點,旨在通過視覺標記(如框、點和涂鴉)來解釋圖像中的感興趣區域 [1], [2]。特別是,將視覺提示注入多模態大語言模型(MLLM)可以建立聯合提示機制,使模型能夠同時利用視覺和文本指令。這種聯合提示方式類似于人類表達,能夠以更靈活和高效的交互方式理解圖像。

將視覺提示應用于遙感(RS)領域必須考慮其圖像的獨特特性,包括尺度變化、跨類別多樣性以及復雜的上下文語義信息 [3], [4]。其中的主要挑戰在于有效指導模型識別和解釋復雜遙感圖像中的關鍵潛在信息。然而,僅使用普通語言難以有效描述復雜遙感圖像中的特定區域 [5], [6]。此外,現有MLLMs主要實現了圖像級別的視覺-語言對齊,這限制了其進行詳細圖像理解的能力 [7]。因此,迫切需要開發更簡潔且高效的提示機制,以增強遙感領域的細粒度視覺推理能力。

提示工程(Prompt engineering)已在自然語言處理(NLP)領域得到廣泛研究 [8], [9],并逐漸擴展至計算機視覺領域。典型案例包括Segment Anything(SAM)[11]模型,該模型利用多種視覺提示實現零樣本分割,從而適配多種新圖像分布。此外,GPT4RoI [12]和RegionBlip [13]通過對區域-文本對的訓練,使MLLMs能夠完成區域級別的視覺理解任務。而Osprey [14]在像素級別視覺理解方面表現出色,但依賴預附加的分割模型,限制了其應用范圍。此外,Ferret [15]和SPHINX-V [16]支持自由形狀的視覺提示標記以實現像素級圖像理解。然而,這些模型均在自然場景數據上進行訓練,在處理遙感圖像時性能不佳。

在遙感領域,致力于區域級細粒度圖像理解或視覺提示的工作非常有限。例如,RSVG [17]采用語言提示來查詢并定位特定對象。而EarthGPT [18]和GeoChat [6]等其他代表性遙感MLLMs超越了圖像級別的理解,通過在視覺定位數據上訓練實現了區域級視覺感知。此外,SAM在遙感圖像上的表現有限,因為其ViT骨干網絡是在大規模近距離遙感數據集上預訓練的 [19], [20]。受SAM啟發,RSPrompter [21]引入了一種自動化提示生成方法,用于開發針對遙感數據的交互式分割。然而,這些遙感MLLMs主要實現了圖像-文本對齊,僅依賴語言指令,難以發現復雜遙感場景中隱藏的有價值信息,并且缺乏交互的靈活性。

為了填補這一空白,本文提出了一個基于視覺提示的MLLM,命名為EarthMarker,用于首次擴展MLLMs在遙感領域的區域級和點級理解能力。如圖1所示,EarthMarker在多粒度遙感圖像解釋方面表現出色。具體而言,EarthMarker可以在從粗粒度的整體場景級別到細粒度的區域/對象級別,甚至點級別的區分之間切換。此外,EarthMarker能夠完成廣泛的粗粒度和細粒度遙感視覺任務,包括場景分類、目標分類、圖像/區域/點級別標注以及關系分析等。值得注意的是,視覺提示用于隔離特定區域,并指導模型解釋整個遙感圖像的局部內容。

實際上,稀疏視覺提示、密集遙感圖像特征以及語義層級的文本特征之間存在顯著的差異,這使得對齊和整合這些模態變得具有挑戰性。為了解決這一問題,本文開發了一種共享視覺編碼方法。具體而言,將視覺提示處理為類似RGB圖像,并與輸入圖像共享相同的視覺編碼器。這種策略有助于一致的特征提取,并理解視覺提示區域與整體圖像之間的關系,從而提升模型在視覺提示學習下的性能。

由于遙感數據的有限性,難以實現區域和文本的交互、空間關系的理解以及目標定位。為了緩解這一限制,本文采用通用領域數據進行混合訓練。更重要的是,為了增強視覺提示-圖像-文本的對齊,本文提出了跨領域學習策略。具體而言,在多領域圖像-文本對齊的第一階段,EarthMarker通過自然場景和遙感圖像標注數據進行訓練,以獲得對圖像的整體理解并提升概念多樣性的建模能力。隨后,模型進一步在自然場景的指代數據上訓練,以獲得圖像的空間感知能力,從而為遙感領域中的指代理解能力的發展奠定基礎。最后,在遙感視覺提示調優階段,本文利用包含多種空間分辨率的遙感區域-文本和點-文本指令數據進行領域自適應訓練。

EarthMarker配備了整體和點/區域級遙感圖像解釋能力。通過多領域聯合訓練,不僅提升了對細粒度遙感圖像的深入解讀能力,還增強了開放詞匯推理能力。此外,模型的可更新參數是獨立的,避免了不同粒度圖像理解之間的干擾。

另一個挑戰是現有視覺提示數據集 [14], [15] 限于自然場景,缺乏遙感語義特征。此外,目前公開的遙感標注數據往往過于簡單且重復,缺乏遙感圖像的獨特特性。因此,本文構建了一個名為RSVP的視覺提示數據集,包含多模態大規模視覺-語言聯合指令跟隨任務。特別地,本文將各種公開可用的遙感數據轉換并重新標注為統一的對話格式。此外,部分高質量的標注數據由GPT4V [22]生成,旨在展現每個遙感圖像的獨特特性,從而增強數據的豐富性和多樣性。

通過在多類型遙感數據集上的廣泛實驗,證明EarthMarker在多粒度遙感視覺任務中的性能優于最先進(SOTA)專家模型、MLLMs以及視覺提示模型。具體來說,在零樣本場景分類任務中,EarthMarker顯著優于其他現有MLLMs。特別是在指代對象分類任務中,EarthMarker在DIOR-RSVG數據集 [23] 上使用邊界框作為視覺提示獲得了98.37%的語義相似性(SS)得分,并在使用點提示時獲得了95.96%。此外,在圖像和區域標注任務中,EarthMarker也遠超其他MLLMs和視覺提示模型。

綜上,實驗結果表明,EarthMarker在各種多粒度遙感圖像理解任務中表現出卓越性能,并具備出色的零樣本推理能力。

我們的貢獻可以總結如下:

首個遙感視覺提示多模態大語言模型(MLLM),EarthMarker:本文首次在遙感領域提出了一個基于視覺提示的MLLM,名為EarthMarker。EarthMarker能夠通過視覺和文本聯合提示理解遙感圖像,并靈活切換解釋層級,包括圖像級、區域級和點級。更重要的是,EarthMarker填補了遙感領域視覺提示MLLM的空白,顯著滿足了實際應用中對遙感圖像細粒度解釋的需求。

首個遙感視覺提示學習框架:本文開發了一種通用的區域級和點級視覺提示數據標注方法,并提出了一種共享視覺編碼機制,以增強視覺提示、整體圖像和文本指令之間的交互。此外,設計了一種跨領域學習策略,通過利用多領域數據輕量化優化非關聯參數,使EarthMarker具備空間感知能力和聯合指令跟隨能力。

首個遙感視覺提示數據集RSVP:本文構建了一個名為RSVP的大規模遙感區域指令數據集,包含約365萬對圖像-點-文本和圖像-區域-文本配對數據。這一數據集的構建促進了遙感圖像的細粒度解釋,為遙感領域中視覺提示的開發奠定了基礎。

在多粒度遙感視覺任務中的卓越表現:通過廣泛的實驗驗證,EarthMarker在多粒度遙感視覺任務中展現了競爭力,其性能優于最先進的專家模型、MLLMs和視覺提示模型。所評估的任務包括場景分類、目標分類、區域標注、關系分析等。因此,EarthMarker成功探索了視覺提示學習在遙感領域的適應性,不僅提升了MLLM的性能,還標志著在細粒度遙感圖像解釋方面邁出了重要一步。

方法簡介

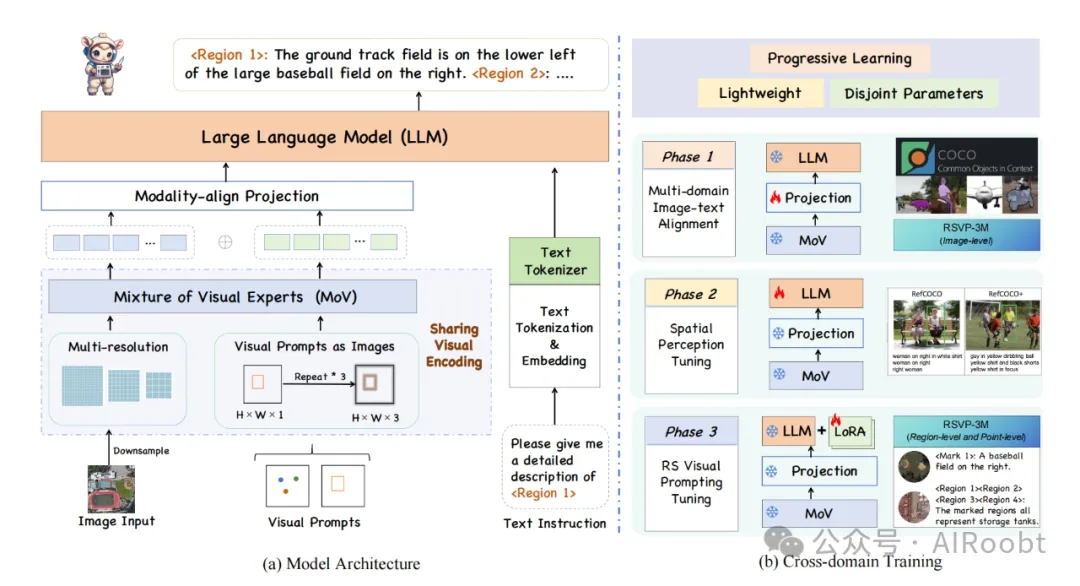

EarthMarker的總體架構如圖1所示,提出了一種共享視覺編碼機制,以增強視覺提示、整體圖像和文本指令之間的交互理解。此外,設計了跨域三階段學習策略,使得EarthMarker具備了空間感知和聯合指令跟隨能力。該研究貢獻了一個視覺和語言聯合提示多模態理解框架,并構建大規模的遙感多模態聯合指令數據集,展示出了極大的實際應用的潛力。

圖1 EarthMarker總體架構

可視化效果

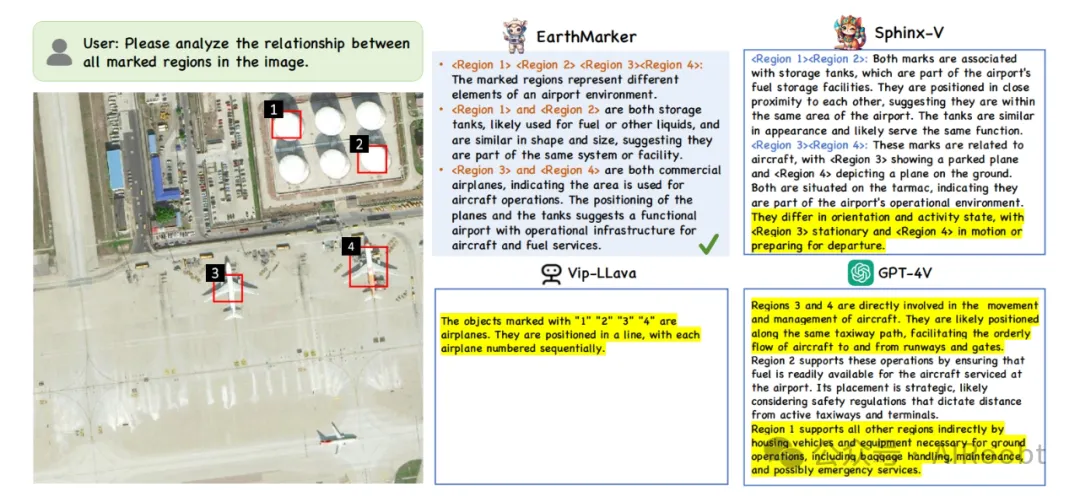

EarthMarker可完成復雜的視覺推理任務,尤其在目標關系分析任務中性能超越GPT-4V。如圖2所示,EarthMarker展示出驚人的分析能力:首先總結了視覺提示所標識區域分別為機場環境中的不同要素, 接著對相同類別的區域進行了聚類分析,并推斷出這些標注區域在機場環境中的不同功能。

圖2 復雜推理任務:關鍵目標關系分析(黃色高亮部分表示錯誤)

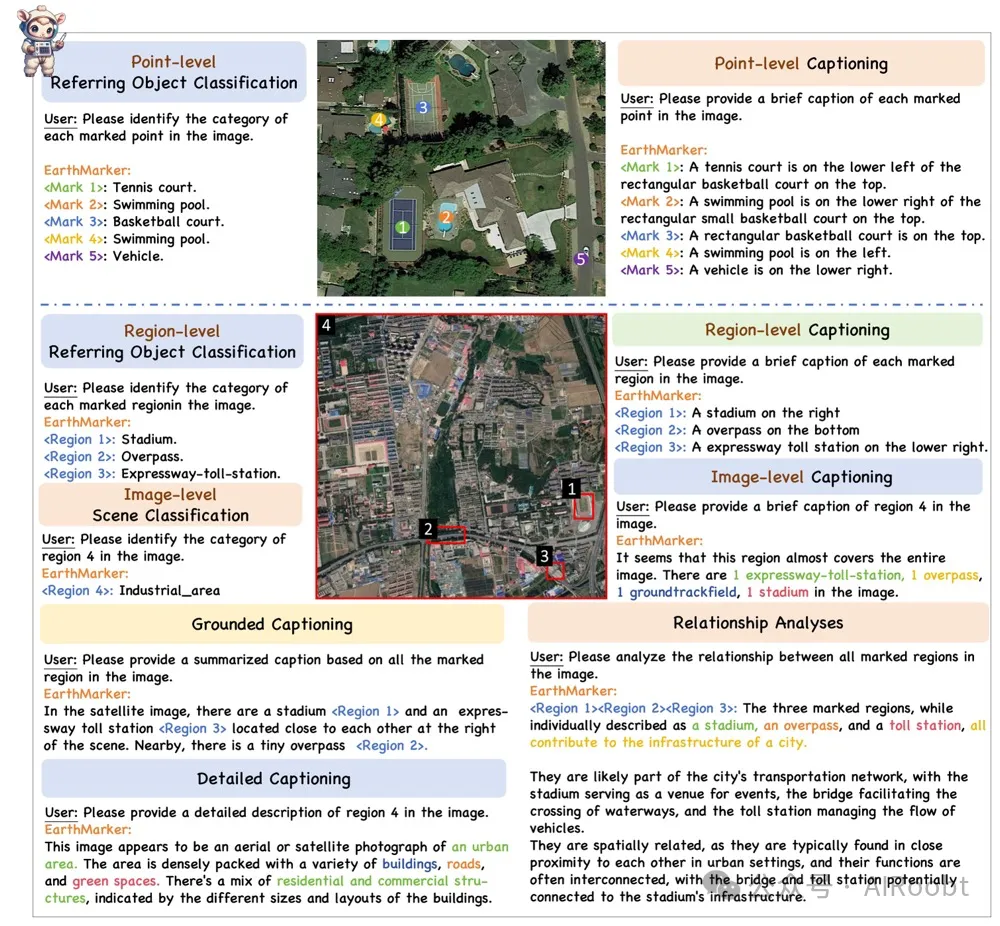

綜合來講,EarthMarker具備多才多藝的能力,如圖3所示,EarthMarker可實現多粒度(如圖像級、區域級和點級)遙感圖像解譯,擅長于各種視覺任務,包括場景分類、指定對象分類、圖像描述、關系分析等。

圖3 EarthMarker具備多粒度遙感圖像解譯能力,可實現多任務推理

相關工作

A. 多模態大語言模型(MLLMs)

近年來,大語言模型(LLMs)的進步極大地推動了自然語言處理(NLP)領域的變革與創新。代表性工作包括閉源的GPT系列 [12], [24] 和開源的LLaMA系列 [25], [26],它們展現了強大的通用語言處理與推理能力。受到LLM的啟發,通過進一步引入視覺信號,多模態大語言模型(MLLMs)得以發展,用于實現視覺-語言的相互理解以及多種視覺任務。例如,VisualGPT [27]、BLIP [28] 和 Flamingo [29] 在將LLMs與視覺模態對齊后,表現出強大的多模態推理潛力。值得注意的是,LLAMA-Adapter V2 [30] 和 SPHINX [31] 采用零樣本注意力機制和線性投影層調優,將LLM與視覺信號相結合。此外,VisionLLM [32] 將面向視覺任務的定義與LLM方法論對齊,從而以開放式的方式解決視覺中心任務。這些自然場景的MLLMs為擴展到遙感(RS)領域奠定了基礎。

一些開創性的遙感MLLMs已經出現,例如EarthGPT [18]、GeoChat [6]、SkyEyeGPT [33] 和 LHRS-Bot [34],這些模型使MLLMs能夠解釋遙感圖像。其中,GeoChat是第一個針對光學遙感圖像解決多任務問題的MLLM。EarthGPT提出了一個通用MLLM,可以處理多源遙感圖像并執行廣泛的遙感視覺任務。LHRS-Bot則構建了LHRS-Bench,用于促進遙感社區對遙感特定MLLMs進行多維度評估。這些模型無疑促進了遙感特定領域MLLMs的發展。然而,這些模型僅通過語言交互完成視覺解釋,而無法通過視覺提示生成響應來處理指代視覺理解任務。顯然,現有的遙感MLLMs主要聚焦于圖像級別和視覺定位,但無法進行更細粒度的區域、點和像素級別的解釋。因此,本文旨在增強MLLMs在遙感圖像多粒度理解上的多功能性。

B. 提示工程(Prompt Engineering)

提示工程是NLP中的新興研究方向 [24]。代表性工作包括AutoPrompt [8] 和 CoOp [9],它們旨在為語言模型和視覺-語言模型自動生成提示模板,而非手動設計。此外,語言提示已被應用于開發開放詞匯檢測模型,如DetPro [35] 和 Promptdet [36]。與語言提示技術的廣泛發展相比,視覺提示仍需進一步探索。

一個重要的發展是SAM [11] 模型,它支持多種分割提示以增強零樣本性能。由于SAM中缺乏語義標簽,Semantic-SAM [37] 被提出以實現多層次語義分析與預測。值得注意的是,GPT4RoI [12] 利用空間框并結合語言和感興趣區域(RoI)作為輸入,從而實現區域識別。Colorful Prompting Tuning (CPT) [38] 通過基于顏色的標記來提高預訓練視覺-語言模型的性能。此外,Osprey [14] 將遮罩區域融入語言指令,從而實現像素級視覺理解。其他視覺提示相關工作包括RegionBlip [13]、Kosmos-2 [39]、Shikra [40] 和 Ferret [15],這些研究通過利用視覺提示技術,在區域級圖像理解中顯示出前景。研究“通過圖像修復實現視覺提示” [41] 表明,通過提供所需任務示例,可以很好地完成各種視覺任務。此外,RegionPLC [42] 提出了一個輕量級且可擴展的區域點-語言對比學習框架,用于開放世界3D場景理解。

然而,上述模型均基于自然數據集進行訓練,自然圖像與遙感圖像之間的顯著差異表明,它們直接應用于遙感任務的能力有限。

在遙感領域,除傳統視覺模型 [43], [44] 外,最近在語言或視覺指令學習上的研究有限。例如,RSVG [17] 可基于自然語言表達提供參考對象的位置。EarthVQA [45] 數據集和語義對象感知框架(SOBA)被開發,EarthVQA包含圖像、對應的語義視覺提示以及問答對,用于訓練SOBA以實現基于對象的推理。受提示學習啟發,RSPrompter [21] 設計了一種自動化方法,用于生成適用于SAM輸入的提示,從而促進遙感圖像的分割。然而,RSVG采用語言提示而非視覺提示;EarthVQA僅涉及城市規劃圖像上的像素級推理;而RSPrompter僅適用于基于提示的分割任務。此外,一些專家模型已開發出基于點監督的檢測和語義分割,如PSOD [46]–[49]。然而,這些模型僅為單一任務設計,缺乏多功能性。

顯然,目前尚無統一的視覺提示框架專為遙感領域設計,以進一步提高MLLMs的多粒度解釋能力。這些局限性阻礙了更復雜和更細粒度遙感圖像理解的進一步發展,因此本文聚焦于填補這一空白。

本文轉載自公眾號AIRoobt ,作者:AIRoobt