提升RAG性能的全攻略:優化檢索增強生成系統的策略大揭秘 原創 精華

01、概述

近年來,隨著檢索增強生成(Retrieval Augmented Generation,RAG)應用的快速普及,其性能優化成為開發者們關注的熱點。盡管基礎RAG管道設計較為簡單,但要滿足實際業務需求,往往需要更高級的優化策略。本文將全面解讀RAG優化的各類方法,幫助大家快速掌握主流策略并在實踐中應用。

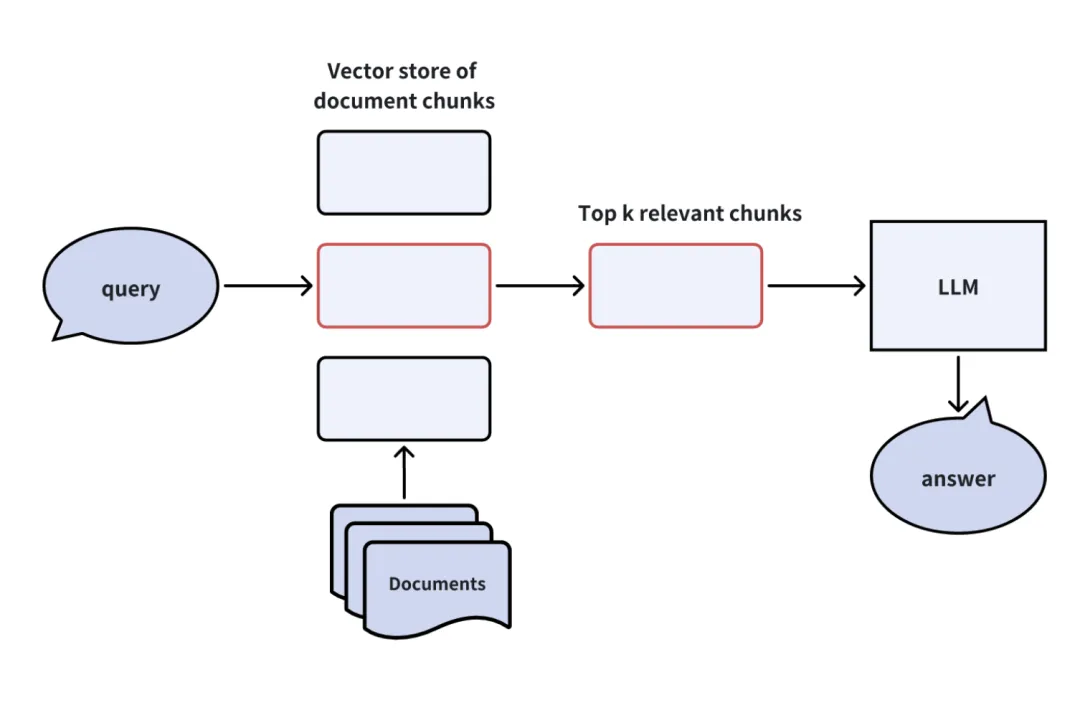

02、RAG管道基礎:從零開始理解工作原理

一個標準的RAG管道一般包含以下幾個基本步驟:

- 文檔加載與分塊:將文檔內容拆分為多個小塊(chunk),并將這些塊存儲到向量數據庫(如Milvus或Zilliz Cloud)。

- 檢索相關內容:根據查詢,向量數據庫找到與查詢最相關的Top-K文檔塊。

- 注入上下文:將檢索到的文檔塊作為上下文注入大語言模型(LLM)的提示中。

- 生成回答:LLM結合上下文生成最終的答案。

這種直觀的流程雖然高效,但在復雜場景中可能出現性能瓶頸,比如信息丟失或回答不準確。因此,針對RAG各環節的優化策略便應運而生。

03、RAG優化策略分類:全面覆蓋五大方向

可以將RAG優化策略劃分為以下五大類:

- 查詢優化(Query Enhancement):通過修改用戶查詢表達方式,使意圖更清晰,提升查詢準確性。

- 索引優化(Indexing Enhancement):通過改進索引方式,增強文檔塊的檢索效率。

- 檢索器優化(Retriever Enhancement):提升檢索階段的準確性與上下文覆蓋范圍。

- 生成器優化(Generator Enhancement):改善提示設計,確保生成更優質的答案。

- 管道優化(Pipeline Enhancement):優化整體RAG管道流程,動態調整系統執行方式。

接下來,我們將逐一探討每一類優化方法及其應用場景。

一、查詢優化:為系統注入“清晰思路”

在RAG系統中,查詢的準確性至關重要。以下幾種方法能夠幫助優化查詢階段:

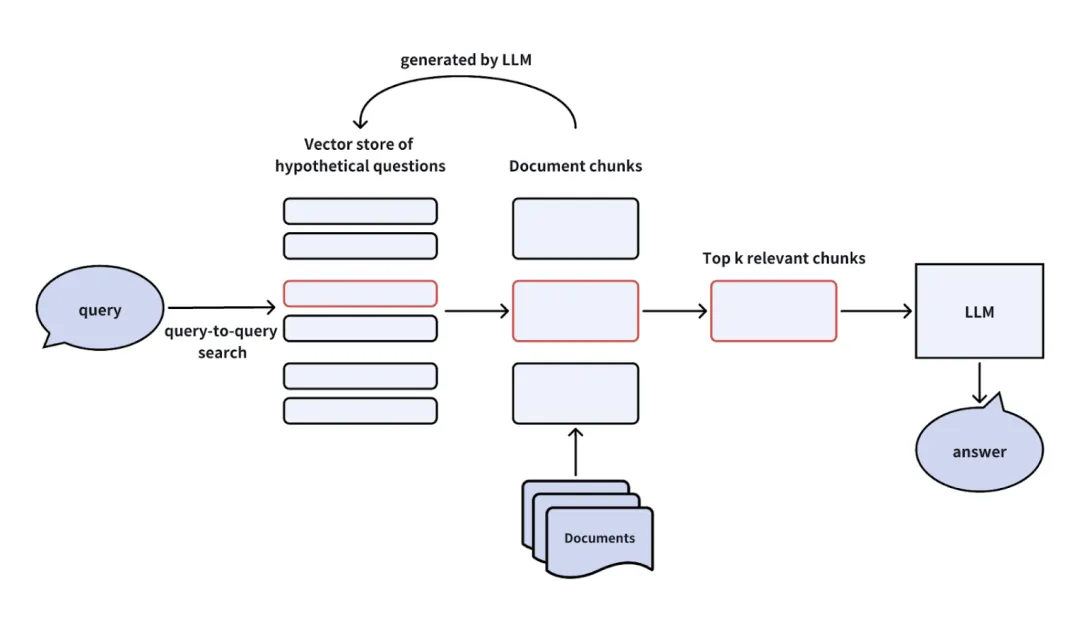

1. 假設性問題生成(Hypothetical Questions)

通過大語言模型(LLM)生成一組假設性問題,模擬用戶可能的提問方式。

- 流程:先根據文檔塊生成假設性問題,將其存儲于向量數據庫中。當用戶提交實際查詢時,系統先檢索假設性問題,再返回相關文檔塊供LLM生成答案。

- 優點:緩解跨領域查詢的對稱性問題,提高檢索精度。

- 缺點:生成假設性問題可能增加計算開銷,且存在不確定性。

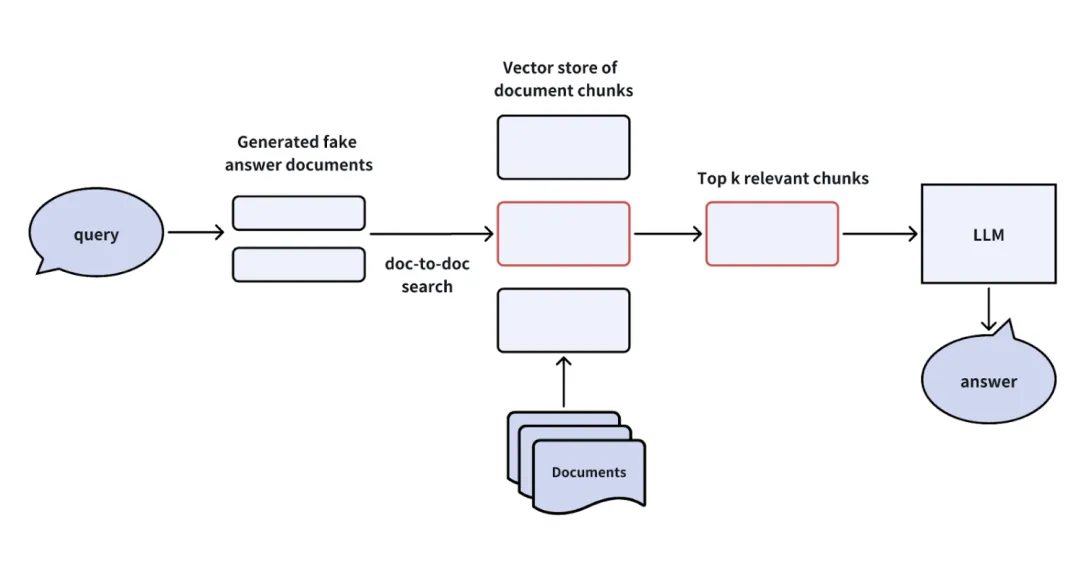

2. 假設性文檔嵌入(HyDE)

HyDE方法會根據用戶查詢生成一個“假設性回答”,將其轉化為向量嵌入后用于檢索文檔塊。

- 優勢:類似于假設性問題生成,但通過直接生成答案有效處理復雜查詢。

- 不足:生成“假設性回答”需要額外的計算資源。

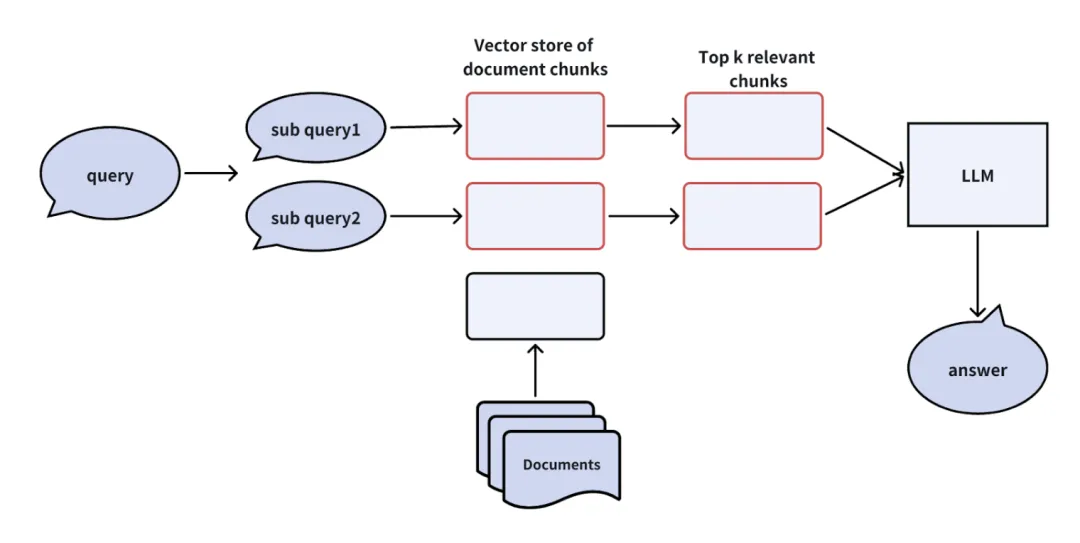

3. 子查詢拆分(Sub-Queries)

對于復雜查詢,可以先將其拆分為多個子查詢,分別檢索并合并答案。例如:

- 原始查詢:Milvus和Zilliz Cloud的功能有什么不同?

- 拆分后:

- 子查詢1:Milvus的功能有哪些?

- 子查詢2:Zilliz Cloud的功能有哪些?

通過簡化復雜查詢,系統可以更準確地檢索相關內容。

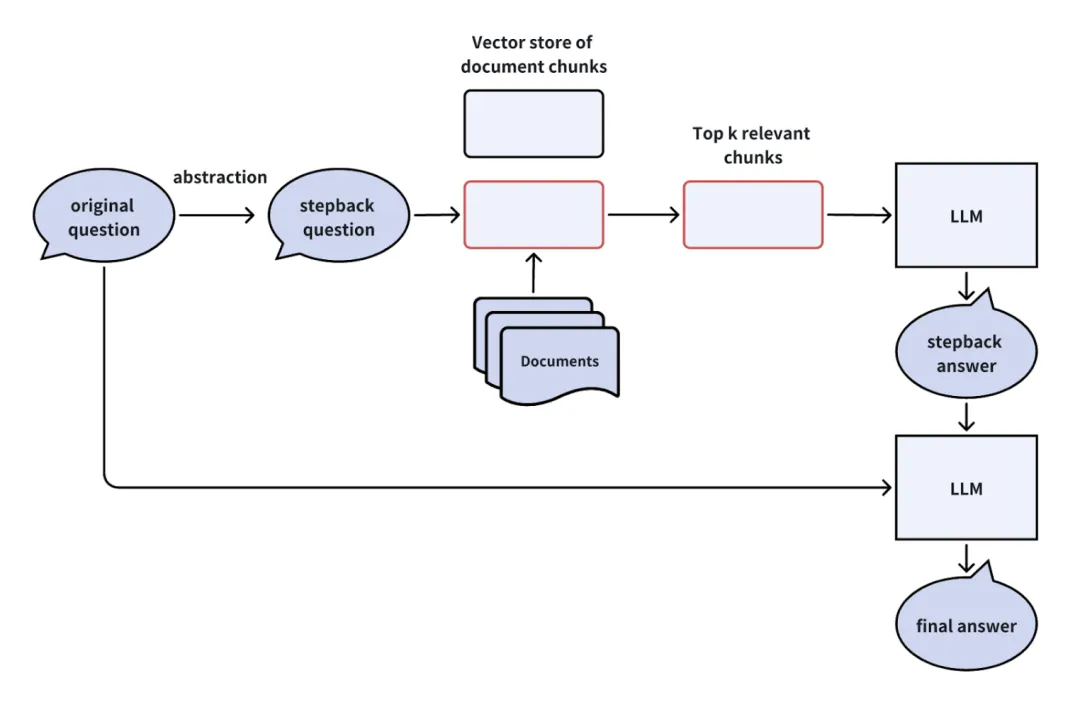

4. 退一步提問(Stepback Prompts)

將復雜的查詢轉化為“退一步”問題。例如:

- 用戶問題:Milvus是否可以存儲10億條記錄的數據集?

- 退一步問題:Milvus能處理的數據集規模上限是多少?

這種方法能夠簡化原始問題,使檢索更具針對性。

二、索引優化:打造高效的文檔檢索方式

索引階段的優化方法可以幫助系統更快速、更精準地定位相關文檔塊。

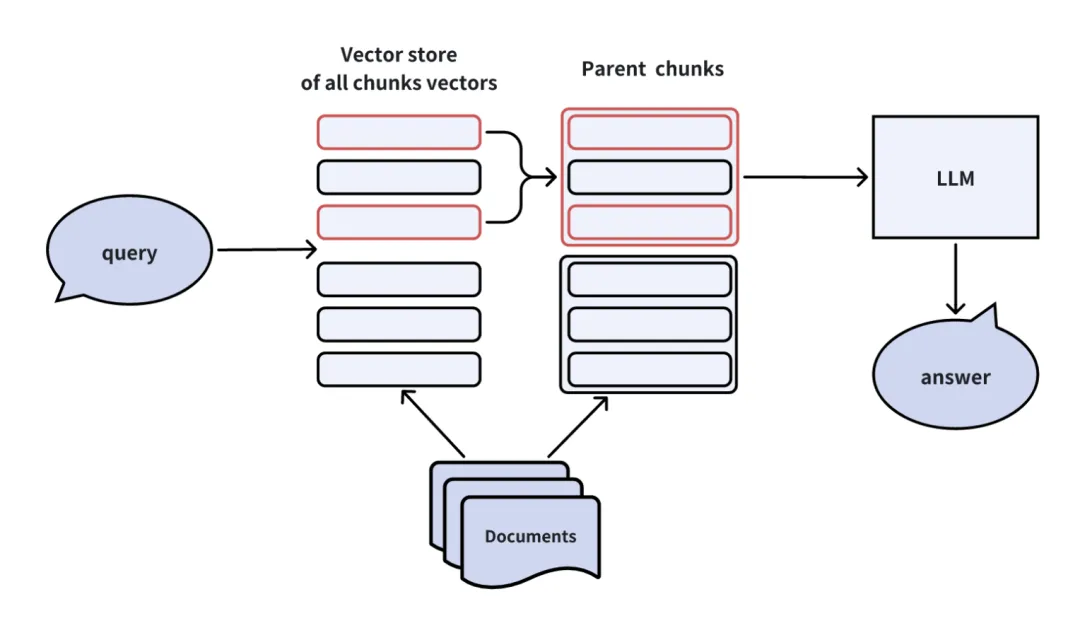

1. 自動合并文檔塊

在索引過程中,建立“父子層級”:

- 初始檢索時聚焦細粒度子文檔塊。

- 如果多個子塊來自同一父文檔,則將父文檔提供給LLM作為上下文。

此方法已在LlamaIndex中實現,對提升檢索覆蓋率非常有效。

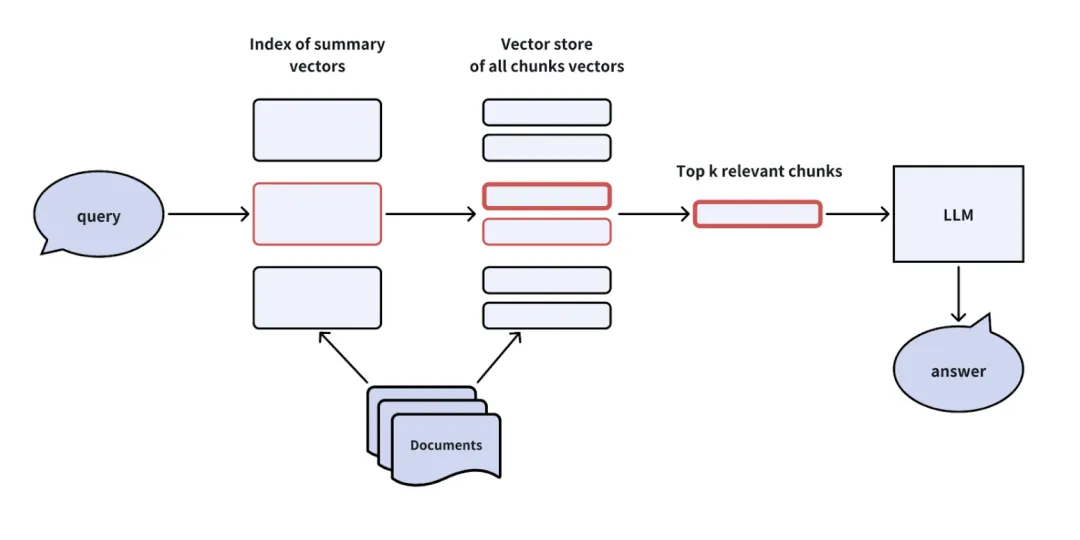

2. 構建分層索引

采用兩級索引結構:

- 第一級存儲文檔摘要,用于快速篩選相關文檔。

- 第二級存儲文檔塊,僅檢索篩選出的相關文檔內的內容。

這種方式在處理大規模數據或分層結構數據(如圖書館藏)時尤為適用。

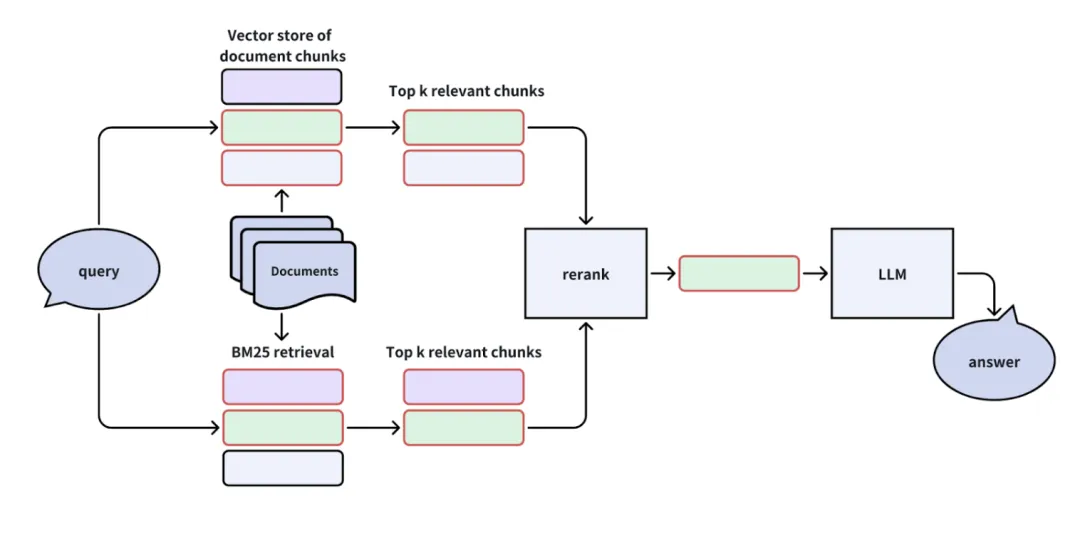

3. 混合檢索與重排序(Hybrid Retrieval & Reranking)

結合詞頻算法(如BM25)或稀疏嵌入方法(如Splade)與向量檢索。檢索完成后,通過重排序算法(如Cross-Encoder)對結果進行相關性排序。

- 優點:提升了檢索覆蓋率,減少向量召回不足的問題。

三、檢索器優化:讓信息“更近一步”

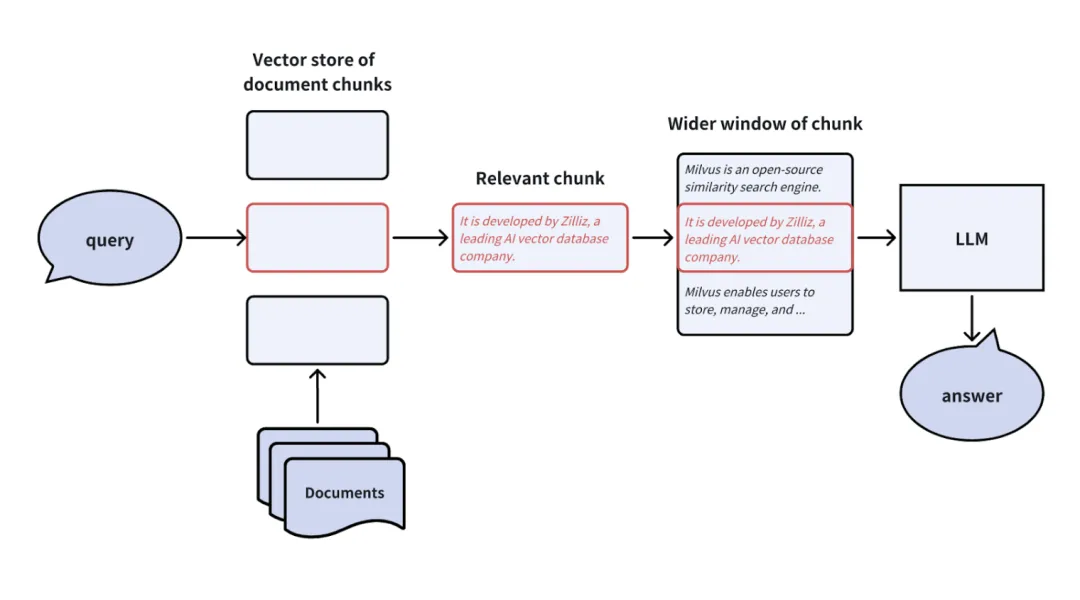

1. 句子窗口檢索(Sentence Window Retrieval)

在向量數據庫中檢索細粒度文檔塊,但將更大范圍的上下文信息提供給LLM,以減少信息遺漏。

- 注意:窗口大小需要根據業務需求動態調整,避免過多無關信息干擾。

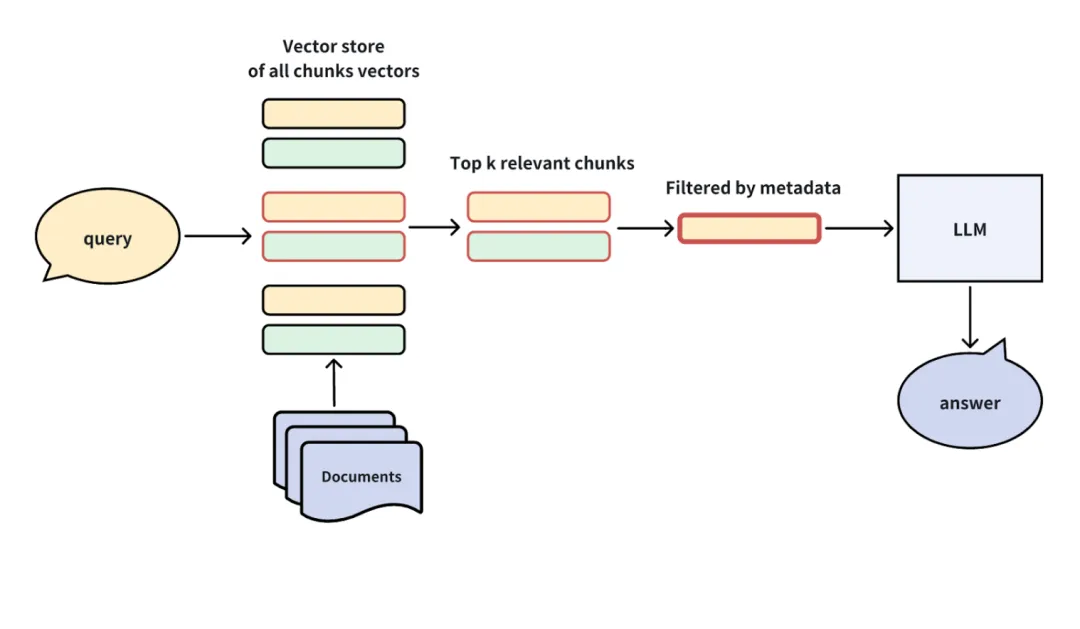

2. 元數據篩選(Meta-data Filtering)

通過時間、類別等元數據過濾檢索結果。例如,對于財報查詢,僅保留用戶指定年份的相關文檔。此方法在數據量龐大且元數據豐富的場景中非常有效。

四、生成器優化:從提示設計到內容生成

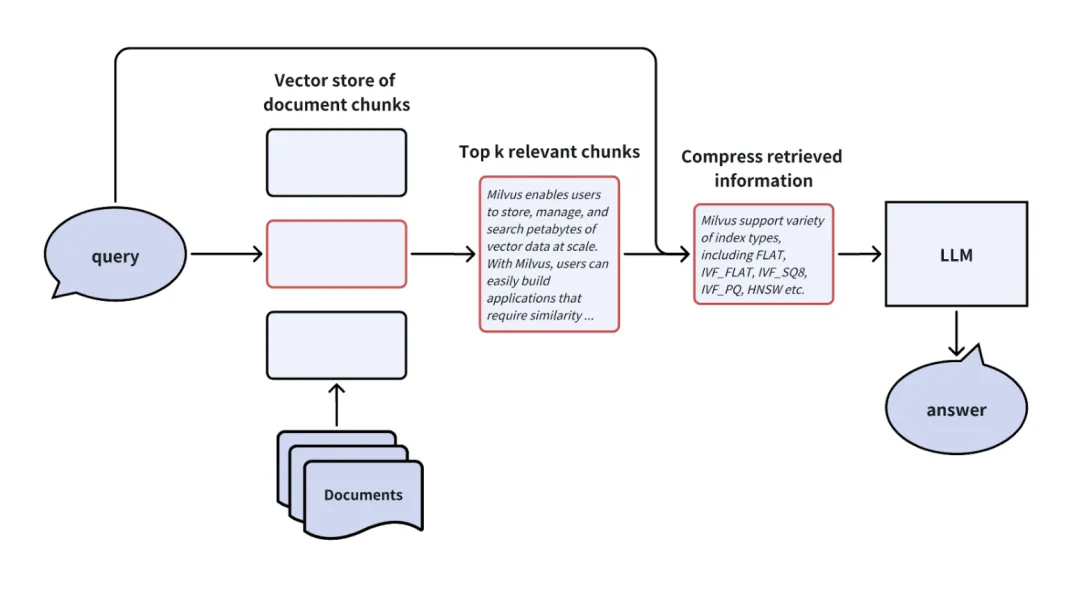

1. 壓縮提示信息

對檢索到的文檔塊進行信息壓縮,減少無關細節并強調重點。

- 優點:優化有限提示窗口內的信息利用率,提高生成答案的準確性。

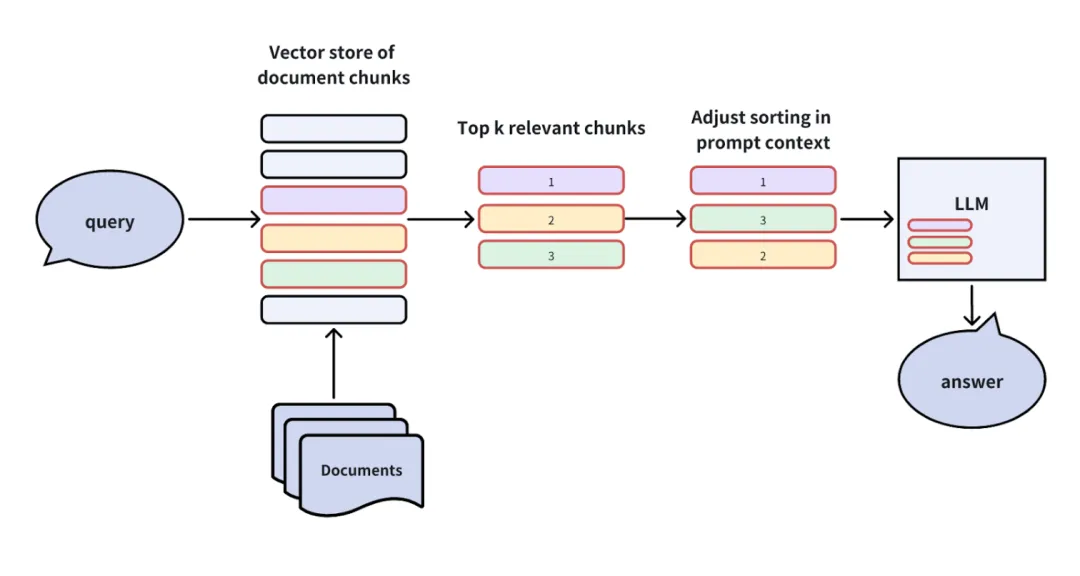

2. 調整提示塊順序

研究發現,LLM更傾向于使用提示開頭和結尾的信息。因此,可以將高置信度文檔塊放置在提示的首尾,以提升回答質量。

五、管道優化:全面提升RAG系統效率

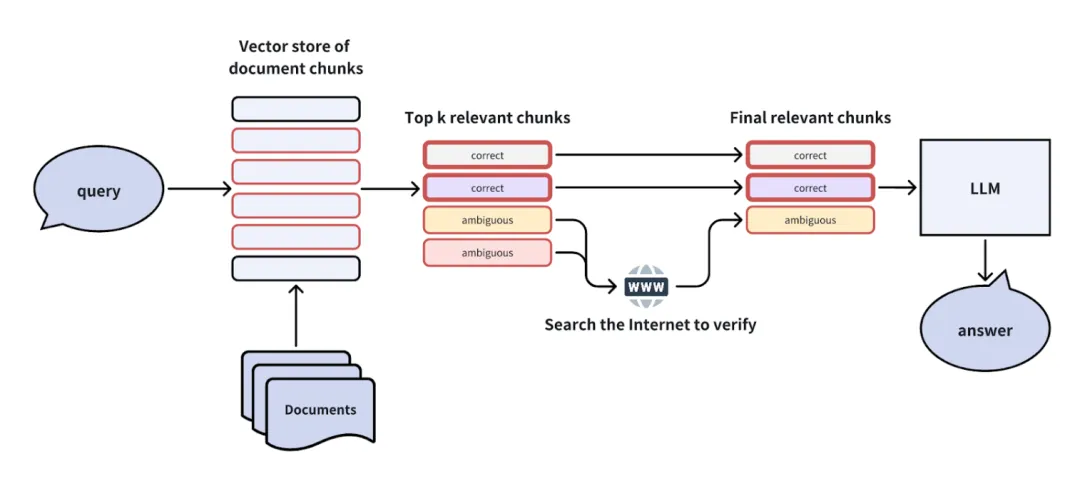

1. 自我反思(Self-reflection)

對于模糊或不確定的文檔塊,系統可進行“二次反思”,利用自然語言推理(NLI)或額外工具進行驗證,從而確保回答的準確性。

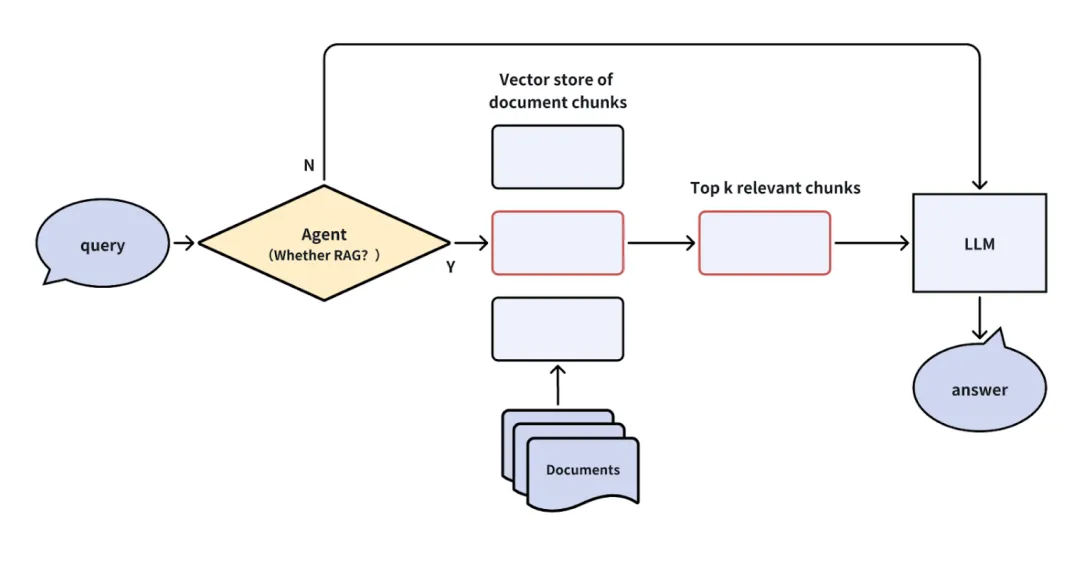

2. 查詢路由(Query Routing)

設計一個路由代理,判斷查詢是否需要經過RAG管道。簡單問題可直接由LLM回答,復雜問題則進入RAG系統處理。

- 優勢:提升響應速度,避免不必要的管道資源消耗。

03、總結:實現RAG應用的性能飛躍

盡管標準RAG管道設計較為簡潔,但為了達到實際業務的性能要求,采用多種優化策略是必要的。本文從查詢優化、索引優化、檢索器優化、生成器優化及管道優化五大方向,詳細解析了多種方法及其實際應用場景。

在實際應用中,開發者可以根據需求靈活組合這些策略,為RAG系統注入更多智慧,推動其在多領域的廣泛應用。希望本文的總結能幫助大家快速掌握RAG優化技巧,為您的AI項目提供新思路!

參考:

- ??https://docs.llamaindex.ai/en/stable/examples/retrievers/recursive_retriever_nodes/??

- ??https://arxiv.org/abs/2307.03172??

本文轉載自公眾號Halo咯咯 作者:基咯咯