使用BERT的LLM提取摘要 原創(chuàng)

在當(dāng)今快節(jié)奏的世界里,充斥著太多的信息,并且難以處理。人們越來越習(xí)慣于在更短的時(shí)間內(nèi)接收更多的信息,當(dāng)他們不得不閱讀大量的文件或書籍時(shí),可能會感到沮喪。這就該提取摘要發(fā)揮重要作用了。為了提取文章的核心內(nèi)容,這個(gè)過程從文章、頁面或段落中提取關(guān)鍵句子,為人們提供一些要點(diǎn)的快照。

對于那些無需逐字閱讀就能理解大型文檔的人來說,提取摘要是游戲規(guī)則的改變者。

本文深入探討了提取摘要的基本原理和應(yīng)用,并將研究大型語言模型的作用,特別是BERT(來自Transformers的雙向編碼器表示)以增強(qiáng)該過程。本文還將包括一個(gè)使用BERT進(jìn)行提取摘要的實(shí)踐教程,展示它在將大量文本精簡成信息豐富的摘要方面的實(shí)用性。

理解提取摘要

提取摘要是自然語言處理和文本分析領(lǐng)域的一項(xiàng)重要技術(shù)。提取摘要可以從原文中精心挑選出關(guān)鍵的句子或短語,并將其組合起來,形成一個(gè)簡潔而翔實(shí)的摘要。這包括仔細(xì)地篩選文本,以確定所選文章中最關(guān)鍵的元素和中心思想或論點(diǎn)。

在抽象摘要涉及生成源材料中通常不存在的全新句子的情況下,提取摘要則堅(jiān)持原始文本。它不會改變或改寫句子,而是準(zhǔn)確地提取句子原義,保持原來的措辭和結(jié)構(gòu)。這樣,摘要就能與源材料的基調(diào)和內(nèi)容保持一致。在信息的準(zhǔn)確性和保留作者的原始意圖成為優(yōu)先事項(xiàng)的情況下,提取摘要技術(shù)是非常有益的。

它有很多不同的用途,例如總結(jié)新聞文章、學(xué)術(shù)論文或長篇報(bào)告。這個(gè)過程有效地傳達(dá)了原始內(nèi)容的信息,而不會出現(xiàn)轉(zhuǎn)述時(shí)可能出現(xiàn)的潛在偏見或重新解釋。

抽取摘要如何使用大型語言模型(LLM)?

1.文本分析

例如,該模型將分析一個(gè)包含四句話的段落,將其分解為以下四個(gè)句子。

- 建于古埃及的吉薩金字塔巍然屹立了數(shù)千年。

- 它們是為法老建造的陵墓。

- 大金字塔是最著名的金字塔。

- 這些金字塔是建筑的智慧象征。

2.特征提取

在這個(gè)階段,算法需要分析每個(gè)句子,以識別特性(Characteristics)或特征(Features),這些特性或特征可能表明它們對整個(gè)文本的重要性。常見的特征包括關(guān)鍵詞與短語的頻率和重復(fù)使用、句子的長度、它們在文本中的位置及其含義,以及對文本主題中心的特定關(guān)鍵詞或短語的存在。

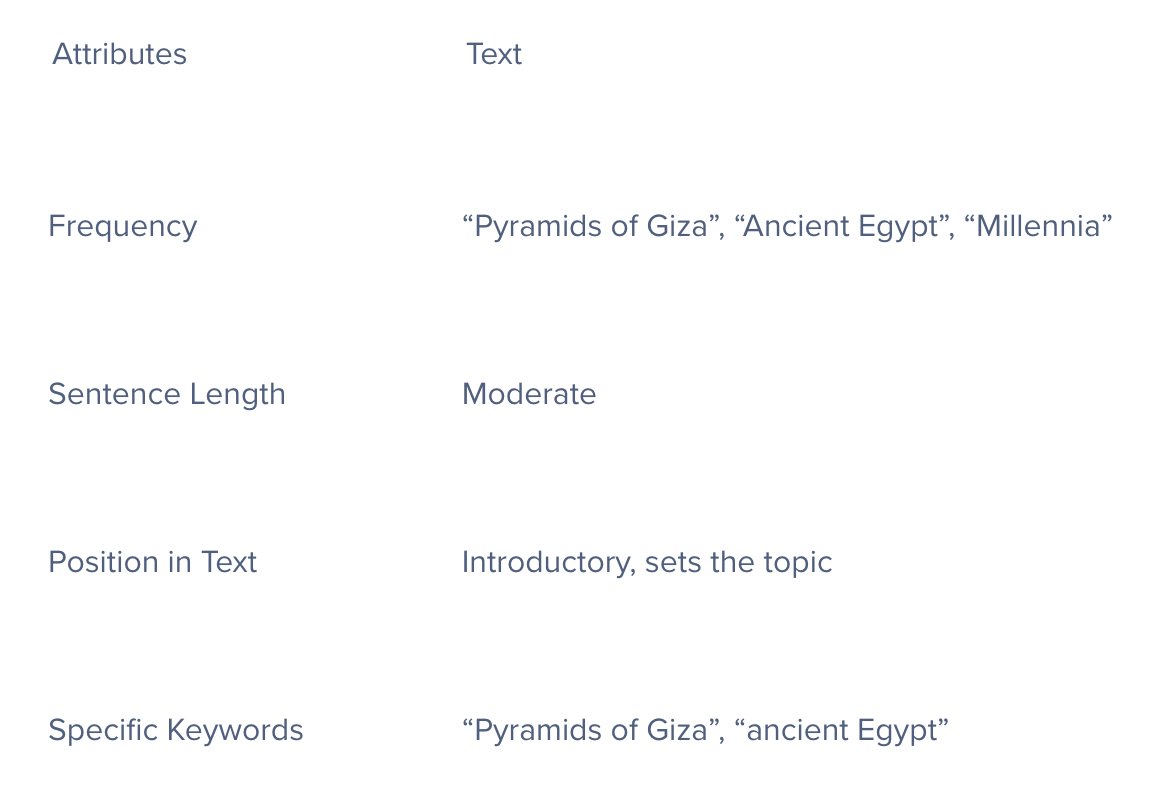

以下是一個(gè)大型語言模型(LLM)如何對第一句話進(jìn)行特征提取的例子:“吉薩金字塔,建于古埃及,巍然屹立了數(shù)千年。”

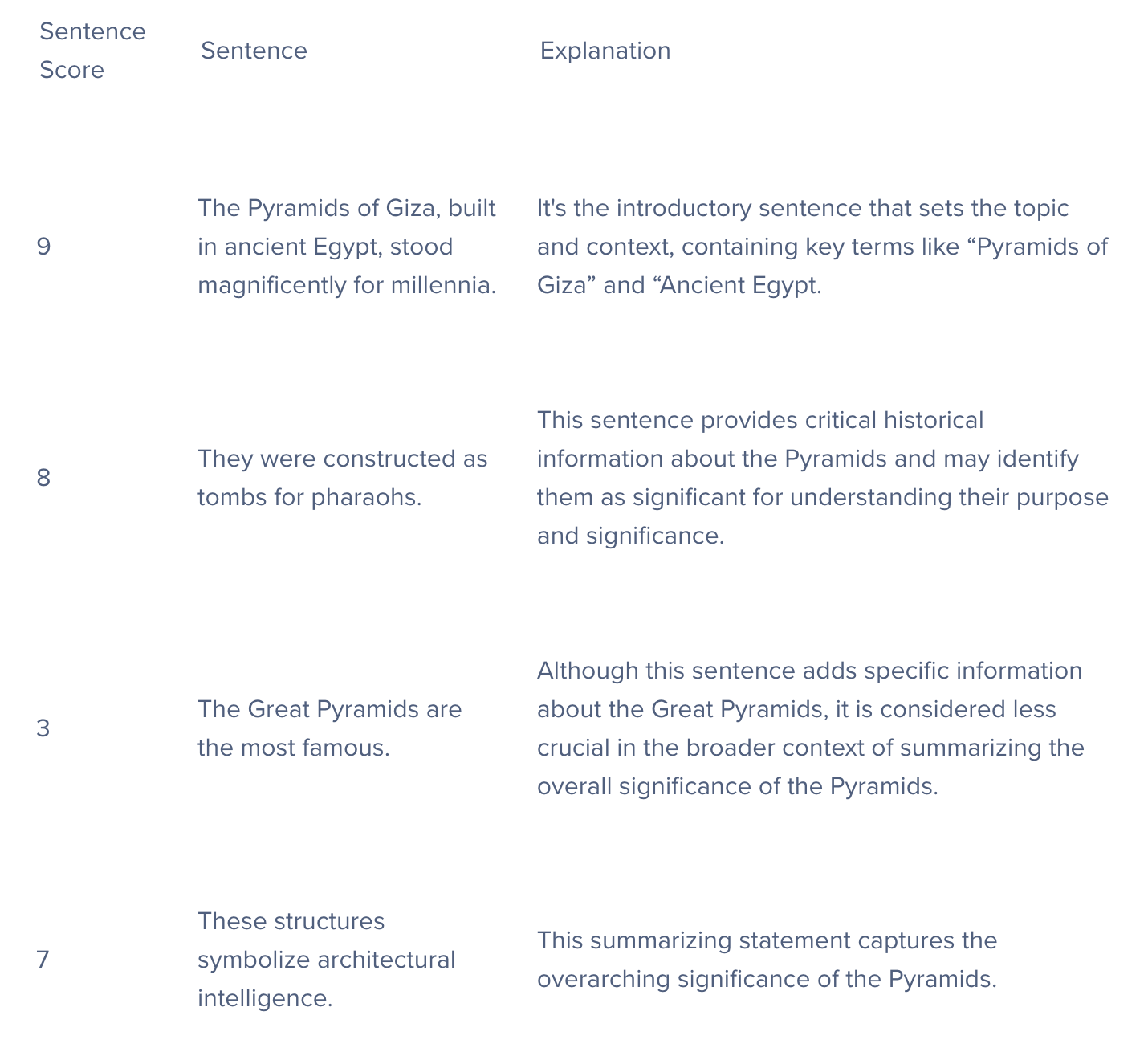

3.對句子進(jìn)行評分

簡單地說,這個(gè)過程對每個(gè)句子的潛在意義進(jìn)行評估,對整個(gè)文本進(jìn)行總結(jié)。

4.選擇與聚合

為了創(chuàng)建有效的摘要,算法必須平衡包括重要句子的需求,這些句子必須簡潔,避免冗余,并確保所選句子提供對整個(gè)原文的清晰和全面的概述。

建于古埃及的吉薩金字塔巍然屹立了數(shù)千年。它們是為法老建造的陵墓。這些金字塔是建筑智慧的象征。

這是一個(gè)非常基礎(chǔ)的例子,從總共4個(gè)句子提取了3個(gè)句子,以獲得最佳的整體概括。多讀一個(gè)句子并沒有壞處,但如果文本變長了怎么辦?例如有三個(gè)段落的文本?

如何運(yùn)行BERT LLM提取摘要

步驟1:安裝和導(dǎo)入必要的軟件包

!pip install bert-extractive-summarizer

from summarizer import Summarizer

步驟2

從Python中的摘要器導(dǎo)入的Summarizer()函數(shù)是一個(gè)提取文本摘要工具。它使用BERT模型從更大的文本中分析和提取關(guān)鍵句子。該功能的目的是保留最重要的信息,提供原始內(nèi)容的精簡版本。它通常用于高效地總結(jié)冗長的文檔。

model = Summarizer()

步驟3:導(dǎo)入文本?

text = "The history of Graphics Processing Units (GPUs) dates back to the early 1980s when companies like IBM and Texas Instruments developed specialized graphics accelerators for rendering images and improving overall graphical performance. However, it was not until the late 1990s and early 2000s that GPUs gained prominence with the advent of 3D gaming and multimedia applications. NVIDIA's GeForce 256, released in 1999, is often considered the first GPU, as it integrated both 2D and 3D acceleration on a single chip. ATI (later acquired by AMD) also played a significant role in the development of GPUs during this period. The parallel architecture of GPUs, with thousands of cores, allows them to handle multiple computations simultaneously, making them well-suited for tasks that require massive parallelism. Today, GPUs have evolved far beyond their original graphics-centric purpose, now widely used for parallel processing tasks in various fields, such as scientific simulations, artificial intelligence, and machine learning. Industries like finance, healthcare, and automotive engineering leverage GPUs for complex data analysis, medical imaging, and autonomous vehicle development, showcasing their versatility beyond traditional graphical applications. With advancements in technology, modern GPUs continue to push the boundaries of computational power, enabling breakthroughs in diverse fields through parallel computing. GPUs also remain integral to the gaming industry, providing immersive and realistic graphics for video games where high-performance GPUs enhance visual experiences and support demanding game graphics. As technology progresses, GPUs are expected to play an even more critical role in shaping the future of computing."

以下是代碼塊中沒有包括它的文本:“圖形處理單元(GPU)的歷史可以追溯到20世紀(jì)80年代初,IBM和德州儀器等公司當(dāng)時(shí)開發(fā)了專門的圖形加速器,用于渲染圖像和提高整體圖形性能。然而,直到20世紀(jì)90年代末和21世紀(jì)初GPU才隨著3D游戲和多媒體應(yīng)用的出現(xiàn)而嶄露頭角。NVIDIA公司的GeForce 256于1999年發(fā)布,通常被認(rèn)為是全球第一款GPU,因?yàn)樗鼘?D和3D加速功能都集成在一個(gè)芯片上。ATI公司(后來被AMD公司收購)在這一時(shí)期的GPU開發(fā)中也發(fā)揮了重要作用。

GPU的并行架構(gòu)有數(shù)千個(gè)核心處理器,使它們能夠同時(shí)處理多個(gè)計(jì)算,非常適合需要大規(guī)模并行性的任務(wù)。如今,GPU已經(jīng)遠(yuǎn)遠(yuǎn)超出了其最初以圖形為中心的用途,現(xiàn)在被廣泛用于各種領(lǐng)域的并行處理任務(wù),例如科學(xué)模擬、人工智能和機(jī)器學(xué)習(xí)。金融、醫(yī)療保健和汽車工程等行業(yè)利用GPU進(jìn)行復(fù)雜的數(shù)據(jù)分析、醫(yī)學(xué)成像和自動駕駛汽車開發(fā),展示了其超越傳統(tǒng)圖形應(yīng)用程序的多功能性。

隨著技術(shù)的進(jìn)步,現(xiàn)代GPU不斷突破計(jì)算能力的極限,通過并行計(jì)算在不同領(lǐng)域?qū)崿F(xiàn)突破。GPU仍然是游戲行業(yè)不可或缺的一部分,為視頻游戲提供身臨其境和逼真的圖形。高性能GPU增強(qiáng)了視覺體驗(yàn),并支持要求苛刻的游戲圖形。隨著技術(shù)的進(jìn)步,GPU有望在塑造計(jì)算的未來方面發(fā)揮更關(guān)鍵的作用。”

步驟4:執(zhí)行提取摘要

# Specifying the number of sentences in the summary

summary = model(text, num_sentences=4)

print(summary)

摘要輸出:

圖形處理單元(GPU)的歷史可以追溯到20世紀(jì)80年代早期,IBM和德州儀器等公司當(dāng)時(shí)開發(fā)了專門用于渲染圖像和提高整體圖形性能的圖形加速器。NVIDIA公司于1999年發(fā)布的GeForce 256通常被認(rèn)為是第一款GPU,因?yàn)樗趩蝹€(gè)芯片上集成了2D和3D加速功能。如今,GPU已經(jīng)遠(yuǎn)遠(yuǎn)超出了其最初以圖形為中心的目的,現(xiàn)在廣泛用于各種領(lǐng)域的并行處理任務(wù),例如科學(xué)模擬、人工智能和機(jī)器學(xué)習(xí)。隨著技術(shù)的進(jìn)步,GPU有望在塑造未來的計(jì)算中發(fā)揮更加關(guān)鍵的作用。

該模型從龐大的文本語料庫中提取了4個(gè)最重要的句子來生成這個(gè)摘要!

使用大型語言模型提取摘要的挑戰(zhàn)

語境理解局限性

訓(xùn)練數(shù)據(jù)偏差

處理專業(yè)或技術(shù)語言

結(jié)論

很明顯,提取摘要不僅僅是一個(gè)方便的工具;在信息飽和的時(shí)代,其重要性日益增長。通過利用BERT等技術(shù)的力量,可以看到復(fù)雜的文本如何被提煉成易于理解的摘要,這節(jié)省了人們的時(shí)間,并幫助他們進(jìn)一步理解被總結(jié)的文本。

無論是學(xué)術(shù)研究、商業(yè)見解,還是在技術(shù)先進(jìn)的世界里保持信息靈通,提取摘要都是一種實(shí)用的方法,可以在信息海洋中導(dǎo)航。隨著自然語言處理的不斷發(fā)展,像提取摘要這樣的工具將變得更加重要,幫助人們快速找到并理解在這個(gè)分秒必爭的世界中最重要的信息。

原文標(biāo)題:Extractive Summarization With LLM Using BERT,作者:Kevin Vu

鏈接:?https://dzone.com/articles/extractive-summarization-with-llm-using-bert?。